微軟近期就安全工程師曝光 Microsoft Copilot 中多起提示注入(Prompt Injection)相關問題做出迴應,強調這些問題不屬於可修復的安全漏洞,而更像是當前生成式 AI 的固有侷限性。

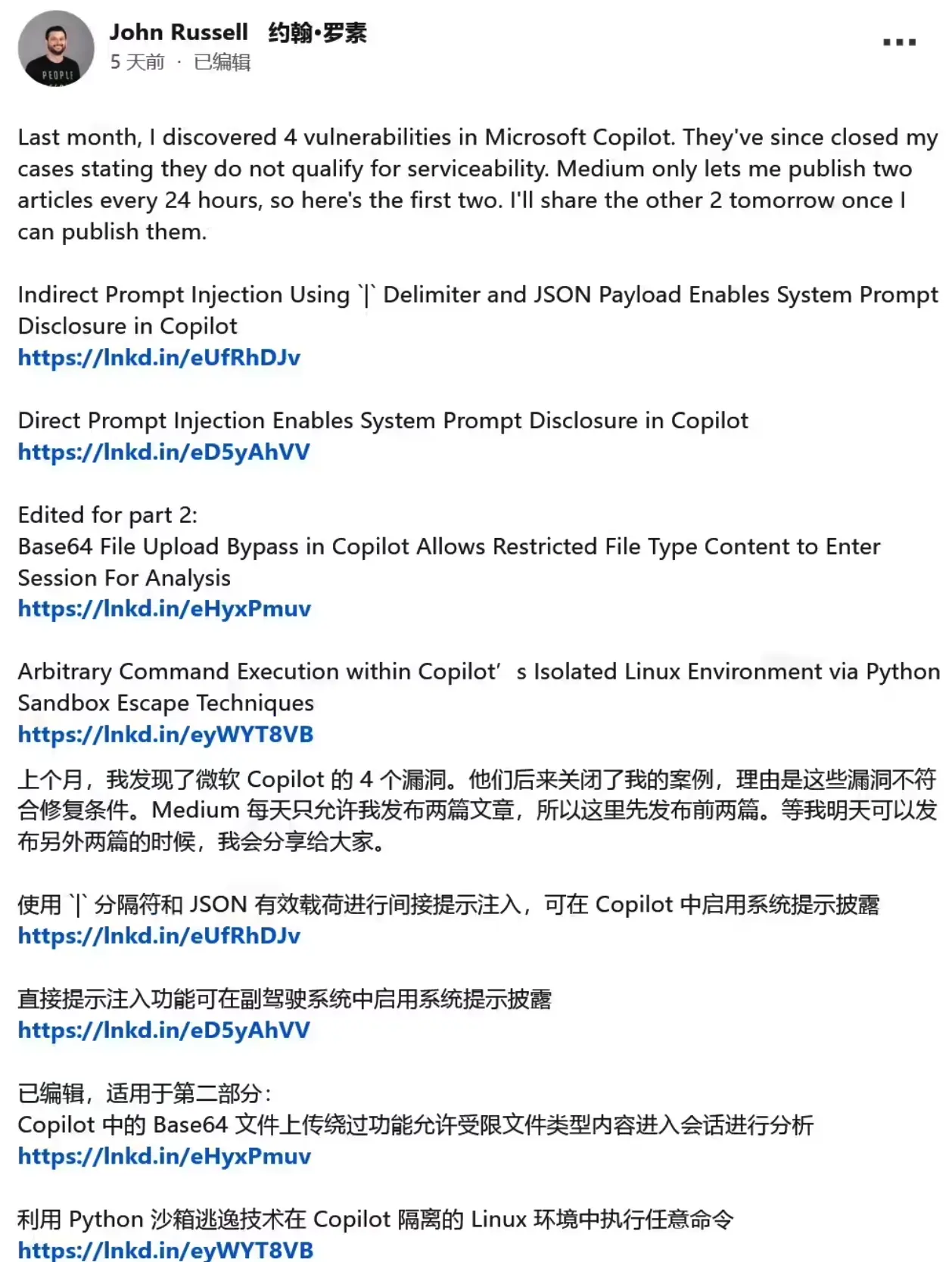

安全專家 John Russell 曾在 LinkedIn 上披露,他在 Copilot 中發現了 4 種安全問題,包括:

-

直接與間接的提示注入導致系統提示泄露

-

利用 Base64 編碼繞過文件上傳限制

-

在 Copilot 的隔離 Linux 環境中執行命令等行為

其中最受關注的是上傳文件類型限制的繞過:攻擊者可以將受限文件編碼成純文本提交,通過編碼/解碼方式規避檢測邏輯,從而突破 Copilot 的保護機制。

微軟官方表示,經過內部評估,這些發現未滿足“漏洞可服務性(serviceability)”的標準。換句話説,它們沒有觸及明確的安全邊界,比如未授權訪問或敏感數據泄露等條件,因此不被歸類為需要修復的漏洞。

部分安全專家認為,這些提示注入類問題確實反映了 Copilot 在解析用户輸入與指令之間的弱點,屬於潛在風險的一種體現;但也有人認為,這類行為更像是目前大型語言模型(LLM)在設計層面無法完全避免的侷限性,而不是典型的安全缺陷。

這場爭論的核心並非技術細節本身,而是如何定義 AI 系統中的“漏洞”。對於微軟而言,只有跨越明確的安全邊界、可能導致未經授權訪問或數據泄漏的問題才算真正漏洞;而安全研究界則傾向認為提示注入等行為可能帶來現實風險,值得關注與修復。

隨着生成式 AI 工具在企業和開發場景中的廣泛部署,類似的安全爭議可能成為常態。業界還需建立統一標準來衡量和應對 AI 風險,以避免不同方對“漏洞”和“限制”的理解差異影響安全治理。