吳恩達(Andrew Ng)提出對傳統圖靈測試進行擴展,以衡量 AGI 是否實現,稱為Turing-AGI Test”(圖靈-AGI測試)。

--------------------

親愛的朋友們,

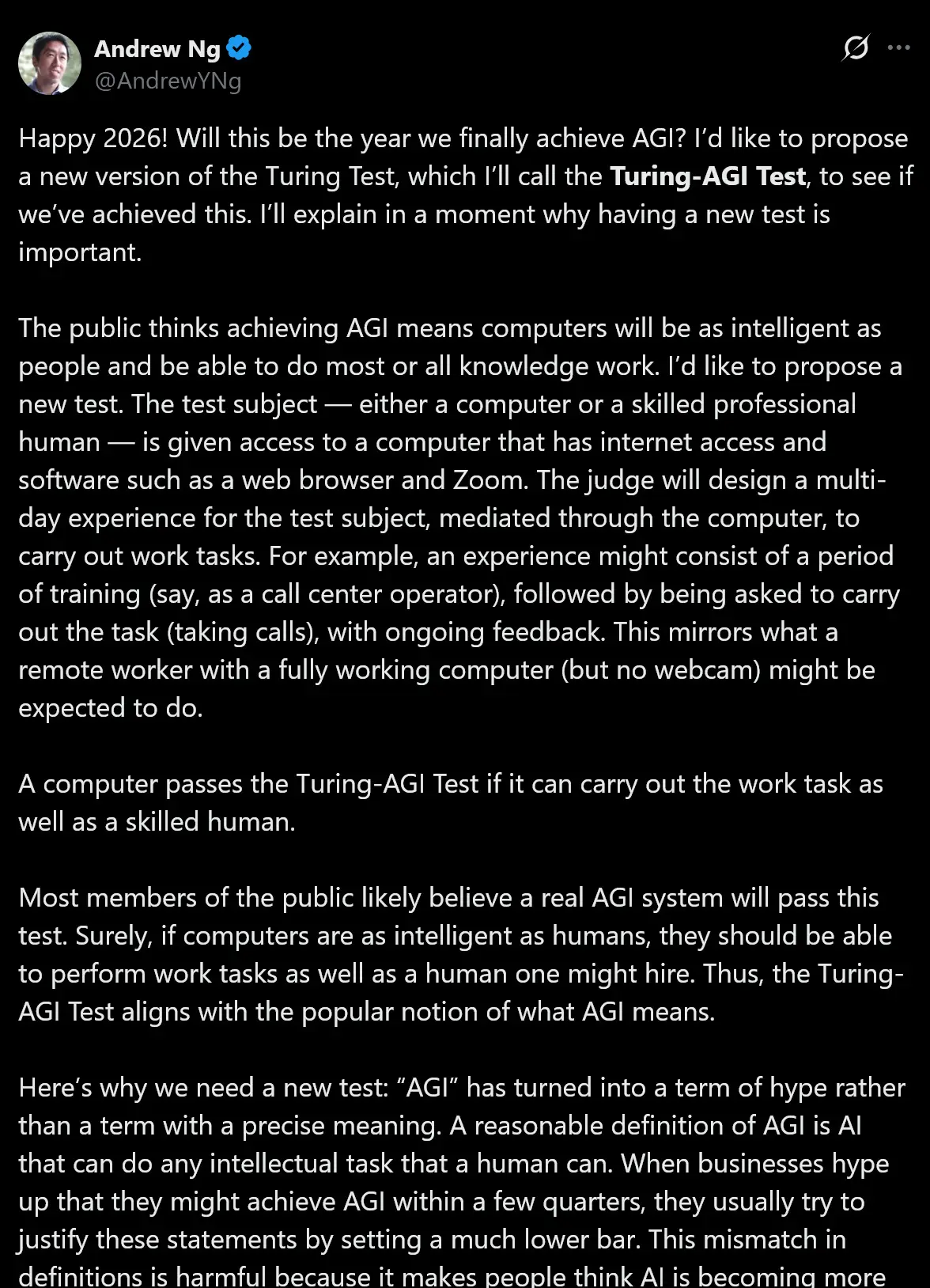

2026年新年快樂! 今年會是我們最終實現AGI(通用人工智能)的一年嗎?我想提議一個圖靈測試的新版本,我將其稱為“圖靈-AGI測試”(Turing-AGI Test),來看看我們是否已經達成了這一目標。稍後我會解釋為什麼擁有一個新的測試標準如此重要。

公眾普遍認為,實現AGI意味着計算機將和人類一樣聰明,並且能夠勝任大部分甚至所有的知識型工作。我想提出的新測試是這樣的:測試對象——可以是一台計算機,也可以是一位熟練的人類專業人士——將被賦予一台電腦的訪問權限,這台電腦可以上網,並安裝了瀏覽器和Zoom等軟件。裁判將為測試對象設計一個為期多天的“工作體驗”,並通過這台電腦作為媒介來執行工作任務。例如,這一體驗可能包含一段培訓期(比如作為呼叫中心接線員),隨後要求其執行具體任務(接聽電話),並在此過程中給予持續的反饋。這類似於一個擁有功能完備的電腦(但沒有網絡攝像頭)的遠程工作者所被期望完成的工作。

如果一台計算機能夠像熟練的人類一樣出色地完成這些工作任務,那麼它就通過了“圖靈-AGI測試”。

大多數公眾可能都相信,一個真正的AGI系統是可以通過這項測試的。當然,如果計算機真的像人類一樣聰明,它們理應能夠像我們僱傭的人類員工一樣出色地完成工作任務。因此,“圖靈-AGI測試”與大眾對AGI含義的普遍認知是相符的。

這就是我們需要一個新測試的原因: “AGI”已經變成了一個炒作術語,而不再是一個具有精確含義的術語。AGI的一個合理解義是“能夠完成人類所能完成的任何智力任務的AI”。當企業大肆炒作他們可能在幾個季度內實現AGI時,他們通常試圖通過設定一個低得多的門檻來為這些言論辯護。這種定義上的錯位是有害的,因為它讓人們誤以為AI變得比實際上更強大。我看到這種情況誤導了所有人,從高中生(他們因為認為AGI即將到來,學習某些領域毫無意義而避開這些學科)到CEO(他們在決定投資什麼項目時,有時會基於“AI在1-2年後的能力將超越任何現實可能”的假設)。

最初的圖靈測試要求計算機通過文字聊天愚弄人類裁判,使其無法分辨自己是機器還是人,但這已不足以表明人類水平的智能。勒布納獎(Loebner Prize)競賽實際上運行了圖靈測試,並發現要愚弄裁判,模擬人類的打字錯誤——甚至比真正展示智能——更為必要。當今AI發展的一個主要目標是構建能夠從事具有經濟價值的工作的系統,而不是愚弄裁判。因此,一個經過修改的、衡量“做工能力”的測試,將比衡量“愚弄人類能力”的測試更有用。

對於今天幾乎所有的AI基準測試(如GPQA、AIME、SWE-bench等),測試集都是預先確定的。這意味着AI團隊最終至少會間接地針對已發佈的測試集來優化他們的模型。此外,任何固定的測試集只能衡量智能的一個狹窄切片。相比之下,在圖靈測試中,裁判可以隨心所欲地提出任何問題來探測模型。這讓裁判能夠測試計算機或人類的知識到底有多“通用”。同樣,在“圖靈-AGI測試”中,裁判可以設計任何體驗——這些體驗對於被測試的AI(或人類受試者)來説是不預先透露的。這比預定的測試集能更好地衡量AI的通用性。

AI正處於驚人的進步軌道上。在過去的幾十年裏,過度的期望曾導致了“AI寒冬”,當時對AI能力的失望導致了關注度和資金的減少,直到領域取得更多進展後才有所回升。阻礙AI巨大動力的少數因素之一,就是不切實際的炒作所製造的投資泡沫,這帶來了失望和興趣崩盤的風險。為了避免這種情況,我們需要重新校準社會對AI的期望。一個測試將對此有所幫助。

如果我們舉辦一場“圖靈-AGI測試”競賽,而每個AI系統都未達標,那將是一件好事! 通過平息圍繞AGI的炒作並降低泡沫的風險,我們將為AI的持續投資創造一條更可靠的路徑。這將讓我們繼續推動真正的技術進步並構建有價值的應用——即使是那些遠未達到AGI水平的應用。而如果這個測試設定了一個明確的目標,讓團隊可以以此為方向來摘取實現AGI的殊榮,那也同樣美妙。我們可以確信,如果一家公司通過了這個測試,他們創造的將不僅僅是一份營銷通稿——那將是某種極具價值的東西。

新年快樂,祝大家在新的一年裏構建愉快!

Andrew

轉自:https://weibo.com/2194035935/QlYRX6f1I

原文:https://www.deeplearning.ai/the-batch/issue-334/