百度百舸·AI異構計算平台已支持快速部署DeepSeek-V3、DeepSeek-R1及其蒸餾的Llama、Qwen等小規模dense模型。您可以登錄百度百舸平台快速部署DeepSeek系列模型體驗模型效果。

01 開通輕量計算實例

開通一台H20(ebc.lgn7t.c208m2048.8h20.4d)規格的計算實例並添加到百度百舸·AI異構計算平台。

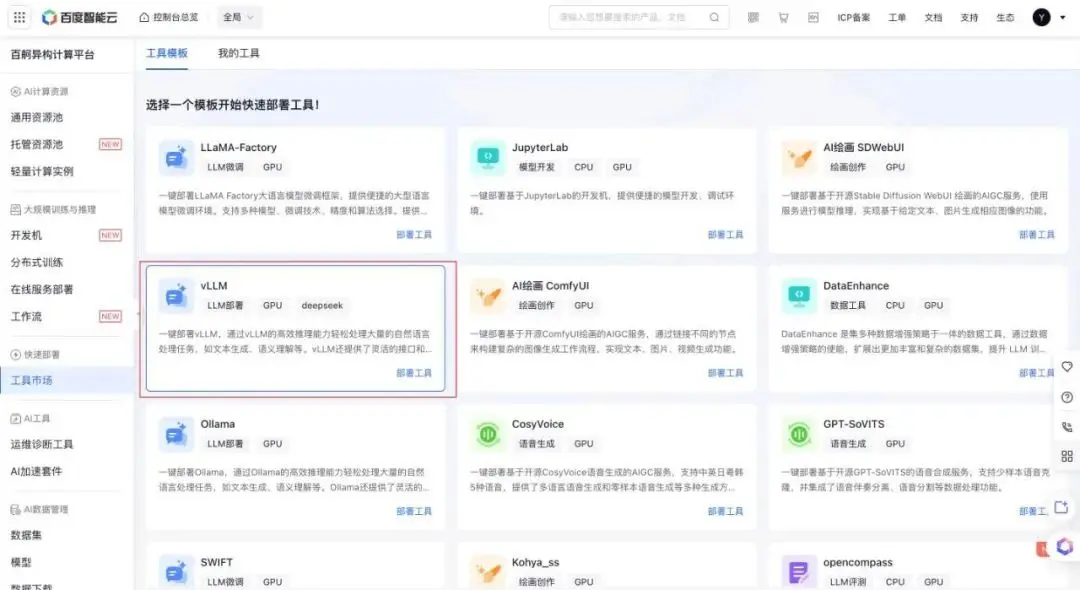

02 部署vLLM

在百度百舸平台的左側導航中選擇「工具市場」頁面,部署工具vLLM。

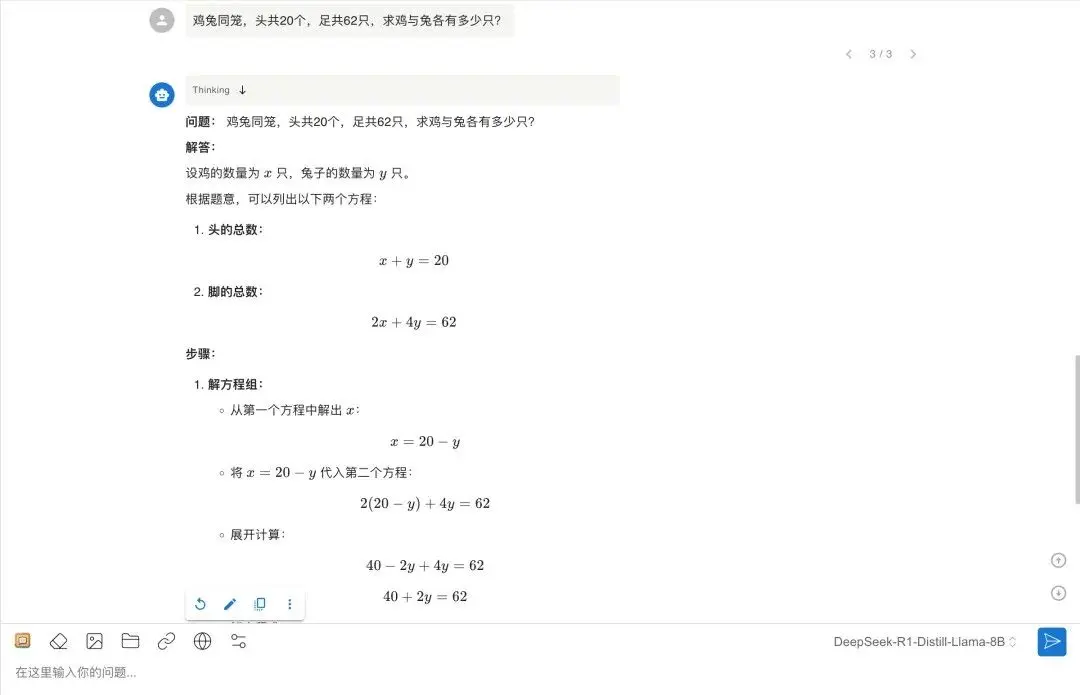

03 模型推理

vLLM部署成功,登錄實例下載模型並啓動vLLM服務,安裝WebUl客户端。

發送請求開始對話。

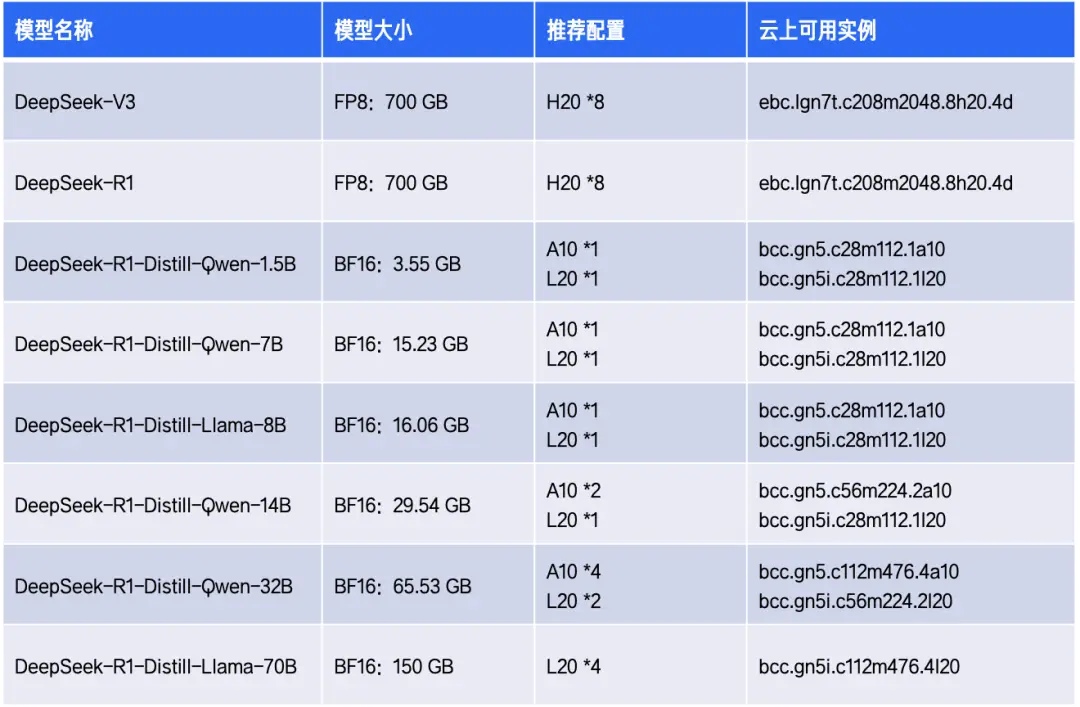

04 各系列模型的推薦配置清單

在完成滿血版DeepSeek模型的快速部署後,百度百舸·AI異構計算平台還能為這些在線服務提供全生命週期管理、自研框架推理加速、推理資源碎片整理等能力。在保障服務穩定性的同時,有效降低推理成本並提升推理性能。

訪問百度百舸頁面https://cloud.baidu.com/product/aihc.html,感受服務穩定性與成本效益的雙重提升!

————END————

推薦閲讀

首日調用客户破1.5萬!DeepSeek-V3/R1上線背後的超低推理成本技術揭秘

喚醒 AI 算力,專有云 ABC Stack 面向企業級智算平台的 GPU 提效實踐

百度APP iOS端磁盤優化實踐(上)

對話AI原生|比幫你寫代碼更爽的是:讓Agent來打工

0 Token 間間隔 100% GPU 利用率,百度百舸 AIAK 大模型推理引擎極限優化 TPS