導讀

面對百度APP日均數千億PV、超百PB數據規模帶來的巨大挑戰,我們完成了數據倉庫的系統性升級。本文詳細闡述了通過"兩步走"策略解決資源壓力、處理延遲和架構瓶頸的全過程:第一階段聚焦日誌清洗環節的穩定性與成本優化,第二階段實現實時離線鏈路解耦、核心數據隔離及計算框架容錯能力提升。此次升級顯著提升了數據處理時效性、系統穩定性和成本效益,為業務發展提供了更堅實的數據支撐。

背景

百度APP及其產品矩陣作為百度體量最大的C端業務線,在數據處理全鏈路面臨規模與架構的雙重挑戰。日誌清洗環節因日均幾千億PV、超百PB的龐大數據規模,導致計算資源持續承壓、處理延遲頻發,加之歷史遺留的複雜日誌格式,清洗穩定性與時效性逐步下降,存儲成本高昂。與此同時上游日誌數據仍存在實時與離線鏈路耦合、核心與邊緣數據未有效隔離、計算框架容錯能力不足等結構性問題,影響關鍵數據產出的穩定與時效。整體系統切換與優化面臨高額的歷史負擔和技術重構成本,下游業務的數據可用性、決策及時性及深度運營分析均受到顯著制約。

基於以上問題,我們制定了“兩步走”的升級策略:第一階段優先解決日誌清洗環節的穩定性和存儲成本問題;第二階段在此基礎上,重點推進數倉上層架構優化,包括實時與離線鏈路解耦、核心數據隔離處理以及計算框架容錯能力提升,逐步實現整體數據倉庫的高效、穩定與可持續升級。

01 第一階段:多日誌源整合

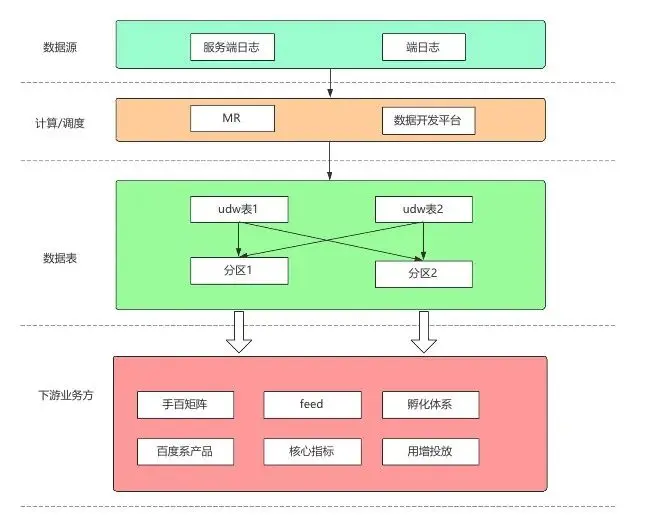

1. 2023年之前架構

在百度APP及其產品矩陣的數據體系建設過程中,日誌清洗作為整個數據流水線的起始環節,其處理穩定性和產出時效性始終處於關鍵地位,是保障下游業務數據可用性與決策及時性的重中之重。然而,隨着業務規模持續擴大和用户體量快速增長,每日產生的日誌量急劇上升,由此帶來的巨大計算壓力使得整個清洗鏈路頻繁面臨資源瓶頸與處理延遲,穩定性和時效性均逐步下滑,難以滿足下游各業務方對數據交付時間和質量的要求。與此同時,數據入口的分散催生了大量煙囱式的開發與冗餘的計算邏輯,不僅推高了運維成本,更在源頭形成了數據孤島。下游基於此類數據構建的數倉架構必然複雜化,多表的 JOIN 與理解成本高昂,使得整個數據建設環節揹負着日趨沉重的成本與協作壓力。

2. 問題分析

2.1 舊架構分析

2.1.1 數據孤島化加劇,認知與使用成本高昂

現有架構對每類日誌採用獨立落表方式,導致數據存儲呈現碎片化狀態。這種設計造成同一業務實體的相關信息分散在不同表中,形成嚴重的數據割裂。下游用户在使用數據時,不得不通過多表關聯才能獲取完整信息,不僅大幅增加了技術實現難度,更帶來了沉重的認知負擔。用户需要理解多張表的結構和關聯關係,極易產生理解偏差,進而影響數據分析的準確性和可靠性。

2.1.2 關聯查詢性能瓶頸,制約數據價值釋放

與此同時,多表關聯查詢模式給系統帶來了巨大的性能壓力。隨着數據量的持續增長,表連接操作的成本呈指數級上升,查詢響應時間顯著延長。特別是在需要跨多個表進行關聯分析的場景下,系統往往需要耗費大量計算資源和時間,無法滿足業務對高效數據分析和快速決策的需求,嚴重製約了數據價值的及時釋放。

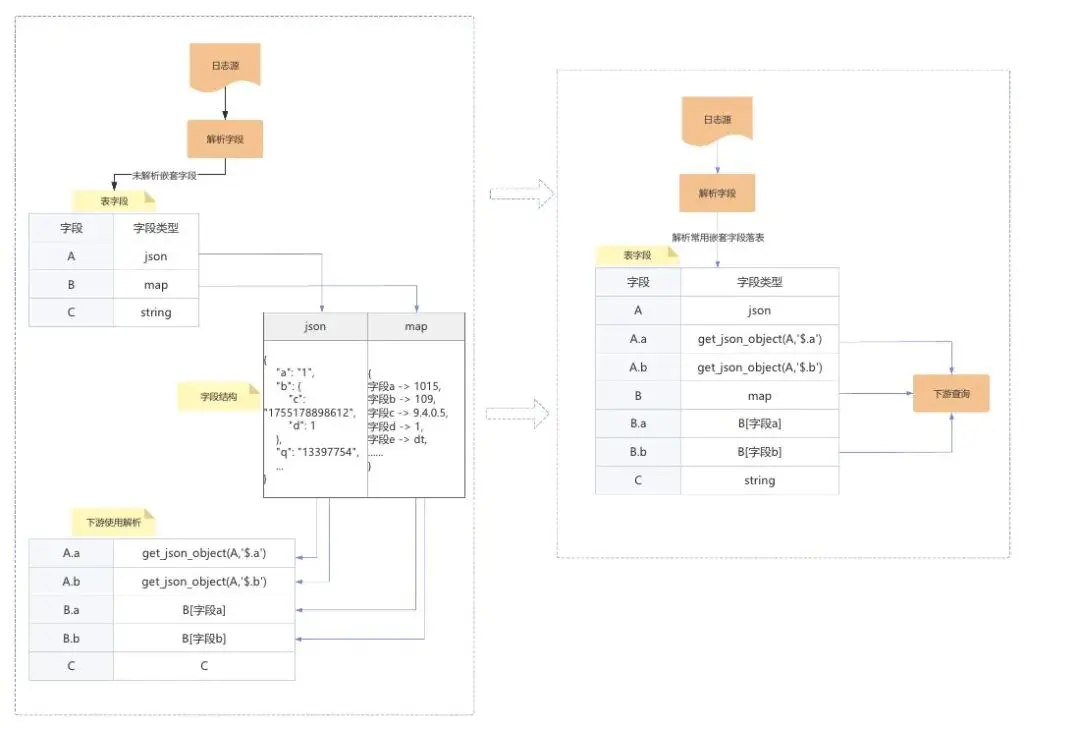

此外,原始日誌結構中普遍存在的複雜嵌套格式(如多層JSON、數組結構等)大幅增加了數據清洗和解析的複雜度。大量業務自定義字段缺乏統一規範,導致解析邏輯冗餘且低效,進一步降低了整體處理性能。這些因素共同加劇了數據處理的延遲與資源消耗,形成系統性瓶頸。

2.1.3 維護複雜度與脆弱性並存,系統穩定性堪憂

獨立的數據處理流水線,導致系統維護點分散。任何邏輯變更或schema調整都需要在多處同步實施,極大地增加了維護工作量。這種架構的脆弱性也顯著提高了出錯風險,單個任務修改的錯誤可能引發連鎖反應,影響整個數據鏈路的穩定性。

特別需要指出的是,當前採用的UDW數倉及配套ETL框架仍是2012年上線的技術方案,已明顯落後於業界主流水平。該框架存在諸多侷限性:首先,其兼容性差,難以與現有開源生態工具鏈高效集成;其次,基於C++的MR計算框架穩定性不足,日常運行中容易出現各種異常;最後,開發調試效率低下,嚴重製約了數據需求的迭代速度。這些技術債務不僅增加了系統的維護複雜度,更成為制約數據平台發展的關鍵瓶頸。

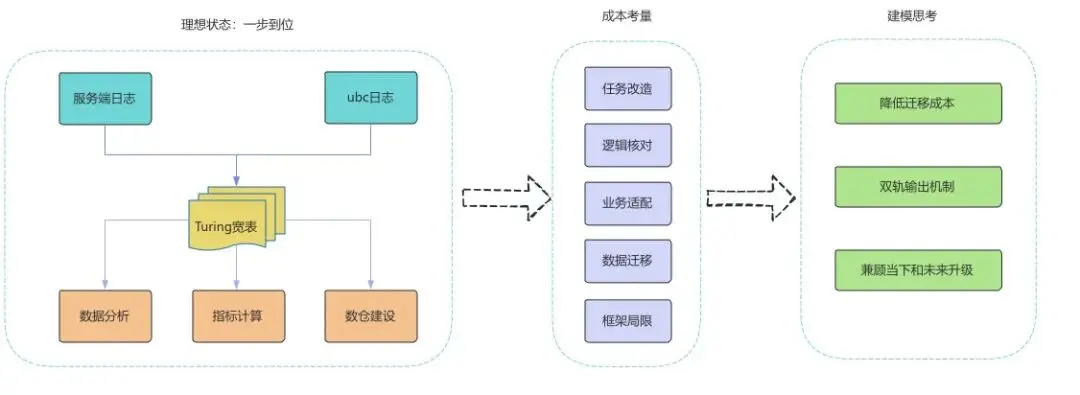

2.2 重構思路分析

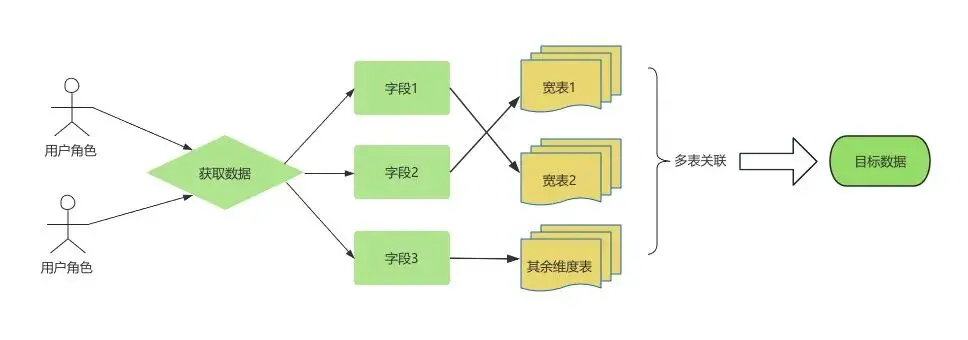

理想狀態:從數據架構的理想設計來看,基於通用寬表數據建模方法論,採用“一步到位”的方式直接產出高度整合、面向主題的Turing寬表,是最為高效和優雅的解決方案。它能夠減少中間冗餘加工環節,提升數據一致性和複用度。

升級成本:下游業務方因歷史原因,數據應用架構高度依賴傳統UDW模式的數據組織與服務方式,遷移至Turing寬表體系涉及大量腳本改造、邏輯核對與業務適配工作,技術切換和數據遷移成本極高,導致架構升級短期難以實施。

思考:為實現數據架構的平滑升級,本次重構方案採用漸進式過渡策略,在着力解決現有架構核心痛點的同時,必須充分考慮百度業務數據鏈路長、歷史包袱重的現實情況,審慎平衡技術先進性與落地可行性。方案設計嚴格遵循"平滑過渡、風險可控、成本最優"三大原則。

需要特別指出的是,由於現有數據體系深度嵌入各業務線的策略計算與離線分析環節,其緊密的耦合關係導致配套升級難度極大、週期長。這不僅涉及底層數據表的更替、依賴路徑修改,更要求對依賴原有數據模型的下游業務進行協同改造和全面適配,溝通和推進難度極大。所以在保障業務連續性的前提下,如何有序推進全鏈路的升級切換是本次升級的重中之重。

建模思路:

(1)降低遷移成本

在數據中間層設計上,方案延續使用刻鐘級UDW表作為緩衝層,通過將多個離散的UDW表整合為統一的寬表模型,進一步降低下游的使用和理解成本。同時,對錶schema實施精細化改造,包括消除冗餘字段、統一數據標準、優化存儲格式,並重構字段邏輯以提升數據一致性。這種設計既保持了與現有下游系統的兼容性,又顯著降低了數據使用複雜度。

(2)雙軌輸出機制

為確保遷移過程的平穩性,方案採用雙軌輸出機制:一方面繼續提供優化後的UDW寬表,保障現有作業的無縫運行;另一方面通過聚合加工生成小時級Turing表,作為統一對外輸出的日誌寬表。這種漸進式遷移路徑使下游用户可根據自身情況靈活選擇切換時機,最大限度降低升級成本。

(3)兼顧歷史和未來

此次架構優化為後續全面升級奠定了堅實基礎。通過UDW層的預處理和Turing表的逐步推廣,最終將實現架構的完全過渡,在提升系統性能的同時確保業務連續性,達成技術演進與業務穩定之間的最佳平衡。

3. 解決方案

過渡方案設計與實施:穩時效、降成本、提效率的綜合治理

面對日誌清洗環節日益嚴峻的穩定性、時效性及成本壓力,我們制定並實施了一套詳盡的過渡性解決方案。該方案並未激進地推行一步到位的Turing寬表遷移,而是立足於現有技術生態,以快速解決下游業務最迫切的痛點為目標,重點攻堅“產出時效不穩定”、“存儲計算成本高”及“明細數據查詢效率低下”三大核心問題。

3.1 優化處理粒度與邏輯沉澱,保障時效與複用性

為徹底扭轉小時級任務積壓與延遲的局面,我們首先對調度週期進行了粒度細化,將日誌清洗任務從小時級調度全面提升至刻鐘級(15分鐘)。這一調整顯著降低了單次任務的處理數據量和計算壓力,使數據產出的延遲大幅減少,穩定性和時效性得到了根本保障。在技術選型上,我們並未盲目更換計算框架,而是繼續沿用成熟穩定的C++/MR框架,確保了遷移過程的平穩性與可靠性。

同時,我們致力於提升數據的易用性與標準化程度。針對下游業務方需要反覆從複雜JSON、Map等嵌套字段中解析提取關鍵信息的痛點,我們進行了大規模的業務通用邏輯下沉工作。將超過100個高頻訪問的埋點屬性進行預解析、扁平化處理,轉化為單獨的標準化字段。這不僅極大減輕了下游的數據預處理負擔,更直接提升了基於這些字段的查詢過濾與聚合分析效率,為下游開發節省了大量時間。

3.2 兼顧歷史依賴與未來演進,提供平滑遷移路徑

我們充分認識到下游業務對原有UDW數倉體系的強依賴性。為保障業務的連續性,我們並未強制要求所有方立即遷移,而是採取了雙軌並行的支撐策略。在產出新一代數據模型的同時,我們繼續提供UDW中間表,確保那些尚未準備好遷移至Turing寬表的業務方能夠無縫對接,無需修改現有代碼,極大降低了方案的落地門檻和風險。

3.3 深度優化存儲與查詢,實現性能跨越式提升

為進一步降低存儲成本並提升Turing寬表的查詢性能,我們對其存儲結構進行了深度優化。

- 合併小文件與高效壓縮:海量小文件是制約查詢性能的首要元兇。我們通過按設備ID、點位ID、時間戳等關鍵字段進行精細排序,將數據寫入為連續有序的大文件,從而將單天高達800萬個小文件合併至60萬左右,文件數量減少了近93%。在存儲格式上,我們選用Parquet列式存儲,並經過充分調研測試,採用了ZSTD壓縮算法。ZSTD在壓縮比、壓縮/解壓速度上取得了最佳平衡,且完美支持多線程,最終實現了每天節省超過420TB的巨大存儲開銷,成本效益極其顯著。

4. 新的問題&解決策略

問題1:寬表數據量膨脹導致的查詢性能下降

解決策略:為應對寬表數據量激增對查詢性能帶來的挑戰,我們實施了體系化的查詢加速方案,顯著提升海量數據下的檢索效率

- 強制分區限制策略:在查詢引擎層上線了強制要求限制分區條件的規則,避免了全表掃描帶來的鉅額元數據開銷,大幅提升元數據檢索效率。

- 查詢結果緩存:對常見的熱點查詢結果進行緩存,對於重複性查詢實現了秒級響應。

- 智能資源調度:根據查詢的計算複雜度,系統自動將其調度到不同配置的資源池中執行,簡單查詢快速返回,複雜查詢獲得充足資源,實現了集羣資源的高效利用。

問題2:分區數量增多導致點位所在的分區變得困難

解決策略:針對分區維度增加後,數據定位難度加大的問題,我們通過元數據管理與平台化集成提供解決方案:

- 新建分區元數據集,以天為粒度預先計算並存儲所有點位與分區的映射關係,形成高效的點位分區定位查詢,為點位所在分區快速檢索提供基礎支撐。

- 與現有點位管理平台深度集成,在其點位查詢界面新增【查一查】功能。用户可通過界面化操作直接獲取精準的數據分區信息及查詢SQL模板,極大提升了用户使用的效率,降低了用户使用成本。

02 第二階段:全面提速

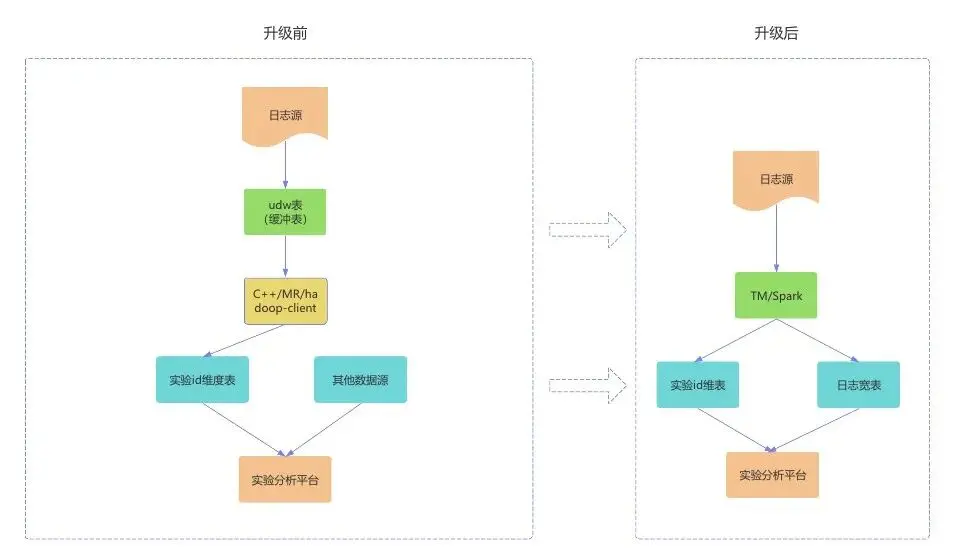

1. 2023→2024年架構

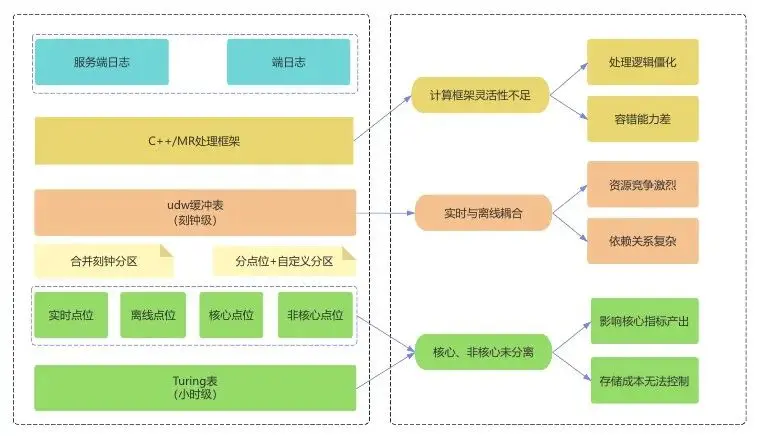

隨着業務發展,該數倉已完成由UDW(統一數據工作台)向Turing(新數據工作台)的改造,並初步建立起體系化的數據模型與分層數據集,顯著提升了數據複用性和分析效率。基於這些寬表與數據集,大部分常規分析場景已能夠快速響應。然而,在數據加工的最上游,即明細數據寬表的生產環節之前依舊包含緩衝的刻鐘級udw表,因此仍存在若干架構性瓶頸。首先,實時數據處理鏈路與離線批處理鏈路相互耦合,資源競爭與依賴關係複雜,影響了整體任務的穩定性和時效性;其次,核心業務指標與非核心附屬數據未被有效拆分處理,導致關鍵數據產出易受邊緣數據波動或延遲的干擾;此外,當前的計算框架對於數據遲到、重複、異常值等複雜情況的處理靈活度不足,容錯與自適應能力有待加強。

為徹底解決這些問題,進一步提升數據產出的時效性、準確性和穩定性,以更好地賦能百度APP及其產品矩陣及各下游業務的數據分析與決策,亟需結合各數據點位的實際使用情況和業務優先級,對最上游的日誌ETL(抽取、轉換、加載)處理流程進行系統性的優化與重構。

2. 問題分析

當前數據ETL處理流程面臨以下幾個核心挑戰,這些問題不僅影響數據產出的效率與穩定性,也為下游業務數據的準確性和及時性帶來風險。

2.1 開發框架靈活性不足,資源協調與彈性擴展能力受限

目前的ETL任務仍沿用原有UDW大表處理框架,通過單機Hadoop Client提交任務,並依賴QE(底層為mapreduce引擎)進行計算。該框架在資源調度和權限管理方面已逐漸暴露出瓶頸。同時udw是2012年提出的數倉建設方案,隨着開源計算、存儲技術的發展,udw性能逐步落後業界,部分功能不具備繼續升級迭代可行性。一旦出現上游數據延遲、隊列資源擁塞或系統異常,容易導致任務大規模積壓。由於缺乏跨隊列或跨資源的調度容災能力,無法協調其他計算資源執行任務回溯與補償,最終將直接影響整體數據產出時效,甚至波及下游多條業務線的核心數據應用。

2.2 核心與非核心數據處理耦合,異常影響範圍擴散

在日誌清洗ETL環節中,核心業務數據點位與非核心業務數據點位、以及實時與離線數據流目前尚未進行有效拆分處理。這種架構層面的耦合導致一旦上游數據源或計算過程中發生異常,其影響面會迅速擴大,不僅關鍵業務指標受到衝擊,非核心業務數據的問題也可能反向干擾核心鏈路的穩定性。缺乏業務優先級識別和隔離機制,降低了計算鏈路的整體容錯能力和故障隔離水平。

2.3 計算鏈路冗長複雜,維護困難且穩定性面臨挑戰

當前處理流程中包含UDW中間緩衝層,導致計算環節增多、鏈路層級深化。較長的依賴鏈不僅增加了數據產出的端到端延遲,也顯著提高了運維監控和故障定位的複雜度。任何環節出現性能波動或失敗都易引起連鎖反應,威脅整體任務的穩定性和時效性,同時也帶來較高的人力維護成本。

2.4 實時與離線數據源不一致,存在冗餘計算與口徑偏差

百度APP及其產品矩陣業務當前使用的實時計算鏈路和離線數據鏈路在核心指標上並未實現數據源統一,兩條鏈路獨立處理且並行存在。這導致相同指標需要在不同流程中重複計算,既造成資源浪費,也增加了數據口徑對齊的難度。長期來看,此類架構問題會直接影響關鍵指標的一致性和可信度,對業務決策準確性構成潛在風險。

2.5 存儲無序增長,數據冗餘和存儲成本與日俱增

隨着業務規模的持續擴張和流量快速增長,支撐核心業務的明細數據寬表總量已達到百PB級別,存儲與計算成本壓力日益凸顯。然而,不同業務域對數據的保留週期和使用頻率存在顯著差異,全部數據長期存儲既不經濟也無必要。

3. 解決方案

3.1 ETL框架升級

在完成由多張udw表到Turing表的優化工作完成後,數據處理的時效性與穩定性雖然取得了一定改善,但仍存在進一步提升的空間。具體而言,原有的C++ MR計算框架在任務運行過程中逐漸暴露出兩類典型問題:一是容易發生計算長尾現象,個別任務實例處理緩慢,拖慢整個作業完成進度;二是基於單機調度的模式存在可靠性瓶頸,整體資源協調和任務容錯能力有限。這些問題導致數據產出的延遲風險依然較高,難以完全滿足業務對數據時效日益提升的要求。

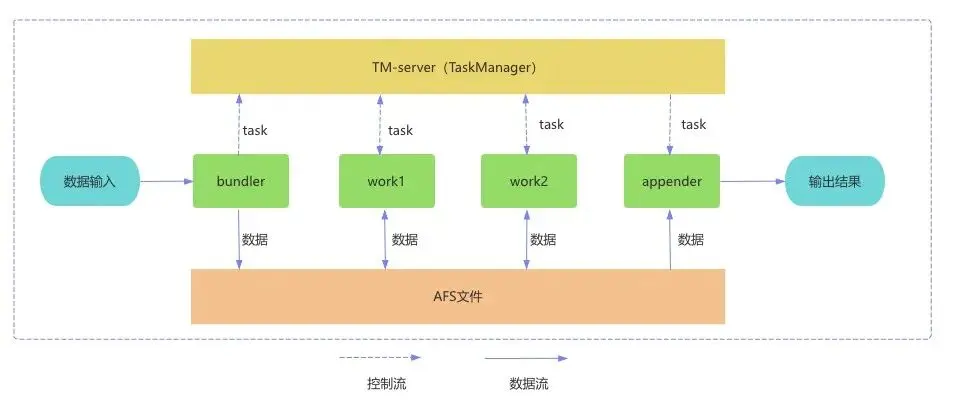

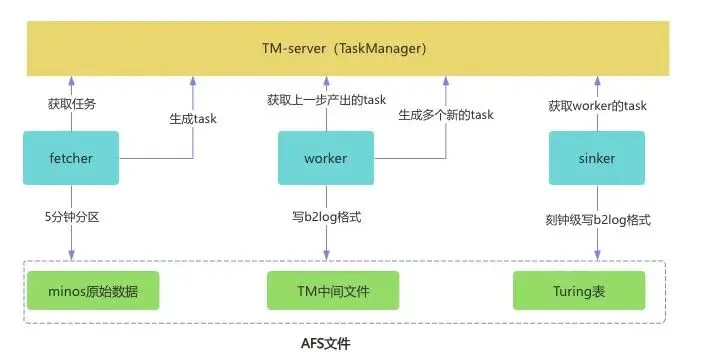

為解決上述痛點,經過充分的技術調研與架構評估,我們決定將計算框架升級為TM+Spark的組合方案。其中,TM(Task Manager)作為廠內自研的高性能流式處理框架,在多個關鍵維度上顯著優於原有的C++ MR架構。

TM(Task Manager):更高的容錯性和更強的穩定性

首先,在容錯性方面,TM具備更為智能和敏捷的錯誤恢復機制。當某個計算實例發生故障或執行緩慢時,TM調度系統能夠迅速感知並主動發起搶佔操作,將當前Task動態遷移至新的實例繼續處理,從而有效避免傳統MR框架中由於個別長尾任務導致的整體作業延遲。這一機制極大提升了作業的穩健性和執行效率。

其次,在調度穩定性方面,TM基於Opera調度系統進行資源管理與任務分配,這一調度架構具有高度解耦和資源隔離的特點。每個任務實例獨立運行,互不干擾,有效避免了在MR模式下由於同一隊列中其他高負載或異常作業所帶來的負面衝擊,從而保障關鍵數據處理任務的穩定性和可預期性。

此外,TM框架也在輸出存儲效率方面做出了重要升級。它原生支持輸出Parquet列式存儲格式,並集成ZSTD壓縮算法,在減少存儲空間佔用的同時大幅提升了後續查詢操作的I/O效率。這一改進使得數據在寫入階段就具備更優的列組織結構和壓縮特性,為下游分析提供了高性能的數據基礎。

主流開源框架Flink和TM的對比如下:

Spark:通過構建DAG,計算更高效;利用RDD或者DataFrame減少IO耗時;多線程機制,執行速度更快。

Spark對比MR的核心優勢:

- 速度:基於內存計算,無需反覆做讀寫操作,更加高效

- 高度集成:spark豐富的API和高級抽象的函數可以輕鬆實現複雜的邏輯計算和處理,無需和MR一般需要編寫複雜的處理邏輯

- 計算模型:內置的RDD數據結構可以提高數據計算的容錯性;查詢優化和執行優化可以適應複雜數據的處理和查詢

結合Spark通用計算引擎強大的分佈式內存計算能力和豐富的生態組件,新框架不僅解決了之前C++ MR模式中的長尾與調度瓶頸,還進一步實現了處理鏈路的統一與優化。Spark的高擴展性和TM的流式穩健性相結合,共同構建出一個容錯能力強、資源利用高效、運維負擔低的新一代數據處理架構,為業務提供更低延遲、更高可靠性的數據服務。

3.2 日誌分類分級

3.2.1 埋點上線不規範,被動兼容推高處理成本

在當前百度APP及其產品矩陣業務高速發展的背景下,日均處理日誌量已達3000億PV的龐大規模,數據流的穩定、高效與成本可控變得至關重要。

原有的埋點分類和校驗存在兩個突出的問題:

- 上報不規範:存在大量不經過日誌中台統一校驗而直接上線的業務打點,這些“非規範”打點格式各異、質量參差不齊,極易引發解析異常。

- 處理成本高:下游的日誌清洗ETL環節被迫陷入“被動兼容”的循環中,需要頻繁地跟進制訂適配規則以解析這些非標數據,不僅帶來了極高的運維成本,更因計算資源的無效消耗而加劇了整體處理鏈路的負擔,嚴重製約了數據產出的時效性與穩定性。

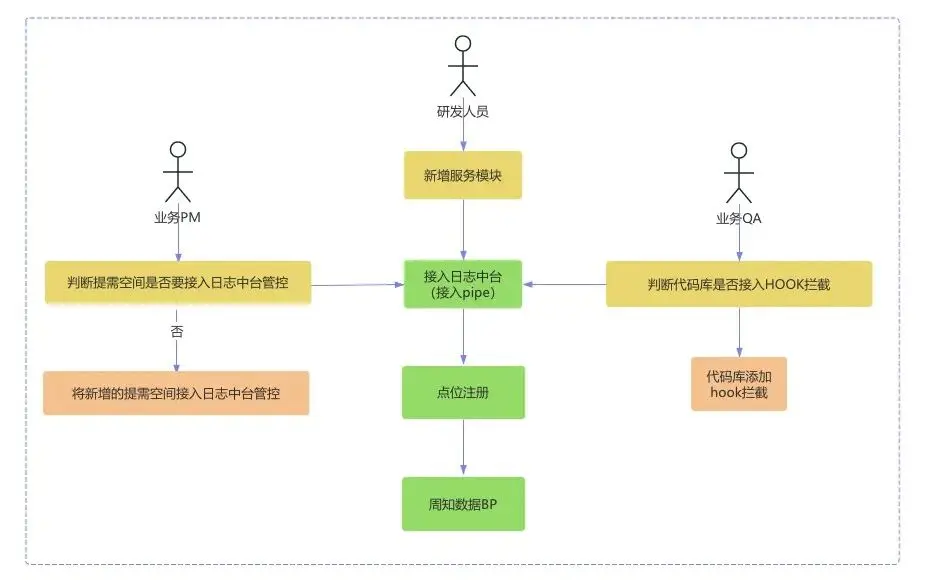

3.2.2 通過協同治理實現日誌中台全流量覆蓋

為從根本上破解這一難題,我們基於對百度APP及其產品矩陣數據全鏈路的深入洞察,發起了一項跨體系的協同治理工程。聯合了日誌中台團隊、各業務研發團隊、QA質量保障團隊及PMO項目管理團隊,形成了強有力的專項工作組。

第一階段的核心任務是對所有日誌模塊進行全域梳理。我們共同制定了統一的《新增業務模塊接入日誌中台規範》與《日誌埋點規範》,明確了從數據採集、上報到校驗的完整標準流程,並強力推動百度APP及其產品矩陣(包括主客户端及相關創新業務)的全量需求空間、代碼倉庫及日誌模塊,完成向日志中台的標準化接入遷移。這一舉措將日誌中台的流量覆蓋能力從治理前的約80%一舉提升至100%,實現了全流量管控。

更重要的是,我們在日誌中台增強了多項主動校驗能力:包括日誌長度校驗、關鍵公共參數完整性校驗、以及精確到需求ID的粒度校驗。這使得任何不合規的打點企圖在測試和上線階段就能被即時發現和攔截,實現了“問題早發現、早解決”的閉環管理,從而構築起覆蓋全場景的打點需求上線質量保障體系,從源頭上杜絕了異常日誌的產生。

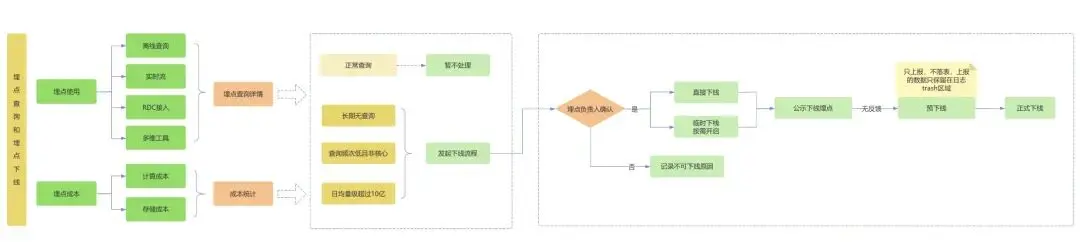

3.2.3 打破“只上不下”僵局,建立埋點生命週期管理

在成功建立起“入口”管控機制後,我們將治理重心轉向對歷史存量埋點的“出口”梳理與優化。長期以來,由於缺乏有效的評估手段,點位數據存在着“只增不減”的痼疾,大量廢棄或無效點位持續消耗着鉅額的計算和存儲資源。為此,我們創新性地從鑑權信息入手,通過對十幾類不同下游使用場景(包括內部報表、算法模型、RDC數據轉發服務等)的全面調研與信息收集,並對相關日誌解析鏈路進行深度分析,首次精準地繪製出以百度APP及其產品矩陣全量15000多個點位為起點的、覆蓋所有下游應用場景的“點位全鏈路使用地圖”。

基於這張價值地圖,我們清晰地識別出超過10000個點位已無任何下游業務使用或價值極低。通過嚴格的評估與協作流程,我們果斷對這些埋點進行了下線處理,下線比例高達存量點位的71%。此次大規模治理行動,不僅直接釋放了海量的計算和存儲資源,有效緩解了系統瓶頸,更打破了長達多年的“埋點只上不敢下”的歷史僵局,建立了點位的全生命週期管理模式,為後續數據的精細化管理與成本優化奠定了堅實基礎。

3.3 AB實驗數據扇出處理

3.3.1 現狀與問題

在數據驅動的業務迭代中,A/B實驗平台的指標建設和效果評估能力至關重要。然而,隨着業務快速擴張和實驗複雜度的提升,原有的實驗數倉架構逐漸顯露出嚴重瓶頸。平台最初是在通用數倉分層模型的基礎上,採用“每個指標單獨計算”的模式進行建設。這種設計在初期雖然靈活,但隨着實驗數量和指標數量的急劇增長,計算鏈路變得異常複雜、冗餘且難以維護。由於缺少與公司數據中台團隊的深度協同和標準化約束,每次新增實驗指標都需要大量重複開發,導致實驗數據需求的交付週期不斷延長,嚴重拖慢了業務迭代速度,引發了業務團隊的負反饋。

3.3.2 解決方案

(1)分析過程

理想的解決方案是直接複用百度APP及其產品矩陣已有的標準化大寬表進行實驗指標配置。即基於一張集成所有關鍵維度與指標的大寬表,快速定義和產出實驗分析所需的數據集。然而,現實情況卻更為複雜:百度APP及其產品矩陣客户端同時線上進行的實驗數量極多,平均每個cuid(用户唯一標識)對應的實驗ID(sid)字符長度已超過2400字符。這個長度幾乎相當於單條日誌原始存儲容量的40%,如果直接將實驗ID維度接入寬表,將導致每條日誌存儲膨脹近一倍。這不僅會帶來極高的存儲成本,也會大幅增加下游所有數據應用的數據掃描量和傳輸開銷,嚴重拖慢查詢性能,進而影響整個數據鏈路的效率。

(2)設計思路

面對這一獨特挑戰,我們並未選擇傳統的寬表集成方案,而是從數據生成的源頭實施了更根本的架構優化。我們重點對實驗ID映射關係進行了拆分和重構:將sid與核心行為數據解耦,設計並建設了獨立的sid維表。該維表直接從日誌源頭統一生成,整合了來自客户端的實驗曝光及分組信息,並實現了對業務方、評估方各自獨立建設的多套映射關係的全面統一。這一舉措不僅從本質上避免了主寬表的存儲膨脹,還徹底解決了因數據來源不一致而導致的實驗效果評估diff問題,顯著提高了實驗數據的準確性和可信度。

(3)成果與收益

在此基礎上,A/B實驗平台的分析查詢不再依賴於對超大寬表的直接掃描,而是通過sid維表與核心行為寬表進行動態拼接的方式實現指標計算。

在指標口徑對齊方面,已完成實驗類指標與OKR指標的口徑統一工作,累計對齊上線指標2000餘個,覆蓋多個主題和維度。實驗指標改由數據中心寬表統一生產,顯著減少了以往在指標口徑溝通與對齊方面的成本;在實驗效率提升顯著,指標開發環節通過複用寬表及數倉下沉邏輯,並升級計算框架,使常規需求開發週期從原先2周以上縮短至1周內,開發效率提升超50%。同時核心指標計算SLA由T+14小時提升至T+10小時,處理時效明顯提高;在計算資源成本方面,通過整體數據流複用和抽樣日誌整合優化,實現了計算資源成本的有效降低。另外,聯動產品及策略團隊治理並下線無效實驗指標超1800+,釋放的資源進一步支撐了新場景的指標建設需求。

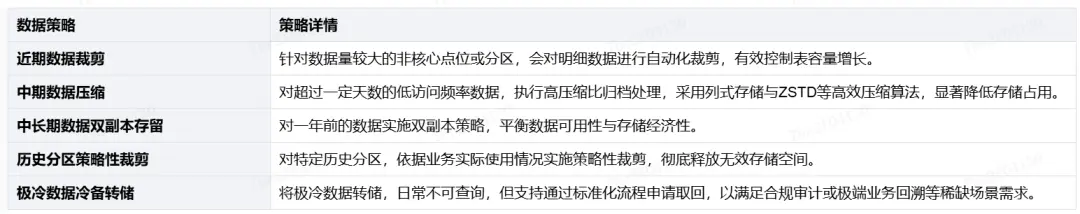

4. 分級存儲治理

隨着業務規模的持續擴張與產品矩陣的不斷豐富,百度APP及其產品矩陣業務的日誌數據量呈現指數級增長,單張核心Turing數據表的存儲量已達到百PB級別,面臨巨大的存儲與成本壓力。傳統的統一存儲週期策略難以適應當前複雜的使用場景:一方面,大量短期數據被無效保留,佔用鉅額存儲資源;另一方面,部分核心業務場景仍需依賴長週期歷史數據進行跨年指標對比、關鍵數據需求回溯與深度建模分析。

為解決這一矛盾,我們針對Turing表啓動了多維度的精細化存儲治理工作。通過深入分析業務使用特徵與數據訪問頻率,我們建立了差異化的數據生命週期管理機制,實施“熱->温->冷”三級數據分層存儲策略。對高頻訪問的近期數據全部保留,對訪問頻率較低的長期歷史數據自動進行轉儲、壓縮或者裁剪等,並配套建立完備的數據取回與回溯流程。

該項治理在充分保障核心業務長週期數據使用需求的前提下,顯著壓縮了整體存儲規模,實現了存儲成本的大幅優化,為未來數據的可持續增長與高效管理奠定了堅實基礎。

具體實施策略:

03 總結與展望

隨着業務規模的持續擴張和產品矩陣的不斷豐富,數據量呈現指數級增長,這一趨勢持續驅動着數據處理架構與模型的演進與迭代,同時也對數據分析的敏捷性、易用性和可靠性提出了更高要求。在數倉系統全面升級的過程中,我們着力優化數據處理全鏈路,通過改進調度機制、減少計算環節、強化故障自動恢復能力,顯著縮短了整個數據處理流程的時長,有效識別並排除多項潛在穩定性風險。此外,依託於對全端埋點體系的系統化梳理與標準化規範,構建了高質量、可複用的數據資產底座。

本次整體架構的升級為業務提供了堅實的數據支撐,在數據時效性、準確性和使用便捷性方面均實現顯著提升。作為百度體系內最核心且數據規模最大的業務板塊,百度APP仍面臨數據持續激增帶來的諸多挑戰,包括埋點規範統一難度高、技術棧兼容與選型約束多、日誌解析複雜度高、存儲結構靈活多變以及成本控制壓力增大等問題。

面向未來,我們將持續推進數倉架構的深度優化,重點圍繞埋點治理、架構升級、效能提升、存儲模型優化和資源精細化管理等方面展開工作。目標是構建一套具備更高時效性、更優數據模型、更低存儲與計算成本的全新一代數倉鏈路,為業務創新與決策提供高效、可靠、低成本的數據服務能力。