作者 | 飛槳

導讀

飛槳框架2.4版本迎來正式發佈啦!相比飛槳框架2.3版本,飛槳框架v2.4增加了167個功能性API,新增稀疏計算(paddle.sparse)、圖學習(paddle.geometric)和語音處理(paddle.audio)等更多領域API,同時也進一步完善了loss計算、張量計算、分佈式和視覺變換等類別的API,在提供了更加豐富的API體系的同時更好地支持深度學習稀疏計算、圖學習、語音領域的快速迭代和創新、不斷擴展對3D點雲、Sparse Transformer等場景應用的支持,加速創新,讓基於深度學習的應用開發更簡單!

全文9947字,預計閲讀時間25分鐘.

一、全面支持主流模型稀疏化訓練及推理

當前越來越多的場景有稀疏計算的需求,例如3D點雲圖像處理和NLP中的稀疏Attention等。神經網絡的稀疏化可以提高網絡的性能,減少計算量及內存/顯存的佔用,已成為深度學習的研究熱門之一。飛槳v2.4新增瞭如下稀疏類API,支持主流稀疏模型的訓練和推理,並支持多種稀疏Tensor格式及稀疏Tensor與稠密Tensor的混合計算,同時其名稱和使用方式與常規稠密Tensor的API保持一致,方便記憶且容易上手。

稀疏基礎計算API:

-

一元計算:

paddle.sparse.sin/sinh/tan/tanh/expm1/log1p/pow/square/sqrt/abs/cast/neg...

-

二元計算:

paddle.sparse.add/substract/multiply/divide...

-

矩陣和向量計算:

paddle.sparse.matmul/masked\_matmul/addmm/mv...

-

數據變形:

paddle.sparse.transpose/reshape...

稀疏組網API:

-

網絡層:

paddle.sparse.nn.Conv3D/SubmConv3D/MaxPool3D/BatchNorm...

-

激活層:

paddle.sparse.nn.ReLU/ReLU6/LeakyReLU/Softmax...

Part1 覆蓋稀疏計算主流應用場景

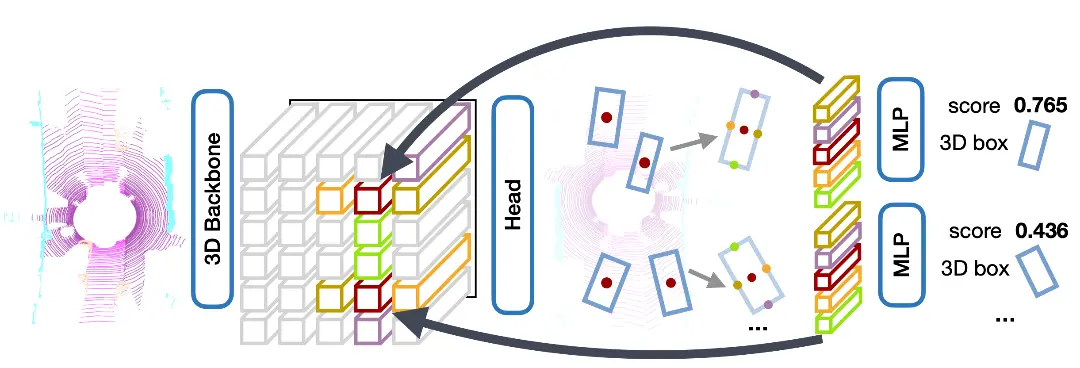

3D點雲目標檢測

CenterPoint是一種物體檢測器,以點雲作為輸入,將三維物體在Bird-View下的中心點作為關鍵點,基於關鍵點檢測的方式迴歸物體的尺寸、方向和速度。

飛槳框架v2.4完整提供了這類模型需要的稀疏SubmanifoldConv3D/Conv3D、稀疏BatchNorm和稀疏ReLU等API。模型的訓練評估、動轉靜及推理的各項功能均已完全實現,歡迎試用。實測比業界同類競品提速4%,訓練精度提升0.2%。

- CenterPoint模型介紹

https://github.com/PaddlePadd...

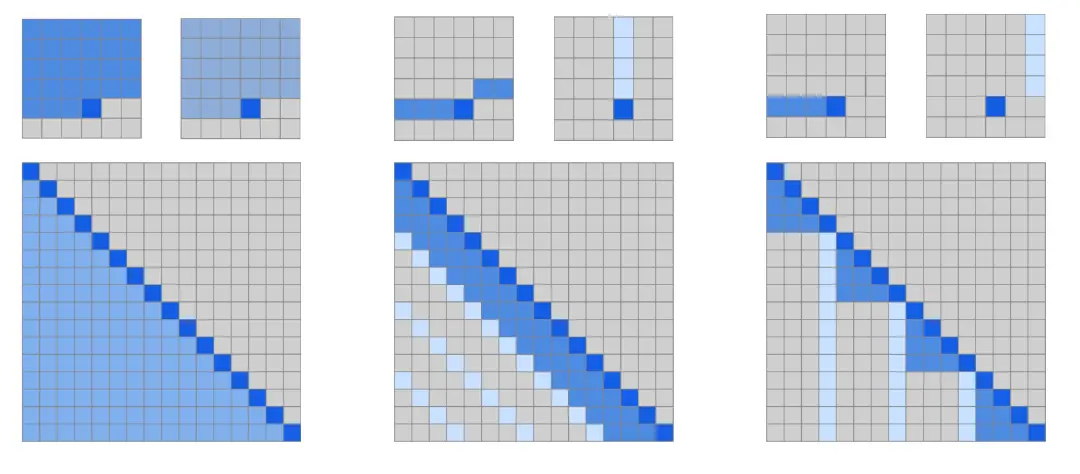

Sparse Transformer

稀疏Transformer與經典的稠密Transformer相比,能支持更長的輸入序列,得到更好的網絡性能。

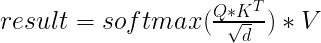

稀疏Attention的核心計算邏輯為:

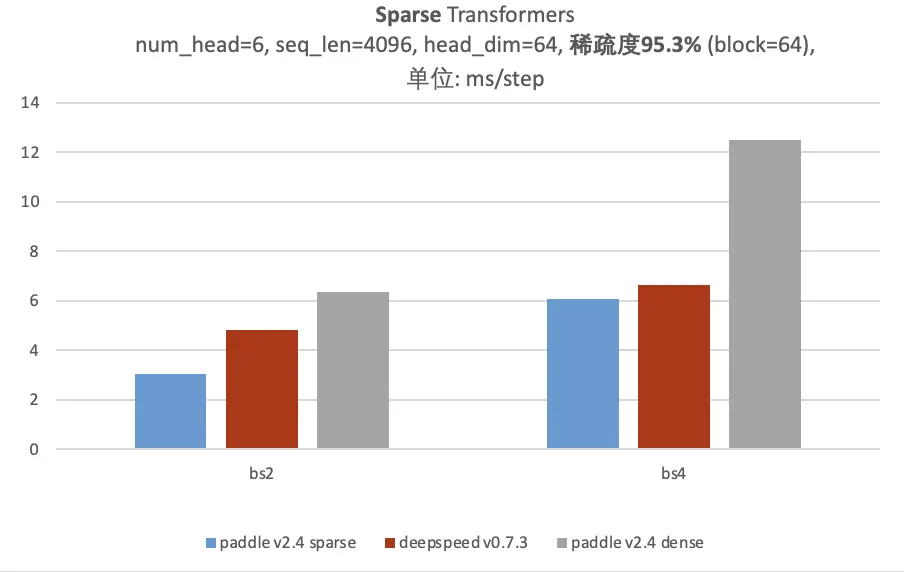

飛槳框架v2.4提供稀疏矩陣乘、稀疏softmax等運算,可完整支持SparseTransformer的運算。在高稀疏度場景下,相比使用DenseTensor提速105.75%,相比同類產品稀疏計算提速4.01%~58.55%,極致節省顯存並提升性能。

Part2 支持多種稀疏Tensor格式及稀疏Tensor與稠密Tensor的混合計算**

飛槳API支持最常使用的稀疏數據COO和CSR格式。COO為稀疏數據座標格式,CSR為壓縮行信息格式。不同格式的稀疏數據使用場景不同,其中SparseConv3D更適合處理COO格式的數據,SparseTransformer中有較多取整行的操作,更適合處理CSR格式的數據,能更好降低計算複雜度。雖然這些API有不同的格式傾向,但是飛槳稀疏API在設計時,每個都儘可能支持多種稀疏格式,這樣在不同模型場景下處理不同的數據格式時都可以使用相同的API,不用修改代碼,更靈活且更能極致提升性能。

以ReLU激活函數為例,其支持處理不同的稀疏Tensor:

# 稀疏COO Tensorcoo = paddle.sparse.sparse_coo_tensor( indices = [[0, 1, 2], [1, 2, 0]], values = [1., 2., 3.], shape = [3, 3])out = paddle.sparse.nn.functional.relu(coo)# 稀疏CSR Tensorcsr = paddle.sparse.sparse_csr_tensor( crows = [0, 1, 2, 3], cols = [1, 2, 0], values = [1., 2., 3.], shape = [3, 3])out = paddle.sparse.nn.functional.relu(csr)除了支持不同的稀疏格式外,對於二元計算及矩陣向量計算等API,還支持多種稀疏格式和常規的稠密格式(Dense Tessor)的混合計算,網絡可以部分使用傳統組網,部分使用稀疏,更方便已有模型的優化:

# COO與Dense矩陣乘,返回稠密Tensorcoo = paddle.sparse.sparse_coo_tensor( indices = [[0, 1, 2], [1, 2, 0]], values = [1., 2., 3.], shape = [3, 3])dense = paddle.rand([3, 2])out = paddle.sparse.matmul(coo, dense)# CSR與Dense矩陣乘,返回稠密Tensorcsr = paddle.sparse.sparse_csr_tensor( crows = [0, 1, 2, 3], cols = [1, 2, 0], values = [1., 2., 3.], shape = [3, 3])dense = paddle.rand([3, 2])out = paddle.sparse.matmul(csr, dense)# Dense與Dense矩陣乘,返回稀疏Tensorx = paddle.rand([3, 5])y = paddle.rand([5, 4])mask = paddle.sparse.sparse_csr_tensor( crows = [0, 2, 3, 5], cols = [1, 3, 2, 0, 1], values= [1., 2., 3., 4., 5.], shape = [3, 4])out = paddle.sparse.masked_matmul(x, y, mask)Part3 名稱和使用方式與常規稠密Tensor的API保持一致,方便記憶且容易上手

一般模型中使用的API都是處理稠密數據(Dense Tensor)的API。飛槳SparseAPI在設計之初就考慮儘可能降低理解成本,與常規處理稠密數據(Dense Tensor)的API保持風格一致,方便用户快速上手。

以模型中一段ResNet稀疏網絡的代碼為例:

import paddlefrom paddle import sparsefrom paddle.sparse import nnclass SparseBasicBlock(paddle.nn.Layer): def __init__( self, in_channels, out_channels, stride=1, downsample=None, ): super(SparseBasicBlock, self).__init__() self.conv1 = nn.SubmConv3D( in_channels, out_channels, kernel_size=3, stride=stride, padding=1) self.bn1 = nn.BatchNorm(out_channels, epsilon=1e-3, momentum=0.01) self.relu = nn.ReLU() self.conv2 = nn.SubmConv3D( out_channels, out_channels, kernel_size=3, stride=stride, padding=1) self.bn2 = nn.BatchNorm(out_channels, epsilon=1e-3, momentum=0.01) self.downsample = downsample def forward(self, x): identity = x out = self.conv1(x) out = self.bn1(out) out = self.relu(out) out = self.conv2(out) out = self.bn2(out) if self.downsample is not None: identity = self.downsample(x) out = sparse.add(out, identity) out = self.relu(out) return out可以看到,ResNet稀疏網絡的代碼和常規ResNet網絡代碼幾乎沒有差別,只需要通過paddle.sparse.*替代paddle.*即可,源於飛槳Sparse系列API在整體使用上與Dense系列API高度一致。如果能夠增加import路徑替換,甚至原網絡代碼都無需改動。例如通過frompaddle.sparseimportnn,則可保持與原來的nn.*寫法完全一致,更易於上手。

二、新增圖學習類API,支持高效圖學習計算

近幾年,圖學習相關研究發展迅速,在自然語言處理、計算機視覺、推薦系統、生物化學等領域具有較為廣泛的應用和發展。圖學習逐漸成為機器學習領域的關鍵技術,本次飛槳框架v2.4新增paddle.geometric圖學習類API,提供更好的圖學習建模和高效圖學習計算體驗。

Part1 高效圖消息傳遞

現有的大多數圖學習框架在進行圖模型設計時,通常採用圖消息傳遞機制的經典範式。飛槳框架v2.4新增圖學習消息傳遞API,支持高效圖消息傳遞。其中,新增的send\_u\_recv、send\_ue\_recv、send\_uv共計3個API,通過實現原子級別的消息發送與接收,大大減少了冗餘的中間顯存變量佔用,從而帶來顯著的顯存收益。在稠密圖場景下,GCN、GAT等經典圖神經網絡模型可節省50%+的顯存,並可進一步提升訓練速度約20%。各個send\_recv系列API支持sum、mean、max、min共計4個消息聚合方式,在節點特徵與邊特徵交互時則支持add、sub、mul、div共計4種計算方式。使用方式示例如下:

import paddlex = paddle.to_tensor([[0, 2, 3], [1, 4, 5], [2, 6, 7]], dtype="float32")y = paddle.to_tensor([1, 1, 1, 1], dtype="float32")indexes = paddle.to_tensor([[0, 1], [1, 2], [2, 1], [0, 0]], dtype="int32")src_index, dst_index = indexes[:, 0], indexes[:, 1]out = paddle.geometric.send_ue_recv(x, y, src_index, dst_index, message_op="add", reduce_op="sum")Part2 高性能圖採樣

圖採樣步驟對於圖採樣模型特別是在大圖場景下是非常有必要的,但同時也是圖模型訓練的性能瓶頸。本次新增了高性能圖採樣API,支持高併發圖採樣,加快圖採樣模型採樣和訓練效率,經典圖模型Graphsage的採樣速度可提升32~142倍,訓練速度可提升12~57倍。除了支持純GPU採樣和CPU採樣之外,還可以支持藉助UVA(Unified Virtual Addressing,統一虛擬尋址)技術,將圖結構放置在內存中進行GPU採樣,該實現方式在大圖場景下非常有效。簡單示例如下:

import paddlefrom paddle.fluid import corerow = np.array([3, 7, 0, 9, 1, 4, 2, 9, 3, 9, 1, 9, 7])colptr = np.array([0, 2, 4, 5, 6, 7, 9, 11, 11, 13, 13])row = core.eager.to_uva_tensor(row)colptr = core.eager.to_uva_tensor(colptr)nodes = paddle.to_tensor([0, 8, 1, 2])sample_size = 2# 鄰居採樣API的輸入要求圖結構信息為CSC格式neighbors, neighbor_count = paddle.geometric.sample_neighbors(row, colptr, nodes, sample_size=sample_size)# 生成重編號後的邊reindex_src, reindex_dst, out_nodes = paddle.geometric.reindex_graph(nodes, neighbors, neighbor_count)三、新增語音領域類API

近幾年,智能語音領域快速迅速,深度學習領域產生了很多語音訓練處理基礎能力的需求。本次飛槳框架v2.4新增paddle.audio類API提供了語音基礎處理能力,提升了語音建模和學習便捷性。

Part1 高效的特徵提取模塊

特徵提取模塊是深度學習語音領域最基礎的模塊,特別在大規模數據訓練和推理過程中,其速度為一個性能瓶頸。本次新增MFCC、Spectrogram、LogMelSpectrogram等特徵提取API,支持GPU計算,相比CPU實現處理性能提升15倍以上,可大幅提升語音模型訓練GPU利用率,達到快速訓練和推理的效果。使用示例如下:

import paddlefrom paddle.audio.features import LogMelSpectrogram#設置音頻相關參數sample_rate = 16000wav_duration = 0.5num_channels = 1num_frames = sample_rate * wav_durationwav_data = paddle.linspace(-1.0, 1.0, num_frames) * 0.1waveform = wav_data.tile([num_channels, 1])#設置特徵提起器相關參數feature_extractor = LogMelSpectrogram(sr=sample_rate, n_fft=512, window = 'hann', power = 1.0)feats = feature_extractor(waveform)Part2 音頻處理基礎模塊

深度學習語音領域,除了傳統的經典模型外,還有很多語音前端處理的實驗需要進行,定製化語音特徵的需求應運而生。本次新增窗函數、離散餘弦變換等特徵提取基礎API,方便用户自定義語音特徵提取,方便完成定製化需求。使用示例如下:

import paddle#cosine窗函數示例n_fft = 512cosine_window = paddle.audio.functional.get_window('cosine', n_fft)#高斯窗函數std = 7gaussian_window = paddle.audio.functional.get_window(('gaussian',std), n_fft)#離散餘弦變換示例n_mfcc = 23n_mels = 257dct = paddle.audio.functional.create_dct(n_mfcc, n_mels)Part3 語音IO模塊

對各種語音數據進行讀取是音頻處理的基礎。現實場景中語音的編碼格式各式各樣,所以需要IO模塊靈活地支持多種格式。飛槳框架v2.4新增語音IO模塊,提供2種音頻I/Obackend,支持6種編解碼,便捷地實現語音數據的加載。使用示例如下:

import osimport paddle#設置相關參數,生成示例音頻sample_rate = 16000wav_duration = 0.5num_channels = 1num_frames = sample_rate * wav_durationwav_data = paddle.linspace(-1.0, 1.0, num_frames) * 0.1waveform = wav_data.tile([num_channels, 1])base_dir = os.getcwd()filepath = os.path.join(base_dir, "test.wav")#保存和提取音頻信息paddle.audio.save(filepath, waveform, sample_rate)wav_info = paddle.audio.info(filepath)#wav_info中會有sample_rate, num_frames, num_channels等信息Part4 語音分類數據集

在訓練深度學習語音模型的時候,方便地下載處理數據集會為模型訓練帶來便捷。飛槳框架v2.4新增TESS、ESC50語音分類數據集。用户不必進行復雜的預處理,可以方便地啓動訓練流程,便捷地完成訓練。用户也可以依照此代碼,方便定製自己的數據集。使用示例如下:

import paddlemode = 'dev'esc50_dataset = paddle.audio.datasets.ESC50(mode=mode, feat_type='raw')for idx in range(5): audio, label = esc50_dataset[idx] # do something with audio, label print(audio.shape, label) # [audio_data_length] , label_idesc50_dataset = paddle.audio.datasets.ESC50(mode=mode, feat_type='mfcc', n_mfcc=40)for idx in range(5): audio, label = esc50_dataset[idx] # do something with mfcc feature, label print(audio.shape, label) # [feature_dim, length] , label_id四、其它新增的API

除了以上描述的幾類新增API,飛槳框架v2.4還對已有的一些API類別進行了擴充。

Part1 loss計算API

為了更方便地支持各種組網的loss計算需求,飛槳框架v2.4擴充了多個loss計算的API,包括:

- paddle.nn.functional.cosine\_embedding\_loss根據label類型,計算2個輸入之間的CosineEmbedding損失。

- paddle.nn.functional.soft\_margin\_loss計算輸入和label間的二分類softmargin損失。

- paddle.nn.functional.multi\_label\_soft\_margin\_loss計算輸入和label間的多分類最大熵損失。

- paddle.nn.functional.triplet\_margin\_loss和paddle.nn.functional.triplet\_margin\_with\_distance\_loss計算輸入與正樣本和負樣本之間的相對相似性,後者可自定義距離計算函數。

Part2 張量計算API

飛槳框架2.3之前的版本實現了很多基礎的張量計算API,飛槳框架2.4版本基於這些基礎API,通過組合的方式擴充了張量計算API,方便用户直接使用,包括:

- 新增paddle.sgn取複數的單位值和實數的符號。

- 新增paddle.count\_nonzero沿給定的軸統計輸入張量中非零元素的個數。

- 新增paddle.take將輸入張量視為一維,返回指定索引上的元素集合。

- 新增paddle.bucketize根據給定的一維桶劃分,得到輸入張量對應的桶索引。

- 新增paddle.triu\_indices和paddle.tril\_indices分別取二維張量(矩陣)中上/下三角矩陣元素的行列座標。

- 新增paddle.heaviside計算赫維賽德階躍函數。

- 新增paddle.nanmedian和paddle.nanquantile忽略張量中的nan值,分別計算出中位數和分位數值。

Part3 分佈式API

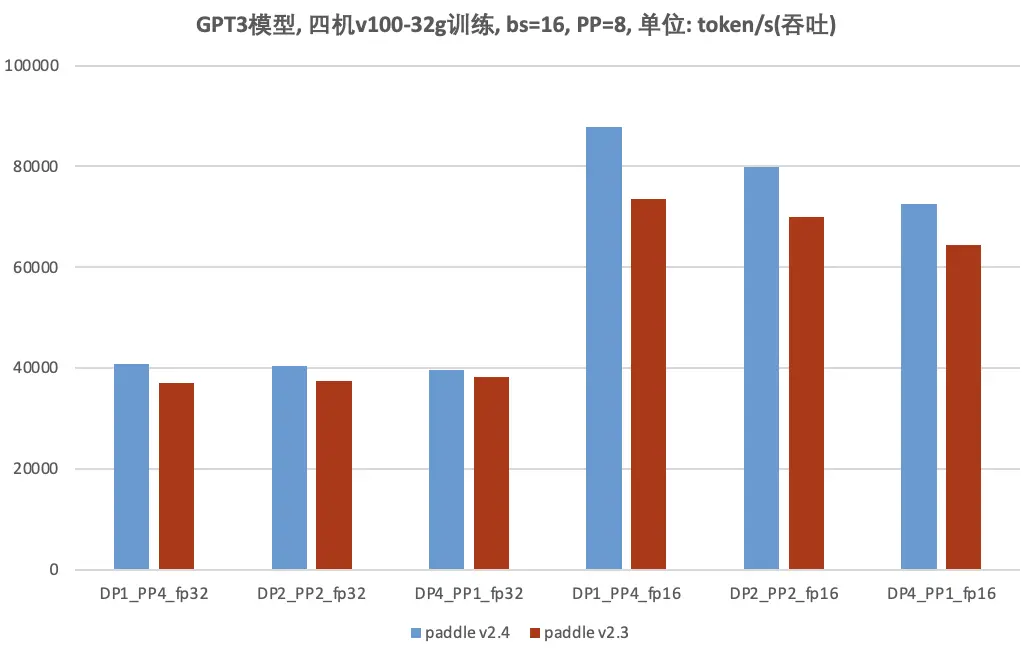

新增10個分佈式通信API,如paddle.distributed.communication.stream.all\_gather等,支持在主計算流上做通信,降低了在流切換、事件等待時的性能開銷,能夠使分佈式GPT3模型訓練提速11.35%。

Part4 視覺變換API

基於飛槳基礎API,擴充了paddle.vision.transforms中視覺變換API,包括:

- paddle.vision.transforms.affine和paddle.vision.transforms.RandomAffine對圖像進行仿射變換,後者使用隨機產生的仿射變換矩陣參數。

- paddle.vision.transforms.erase和paddle.vision.transforms.RandomErasing使用給定的值擦除輸入圖像中的像素,前者是選定區域,後者是隨機區域。

- paddle.vision.transforms.perspective和paddle.vision.transforms.RandomPerspective對圖像進行透視變換,前者是選定區域,後者是隨機區域,兩者都可以選擇插值方法。

除了上面的介紹外,飛槳框架v2.4還擴充了一些組網類(如paddle.nn.ChannelShuffle)、輔助類(如paddle.iinfo)等API,詳細列表可點擊下方鏈接或者閲讀鏈接參考Release Note。

- Release Note地址

https://github.com/PaddlePadd...

五、結語

飛槳框架的建設除了來自百度的工程師外,還有一批熱愛飛槳、熱愛開源的開發者,他們正在用自己的方式參與飛槳框架的建設,與飛槳共同成長。在飛槳框架v2.4中,有約三分之一的新增API由社區開發者貢獻,飛槳的繁榮離不開廣大開發者的使用與支持。

飛槳框架v2.4逐步形成了成熟的API開發範式,框架的開發難度持續降低。配合官方提供的標準開發環境,飛槳社區開發者可以更加順暢地完成飛槳API開發與貢獻。具體體現在:

- 簡化API開發步驟:飛槳框架v2.4完成了基礎框架算子體系重構,構造高可複用的PHI算子庫(Paddle HIgh reusability operator library),支持基於已有的算子內核以及Kernel Primitives API組合實現新的算子,支持插件式接入新硬件或者新加速庫。PHI算子庫的成熟,提升了飛槳API的開發效率,並形成了通用的API開發流程,使得開發者可以更加簡潔流暢地參與飛槳API的開發與貢獻。

- 發佈標準API貢獻指南:飛槳框架v2.4形成了標準的API貢獻指南,包括貢獻流程與操作指南、API設計文檔模板、API代碼模板、API文檔寫作規範,為飛槳社區開發者提供清晰的文檔指引與輔助,使得開發者可以快速上手。

- 提供標準開發環境:飛槳AIStudio平台推出標準開發環境,為開發者提供飛槳鏡像環境、在線IDE與專屬GPU算力,登錄即可開發調試,免去環境配置與算力限制,隨時隨地參與飛槳框架的開發與貢獻。

飛槳框架v2.4提供了更加豐富的API體系,不僅更好地支持深度學習稀疏計算、圖學習、語音領域的快速迭代和創新,而且不斷擴展對3D點雲、Sparse Transformer等場景應用的支持,同時也不斷優化飛槳API的使用體驗,更好地支持業界論文中模型的實現,加速創新,讓基於深度學習的應用開發更簡單!

—— END——

推薦閲讀:

百度工程師帶你瞭解Module Federation

巧用Golang泛型,簡化代碼編寫

Go語言DDD實戰初級篇

Diffie-Hellman密鑰協商算法探究

貼吧低代碼高性能規則引擎設計

淺談權限系統在多利熊業務應用