QwQ 是 Qwen 系列的推理模型,相比傳統指令調優模型,QwQ 具備思考和推理能力,在下游任務尤其是難題上能取得顯著性能提升。QwQ-32B 是中型推理模型,能夠與 DeepSeek-R1、o1-mini 等最先進的推理模型取得競爭性性能。\

教程鏈接:https://go.openbayes.com/d6USh

使用雲平台:OpenBayes\

http://openbayes.com/console/signup?r=sony\_0m6v

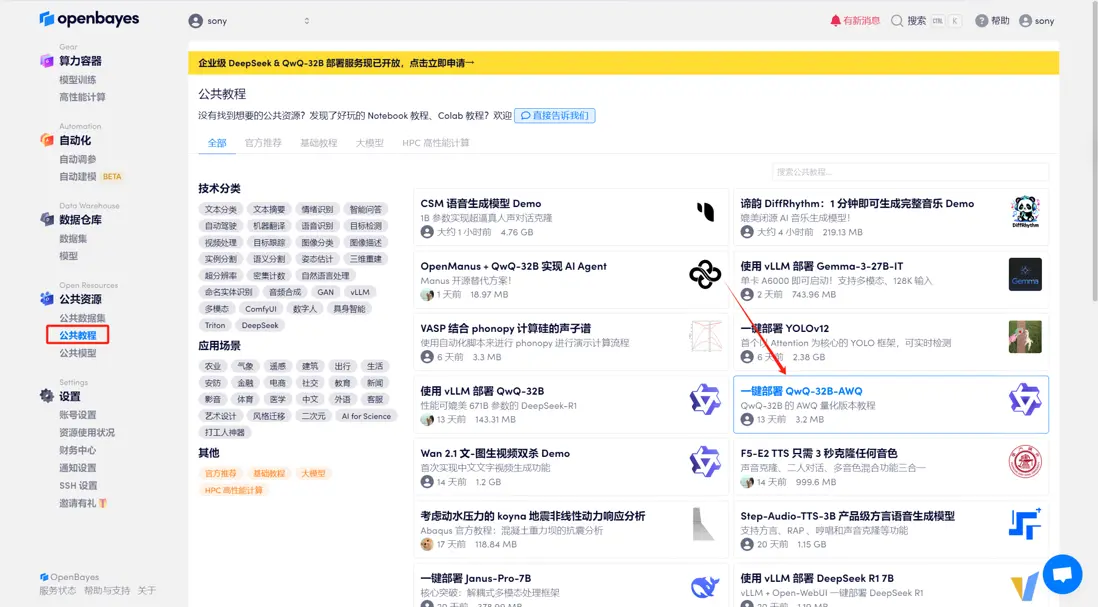

登錄 http://OpenBayes.com,在「公共教程」頁面,選擇鍵部署 「一鍵部署 QwQ-32B-AWQ」教程。

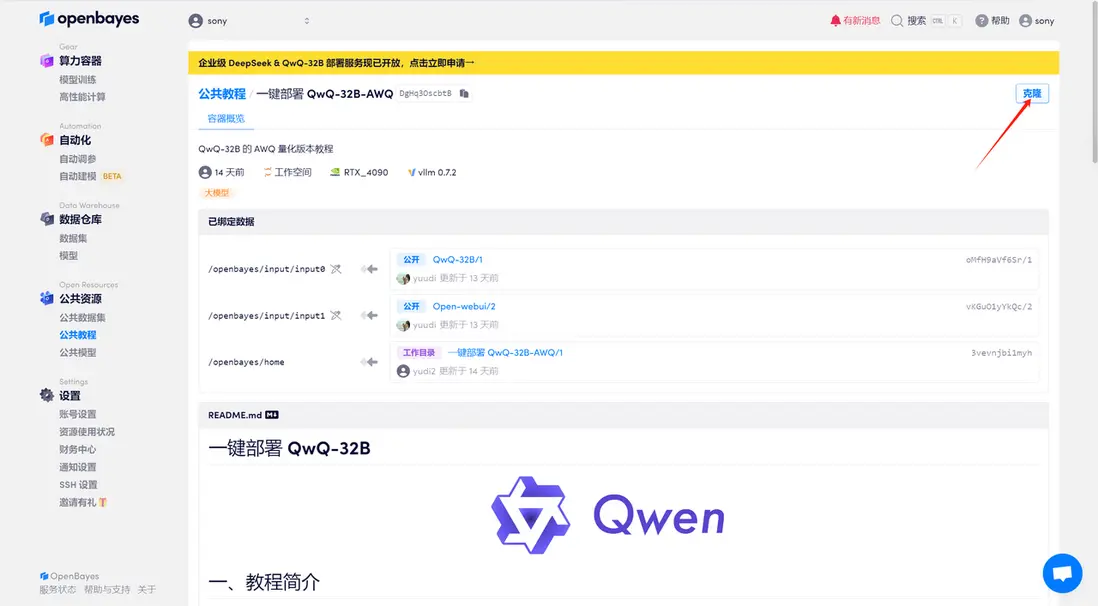

頁面跳轉後,點擊右上角「克隆」,將該教程克隆至自己的容器中。

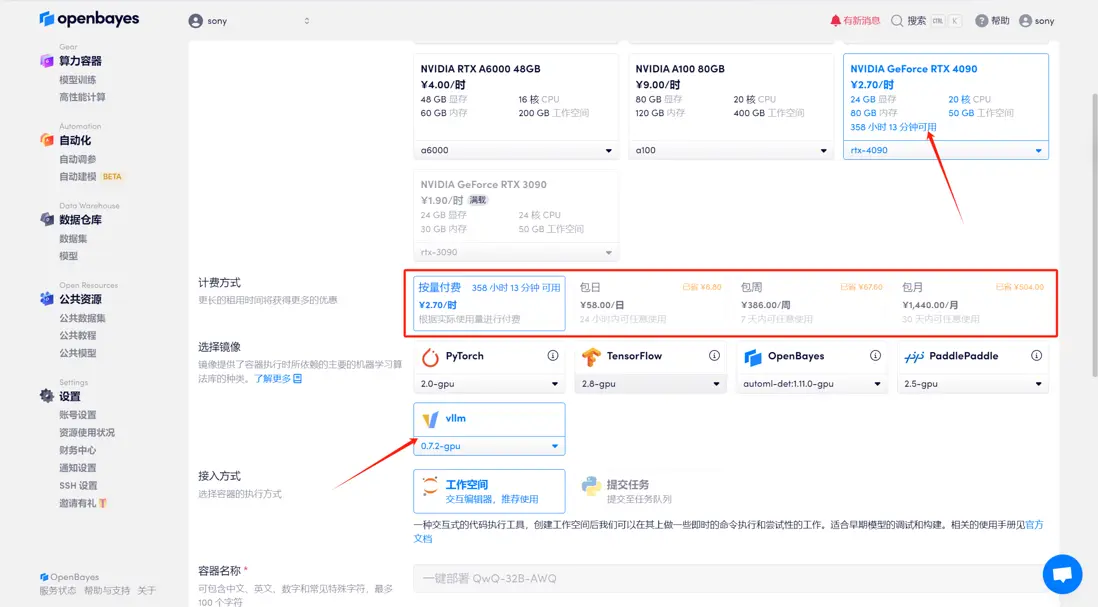

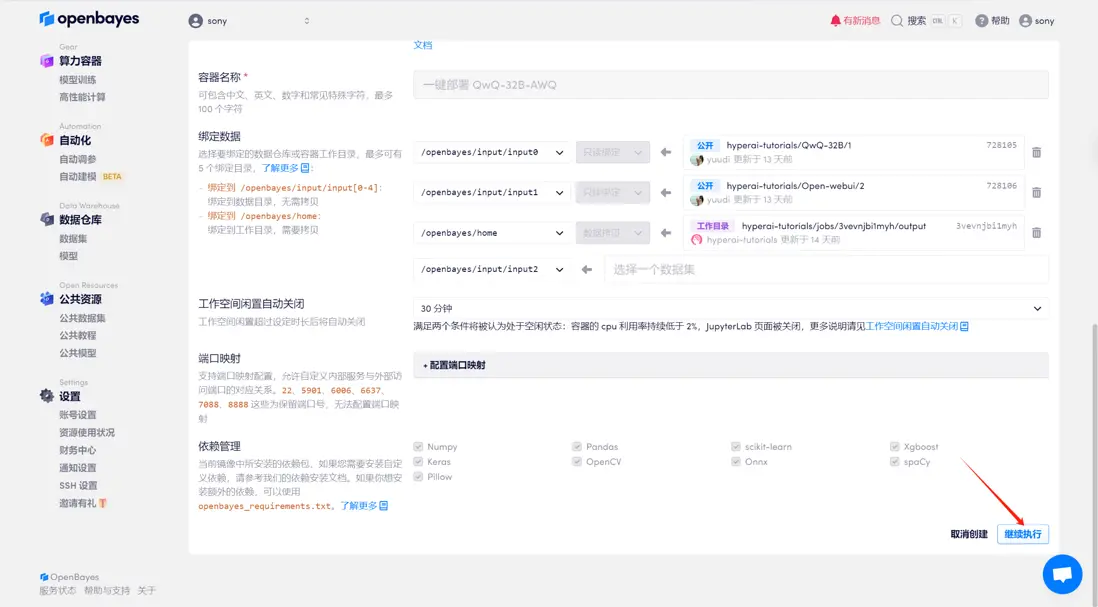

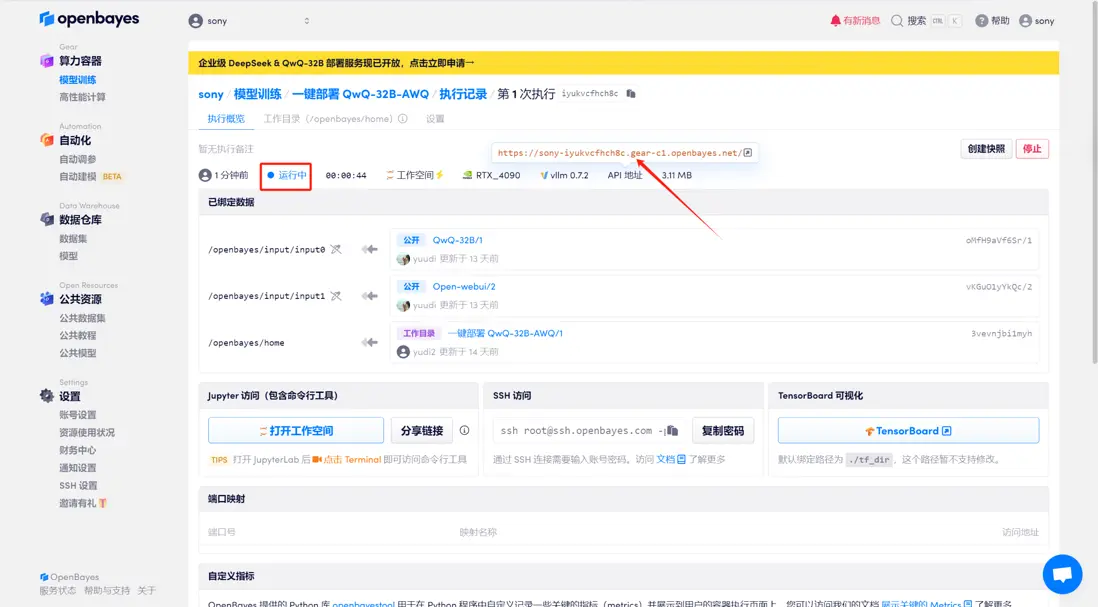

選擇「NVIDIA GeForce RTX 4090」以及「vLLM」鏡像,OpenBayes 平台上線了新的計費方式,大家可以按照需求選擇「按量付費」或「包日/周/月」,點擊「繼續執行」。可以使用文章開頭的邀請鏈接,獲得 RTX 4090 使用時長!

稍等片刻,待系統分配好資源,當狀態變為「運行中」後,點擊「API 地址」邊上的跳轉箭頭,即可跳轉至 Demo 頁面。

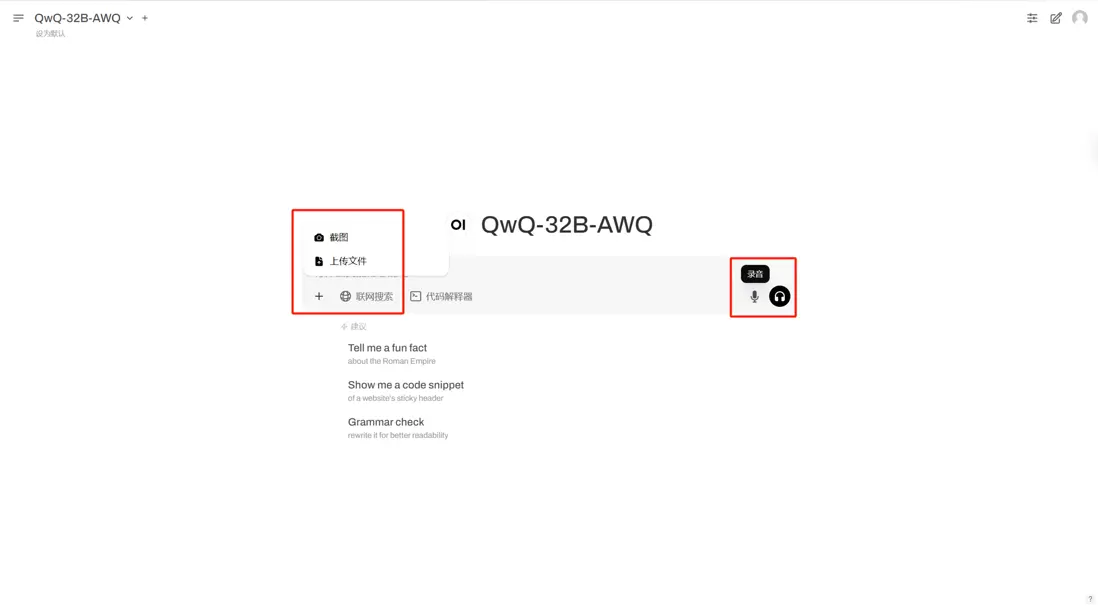

進入網頁後,即可與模型展開對話。在中間的輸入框輸入對話內容,模型支持文本輸入、圖片上傳、文件上傳和語音輸入。

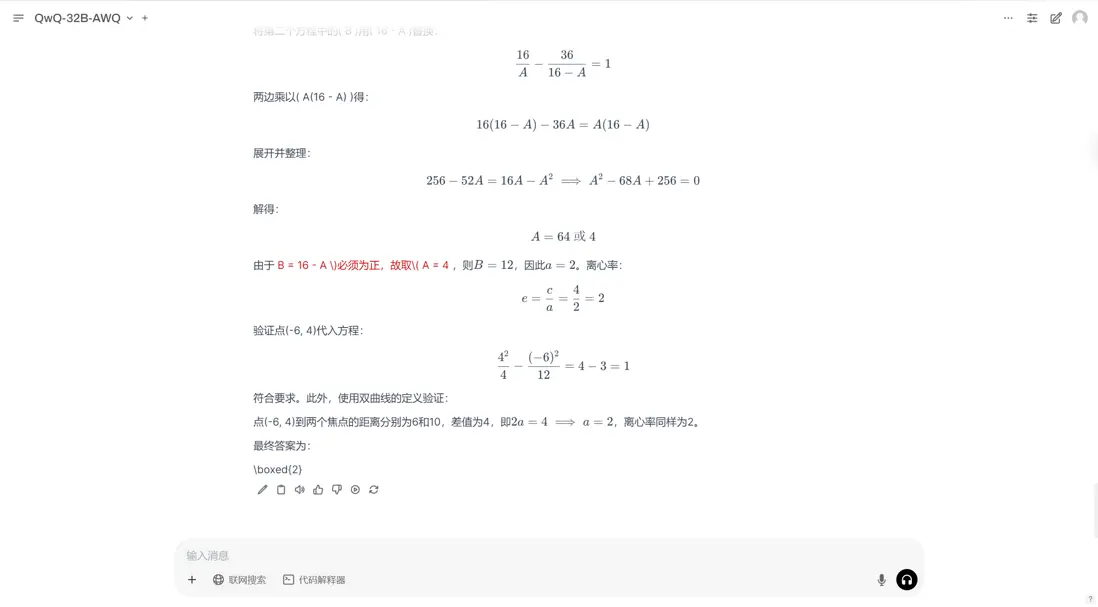

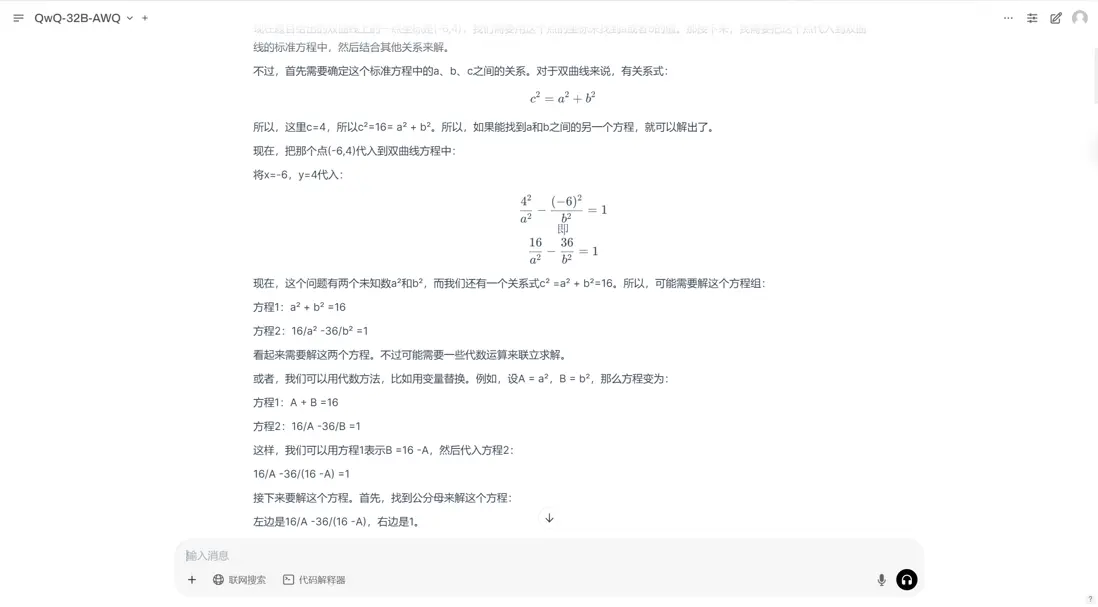

這裏我們輸入了一道數學題,可以看到模型很快給出了回覆。並且相比傳統指令調優模型,QwQ 具備思考和推理能力。