一、為什麼“低延遲視頻”在 2025 年突然變成剛需?

過去十年裏,“低延遲”這個詞經常被用爛:

- 直播平台説自己低延遲;

- 安防攝像頭説自己實時;

- 互動課堂説自己秒開不卡。

但大多數場景,本質是**“人在屏幕前慢慢看”**,幾秒鐘的延遲也能“忍”。

到了 具身智能(Embodied AI) 和 低空經濟(無人機/無人機集羣/eVTOL) 這兩個方向,“忍一忍”的緩衝區就徹底不夠用了。

幾個現實的變化:

- 主體從“人坐着看”變成“系統在動、設備在飛”

- 機器人在倉庫裏穿行;

- 無人機在城市低空穿梭;

- 巡檢車在園區裏自動繞行。

它們不是“按一下、慢慢看結果”,而是連續感知 + 連續決策,一旦視頻鏈路延遲大、抖動大,後面整套控制策略就開始“瞎”。

- 控制閉環不再只依賴本地傳感器,而是高度依賴視頻感知

很多系統“眼睛”就是攝像頭,AI 模型、遠程控制、決策系統全看這一條視頻流。如果這條“眼睛鏈路”慢一拍,後面的 PID、軌跡規劃、避障、編隊,全都跟着錯節奏。 - 容錯率越來越低

- 工業機器人撞一下貨架,叫事故;

- 無人機晚避障 0.5 秒,可能就是真撞;

- 執法/巡檢設備延遲太大,遠程指揮就形同虛設。

結論很簡單:

過去視頻是“好看就行”,

現在視頻是“要命的輸入信號”。

這也是為什麼,超低延遲的 RTSP/RTMP 播放器不再是“播放器裏的一個配置項”,而是具身智能和低空經濟裏那條“看不見但最關鍵”的基礎設施。

而大牛直播SDK(SmartMediaKit)這幾年做的事情,本質就是:

把這一條“眼睛鏈路”,做成可工程化、可規模複製的模塊能力。

二、RTSP/RTMP 在這些場景裏到底扮演什麼角色?

很多人一提具身智能和低空經濟,直覺就想到:

- ROS / CyberRT / Apollo 等中間件;

- LiDAR / IMU / GNSS;

- WebRTC / QUIC / SRT;

但在真正的工程落地裏,你會發現一個樸素的現實:

大量設備端還是 RTSP/RTMP 最先落地,也是最好落地。

1. RTSP:設備端“自帶”的實時協議

在 AI 攝像頭、無人機雲台、車載監控、機器人底盤這些硬件系統裏:

- RTSP 作為生產端(攝像頭/AI Box)的主流編碼輸出接口,是最常見的:

- IPC、NVR、AI Box:出 RTSP 流;

- 機器人邊緣模塊:內部算法直接推 RTSP;

- 工業相機:SDK 一鍵開 RTSP 輸出。

- 網絡往往不是一個乾淨的“數據中心網絡”,而是:

- Wi-Fi、4G/5G、專網、短距離自組網混合;

- 隨時可能出現丟包、抖動、帶寬波動。

在這種環境裏,RTSP 的特點非常契合需求:

- 協議簡潔、成熟度高、實現成本低;

- 天然適配 H.264/H.265/AAC 等編碼;

- 提供基本的PLAY/PAUSE/SETUP/TEARDOWN 控制能力;

- 對設備廠商來説,是“一次性成本”——搞好一次,幾乎所有行業項目都能複用。

因此,在具身智能和低空經濟的很多項目裏,RTSP 往往是設備端最先穩定下來的那一條輸出鏈路。

2. RTMP:仍然是“上雲”和“中轉節點”的強項選手

即便在 2025 年,RTMP 依然沒有“過時”,原因同樣很現實:

- 運營/運維體系成熟:

各種雲服務、CDN、邊緣節點,對 RTMP 的支持鏈路非常完整。 - 實時性和兼容性平衡得還不錯:

在合理調優下,百毫秒到幾百毫秒延遲是常規操作。 - 在“設備 → 邊緣節點 → 中心平台”的架構裏,RTMP 依然是很好的傳輸協議中樞。

實際工程裏常見的鏈路形態是:

設備/終端:RTSP 輸出

邊緣節點/網關:RTSP 拉流 → 轉 RTMP 推流(或 HTTP-FLV / WebRTC)

控制側/可視化平台:RTMP/HTTP-FLV/WebRTC 播放

這就帶來一個直接問題:

如果中間環節已經做了很多優化,但播放器端還是用一個“通用播放器 + 默認緩衝 2~3 秒”,那前面的所有低延遲努力基本白費。

所以,一個真正可用的低延遲 RTSP/RTMP 播放器,不再是“選項”,而是整個鏈路的關鍵一環。

三、“超低延遲播放器”到底難在哪裏?

很多人會下意識地問一句:

“低延遲不就是把緩衝 buffer 調小嗎?”

真要是這麼簡單,音視頻工程師就失業了。

1. 協議棧層面的挑戰

在 RTSP/RTMP 這種協議上做超低延遲,涉及至少三層:

- RTP/RTMP 協議解析和時序管理

- 丟包重傳策略是否適配當前網絡;

- 時間戳(PTS/DTS)、亂序包重排、NTP 對齊;

- 自適應 JitterBuffer 算法:在“不卡”和“延遲小”之間找平衡點。

- 解碼器層面

- H.264/H.265 的多種編碼形態:B 幀、長 GOP、SVC、動態分辨率切換;

- 軟解/硬解切換策略;

- 多路流併發時的解碼資源管理。

- 渲染+同步層

- 視頻渲染的幀隊列設計;

- 音視頻同步策略(需要還是不需要 AV sync);

- 在 UI、遊戲引擎、VR 頭顯、嵌入式屏幕上的繪製差異。

如果只是“減小一個播放器緩衝參數”,頂多讓你:

- 有些場景看起來更快;

- 但抖動更大、卡頓更多、畫面撕裂嚴重。

真正可用的超低延遲播放器,必須在上述三層都做系統性設計,並且從一開始就以“低延遲”為目標,而不是後面再擰幾個參數。

2. 工程實踐:真實網絡永遠比實驗室難看

具身智能和低空經濟場景的網絡特點是:

- 無線鏈路多(Wi-Fi、4G/5G、自組網等);

- 多跳轉發、NAT、VPN、專線混合;

- 有時候是車載/機載,鏈路本身就在動。

模擬環境下你能調到 150ms,

一旦上了車、上了無人機,延遲直接翻倍甚至更多。

所以一個真正可用的方案,必須經過:

- 大量真實項目的踩坑和修正;

- 在各種奇奇怪怪的 RTSP/RTMP 源上驗證;

- 在各種弱網環境下實戰調優。

大牛直播SDK 的 RTSP/RTMP 播放器模塊,基本就是在這樣的環境裏被項目“打出來”的,而不是在辦公室裏舒服地寫 demo。

四、RTSP/RTMP 播放器:從“能播”到“敢託底”的差異

以大牛直播SDK 為例,它把播放器這塊拆成了一套可以“單獨拿出來當能力賣”的模塊:

- 跨平台 RTSP 播放器模塊(SmartPlayer / RTSP Player SDK)

- 跨平台 RTMP 播放器模塊(SmartPlayer / RTMP Player SDK)

核心特徵,用工程化視角看,有幾個關鍵點:

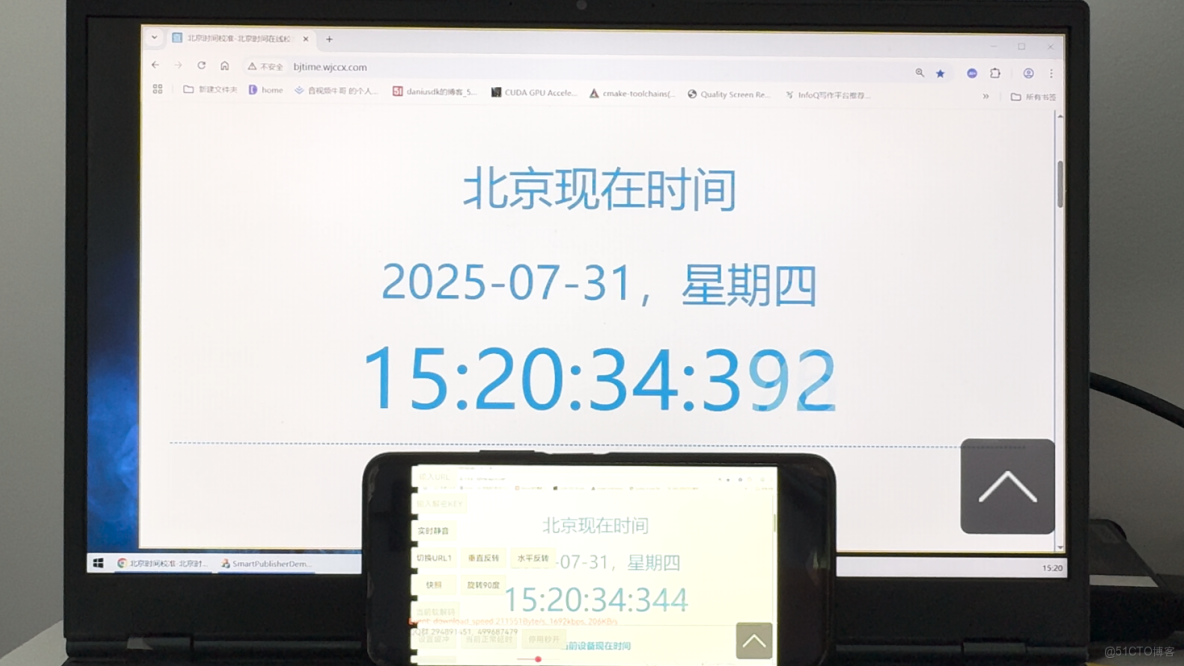

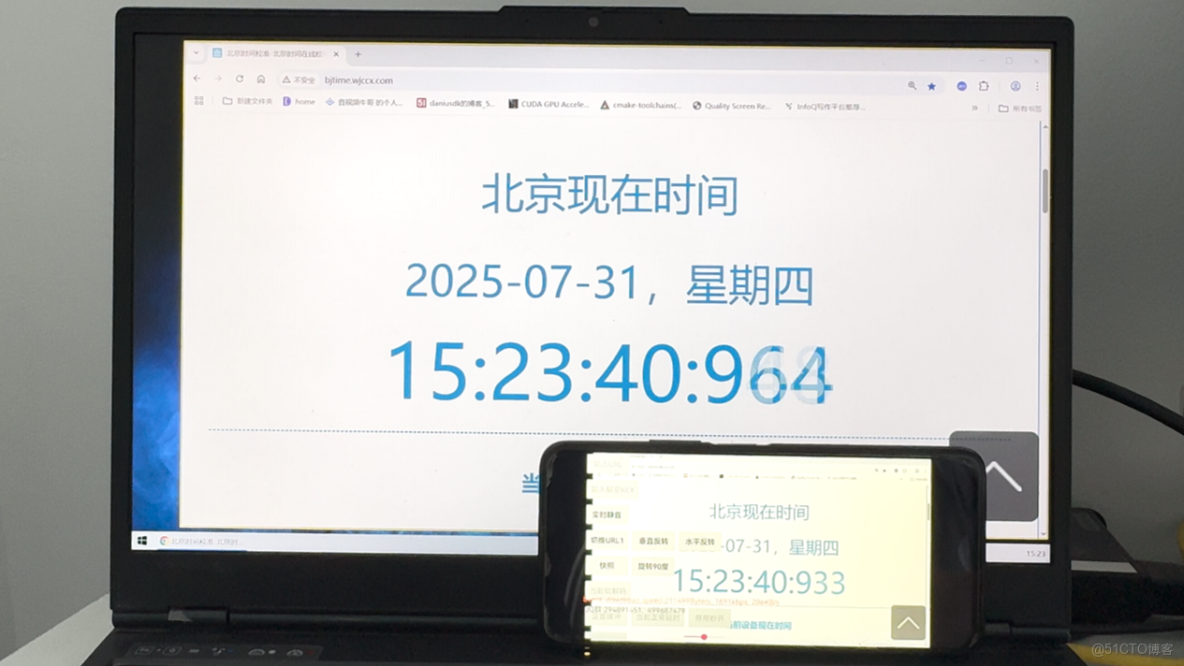

1. 真正“按毫秒算”的端到端延遲控制

在實際落地裏,RTSP/RTMP 播放器配合編碼器/服務器,可以做到:

- 100~200ms 級別的端到端延遲(可見畫面);

- 在丟包、抖動場景下,能自動適配緩衝,不把延遲“失控地堆高”;

- 重點場景可以做到“寧可掉幀,也不無上限拖延遲”。

這背後是:

- RTP層:自適應抖動緩衝的策略;

- 解碼:針對 AI 攝像頭/無人機碼流的兼容性優化;

- 渲染:針對多平台的渲染路徑優化(Windows、Linux、Android、iOS、Unity/VR)。

2. 跨平台一致性:一套接口,多端跑

具身智能和低空經濟項目很少只有一個平台:

- 前端:Android Pad / 工控機 / Windows 上位機 / iOS 控制端;

- 中心:Linux / 國產化系統 / Docker 化部署;

- 遠程控制:桌面客户端、移動端混合。

大牛直播SDK 的 RTSP/RTMP 播放器模塊,本來就按“四端統一 + 國產化適配”的套路走:

- Windows / Linux / Android / iOS 四端 SDK;

- 可在 Unity3D、頭顯、嵌入式裏集成;

- 針對國產 CPU + 國產 OS(UOS、麒麟等)做過長期適配。

對項目方來説,最大的收益不是“多一個平台支持”,而是:

場景從“每個平台單獨調一遍”變成“統一能力、統一調優、統一升級”。

3. 不是“實驗室參數”,而是“項目實戰”的能力

大牛直播SDK 這些年的主要戰場其實一直在:

- 安防/工控/能源/電力/園區等行業項目;

- 政企、運營商的大型系統;

- 機器人、巡檢、無人機、遠程作業等高實時性場景。

因此它的播放器模塊,比較“工程味”的地方在於:

- 不挑 AI 攝像頭、AI Box、IPC 廠商;

- 能扛住各種“奇葩流”:

- 動態分辨率、碼率波動、長 GOP、非標 NALU 分片等;

- 在弱網環境裏,延遲和流暢性之間的平衡是經過大量業務場景驗證的,而不是憑感覺拍腦袋。

五、具身智能場景:RTSP/RTMP 播放器在“動作系統”裏的位置

站在具身智能的視角,我們可以把系統拆成四層:

- 感知層(Perception)

- 攝像頭、雷達、IMU、編碼器等;

- 視頻在這裏就是“第一感知通道”。

- 理解與決策層(Cognition & Planning)

- 傳統 CV + DNN 模型;

- 運動規劃、軌跡生成;

- 現在越來越多地加入大模型(多模態 LLM)。

- 控制執行層(Control & Actuation)

- 電機/舵機/底盤控制;

- 控制器和執行器間的閉環。

- 人機協同與監控層(HMI & Supervision)

- 遠程監控界面、控制枱;

- 操作員干預、任務接管。

在這四層裏,超低延遲 RTSP/RTMP 播放器主要影響兩塊:

1. 人機協同與監控層:操作員需要“即時的眼睛”

典型場景:

- 遠程遙操作機器人:

- 操作員通過手柄/鍵盤下指令;

- 通過畫面判斷是否需要調整動作;

- 如果畫面延遲 500ms+,操作節奏會明顯跟不上。

- 巡檢機器人在廠房/管廊內移動:

- 自動巡檢為主,人只是“掛着看”;

- 一旦出現異常(障礙物、人闖入),需要人為接管;

- 接管時,視頻必須是“相對實時”的,否則人根本不敢下指令。

在這些場景裏,大牛直播SDK 的 RTSP/RTMP 播放器模塊,就扮演了**“控制枱上的眼睛”**:

- 接 RTSP/RTMP 實時流;

- 把延遲壓在 100–200ms 量級;

- 保證畫面穩定,不因網絡波動頻繁花屏/卡頓。

2. 感知 & 決策層:視頻作為 AI 輸入信號鏈路的一環

隨着多模態大模型的興起,

“視頻→特徵→大模型→決策” 的鏈路越來越多。

在邊緣/近端部署裏,你會看到這樣的形態:

設備端/機器人:攝像頭 → 編碼 → RTSP/RTMP 推出

邊緣算力節點:RTSP/RTMP 拉流 → 解碼 → AI 模型推理 → 下發控制指令

這裏有兩個關鍵點:

- 解碼這一步離不開“穩定的播放器/解碼器能力”

大牛直播SDK 的 RTSP/RTMP 播放模塊,很多時候不僅僅是“畫出來”,而是提供解碼後回調數據(YUV/RGB),供上層 AI 模型直接消費。 - 如果解碼鏈路本身延遲大、不穩定,AI 決策就會“看舊畫面做新決策”

這在具身智能裏是非常致命的。

播放器/解碼模塊如果能保證低延遲、無無上限緩衝增長,AI 控制鏈路才有意義。

因此在很多項目裏,大牛直播SDK 的 RTSP/RTMP 播放模塊已經不是“UI 播放器組件”,而更像是:

一個“低延遲視頻解碼節點”,既負責預覽,又負責給 AI 提供實時輸入。

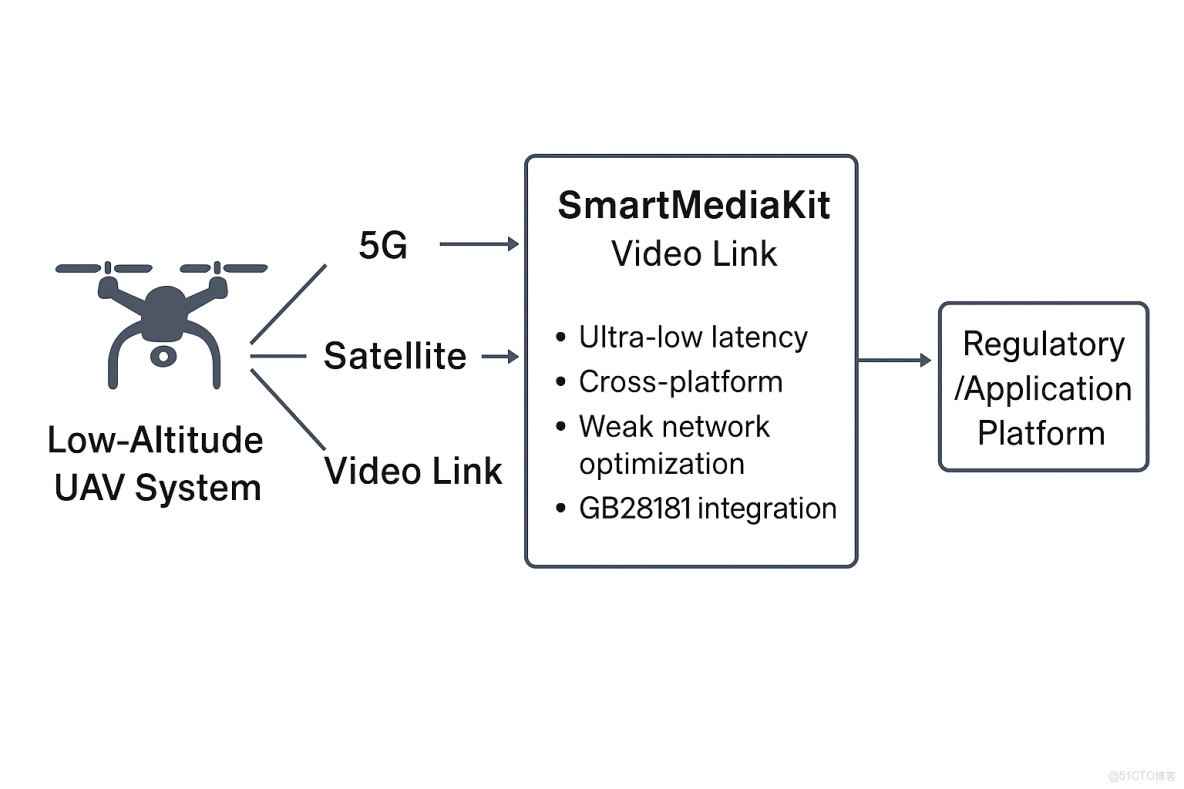

六、低空經濟場景:無人機/飛行器的“視頻神經”

低空經濟裏,視頻鏈路的特徵更極端一些:

- 設備端:無人機 / eVTOL / 巡檢飛行器;

- 傳輸:4G/5G 專網、公網,甚至衞星鏈路;

- 地面端:控制站、車載指揮中心、調度大廳。

在這些場景裏:

- 飛行器上的攝像頭既是“人眼”,也是“算法眼”

- 人眼端:操作員、調度員通過畫面做判斷;

- 算法眼:

- 目標檢測(輸電線路、杆塔、地面目標);

- 路徑規劃輔助;

- 異常識別(煙火、障礙物等)。

- 低延遲是“接管權”的前提

無人機多數時間按預設航線飛行,但一旦需要人工接管——

- 延遲高,人就會產生“暈車感”;

- 延遲不穩定(時快時慢),操作員的判斷會出現錯配。

- RTSP/RTMP 在飛行器 → 地面段仍是高性價比方案

- 設備端:

- 編碼後一份 RTSP/RTMP 輸出,走 4G/5G 上行到雲/邊緣;

- 地面端:

- 通過超低延遲 RTSP/RTMP 播放器實時預覽;

在這套鏈路裏,大牛直播SDK 的 RTSP/RTMP 播放器能力主要解決兩件事:

- 在複雜網絡條件下,把“視頻畫面延遲 + 抖動”壓到可控範圍;

- 保證多路飛行器、多角度畫面的併發預覽穩定,不因為多流同時觀看就失控。

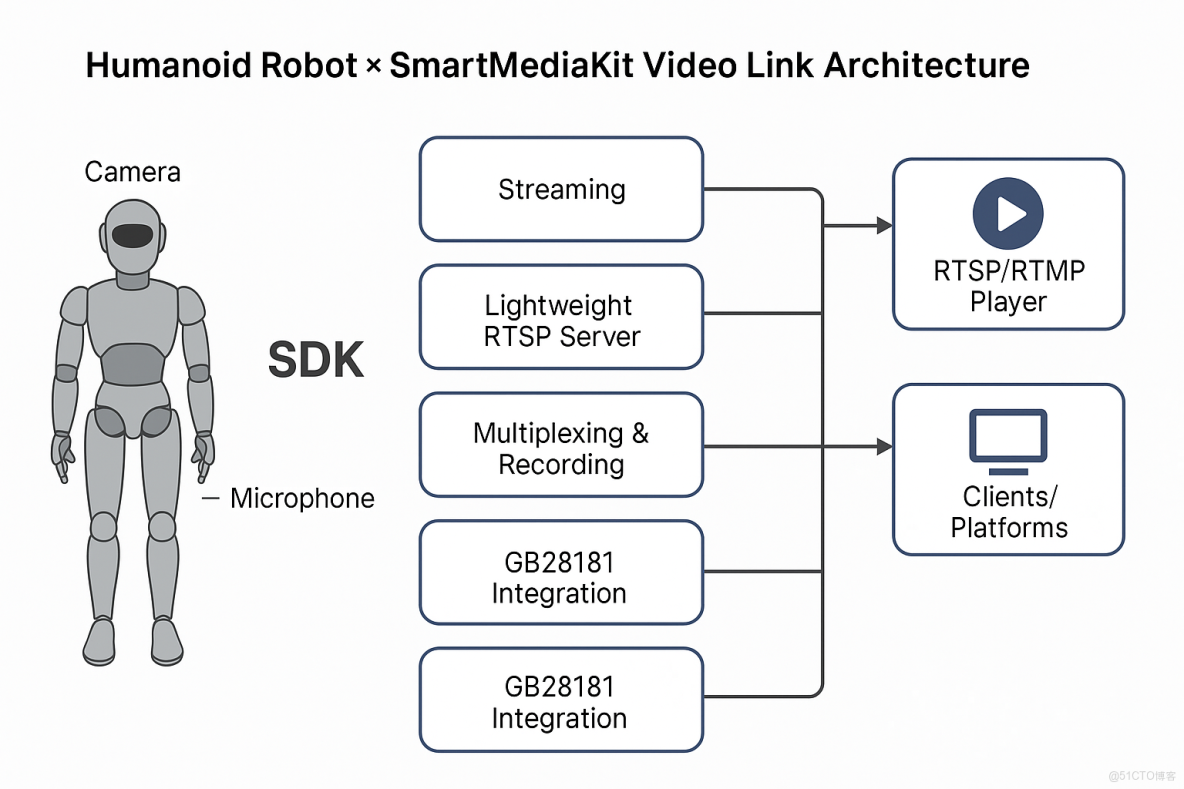

七、從“模塊”視角看:大牛直播SDK 如何被集成進這些系統?

一個典型的具身智能 / 低空經濟項目,如果用到大牛直播SDK 的 RTSP/RTMP 播放器,通常會有這樣的集成方式(高層設計):

- 終端/設備端

- 攝像頭 → H.264/H.265 編碼 → RTSP/RTMP 輸出(設備自帶或 SDK 推流模塊)。

- 中間節點(可選)

- 大牛直播SDK 的輕量級 RTSP 服務 / 轉發模塊;

- 或 RTSP 轉 RTMP/HTTP-FLV網關。

- 控制枱/監控端

- Windows/Linux 上位機:集成大牛直播SDK 的 RTSP/RTMP 播放器;

- Android 控制平板、iOS 終端:嵌入移動端 SDK;

- Unity3D/VR 頭顯:通過大牛直播SDK 的 Unity 播放模塊,以 ExternalTexture/OES 做零拷貝渲染。

- AI 模型/大模型適配(可選)

- 通過播放器的解碼回調接口(YUV/RGB),直接接入 AI 模型推理;

- 把大牛直播SDK 當成“實時視頻輸入源”,而不是僅僅當“播放器”。

這一套下來,你並不需要從零實現一個跨平台、支持各種奇葩碼流的低延遲播放器,而是:

直接把“超低延遲 RTSP/RTMP 播放模塊”當一個能力塊嵌進去,

重點精力放在你真正要做的核心價值:

- 具身智能的決策策略;

- 低空經濟的飛行任務編排;

- 行業場景的業務流程設計。

八、為什麼在這個時點,值得認真選一套“專業SDK”?

很多團隊在項目早期的真實想法是:

“先用開源頂一頂,能跑就好,後面再説。”

這個思路在做直播 App、短視頻 Demo 的時候,問題不算大。

但在具身智能和低空經濟場景裏,有兩個現實風險:

- 項目生命週期很長,技術債遲早要還

- 一開始用開源拼一套,延遲、兼容性勉強能接受;

- 隨着項目從 PoC → 小規模試點 → 車隊/機隊規模化,問題開始指數級爆炸:

- 不同攝像頭廠商、不同無人機平台,不同網絡環境;

- 每個“角落問題”都需要大量人力去打補丁。

- 責任閉環和 SLA 不再是“説説而已”

- 機器人撞貨架、無人機誤飛到禁區,這些都不再是“Demo 小 bug”;

- 需要的是一個可以背鍋、持續演進、提供支持的技術棧,而不是單純代碼。

大牛直播SDK 本身就是付費的商業 SDK,它的價值不在於“功能多幾個按鈕”,而是在於:

- 把 RTSP/RTMP 播放這件事,

從“項目團隊自己熬夜堆代碼”

變成“買一個穩定的工程能力 + 服務支持”。

你真正買到的是:

- 跨平台、跨編碼器、跨場景的穩定性;

- 持續的 bug 修復與新版本支持(比如新平台、新芯片、新協議兼容);

- 項目遇到棘手視頻鏈路問題時,有一個能深度溝通的技術團隊。

在具身智能和低空經濟這樣**“高風險 + 高複雜度 + 長週期”**的行業裏,這種“可託底”的能力,往往比代碼本身更值錢。

九、結語:真正的智能,離不開一條可靠的“視覺鏈路”

無論是具身智能,還是低空經濟,它們共同的本質是:

讓機器在真實世界中持續行動,並在行動中不斷感知、判斷、決策。

但所有智能行為都有一個最樸素的前提——

系統必須“看得清”“看得準”“看得及時”。

- 攝像頭提供的是物理世界的光信號;

- RTSP/RTMP + 超低延遲鏈路承擔的是信息世界的視覺神經傳導;

- 而像大牛直播SDK這樣的專業視頻 SDK,承擔的角色更像是讓視覺信號穩定、快速、可工程化傳遞的關鍵基礎設施。

當這條鏈路足夠可靠,你才能把精力真正投入到系統智能的核心價值上:

- 更穩健的決策模型;

- 更高效的任務協作;

- 更靈活的業務場景創新。

如果視覺鏈路不穩定、延遲不可控,再先進的規劃算法、再強大的大模型,都沒法避免一個殘酷現實:

智能系統看到的不是“現在”,而是“幾百毫秒前的世界”。

在工程實踐中,很多看似宏大的“具身智能”“低空經濟”難題,

最終往往不是倒在算法、算力或模型上,

而是倒在一個微小但致命的細節上:那一幀畫面,來得太晚。