告別盲目試錯!大模型微調核心參數的“油門、檔位與里程

(一)引言:參數沒調對,微調全白費

大家好,我是七七!剛入門大模型微調時,我踩過最致命的坑就是“瞎調參數”——拿着7B模型,隨便設個學習率、batch_size就跑訓練,結果要麼模型不收斂(損失一動不動),要麼顯存直接炸了,折騰兩三天都沒調出正經效果。

後來跟身邊的技術大佬請教才明白:大模型微調的核心不是“跑通代碼”,而是“調好參數”。就像開車,油門(學習率)、檔位(batch_size)、里程(訓練輪次)沒配合好,再棒的“車子”(模型)也跑不出好效果。新手之所以調參難,本質是沒搞懂每個參數的作用,更不知道背後的基礎邏輯。

今天這篇文章,就帶新手朋友從0到1吃透大模型微調的3大核心參數(學習率、batch_size、epochs),用大白話講清原理,附PyTorch實操步驟(複製就能跑),再分享一套“新手友好型”調參邏輯,幫你告別盲目試錯。

(二)技術原理:3大核心參數拆解(通俗版)

大模型微調的核心目標,是讓預訓練模型“適配具體任務”(比如用通用模型微調做情感分析),而學習率、batch_size、epochs這三個參數,直接決定了“模型怎麼學、學多久、學得穩不穩”。每個參數都講透“作用+比喻+默認範圍+避坑點”,新手也能秒懂。

1. 學習率(Learning Rate, LR):模型學習的“油門”

核心作用:控制模型參數更新的幅度,也就是“每一次學習後,模型調整自身參數的力度”。

通俗比喻:像開車踩油門,油門踩太猛(學習率太高),車子容易衝出去(模型參數震盪,不收斂,損失忽高忽低);油門踩太輕(學習率太低),車子龜速前進(模型學習緩慢,訓練很久效果也沒提升);只有油門力度適中,才能平穩加速(模型快速收斂,效果穩步提升)。

基礎範圍與適配場景:

通用默認值:2e-5 ~ 5e-5(微調7B/13B模型最常用,適配大多數文本任務);小模型/簡單任務(如二分類):可適當提高到5e-5 ~ 1e-4;大模型/複雜任務(如多輪對話):建議降低到1e-5 ~ 2e-5,避免參數震盪。

新手必避坑:

不要用預訓練的學習率(預訓練LR通常是1e-4以上,微調時用這麼高,模型必崩);學習率不是固定不變的,可搭配“warmup(熱身)”(前幾輪用小LR,避免一開始衝太猛),後續文章會講進階調度策略。

2. 批量大小(Batch Size):模型學習的“運輸車”

核心作用:控制每次送入模型訓練的數據量,也就是“模型一次學多少樣本”。

通俗比喻:像運輸車拉貨,每輛車拉太多(batch_size太大),超出載重(顯存不夠),直接拋錨(OOM報錯);每輛車拉太少(batch_size太小),運輸效率低(模型訓練速度慢,且容易受單一樣本噪聲影響,訓練不穩定);拉貨量適中(適配顯存的最大batch_size),效率和穩定性兼顧。

基礎範圍與適配場景(按顯卡顯存劃分):

16G顯卡(如RTX 3090/4070):微調7B模型,batch_size建議設2~4(FP16精度下);24G顯卡(如RTX 4090):微調7B模型,batch_size可設48;微調13B模型,設24;8G顯卡(入門級):只能設1~2,需搭配後續講的“梯度累積”彌補效果。

新手必避坑:

不要盲目追求大batch_size,優先保證“不OOM”,再談效率;batch_size變了,學習率可適當調整(大batch_size可略提高LR,小batch_size可略降低,保持“有效學習率”穩定)。

3. 訓練輪次(Epochs):模型學習的“複習次數”

核心作用:控制整個訓練集被模型學習的總次數,也就是“模型把所有訓練樣本重複學幾遍”。

通俗比喻:像學生複習考試內容,複習太少(epochs太少),知識點沒記牢(模型欠擬合,效果差);複習太多(epochs太多),容易死記硬背(模型過擬合,訓練集效果好,測試集效果差);複習次數適中,才能既掌握知識點又靈活運用。

基礎範圍與適配場景:

通用默認值:35輪(大多數文本任務,如情感分析、文本摘要,這個範圍足夠);訓練數據量少(如幾千條樣本):可設58輪,避免欠擬合;訓練數據量多(如幾萬條樣本):可設2~3輪,避免過擬合,同時節省訓練時間。

新手必避坑:

不要以“訓練輪次越多越好”為標準,要觀察“驗證集損失”,當驗證集損失開始上升時,説明已經過擬合,應立即停止訓練;可搭配“早停(Early Stopping)”策略,自動停止過度訓練,後續會講實操。

(三)實踐步驟:手把手調參實操(7B模型情感分析案例)

本次實操以“文本情感分析”為任務(二分類:正面/負面),用Llama 2 7B模型,適配16G顯卡(FP16精度),工具用PyTorch+Transformers,步驟清晰到新手能直接複製跑。核心邏輯:先設基礎參數跑通訓練,再單參數微調優化效果。

前置準備:安裝依賴庫,命令如下:

pip install torch transformers accelerate peft datasets pandas scikit-learn

步驟1:設置基礎參數(新手安全版)

先按16G顯卡適配,設置“不OOM、易收斂”的基礎參數,避免一開始就踩坑:

import torch

from transformers import AutoModelForSequenceClassification, AutoTokenizer, TrainingArguments, Trainer

from datasets import Dataset

import pandas as pd

from sklearn.metrics import f1_score, accuracy_score

# 1. 基礎參數配置(16G顯卡7B模型專屬)

model_name = "meta-llama/Llama-2-7b-hf" # 模型名稱

lr = 2e-5 # 學習率(新手默認值)

batch_size = 2 # 批量大小(16G顯存安全值)

epochs = 3 # 訓練輪次(通用默認值)

num_labels = 2 # 情感分類任務,2個類別(正面/負面)

output_dir = "./llama2-sentiment" # 模型保存路徑

# 2. 加載模型和Tokenizer

tokenizer = AutoTokenizer.from_pretrained(model_name)

# 開啓FP16精度,節省顯存

model = AutoModelForSequenceClassification.from_pretrained(

model_name,

torch_dtype=torch.float16,

num_labels=num_labels

).to("cuda")

步驟2:準備訓練數據(模擬情感分析數據集)

模擬1000條電影評論數據(實際場景中替換為你的數據集即可),處理為模型可接受的格式:

# 模擬情感分析數據(text=評論內容,label=0=負面,1=正面)

data = {

"text": ["這部電影太精彩了,推薦大家去看", "劇情拖沓,浪費時間", "演員演技在線,值得二刷"] + ["電影很好看" for _ in range(498)] + ["不推薦觀看" for _ in range(497)],

"label": [1, 0, 1] + [1]*498 + [0]*497

}

df = pd.DataFrame(data)

# 劃分訓練集、驗證集(8:2)

train_df = df.sample(frac=0.8, random_state=42)

val_df = df.drop(train_df.index)

# 轉換為Hugging Face Dataset格式

train_dataset = Dataset.from_pandas(train_df)

val_dataset = Dataset.from_pandas(val_df)

# 數據預處理函數(分詞)

def preprocess_function(examples):

return tokenizer(examples["text"], truncation=True, padding="max_length", max_length=128)

# 應用預處理

tokenized_train = train_dataset.map(preprocess_function, batched=True)

tokenized_val = val_dataset.map(preprocess_function, batched=True)

步驟3:配置訓練參數,啓動微調

用Transformers的TrainingArguments配置訓練細節,包含前面設置的核心參數,同時添加簡單評估邏輯:

# 評估指標計算函數

def compute_metrics(eval_pred):

logits, labels = eval_pred

predictions = torch.argmax(torch.tensor(logits), dim=-1)

return {

"accuracy": accuracy_score(labels, predictions),

"f1": f1_score(labels, predictions, average="binary")

}

# 配置訓練參數

training_args = TrainingArguments(

output_dir=output_dir,

per_device_train_batch_size=batch_size, # 單卡訓練batch_size

per_device_eval_batch_size=batch_size,

learning_rate=lr,

num_train_epochs=epochs,

logging_steps=10, # 每10步打印一次日誌

evaluation_strategy="epoch", # 每輪評估一次

save_strategy="epoch", # 每輪保存一次模型

fp16=True, # 開啓FP16精度,節省顯存

load_best_model_at_end=True, # 訓練結束後加載效果最好的模型

metric_for_best_model="f1", # 以F1值為標準選擇最優模型

weight_decay=0.01, # 輕微權重衰減,防止過擬合

)

# 初始化Trainer,啓動訓練

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_train,

eval_dataset=tokenized_val,

compute_metrics=compute_metrics

)

# 開始微調

trainer.train()

步驟4:單參數微調優化(新手核心邏輯)

基礎參數跑通後,若效果不佳(如F1值低、損失不收斂),按“先調學習率→再調batch_size→最後調epochs”的順序,單參數微調(每次只改一個參數,排除干擾),優化邏輯如下:

• 學習率微調:若基礎LR=2e-5訓練後損失不下降,可試1.5e-5(降低)或3e-5(提高),對比F1值和損失變化;

• batch_size微調:若基礎batch_size=2訓練穩定,可嘗試調到4(若顯存足夠),訓練速度會提升,同時可把LR略提高到2.5e-5;

• epochs微調:若訓練3輪後驗證集損失還在下降,説明欠擬合,可加到5輪;若3輪後驗證集損失上升,説明過擬合,可降到2輪。

新手單參數微調試錯成本很高,每次調整都要等幾小時訓練結束才能看到效果。推薦試試LLaMA-Factory online,它能根據你的顯卡型號(16G/24G)和模型規模(7B/13B),自動推薦適配的基礎參數組合,還能實時展示參數調整對損失、指標的影響,省去反覆試錯的時間,新手也能快速找到最優參數。

(四)效果評估:如何判斷參數調得好不好?

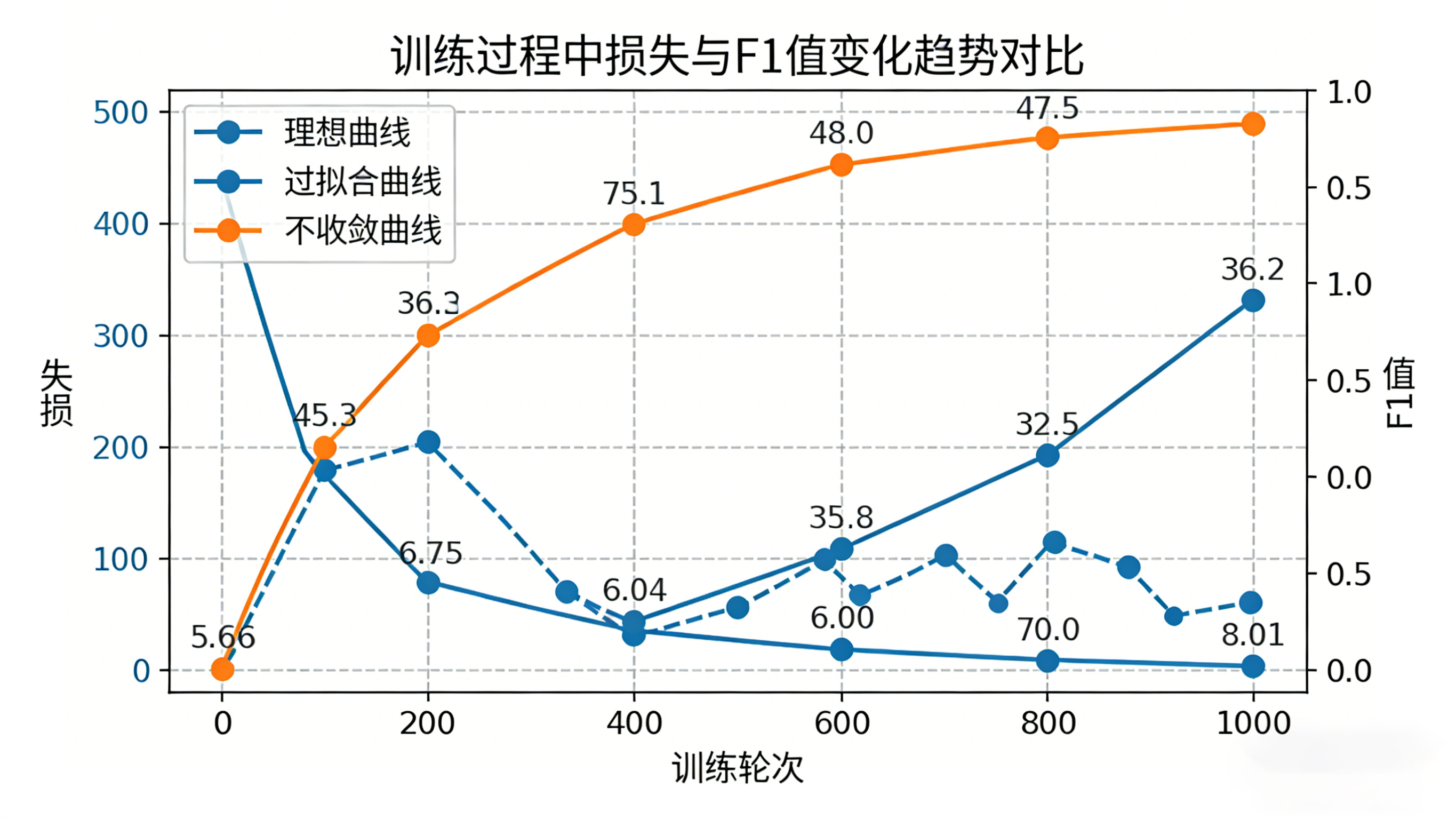

調參不是“改完參數就完事”,要通過“損失變化、指標提升、穩定性”三個維度驗證效果,避免“參數調錯還不知道”。

1. 看損失變化(判斷模型是否收斂)

訓練過程中觀察“訓練集損失(train_loss)”和“驗證集損失(eval_loss)”:

理想情況:兩者均穩步下降,且差距不大(説明模型收斂,無過擬合/欠擬合);異常情況1:訓練集損失下降,驗證集損失上升→過擬合,需減少epochs或增加權重衰減;異常情況2:兩者都不下降→學習率太低,或參數初始化有問題,需提高學習率重新訓練;異常情況3:損失波動很大→學習率太高,或batch_size太小,需降低學習率或增大batch_size(搭配梯度累積)。

2. 看核心指標(判斷模型效果好不好)

結合任務類型看指標,比如情感分析看F1值、準確率:

調參後指標提升(如F1值從0.75提升到0.85)→ 參數調整有效;指標無變化或下降→ 參數調整不當,需回滾到上一組參數;優先看驗證集指標,而非訓練集指標(訓練集指標高可能是過擬合)。

3. 看穩定性(判斷參數是否可靠)

用同一組參數重複訓練2~3次,看指標波動是否≤2%:

波動小(如F1值穩定在0.83~0.85)→ 參數可靠,模型效果穩定;波動大(如F1值在0.78~0.86之間)→ 可能是batch_size太小,或數據噪聲大,需增大batch_size(搭配梯度累積)或清洗數據。

(五)總結:新手調參的核心邏輯的與進階方向

核心總結

今天給大家講透了大模型微調的3大核心參數,以及新手專屬的調參邏輯,最後梳理3個關鍵要點,幫你快速上手:

• 參數邏輯:學習率控“更新力度”,batch_size控“學習效率”,epochs控“學習次數”,三者相輔相成,優先保證“不OOM、能收斂”,再追求“效果優、速度快”;

• 調參順序:先設基礎默認值(LR=2e-5、batch_size=2~4、epochs=3)跑通訓練,再單參數微調,每次只改一個參數,避免干擾;

• 避坑核心:不盲目追求大參數,不照搬預訓練參數,以“損失變化、指標提升、穩定性”為判斷標準,拒絕“憑感覺調參”。

如果想快速掌握調參邏輯,又不想反覆踩坑,LLaMA-Factory online是個很適合新手的工具。它不僅能自動適配硬件推薦基礎參數,還能可視化展示不同參數組合的訓練效果,甚至提供“參數微調建議”,幫你快速找到優化方向,省去手動記錄、對比的麻煩,讓調參從“盲目試錯”變成“科學優化”。