1、前言

1.1、整體配置

本地windows個人計算機:用來跑向量模型和搭建運行docker容器

星火的spark max模型api接口(有高額免費的tokens使用)

1.2、介紹

不會在詳細講述docker-compose配置、ollama等使用,上一篇文章有具體説明。

基於github上的chatgpt-on-wechat項目實現。

本次演示最後結果只是能跑通,看到效果,簡易上手。

會根據上一篇文章的部署來繼續

需要上一篇的ollama內容和docker內容

2、註冊訊飛星火且獲取spark max模型api

註冊認證一下後,點擊星火api->在線調試->創建新應用

到下面頁面後

點擊spark max,點擊購買,裏面有token免費額度,購買完成後看到右側的三行,暫時不用複製,進行下一步即可

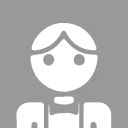

3、啓動docker-compose部署oneapi和fastgpt等項目

3.1、oneapi接口部署

cd到上篇文章的工作目錄,即有docker-compose.yml和config.json那個文件夾下

執行docker-compose up -d

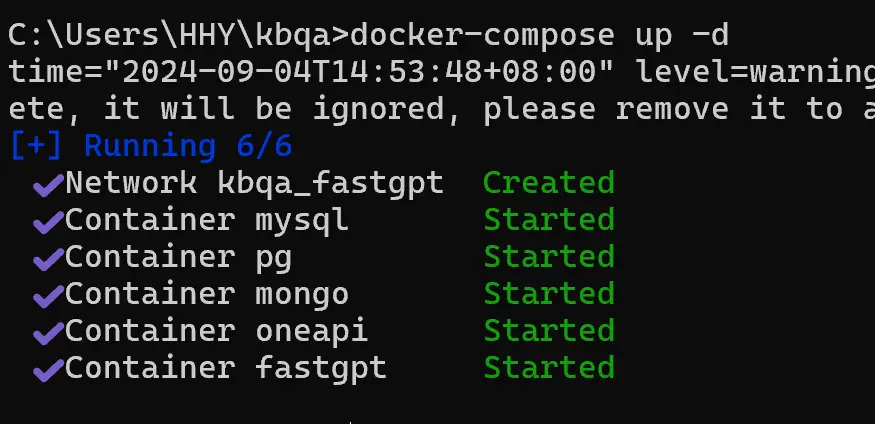

在docker-desktop軟件點擊下面進入oneapi的頁面

也可以直接進入鏈接http://localhost:3001/

點擊渠道->添加渠道

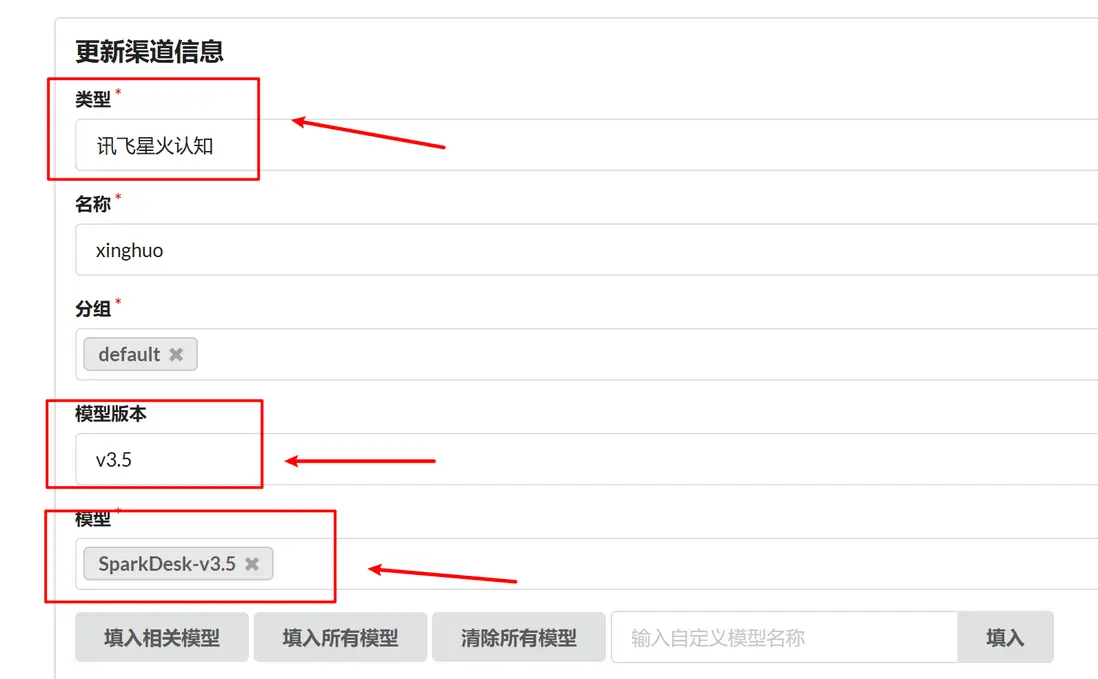

類型下拉列表選擇訊飛星火認知,當然也可以選擇自定義類型,不過oneapi提供了星火的接口鏈接,如果選擇自定義類型就需要添加baseurl,自定義類型用於私有化部署模型作為接口使用

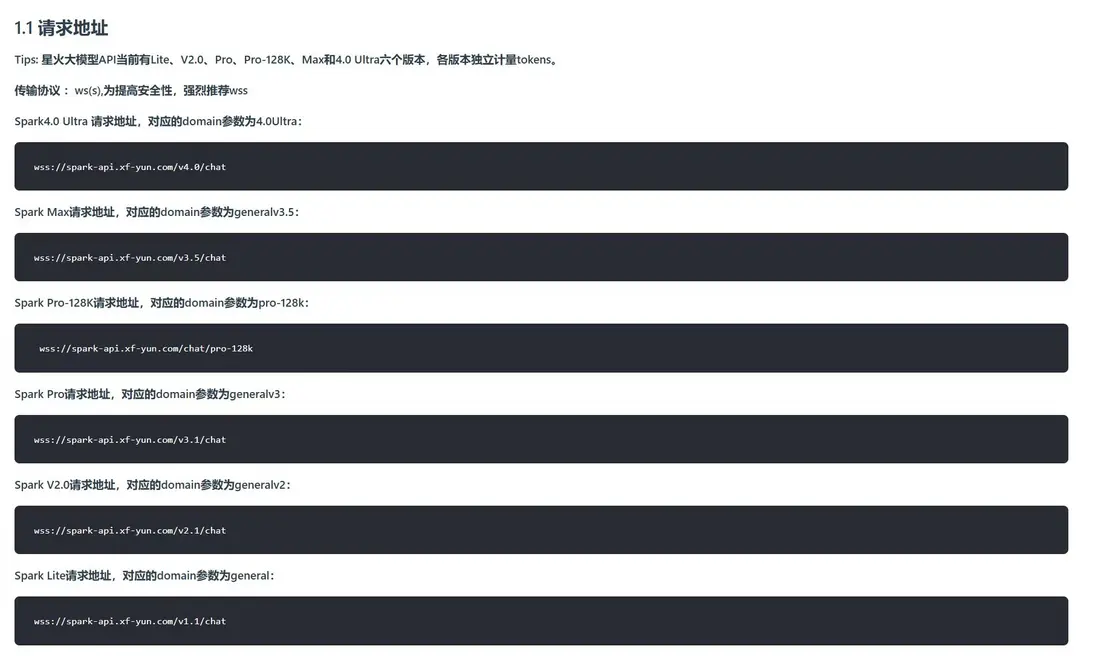

名稱隨意、分組隨意、模型版本需要選擇v3.5,版本選擇參考下圖

模型填入SparkDesk-v3.5即可

按照 | | 格式將上述右側三行APPID|APISecret|APIkey填入密鑰,注意‘|’需要保留

代理不用填,因為最上面類型已經選好訊飛星火認知,如果你是選的自定義渠道就需要填base_url

完成後提交->測試

上一篇文章已經測試過dmeta-zh向量模型,返回400就是正常,這裏不在演示ollama拉取該模型

3.2、fastgpt接口部署

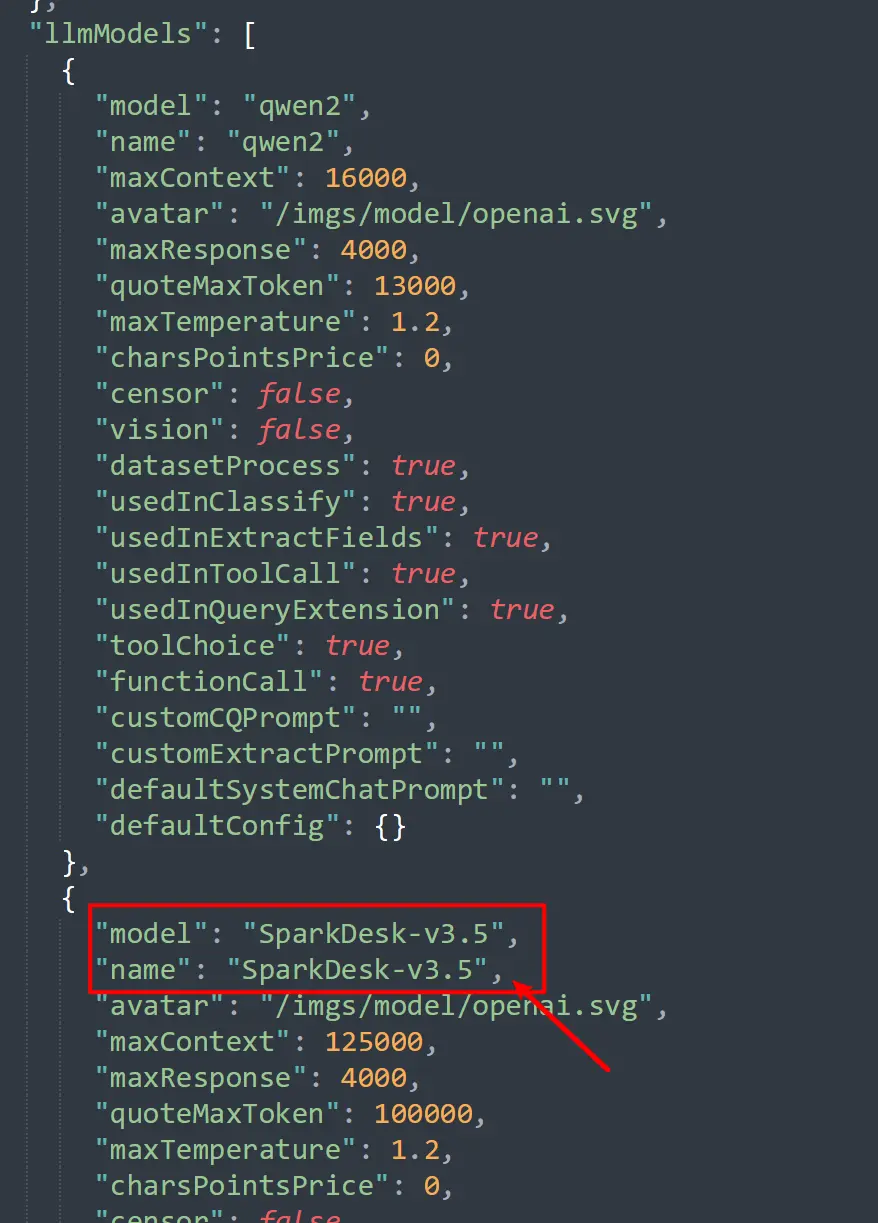

打開config.json文件

將LLMModels下面選一個地方換成星火模型,注意model必須填入和oneapi一致,也就是SparkDesk-v3.5,name的話隨意,不過建議填一樣的

保存即可

4、測試模型效果和自建知識庫效果

4.1、模型效果

重啓docker-compose

執行docker-compose down

執行docker-compose up -d

打開fastgpt即http://localhost:3000/

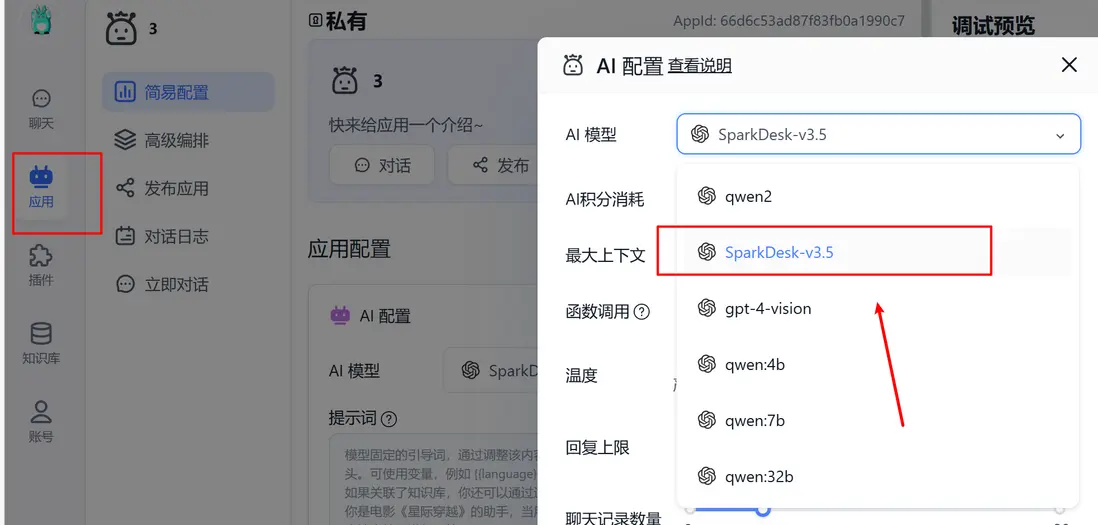

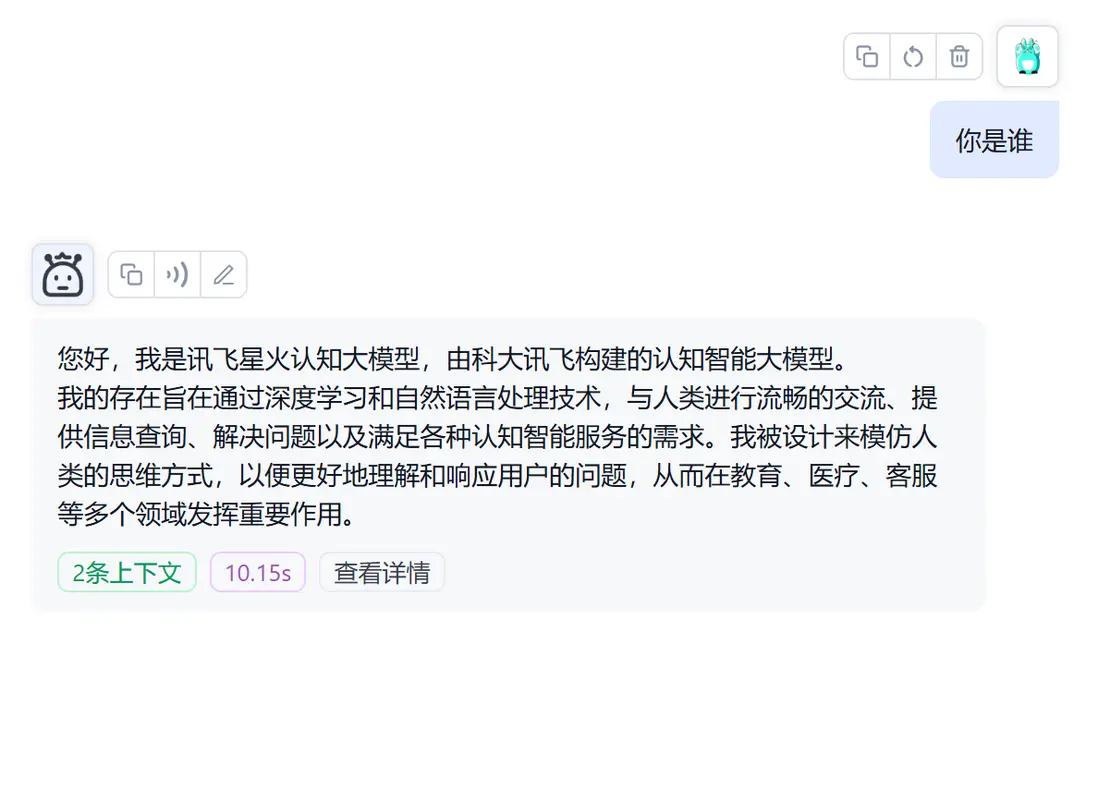

創建應用->選擇SparkDesk-v3.5模型,並進行對話測試

4.2、自建知識庫

至於搭建知識庫,跟上一篇文章一樣操作即可,就是新建知識庫->選擇索引模型dmeta-zh

然後一頓之前一樣操作即可,這裏不展開述

搭建知識庫後問答速度會很慢,可能是文檔格式不好的原因,也可能是索引模型的原因,具體可以查一下理論知識,關於大模型知識庫檢索的理論知識

5、拉取啓動chatgpt-on-wechat項目

5.1、拉取並配置項目

有人提供的直接配置的鏡像,不用去github上整

mkdir chatgpt-on-wechat

cd chatgpt-on-wechat

curl -O https://harryai.cc/chatgpt-on-wechat/docker-compose.yml如果報4開頭錯誤,則需要搭建梯子再curl一次

執行命令一定要注意現在的工作目錄,下載好docker-compose.yml後

cd切換回fastgpt和oneapi等項目的目錄

然後啓動

docker-compose up -d

進入fastgpt

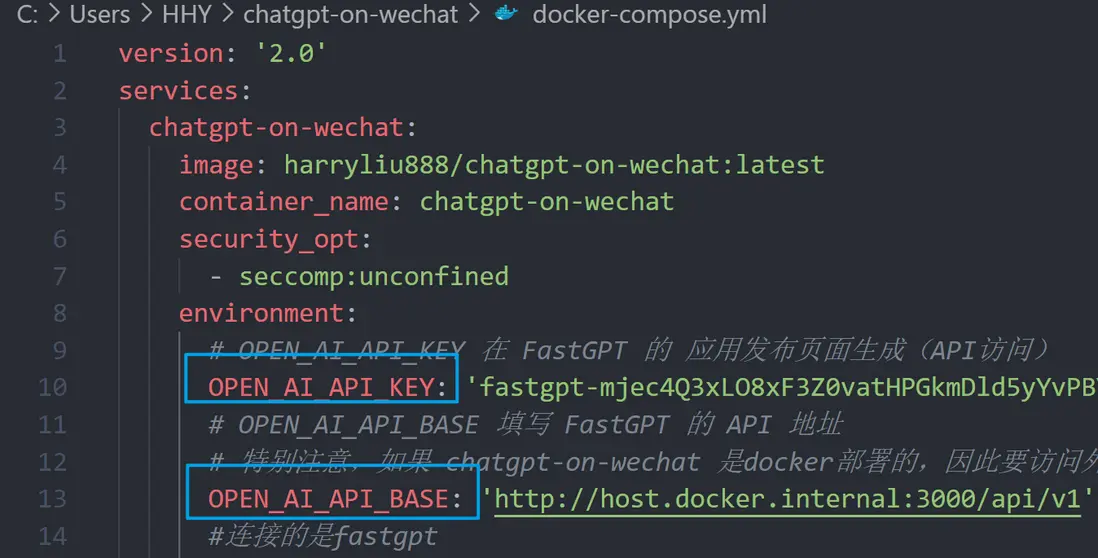

新建後會得到fastgpt的apikey,複製到上面拉取的docker-compose.yml的下面位置

OPEN_AI_API_BASE填入http://host.docker.internal:3000/api/vi

注意必須按照上面格式填入,後面的api和/vi也不能少,這兩個參數是為了對接fastgpt用的

修改好後保存

5.2、啓動項目

cmd中cd到該docker-compose.yml同目錄下,即chatgpt-on-wechat目錄

執行docker-compose up(這裏不用加-d,分別看執行情況)

隨後會生成一個二維碼,找個小號微信掃碼登錄一下即可,出現name後即成功

可以開始問答了

補充一下,必須以這個開頭進行提問,否則捕捉不到問題,也就無法回答

下面測試羣可以更換名字,也就是機器人會在哪些羣進行回答,注意修改後重啓docker-compose才能生效

6、補充説明

這裏演示的都是基本用法,拓展的地方有很多,可以去研究一下github上的這個項目

同時curl拉取的文件都是他人提供,可能會下架