基於 YOLOv8 的學生課堂行為檢測-完整項目源碼

一、問題背景:為什麼要做“課堂行為識別”

在智慧校園和數字化教學逐步落地的過程中,課堂行為數據正在從“不可量化”走向“可分析、可追溯、可評估”。

在真實教學場景中,教師和管理者往往關注以下問題:

- 學生是否專注聽講?

- 是否存在頻繁低頭、趴桌、玩手機等行為?

- 課堂互動(舉手、回答問題)是否足夠積極?

- 不同時間段、不同課程的學習狀態差異如何?

傳統方式主要依賴人工巡視或事後主觀評價,存在明顯侷限:

| 方式 | 問題 |

|---|---|

| 人工觀察 | 成本高、主觀性強、難以量化 |

| 問卷反饋 | 滯後、失真、難以持續 |

| 簡單視頻回放 | 無結構化信息、分析效率低 |

因此,基於計算機視覺的課堂行為識別系統成為一個極具實際價值的工程方向。

源碼下載與效果演示

嗶哩嗶哩視頻下方觀看:

https://www.bilibili.com/video/BV1m7KJzNEQ2/

包含:

📦完整項目源碼

📦 預訓練模型權重

🗂️ 數據集地址(含標註腳本

二、整體技術路線設計

本項目的目標不是“只跑一個模型 Demo”,而是構建一個可直接使用的完整系統。因此在設計之初,整體架構就圍繞以下三點展開:

- 模型必須實時可用

- 系統必須非算法人員也能操作

- 工程結構支持後續擴展

2.1 系統總體架構

整體採用典型的三層結構:

數據層 → 模型層 → 應用層- 數據層:YOLO 格式行為數據集(圖片 + 標籤)

- 模型層:YOLOv8 Detection 模型(PyTorch)

- 應用層:PyQt5 桌面 GUI + 多輸入推理模塊

攝像頭 / 視頻 / 圖片

↓

YOLOv8 行為檢測

↓

行為類別 + 置信度

↓

GUI 實時展示 / 保存結果

三、為什麼選擇 YOLOv8 做課堂行為識別

在行為識別領域,常見技術路線包括:

- CNN + 分類(僅判斷整張圖)

- CNN + 時序模型(LSTM / Transformer)

- 目標檢測 + 行為標籤

在課堂場景中,我們更關心的是:

“誰”在“做什麼行為”

因此,目標檢測模型比單純分類模型更合適。

3.1 YOLOv8 的工程優勢

YOLOv8 相比早期 YOLO 版本,具備明顯工程優勢:

- Anchor-Free 設計

不再依賴複雜 Anchor 調參,對新場景友好 - 端到端訓練流程簡化

- 推理速度快,適合實時攝像頭

- Ultralytics 官方生態成熟

- 原生支持 ONNX / TensorRT 導出

對於“課堂實時監測”這種 FPS 和穩定性同等重要 的任務,YOLOv8 是非常理性的選擇。

四、行為數據集構建:比模型更重要的一步

在實際項目中,數據質量往往決定上限。

4.1 行為類別設計原則

本項目中的課堂行為類別遵循三個原則:

- 視覺上可區分

- 教學場景有明確意義

- 避免過細導致標註困難

示例類別包括:

- 舉手

- 看書

- 寫作業

- 聽講

- 趴桌

- 玩手機

這些行為都可以通過單幀圖像 + 空間特徵進行判別,而無需複雜時序建模。

4.2 數據集結構(YOLO 標準)

dataset/

├── images/

│ ├── train/

│ └── val/

├── labels/

│ ├── train/

│ └── val/標籤採用 YOLO 標準格式:

class_id x_center y_center width height例如:

3 0.51 0.36 0.39 0.32所有座標均為 相對比例,方便多分辨率訓練。

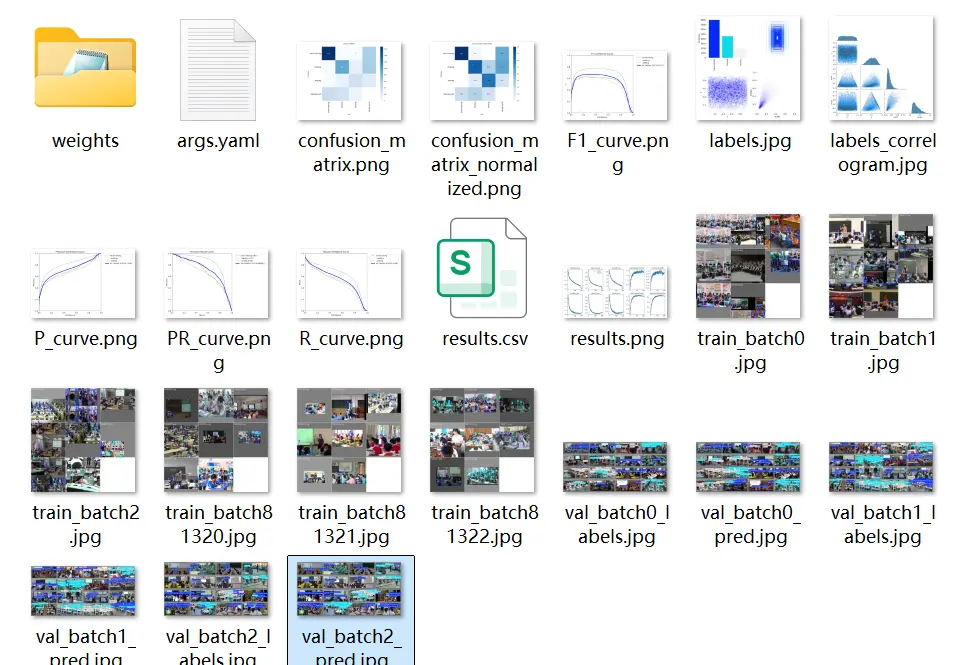

五、模型訓練與參數配置經驗

5.1 訓練策略

在課堂場景中,模型訓練重點並不是追求極限精度,而是:

- 穩定收斂

- 類別區分度清晰

- 推理速度可控

示例訓練命令:

yolo detect train \

data=dataset/classroom.yaml \

model=yolov8n.pt \

epochs=100 \

batch=16 \

imgsz=6405.2 關鍵指標解讀

訓練完成後,重點關注:

- mAP@0.5:是否穩定在 90% 左右

- 混淆矩陣:是否存在行為間嚴重混淆

- box_loss / cls_loss 收斂情況

課堂行為中,“看書 / 寫作業”是最容易混淆的類別,通常需要通過 數據平衡和樣本增強 來改善。

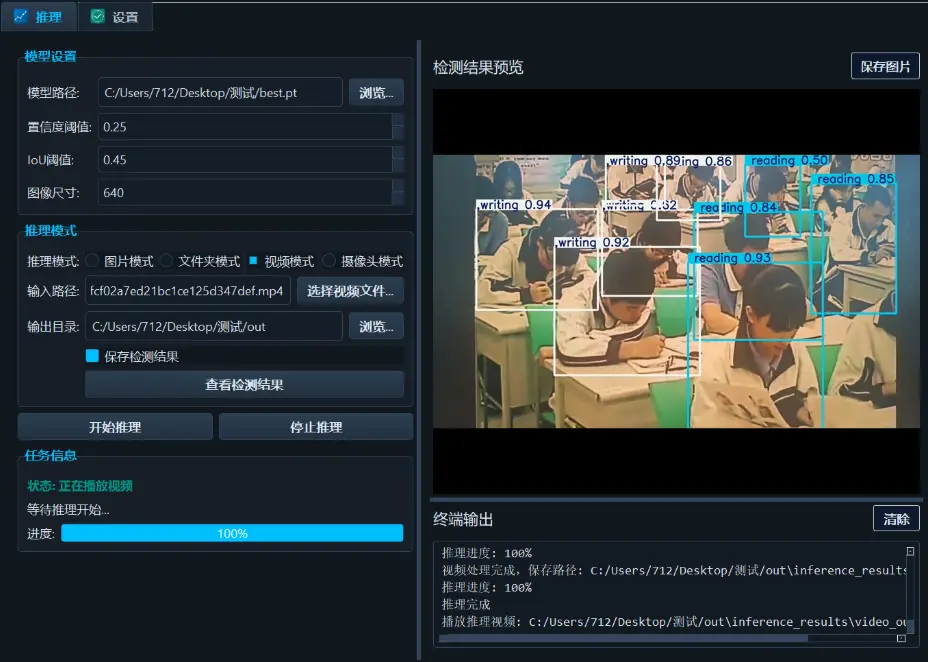

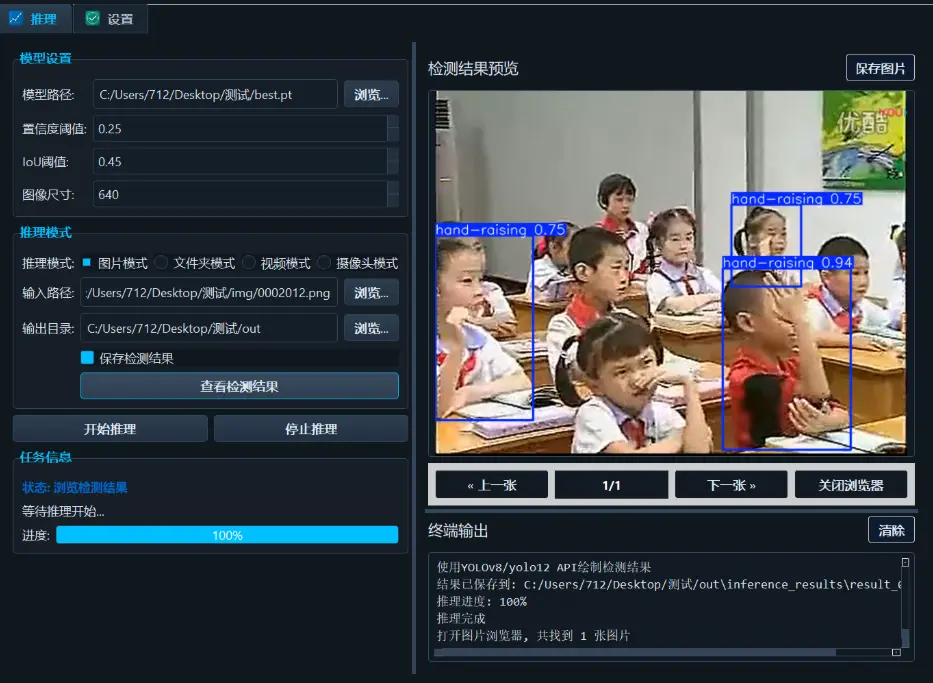

六、推理系統設計:從模型到可用軟件

如果説模型是“發動機”,那麼 GUI 系統就是“駕駛艙”。

6.1 多輸入推理設計

系統支持以下輸入形式:

- 單張圖片檢測

- 文件夾批量檢測

- 視頻文件檢測

- 攝像頭實時檢測

其核心思想是:

統一推理接口,不同輸入僅影響數據讀取方式

results = model(frame, conf=0.25)6.2 PyQt5 界面設計要點

GUI 設計遵循三個工程原則:

- 功能按鈕邏輯清晰

- 推理與界面解耦

- 避免阻塞主線程

常見功能包括:

- 模型加載

- 輸入源選擇

- 實時結果顯示

- 結果保存開關

這種設計使得非算法人員也能直接運行系統。

七、實際應用價值分析

在真實教學場景中,該系統可用於:

- 課堂狀態統計分析

- 教學質量評估輔助

- 學生行為數據可視化

- 智慧教室系統模塊化集成

相比“單純監控”,該系統更強調:

結構化行為數據的自動生成

八、可擴展方向與進階思路

該項目並非終點,而是一個可持續擴展的工程起點。

可擴展方向包括:

- 引入姿態估計(Keypoints)

- 多攝像頭聯動分析

- 行為時間序列建模

- 行為頻次 / 趨勢統計

- 與教學管理系統對接

未來可從“檢測行為”升級為:

理解課堂狀態

九、總結

本文從工程視角出發,完整覆盤了一個 基於 YOLOv8 的學生課堂行為識別系統 從需求分析、模型選擇、數據構建、訓練評估到 GUI 應用落地的全過程。

該項目的核心價值不在於“某一個模型指標”,而在於:

- 模型可實時運行

- 系統可直接部署

- 工程結構可持續演進

對於希望將 計算機視覺真正落地到教育場景 的開發者而言,這是一個非常具有實踐意義的方向。

本文從工程實踐角度系統性地梳理了一個基於 YOLOv8 的學生課堂行為識別系統的完整落地過程,涵蓋需求背景、模型選型、數據集構建、訓練評估以及 PyQt5 圖形化應用封裝等關鍵環節。實踐表明,目標檢測模型在課堂行為分析這一複雜場景中具備良好的實時性與可擴展性,能夠有效將“不可量化的課堂狀態”轉化為結構化、可分析的數據資產。相比單一算法實驗,本項目更強調模型與系統的協同設計,使 AI 能夠真正服務於教學管理與教學分析。未來,隨着姿態估計、多模態數據與行為統計分析的引入,該類系統有望從行為識別進一步升級為課堂狀態理解與教學決策支持,為智慧校園建設提供更加可靠的技術基礎。