一、工具開發背景與效果

在數據驅動決策的時代,社交媒體數據分析需求日益增長。作為一名資深開發者,我注意到研究人員常需要獲取微博公開數據進行學術分析。為此,我開發了這款專業級數據採集工具:爬微博博主軟件。旨在為學術研究提供技術支持。

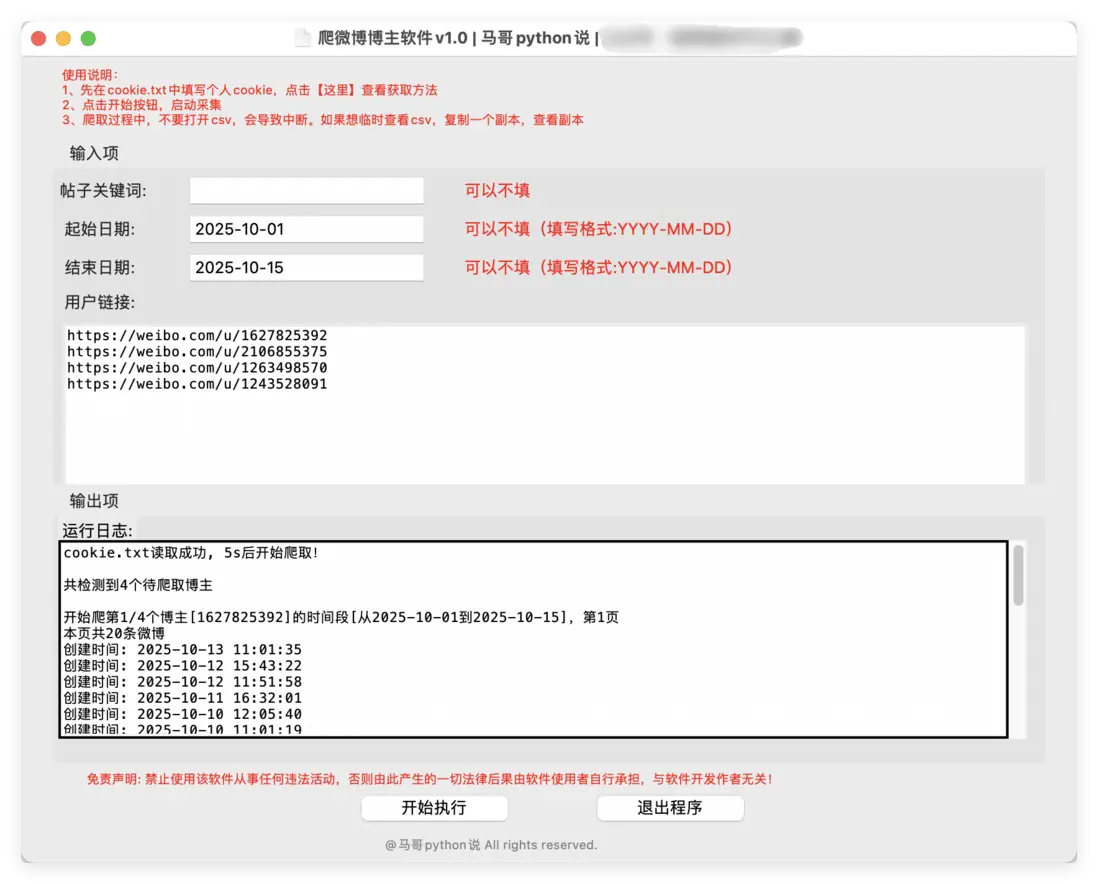

界面如下:

使用過程演示視頻:請見原文。

二、工具核心特性

2.1 系統兼容性

支持Windows和Mac雙平台運行無需複雜環境配置,開箱即用

2.2 數據採集機制

採用API接口協議進行數據獲取智能分頁採集,確保數據完整性請求間隔優化,符合平台規範

2.3 數據安全保障

實時增量保存機制

完善的日誌記錄

系統數據本地化存儲

三、技術架構解析

3.1 前端界面

基於tkinter框架開發GUI界面,提供直觀的操作體驗:

簡潔的輸入區域

實時的進度顯示

清晰的運行狀態提示

部份實現源碼:

# 創建主窗口

root = tk.Tk()

root.title('爬微博博主軟件v1.0 | ')

# 設置窗口大小

root.minsize(width=850, height=660)3.2 後端處理

核心功能模塊包括:

請求模塊:使用requests庫發送HTTP請求

解析模塊:處理JSON格式響應數據

部分實現源碼:

# 發送請求

r = requests.get(url, headers=h1, params=params)

# 接收響應數據

json_data = r.json()存儲模塊:

通過pandas進行結構化存儲

# 保存數據到DF

df = pd.DataFrame(

{

'博主暱稱': name_list,

'博主id': user_id,

'頁碼': page,

'微博id': id_list,

'微博bid': bid_list,

'微博鏈接': wb_url_list,

'發佈時間': create_time_list,

'發佈於': region_name_list,

'轉發數': reposts_count_list,

'評論數': comments_count_list,

'點贊數': like_count_list,

'話題標籤': topic_list,

'微博內容': text_list,

}

)

# 保存csv文件

df.to_csv(self.result_file, mode='a+', index=False, header=header, encoding='utf_8_sig')日誌模塊:

詳細記錄運行全過程。

部分源碼:

def get_logger(self):

self.logger = logging.getLogger(__name__)

# 日誌格式

formatter = '[%(asctime)s-%(filename)s][%(funcName)s-%(lineno)d]--%(message)s'

# 日誌級別

self.logger.setLevel(logging.DEBUG)

# 控制枱日誌

sh = logging.StreamHandler()

log_formatter = logging.Formatter(formatter, datefmt='%Y-%m-%d %H:%M:%S')

# info日誌文件名

info_file_name = time.strftime("%Y-%m-%d") + '.log'

# 將其保存到特定目錄

case_dir = r'./logs/'

info_handler = TimedRotatingFileHandler(filename=case_dir + info_file_name,

when='MIDNIGHT',

interval=1,

backupCount=7,

encoding='utf-8')

self.logger.addHandler(sh)

sh.setFormatter(log_formatter)

self.logger.addHandler(info_handler)

info_handler.setFormatter(log_formatter)

return self.loggerlog文件:

四、數據規範説明

4.1 採集字段

工具採集的微博數據包含以下維度:

字段:博主暱稱,博主id,頁碼,微博id,微博bid,微博鏈接,發佈時間,發佈於,轉發數,評論數,點贊數,話題標籤,微博內容

4.2 數據格式

輸出為標準化CSV文件:UTF-8編碼確保中文兼容規範的字段命名在數據驅動決策的時代,社交媒體數據分析需求日益增長。作為一名資深開發者,我注意到研究人員常需要獲取微博公開數據進行學術分析。為此,我開發了這款專業級數據採集工具:,旨在為學術研究提供技術支持。

五、使用規範與建議

- 合法使用:僅限學術研究用途

- 頻率控制:建議設置合理採集間隔

- 數據管理:妥善保存採集結果

- 版權尊重:引用數據時註明來源

六、作者聲明

本工具為原創開發,如需瞭解更多技術細節或進行專業交流,可通過正規渠道聯繫開發者(首發公眾號:老男孩的平凡之路)。工具使用需嚴格遵守相關法律法規和平台規定。