Open WebUI 是一個可擴展的、自託管的 AI 界面,完全離線運行。本期我們將展示如何在 DGX Spark 設備上部署集成 Ollama 服務器的 Open WebUI,然後通過本地瀏覽器訪問 Web 界面,同時模型在 DGX Spark 上運行。

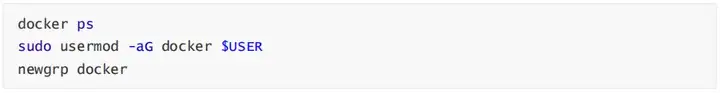

1. 配置 Docker 權限

從 NVIDIA Sync 打開終端應用程序,啓動交互式 SSH 會話並測試 Docker 訪問權限,在終端中運行。

如果看到權限被拒絕錯誤(例如嘗試連接到 Docker 守護程序套接字時出現權限被拒絕的錯誤),就把用户添加到 docker 組,這樣就不需要使用 sudo 運行命令。

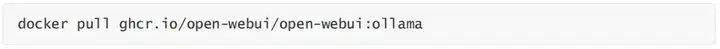

2. 驗證 Docker 設置並拉取容器

速度慢可以嘗試將 http://ghcr.io 換成 http://ghcr.nju.edu.cn

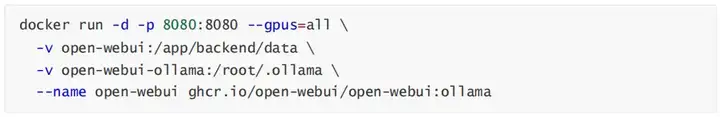

3. 啓動 Open WebUI 容器

這將啓動 Open WebUI 容器,我們可以通過本地網絡瀏覽器訪問 Open WebUI 界面。

應用數據會存儲在 open-webui 卷中,模型數據存儲在 open-webui-ollama 卷中。可以用docker volume ls 查看到這2個卷,如果不存在這2個卷,第一次運行容器會自動創建,默認路徑: /var/lib/docker/volumes/

4. 創建管理員賬户

- 創建管理員賬户

- 填寫管理員賬户創建表單

- 點擊註冊按鈕創建賬户並訪問主界面

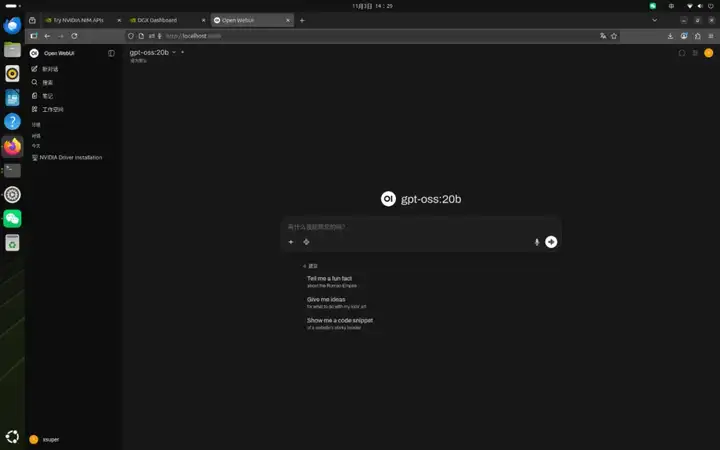

5. 下載並配置模型

- 點擊 Open WebUI 界面左上角的"選擇模型"下拉菜單

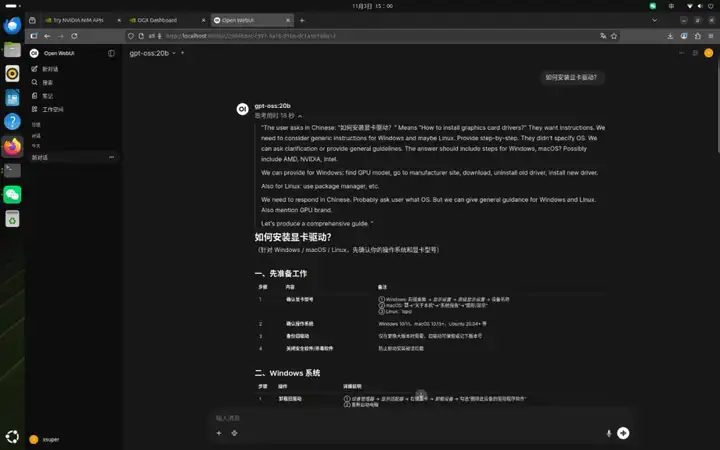

- 在搜索框中輸入 gpt-oss:20b

- 點擊出現的 "從 http://Ollama.com 拉取 'gpt-oss:20b'" 按鈕

- 等待模型下載完成,可以在界面中監控進度

- 完成後,從模型下拉菜單中選擇 "gpt-oss:20b"

6. 測試模型

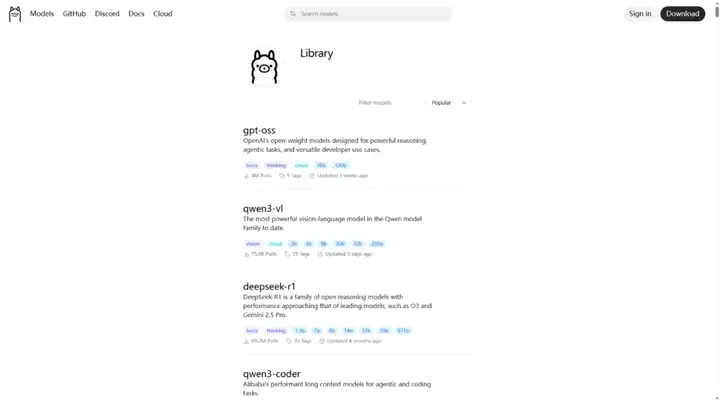

7. 下載其他模型

還可嘗試從 https://ollama.com/library 下載 Ollama 庫中的不同模型。