Flux 模型今年發佈之後,帶來了文生圖的一次升級,圖像生成的質量效果飛躍提升。

但 Flux 對顯存提出了要求。Flux.1 擁有高達12B的訓練參數。FLUX.1 [dev] 和 FLUX.1 [schnell]兩個版本官方原配模型大小為 23.8GB,需要至少 24GB 的顯卡才能順利運行。不過得益於FP8的支持,經過優化之後模型體積可縮減至 11.9GB,不過跑起來也至少需要 16GB 顯存的顯卡。

無論是模型訓練,還是生圖過程,batch size 等參數的調整都會直接影響顯存要求。贊奇工程師團隊近期對如下應用場景的高 batch size 情形進行了測試:

- Flux.1-dev Lora 訓練

- Flux.1-dev FP16 訓練

- Flux.1-dev FP8 訓練

- Flux.1 生圖

- SDXL 生圖

- Stable Diffusion 1.5 生圖

顯卡選擇

NVIDIA RTX™ 5000 Ada 及 NVIDIA RTX™ 5880 Ada 分別擁有32GB、48GB的高顯存,能夠很好地支持文生圖模型訓練以及 AIGC 生圖。我們選用這兩款顯卡進行測試。

NVIDIA RTX™ 5880 Ada 圖片來源於 NVIDIA

NVIDIA RTX™ 5000 Ada 圖片來源於 NVIDIA

測試結果總覽

接下來我們看看具體測試情況:

Flux.1-dev Lora 訓練

我們用單張 NVIDIA RTX 5000 Ada(32GB 顯存)進行了Flux Lora 訓練的測試。測試用例中尺寸設置512*512,batch size為 6,學習率0.00005,步數為3000時,GPU顯存佔用約30GB,顯卡利用率100%。

測試用例:

1、本地工作站配置

- GPU:NVIDIA RTX 5000 Ada (32GB) *1

- CPU: Intel i5-12600KF (3.7GHz) *1

- 內存:64GB

- 系統:win 11

2、訓練包版本

3、訓練參數:

- 數據集:帽子圖片與摳臉人物圖

- ComfyUI工作流

- 學習率:0.00005

- 分辨率:512*512

- Batch Size:6

- dim:16

- alpha: 8

- 步數:3000

其他全部為ComfyUI插件默認參數

*訓練數據集可與下方助手聯繫獲取

4、訓練成果

Flux.1-dev FP16 訓練

我們採用單張 NVIDIA RTX 5880 Ada(48GB)開展測試。測試用例中尺寸512*512,batch size為 6,學習率0.0003,步數設置10000時,顯卡顯存佔用約35GB,顯卡利用率到 93%,共耗時20小時15分,迭代一步約7.3秒。

測試用例:

1、本地工作站配置

- GPU:NVIDIA RTX 5880 Ada (48GB) *1

- CPU: Intel i5-12600KF (3.7GHz) *1

- 內存:64GB

- 系統:win 11

2、訓練參數

- Flux models:

- transformer: flux1-dev.safetensors

- vae: ae.safetensors

- clip_l: clip_l.safetensors

- t5: t5xxl_fp16.safetensors

- unetLR: 0.0003

- networkDim: 16

- 1rScheduler: cosine_with_restarts

- targetSteps: 10000

- networkAlpha: 2

- optimizerType: AdamW8Bit

- batch size:6

- dataset size: 512*512

- 數據集:207張

*詳細工作流可詳詢下方助手

3、訓練成果:

原圖:

訓練結果圖(部分):

Flux.1-dev FP8 訓練

我們繼續用單張 NVIDIA RTX 5880 Ada 進行高batch size的模型訓練。測試用例中 batch size 設置為11,分辨率512*512,學習率0.001,步數1000時,GPU顯存佔用約44GB,顯卡利用率到97%,共耗時3小時15分,loss 值0.067。

測試用例:

1、本地工作站配置:與 Flux FP16 訓練時相同

2、訓練參數:

- Flux models:

- transformer: flux1-dev.safetensors

- vae: ae.safetensors

- clip_l: clip_l.safetensors

- t5: t5xxl_fp8.safetensors

- unetLR: 0.001

- networkDim: 64

- 1rScheduler: cosine_with_restarts

- targetSteps: 1000

- networkAlpha: 32

- optimizerType: AdamW8Bit

- batch size:11

- dataset size: 512*512

數據集:30張

*詳細工作流可詳詢下方助手

3、訓練成果:

原圖:

訓練結果圖:

Flux.1 文生圖

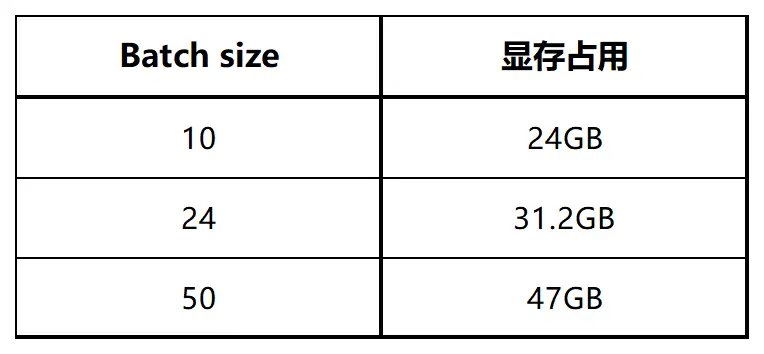

Flux.1 生圖測試中,在尺寸1024*1024,採樣步數50步的情況下:

1、工作流設置:

2、本地工作站配置:

- CPU: Intel i5-12600KF (3.7GHz) *1

- 內存: 64GB

- 系統: win 11

3、測試情況:

我們選用單張 NVIDIA RTX 5000 Ada (32GB) 顯卡測試了 batch size 為24時的情況。測試結果顯示,GPU 顯存佔用 31.2GB,GPU 利用率達99%,項目總耗時約18分鐘。

接下來,我們採用單張 NVIDIA RTX 5880 Ada (48GB) 測試了 batch size 為45至50時的情況。測試結果顯示:

當 batch size 為 45 時,GPU 顯存佔用 44GB,GPU利用率達 95%,項目測試用時27分鐘。

當 batch size 為 50 時,GPU 顯存佔用 47GB,GPU利用率達 97%,項目測試耗時約35分鐘。

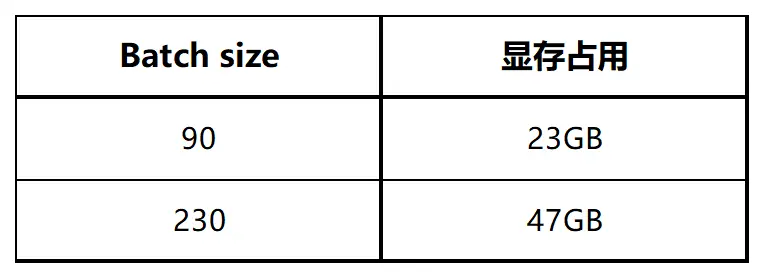

SDXL 生圖

SDXL生圖測試中,在設置尺寸1024*1024,採樣步數20步的情況下:

1、工作流設置:

2、本地工作站配置:同 Flux.1 文生圖測試。

3、測試情況:

我們選用單張 NVIDIA RTX 5000 Ada (32GB) 顯卡測試了 batch size 為 90 時的情況。測試結果顯示,在NVIDIA RTX 5000 Ada 加持下,GPU顯存佔用約23GB,GPU 利用率 97%,生圖時間約10分鐘,出圖效率非常高。

接下來我們用單張 NVIDIA RTX 5880 Ada (48GB) 顯卡測試了 batch size 為230 時的情況,GPU顯存佔用 47GB,GPU 利用率 99%,生圖時間約22分鐘。

Stable Diffusion 1.5 生圖

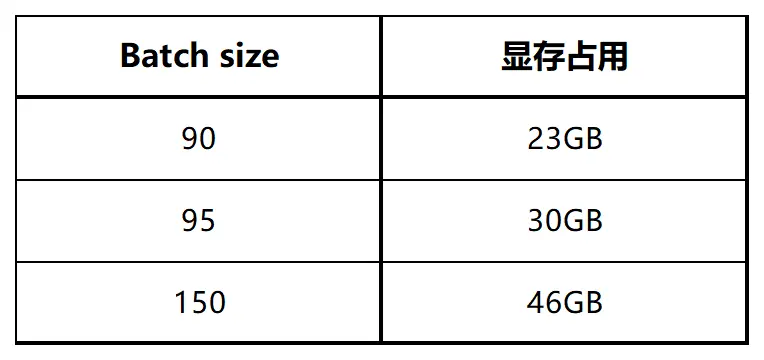

Stable Diffusion 1.5 生圖測試中,模型選用 AWPainting_v1.5.safetensors,尺寸1024*1024,採樣步數20步的情況下:

1、工作流設置:

2、本地工作站配置:同Flux.1 文生圖測試。

3、測試情況:

我們選用單張 NVIDIA RTX 5000 Ada (32GB) 顯卡測試了 batch size 為 90 時的情況。測試結果顯示,GPU顯存佔用約 23GB,GPU利用率100%,生圖時間約10分鐘,效率極高;batch size 為 95 時,顯卡顯存佔用至 30GB,GPU利用率 99%。

我們採用單張 NVIDIA RTX 5880 Ada (48GB) 顯卡測試 batch size 為 150 的情況。結果顯示,GPU顯存約佔 46GB,顯卡利用率 96%,生圖時間僅6分鐘,出圖效率非常高。

搭載超強顯卡 告別顯存焦慮

NVIDIA RTX 5000 Ada 與 NVIDIA RTX 5880 Ada 均具備超高顯存,在高 batch size 場景下能將生產力拉滿,妥妥地甩開顯存焦慮!

如想體驗超強顯卡的童鞋也可隨時申請、免費體驗:

顯卡規格

- 如想了解更詳細的測試情況可添加微信助手:XSuperZoneTech