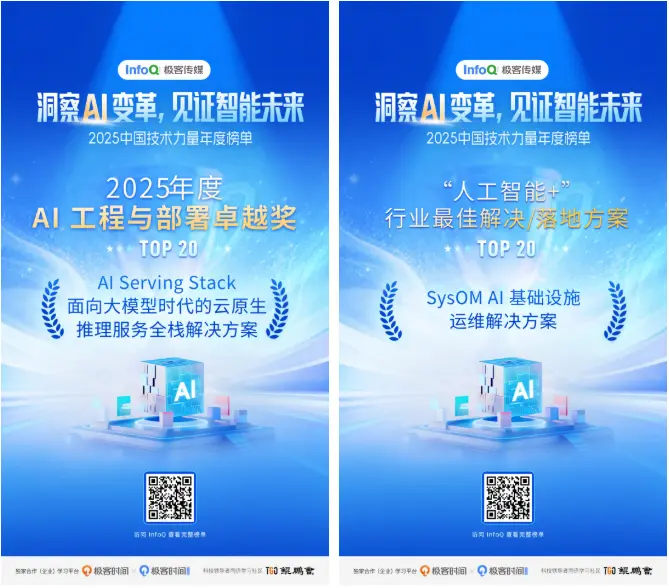

近日,InfoQ 極客傳媒攜手模力工場發起的 “2025 中國技術力量榜單” 評選結果正式揭曉。龍蜥社區與合作伙伴聯合提報的 “AI Serving Stack:面向大模型時代的雲原生推理服務全棧解決方案”,憑藉創新的 RBG 重新定義推理編排、智能調度實現差異化負載優化、以 KVCache 為中心的 PD 分離和以存換算架構等方面的突出創新,斬獲了 “2025 年度 AI 工程與部署卓越獎”。同時,“SysOM AI 基礎設施運維解決方案”憑藉在大規模 AI 訓推集羣的“分鐘級發現、小時級定界”能力、及持續性能剖析與資源效能提升上的領先實踐,榮獲“‘人工智能+’行業最佳解決/落地方案”獎項。

在“人工智能 +”行動規劃的推動下,人工智能已從前沿技術逐漸演變為驅動產業升級與經濟轉型的關鍵力量。2025 年,中國 AI 技術落地與產業應用進入加速期。龍蜥社區積極佈局 AI 基礎軟件棧,在操作系統內核、工具鏈與運維體系等關鍵環節持續創新,構建起支撐大模型高效訓練與推理的堅實底座。

大模型推理正演變為"最昂貴的微服務"——既需 HPC 集羣的極致性能,又要求雲原生的敏捷彈性。AI Serving Stack 是由龍蜥社區與 SGLang 社區、Mooncake 社區、清華大學、南京大學、小紅書、算秩未來、科大訊飛和阿里雲聯合打造,堅持全棧開源理念,採用開放治理模式,100% 開源架構讓企業可零成本快速落地。作為大模型生產級”最後一公里”難題的解決方案,AI Serving Stack 填補開源社區在“生產級 LLM 推理編排”領域的空白,提供了從部署管理、智能路由、彈性伸縮、深度可觀測的一體化能力,助力企業無論處於 AI 應用初期還是已運行大規模推理業務,都能輕鬆駕馭複雜的雲原生 AI 推理場景。依託領先的 RBG 部署編排機制、智能負載調度策略,以及以 KVCache 為中心的 PD 分離架構和以存換算架構,AI Serving Stack 實現數倍性能提升,顯著降低推理成本。未來,AI Serving Stack 將以更加開放的生態聚合產學研智慧,為產業提供從“能跑通”到“高可用、高吞吐、高彈性”的質變路徑。

SysOM(System Operation&Maintenance)是龍蜥社區系統運維 SIG 打造的一站式操作系統運維平台,通過監控、診斷、持續性能剖析等一體化解決方案,具備常態化、無侵入、低開銷、可視化分析等特點,廣泛應用於教育、醫療、電商、智駕等場景的性能診斷和分析優化。SysOM AI 基礎設施運維解決方案是圍繞訓練及推理場景“MTTR (平均修復時間)長、無效訓練時間長”等痛點,以“1 分鐘極速發現、5 分鐘快速定界定位問題”為目標,顯著提升整體訓推效率。目前,龍蜥社區系統運維聯盟成員單位阿里雲已基於 SysOM 項目發佈了操作系統控制枱,操作系統控制枱為用户提供全面的系統資源監控、問題分析和故障解決能力,旨在優化系統性能,顯著提升運維效率和業務穩定性。未來,SysOM 將會繼續幫助提升訓推業務場景萬卡集羣規模的 GPU 利用率等問題而努力。

操作系統控制枱地址:https://alinux.console.aliyun.com/

此前,龍蜥社區及龍蜥操作系統也獲得了業界的廣泛認可,榮獲 OS2ATC 2025 “最具影響力開源創新貢獻獎”、龍蜥操作系統通過工信部電子標準院首批開源項目成熟度評估,唯一獲得“卓越級”(最高等級)的開源項目等 40+ 行業獎項。未來,龍蜥社區將持續深耕 AI 與操作系統融合創新,攜手更多合作伙伴,共建開放、高效的下一代智能基礎設施底座。

完整榜單見鏈接:https://www.infoq.cn/zones/chinatechawards2025/

—— 完 ——