近日,2025 龍蜥操作系統大會(OpenAnolis Conference,簡稱 2025 龍蜥大會)於北京圓滿結束。同時,由阿里雲智能集團編譯器技術總監李三紅,龍蜥社區運營委員會副主席、龍騰計劃生態負責人金美琴聯合出品的“數據×模型×軟件”分論壇也圓滿舉辦。來自阿里雲、安謀科技、HiEV大蒜粒車研所、中興通訊以及清華大學、澳門大學等企業和高校的 12 位大咖,從操作系統與上下游生態協同的視角出發,與參會嘉賓一起探討了如何通過技術協作加速智能駕駛的進步,分享了各自在自動駕駛技術棧中的前沿實踐與生態思考。以下文章轉自 HiEV 大蒜粒車研所公眾號:

過去兩年,隨着大模型的發展,智駕行業行業似乎進入一場“軍備競賽”。從大規模裝車量產,採集數據餵養模型迭代,“算力”成為一段時間內主機廠們關注的焦點,行業甚至有「千卡是門檻,萬卡是入場券」的説法。

從 BEV+Transformer 到端到端,再到如今大熱的 VLA(視覺-語言-動作)模型,參數量指數級膨脹,讓整個行業陷入了一種“囤卡狂熱”。

彷彿只要堆砌了足夠的 H100 或 H800,L3 甚至 L4 級別的自動駕駛能力就會在 Scaling Law 的魔法下,自動涌現。

在前不久的 2025 龍蜥操作系統大會“數據×模型×軟件”分論壇上,我們聽到了一些冷靜得近乎“潑冷水”的聲音。

主持人在圓桌討論的時候提到一個很有意思的事情:

之前微軟 CEO 薩提亞·納德拉在接受採訪的時候就感慨過,即便擁有大量的 GPU,也面臨着缺乏足夠的物理基礎設施(如機櫃與電力環境)來安置它們的尷尬境地。

這也折射出了智駕行業一個被長期掩蓋的痛點:單純依靠堆砌 GPU,想“大力出奇跡”的模式,正在撞上一堵「物理現實與經濟成本」的牆。

當行業的焦點都集中在英偉達、華為昇騰這些台前的“算力卡”上時,一場關於操作系統、基礎軟件與異構計算的“隱形戰爭”早已在水面下打響。

阿里雲副總裁李俊平在開場致辭中提出了一個公式:AI 的效能 = 數據(燃料)× 模型(引擎)× 軟件(油門和方向盤)。

(圖/阿里雲副總裁李俊平)

今天的智駕競爭,正在從單一的模型之爭,演變為這三者乘積效應的系統工程對抗。

這屆智駕,被“數據搬運”卡脖子

“談卡傷感情,沒卡沒感情。”這是前兩年智駕圈的真實寫照。但到了 2025 年,很多車企發現,即便斥巨資買來了卡,訓練效率卻並沒有線性增長。

問題出在哪?GPU 在“偷懶”。

這其實不是什麼硬件故障,而是數據“喂”得不夠快。

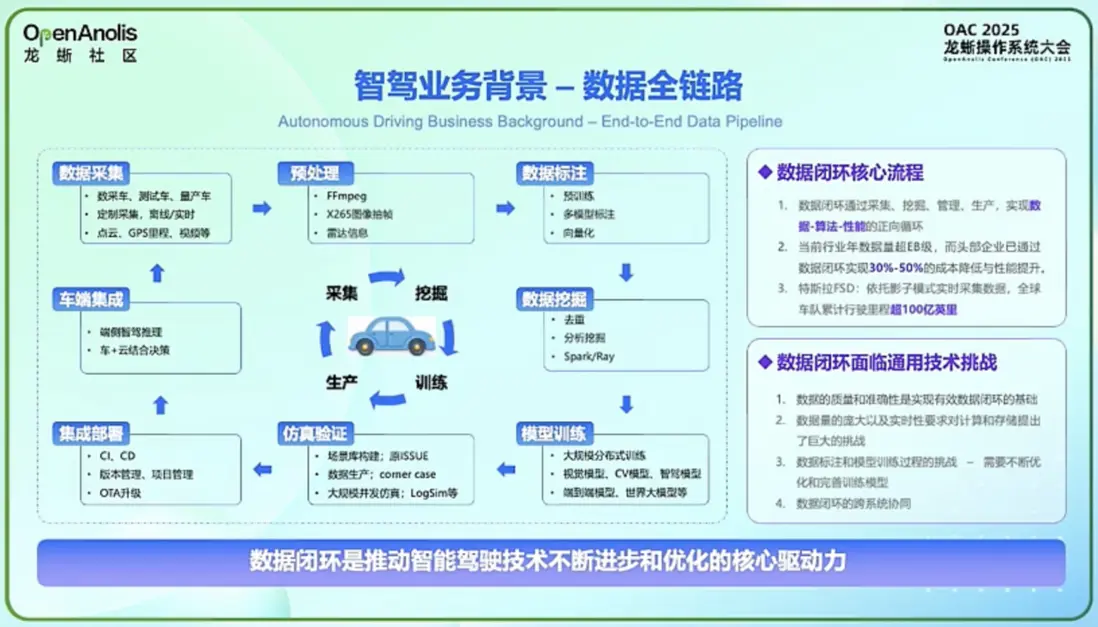

智駕研發並非只有模型訓練這一個環節,它是一個包含數據採集、清洗、標註、挖掘、訓練、仿真到端側部署的一條長長的數據閉環。

阿里雲智能集團高級架構師張先國分享了一組數據:智駕研發團隊,雲端存儲的數據總量通常已達到 400PB 到 800PB,日增量在 1PB 以上。一個智駕企業同時進行多個模型訓練,消耗的算力經常需要萬卡以上。

(圖/阿里雲智能集團高級架構師張先國)

想象一下,GPU 就像是一台擁有 F1 引擎的賽車,但如果給它輸油的管子(I/O帶寬)只有吸管那麼細,引擎空轉就在所難免。

在 2025 龍蜥大會的現場,多位專家指出了“數據閉環”中存在的隱形關卡: 一個是數據加載的問題。訓練開始前,海量的小文件(圖片、標註信息)需要從存儲層搬運到計算層。另一個是預處理可能遭受的瓶頸:視頻需要抽幀、解碼、清洗,訓練集羣就在那裏,但數據卡在緩存層過不來,GPU 只能閒置等待。

阿里雲智能集團產品專家錢君在演講中提到,為了解決這個問題,行業正在把目光投向存儲與操作系統的底層優化。

(圖/阿里雲智能集團產品專家錢君)

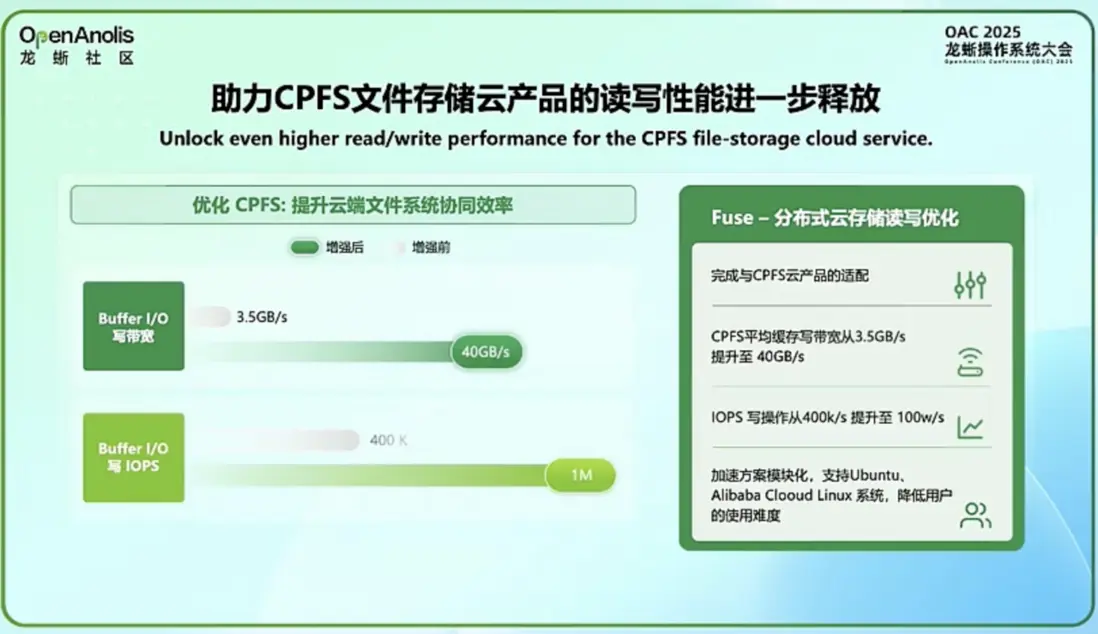

例如,龍蜥操作系統(OpenAnolis)給出的方案是全鏈路的“疏通”:針對 CPFS(並行文件系統),龍蜥在 OS 層面進行了深度適配。緩存寫場景下的性能可以直接提升 10 倍。這意味着模型訓練中的 Checkpoint 保存時間大幅縮短:以前需要幾小時,現在幾十分鐘就能搞定。 這種“看不見”的基礎設施優化,雖然沒有新開發一個大模型那麼性感,但它決定了生產智能的效率和成本,是讓萬卡集羣真正跑滿的關鍵。

CPU:被忽視的“異構協同”

在智駕的模型訓練中,公眾通常認為關鍵的算力在於 GPU;但在本屆大會上,“CPU 的挖掘”成為當下的新共識。

“不能只關注 GPU,CPU 在數據預處理、存儲 I/O 及邏輯控制中扮演着關鍵角色。” 中興通訊操作系統產品副總經理胡衝在圓桌討論中直言。

(圖/中興通訊操作系統產品副總經理胡衝)

事實上,在視頻轉圖片(抽幀)、數據清洗、以及 Spark 大數據分析環節,CPU 才是主力軍。而且,隨着架構的演進,Arm 架構的服務器 CPU(例如如阿里雲倚天 710 )正在展現出獨特的優勢。

(圖/安謀科技(Arm China)雲人工智能事業部總監侯科鑫)

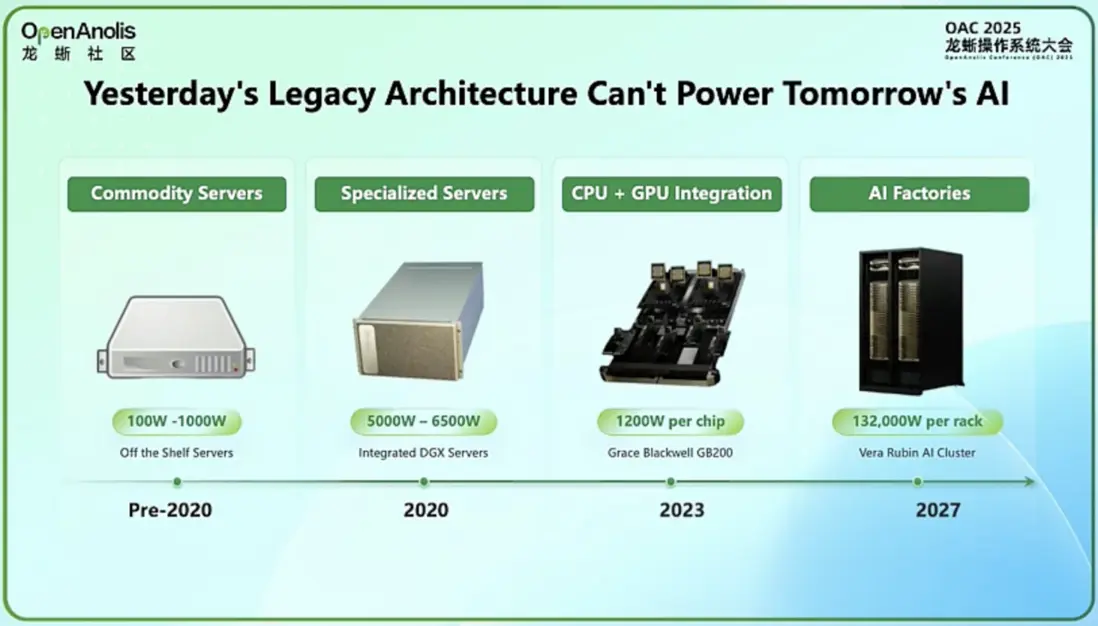

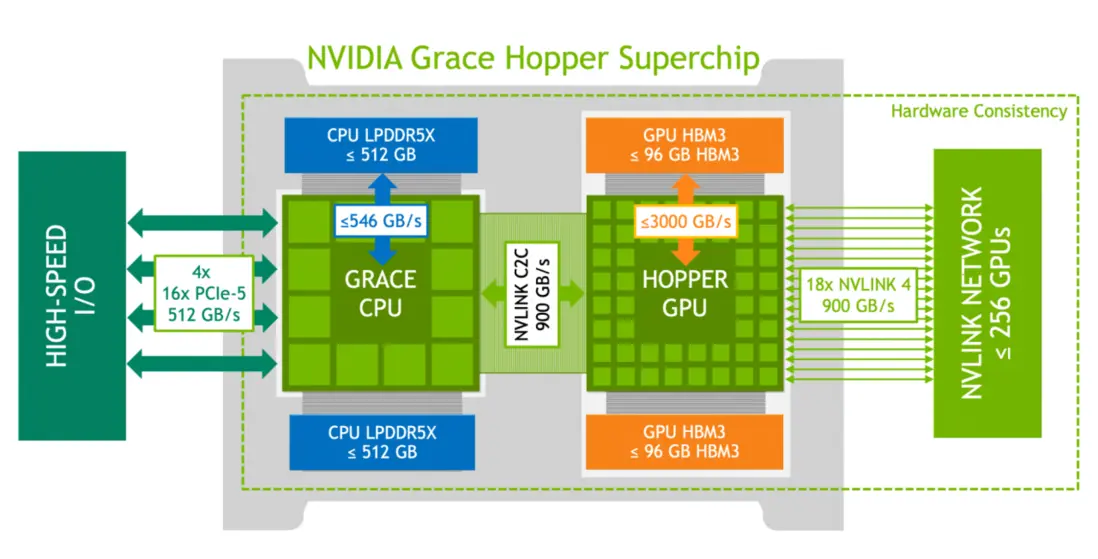

安謀科技(Arm China)雲人工智能事業部總監侯科鑫女士,在演講中向現場觀眾展示了數據中心架構的演進邏輯:隨着 NVIDIA Grace Hopper 異構加速平台的推出,CPU 與 GPU 的“緊密協同處理”已成為行業明確的發展方向。

為什麼要協同?是為了打破“內存牆”。

“視頻處理並不是簡單的計算,它對高負載下算力要求極高。”張先國指出。

智駕訓練需要把每秒視頻抽幀為 8-32 張圖片,在視頻解碼計算(如 H.264/H.265 格式)的高併發場景下,傳統的 x86 架構,由於睿頻(超線程)機制和功耗牆的存在,在高負載下往往會降頻。

而張先國分享的實測數據顯示,Arm 架構處理器憑藉更多的物理核和大緩存(L1/L2 Cache),在智駕數據處理場景下表現驚人:

首先是視頻抽幀,性能比傳統 x86 提升約 20%,成本卻降低了 20%-30%;

大數據清洗方面,由於擁有更大的 Cache(緩存),數據 Miss 率極低,這意味着 CPU 不需要頻繁地去內存“搬磚”,從而使端到端性能提升了 30%,在部分場景下甚至實現了翻倍。

一個高效的智駕雲端底座,必須是 CPU 與 GPU “各司其職、緊密抱團”的異構系統。

侯科鑫還從更宏觀的維度講述了硬件底座的變遷。她指出,為了打破“內存牆”和功耗瓶頸,數據中心正在從通用服務器向“定製化 SoC + Chiplet”演進。

NVIDIA 的 Grace Hopper 平台就是典型案例——通過將 Arm 架構 CPU 與 Hopper GPU 緊密互聯,實現內存共享,極大降低了數據搬運的延遲。這種 CPU 與 GPU 緊密協作的架構,正是為了解決單一算力無法應對複雜數據流的困境。Arm 推出的 Total Design 生態和 Neoverse CSS,正是以推動異構計算規模化落地為核心目標,讓芯片設計公司能節省大量工程投入,快速構建這種異構計算的「高速公路」。

(圖片來源:NVIDIA)

基礎軟件的魔法:不堆卡也能讓訓練變得更快

摩爾定律在放緩,硬件的紅利正在吃緊。這時候,軟件工程的價值就被進一步放大了。阿里雲智能集團編譯器技術總監李三紅在圓桌環節提到了一個非常典型的矛盾:模型開發者的“爽”和底層工程師的“痛”。

(圖/阿里雲智能集團編譯器技術總監李三紅)

算法工程師喜歡用 PyTorch 的 Eager 模式,因為這樣寫代碼像寫 Python 一樣靈活,所見即所得;但這種模式對底層硬件極其不友好,運行效率低。而底層工程師希望用 Compile 模式,把代碼編譯成極致優化的機器碼,但這又要求上層改代碼,門檻極高。

“上層的模型開發者追求開發效率(Eager Mode),底層的 Infra 追求成本和性能,這中間的 Gap(鴻溝),就是基礎軟件的機會。” 阿里雲智能集團編譯器技術總監李三紅在圓桌討論中一針見血地指出。

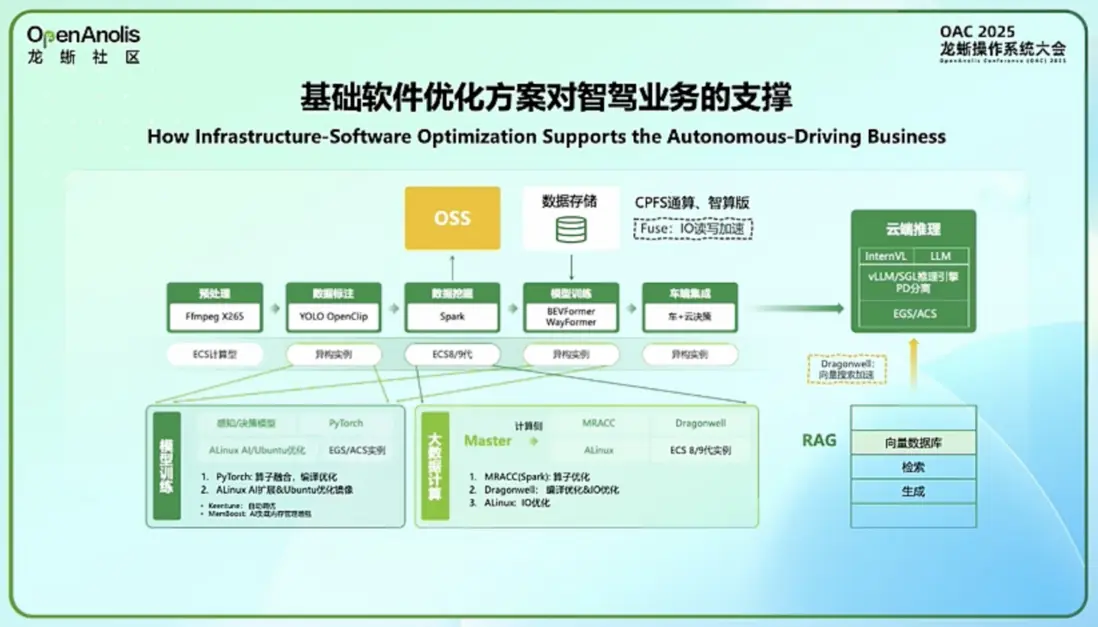

針對如何填補這一鴻溝的問題,阿里雲智能集團產品專家錢君與高級架構師張先國在隨後的演講中展示了龍蜥操作系統(OpenAnolis)如何通過全鏈路優化,在不改變硬件的情況下“白撿”性能:

- 存儲加速(IO 吞吐): 針對 CPFS(並行文件系統),系統在 OS 層面進行了深度適配。錢君披露的數據顯示,在緩存寫場景下,性能提升了驚人的 10 倍。這意味着模型訓練中的 Checkpoint 保存時間大幅縮短,斷點續訓不再是噩夢。

- 網絡加速(打破 TCP 限制): 張先國指出,通過部署自研的 eRDMA 協議,相比傳統 TCP,延遲降低 3 倍,帶寬提升 4 倍(實測可達 18GB/s)。這讓數據在節點間的跳躍如同在本地總線般順滑。

- 編譯器優化(榨乾每一滴算力): 針對 PyTorch 等框架的運行效率痛點,利用 AI Compiler 進行算子融合。據錢君介紹,這套方案在部分通用模型上帶來了接近 100% 的性能提升,有效地解決了開發靈活性與運行效率不可兼得的難題。

效果有多明顯?

地平線和小鵬汽車的案例顯示,通過這一套“操作系統+編譯器+調度”的組合拳,部分場景下的性能提升可達 30% 甚至 100%,而成本卻能下降 20%-60%。

在「降本增效」成為汽車產業主旋律的 2025 年,這種來自基礎軟件的“軟實力”,比盲目堆更多的卡,更有性價比。

眺望未來:世界模型與“合成數據”

如果説當下智駕行業發展的痛點是“效率”,那麼未來的挑戰可能會是“認知”。

清華大學人工智能研究院視覺智能研究中心主任鄧志東教授在圓桌論壇上拋出了一個前瞻性觀點:智駕模型正在從單純的感知,向世界模型(World Model)演進。

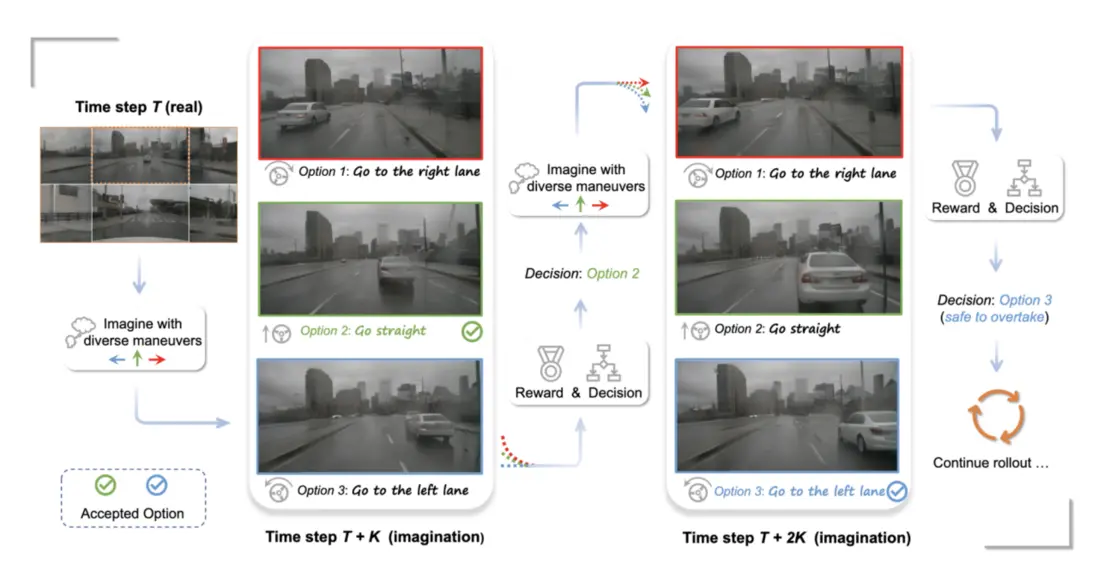

圖片來源:CVPR 2024 Driving into the Future: Multiview Visual Forecasting and Planning with World Model for Autonomous Driving

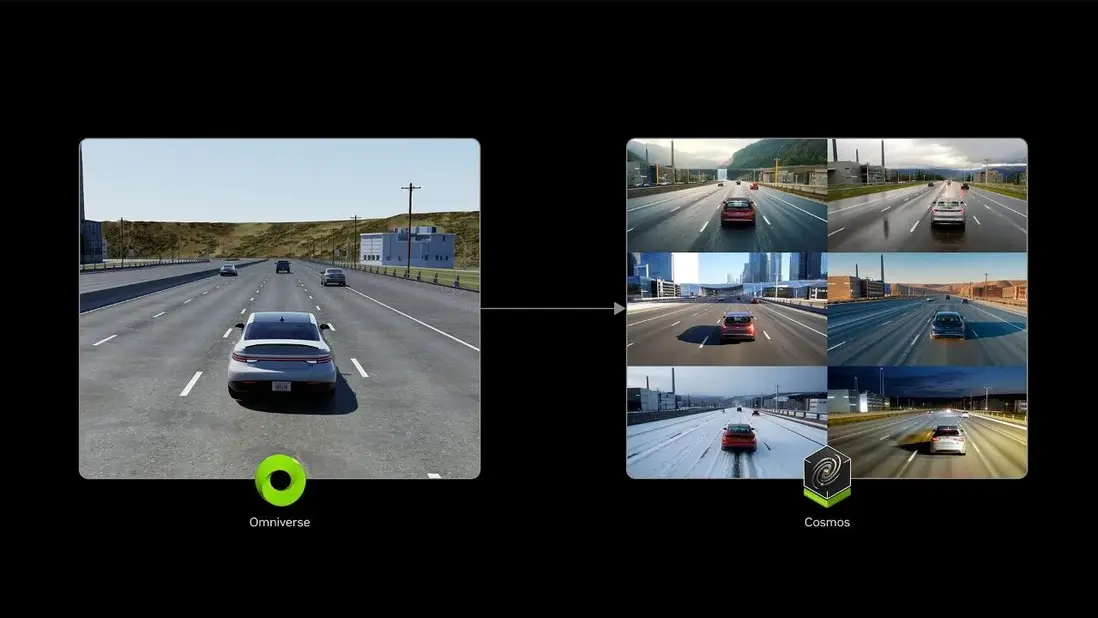

目前的端到端大模型,雖然能處理很多場景,但面對極端的 Corner Case(長尾場景),靠實車採集的數據永遠是不夠的。

(圖片來源:NVIDIA)

“路是跑不完的,但世界是可以被模擬的。”

但這種演進這種演進對基礎設施提出了更苛刻的要求:

- 算力需求的指數級爆炸: 世界模型極重,不僅需要理解物理世界,還要生成虛擬物理世界。這可能需要數百億甚至更高的算力支撐,甚至觸及到供電能力的邊界。

- 合成數據的崛起: 真實路採數據的效率太低且稀缺。未來,大量的訓練數據將來自“虛擬物理世界”的高效生成。這對 GPU 的渲染能力和 CPU 的邏輯模擬能力提出了雙重挑戰。

- 軟件定義的靈活性:正如中興操作系統產品線副總經理胡衝在圓桌中所感慨的,算法迭代極快——“去年可能還是 BEV,今年就是 VLA 了”。而阿里雲李三紅也證實,一線技術團隊確實清晰感知到了模型向 VLA 及世界模型演進的趨勢。這種軟件層面的極速狂奔,與硬件芯片較長的迭代週期形成了鮮明對比。這就要求編譯器和操作系統必須具備極強的適應性,通過軟件定義來抹平硬件迭代的時間差。AI 不僅要“看懂”視頻,還要能“生成”視頻,甚至要理解牛頓定律。

鄧教授指出,這需要底層算力支持極其複雜的“虛實遷移”。這意味着,未來的操作系統不僅要調度計算,還要調度“物理世界的規則”。

(圖/清華大學教授、清華大學人工智能研究院視覺智能研究中心主任鄧志東)

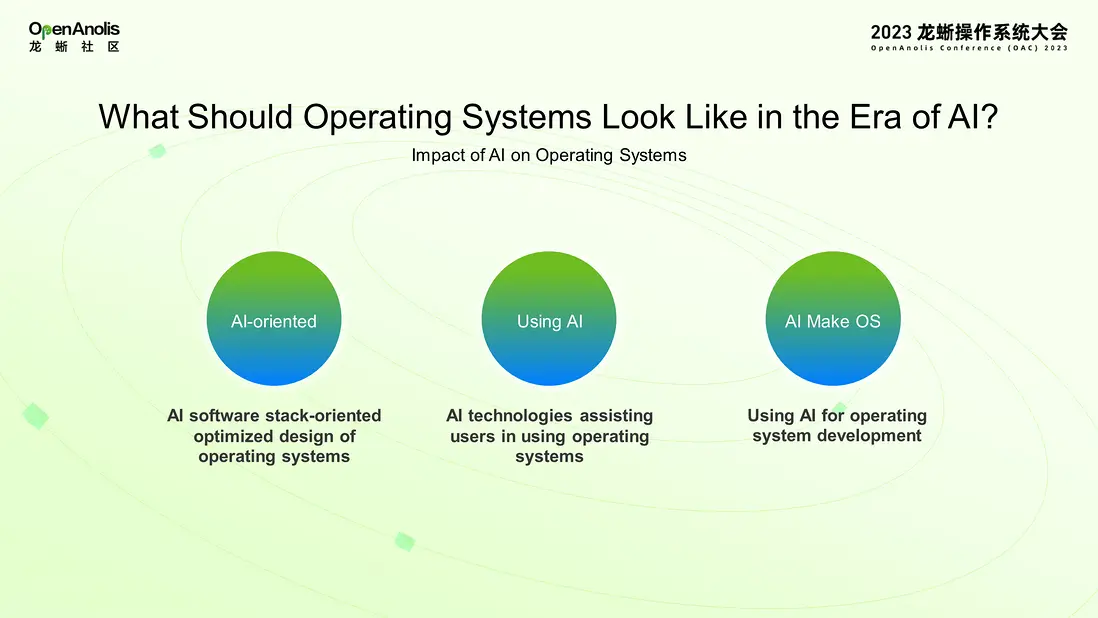

這也解釋了為什麼像龍蜥這樣的開源社區,開始在這個階段強調“ AI 原生操作系統”的概念——因為舊的底座,真的撐不住新的世界了。

開源底座的長期主義

從 2025 龍蜥大會的這場分論壇中,我們看到了汽車科技行業的一個明顯轉折:

大家不再盲目迷信硬件的堆砌,開始迴歸計算機科學的常識——系統協同。

面對 Arm、x86、RISC-V 等複雜的芯片架構,面對日新月異的模型算法,車企和智駕公司不可能每一家都去從零手搓一套底層軟件。

而龍蜥社區的存在,就是為了提供一個標準化的技術底座,屏蔽底層異構硬件(不同架構的 CPU、GPU、NPU)的差異,讓車企和智駕公司能夠專注於上層模型和算法的創新。正如 Arm 通過 Arm Total Design 聯合產業鏈一樣,軟件層面也需要這樣一個“連接器”來降低全行業的試錯成本。

正如胡衝所言:“通過社區共建、共享,降低車企的研發門檻與成本,是解決算力荒的另一種路徑。”

在算力資源有限、成本高企、模型日趨複雜的背景下,誰能更高效地榨乾每一 Tops 算力的價值,誰能以更低的成本完成數據的閉環流轉,誰就能在 L3+ 的量產前夜活下來。

數據是資產,模型是能力,而軟件與操作系統,是這一切的根基。

自動駕駛的下半場,不再是單點技術的突破,而是“數據-模型-軟件”全鏈路的生態戰爭。在這個戰場上,那個由 CPU、操作系統、編譯器、文件系統構成的龐大“新基座”,正在成為決定勝負的隱形力量。

對中國的自動駕駛產業而言,建立一個自主、可控、高效的基礎軟件生態,其戰略意義或許絲毫不亞於擁有幾萬張顯卡。

因為只有根扎得夠深,智能的樹才能長得夠高夠穩。

本次分論壇回顧已上線,歡迎點擊下方鏈接查看回放:https://openanolis.cn/openanolisconference2025

—— 完 ——