汽車行業趨勢與核心挑戰

近年來,新能源汽車加速普及,智能座艙、車聯網和智能輔助駕駛等技術已成為整車廠商競爭的關鍵。這些功能基於端雲協同架構,雲端基礎設施至關重要——無論是用户在車上點播音樂、遠程控制車輛,還是智能車聯網系統上傳傳感器數據,背後都離不開穩定、高效的基礎設施雲平台支持。

隨着車輛聯網率的提升以及 AI 模型能力的增強,汽車行業IT系統的數據吞吐量與計算負載呈指數級增長。一輛具備智能輔助駕駛能力的測試車,單日即可產生數 TB 的原始數據;一次面向百萬用户的 OTA 升級,也可能在短時間內引發流量洪峯。在此業務特點下,雲端基礎設施的穩定性已成為直接影響用户體驗甚至行車安全的核心環節。

汽車行業的基礎設施面臨的四大核心運維挑戰

在上述業務壓力下,支撐汽車場景的基礎設施頻繁遭遇以下四類典型問題,傳統的運維手段往往難以有效應對:

1、週期性高峯業務-資源超載與系統夯機

在 OTA 推送或早晚高峯、節假日遠程控制集中觸發時,服務器內存和 CPU 瞬時過載,系統進入“假死”狀態——進程無法調度、命令無響應,即使未完全宕機,業務也已不可用。

2、出行服務下的資源超賣-內存失控與服務中斷

內存泄漏、緩存膨脹或顯存異常增長等問題隱蔽性強,初期不易察覺,但會逐步耗盡系統資源,最終觸發OOM(Out-Of-Memory)導致關鍵進程被強制終止,服務中斷。

3、車聯網服務響應遲滯-性能抖動與偶發卡頓

系統在多數時間運行正常,卻偶爾出現毫秒級延遲突增,且無法穩定復現。這類問題通常源於鎖競爭、高頻系統調用或 I/O 瓶頸,傳統監控指標難以捕捉根因。

4、智能駕駛業務-智算可觀測能力缺失

在 GPU 集羣中,顯存使用異常、NCCL 通信失敗、任務卡死等問題頻發,但缺乏從應用層到硬件層的全棧觀測能力,導致排查週期長、依賴人工經驗,嚴重影響模型訓練與推理效率。

這些問題共同指向一個核心訴求:汽車行業需要一套能夠貫通“應用—操作系統—硬件”的智能運維體系,實現故障的提前預警、精準定位與自動恢復,而非被動響應。

通過操作系統管理平台一站式解決 OS 運維卡點

操作系統管理平台介紹

操作系統控制枱是阿里雲自研的操作系統管理平台,覆蓋主流 Linux 操作系統,旨在為客户提供便捷易用、高效、專業的操作系統生命週期管理能力,包括運維管理、操作系統智能助手 OS Copilot、訂閲等功能,支持通過界面、OpenAPI、MCP、CLI 等多種方式提供服務。致力於降低操作系統的技術門檻,通過系統解決客户應用與雲平台運維信息不對稱等問題,提升用户的雲上體驗。操作系統控制枱智能運維可以讓用户擺脱冗長的運維垂直棧和分析鏈,讓平台更懂用户業務的異常根因,懂資源的消耗。

操作系統控制枱地址:https://alinux.console.aliyun.com/

解決方案概述

面對智能座艙與自動駕駛業務對雲端基礎設施提出的高併發、低延遲、強穩定等嚴苛要求,傳統運維手段已難以應對資源超載、內存失控、性能抖動和 AI 任務異常等複雜問題。操作系統控制枱作為面向汽車行業的綜合運維平台,致力於打通“應用—操作系統—硬件”全棧鏈路運維能力。

場景化解決方案與核心能力

針對智能座艙、自動駕駛等業務以上提到的汽車行業四大典型運維痛點,操作系統控制枱推出對應的診斷及觀測能力,在常見的夯機、OOM、抖動及 AI 觀測都給出了對應的解決方案,彌補汽車行業的企業在基礎設施可觀測性的能力短板。

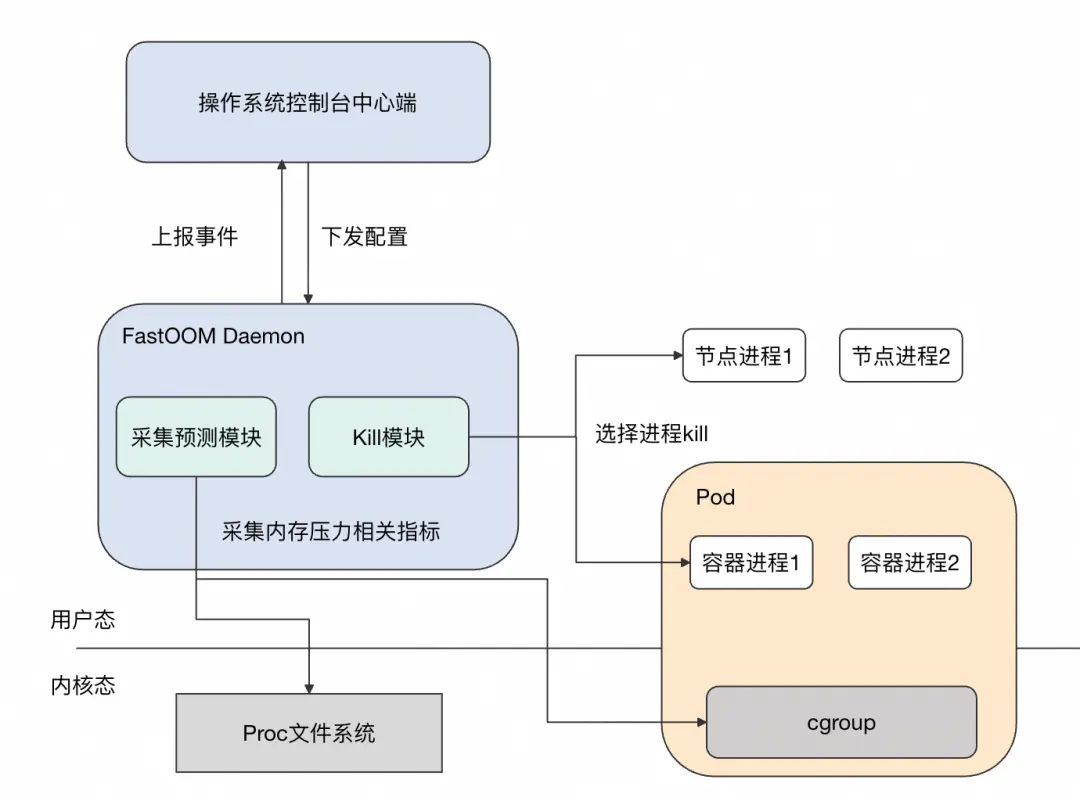

應對資源超載與系統夯機 —— 主動內存保護

核心收益:解決用車週期性高峯業務場景,資源的夯機問題,減少業務卡頓及異常。

適用場景:OTA 大規模推送、遠程控制指令洪峯、AI 模型高併發推理等瞬時高負載場景。

在高峯期,系統常因內存迅速耗盡而進入“near-OOM”狀態,傳統 Linux OOM 機制響應滯後,往往在系統已卡死或無響應後才觸發進程終止,且易誤殺緩存型或 I/O 密集型進程,進一步加劇磁盤壓力。

通過以下機制實現主動防護:

- 堆內存精準評分:不再依賴 RSS(常駐內存),而是聚焦可回收的堆內存使用量,更準確識別真正造成內存壓力的進程。

- 批量終止策略:單次釋放不足以緩解壓力時,可同時終止多個高內存佔用進程,快速釋放大量內存。

- 多級壓力響應:支持低、中、高三檔靈敏度配置,適配不同業務對延遲的容忍度。

- 關鍵進程白名單:通過進程名或命令行參數顯式保護車控、推理等關鍵服務,避免誤殺。

在內存壓力上升初期即介入干預,有效防止系統夯機,保障遠程控制、OTA 下發等關鍵指令的可達性和執行時效。

破解內存黑盒 —— 內存全景分析

核心收益:解決出行出行服務下的資源超賣所引起的服務中斷問題,提升業務連續性。

適用場景:內存使用率持續飆升、頻繁觸發 OOM、緩存佔用異常、GPU 顯存增長不明等複雜內存問題。

傳統運維難以回答“內存到底被誰用了”——是應用泄漏?文件緩存堆積?還是驅動或 GPU 隱性佔用?內存全景分析提供統一、細粒度的內存視圖。

- 一鍵生成全鏈路報告:無需登錄機器,控制枱點擊即可輸出包含進程、容器、緩存、驅動、GPU 顯存的完整內存分佈。

- 穿透應用堆內存:支持對 Java、Python、C++ 等語言進程的堆內對象進行二次拆解,定位具體泄漏點。

- 關聯緩存與原始文件:如識別出“/ota/firmware_v2.1.bin”佔用了 8GB page cache,便於優化預加載或清理策略。

- 納入 GPU 與網卡內存:將 RDMA 緩衝區、GPU 顯存映射等“不可見”內存納入監控範圍,消除盲區。

內存全景從“猜測誰吃內存”轉變為“秒級定位泄漏源”,顯著縮短故障排查時間,支撐容量規劃與資源優化。

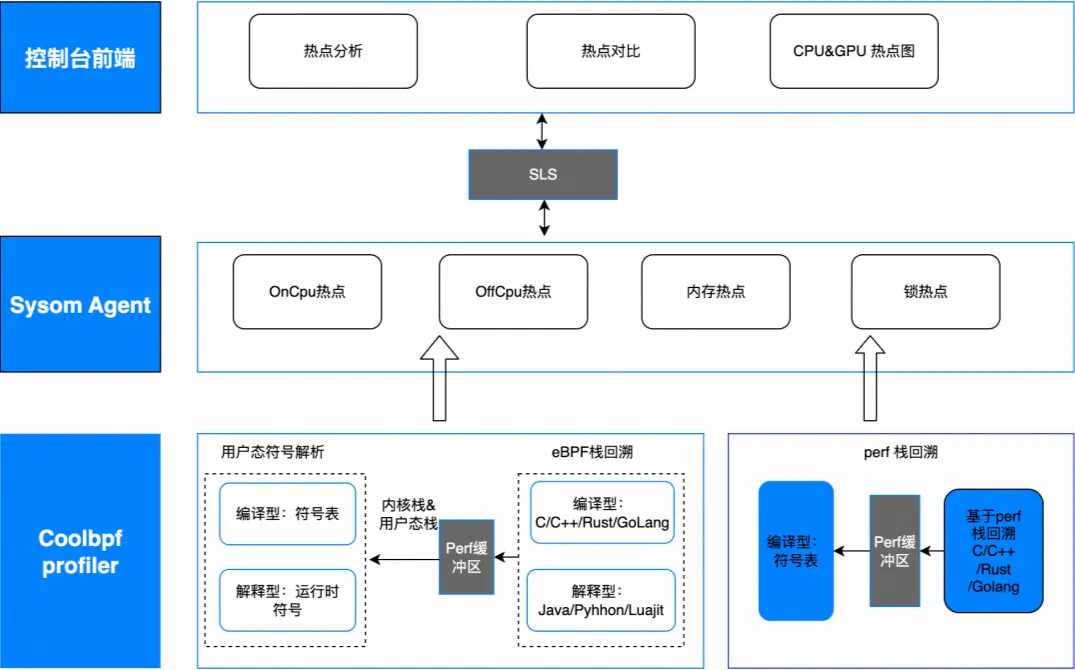

消除性能抖動 —— 進程熱點分析

核心收益:解決車聯網服務響應遲滯問題,提升用户體驗。

適用場景:偶發性卡頓、CPU 或 I/O 突發飆升、毫秒級延遲突增等難以復現的性能問題。

這類問題往往無固定復現路徑,傳統監控無法捕獲瞬時調用棧,導致根因長期懸而未決。

進程熱點分析基於 eBPF 實現輕量、持續追蹤,該功能具有以下特點:

- 小於 3% 性能開銷:無侵入採集函數調用棧、上下文切換、系統調用等數據,適用於生產環境長期運行。

- 火焰圖 + Diff 對比:直觀展示 CPU 熱點路徑,並支持抖動前後或版本升級前後的性能差異比對,自動高亮退化點。

- 智能識別:結合大模型語義理解,識別高頻/proc 訪問、鎖競爭、阻塞 I/O 等常見性能陷阱,並給出優化建議。

- 秒級回溯抖動時刻:系統持續緩存輕量調用棧,問題發生時可立即鎖定瞬時高負載進程及其熱點函數。

進程熱點分析解決了“無法復現”的性能難題,讓偶發卡頓變得可追蹤、可解釋、可修復。

保障智算基礎設施的穩定 —— GPU 持續追蹤時序圖

核心收益:解決智能駕駛業務在 GPU 場景運維難的問題,提升訓推效率,節省成本。

適用場景:自動駕駛模型訓練、vLLM 等大模型推理、多 GPU 通信任務等 AI 密集型負載。

AI 任務對 GPU 資源穩定性高度敏感,但顯存泄漏、XID 錯誤、通信瓶頸等問題往往隱蔽且難定位。

操作系統控制枱構建基於內核的持續追蹤體系,它具有以下特點:

- 分鐘級異常告警:實時監控顯存、SM 利用率、温度、XID 錯誤碼等,及時發現GPU掉卡、硬件報錯或任務卡死。

- 小時級問題定界:支持慢節點識別、NCCL 通信延遲分析、單卡/整機資源瓶頸判斷,快速縮小排查範圍。

- 函數級根因剖析:通過 GPU 火焰圖和 Timeline Profiling,將 Python 層調用、框架算子與 CUDA Kernel 關聯,可視化算子執行序列與等待時間。

- 讓 AI 任務“看得見、説得清、改得準”,避免因底層資源異常導致訓練中斷或推理延遲,提升 AI 基礎設施可靠性。

行業成功案例分享

案例一:車機服務高峯期無響應

案例背景

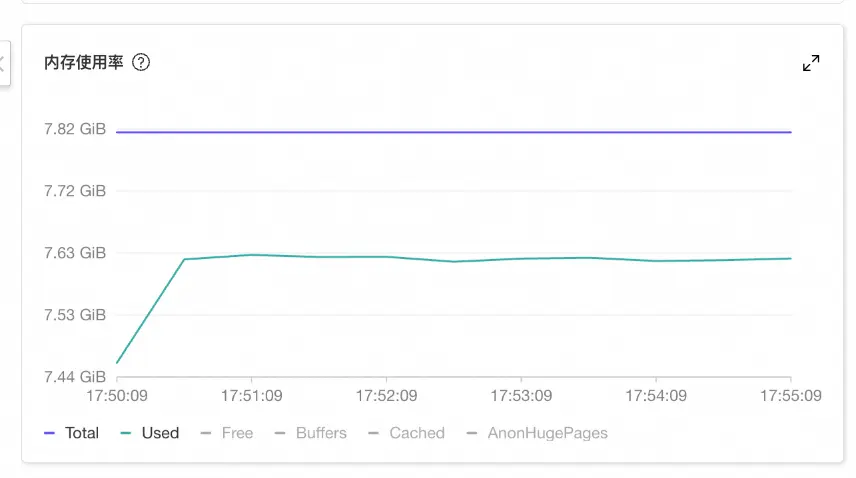

某頭部物流行業用户節假日出現業務無響應、登錄實例也十分卡頓。通過監控發現客户實例使用的內存在某個時間點開始徒增,接近系統的總內存(即 available 非常低),但沒有超過系統總內存。

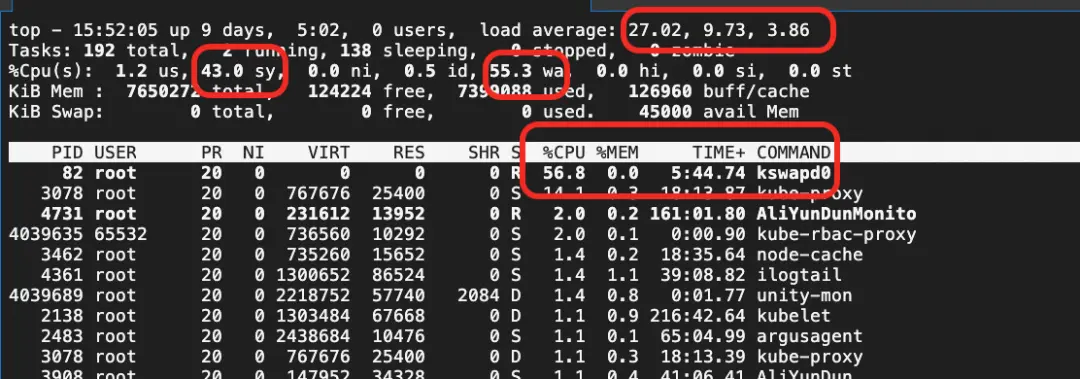

通過 top 命令可以看到系統的 CPU sys 利用率和 iowait 利用率和系統負載都持續飆高,kswapd0 線程佔用非常高的 CPU 進行內存回收。

解決方案

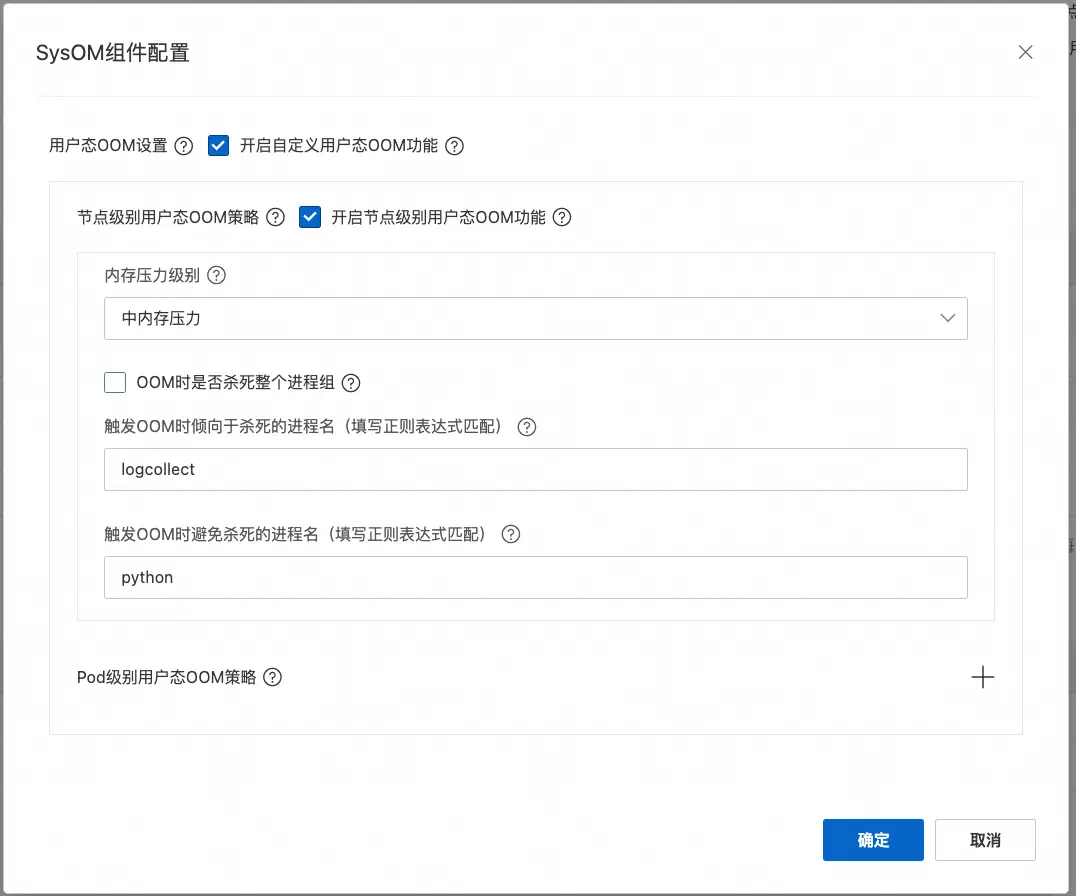

通過配置開啓節點級別的 FastOOM 功能,由於業務是實驗較為敏感的業務,內存壓力選擇中,且設置業務程序(以 python 啓動,進程名包含 python 子串)為避免被 OOM 進程且設置無關的日誌程序優先殺死。

開啓後,當節點內存水位處於 near-OOM 狀態時,用户態提前介入,根據配置殺死了如下進程,從而釋放了部分內存避免系統進入了夯機狀態。通過操作系統控制枱的系統概覽可以看到 FastOOM 介入的相關記錄。

如下圖所示,由於 kube-rbac-proxy 和 node_exporter 等進程 oom_score_adj 被設置為接近 999,FastOOM 會匹配內核策略優先殺死這些進程,但是由於殺死這些進程後釋放內存較小,仍處於 near-OOM;因此 FastOOM 殺死了配置優先殺死的 logcollect 進程。

由於用户態及時介入殺死進程釋放出內存,使系統避免進入了near-OOM的抖動狀態。

案例二:AI 推理場景顯存異常增長

案例背景

某頭部自動駕駛方案公司部署的 vLLM 線上推理服務:KV-Cache 利用率並未打滿,但通過 GPU 監控(DCGM)觀察到有顯存明顯增長。vLLM 啓動時使用顯存預分配機制,在 KV-Cache 利用率未滿情況下理論顯存值不應上漲。

解決方案

對在線業務應用進行 continuous Profiling,在 TimeLine 上找到顯存申請的 cudaMalloc 調用,打上標記線,即可找到具體的 Python 調用,進一步定位到導致顯存額外申請的調用棧如下所示,結合 decorate_context() 實現可以判斷出顯存增長的原因 Torch 的緩存管理機制,可以通過調整 vLLM 顯存預佔或 Torch 緩存的顯存佔用環境變量來進行相應的問題規避。

案例三:智能汽車全球發佈會——高併發實時交互下的零卡頓保障

案例背景

2025 年春季,某智能電動汽車品牌在全球同步發佈其旗艦車型,並啓動大規模整合營銷活動。由於發佈會覆蓋全球多個時區,且關鍵的價格公佈環節引發高度關注,價格揭曉後 5 分鐘內,App 總訪問量突破 800 萬,商城相關接口請求峯值高達 12 萬 QPS,整體流量達日常水平的 200 倍以上。在此極端併發場景下,系統面臨嚴峻挑戰:核心交互接口的端到端響應必須控制在 30ms 以內,任何毫秒級的延遲都可能導致 APP 白屏、操作無響應或直播卡頓,嚴重影響用户體驗並威脅品牌形象。與此同時,瞬時流量洪峯、極致的體驗敏感性以及秒級故障定位與恢復的嚴苛要求,使得傳統依賴日誌回溯的運維排查方式完全失效,系統穩定性與實時可觀測性面臨前所未有的考驗。

解決方案

依託操作系統控制枱構建“三位一體”保障體系:

1.高併發資源防護 —— 主動內存保護 + 關鍵進程隔離 提前識別車控指令服務、視頻流網關、身份認證微服務為 關鍵路徑組件,加入 FastOOM 白名單; 配置中等靈敏度內存壓力策略,在系統進入 near-OOM 前主動釋放低優先級進程內存,避免 kswapd 搶佔 CPU 導致 API 延遲飆升,實現發佈會全程實現 “零白屏、零卡頓、零交互失敗”。

2.實時性能監控 —— 進程熱點分析持續追蹤 全鏈路啓用 eBPF 驅動的進程熱點分析,持續採集函數調用棧; 當某區域用户集中反饋“點擊無反應”時,系統秒級回溯到問題時刻; 結合大模型輔助診斷,自動建議“緩存網絡指標”而非實時讀取,熱修復後延遲 P99 從 50ms 降至 30ms。

展望

隨着智能電動汽車的持續發展,車載系統與雲端基礎設施的耦合將更加緊密。未來,汽車不僅是交通工具,更是移動的計算終端和數據節點。這要求雲平台不僅具備更強的彈性、更低的延遲和更高的可靠性,還需在資源調度、故障自愈和性能優化等方面實現更深層次的智能化。

操作系統控制枱將持續圍繞汽車行業核心場景打磨能力。一方面,我們將進一步強化對高併發、高實時性業務的支持,優化 FastOOM、內存全景分析、進程熱點追蹤等能力在 OTA 洪峯、自動駕駛訓練推理等典型負載下的表現;另一方面,我們將探索 AI 驅動的智能運維(AIOps)路徑,結合大模型與實時可觀測數據,構建具備預測、診斷、決策和執行能力的 AI Agent 運維體系。

聯繫我們

您在使用操作系統控制枱的過程中,有任何疑問和建議,可以搜索羣號:94405014449 加入釘釘羣反饋,歡迎大家掃碼加入交流。