新功能上線

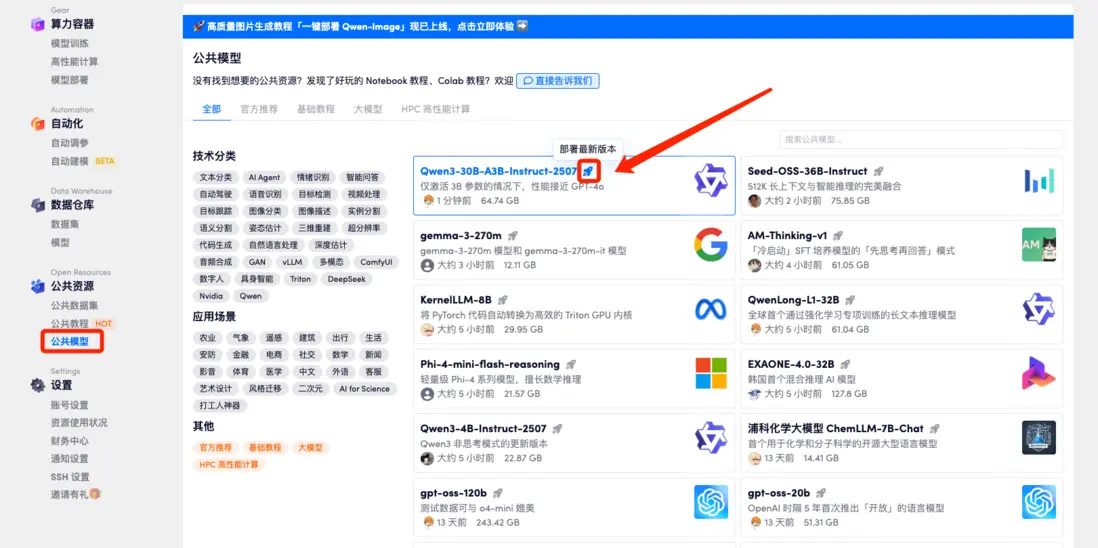

平台公共模型界面現已推出「一鍵部署」功能,具體使用方式如下:

- 進入「公共模型」,點擊模型右側的「小火箭」標識,即可快速部署該模型。

- 也可以在點擊模型後,選擇右上角「部署當前版本」進行部署。

本週資源更新

4 個公共教程:

- 微軟 VibeVoice-1.5B 重新定義 TTS 技術邊界

- vLLM+Open WebUl 部署 gemma-3-270m-it

- vLLM+Open WebUl 部署 Seed-OSS-36B-Instruct

- vLLM + Open WebUI 部署 NVIDIA-Nemotron-Nano-9B-v2

10 個公共模型:

- Jan-v1-4B

- KernelLLM-8B

- AM-Thinking-v1

- gemma-3-270m

- EXAONE-4.0-32B

- QwenLong-L1-32B

- Seed-OSS-36B-Instruct

- Qwen3-4B-Instruct-2507

- Qwen3-4B-Thinking-2507

- Phi-4-mini-flash-reasoning

訪問網立即使用:openbayes.com

公共教程

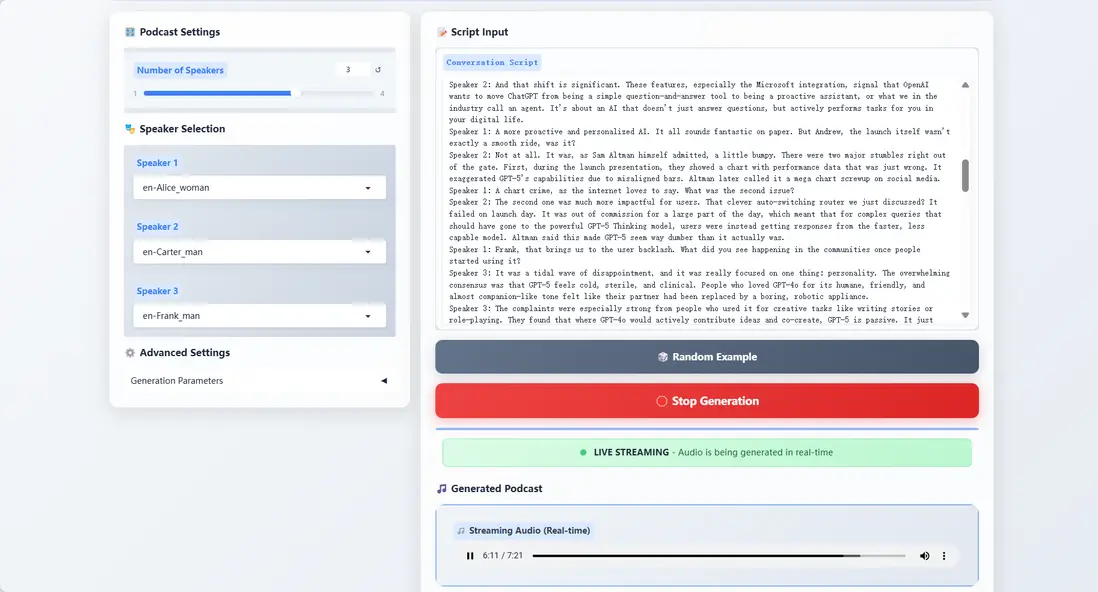

- 微軟 VibeVoice-1.5B 重新定義 TTS 技術邊界

VibeVoice-1.5B 能生成富有表現力、長篇幅、多説話者的對話式音頻,如播客。該模型通過創新的連續語音標記化技術和下一代標記擴散框架,結合大型語言模型(LLM),實現高效處理長序列音頻的能力,同時保持高保真度。VibeVoice 能合成長達 90 分鐘的語音,支持多達 4 位不同説話者,突破傳統 TTS 系統的限制,為自然對話和情感表達提供新的可能。

- 在線運行:

https://go.openbayes.com/P170p

項目示例

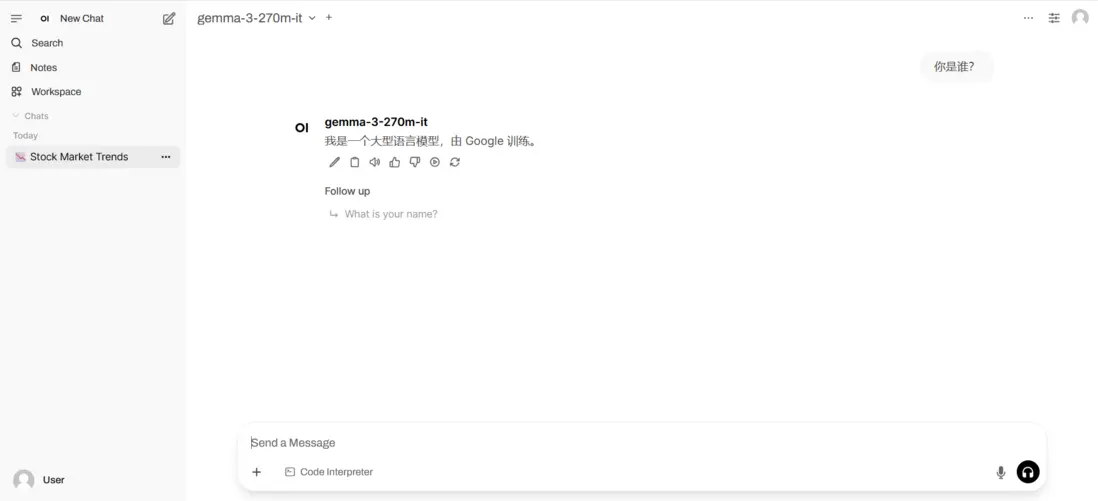

- vLLM+Open WebUl 部署 gemma-3-270m-it

gemma-3-270m-it 基於 270M(2.7億)參數構建,專注於高效對話交互與輕量化部署。該模型輕量高效,僅需單卡 1GB+ 顯存即可運行,適合邊緣設備與低資源場景;支持多輪對話,針對日常問答、簡單任務指令進行專項微調,專注文本生成與理解(不支持圖像等多模態輸入),且支持 32K tokens 上下文窗口,可處理長文本對話。

- 在線運行:

https://go.openbayes.com/M8MB7

項目示例

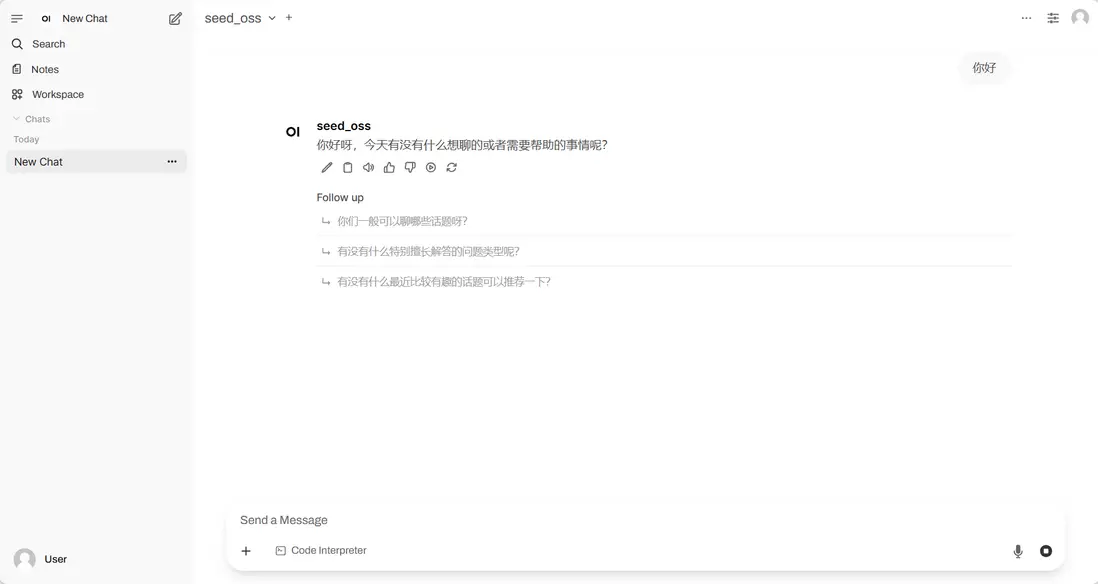

- vLLM+Open WebUl 部署 Seed-OSS-36B-Instruct

Seed-OSS-36B-Instruct 使用了 12萬億(12T)tokens 進行訓練,並在多個主流開源基準測試中取得了出色的表現。該模型的架構結合了多種常見的設計選擇,包括因果語言建模、分組查詢注意力(Grouped Query Attention)、SwiGLU 激活函數、RMSNorm 和 RoPE 位置編碼。其最具代表性的特性之一是原生長上下文能力,最大上下文長度可達 512k tokens,能夠在不損失性能的情況下處理超長文檔和推理鏈。這一長度是 OpenAI 最新 GPT-5 模型系列的兩倍,大約相當於 1600 頁文本。

- 在線運行:

https://go.openbayes.com/II5aV

項目示例

- vLLM + Open WebUI 部署 NVIDIA-Nemotron-Nano-9B-v2

NVIDIA-Nemotron-Nano-9B-v2 作為 Nemotron 系列的混合架構優化版本,該模型創新性融合 Mamba 高效長序列處理與 Transformer 強語義建模能力,僅以 90 億(9B)參數就實現了 128K 超長上下文支持,在邊緣計算設備(如 RTX 4090 級 GPU)上的推理效率與任務性能,可對標同參數規模的前沿模型,標誌着大語言模型在輕量化部署與長文本理解領域的重大突破。

- 在線運行:

https://go.openbayes.com/Xl6tH

項目示例

公共模型

- Jan-v1-4B

- 發佈機構:Jan 團隊(JanHQ)

Jan-v1-4B 是 Jan 家族的首發版本並面向 Jan App 的實際工作流場景而設計。該模型基於阿里雲 Qwen3-4B-Thinking 模型微調而來,僅用 4 億參數便在 SimpleQA 基準測試中達到 91% 的準確率,性能媲美商業產品 Perplexity Pro。Jan-v1-4B 支持 256 Ktokens 的上下文長度,並可通過YaRN技術擴展至 100 萬 tokens,具備全本地運行的能力。此外,該模型採用雙模推理機制,支持邏輯推理、工具調用和複雜任務處理,適用於學術研究、長文檔分析、代碼生成及智能代理等場景。

- 在線使用:

https://go.openbayes.com/M7xUO

- KernelLLM-8B

- 發佈機構:Meta

KernelLLM-8B 的核心功能是將 PyTorch 代碼自動轉換為高效的 Triton GPU 內核,旨在降低高性能 GPU 編程的門檻,滿足對定製化內核解決方案日益增長的需求。儘管模型規模相對較小,但其在專門化的基準測試中展現了卓越的性能:在 KernelBench-Triton 的測試中,其單次推理(pass@1)得分達到了 20.2,超越了參數規模大得多的 GPT-4o (200B) 和 DeepSeek V3 (671B) 等模型。

- 在線使用:

https://go.openbayes.com/jc8Y5

- AM-Thinking-v1

- 發佈機構:a-m-team 團隊

AM-Thinking-v1 基於開源的 Qwen2.5-32B 基礎模型構建,並完全採用公開數據集進行訓練。該模型在數學推理(AIME2024 得分 85.3)和代碼生成(LiveCodeBench 得分 70.3)等需要複雜邏輯的任務上表現出色,其性能超越了參數規模更大的 DeepSeek-R1(671B MoE),並接近 Qwen3-235B-A22B 等頂級大模型,展現了中等規模模型通過精細設計後訓練流程所能達到的強大推理潛力。

- 在線使用:

https://go.openbayes.com/9VMkR

- gemma-3-270m

- 發佈機構:谷歌

Gemma-3-270M 參數量僅為 2.7 億,專為終端設備部署和低功耗場景優化。該模型具備出色的指令遵循和文本結構化能力,其 INT4 量化版本運行時僅需約 240 MB 內存,能高效運行於手機、瀏覽器甚至樹莓派等資源受限環境,非常適合需要快速響應、隱私保護或離線處理的任務,如情感分析、實體提取和創意寫作。

- 在線使用:

https://go.openbayes.com/axmmb

- EXAONE-4.0-32B

- 發佈機構:LG AI Research

EXAONE-4.0 集成了非推理模式與推理模式,旨在同時實現 EXAONE 3.5 的卓越易用性和EXAONE Deep 的高級推理能力。該模型支持 MCP 與函數調用功能,為 Agentic AI 提供技術基礎,除了韓語、英語之外還支持西班牙語。

- 在線使用:

https://go.openbayes.com/PZKug

- QwenLong-L1-32B

- 發佈機構:阿里巴巴通義千問團隊

QwenLong-L1-32B 是全球首個通過強化學習(RL)專項訓練的長文本推理模型(LRM),能夠高效處理長達 13w token 的上下文。該模型採用漸進式上下文擴展和混合獎勵函數等創新技術,在多項長文本問答基準測試中展現出卓越性能。該模型專為複雜的長文檔分析與推理任務設計,在金融、法律、科研等需要深度處理大量信息的領域有重要應用價值。

- 在線使用:

https://go.openbayes.com/WR2EZ

- Seed-OSS-36B-Instruct

- 發佈機構:字節跳動 Seed 團隊

Seed-OSS-36B-Instruct 以其強大的推理能力、原生的 512K 超長上下文支持和創新的「推理預算」控制機制著稱。該模型在多項基準測試中取得了領先成績,並能靈活處理需要長文本理解和複雜邏輯推理的任務。

- 在線使用:

https://go.openbayes.com/XUtJb

- Qwen3-4B-Instruct-2507

- 發佈機構:阿里巴巴通義千問團隊

Qwen3-4B-Instruct-2507 是之前 Qwen3 非思考模式的更新版本,在非推理領域,Qwen3-4B-Instruct-2507 在知識、推理、編程、對齊以及 agengt 能力上全面超越了閉源的小尺寸模型 GPT-4.1-nano。

- 在線使用:

https://go.openbayes.com/Jwk3j

- Qwen3-4B-Thinking-2507

- 發佈機構:阿里巴巴通義千問團隊

Qwen3-Thinking-2507 是 Qwen3 思維模型的延續,具有更高的推理質量和深度。性能方面,Qwen3-4B-Thinking-2507 在複雜問題推理能力、數學能力、代碼能力以及多輪函數調用能力上的表現大幅領先 Qwen3 同尺寸小模型。在推理領域,Qwen3-4B-Thinking-2507 表現突出,推理能力可媲美中等模型 Qwen3-30B-Thinking。

- 在線使用:

https://go.openbayes.com/HV8EG

- Phi-4-mini-flash-reasoning

- 發佈機構:Microsoft 團隊

Phi-4-mini-flash-reasoning 基於合成數據構建,專注於高質量、密集推理數據,並進一步微調以獲得更高級的數學推理能力。該模型能夠在邊緣設備、移動應用和嵌入式系統等資源不足的場景下,引入先進的推理功能。在架構方面,Phi-4-mini-flash-reasoning 引入了自主研發的創新架構 SambaY,延遲平均降低了 2 至 3 倍,整體推理性能顯著增強。

- 在線使用:

https://go.openbayes.com/MAIXk