本文介紹了 Parquet 和 Feather 兩種文件類型,可以提高本地存儲數據時的讀寫速度,並壓縮存儲在磁盤上的數據大小。大型 CSV 文件的剋星!用起來~

💡 作者:韓信子@ShowMeAI

📘 數據分析實戰系列:https://www.showmeai.tech/tutorials/40

📘 本文地址:https://www.showmeai.tech/article-detail/409

📢 聲明:版權所有,轉載請聯繫平台與作者並註明出處

📢 收藏ShowMeAI查看更多精彩內容

💡 引言

我們在處理本地存儲的數據時遇到了一些問題。在相對較小的數據集上,讀取-處理-寫入操作可能很舒服,但對於大型 .csv 文件來説,這些操作非常麻煩,可能會消耗大量時間和資源。

為了解決這個問題,我將介紹兩種文件類型,它們可以提高您的數據讀寫速度,並壓縮存儲在磁盤上的數據大小:

- 📘Parquet

- 📘Feather

這兩種文件類型都具有以下特點:

- 默認情況下可以使用 Python-Pandas 訪問。不過,您可能需要額外安裝 pyarrow 和它的一些擴展,具體取決於您的數據類型。

- 支持基於列的 I/O 管理。這樣,您可以防止在讀取所有數據時臨時使用額外的 RAM,然後刪除不需要的列。

- 以二進制格式以自己的類型而不是原始格式存儲數據,您最多可以節省 50% 的存儲空間,並且可以在讀寫操作中獲得高達 x100 的加速。

這兩種文件類型都非常易於使用。更改您當前使用的代碼行即可。讓我們來看看它們!

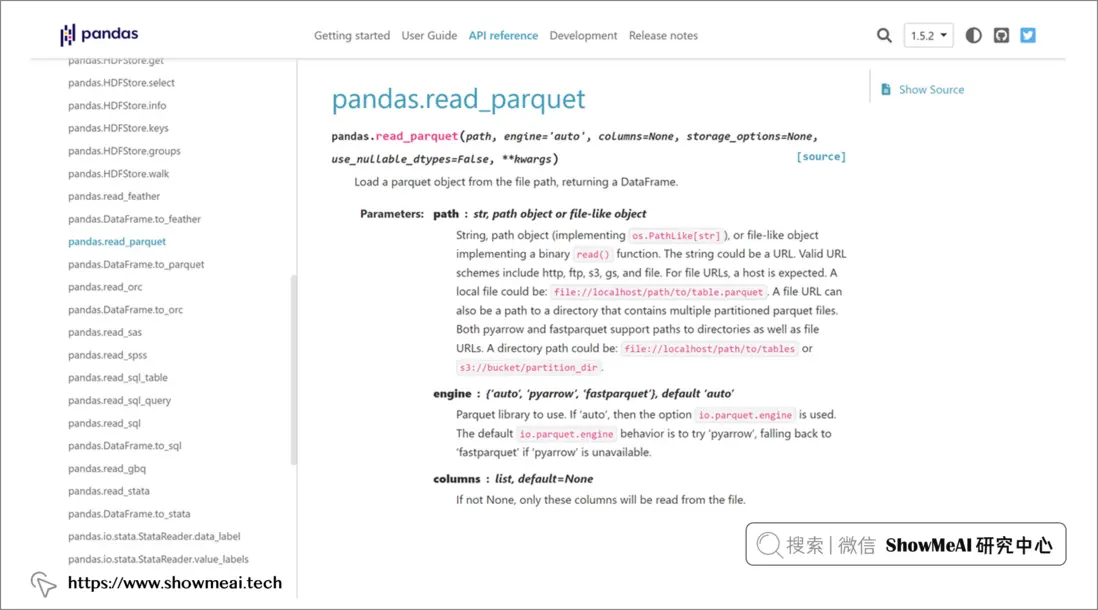

💦 Parquet格式

import pandas as pd

df = pd.read_csv("some_data.csv")

# Saving Parquet files

df.to_parquet("df.parquet")

# Reading Parquet files

df_parq = pd.read_parquet("df.parquet")💦 Feather格式

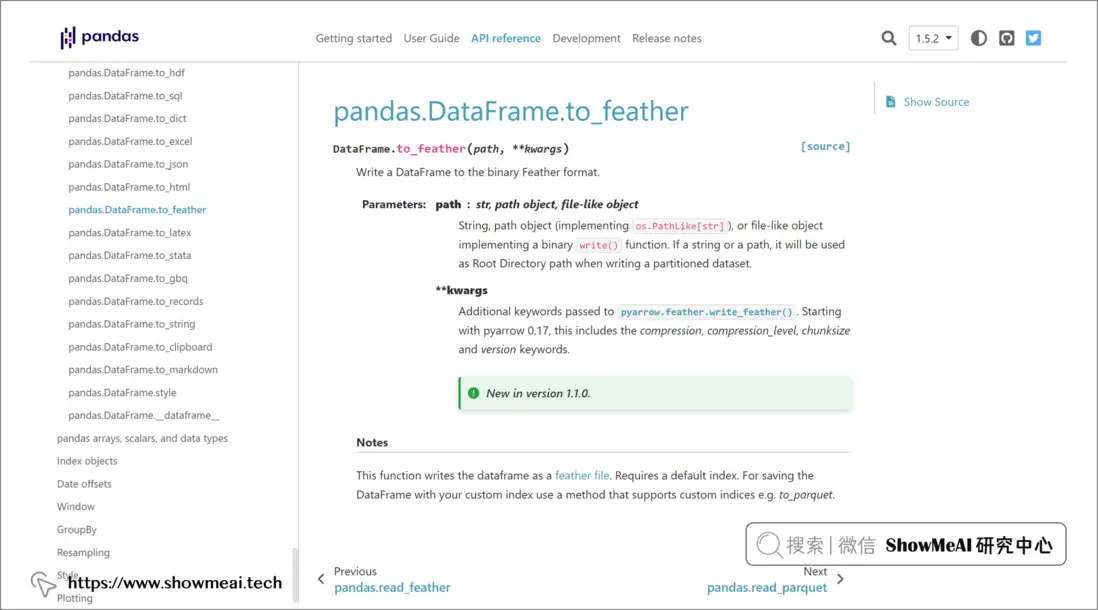

import pandas as pd

df = pd.read_csv("some_data.csv")

# Saving Feather files

df.to_feather("df.feather")

# Reading Feather files

df_feat = pd.read_feather("df.feather")💡 總結

在本篇內容中,ShowMeAI給大家介紹了提高讀寫速度的數據格式,如果您不想使用 Excel 原始格式存儲數據,那麼建議您使用並行讀取和寫入數據的方法,這樣可以提高數據處理的速度和效率。

參考資料

- 📘Parquet

- 📘Feather

推薦閲讀

- 🌍 數據分析實戰系列:https://www.showmeai.tech/tutorials/40

- 🌍 機器學習數據分析實戰系列:https://www.showmeai.tech/tutorials/41

- 🌍 深度學習數據分析實戰系列:https://www.showmeai.tech/tutorials/42

- 🌍 TensorFlow數據分析實戰系列:https://www.showmeai.tech/tutorials/43

- 🌍 PyTorch數據分析實戰系列:https://www.showmeai.tech/tutorials/44

- 🌍 NLP實戰數據分析實戰系列:https://www.showmeai.tech/tutorials/45

- 🌍 CV實戰數據分析實戰系列:https://www.showmeai.tech/tutorials/46

- 🌍 AI 面試題庫系列:https://www.showmeai.tech/tutorials/48