【本文價值提示】

作為一個擁有大數據背景的工程師,你可能習慣了按 GB、TB 甚至 PB 來衡量數據。但在大模型(LLM)的世界裏,計量單位變了——變成了 Token。

這不僅僅是一個計費單位,它是大模型理解世界的“原子”,是架構設計的“硬約束”,更是導致模型“算術不好”的罪魁禍首。

本文是 “從大數據工程師到 AI 架構師” 系列教程的第一篇。我們將揭開大模型黑盒的第一層面紗,帶你從架構師的視角,重新理解數據的入口。

大家好,我是你們的轉型領路人。

很多剛開始接觸大模型(LLM)的朋友,在調用 OpenAI 或 Claude 的 API 時,往往會產生一種錯覺: “我發給模型的是一句話,模型讀懂了這句話,然後回了我一句話。”

錯!大錯特錯。

在 AI 的眼裏,根本沒有“字”或“單詞”的概念,只有一串串冷冰冰的數字。如果你不理解這一點,你設計的 AI 應用不僅會性能低下,還會讓公司的API 賬單爆炸,甚至會出現一些讓你摸不着頭腦的邏輯錯誤。

今天,我們就來聊聊大模型數據流轉的第一站:**Tokenization(分詞)**。

01 什麼是 Token?AI 的“精神食糧” 🍔

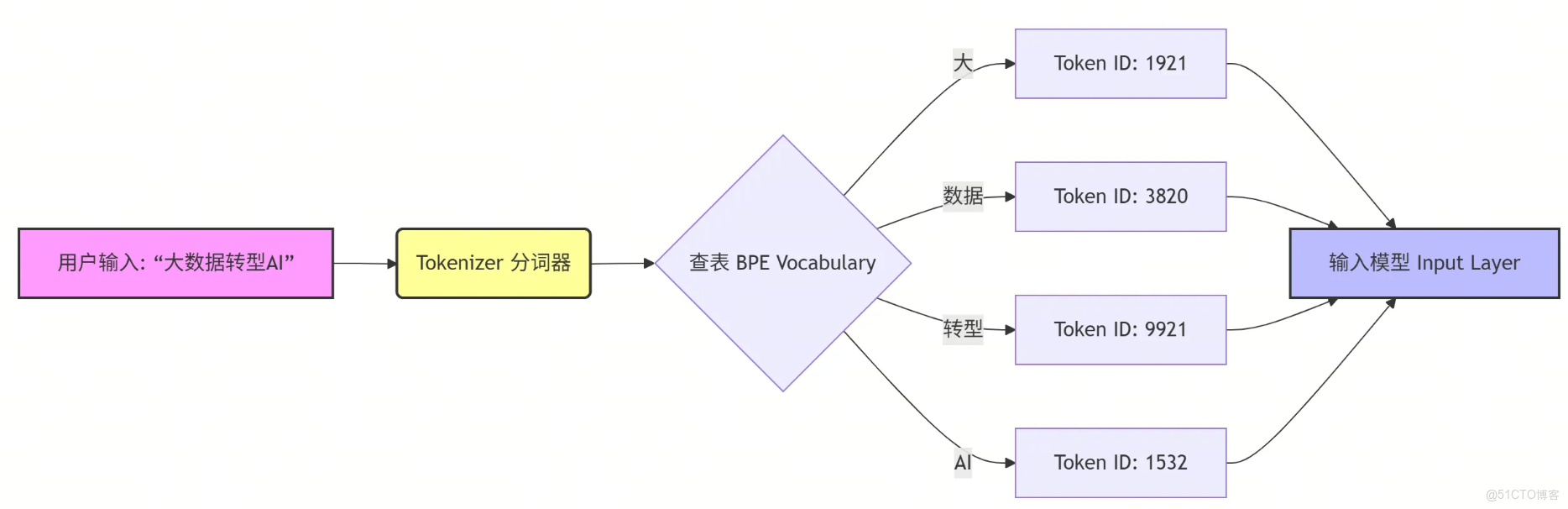

在大數據處理中,我們習慣把文本看作 String 或 Bytes。但在 LLM 中,文本在進入模型之前,必須被切碎。

Token(詞元) 就是模型能消化的最小單位。

你可以把大模型想象成一個**“挑食的吃貨”**。你給它一整塊牛排(一句話),它吃不下去。你必須用刀叉(Tokenizer)把牛排切成一小塊一小塊(Tokens),它才能一口一口吃掉。

這裏的關鍵認知差在於:

- 人類視角:

I love AI是 3 個單詞。 - 機器視角:這可能是 3 個 Token,也可能是 4 個,取決於你怎麼切。

📝 架構師的速記公式:

- 中文場景:1 個漢字 ≈ 1 個 Token(大部分情況下)。

- 英文場景:1 個單詞 ≈ 1.3 個 Token(因為複雜的詞會被拆開)。

⚠️ 警鐘長鳴: 很多初級工程師在做成本預估時,直接用“字符數”去乘價格,結果月底賬單出來發現比預估高了 30%~50%。這就是不懂 Token 轉換率的代價。

02 BPE:統計學上的“暴力壓縮” 🗜️

你可能會問:“為什麼要切分?直接用 Unicode 編碼或者按單詞切不行嗎?”

這就涉及到了 Tokenization 的核心算法——BPE (Byte Pair Encoding) 。

作為大數據工程師,你對“壓縮算法”一定不陌生。BPE 其實就是一種基於統計學的文本壓縮。它的邏輯非常簡單粗暴:

- 高頻出現的字符組合:合併成一個獨立的 Token(比如

ing、tion、the)。 - 低頻出現的字符組合:拆分成多個 Token。

舉個栗子 🌰

假設我們要處理單詞 **"Unhappiness"**:

- 如果是生僻詞,模型可能沒見過。

- BPE 會把它拆解為:

Un(前綴) +happi(詞根) +ness(後綴)。

這樣一來,模型即使沒見過 "Unhappiness",但它學過這三個部分,就能猜出意思是“不快樂”。

📉 流程圖解:文本是如何變成數字的

03 架構師的噩夢:數字與代碼的“失語症” 😵💫

理解了 BPE,你就能解釋一個困擾無數人的玄學問題: “為什麼 ChatGPT 這種超級大腦,做三位數的加減法經常算錯?”

原因不在於模型笨,而在於 Tokenization 把它坑了。

在 BPE 算法下,數字的切分非常詭異。

1000可能是一個 Token。1,000可能是兩個 Token (1和,000)。1001可能是兩個 Token (10和01)。

👀 想象一下: 你要教一個孩子學數學,但你禁止他看數字本身,而是告訴他:“蘋果 + 香蕉 = 梨”。這孩子能學會才怪!

因為數字被切分得支離破碎,破壞了數位(個十百千)的邏輯,導致模型在處理算術、哈希值、甚至某些代碼縮進時,表現得像個“智障”。

🛠️ 架構決策點: 如果你的業務場景涉及精確的數學計算或複雜的 ID 匹配,千萬不要完全依賴 LLM 的推理。 正確做法:使用 Tool Use(工具調用),讓 LLM 寫 Python 代碼去算,或者調用計算器 API。

04 核心硬約束:Context Window(上下文窗口) 🪟

做大數據架構,我們習慣了橫向擴展(Scale-out)。數據多了?加機器!

但在 LLM 的世界裏,有一個目前無法物理突破的硬約束:Context Window。

每個模型都有最大窗口限制(例如 GPT-4 是 128k,Llama 2 是 4k)。這個窗口大小 = 輸入 Token + 輸出 Token。

這就好比你有一個工作台:

- 你把參考資料(Prompt + RAG 檢索到的文檔)堆在桌上。

- 你還要留出空間寫答案(Output)。

- 如果桌子滿了,你要麼扔掉舊資料(截斷),要麼就寫不出答案(報錯)。

💡 架構師的思考:

在設計 RAG(檢索增強生成) 系統時,你檢索出的文檔往往有幾萬字。

- 全部塞進去? 窗口爆了,或者費用爆了。

- 只塞一部分? 丟棄哪部分?頭部?尾部?還是中間?

這是一個典型的 “空間換質量” 的博弈。你需要根據 Token 數量,動態計算能塞入多少條知識庫內容。

05 實戰演練:用 Python 看看 Token 的真面目 🐍

光説不練假把式。作為工程師,我們直接上代碼。我們將使用 OpenAI 官方的 tiktoken 庫來直觀感受一下。

import tiktoken

# 加載 GPT-4 的編碼器

enc = tiktoken.get_encoding("cl100k_base")

# 實驗文本:中英混合 + 數字

text = "AI架構師 2025 transformation"

# 編碼

tokens = enc.encode(text)

print(f"原文: {text}")

print(f"Token IDs: {tokens}")

print(f"Token 數量: {len(tokens)}")

# 解碼回來看每個 Token 對應什麼

print("-" * 20)

for t in tokens:

print(f"ID: {t} -> '{enc.decode([t])}'")

運行結果預演: 你會發現 AI 可能是一個 Token,架構師 被拆成了幾個 Token,而 transformation 作為一個常見英文詞,可能只是一個 Token。

這就是為什麼同樣的語義,英文 Prompt 通常比中文 Prompt 更省錢、處理速度更快的原因。

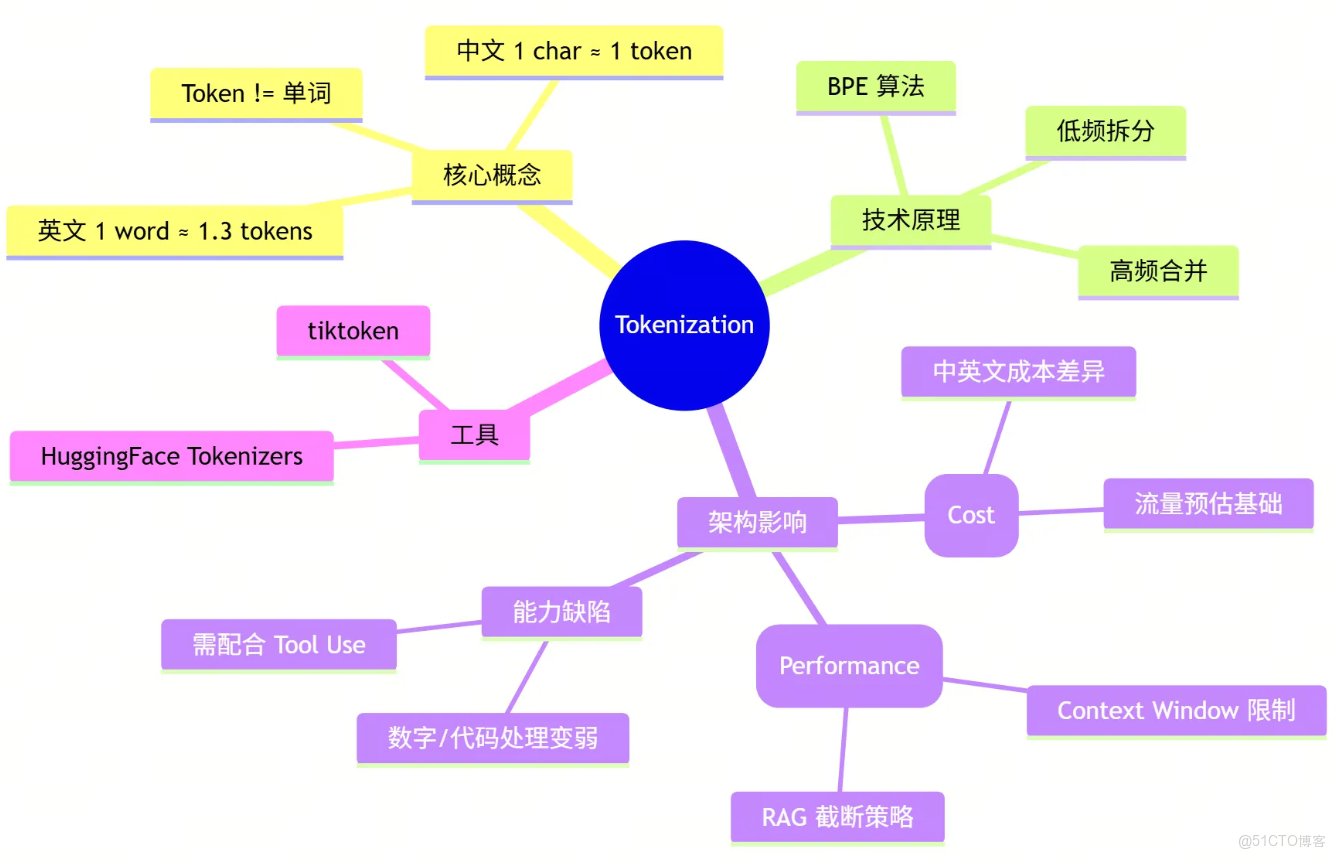

06 總結:架構師的知識圖譜 🗺️

恭喜你,完成了從大數據向 AI 架構轉型的第一步!

現在,當你再看 LLM 的輸入框時,你不應該只看到文本,而應該看到流動的 Token、潛在的計費點以及窗口的約束。

讓我們用一張思維導圖總結今天的核心內容:

🔜 下期預告

搞懂了數據如何“進入”模型,下一期我們將深入模型的心臟。

為什麼有的模型只能做閲讀理解(BERT),有的卻能吟詩作對(GPT)? 第二階段:核心引擎——Transformer 架構解析。我們將剖析 Encoder 與 Decoder 的愛恨情仇,教你如何根據業務場景進行模型選型。

👇 互動話題: 你在使用大模型 API 時,有沒有遇到過因為 Token 超長被截斷,或者數學算錯的坑?歡迎在評論區分享你的“血淚史”!

喜歡這篇文章嗎?點贊、在看、轉發,是更新的最大動力! 🚀