檢索增強生成(RAG)技術通過為大模型引入外部知識庫,已成為解決其知識侷限與幻覺問題的核心方案。本文將聚焦於RAG在大模型智能體中的應用,系統解析其從數據準備、智能檢索到答案生成的核心工作流程。文章將探討Agentic RAG如何通過自主決策優化傳統流程,並分析其在企業級應用中的實際價值與面臨的性能挑戰。

如果,你重金聘請的AI專家,能和你暢談哲學歷史,但一問到公司上週剛更新的產品參數,它要麼開始“一本正經地胡説八道”,要麼只能承認“我的知識截止到2021年”。這並非個例,而是當前大模型智能體普遍面臨的三大核心痛點:知識侷限、幻覺頻發與信息過時。RAG技術,正是為這個“天才”配備的一本實時可查、精準可靠的“外部大腦”。

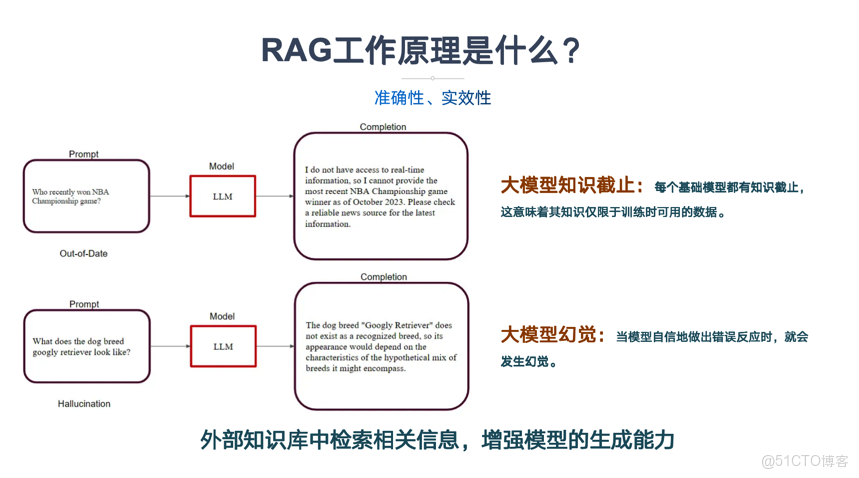

大模型的“博學”本質上是其訓練數據集的靜態快照。一旦訓練完成,其知識庫便基本凍結。這帶來了三個致命缺陷:

- 知識幻覺:模型為了“完成句子”,會基於統計概率生成看似合理但完全錯誤的信息。在企業級的金融、法律、醫療場景中,這種“幻覺”可能帶來災難性後果。

- 信息過時:模型無法知曉訓練後發生的事件。當用户詢問“最新的行業政策”時,一個基於2023年數據訓練的模型,給出的建議可能早已失效。

- 領域知識匱乏:通用大模型在特定垂直領域(如精密製造、生物醫藥)的專業深度不足,回答往往流於表面,缺乏實操價值。

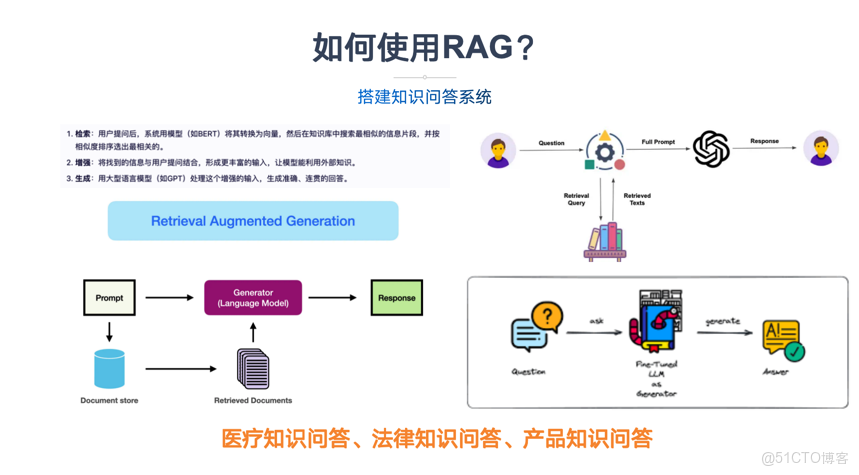

RAG直擊這些痛點,其核心邏輯是 “不讓模型‘硬想’,而是讓它‘先查再答’” 。當用户提問時,系統會先從企業專屬的知識庫中檢索出最相關的信息片段,然後將這些“證據”連同問題一起交給大模型,指令其“基於以下資料回答”。這相當於把開卷考試的模式引入了AI問答。模型不再依賴模糊的“記憶”,而是基於明確的、可追溯的外部事實進行生成,從根本上抑制了“無中生有”的幻覺。

本質上,RAG不是讓模型“變得更聰明”,而是讓它“變得更嚴謹”。 它把生成答案的職責,從依賴模型不可靠的內部記憶,轉移到了可控、可驗證的外部知識源上。

面對大模型的知識短板,業界主要有兩種思路:模型微調(Fine-Tuning) 和 RAG。兩者路徑迥異,成本與效果天差地別。

模型微調好比是給這位“超級大腦”做一場漫長的“腦部手術”。你需要準備大量高質量的標註數據,投入可觀的算力資源,對模型的參數進行直接調整。這個過程成本高昂、更新遲緩,且可能引發“災難性遺忘”——在教會模型新知識的同時,削弱其原有的通用能力。更重要的是,新知識被融合進模型的參數中,難以追溯和驗證其來源,形成了一個“知識黑箱”。

而RAG則提供了一種優雅得多的“插件式”解決方案。它不動模型的“大腦”分毫,而是為其外接了一個“移動硬盤”(向量數據庫)和一套“檢索系統”。這種架構帶來了革命性的優勢:

- 動態實時更新:更新知識?只需向向量數據庫裏插入新的文檔向量即可,幾乎是實時生效。企業政策變了,明天問答系統就能基於新政策回答。

- 部署成本極低:無需動輒數十張GPU的算力,利用開源的向量數據庫和嵌入模型,中小團隊也能快速搭建。

- 答案可追溯、可解釋:系統能明確告訴你,答案是根據哪份文檔的哪一頁生成的,極大增強了可信度與可審計性。

- 保護數據隱私:私有數據始終以向量形式存儲在本地或可控的雲端,從未直接輸入給原始大模型進行訓練,合規風險極低。

簡而言之,微調是“改造大腦”,而RAG是“增強工具”。對於絕大多數需要快速落地、知識頻繁更新、且注重成本與安全的企業應用場景,RAG的敏捷性與經濟性優勢是壓倒性的。它讓大模型智能體擺脱了“訓練數據決定論”的束縛,真正成為一個可以信賴的、擁有“最新外部大腦”的業務夥伴。

RAG核心工作流程:三步拆解從檢索到生成

RAG不是魔法,而是一套嚴謹的工程化流程。它通過三個精密銜接的步驟,將大模型的生成能力與外部知識庫的檢索能力無縫結合,其核心目標是用外部證據約束模型,從根源上抑制幻覺。理解這套流程,是判斷一個RAG系統是否可靠的關鍵。

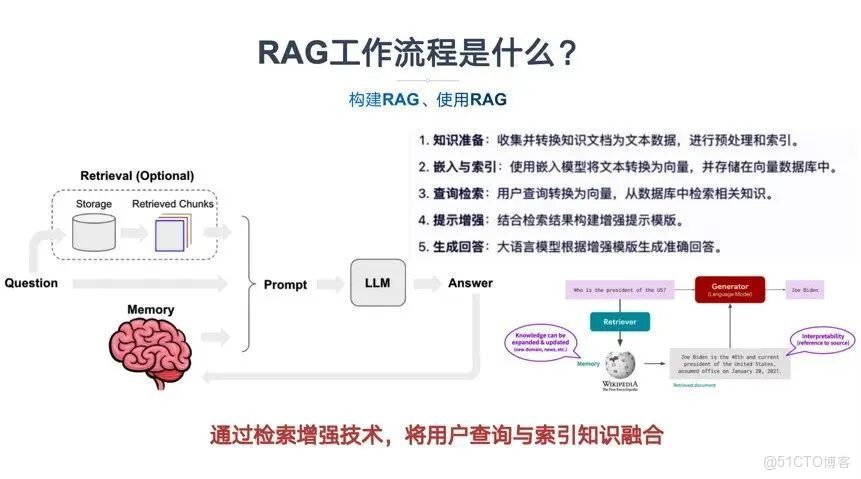

數據準備與索引:文本分割與向量化入庫

RAG系統的天花板,在數據入庫時就已經被決定了。 這一步常被低估,卻是“垃圾進,垃圾出”原理最直接的體現。

- 文本分割(Chunking)是首要陷阱。簡單的按固定字符數切割,極易將完整語義攔腰斬斷。例如,將政策條款“入職滿一年可享受5天年假”從“滿一年”處切斷,會導致檢索到的信息失真。更優的策略是語義分塊,依據段落、標題或自然語義邊界進行劃分,確保每個“知識塊”在語義上自洽。

- 向量化(Embedding)決定檢索精度。分割後的文本通過嵌入模型轉化為高維向量,這個過程將語義“編碼”成數學形式。模型選擇至關重要:通用模型(如

text-embedding-ada-002)成本高,而在專業領域語料上微調過的開源模型(如sentence-transformers),其檢索精度往往遠超通用模型。 - 最後,向量被存入向量數據庫(如Pinecone, Milvus)。數據庫的索引算法(如HNSW)決定了從海量數據中快速找到相似項的效率。

關鍵洞察:此階段最大的風險在於源文檔質量。如果知識庫本身存在矛盾信息(如兩份文件對同一政策表述不一),無論後續流程多精妙,系統都難以給出準確答案。

智能檢索與增強:查詢轉換、多源召回與上下文構建

當用户提問時,系統進入“開卷考試”的檢索環節。目標是從百萬級向量中,精準撈出最相關的幾個片段。

- 查詢轉換:用户的自然語言查詢首先被向量化。但高級系統會進一步進行查詢擴展(添加同義詞)或查詢改寫(將口語化問題轉為正式檢索語句),以提升召回率。

- 多源召回(混合檢索):這是從“基礎RAG”邁向“高級RAG”的標誌。單一的向量檢索(語義召回)可能遺漏關鍵詞完全匹配的文檔。因此,結合向量檢索與關鍵詞檢索(如BM25)的混合檢索成為主流,前者保證語義理解,後者保證術語精確匹配。

- 上下文構建:檢索到的多個片段可能冗長或矛盾。系統會使用重排序模型(Reranker) 對它們進行精細打分和篩選,然後將最相關、最權威的部分,結構化地組裝成一段“增強的上下文”,準備餵給大模型。

答案生成與合成:基於增強提示的精準輸出

這是價值呈現的環節。大模型接收的不再是孤零零的問題,而是一個精心構建的提示(Prompt),其中明確包含了“任務指令”、“檢索證據”和“輸出規範”。

一個高效的Prompt會嚴格約束模型行為,例如指令:

“請嚴格基於以下提供的上下文信息回答問題。若上下文證據不足,請直接回答‘根據現有資料無法確定’。答案中必須引用具體來源。”

這種“增強提示”從機制上框定了模型的回答範圍,是抑制幻覺的核心手段。模型被強制在給定的證據內進行歸納和表達。同時,要求引用來源不僅增加了答案的可信度與可追溯性,也滿足了企業應用對透明度與合規性的要求。

然而,生成階段仍有挑戰:如何處理證據間的矛盾?如何精簡冗長上下文而不丟失關鍵信息?這便引出了RAG的下一階段進化——由智能體(Agent)來動態管理這一複雜流程。

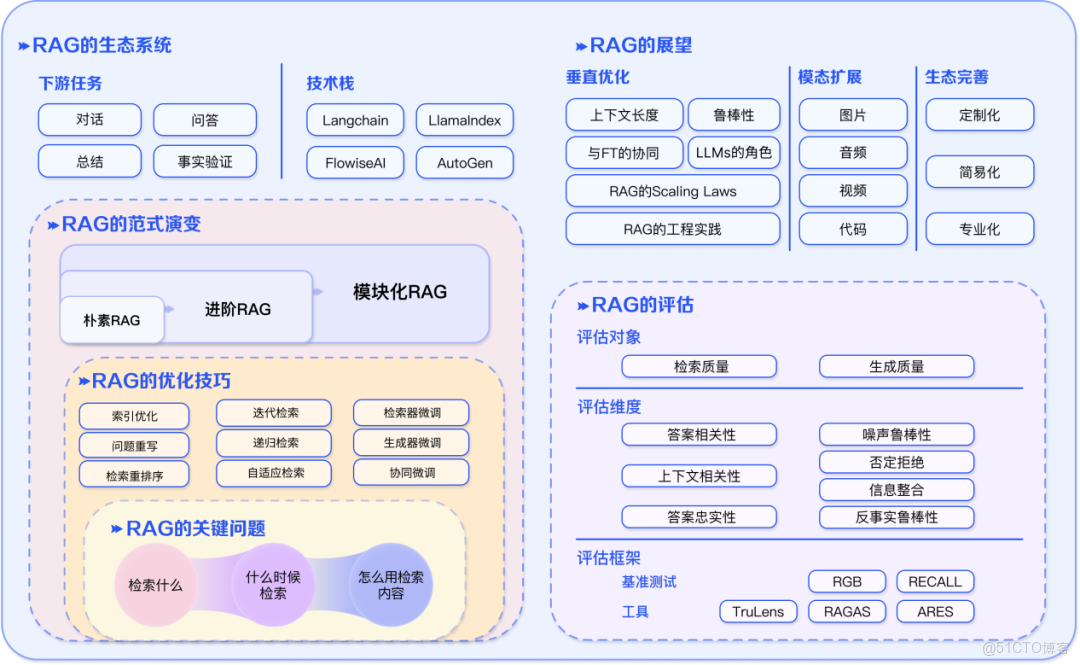

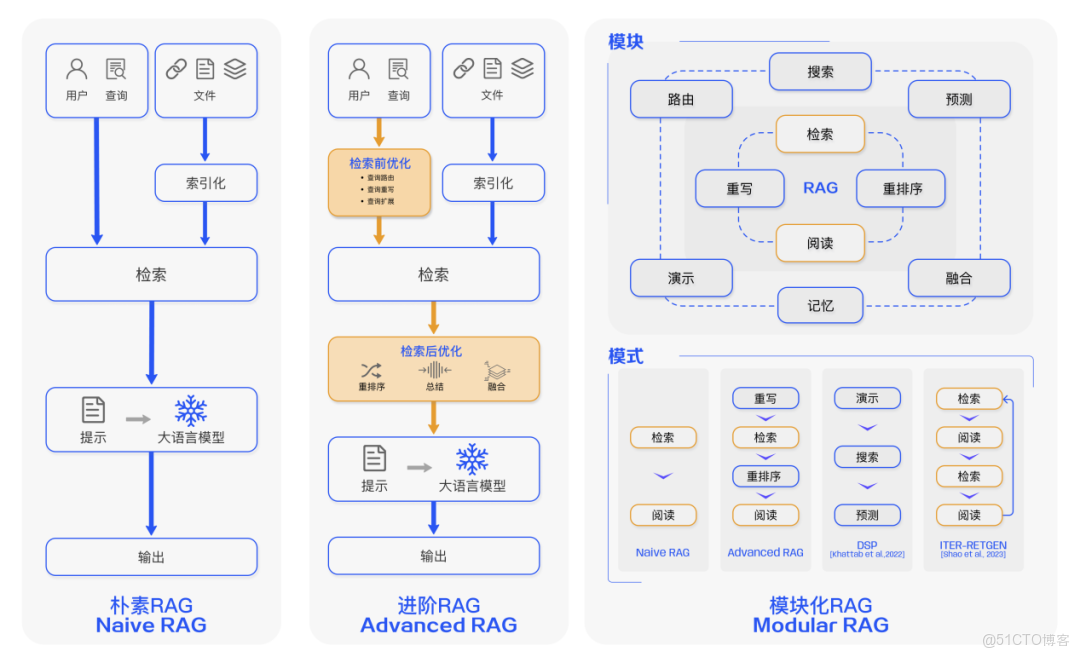

從Naive到Agentic:智能體如何驅動RAG升級?

當傳統RAG(Naive RAG)還在機械地執行“檢索-生成”時,Agentic RAG已悄然進化,它為大模型配備的不再是一本“死”的參考書,而是一位能自主思考、規劃路徑並自我驗證的“研究助理”。

動態決策:智能體如何優化查詢策略與檢索路徑

在Naive RAG中,用户的原始查詢被直接丟給檢索器,這種“一刀切”的策略在面對模糊或複雜的多步推理問題時,極易召回無關信息,成為下游“幻覺”的源頭。

Agentic RAG的智能體,則扮演了“策略指揮官”的角色,其核心能力在於將一次性的線性檢索,升級為可規劃、可評估的智能搜索任務。

首先,是查詢的智能分解與意圖理解。

智能體不會直接檢索“某公司CEO的教育背景如何影響公司戰略?”這樣的複雜長句。它會將其拆解為一系列邏輯子任務:先確定“該公司現任CEO是誰”,再查找“該CEO的具體教育背景”,最後結合“公司的公開戰略文件”進行關聯分析。這種多步推理能力,是傳統RAG難以實現的。

其次,是檢索路徑的動態規劃與自適應調整。

智能體具備混合搜索與路由決策能力。例如,當問題涉及具體名稱、日期時,它可能優先使用精準的關鍵詞檢索;當問題需要語義理解時,則切換到向量檢索。更重要的是,它能根據中間結果動態調整策略。

本質在於,智能體優化的是“如何找”的過程本身,通過理解任務、分解步驟並選擇最優工具,從源頭提升召回信息的質量與相關性。

反思迭代:智能體如何評估與修正生成結果以提升準確性

檢索到優質內容,只是成功了一半。大模型自身的“幻覺”傾向,以及檢索片段可能存在的矛盾或信息缺失,仍是風險點。Agentic RAG的第二個飛躍,在於引入了 “生成-評估-修正”的閉環反思機制,讓系統為其輸出負責。

生成後,智能體首先扮演“質量審計官”,啓動即時評估。

它會將初步答案中的關鍵事實、數據結論重新作為查詢,反向在知識庫中進行事實核對。如果發現某個聲稱缺乏足夠支撐,或與權威信息相矛盾,系統便會標記此處存在“幻覺”風險。此外,它還會進行邏輯一致性檢查,判斷答案內部或與常識是否存在矛盾。

評估發現問題後,迭代修正隨即啓動,而非將存疑答案直接輸出。

智能體會重新規劃任務:可能回到檢索階段,以更精確的查詢尋找缺失證據;也可能調整生成指令,要求模型“若證據不足,需明確説明”。這個過程可能循環多次,直到生成一個滿足預設置信度閾值的答案,或最終坦誠告知用户“根據現有知識無法給出確定回答”。

儘管反思迭代會增加計算開銷和響應延遲,但它將黑箱生成轉變為可審計、可追溯的推理過程。 對於金融、法律、醫療等對準確性要求極高的企業級場景,這種以可控成本換取可靠性的權衡,不僅是必要的,更是RAG技術走向成熟的關鍵標誌。

從Naive到Agentic,RAG的升級遠不止於流程優化,更是設計哲學的轉變:從追求“快速給出一個答案”,到致力於“通過最優路徑找到最可靠的答案”。這背後,是智能體賦予RAG的自主性、反思性與任務導向性,使其真正成為大模型可靠且聰明的“外部大腦”。

你認為,在追求極致準確性的場景下,Agentic RAG增加的響應延遲,是值得付出的代價嗎?歡迎在評論區分享你的看法。