這是一個關於HDFS的核心優勢問題。簡單來説,HDFS的設計目標就是處理超大文件(TB/PB級別),並能在成千上萬台普通商用服務器上穩定運行。

下面我們來詳細分解這兩個問題:

1. HDFS可以處理多大的數據?

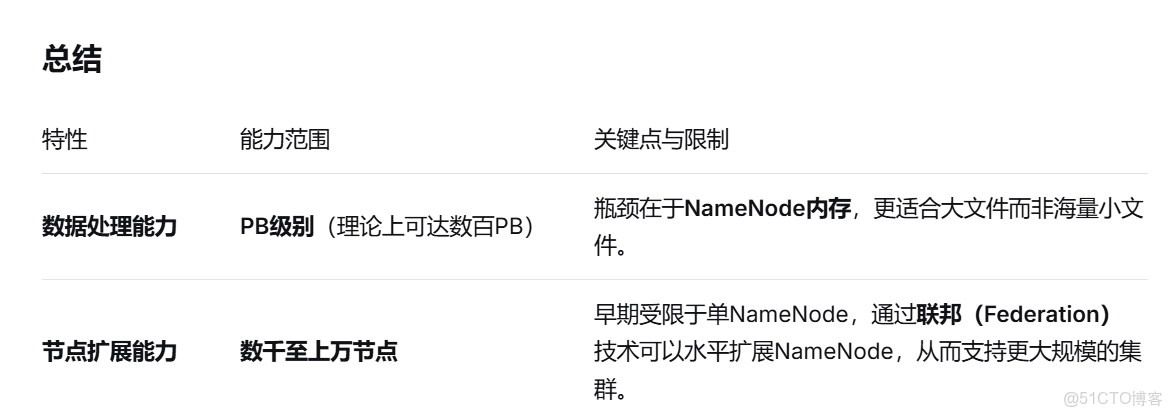

HDFS的設計初衷就是為了解決海量數據的存儲問題,它的數據容量能力可以從以下幾個層面來理解:

理論極限:極高

HDFS的命名空間(可以理解為文件系統的總容量)理論上只受限於NameNode的內存。因為所有文件和目錄的元數據(如文件名、權限、塊位置)都存儲在NameNode的內存中。

一個擁有64GB內存的NameNode,大致可以管理約 10億個 文件塊。如果默認塊大小為128MB,那麼理論上可以存儲的總數據量約為:

`1,000,000,000 blocks * 128 MB/block ≈ 128,000,000 GB ≈ 128 PB`

通過優化(如使用聯邦Federation)和更大內存的服務器,這個上限還可以進一步提升。

實際應用:PB級別是常態

在真實的商業環境中(如阿里巴巴、騰訊、百度、eBay等),HDFS集羣存儲 數十PB到數百PB數據是非常普遍的。

許多中型互聯網公司的HDFS集羣也通常在 **幾PB到十幾PB** 的規模。

**關鍵限制因素:NameNode內存**

* HDFS的容量上限主要瓶頸不在於磁盤,而在於主節點(NameNode)的內存。因為每個文件、每個目錄、每個數據塊都會在NameNode的內存中佔據一定空間。

* 文件數量越多(即使文件很小),對NameNode的壓力就越大,而不是文件總大小。這就是為什麼HDFS最適合存儲大文件,而不適合海量小文件。

小結: 你可以放心地使用HDFS來存儲和處理 PB級別 的數據,這是它最擅長的領域。

2. HDFS可以擴展到多少個節點?

HDFS的擴展性同樣非常出色,其架構就是為了水平擴展而生的。

官方設計目標與驗證:

* HDFS的初始設計目標就是可靠地運行在**成千上萬台** 由普通硬件組成的服務器集羣上。

* 像Yahoo!、Facebook(現Meta)、LinkedIn等公司,在歷史上都運行過擁有 **4000+ 甚至 5000+ 個節點** 的HDFS集羣。這些實踐充分證明了其擴展能力。

實際部署規模:

* 目前,全球最大規模的HDFS集羣部署在**阿里巴巴、騰訊**等超大型互聯網公司。公開報道顯示,它們的某些集羣節點數量已經超過了 **1萬台**。

* 對於絕大多數企業來説,一個擁有幾百到幾千個節點的HDFS集羣已經完全足夠應對業務需求。

擴展性的挑戰與解決方案:

1. NameNode單點瓶頸:在早期版本中,單個NameNode負責所有元數據管理,這成為了集羣節點數量擴展的瓶頸。

* 解決方案:

* 高可用(HA):通過配置Active/Standby兩個NameNode,解決單點故障問題,但不提升性能。

* 聯邦(Federation):這是解決擴展性問題的關鍵。它允許一個集羣中有多個NameNode,每個NameNode獨立管理一部分命名空間(比如/data和/user由不同的NameNode管理)。這樣,元數據的壓力和集羣的總體容量就可以通過增加NameNode來水平擴展,從而支持更多節點。

小結:通過使用聯邦(Federation)和高可用(HA)等技術,HDFS可以輕鬆擴展到**數千個節點,並且在頂級互聯網公司中已經實現了**上萬節點**的部署。

總而言之,HDFS是一個為極致擴展性而設計的分佈式文件系統。對於“大數據”場景,你基本不用擔心它的數據容量和節點規模上限,更應該關注的是如何根據你的數據特性和規模來優化配置(如塊大小、聯邦設計、機架感知等)。