NVIDIA Inference Xfer Library (NIXL) 是一個專為AI推理框架設計的高性能數據傳輸加速庫,通過創新的模塊化插件架構,為分佈式AI推理提供革命性的數據傳輸解決方案。🚀

什麼是NIXL?

NIXL是NVIDIA推出的推理傳輸庫,專門針對AI推理框架中的點對點通信進行優化加速。它為各種類型的內存(CPU、GPU)和存儲(文件、塊存儲、對象存儲)提供統一的抽象層,讓開發人員能夠輕鬆處理複雜的分佈式數據傳輸需求。

核心架構設計

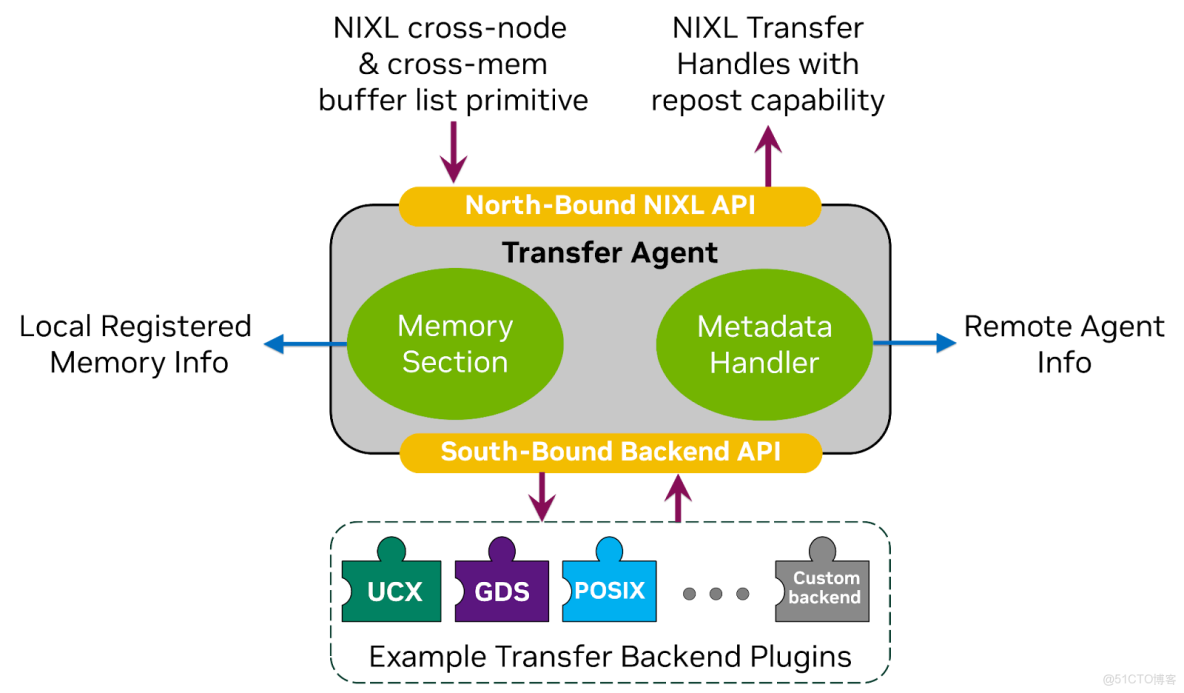

NIXL採用三層架構設計,實現了數據傳輸的極致優化:

傳輸代理(Transfer Agent)

作為NIXL的核心大腦,傳輸代理負責協調所有數據傳輸操作。它包含兩個關鍵子組件:

- 內存段(Memory Section):管理本地註冊內存信息,支持DRAM、VRAM、NVMe-oF等多種內存類型

- 元數據處理器(Metadata Handler):處理遠程代理信息,確保數據傳輸的一致性

南北向API系統

- 北向NIXL API:提供跨節點和跨內存緩衝區的操作原語

- 南向後端API:對接底層傳輸後端插件,實現靈活的擴展性

關鍵技術特性

多後端插件支持

NIXL支持多種高性能後端插件:

- UCX:用於高性能通信,支持RoCE、Infiniband等協議

- GDS(GPUDirect Storage):實現GPU與存儲之間的直接數據傳輸

- POSIX:兼容傳統文件系統操作

- 自定義後端:支持用户根據特定需求開發專用插件

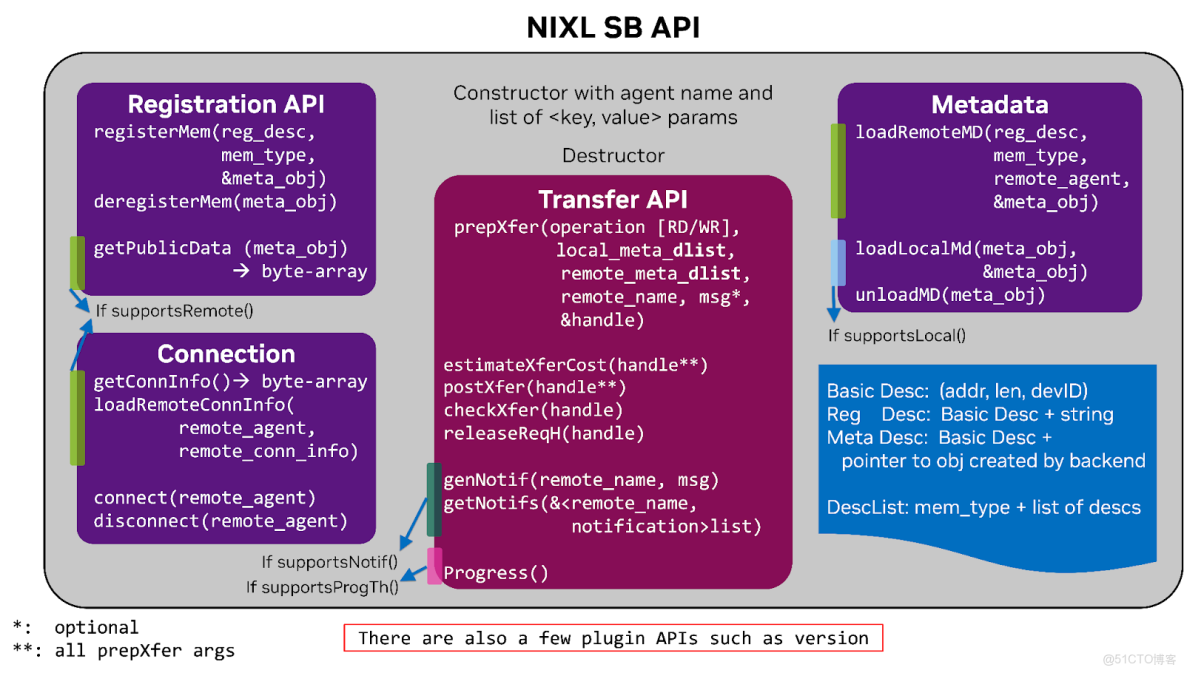

元數據智能管理

NIXL通過元數據處理器實現智能的元數據交換和緩存:

- 支持側通道和中央元數據服務器(如etcd、Redis)

- 動態元數據緩存,支持推理工作負載的彈性伸縮

- 元數據與內存分離管理,確保數據傳輸的一致性

實際應用場景

客户端-服務器架構

在分佈式AI推理系統中,NIXL能夠高效處理客户端與多個服務器節點之間的數據傳輸需求。

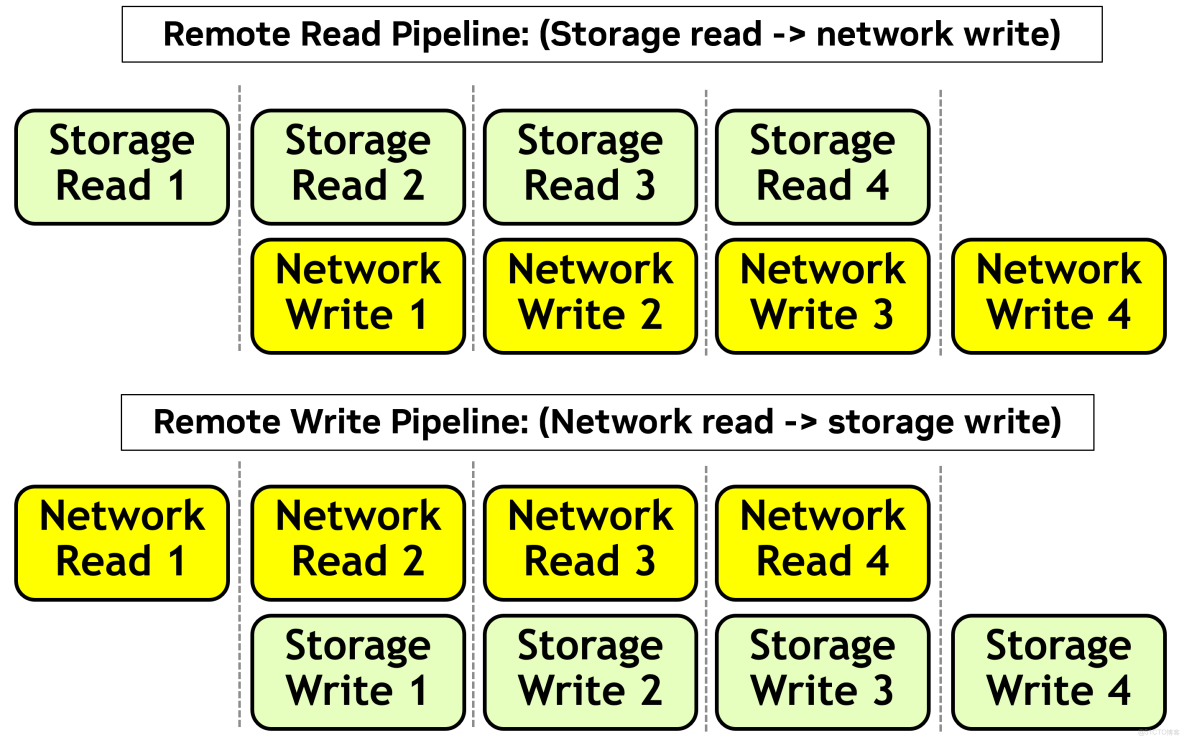

流水線優化傳輸

NIXL通過流水線並行技術顯著提升數據傳輸效率:

- 遠程讀流水線:重疊存儲讀取和網絡寫入操作

- 遠程寫流水線:重疊網絡讀取和存儲寫入操作

快速上手指南

安裝NIXL

通過PyPI快速安裝NIXL:

# CUDA 12環境

pip install nixl[cu12]

# CUDA 13環境

pip install nixl[cu13]基礎使用示例

NIXL提供簡潔的API接口,讓數據傳輸變得異常簡單:

# 初始化NIXL代理

agent = nixl.create_agent("my_agent")

# 註冊內存區域

memory_desc = agent.register_memory(buffer_list)

# 執行數據傳輸

transfer_handle = agent.create_xfer_request(operation, local_descs, target_descs)

agent.post_transfer_request(transfer_handle)性能優勢

NIXL通過以下方式為AI推理框架帶來顯著的性能提升:

- 低延遲傳輸:優化的數據傳輸路徑,減少通信開銷

- 高吞吐量:流水線並行技術最大化帶寬利用率

- 彈性擴展:支持動態添加和移除計算節點

- 統一抽象:簡化不同內存和存儲類型的數據操作

總結

NIXL作為AI推理領域的數據傳輸加速利器,通過創新的架構設計和豐富的後端插件支持,為分佈式推理系統提供了高效、可靠的數據傳輸解決方案。無論您是在構建大規模的AI推理服務,還是優化現有的推理工作負載,NIXL都能為您提供強大的技術支撐。🎯