引言

Tokio作為Rust生態中最重要的異步運行時,其多線程調度器是支撐高併發應用的基石。與傳統線程池不同,Tokio採用work-stealing算法和任務分片技術,在保證公平性的同時實現了極致性能。深入理解Tokio調度器的架構設計,不僅有助於編寫高效的異步代碼,更能讓我們洞察現代併發編程的核心理念。本文將從調度器的設計哲學出發,結合源碼分析和實踐案例,全面剖析Tokio多線程調度器的工作原理。

Work-Stealing調度模型的設計哲學

Tokio的多線程調度器建立在work-stealing算法之上,這是一種經過實踐驗證的負載均衡策略。每個工作線程維護自己的本地任務隊列,當隊列為空時,線程會嘗試從其他線程的隊列中"竊取"任務。這種設計的精妙之處在於最小化了線程間的同步開銷——大部分情況下,線程只需要訪問自己的本地隊列,只有在隊列耗盡時才需要進行跨線程操作。

與簡單的全局隊列模式相比,work-stealing在緩存局部性方面具有顯著優勢。當任務傾向於產生相關的子任務時,這些子任務會優先在同一線程上執行,從而充分利用CPU緩存。同時,竊取機制確保了即使任務分佈不均,空閒線程也能快速找到工作,避免資源浪費。

Tokio的實現在標準work-stealing基礎上做了諸多優化。本地隊列使用了特殊的LIFO語義,新產生的任務被推入隊列頭部,而竊取總是從尾部進行。這種設計基於一個觀察:最近產生的任務更可能與當前執行上下文相關,在同一線程執行能獲得更好的緩存命中率。而被竊取的任務往往是較早產生的,已經相對獨立,適合遷移到其他線程。

use tokio::runtime::Builder;

use std::time::Duration;

fn main() {

// 創建自定義配置的多線程運行時

let runtime = Builder::new_multi_thread()

.worker_threads(4)

.thread_name("tokio-worker")

.thread_stack_size(3 * 1024 * 1024)

.build()

.unwrap();

runtime.block_on(async {

demonstrate_work_stealing().await;

});

}

async fn demonstrate_work_stealing() {

let handles: Vec<_> = (0..100).map(|i| {

tokio::spawn(async move {

// 模擬計算密集型任務

let mut sum = 0;

for j in 0..1000 {

sum += i * j;

// 定期讓出執行權,允許調度器介入

if j % 100 == 0 {

tokio::task::yield_now().await;

}

}

sum

})

}).collect();

for (i, handle) in handles.into_iter().enumerate() {

let result = handle.await.unwrap();

if i % 20 == 0 {

println!("Task {} completed with result: {}", i, result);

}

}

}任務的生命週期與狀態轉換

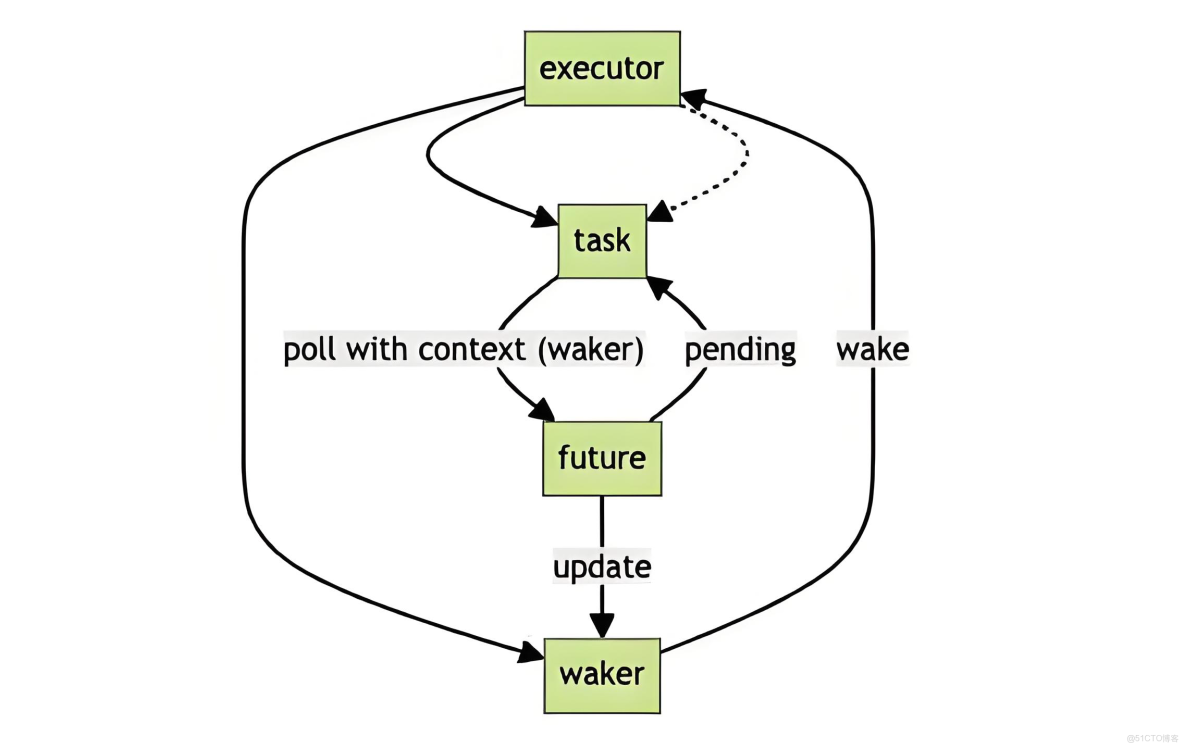

在Tokio中,每個異步任務都封裝在一個Task結構中,經歷着複雜的狀態轉換。從創建、調度、執行到完成,任務在不同的隊列和線程之間流轉。理解這個生命週期對於診斷性能問題和避免常見陷阱至關重要。

當我們通過tokio::spawn創建任務時,它首先被包裝成可執行單元,包含了Future本身以及必要的元數據。調度器會根據當前負載情況決定將任務放入哪個隊列。如果在運行時上下文內創建任務,通常會選擇當前線程的本地隊列;否則會選擇全局注入隊列。這個決策雖然簡單,但對任務的初始執行延遲有直接影響。

任務的執行遵循協作式調度原則,每個任務通過返回Poll::Pending主動讓出控制權。這與操作系統的搶佔式調度形成鮮明對比,要求程序員必須確保任務不會長時間阻塞。Tokio通過預算機制限制單個任務的連續執行時間,當任務消耗完預算後,即使返回Poll::Ready,也會被重新放入隊列末尾,給其他任務執行機會。

use tokio::time::{sleep, Duration, Instant};

use std::sync::Arc;

use std::sync::atomic::{AtomicUsize, Ordering};

async fn task_lifecycle_analysis() {

let counter = Arc::new(AtomicUsize::new(0));

let start = Instant::now();

let tasks: Vec<_> = (0..10).map(|id| {

let counter = counter.clone();

tokio::spawn(async move {

for i in 0..5 {

counter.fetch_add(1, Ordering::Relaxed);

println!("[Task {}] Iteration {}, Thread: {:?}",

id, i, std::thread::current().id());

// 模擬IO等待,觸發任務調度

sleep(Duration::from_millis(10)).await;

}

id

})

}).collect();

// 等待所有任務完成

for handle in tasks {

let id = handle.await.unwrap();

println!("Task {} finished", id);

}

let elapsed = start.elapsed();

let total_iterations = counter.load(Ordering::Relaxed);

println!("\nTotal iterations: {}, Time: {:?}", total_iterations, elapsed);

}隊列結構與任務注入策略

Tokio的隊列系統採用了多層次架構。每個工作線程擁有一個固定大小的本地隊列(通常為256個任務槽位),此外還有一個全局的注入隊列。當本地隊列滿時,新任務會被放入全局隊列;當本地隊列空時,線程會依次嘗試從本地隊列、全局隊列、以及其他線程的隊列中獲取任務。

這種分層設計背後有深刻的權衡考量。本地隊列使用無鎖的單生產者單消費者隊列實現,操作延遲極低;而全局隊列需要支持多生產者多消費者場景,使用了基於鎖的實現,但通過批量操作降低了鎖競爭的影響。工作竊取時,線程會從目標隊列的尾部批量竊取多個任務,減少竊取的頻率。

任務注入策略直接影響系統的響應性和吞吐量。對於大量短生命週期任務的場景,頻繁的全局隊列訪問會成為瓶頸;而對於長生命週期任務,本地隊列的局部性優勢則更為明顯。Tokio通過動態調整注入策略和竊取閾值來適應不同的工作負載特徵。

use tokio::runtime::Handle;

use std::sync::Arc;

use std::sync::atomic::{AtomicU64, Ordering};

async fn queue_injection_demo() {

let metrics = Arc::new(TaskMetrics::new());

// 場景1:大量短任務(快速注入場景)

println!("=== Scenario 1: Many short tasks ===");

let metrics1 = metrics.clone();

for i in 0..1000 {

let metrics = metrics1.clone();

tokio::spawn(async move {

metrics.increment_spawned();

// 極短任務

let _ = i * 2;

metrics.increment_completed();

});

}

sleep(Duration::from_millis(100)).await;

metrics.print_stats("Short tasks");

metrics.reset();

// 場景2:少量長任務(本地隊列優勢場景)

println!("\n=== Scenario 2: Few long tasks ===");

let handles: Vec<_> = (0..10).map(|i| {

let metrics = metrics.clone();

tokio::spawn(async move {

metrics.increment_spawned();

for _ in 0..100 {

sleep(Duration::from_millis(1)).await;

}

metrics.increment_completed();

i

})

}).collect();

for handle in handles {

handle.await.unwrap();

}

metrics.print_stats("Long tasks");

}

struct TaskMetrics {

spawned: AtomicU64,

completed: AtomicU64,

}

impl TaskMetrics {

fn new() -> Self {

Self {

spawned: AtomicU64::new(0),

completed: AtomicU64::new(0),

}

}

fn increment_spawned(&self) {

self.spawned.fetch_add(1, Ordering::Relaxed);

}

fn increment_completed(&self) {

self.completed.fetch_add(1, Ordering::Relaxed);

}

fn print_stats(&self, label: &str) {

println!("{}: Spawned={}, Completed={}",

label,

self.spawned.load(Ordering::Relaxed),

self.completed.load(Ordering::Relaxed)

);

}

fn reset(&self) {

self.spawned.store(0, Ordering::Relaxed);

self.completed.store(0, Ordering::Relaxed);

}

}線程停放與喚醒機制

當工作線程無法找到任何可執行任務時,它不會忙等待而是進入休眠狀態,這個過程稱為線程停放(parking)。Tokio使用條件變量和原子操作的組合實現了高效的停放機制。線程在休眠前會將自己標記為空閒狀態,當有新任務注入時,調度器會喚醒一個或多個空閒線程。

這個機制看似簡單,實則藴含着精妙的併發控制邏輯。為了避免丟失喚醒信號,Tokio在停放前後都會進行多次檢查,確保在標記為空閒和實際休眠之間的窗口期內注入的任務能被及時發現。同時,喚醒策略也經過仔細調優——通常只喚醒一個線程來處理新任務,避免雷鳴羣(thundering herd)效應。

use tokio::sync::Semaphore;

use std::sync::Arc;

async fn parking_demonstration() {

let semaphore = Arc::new(Semaphore::new(2));

println!("Starting parking demo with 2 permits");

// 創建多個任務競爭有限資源

let handles: Vec<_> = (0..5).map(|id| {

let sem = semaphore.clone();

tokio::spawn(async move {

println!("[Task {}] Waiting for permit...", id);

let permit = sem.acquire().await.unwrap();

println!("[Task {}] Acquired permit, working...", id);

// 模擬工作

sleep(Duration::from_secs(1)).await;

println!("[Task {}] Releasing permit", id);

drop(permit); // 顯式釋放

})

}).collect();

for handle in handles {

handle.await.unwrap();

}

}專業思考:性能優化與最佳實踐

在實際應用中,充分發揮Tokio調度器的性能需要遵循一些最佳實踐。首先是避免在異步任務中進行阻塞操作,任何同步IO或長時間計算都應該通過spawn_blocking轉移到專用的阻塞線程池。其次是合理控制任務粒度,過細的任務會增加調度開銷,過粗的任務會影響響應性和公平性。

另一個關鍵點是理解任務親和性。雖然work-stealing能夠動態平衡負載,但頻繁的任務遷移會破壞緩存局部性。對於有狀態的任務,考慮使用LocalSet將相關任務綁定到同一線程執行。同時,監控運行時的度量指標(如隊列深度、竊取頻率)可以幫助識別性能瓶頸。

最後,要認識到調度器配置沒有銀彈。工作線程數量、隊列大小等參數需要根據具體工作負載進行調優。CPU密集型應用通常使用與CPU核心數相同的線程數,而IO密集型應用可能需要更多線程以隱藏IO延遲。通過系統化的性能測試和分析,找到最適合自己應用場景的配置。

use tokio::runtime::Builder;

fn create_optimized_runtime() {

let num_cpus = num_cpus::get();

let runtime = Builder::new_multi_thread()

.worker_threads(num_cpus)

.max_blocking_threads(num_cpus * 4)

.thread_keep_alive(Duration::from_secs(10))

.global_queue_interval(31)

.event_interval(61)

.build()

.unwrap();

runtime.block_on(async {

// 混合工作負載示例

let mut handles = vec![];

// CPU密集型任務

for i in 0..num_cpus {

handles.push(tokio::spawn(async move {

let result = fibonacci(30 + i);

println!("Fibonacci result: {}", result);

}));

}

// IO密集型任務

for i in 0..num_cpus * 2 {

handles.push(tokio::spawn(async move {

sleep(Duration::from_millis(100)).await;

println!("IO task {} completed", i);

}));

}

// 阻塞操作

handles.push(tokio::task::spawn_blocking(|| {

std::thread::sleep(Duration::from_secs(1));

println!("Blocking operation completed");

}));

for handle in handles {

handle.await.unwrap();

}

});

}

fn fibonacci(n: usize) -> u64 {

match n {

0 => 0,

1 => 1,

_ => fibonacci(n - 1) + fibonacci(n - 2),

}

}結語

Tokio的多線程調度器代表了現代異步運行時設計的巔峯水平。通過work-stealing算法、分層隊列架構和精細的停放機制,它在保持簡潔API的同時實現了卓越的性能。深入理解調度器的工作原理,不僅能幫助我們寫出更高效的異步代碼,更能培養對併發系統的深刻洞察。隨着Rust異步生態的不斷成熟,掌握Tokio調度器必將成為高級Rust開發者的必備技能。

希望這篇文章能幫助你深入理解Tokio調度器的架構設計和實踐應用!🦀⚡