#車道線檢測

中科院最新綜述

大家好,很榮幸能受到的邀請來為大家分享我們的一篇關於單目車道線檢測的綜述。與papaer裏展現的順序和內容可能有所不同,在這裏筆者想更多地講一講本文的成文過程以及各類方法的發展史,因此對於各方法的詳細介紹讀者可以參考本文原文,這裏不會花費過多筆墨來重述。關於本文原文中提到的方法,以及更多未提到的方法的論文和代碼均可在筆者構建的GitHub倉庫裏找到,筆者後續也會不斷更新,歡迎大家關注,也歡迎業內同仁指正,共同探討。

- 論文鏈接:https://arxiv.org/abs/2411.16316

- 開源鏈接:https://github.com/Core9724/Awesome-Lane-Detection

最開始入門車道線檢測的時候要從去年春季,看了幾篇22年頂會頂刊的2D車道線檢測論文(那一年的相關論文很高產,僅CVPR就有5篇)説起。起初對於車道線檢測的瞭解也僅限於它們在文中related work部分裏提到的有基於分割的、基於anchor的、基於曲線的方法等等。但是還有一些地方不明白,相信不少剛接觸這個領域的朋友也有同樣的疑問:

1、為什麼要區分不同的實例?而且一些論文裏專門針對解決這個問題花費大量篇幅講解,可是另一些論文裏似乎又沒怎麼提及;

2、為什麼用語義分割得到的車道線mask還要進一步擬合成點集或曲線?很多論文裏只説了用分割做的話需要進一步後處理擬合,但沒説這樣做的原因;

帶着這些疑問,筆者又翻閲了近年來的一些相關綜述,期望能得到答案。遺憾的是,當時最新的質量較高的綜述只到21年為止,裏面包含的方法基本都是2D車道線檢測且用語義分割來做的方法,也沒有強調實例區分和曲線擬合這兩個問題。

所幸之後接觸到了一些自動駕駛工程師,和他們交流一番後才明白:下游規劃控制任務實際上只關心車道線中心線。如果不區分車道線實例以及缺乏矢量化格式(點集或曲線方程)的話,就沒法計算了。

考慮到以往的綜述年代有點老,近年來很多新的方法都不包含,於是萌生了寫一篇車道線檢測的綜述的想法。但是當時筆者只對2D車道線檢測理解比較深入,而近年來也有3D車道線檢測的工作出現,所以在綜述範圍上就又有疑問了:只寫2D還是2D和3D都寫?

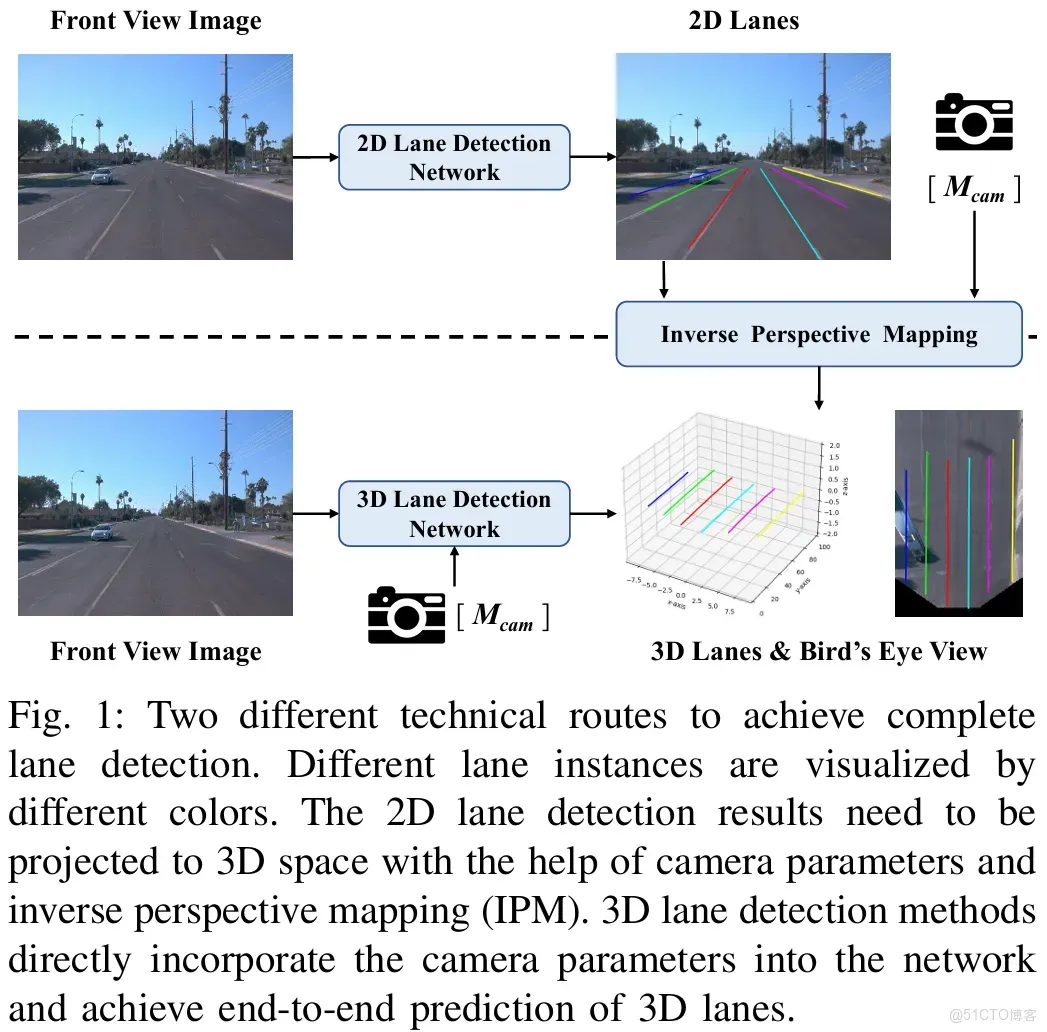

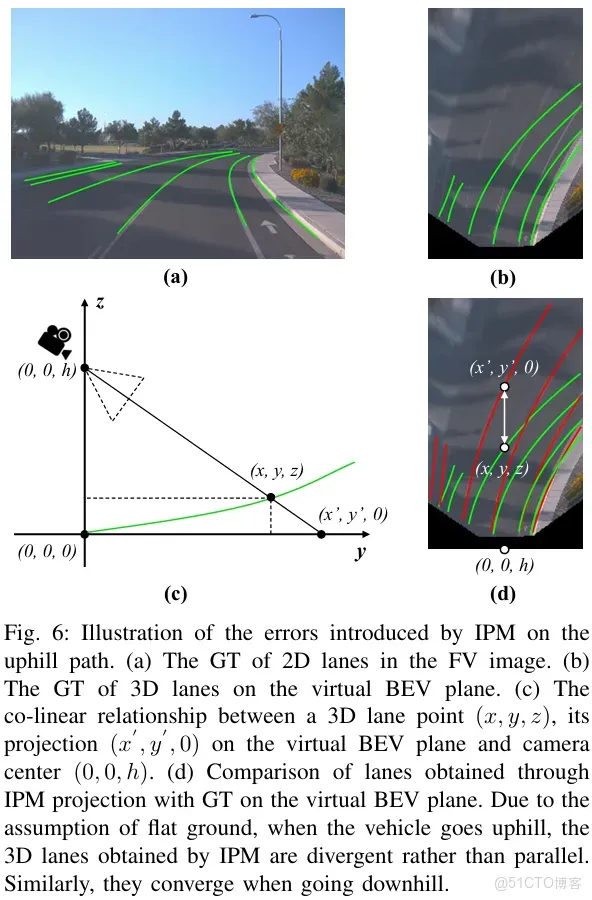

後來在看了3D車道線檢測的相關論文後才明白:下游需要的都是基於自車的3D信息,2D車道線檢測結果還需要IPM投影得到3D車道線才能用。然而IPM假設地面平坦,在上下坡時會不準確,所以3D車道線檢測任務誕生。

因此筆者認為有必要把2D車道線檢測和3D車道線檢測都寫進去,它們之間的關係是很密切的。考慮到傳統方法現在基本很少用了,目前基本都是深度學習主導。另外LiDAR-based的方案太少,目前在這個領域裏主流傳感器還是單目相機。於是確定了最終選題:基於深度學習的單目車道線檢測綜述。

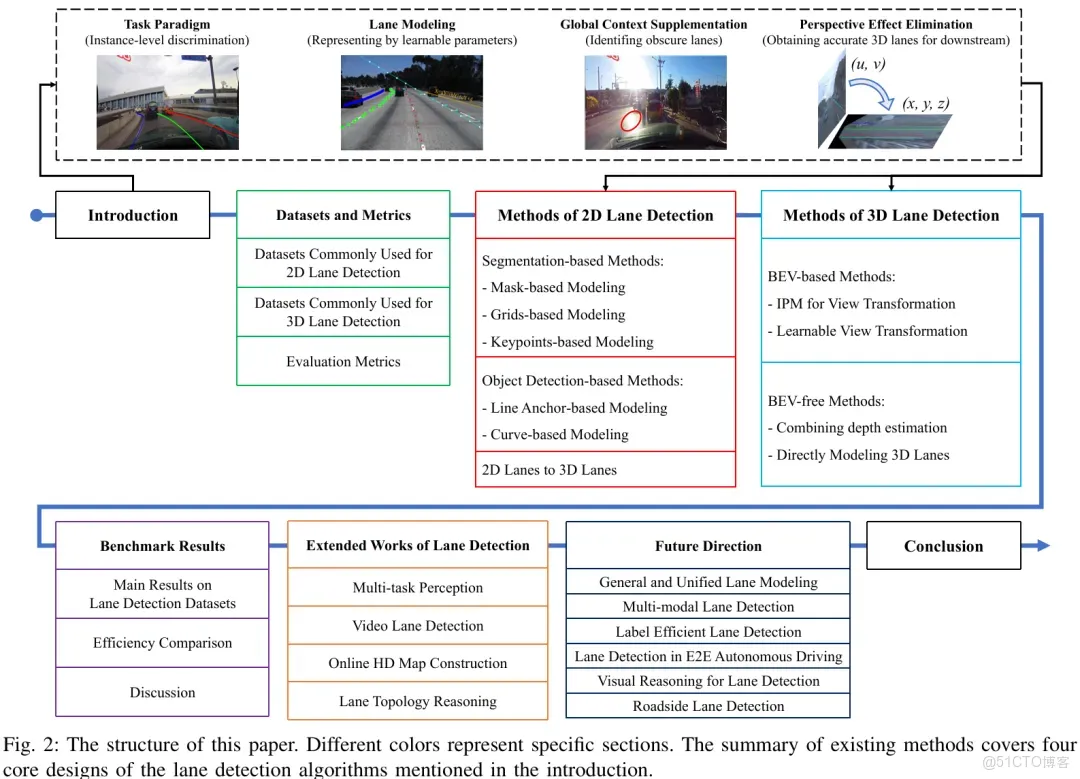

1、本文組織結構

以往的綜述過分關注每個具體的方法的網絡結構和損失函數,雖然它們對於深度學習來説也很重要,但是並不完全構成解決車道線檢測任務本身挑戰的關鍵。所以本文從車道線檢測任務的完整流程和挑戰出發,先總結了車道線檢測算法的四個核心設計,然後從這四個方面展開方法回顧。

先説車道線檢測任務的完整流程和挑戰:

完整流程:從前視圖(Front View,以下簡稱FV)得到基於自車座標系下的3D車道線,即鳥瞰圖(Bird‘s Eye View,以下簡稱BEV)結果,實現方式如圖1所示,包括:

1、2D車道線檢測+IPM;

2、3D車道線檢測。

挑戰:

1、精確的定位和實時處理能力;

2、能夠應對車道線被遮擋、光照等干擾因素影響的情況;

3、區分不同實例;

4、以矢量化格式呈現車道線檢測結果(點集或曲線方程)。

基於完整流程和挑戰,筆者總結了車道線檢測算法的四個核心設計:

1、任務範式,即如何區分車道線實例;

2、車道線建模,即將車道線表示為一組網絡可學習的參數;

3、全局上下文補充,即應對那些不明顯的車道線;

4、(相機)透視效應消除,即為下游提供準確的3D車道線。

因此本文對現有方法的回顧主要從以上四個核心設計為角度開展。本文的貢獻如下:

1、對基於深度學習的單目車道線檢測並且首次同時包含2D和3D車道線檢測方法的全面綜述;

2、本文先介紹了車道線檢測算法的四個核心設計,然後從上述角度系統地總結現有方法。以往的相關綜述通常對某個方法的具體網絡結構和損失函數做詳細介紹,然後附上相應方法的網絡結構圖。筆者更傾向於把每一類方法都總結為一個pipeline,然後針對每個pipeline介紹其框架下的每個方法,這樣可以幫助讀者更好地理解;

3、考慮到不同方法做實驗時使用的設備可能有所不同,直接用其原論文中報告的速度來進行比較肯定是不公平的。所以除了比較不同方法在不同benchmark下的性能以外,還在統一環境下重新測試了代表性方法的速度;

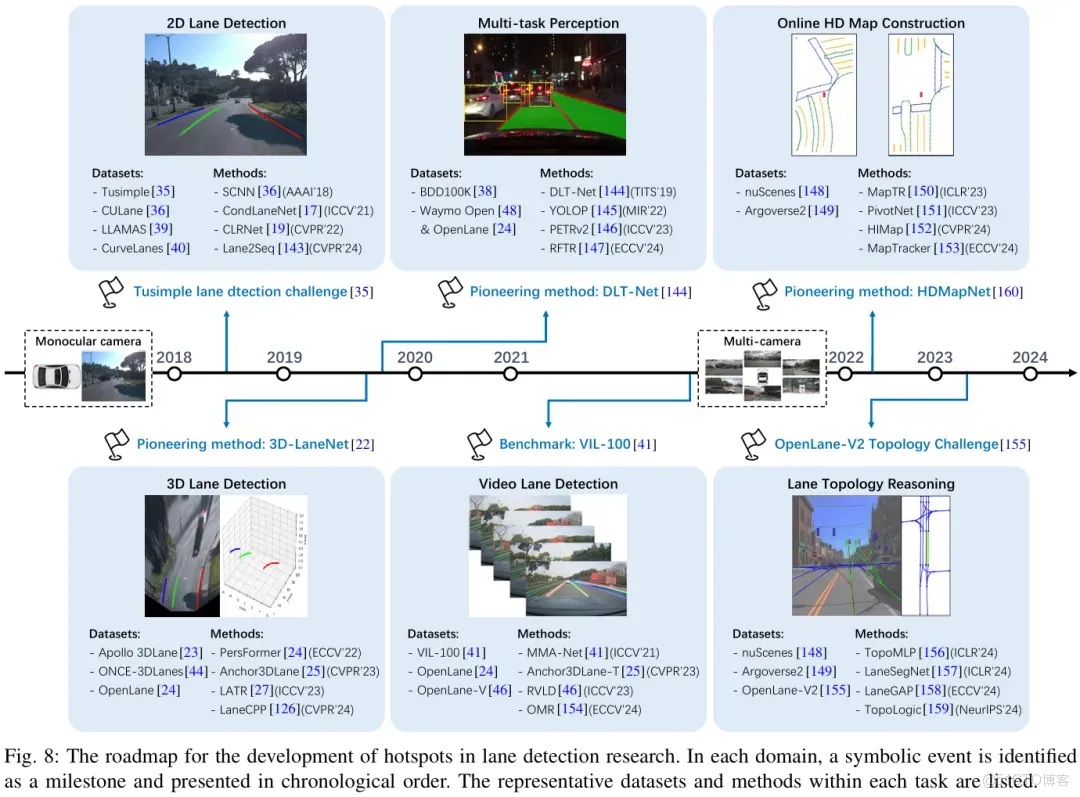

4、近年來還有一些工作(多任務感知、視頻車道線檢測、在線高精地圖構建、車道線拓撲推理)也很受關注,在任務流程上可以視為單目車道線檢測的升級,所以筆者在文中也對它們進行了介紹。基於這些介紹,讀者可以獲得一份關於車道線檢測研究熱點發展的路線圖。

本文的組織結構如圖2所示。

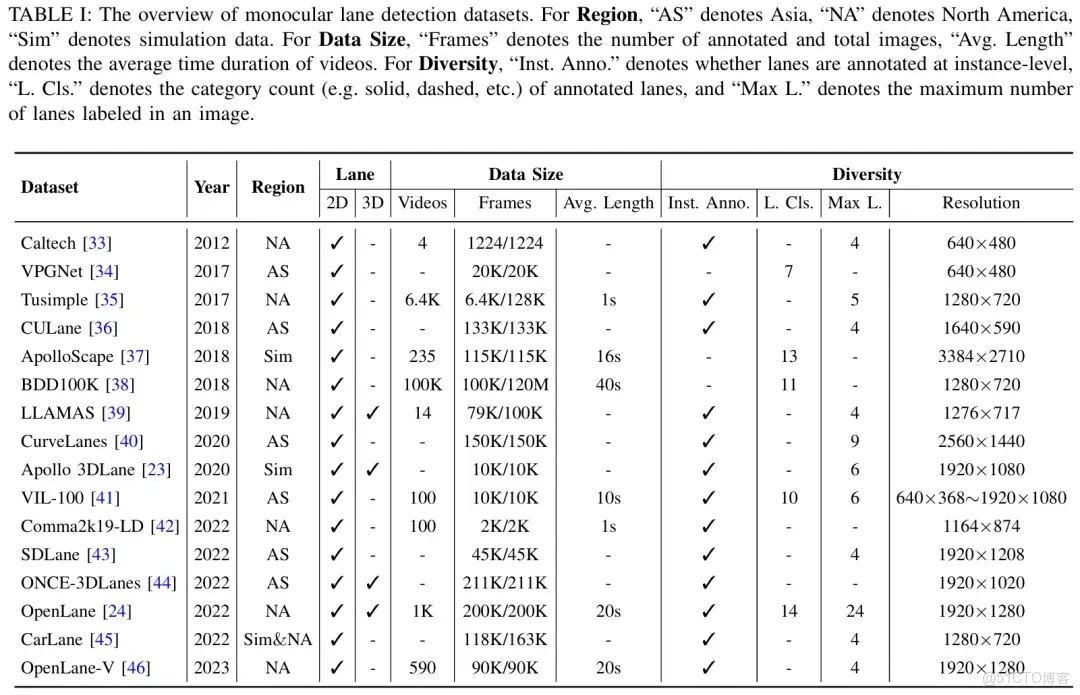

2、數據集和評估指標2.1 數據集

對於2D車道線檢測,最常用的四個數據集:Tusimple、CULane、LLAMAS和CurveLanes。現有2D方法基本上選擇三個做實驗,CULane和Tusimple,外加LLAMAS和CurveLanes二選一。

對於3D車道線檢測,雖然LLAMAS也有3D車道線標註,但最常用的還是Apollo 3DLane、ONCE-3DLanes和OpenLane這三個。

這裏多説一些有關OpenLane、OpenLane-V和OpenLane-V2三個數據集的區別,以防讀者混淆。OpenLane是上海AI Lab在ECCV 2022提出的3D車道線檢測數據集,是對Waymo Open數據集中部分FV圖像的車道線進行標註得到的;OpenLane-V是ICCV 2023的RVLD這篇文章的作者團隊基於OpenLane的部分2D車道線標註修改得到的2D車道線檢測數據集;OpenLane-V2也是上海AI Lab提出的數據集,但它和OpenLane關係其實不大,它是基於nuScenes和Argoverse2兩個環視場景數據集構建而來的,並且標註主要集中在中心線、紅綠燈和拓撲關係,曾用於CVPR 2023拓撲挑戰賽,最終發表於NeurIPS 2023。

2.2 評估指標(TP的判定標準)

不同benchmark的評估指標都有所不同,不過F1-Score是幾乎所有數據集的首要評估指標,而F1-Score的計算又離不開TP的判定。因此本文主要介紹不同主流benchmark的TP判定標準。

對於2D車道線檢測,TP判定主要以Tusimple和CULane為代表。Tusimple主要衡量每個點。當縱座標相同時,如果與GT點的水平距離小於20像素,則認為預測點正確。進而當預測的車道線包含不少於85%的正確點時,該預測線被視為TP。相比之下,CULane更注重衡量車道線整體,車道線被視為若干像素寬的mask,如果預測的車道線mask和GT的IoU大於75%則被視為TP。

對於3D車道線檢測,TP判定主要以OpenLane和ONCE-3DLanes為代表。OpenLane:當一個預測車道線有75%的覆蓋y位置與GT的逐點距離小於允許的最大距離(1.5米)時,被視為TP;ONCE-3DLanes:首先,在z-x平面(即俯視圖)上使用CULane的計算IoU的方法來評估預測與地面實況之間的對齊情況。其次,如果IoU超過預定義閾值,則使用單側倒角距離(詳見ONCE-3DLanes原文或本文附錄)計算相機座標中的曲線匹配誤差。如果該單側倒角距離低於指定閾值,則預測線被歸為TP。

3、2D車道線檢測方法

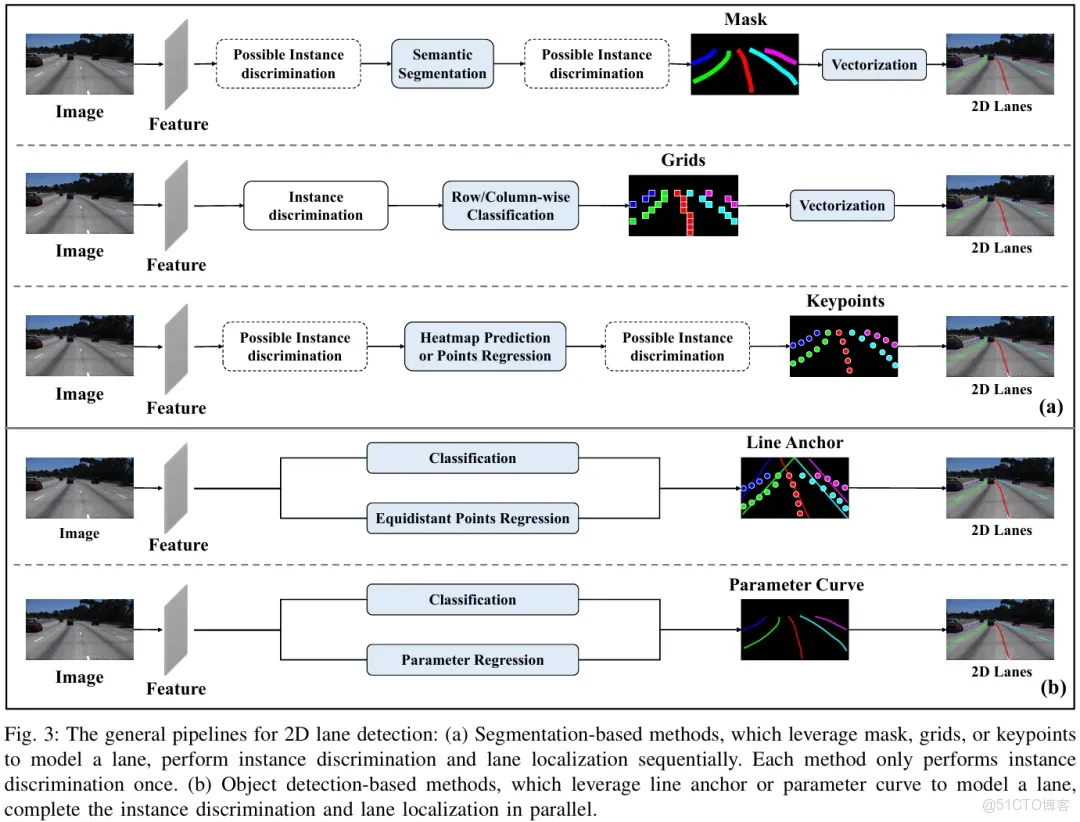

3.1 分類框架

以往的相關綜述主要關注具體網絡結構和損失函數。而實例級判別和矢量化結果表達往往被忽視。相比之下,本文對二維車道線檢測方法的分類主要依據上述兩個方面。

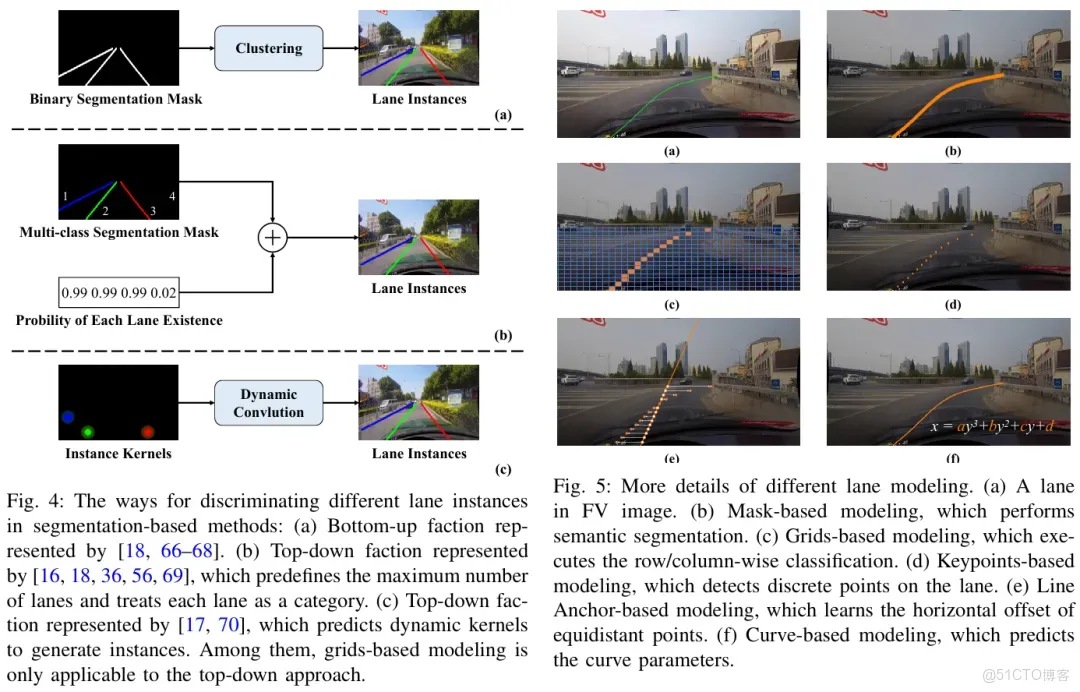

如圖3所示,首先,對於實例級判別,根據完成任務所需的階段數分為兩類範式:

(a)基於分割的方法(segmentation-based methods,兩階段),按照一定的順序完成車道線識別和實例區分。圖4總結了這類方法中實例區分的通用流程。

(b)基於目標檢測的方法(object detection-based methods,單階段),直接同時完成實例區分和定位。這一優勢源自目標檢測算法的一般流程(並行地對一組候選proposal執行分類和迴歸)。

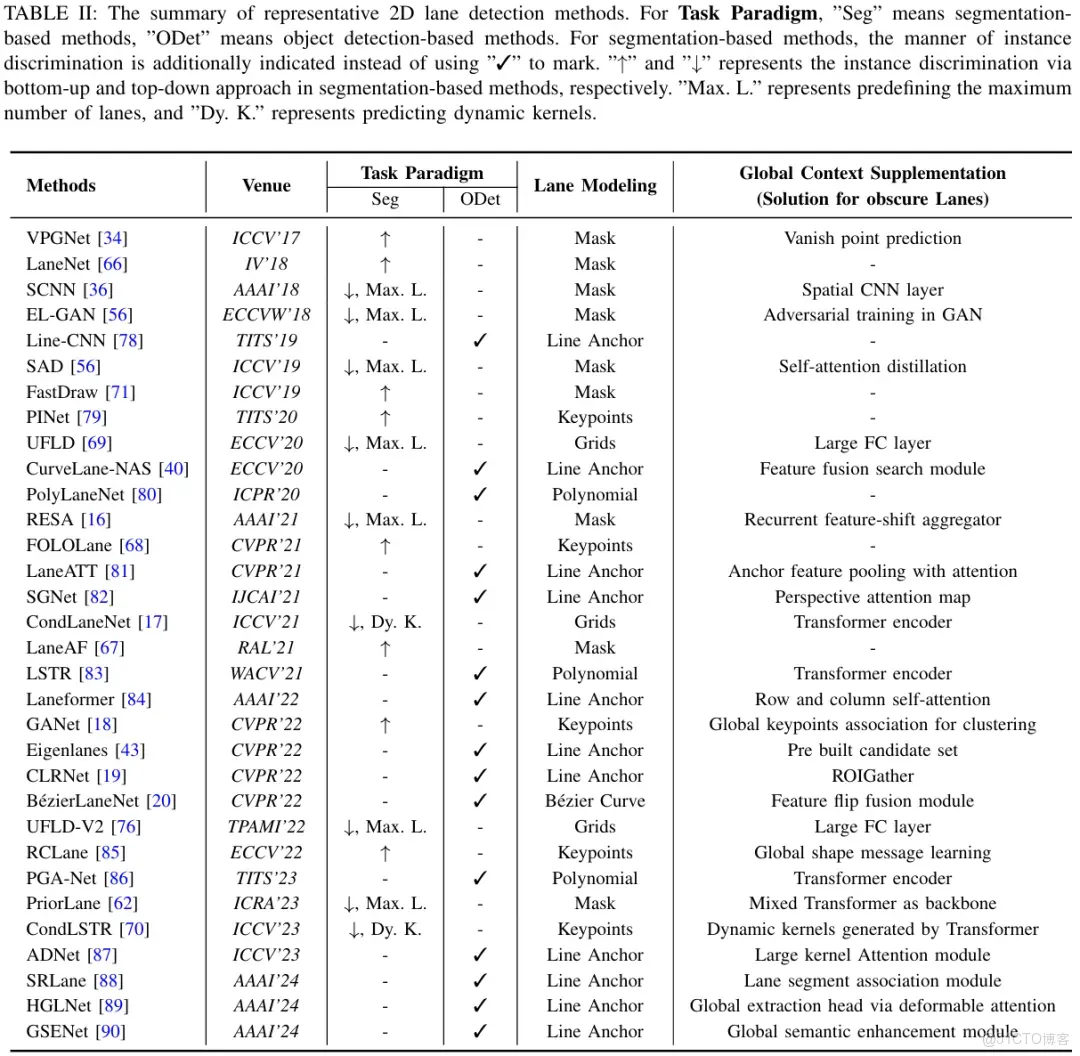

其次,矢量化結果表示要求算法考慮如何將車道線建模為一組用於神經網絡學習的值,即車道線建模。基於分割的方法可以進一步分為基於mask的建模、基於grids的建模和基於keypoints的建模。對於基於目標檢測的方法,採用bounding box來建模細長的車道線往往並不合理。因為目標檢測方法生成的邊界框可能會相互遮擋,而且一個框內可能包含多個車道線實例。為了與一般的目標檢測範式對齊,這些方法設計了獨特的“bounding box”來建模車道線,包括基於line anchor的建模和基於curve的建模。每種車道線建模方式的細節如圖5所示。

另外,大多數現有的2D車道線檢測數據集甚至為被車輛嚴重遮擋或受極端天氣條件影響的車道線提供了完整的標註。這促使許多算法在其網絡裏精心設計特殊結構補充全局上下文來解決這一挑戰,無論它們屬於哪個分類體系。因此,在回顧這些方法時,還闡述了它們為解決這一問題所採取的措施(篇幅限制,在這裏未詳細列出,具體可見本文原文)。根據上述分類標準,表2詳細比較了具有代表性的二維車道線檢測工作。

注:其實不少論文裏的related work部分都有把現有的2D車道線檢測方法分為segmentation-based、anchor-based、keypoints-based、curve-based等等。但是這個分類僅反映了不同方法的車道線建模方式。實例級判別很少被提及,原因一方面是那些基於anchor或者曲線的方法本身遵循目標檢測的範式,不需要考慮實例判別問題;另一方面是在related work裏也確實沒必要分的這麼細(再細分就超頁數了)。但對於綜述來説,有必要把這個上下級關係為讀者解釋清楚,所以本文針對實例級判別和車道線建模方式進行了二級分類。另外,不少論文的related work裏將UFLD、CondLaneNet等方法也歸為anchor-based,這一點可能源自於UFLD原論文中的“row-anchor”表述。但實際上它們是遵循着“實例區分、逐行/列分類”一個順序的過程,需要額外考慮實例判別過程,並不符合目標檢測並行“分類+迴歸”的特點,因此本文將其劃分至基於分割和基於grids的建模的方法。

3.2 基於分割的方法3.2.1 基於mask的建模

基於mask的建模方法,即將車道線檢測視為語義分割任務,也是早期被廣泛採用的方法。不過和一般的語義分割任務不同的是,一般的語義分割任務只分割可見的物體,但是車道線檢測是要能分割出那些不明顯的車道線的。所以這一類的大部分方法在解碼器上採樣之前引入了專門的結構來增強特徵表示,比如VPGNet、SCNN、SAD、EL-GAN、RESA、PriorLane等方法。

而對於實例級判別來説,一個比較直接的方法是用自頂向下(先有實例後有語義類別)的實例分割框架,比如Mask R-CNN或YOLACT,以實現車道線實例級別的區分和分割。然而,目標檢測方法生成的邊界框可能包含多個車道線實例,後續的語義分割過程中區分它們會變得複雜。

SCNN採用了一種與上述不同的自頂向下方式,如圖4(b)所示:每條車道線視為一個類別,然後多類別語義分割結果和一個並行的分類分支結合。後續的SAD、EL-GAN、RESA、PriorLane也都是這麼做的。這種方式方便了實例區分,但也引入了一定的侷限性:需要提前定義車道線的最大數量來確定可能的實例數量。此外,車道線與類別之間的對應關係是通過標註建立的。當車輛變道時,這種預定義的標註可能會導致歧義。

為了解決上述問題,一些方法採用了更為靈活的自底向上(先有語義後有實例)的實例分割方式,即對車道線/背景的二值分割結果進行聚類,如圖4(a)所示。最典型的當屬LaneNet和LaneAF這倆。不過儘管這些方法提高了實例區分能力,但由於自底向上聚類的高複雜度以及語義分割時對所有像素分類的機制,算法的整體效率仍然不佳。

通過網絡分割獲得的車道線mask通常包含大量不相關區域。為了將其用於自車運動預測和規劃,還需要進一步對mask進行去噪處理,以獲得矢量化結果。通常,對於每個車道線的mask,在等間距高度上依次採樣最高響應值,然後進行曲線擬合。

3.2.2 基於grids的建模

為了避免語義分割分類所有像素的機制帶來的低效率,UFLD設計了一種逐行網格分類的方式完成車道線檢測。這個方法也是目前所有2D車道線檢測方法裏最快的,但是它的實例判別過程也是遵循SCNN那一套。所以為了解決實例級判別問題,受經典實例分割方法CondInst和SOLOv2的啓發,ConeLaneNet以預測動態卷積核的方式完成實例級判別,如圖4(c)所示。後來UFLDv2又把逐行分類升級成逐行/列分類來解決水平車道線的檢測難以用逐行分類機制實現的問題。但仍然遵循SCNN的實例判別過程,這使得為每個車道線實例來選擇逐行/列分類過於簡單,所以後來CANet又針對這一點進行了改進,讓網絡能夠動態選擇行分類或列分類。

由於這類方法的網絡輸出每一行/列網格的分類概率,並非矢量化格式,因此還需要後處理。具體地説,每個點的座標計算為位置的期望值(來自同一行/列的網格)即概率加權平均值。這個後處理過程與語義分割獲得的車道線mask的後處理相比更容易實現。

3.2.3 基於keypoints的建模

一些方法直接預測車道線的關鍵點,和基於grids的建模類似,可以被視為基於mask的建模的稀疏版本,但它直接提供了下游所需的矢量化表達。像PINet、FOLOLane、GANet還有RCLane這些都是以自底向上的方式進行,也有遵循自頂向下的方式,最典型的比如CondLSTR。

3.3 基於目標檢測的方法

3.3.1 基於line anchor的建模

這類建模方式是目前用的最多,在各個benchmark上刷點也很高的一類。其方法本質就是預測一條參考線上的等距點的水平偏移量來描述車道線,這與一般目標檢測方法預測中心點和寬高的偏移量是類似的。

這類方法最早可以追溯到Line-CNN,後來被LaneATT發揚光大。不過由於預設大量的line anchor,以及早期一般的目標檢測方法的正負樣本匹配策略的侷限性,導致那一時期出現的方法都需要NMS後處理。後來隨着目標檢測逐漸被DETR佔據主導地位以及匹配策略的改進,相應產生的車道線檢測方法也慢慢向其靠攏。比較典型的例如Laneformer、CLRNet、ADNet,相比於早期的基於line anchor的建模方法,它們從固定密集的line anchor轉變為動態稀疏的line anchor。

3.3.2 基於curve的建模

另一批基於目標檢測的方法直接用曲線方程建模車道線,網絡學習曲線的參數。最初的方法比如PolyLaneNet用三次多項式建模車道線並學習多項式的係數,後來LSTR又把這種建模方式套進了DETR裏。由於學習相對較少的參數,這類方法在速度上屬於較快的一批。但是在性能上並不具備有競爭力的優勢。後來BézierLaneNet用三次貝塞爾曲線建模車道線,網絡學習貝塞爾曲線上的控制點,顯著改善了這一問題。

3.4 2D車道線轉3D車道線(IPM投影過程)

由於實際使用時最終需要3D車道線,所以2D車道線檢測的結果還需要進一步利用IPM投影得到3D車道線。因此本文還對IPM的過程進行了回顧,以幫助讀者理解其過程,以及IPM帶來的缺陷和為什麼3D車道線檢測任務被提出。這裏只展示一下IPM導致的錯誤結果可視化(圖5,以上坡為例),具體的推導步驟讀者可參考本文原文。

4、3D車道線檢測方法4.1 分類框架

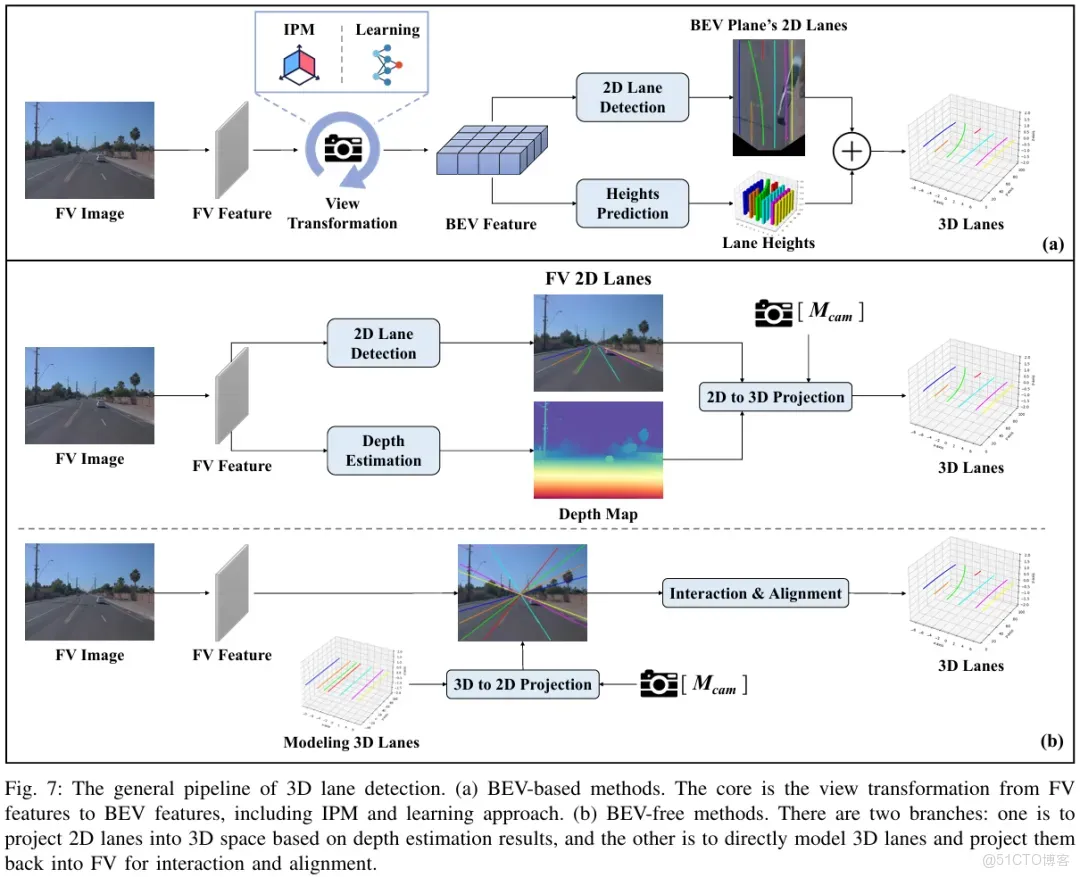

作為2D車道線檢測的升級,3D車道線檢測更加關注:如何用網絡從FV圖像中重建缺失的3D信息。如圖7所示,現有的3D車道線檢測方法可以分為兩大類:

(a)基於BEV的方法:利用相機參數,以某種方式將FV特徵轉換為含有高度信息的BEV特徵。這個構建中間代理,即BEV轉換的過程通常稱為View Transformation。通過這種方式,3D車道線檢測任務可以簡化為在BEV上的2D車道線檢測和高度估計。因此,這類方法的性能不僅取決於BEV中的2D車道線檢測結果,還取決於View Transformation的實現方式。

(b)無BEV方法:不依賴BEV特徵,可以進一步分為兩類。一種是結合深度估計值將2D車道線檢測結果投影至3D空間中;另一種是直接建模3D車道線,有了初始化的3D信息,就可以根據相機參數將其投影到FV上,讓3D車道線與FV特徵之間進行交互,並更新3D車道線。

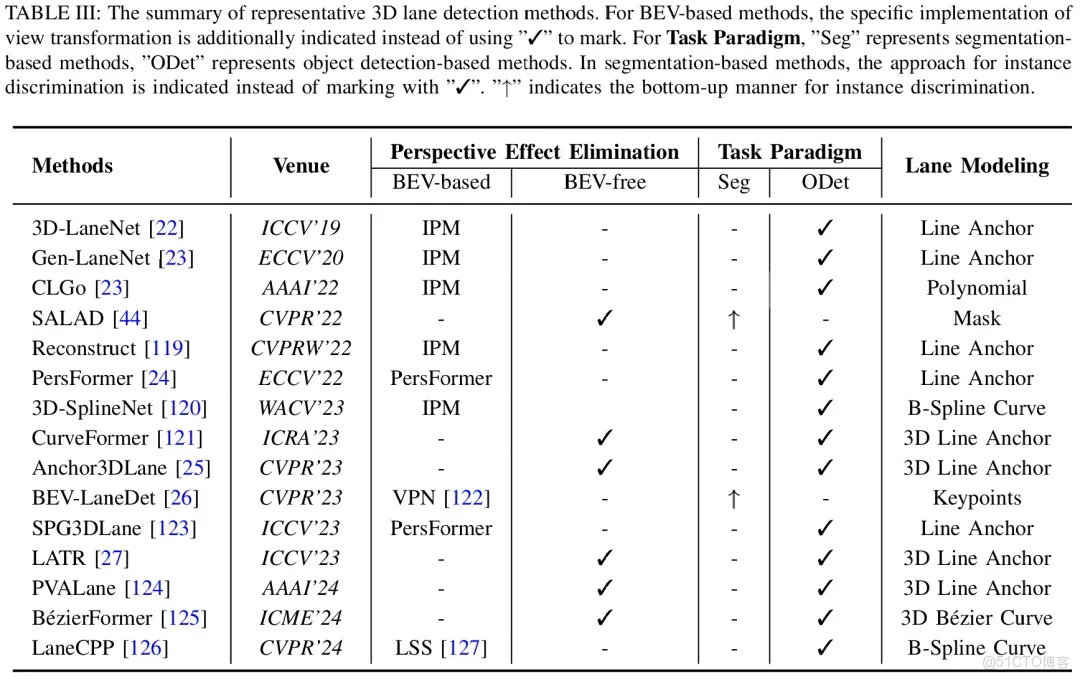

對於每種方法,實例級判別和車道線建模仍然有討論。表3中列出了代表性工作的比較。

4.2 基於BEV的方法4.2.1 IPM用於View Transformation

3D-LaneNet既是3D車道線檢測任務的提出者,也是3D車道線檢測中基於BEV的方法的首個工作。隨後Gen-LaneNet、3D-LaneNet+、CLGo等工作進一步進行改進,但是這些早期的3D車道線檢測方法對於BEV的轉換都是基於IPM實現的,相當於是把IPM從2D車道線檢測結果階段提前到了特徵階段。

4.2.2 可學習的View Transformation

因此,後續的工作為了避免IPM帶來的固有誤差,嘗試以更靈活的方式完成BEV轉換,即可學習的View Transformation。這一思想其實早在一些3D目標檢測的工作中就有體現了,比如LSS、BEVDet、BEVFormer等。對於車道線檢測來説,PersFormer算是首個以可學習的方式實現View Transformation的工作,之後也引出了不少優秀工作,比如BEV-LaneDet、SPG3DLane、LaneCPP等。

4.3 無BEV方法

4.3.1 結合深度估計

和早期的一些深度輔助的單目3D目標檢測方法類似,SALAD將3D車道線檢測分解為FV上的2D車道線檢測和深度估計任務,有了準確的深度值即可將2D車道線精準投影至3D空間。

4.3.2 直接建模3D車道線

這一思想也是類似於一些3D目標檢測中的Sparse BEV方法例如DETR3D和PETR(將3D參考點或3D位置embedding投影回FV進行交互)。典型的方法當屬CurveFormer、Anchor3DLane、LATR等,都是Persformer之後的同時期工作。儘管在交互細節上可能有所不同(比如Anchor3DLane在投影回FV後用類似LaneATT的方式做pooling,CurveFormer和LATR則是用query和FV做cross attention),但是它們的核心思想都遵循:建模3D車道線並正向投影回FV進行交互對齊。

注:1、關於“3D Line Anchor”的表述:雖然在CurveFormer和LATR原文裏沒有像Anchor3DLane和PVALane中明確的“3D Anchor”的表述,但是這些方法的本質都是遵循目標檢測的範式,並學習3D參考線上等距點的X方向和Z方向的偏移量。因此本文將它們的建模方式都歸為“3D Line Anchor”;2、儘管PVALane構建了BEV特徵,但僅用於輔助增強3D車道線檢測效果,而不是像基於BEV的方法那樣成為網絡的必要組成部分。

5、方法性能對比

5.1 主流Benchmark下的結果比較

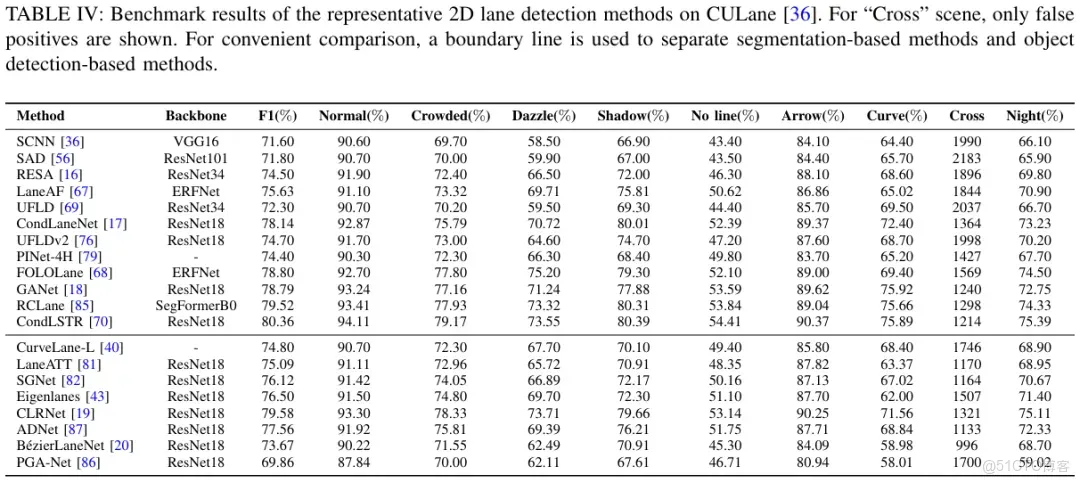

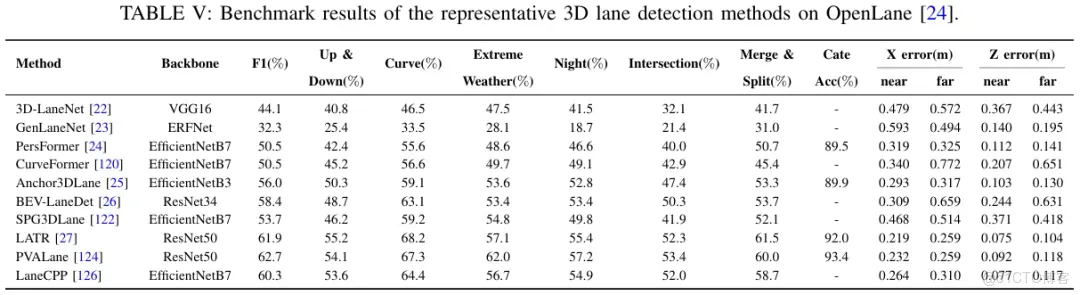

CULane和OpenLane是目前最常用的2D和3D車道線檢測數據集。表4和表5分別報告了這兩個benchmark下代表性方法的性能。所有結果均來自原文數據。更多數據集下的結果在附錄。

5.2 主流Benchmark下的結果比較

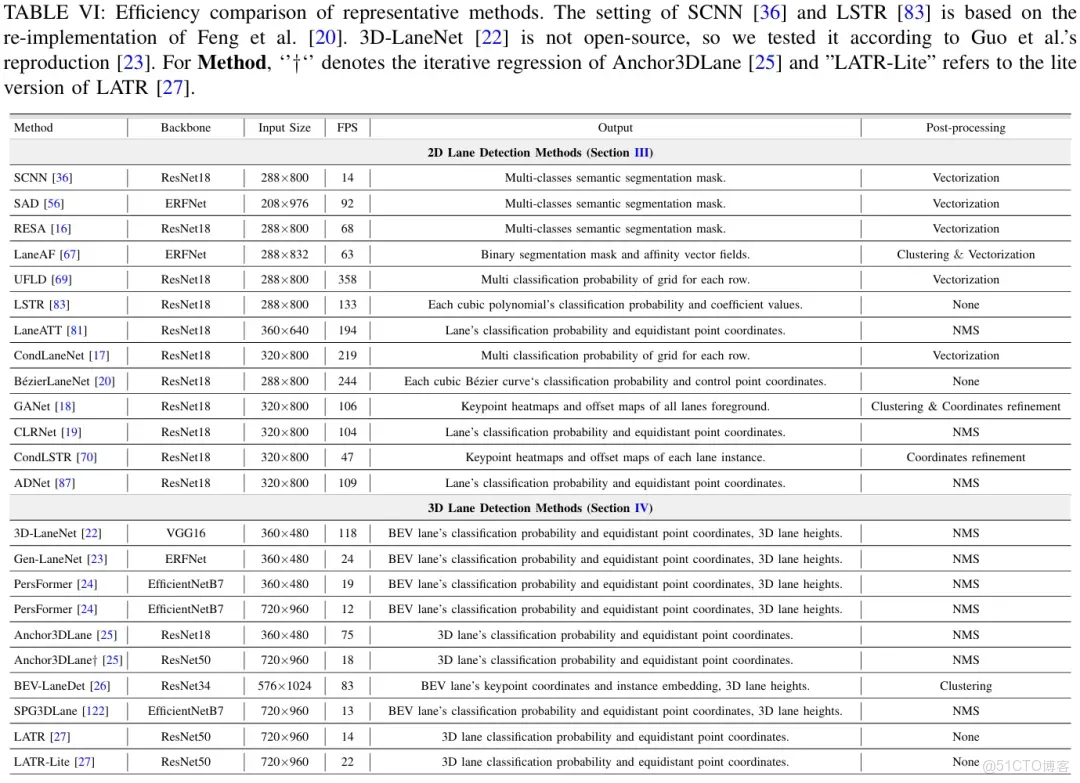

考慮到現有方法中實驗所用設備的差異性,直接用各方法原論文中報告的速度來進行比較是不公平的。因此,筆者在統一環境中重新測試了代表性方法。表6展示了這些方法的工作效率。根據代表性且開源的方法在CULane或OpenLane數據集上的設置,筆者對其進行了重新評估。為確保公平性,僅測試了模型的推理速度以報告FPS值(即不包含後處理部分,因為有的方法的後處理可能在CPU上執行)。同時,還描述了每種方法的骨幹網絡、輸入大小、模型輸出以及可能的後處理(即模型的輸出是否反映了每個唯一車道線實例的矢量化表示)。所有測試均使用單張Nvidia GeForce RTX 3090 GPU。

5.3 討論

先前的章節中從任務範式、車道線建模、全局上下文補充和透視效應消除四個方面概述了現有方法。結合性能和效率的比較,筆者繼續討論它們對車道線檢測的重要性。

1、任務範式。基於分割的方法通過兩階段方法實現實例級判別和車道線定位,算法運行時間的大部分被獨立的實例判別過程所佔據,這使得它們總體上不如一階段實現的目標檢測方法高效。而對於基於目標檢測的方法,有必要考慮網絡訓練過程中的正負樣本匹配策略,這將決定後處理是否需要NMS。

2、車道線建模。在基於mask的建模方法中,每個像素都被分類,這可能導致不準確的分割mask,進而阻礙矢量化擬合。因此,實現最佳性能和效率仍然是個挑戰。相比之下,基於keypoints的建模、基於line anchor的建模和基於curve的建模方法學習的點或參數更少,且直接產生下游所需的矢量化結果。

基於keypoints的建模方法表現出強大的性能,得益於其在專注於局部方向上的高精度姿態估計技術。然而,這些算法的整體效率受到其分割範式中固有實例判別步驟的限制。

基於line anchor的建模方法利用車道線在單目圖像中的垂直和細長特性,在性能和效率之間取得了良好的平衡。然而,這些方法學習等距點的水平偏移量,因此不適用於U形或近乎水平的車道線。這一特殊情況將在後續章節進一步討論。

基於curve的建模方法表現出良好的效率,但在2D車道線檢測基準上的競爭性能方面有所欠缺。有趣的是,這種方法在3D車道線檢測中取得了有競爭力的表現。根據Han等人的分析,這種差異應該是由於地面高度的影響,使得在FV中難以擬合不規則的車道線。相比之下,這些車道線在BEV中看起來更平滑,因此更容易擬合。

最後,像UFLD這樣的基於grids的建模方法實現了最高的效率;然而,這是以降低計算量為代價的,導致性能次優,通常需要更高級的算子(CondLaneNet裏的Transformer encoder和動態卷積)來彌補。

3、全局上下文補充。無論屬於哪種類型,大多數方法都達成了一個共識,即補充全局信息可以顯著提高車道線檢測性能,特別是對於檢測那些不明顯的車道線。此外,確保這些專門設計的結構在高效處理和有效結果之間取得平衡至關重要。雖然這一方面在現有的3D車道線檢測benchmark和方法中很少被關注(主要還是因為3D車道線檢測更關注在網絡中消除透視效應),但在實際應用中,2D車道線檢測中的某些解決方案可以作為參考或者直接無縫集成到三維車道線檢測框架中。

4、透視效應消除。最終目標仍然是實現精確的3D車道線檢測,以支持下游應用。使用IPM將二維車道線檢測結果投影到三維空間中是可行的。然而,由於假設地面平坦,即使在FV中預測準確,BEV中也往往會出現錯誤結果。雖然基於深度值將2D車道線檢測結果投影到三維空間的方法很直接,但這種方法嚴重依賴於深度估計結果,無法進行端到端的優化。

早期的3D車道線檢測方法仍然假設地面是平坦的,利用IPM來構建BEV特徵。後來一些方法通過融入可學習的方式對此進行了改進,從而提高了性能。另一批方法則完全避免了BEV特徵的構建,直接對3D車道線進行建模,並利用3D到2D的正向投影來規避IPM引入的固有誤差。應該指出的是,Transformer在BEV轉換(PersFormer)或實現3D車道線與前視圖特徵之間的交互(LATR)上具有強大的能力,這一點在相關的3D目標檢測工作(BEVFormer,PETR)也有所體現。然而,deformable attention等高級算子的硬件部署仍然是一個需要優化的問題。

6、車道線檢測的擴展工作

其實正常到第5章後關於對車道線檢測方法的總結部分就結束了。但是筆者在接觸到一些其他和車道線檢測高度相關的領域後,覺得還是有必要提及一下。這些工作在任務流程上可以視作單目圖像車道線檢測的升級:

1、多任務感知:一個模型同時完成目標檢測和車道線檢測等任務;

2、視頻車道線檢測:多幀圖像的時序關聯;

3、在線高精地圖構建:檢測環視圖下的地圖元素,包括車道線、人行橫道、車道邊界線等各種靜態目標;

4、車道線拓撲推理:同樣是環視圖場景,檢測中心線,預測中心線之間的拓撲以及紅綠燈和中心線之間的拓撲關係,從而實現場景理解。

並且在近年來也很火熱,因此筆者在本章對它們進行了介紹,並給出一份關於車道線檢測研究熱點的發展路線圖(圖8)。可以觀察到,從檢測2D車道線到檢測3D車道線,再到檢測地圖元素,再到檢測中心線和拓撲關係預測,模型的輸出越來越靠近下游應用。

6.1 多任務感知

早期的一些工作主要集中在BDD100K數據集上的三個任務:目標檢測、可行使區域分割和車道線檢測。其代表性方法例如YOLOP、YOLOPv2等,它們採用強力Encoder結構提特徵然後銜接多個任務頭,實現了強大的性能。不過需要指出的是BDD100K數據集裏的車道線沒有實例級標註,註釋都是語義分割mask,所以這些方法的車道線檢測頭也都是用語義分割的方式來做的。最近的研究慢慢上升到3D多任務感知上,比如PETRv2設計三種query,用三個任務頭完成3D目標檢測、BEV分割和3D車道線檢測,還有RFTR設計一種統一向量場表示從而將3D目標檢測和3D車道線檢測集成到一個單頭模型裏。

6.2 視頻車道線檢測

對於2D的視頻車道線檢測,早期的一些工作用經典RNN網絡(LSTM、GRU)實現多幀特徵融合。後來21年ICCV新出了VIL-100數據集,每個視頻的幀率下采樣至10s,因此更適合視頻車道線檢測。其相應的baseline方法設計兩種attention模塊來關聯多幀的特徵。後續也有RVLD、OMR等創新工作。在3D車道線檢測方面,STLane3D算是第一篇利用時序信息的工作,利用attention關聯多幀的BEV特徵。相比之下,Anchor3DLane-T和CurveFormer++在3D Line Anchor的特徵上做attention來補充時序信息。

6.3 在線高精地圖構建

即現在業內大火的無圖NOA。基本流程是通過環視圖構建BEV特徵,然後解碼器預測地圖元素。因此其關鍵和車道線檢測類似,需要考慮如何統一地建模各種地圖元素。需要指出的就是當傳感器從單目相機增加到多相機時,在BEV平面上會出現很多U型或水平線,那這時候車道線檢測裏常用的學習等距點偏移量的line anchor modeling方法就不適用了。該任務最先由HDMapNet提出,其採用自底向上的分割方法預測所有地圖元素的mask,並結合instance embedding聚類得到地圖元素實例。但這種方法仍然需要矢量化後處理以供下游使用,因此後續的工作試圖直接完成端到端矢量化建圖。在後續的一眾方法裏,MapTR可謂是最具代表性的工作,其用均勻點來統一建模地圖元素,所有地圖元素都被表示為具有相同點數和不同排列順序的集合。得益於其統一的置換等價建模方式和層級化query的設計,MapTR在nuScenes上僅靠相機輸入就實現了當時的SOTA,為後續的研究提供了強有力的baseline。後續的大部分工作基本都是針對MapTR進行了改進,比如PivotNet、HIMap、StreamMapNet、MapTracker等,也有一些工作引入地圖先驗來加強局部建圖能力。這一領域內的優秀工作還有很多,由於這一章是對車道線檢測擴展工作的簡單介紹,所以筆者沒有列出所有的方法(僅ECCV 2024的在線建圖論文貌似就高達7篇),更多方法的論文和代碼可以在筆者構建的GitHub倉庫裏找到。

6.4 車道線拓撲推理

早期的工作主要集中在線和線之間的拓撲關係上,即檢測車道中心線來構建一幅車道圖(lane graph)。開創性工作當屬STSU,之後也衍生了如CenterLineDet、LaneGAP等創新工作。後來OpenLane-V2數據集誕生,除了包含中心線檢測以外,還引入了線和交通標誌之間的拓撲關係,代表性方法例如TopoNet和TopoMLP。TopoNet也是當時的拓撲挑戰賽的冠軍。後來LaneSegNet又把車道線和中心線的關係連接起來,進一步加強了場景理解。

7、未來方向

對於未來方向,討論的範圍包括:領域內仍然有待改進的問題,尚未充分探索的子領域,以及在本領域之外具有重大研究價值的相關任務。

1、高效統一的建模方式。就目前而言,在不影響效率的條件下有效地建模任意形狀的車道線仍然是一個挑戰。特別是當場景從單目相機前視圖擴展到多相機環視圖時,會存在大量U形或近乎水平的車道線。在這種情況下,嚴重依賴先驗知識的建模方法,如基於grids的逐行分類建模,或是學習等距點偏移量的基於line anchor的建模方式都不適用。這種情況下往往表現不佳的基於mask的建模方式實際上更有效。像MapTR的均勻點建模方式就不會出現這種歧義性,不過這些建圖方案在實車應用的時候還需要對速度進行優化。再有就是CVPR 2024的Lane2Seq通過序列生成來統一2D車道線檢測也是一個不錯的思路,儘管其效率需要進一步改進(Lane2Seq以自迴歸的方式輸出車道線的點集,當車道線數量增多時推理速度就會顯著下降,這可能也是為什麼其沒有在CurveLanes這種多車道線場景的數據集做實驗的原因)。

2、多模態車道線檢測。其實近年來純LiDAR的車道線檢測Benchmark和方案也有,最典型的比如CVPR 2022的K-Lane。儘管LiDAR可以直接提供3D信息,但其較短的感知範圍和較高的成本使得基於相機的方法更普遍。不過後續的技術路線肯定是多模態融合,這一點已經在很多通用3D感知工作中得到印證了,但對於車道線檢測來説目前這類方法還很稀少,代表性的如-3DLaneNet、DV-3DLane,都是LATR團隊的工作。

3、標籤高效的車道線檢測。即弱監督策略和無監督策略,同樣目前相關工作較少。

4、對於端到端自動駕駛。在端到端框架中,車道線檢測往往不再輸出顯式的車道線座標,而是作為提供中間表示的模塊。後續的研究或許可以將特定的車道線檢測輸出(如中心線、車道線寬度、曲率等)作為先驗知識整合進端到端框架裏來提高性能。

5、針對車道線檢測的視覺推理。大語言模型(LLM)和視覺語言模型(VLM)目前也已經被廣泛用於自動駕駛領域,相關工作有很多。值得注意的是今年CVPR的一個新數據集MapLM,是專門針對地圖和交通場景裏的車道線等靜態目標開發的benchmark,利用大模型來更好地理解交通場景,未來在這方面的研究應該會更多。

6、路側車道線檢測。V2X也是目前比較火熱的一個方向,其相應的路側3D目標檢測任務和相關方法也得到了廣泛關注。但是目前還沒有針對路側場景車道線標註的相關數據集和方法。如果能誕生相應benchmark和baseline,路側車道線檢測可以有效地幫助監控車輛非法變道等行為,在安防領域具有巨大的潛力。

8、總結

本文全面回顧了基於深度學習的單目車道線檢測的最新進展,涵蓋了先進的2D和3D車道線檢測方法。通過理論分析和實驗評估,確定了車道線檢測算法的四個核心設計:(1)所遵循的任務範式;(2)車道線的建模方式;(3)全局上下文補充;(4)相機透視效應的消除。從這些角度,本文對現有方法進行了全面概述。此外,本文還回顧了單目車道線檢測的擴展工作,旨在為讀者提供對車道線檢測發展的更全面理解。最後指出了車道線檢測的未來研究方向。

本文的成文離不開筆者的指導老師們的傾心幫助,首先在此對他們表達誠摯的感謝。

然後,筆者在剛入門車道線檢測時走過不少彎路,後來通過閲讀大量文獻、搜索各種知..乎經驗貼、觀看相關工作的講解視頻以及參加的車道線檢測課程和高精地圖論文帶讀課程,才對該領域有了全面的認知。這一路的成長離不開領域內眾多同行前輩們的優秀工作,也許你們並不認識我,但我此前從諸位的知..乎貼或論文講解視頻中屬實受益匪淺,在此表示感謝。

以下致謝作者排名不分先後順序。

- RESA(2D車道線檢測,AAAI 2021):Hao Fang

- BézierLaneNet(2D車道線檢測,CVPR 2022):Zhengyang Feng\

- PersFormer(3D車道線檢測,ECCV 2022):Li Chen,Chonghao Sima

- Anchor3DLane(3D車道線檢測,CVPR 2023):Shaofei Huang

- BEV-LaneDet(3D車道線檢測,CVPR 2023):Ruihao Wang

- MapTR,MapTRv2(在線高精地圖構建,ICLR 2023,IJCV 2024)& LaneGAP(道路拓撲,ECCV 2024):Bencheng Liao

- BeMapNet,PivotNet(在線高精地圖構建,CVPR 2023,ICCV 2023):Wenjie Ding

- LaneSegNet(道路拓撲,ICLR 2024):Tianyu Li

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#xxx

...

#工程師變身AI“指揮者”,吉.利與阿.裏.雲的軟件開發變革實驗

1975年,IBM工程師Fred Brooks在《人月神話》中提出軟件工程的核心難題:隨着系統規模和團隊規模增長,複雜度會呈指數級上升。他的結論是,軟件工程“沒有銀彈”,沒有單一技術能帶來數量級的生產力提升。

50年後,汽車行業正在經歷軟件工程史上最大規模的挑戰之一。

吉利汽車數智中心AI產品專家阮航透露了一組數字:過去幾年,吉利內部軟件開發人員佔比從不到10%躍升至40%。當一輛智能汽車的代碼量突破億行,當座艙、智駕、底盤等異構系統需要在不同芯片上協同工作,Brooks描述的複雜度問題被放大了數百倍。

不過這一次,車企找到了不同的應對方式。自2025年上半年開始,短短几個月時間,吉利汽車已有數千人研發使用通義靈碼,AI生成佔比超過30%,尤其在通用代碼邏輯開發、代碼檢查測試環節,代碼開發效率提升20%。

與阿里雲通義靈碼的深度合作,正在探索一個可能:AI會是Brooks説的那個“銀彈”嗎?

“軟件”汽車

人員結構的劇變,映射的是汽車產業本質的轉變。

“過去汽車是硬件主導,軟件只是輔助。現在軟件決定了產品的核心體驗。”阮航説。這種轉變帶來的,是開發模式和產品複雜度的“Double Kill”。

首先是迭代速度的加快。傳統面向硬件的V模型開發週期以年計,如今要支撐月級甚至周級的OTA迭代,必須轉向“敏捷+DevOps”模式。與此同時,產品複雜性也在同步增長。汽車行業正經歷電子電氣架構從分佈式ECU向中央計算和區域架構的演進,面向服務架構(SOA)的引入,讓系統集成的複雜度呈指數級增長。

以吉利為例,研發體系需要同時應對座艙域的Linux/Android、智駕域的QNX,以及車身控制域廣泛採用的AUTOSAR平台。應用層多用Java/Python,底層則依賴C/C++。如何讓這些異構系統在不同芯片生態上高效、安全地協同工作,是極其複雜的系統工程。

更具挑戰性的是守住安全底線。汽車軟件開發必須遵從ISO 26262功能安全、ISO/SAE 21434信息安全,以及ASPICE等極其嚴格的國際認證標準。特別是在底層開發中,還需要遵循MISRA C/C++等嚴苛的編碼規範。這些標準確保了汽車的極致安全,但也天然地與快速迭代的敏捷開發模式存在張力。

看清了系統性挑戰的本質後,吉利明確了以AI技術提升研發效率的路線,與阿里雲通義靈碼的深度合作隨即展開。一系列採訪之後,我們得到了一個工程師變身“指揮官”的故事。

全方位AI

談AI落地,首先要談場景。所以,我們先呈現一個完整的場景概括,吉利的研發體系涵蓋應用層軟件研發、嵌入式開發和算法研發三大板塊。一言以蔽之:目前通義靈碼等AI手段正在全面滲透。

其中,應用層軟件研發團隊對通義靈碼的應用最為深入,覆蓋了智能座艙HMI、車聯網服務等場景的快速開發。工程師們頻繁使用通義靈碼來生成新服務的模板代碼和數據轉換邏輯。

嵌入式開發是汽車軟件的“深水區”,以C/C++為主,對實時性、內存管理要求極高。在這一板塊,吉利正探索將AI能力引入底層開發場景,重點在於提升代碼質量和合規性。

算法研發領域,通義靈碼正在協助團隊處理PB級的雷達點雲數據和視頻數據清洗工作。工程師可以通過自然語言描述數據清洗規則,AI自動生成對應的複雜數據處理腳本。

對於最受關注的提效指標,阮航給我們講了一個項目案例。一個原本30天的項目,通過通義靈碼加成,原本耗時10天的“編碼實現”環節,編寫代碼從5人天縮減為4人天,註釋補全從1.5人天縮減為0.5人天,單元測試從2.5人天縮減為2人天,代碼優化從1人天縮減為0.5人天。編碼階段效率提升30%,帶動項目整體提效10%。考慮到吉利汽車是一個相當龐大的組織,眾多項目累加可得的收益是相當可觀的。

每個深度使用AI的工作者講到大模型的痛點,一定會談的必然包括“幻覺”。其實用幻覺描述也不一定準確,講“模型對不瞭解的事情容易胡説八道”更能讓人感同身受。

所以,規模化應用也很快引出了另一個關鍵問題:通用大模型需要精準理解吉利的技術棧和業務邏輯。如果AI生成的代碼不符合企業規範或者無法調用內部API,它的價值將大打折扣。“我們需要AI能理解吉利的業務上下文,而不僅僅是通用代碼。”阮航説。

不過阿里雲和吉利汽車各自的能力組合,很大程度躍過了這個山脈。

阿里雲通義靈碼解決方案專家賈彬介紹了通義靈碼的特點:它本質上是一個高級的編碼智能體(Coding Agent),結合 RAG(檢索增強生成)和MCP(模型上下文協議)等技術,能夠深度融合企業的私有知識庫。

吉利的工作,則是構建一個高質量的,包含了私有代碼庫、API文檔和技術規範的“專有知識庫”提供給大模型。這樣就能構建起一個高度精準的上下文環境,能更好利用大模型的推理能力解決研發問題。

這種配合機制,確保了AI不僅“會寫代碼”,還“會寫吉利的代碼”。例如,當工程師需要調用吉利內部的車控服務API時,通義靈碼能夠準確提示API的調用方式和參數規範,並遵循統一的錯誤處理機制。

當然,為了適應吉利複雜的開發環境和極高的安全要求,通義靈碼支持企業專屬版部署,確保核心代碼資產不出企業內網。雙方通過VPC專線等方式實現了網絡隔離與安全接入。

不只是提效

所以,大規模的人數使用,讓AI工具的價值在不同維度顯現出來。

最直觀的是效率提升。大量模板化、重複性工作被交給AI,工程師可以聚焦於系統架構設計和核心業務邏輯的創新。質量維度的改善同樣明顯,通過與CI/CD流水線等研發工具鏈的集成,通義靈碼可以在編碼階段就進行邏輯預檢,提升代碼的規範性和健壯性。

但效率和質量的提升,還不是AI工具的所有價值。

軟件工程領域有一個著名概念叫“技術債”——因過去妥協而積累的、需要未來償還的維護成本。對於汽車這樣長生命週期的產品,龐大的遺留系統就是最主要的“債務”來源。維護和迭代這些遺留代碼的挑戰尤為嚴峻,很多代碼之所以存在,可能是為了繞過特定的硬件約束,或者是為了處理某些複雜的工況。

如果不理解其原始的設計意圖就盲目修改,極有可能引入安全隱患。所以開發者之間常半開玩笑地説:“能跑就別動,動了就出事。”

知識傳遞需要藉助於人,但人會流動,這使得“償還技術債”變得更加困難,形成了所謂的“代碼考古”困境。

“但這對AI不是問題,因為它能快速讀取代碼,能幫你解釋遺留系統的複雜邏輯,看懂他人的開發邏輯。”賈彬説。

阮航分享了一個實例:一位新入職的工程師需要修改一個有着數年曆史的核心模塊,通過通義靈碼的代碼解釋功能,他得以快速理解原作者的設計意圖和複雜的依賴關係,將原本預估需要一週的熟悉過程縮短到了兩天。AI在這裏扮演了“知識管家”,甚至“任意門”的角色,讓經驗得以沉澱和複用,讓沉寂中的代碼得以換一種方式新生。

這種傳送能力,在吉利的全球化協同中體現得更為明顯。作為一家在瑞典、德國、意大利等地均設有研發中心的全球化企業,吉利通過推進統一代碼倉、統一研發工具、統一協同平台來解決跨地域協同的問題。AI在其中扮演了越來越不可或缺的作用,促進了全球團隊在統一的AI輔助環境下工作,客觀上推動了編碼規範和研發流程的標準化。

依託阿里雲的全球基礎設施,通義靈碼支持吉利在多個研發中心實現“多地部署、就近接入”,確保全球開發者都能獲得低延遲體驗,同時滿足各地的數據合規要求。

AI的介入,也在改變人的角色。

我們就用開始提過的一個質量保障為例具體展開。傳統的代碼評審是在提交後進行,由技術負責人手動審核。這種模式的問題在於:問題被發現時,代碼已經寫完,修復成本高,還可能影響進度。阮航介紹,吉利正在推動質量“左移”(Shift Left),在開發的早期階段就發現並修復問題。

具體做法是:工程師在提交代碼合併請求時,系統會自動觸發調用通義靈碼的API,讓AI代替技術負責人完成初步的、高頻的審核工作。例如檢查變量命名是否規範、是否有充分的異常處理、是否符合既定的安全編碼要求等。

這一轉變使得資深工程師的角色發生了變化,他們從“執行者”轉變為“規則制定者”,負責定義審核的標準,再交由AI去高效執行。而他們自己則可以聚焦於更復雜的系統架構和業務邏輯審核。

執行者到指揮官

所以,AI對於開發場景的影響是全方位的,AI對“人與代碼”、“人與人”、“人與組織”的關係的影響也是全方位的。

這甚至涉及了一個業內廣泛關注的討論:“AI是否會進一步取代人類程序員?”阮航在採訪中分享了他的洞察。他認為,未來職業生涯受到挑戰的,其實是不使用AI的工程師。

“在我們內部,一直在推的一個思維就是:以後我們所有的員工都是Leader。我們要Lead誰?就是AI。我們要指揮AI,把原先我們自己在做的工作做得越來越好。”

從“一線執行者”到“AI指揮官”,人與AI顯然並非取代關係。但這意味着工程師的核心能力要求正在從“實現能力”轉向“定義問題、拆解任務和評估結果”的能力。在這個模式下,工程師更多是從設計、架構、驗收的視角去定義需求,真正的執行和操作交給AI。

“當前工程師和AI可能各佔一半,”阮航説,“但未來,我們希望工程師主導規則制定,AI承擔更多執行工作。”

吉利的終極願景是實現“黑燈研究院”:一個高度自動化的研發環境,從需求提出到部署交付的全流程,由AI與人類工程師協同完成。“當前我們已經搭建起智能化軟件平台,實現了從需求到交付鏈路的點狀能力閉環,”阮航説,“接下來希望將點狀能力連接成線狀能力,即實現從需求分析、代碼生成到測試部署的自動化工作流,最終實現端到端的自動化交付。”

賈彬觀察到:AI正在向“自主智能體”演進。隨着模型在長期記憶、規劃與決策上的能力提升,未來的智能體將能夠承擔長時程任務,自動進行復雜的任務分解、資源調度與工作流編排。與此同時,異步編程與雲端Agent的興起允許將子任務委派到雲端並行執行,工程師負責高層目標與策略制定,可以同時指揮多個Agent,實現更高的並行性與可擴展性,同時通過人類監督與回滾機制保證可控性與安全性。

但是指揮官這個新一代人類程序員的定位,顯然也讓產業出現了“一將難求”的問題。

阮航在雲棲大會的公開發言中就提出了一個呼籲:要共建AI編程的安全標準,共享軟件研發的優質實踐,共育新型人才。

這背後是對行業共同挑戰的洞察。對汽車行業來説,既懂機械硬件又精通軟件系統工程的交叉人才,是當前最急迫的需求。這個人才缺口不是個別企業能解決的。

不過,跨界對AI來説,從來都不是問題。或許,在AI降低了軟件開發的技術門檻後,更多機械背景的工程師也能參與到軟件開發中來。

吉利與阿里雲的合作,正在驗證這種可能性。當車企開始用軟件的方式思考問題,當雲廠商深入到製造業的具體場景,產業邊界的模糊或許正是創新發生的地方。

50年前,Brooks説軟件工程沒有銀彈。今天,AI或許不是那顆銀彈,但它正在改變我們尋找答案的方式。

...

#熬過「真空期」的小.馬.智.行,已經迎來了勢不可擋的正循環

2025年11月6日,在登陸納斯達克剛好一年後,小.馬.智.行正式在香港聯合交易所主板掛牌上市,股票代碼2026。

本次港股IPO中,公司已悉數行使發售量調整權,共計發行約4825萬股,最終發售價每股139港元。若承銷商的超額配售權悉數行使(即綠鞋後),集資額可達77億港元,成為2025年全球自動駕駛行業規模最大IPO,同時是2025年港股AI領域募資額最高的新股。

本次IPO已引入包括Eastspring在內的多家國際頂級投資機構作為基石投資者,基石認購總額達到1.2億美元,同時將獲多家戰略投資方參與錨定認購,其中Uber出資認購1億美元。

回顧小.馬.智.行走過的軌跡可以發現,在其跨過了自動駕駛的「真空期」後,已經迎來了勢不可擋的正向循環。

越過「資金真空期」

從寒冬中挺出新枝

“如果説一家公司要做到100分才能實現無人化,那麼從50分走到99分是個漫長的過程,我把它叫做「真空期」。這三五年的時間,很多人會撐不過去。”在今年6月的一場訪談中,小.馬.智.行聯合創始人、CTO樓天城如此説道。

2021年,國內自動駕駛行業如日中天,融資達144起,總額932億元;可到了2022年,融資事件驟降至92起,規模收縮至240億元,較上年減少74%,2023年的總金額則進一步降至200億元。

在這種背景下,小.馬.智.行在此期間仍然有兩輪融資。其中在最為蕭條的2022年,該公司的D輪融資仍達到2.9億美元。

"技術實力是我們得到投資者支持的關鍵因素。過去兩年中,我們的核心技術指標大幅提升,‘虛擬司機’在大多數場景中可以媲美甚至超越人類司機。"在D+輪融資後,樓天城曾説道。

與此同時,小.馬.智.行通過Robotaxi、Robotruck,技術授權與應用共是三大業務板塊推進商業落地分散風險。2024年上半年,其自動駕駛出行服務(Robotaxi)收入同比增長86%,技術授權與應用服務收入也顯著增長——營收2472萬美元,同比翻番。

同年11月,小.馬.智.行以股票代碼「PONY」在納斯達克掛牌上市,並通過IPO公開發行和同步私募,共籌集約4.52億美元,創下當年美股自動駕駛領域最大規模的IPO。加之IPO前獲得的7輪融資,公司總體融資規模近18億美元。

值得關注的是,自美股上市以來,小.馬.智.行在公開市場吸引了包括柏基投資、公爵資本、方舟投資、威靈頓資產管理、富達投資在內的多家知名機構積極買入,商業化進程的節奏加速讓長線投資者看到更清晰的盈利前景。

2025年5月,小.馬.智.行董事會主席、聯合創始人、CEO彭軍,以及樓天城,宣佈自願延長股份鎖定期至540天。這不僅是向投資者傳遞管理層對公司長期價值的信心,增強投資者持股穩定性,也能夠對抗市場不確定性。

隨後,在2025年第二季度財報發佈後,其股價表現強勁。10月16日,其開盤價報21.39美元,較8月12日的15.05美元上漲超42.13%。

如今,在港股上市後,則進一步拓寬了小.馬.智.行的投資者基礎,提升了股份流動性。雙IPO的資本佈局,無疑會為該公司提供強大的資金支持。

根據小.馬智.行的規劃,未來五年內,所得款項淨額的約50%用於推行市場進入戰略,在我們的主要觸及市場推進L4自動駕駛技術的大規模商業化,包括業務開發、生產、銷售與營銷、客户服務以及與行業參與者的合作;約40%用於L4自動駕駛技術及解決方案的開發;約10%用於營運資金需求及其他一般公司用途。

越過「技術真空期」

從模仿人到超越人

Robotaxi要做到無人化,對技術要求非常非常高。就是人不能犯的錯,它基本都不能犯。

樓天城在今年曾表示,自動駕駛從五年前開始,已經進入到一個前人沒走過的狀態,「模仿複製」已經不再有效,而是必須要開拓新方法,建立高效驗證體系,給系統自主迭代的空間,讓它在虛擬環境裏不斷自我驗證、優化。

他認為,如今的Robotaxi的決策和軌跡,開始變得不易被人理解,這説明它已經不再只是「模仿人」,而是在「超越人」。

2025年4月,小.馬.智.行公佈了讓Robotaxi「超越人」的背後邏輯:基於強化學習範式的世界模型(PonyWorld),該公司打造適用於各類車型及應用場景的虛擬司機(Virtual Driver),已經實現50萬小時全場景、全天候、全無人駕駛運營,安全性表現比人類駕駛高出10倍。

小.馬.智.行自研的自動駕駛軟件棧正是「虛擬司機」的「大腦」,通過端到端模型,虛擬司機可以感知並精準理解周圍環境,預測周圍車輛、行人和其他物體的行為,如突然插隊、魯莽變道以及摩托車意外掉頭或倒車等。

而在硬件和車輛集成方面,該公司自主設計研發了車載計算單元、T-BOX(遠程信息處理單元)、PSU(電源與傳感器清潔控制器)乃至攝像頭等多項硬件模塊,實現性能和成本的雙贏。這樣的技術已成功應用到不同車型、不同場景中,從乘用車到長途貨運卡車。

基於這些技術,小.馬.智.行自主研發的第七代L4自動駕駛軟硬件系統方案也同期發佈。該系統方案不僅採用了100%車規級零部件,設計壽命長達60萬公里,還通過優化系統架構和算法,大幅降低了自動駕駛套件的BOM成本,較前代下降了70%。

更為重要的是,第七代Robotaxi實現了平台化設計,支持多車型適配,能夠靈活部署於不同品牌和型號的車輛上。

小.馬.智.行已與北汽新能源、豐田汽車、廣汽埃安三大主流車企合作,推出了三款不同的第七代Robotaxi車型,併成功在北上廣深等一線城市獲得L4級自動駕駛測試許可,開啓了全無人駕駛的商業化運營。

就在近日,第七代極.狐.阿.爾法T5及埃安霸王龍Robotaxi正式在廣州、深圳等地投入運營,用户只需打開「小.馬.智.行」App或小程序,點擊「呼叫小.馬」,就能體驗到功能和體驗全新升級的車型。

技術上的突破,不僅提升了小.馬.智.行自動駕駛車輛的安全性,更為其商業化的發展奠定了基礎。

越過「商業化真空期」

從測試到規模運營

“根據我們的預測,新一代Robotaxi將具備正的貢獻邊際,這意味着汽車的生存週期應該有一個正的原始邊際——當我們增加一輛車時,至少不會虧錢,這是我們用於大規模擴展的主要標準之一。在第七代L4自動駕駛軟硬件系統,我們應該能夠實現這一點。” 在今年參與《時代週刊》的對話訪談時,彭軍這樣説道。

時代週刊這樣介紹小.馬.智.行——於2016年在硅谷成立,最初專注於中國市場,但如今已擴展到歐洲、東亞和中東地區。該公司正從「專注於AI驅動技術」向「大規模部署」過渡。其目標是在年底前建立超過1000輛車的車隊。

回顧小.馬.智.行在2019-2022年的狀況,是商業化面臨諸多挑戰的階段:公眾對安全性的疑慮、技術迭代、合規成本極高,車隊規模小等因素,導致研發和運營成本難以被覆蓋,商業化難度大大增加。

而如今,小.馬.智.行的技術瓶頸突破後,伴隨政策的成熟,合作伙伴的增加,已經在國內四大一線城市——北京、上海、廣州、深圳開展全無人Robotaxi收費運營服務,並通過與豐田、北汽、廣汽等車企的合作,共同推進自動駕駛車輛的研發與量產。

以小.馬.智.行8月12日發佈的未經審計2025年第二季度財報舉例,當季總營收達1.54億元人民幣,同比大幅增長75.9%,環比增幅也高達53.5%。

作為核心業務的Robotaxi板塊,2025年上半年收入達325.6萬美元(約合人民幣2332萬元),同比大幅增長178.8%。

值得關注的是,乘客車費收入在2025年第一季度和第二季度分別實現約800%和超300%的同比飆升,顯示出該業務商業化進程的持續提速,揭示商業模式成立。

商業模式的成立,除了第七代Robotaxi產品的推出,也離不開小.馬.智.行的運營體系建設:該公司通過開發高度自動化的車隊管理體系,實現了對無人車隊的精細化管理。

該體系能夠實時監控車輛狀態、調度車輛運行、處理突發情況,確保了無人車隊的高效、安全運營。通過運營體系加持,小.馬.智.行可實現1:20的「人員-車輛」安全遠程運營比例。

而且,當無人車自動化停進車位,即可並行完成補能、清潔和無人車點檢作業,即利用充電靜止時間,並行完成所有運維動作,可以做到僅1人即可在1小時充電內完成20輛車的每日維護。

據小.馬.智.行副總裁、Robotaxi自動駕駛出行業務負責人張寧透露,一旦投放千輛級規模的第七代Robotaxi車型後,就可以實現單車運營盈虧平衡。

在正式加入「美+港」雙重上市企業陣營後,小.馬.智.行進一步鞏固了全球自動駕駛「頭號玩家」的姿態和地位。

隨着資金注入、技術發展、以及車輛規模的擴大,運營效率的提升,小.馬.智.行的商業化進程將也將進入正向循環模式,為行業提供可複製的商業化範式。

...

#AdaDrive

港中文中稿ICCV'25的自駕自適應快慢雙系工作統AdaDrive

將大語言模型有效融入自動駕駛系統,需要在發揮其高級推理能力與保障實時性之間取得平衡。現有方法要麼過於頻繁地激活LLMs,導致計算開銷過大;要麼採用固定調度方式,無法適應動態變化的駕駛場景。

為解決這些挑戰,香港中文大學(深圳)和中山大學等團隊的研究人員聯合提出AdaDrive——一種自適應協作快慢框架,能以最優方式決定LLM何時以及如何為決策過程提供支持。其一,關於LLM的激活時機:AdaDrive設計了一種新穎的自適應激活損失,通過對比學習機制動態判斷是否調用LLM,確保僅在複雜或關鍵場景下激活。其二,關於LLM輔助的融合方式:不同於剛性的二元激活,AdaDrive引入自適應融合策略,根據場景複雜度與預測置信度,對LLM的影響進行連續的強度調節,實現與傳統規劃器的無縫協作。

通過這些策略,AdaDrive構建了一個靈活、上下文感知的框架,在不影響實時性能的前提下最大化決策準確率。在語言引導的自動駕駛基準測試中,大量實驗表明,AdaDrive在駕駛準確率與計算效率兩方面均達到SOTA。

- 論文標題:AdaDrive: Self-Adaptive Slow-Fast System for Language-Grounded Autonomous Driving

- 論文鏈接:https://arxiv.org/abs/2511.06253

- 項目主頁:https://github.com/ReaFly/AdaDrive

一、背景回顧

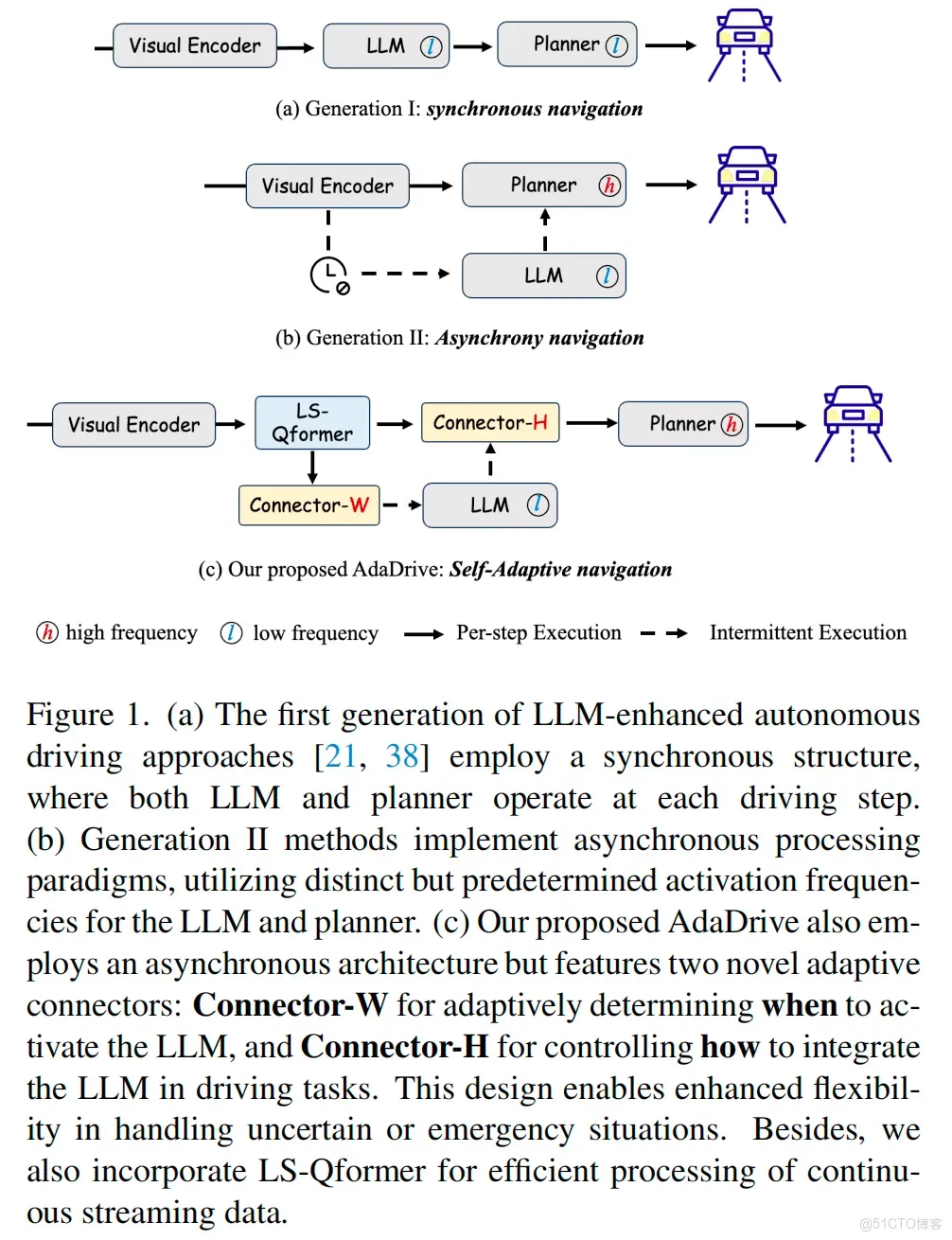

自動駕駛長期以來都是學術界和工業界的研究熱點。隨着大語言模型(LLMs)及其多模態擴展模型(MLLMs)的出現,研究人員開始將LLMs融入自動駕駛系統,以提升其認知推理與決策能力。早期方法如LMDrive和AD-H,採用同步且高度耦合的串行架構,LLM與規劃器在每個駕駛步驟中均會參與運作(見圖1)。這些模型雖提升了駕駛智能性,但引入了巨大的內存開銷與延遲,使得實時部署面臨挑戰,尤其在高速、動態的駕駛環境中。

為解決這一問題,後續研究探索了異步策略,通過預先設定的間隔激活LLM,以平衡性能與效率。然而,固定調度極大限制了模型的適應性——不同駕駛場景對LLM干預的需求差異顯著。例如,在安全關鍵場景中,LLM可能在最需要時未被激活;而在簡單場景中,激活LLM則顯得多餘,導致資源利用不佳。

基於這些侷限,一個理想的LLM增強型自動駕駛框架應具備以下能力:

1)動態決定LLM的激活時機,確保其僅在能發揮作用的場景中參與,同時避免不必要的計算開銷;

2)自適應控制LLM的影響程度——本文的核心發現是,儘管LLM的參與通常能提升性能,但相比二元開關式的全權重激活(如權重1.0),採用較低自適應權重的連續融合方式(如權重0.7)往往效果更優。

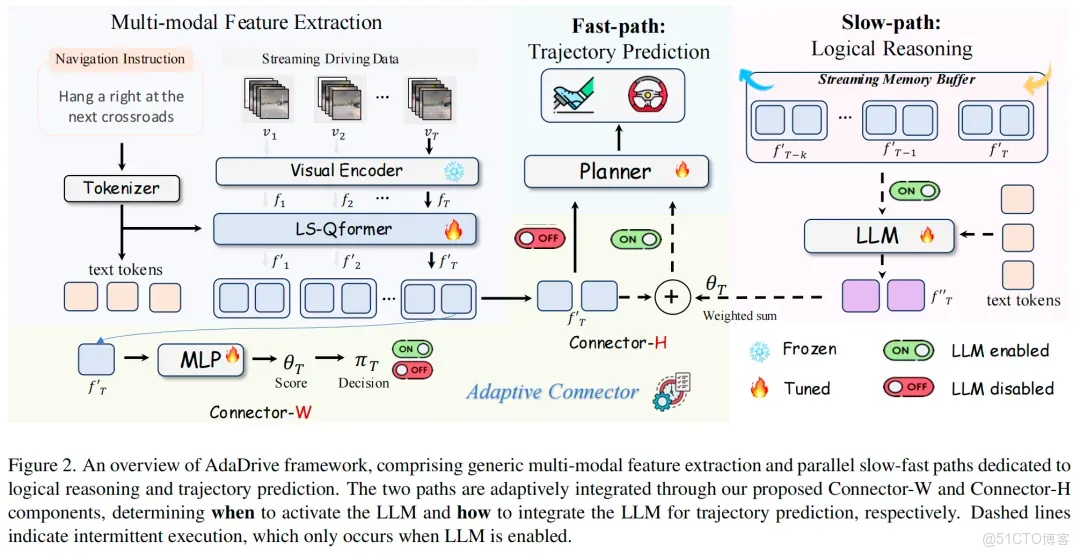

為應對這些挑戰,本文提出AdaDrive——下一代自適應LLM融合自動駕駛框架。該框架採用快慢系統範式,平衡兩類任務:一類是高頻低延遲任務(不調用LLM的輕量級規劃器,稱為快速路徑),另一類是低頻高推理任務(激活LLM作為認知智能體,稱為慢速路徑)。

本文通過兩項關鍵創新對該快慢框架進行優化,實現決策準確率與計算效率的最優平衡:1)自適應LLM激活:不再依賴固定激活間隔,AdaDrive通過新穎的自適應激活損失,動態學習LLM的激活時機。在訓練過程中,通過對比LLM輔助與無LLM輔助的預測結果,模型能自動識別高風險或複雜場景,實現真正的按需激活;2)動態LLM貢獻度調節:不同於以往將LLM激活視為二元決策的方法,AdaDrive引入置信度驅動的融合策略,動態調整LLM的參與權重。核心洞察是,儘管LLM輔助通常能提升性能,但全有或全無的二元激活並非最優——對LLM貢獻度進行自適應調節,往往比極端化的方式效果更好。

為此,AdaDrive根據LLM輸出的置信度與場景複雜度,調節其影響強度,確保其貢獻與傳統規劃模塊達到最優平衡。

此外,本文提出Long-Short Q-former,通過融合短期精準特徵與長期上下文信息增強視覺建模能力,確保流式自動駕駛場景下軌跡預測的一致性。同時,引入傳播式記憶融合(PMF)機制,將被淘汰的幀特徵合併到相鄰幀中,在保持緊湊表示的同時保留關鍵歷史上下文,進一步優化內存效率。實驗結果表明,AdaDrive在語言引導的自動駕駛領域達到了新的SOTA。

本文的貢獻總結如下:

- 提出AdaDrive,首個用於LLM增強自動駕駛的自適應快慢架構,能基於實時駕駛上下文動態激活LLM;

- 一種新的自適應融合機制,自動學習LLM的最優激活時機(以最大化性能增益並最小化計算開銷),並根據模型置信度與場景複雜度決定LLM的貢獻程度;

- 開發LS-Qformer與PMF機制,分別用於增強時序特徵聚合能力和通過高效內存保留關鍵歷史上下文;

- 在標準語言引導自動駕駛基準測試中,在準確率與計算效率兩方面均取得最先進性能。

二、AdaDrive算法詳解

概述

問題定義

給定流式視頻片段序列及對應的導航指令(其中為當前時間戳),本研究旨在構建高效的自動駕駛系統,生成遵循指令的軌跡預測結果:其中,表示時間戳的預測路徑點,後續將通過PID控制器轉換為橫向轉向和縱向加速度指令。

系統架構

如圖2所示,與傳統將指令理解和軌跡預測糅雜在大語言模型中的設計不同,本文提出的AdaDrive將這兩個過程解耦,以不同的激活頻率並行運行。輕量級規劃器作為低層軌跡預測器,對每幀圖像進行高頻處理(快速路徑);而大語言模型作為核心認知單元,以低頻激活方式在關鍵場景下為規劃器提供必要輔助(慢速路徑)。兩條路徑通過本文提出的Connector-W和Connector-H組件實現自適應整合,分別負責決定大語言模型的激活時機以及其對軌跡預測的貢獻程度。

快慢系統多模態特徵提取

給定流式視頻片段序列(每幀數據包含多視角相機圖像和點雲數據),我們採用預訓練視覺編碼器提取並融合每幀的多模態視覺特徵:,進而構建特徵序列。後續的長短時Q轉換器(LS-Qformer)將進一步聚合特徵令牌,同時考慮長時信息和當前幀信息,得到(其中,為令牌數量,為特徵維度)。

快速路徑:軌跡預測

輕量級規劃器以高頻激活方式處理每個時間戳,僅依賴當前幀信息生成路徑點:。

慢速路徑:邏輯推理

與規劃器不同,我們允許大語言模型訪問長時上下文信息,以充分發揮其指令理解和推理能力。為避免內存佔用和計算複雜度無界增長,使其適用於流式場景,我們基於構建流式內存緩衝區,用於管理輸入大語言模型的特徵。該特徵緩衝區容量固定為,存儲的特徵表示為。隨後,大語言模型處理幀上下文信息,輸出當前時間戳的整合特徵,公式如下:

自適應連接器

我們的框架通過兩個專用連接器(Connector-W和Connector-H)的自適應調度增強快慢系統架構,協調大語言模型與規劃器的交互。具體而言,Connector-W決定大語言模型的自適應激活時機,而Connector-H控制大語言模型貢獻的動態縮放。

Connector-W

給定LS-Qformer提取的當前駕駛上下文特徵,我們通過多層感知機(MLP)預測置信度分數,用於決定大語言模型的激活:通過Gumbel-Softmax重參數化,將連續概率分佈轉換為離散二值決策,確保端到端可微性並保持梯度流動:

然而,由於缺乏最優激活時機的金標準或真實監督信號,的優化面臨重大挑戰。為此,我們提出一種基於對比學習的自適應激活損失來解決這些問題。

具體而言,在訓練階段,我們進行兩次軌跡預測前向傳播:一次藉助大語言模型輔助,得到;另一次不使用大語言模型,得到。隨後,分別計算兩者的軌跡損失(L1損失),記為和。在預熱階段後,兩種損失收斂至穩定值,它們的差異反映了當前時間步大語言模型對軌跡預測的貢獻程度。因此,我們將二值決策與軌跡損失關聯,構建新型自適應激活損失:

優化該目標函數自然會在時使,否則為0,從而讓模型學習最優的大語言模型激活條件。此外,為在最小化計算開銷的同時實現最優性能提升,我們在大語言模型輔助的軌跡損失中引入懲罰項,以控制大語言模型的激活頻率,確保僅當顯著低於且差值超過預設閾值時才激活大語言模型:

Connector-H

通過提出的自適應激活損失,模型(Connector-W)學會了確定最優的大語言模型激活時機。然而,二值融合(全有或全無)可能並非與傳統規劃器無縫整合的最優策略。為實現大語言模型貢獻的動態縮放,Connector-H利用預測的置信度分數作為加權特徵整合的融合係數,生成第三種軌跡預測結果。的軌跡損失會自然引導模型學習最優的貢獻縮放比例。

推理階段

Connector-W預測大語言模型激活的置信度分數和對應的二值決策。當大語言模型激活時,Connector-H利用預測置信度作為動態加權係數,調節大語言模型特徵對基礎特徵的貢獻。具體而言,軌跡預測可統一表示為:

長短時特徵建模

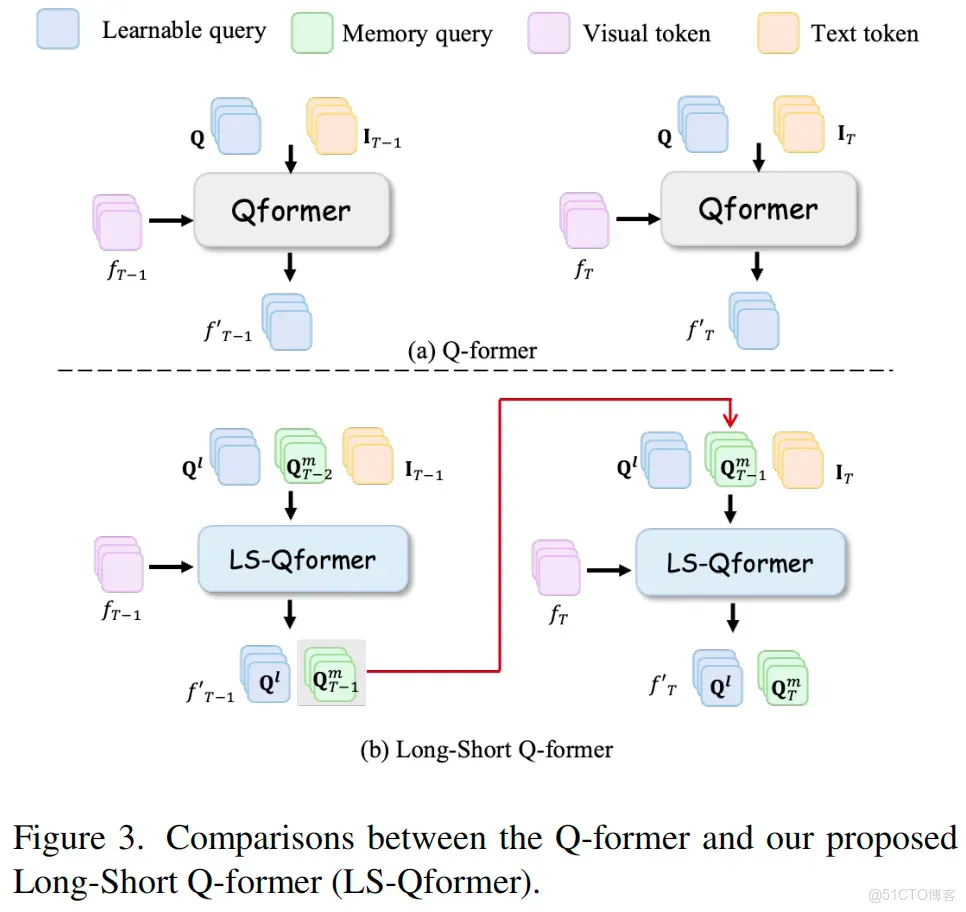

作為連接視覺編碼器和大語言模型的常用組件,Q轉換器已應用於許多多模態大語言模型中。vanilla Q-former可表示為:

其中是用於特徵聚合的額外可學習令牌。然而,該模塊單獨處理每幀圖像,忽略了長時時序信息。為解決這一問題,我們提出長短時Q轉換器(LS-Qformer)。受分組機制啓發,我們將可學習令牌分為兩組,記為和:傳遞到下一幀以聚合長時信息,而與標準Q轉換器類似,專注於當前幀信息。公式如下:

通過這一機制,LS-Qformer同時從當前幀提取關鍵特徵並建模時序特徵演變,得到更豐富的視覺表示。

流式內存緩衝區

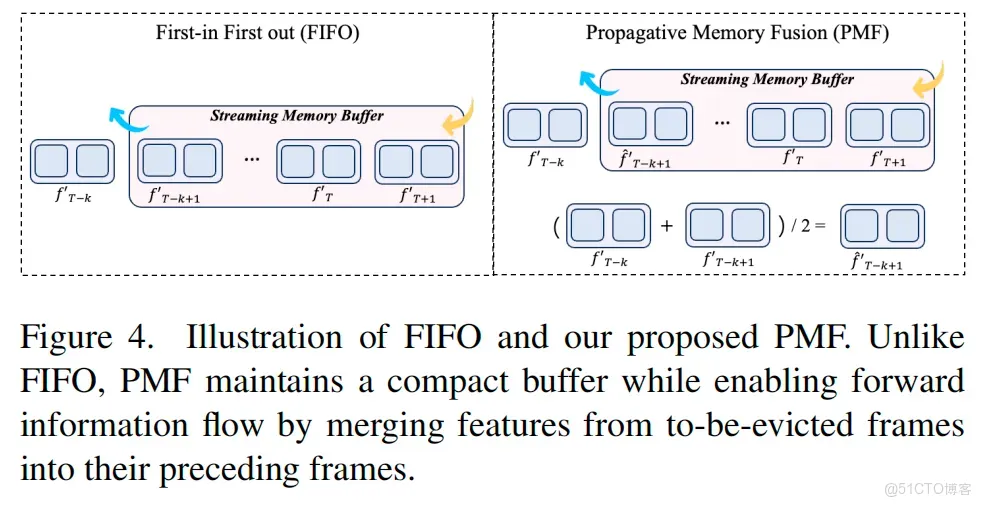

長時上下文信息對於預測目標的潛在行為和軌跡至關重要,進而實現更安全的自動駕駛。然而,存儲和處理連續流式數據不可避免地會導致計算開銷呈指數增長,並可能引發內存溢出。為解決這些挑戰,我們提出一種固定大小的流式內存緩衝區,結合傳播式內存融合(PMF)策略管理歷史駕駛數據。與僅保留固定長度特徵的先進先出(FIFO)機制不同,我們的PMF機制通過將待淘汰幀的特徵合併到其前一幀中保存信息,在維持緊湊緩衝區的同時實現信息的前向傳播,公式如下:

隨後,內存緩衝區更新為,其中表示融合後的特徵。

三、實驗

實驗設置

數據集:本文在標準LangAuto數據集上訓練AdaDrive,該數據集是一個綜合多模態數據集,包含64K條指令跟隨序列。每個序列都封裝了同步的多視角相機圖像和激光雷達點雲,為自主導航提供豐富的時空上下文信息。

基準測試與指標:本文在CARLA仿真環境中進行閉環自主駕駛評估,該基準測試根據駕駛距離分為三個不同子任務:LangAuto-Tiny、LangAuto-Short和LangAuto。路線完成率(RC)、違規分數(IS)和駕駛分數(DS)是三種廣泛採用的評估指標。具體來説,RC表示智能體成功行駛距離與計劃總路線長度的比值;IS通過幾何級數彙總多種交通違規類別,初始值為1.0,每次發生違規時會乘法衰減;DS通過將路線完成率和違規懲罰相乘得到,是主要評估標準,可全面評估自主駕駛性能。

模型配置:本文的框架採用預訓練視覺編碼器,訓練過程中保持凍結狀態。在語言建模方面,本文采用輕量級語言模型TinyLLaMA以降低計算開銷和參數數量。規劃器採用4層Transformer架構。本文在LS-Qformer中設置20個可學習令牌和20個內存令牌,並將流式內存緩衝區的容量k設為10。

實現細節:本文使用AdamW優化器和餘弦學習率調度器。初始學習率設置為1×10⁻⁵,訓練週期為15個epoch。在損失函數中,本文將超參數邊際d設為0.3以約束LLM的激活。

主要結果

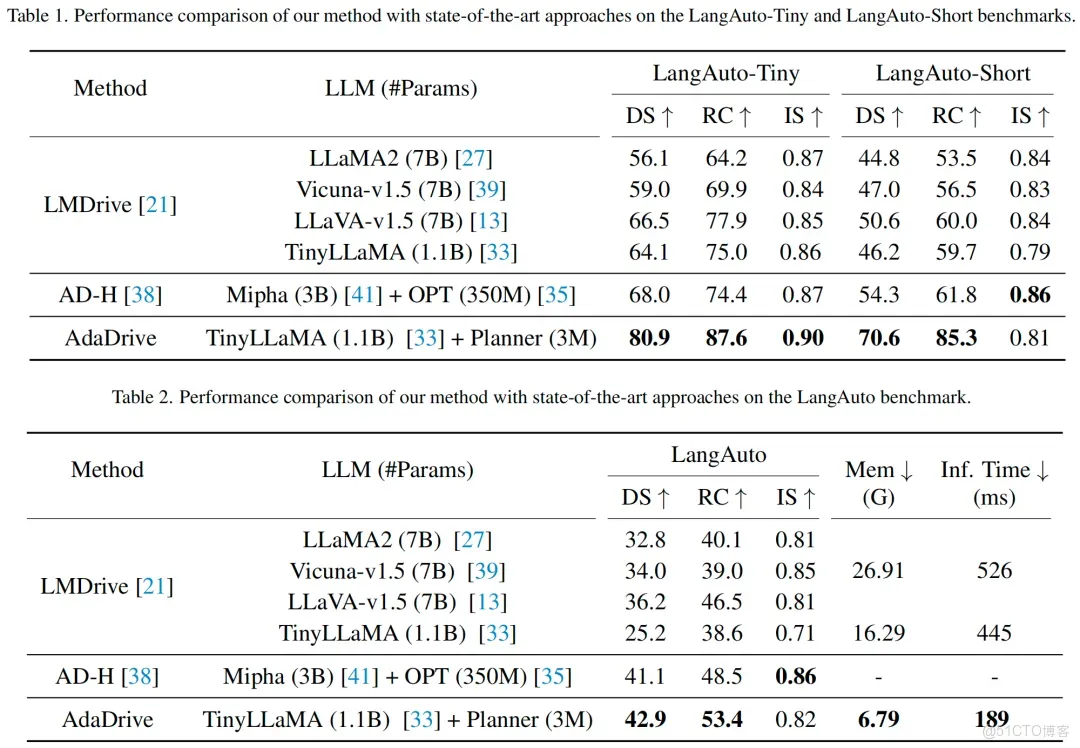

閉環駕駛性能:本文在LangAuto基準測試上開展了全面實驗以評估所提方法,並與現有先進方法進行對比。實驗結果如表1和表2所示。本文提出的AdaDrive在所有基於距離的子任務中均表現出卓越性能,尤其在短距離路線場景中表現突出。具體而言,AdaDrive在LangAuto-Tiny和LangAuto-Short基準測試上的駕駛分數分別達到80.9%和70.6%,大幅超越排名第二的方法,優勢分別為12.9%和16.3%。這些結果驗證了本文自適應快慢駕駛系統的有效性。

推理時間與內存成本:除了提升駕駛性能外,本文的方法在推理時間和計算開銷方面也具有顯著優勢,如表2所示。這些優勢源於兩個關鍵架構設計:1)自適應快慢系統。與採用順序處理、需要LLM在每個時間步進行推理的方法不同,本文的並行架構主要依賴輕量級規劃器,僅在系統自適應調度判定的緊急情況下才激活LLM。

此外,規劃器只需處理當前幀特徵,因為歷史信息已通過LS-Qformer傳播,這些架構設計顯著降低了系統的推理延遲。2)定製化流式內存緩衝區。現有方法缺乏對流式輸入的專門處理,導致數據累積和內存開銷增加。相比之下,本文明確提出流式內存緩衝區架構,可高效管理輸入數據,在降低內存成本的同時提升推理速度。

消融實驗

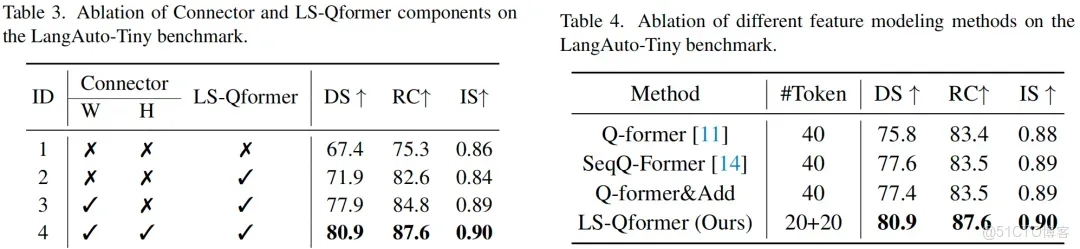

組件有效性:本文開展了全面的消融實驗,以驗證所提LS-Qformer的有效性,並量化通過連接器驅動的LLM交互所帶來的性能提升。首先,本文以基準模型為起點,該模型採用獨立聚合幀級特徵的標準Qformer和用於軌跡預測的規劃器。實驗結果如表3所示。將標準Qformer替換為本文提出的LS-Qformer後,性能得到顯著提升,這表明LS-Qformer能有效捕捉歷史信息中的時間依賴性,助力做出更合理的規劃決策。

此外,本文通過連接器架構將LLM集成到系統中。利用Connector-W主導的動態LLM激活機制,本文的方法實現了顯著的性能提升,駕駛分數達到77.9%。而且,通過將傳統的LLM特徵全權重融合替換為本文創新的Connector-H控制動態LLM貢獻縮放策略,整體DS性能指標進一步提升。

LS-Qformer分析:本文將LS-Qformer與多種架構變體進行對比:1)標準Qformer,以幀為單位獨立處理每個幀;2)SeqQ-Former,將當前輸出令牌作為後續幀特徵提取的查詢;3)帶時間累積的Qformer,通過將前一幀的令牌表示與當前幀特徵相加融合來整合歷史上下文。表4的結果表明,本文的LS-Qformer通過分組機制巧妙地將長程歷史信息與當前幀內容相結合,實現了最優的駕駛分數。

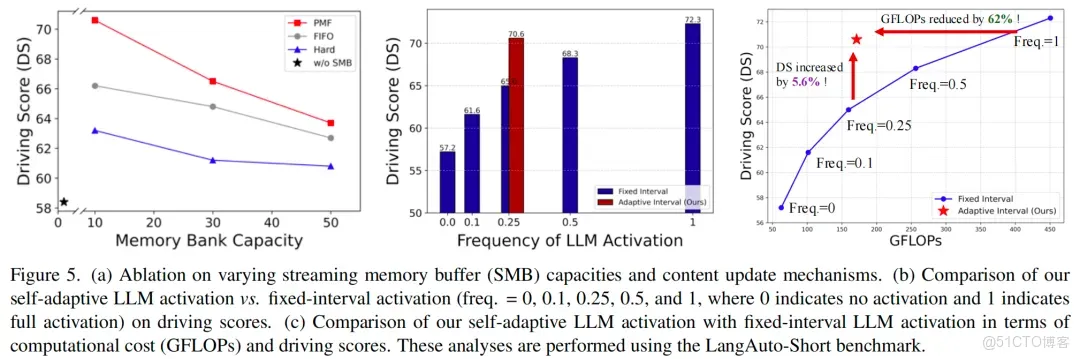

流式內存緩衝區分析:本文研究了不同內存庫容量和內容更新機制對軌跡預測的影響,如圖5(a)所示。得出以下關鍵結論:1)得益於本文LS-Qformer的有效上下文聚合,即使LLM僅關注當前幀(無SMB),本文的方法也能實現相當的性能;2)較小的內存庫容量對軌跡預測更有利,本文推測隨着內存內容的增加,LLM的指令感知能力會在擴展的上下文中被稀釋;3)當達到容量限制時完全清空當前緩衝區的硬更新機制,會導致後續軌跡預測出現固有不穩定性。

相比之下,PMF機制在保持時間連貫性的同時保留了更多上下文信息,從而實現更優性能。

自適應協作分析:本文將自適應LLM激活策略與不同頻率的固定間隔激活進行對比。如圖5(b)所示,更高的激活頻率總能帶來更穩定、更穩健的駕駛性能。本文的自適應LLM激活機制能夠動態響應關鍵場景,實現與連續LLM激活相當的性能,同時平均激活頻率僅為0.28。圖5(c)進一步表明,本文的方法在駕駛性能和計算效率之間實現了最優平衡,與連續激活相比,GFLOPs降低了62%,同時與相近頻率的固定間隔方案相比,駕駛分數提升了5.6%。

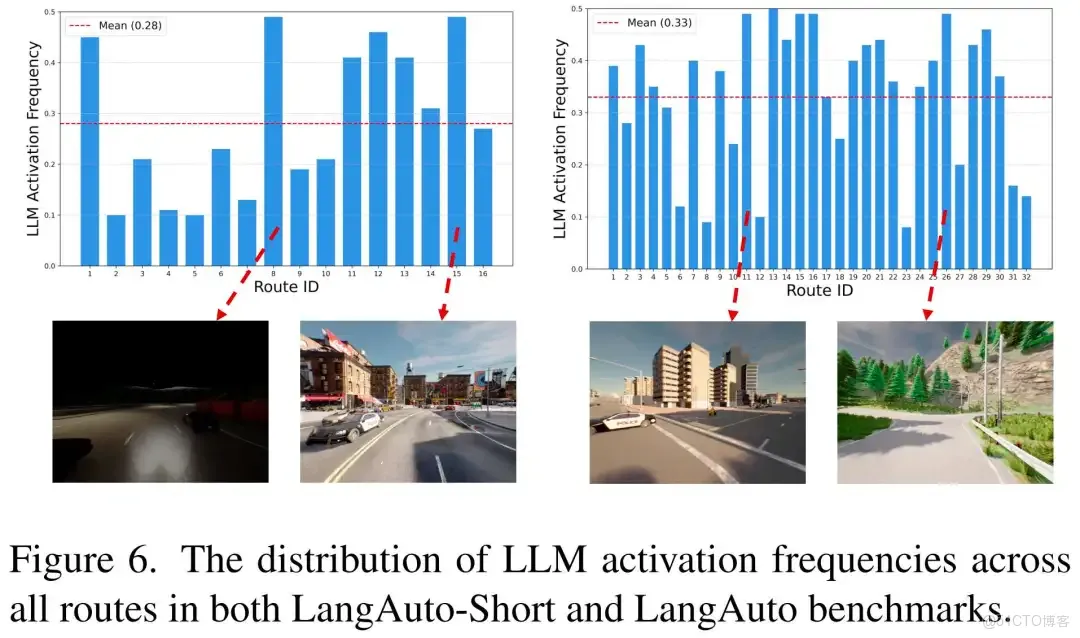

此外,本文分析了LLM在LangAuto-Short和LangAuto基準測試所有路線上的激活頻率分佈,如圖6所示。激活頻率範圍在0.1到0.5之間,表現出有效的稀疏性和動態適應性,平均激活率分別為0.28和0.33。值得注意的是,在複雜路線(如密集城市街道、夜間環境或山路)中觀察到更高的激活頻率,這驗證了本文針對複雜場景自適應啓用LLM的設計原則。

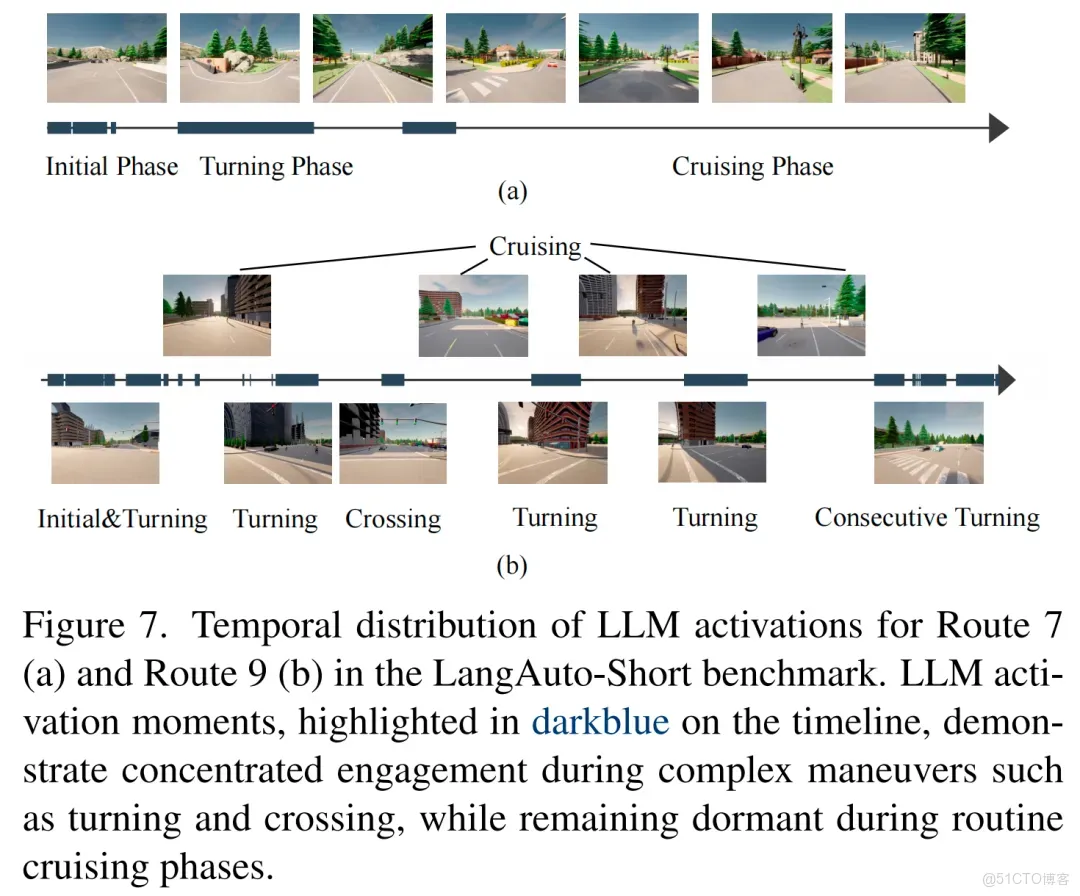

此外,通過分析單個路線內LLM激活的時間分佈,本文發現LLM在關鍵駕駛步驟中的激活頻率會增加。如圖7所示,LLM激活主要集中在複雜場景中,包括方向轉換和路口導航。在這些情況下,LLM先進的邏輯推理能力顯著提升了自主車輛智能體的決策性能。

四、結論

本研究探索了基於LLM的語言引導自主駕駛技術,重點關注兩個核心問題:LLM的最優激活時機和有效利用策略。具體而言,本文的方法採用自適應快慢架構,根據駕駛場景自適應調度LLM激活,同時基於預測置信度分數動態調節其貢獻權重。該策略在控制計算開銷的同時,顯著提升了模型的靈活性和穩健性。

此外,本文引入定製化的LS-Qformer以實現有效的歷史上下文聚合,並提出帶有傳播性內存融合策略的流式內存緩衝區,用於高效管理無界時間數據。大量實驗表明,本文的方法在有效性和效率方面均顯著優於現有方法,驗證了其實際應用潛力。

...