#毫末最新OAD

軌跡偏移學習助力端到端新SOTA~

端到端自動駕駛技術在近年來取得了顯著進展。在本研究中,我們提出了軌跡偏移學習,將傳統的直接預測自車軌跡,轉換為預測相對於軌跡錨點的偏移,降低模型學習的難度。與baseline模型相比,該方法顯著提高了規劃精度和安全性,在nuScenes上將L2 error降低了39.7%(從0.78m降至0.47m),並將碰撞率降低了84.2%(從0.38%降至0.06%)。此外,OAD展示了生成多樣化、多模軌跡的能力,增強了其對複雜駕駛場景的適應性。

技術報告和可視化內容,參考項目主頁:https://wzn-cv.github.io/OAD

簡介

本報告在VAD框架的基礎上構建了更強大的基線模型。具體而言,我們通過實證驗證了幾種明確且有效的技術,包括與鳥瞰視角(BEV)的交互、指令插入位置。此外,我們設計了一種創新的方法,利用軌跡詞彙表來學習偏移量,而非直接學習軌跡。

OAD算法核心

編輯

與BEV的交互

編輯

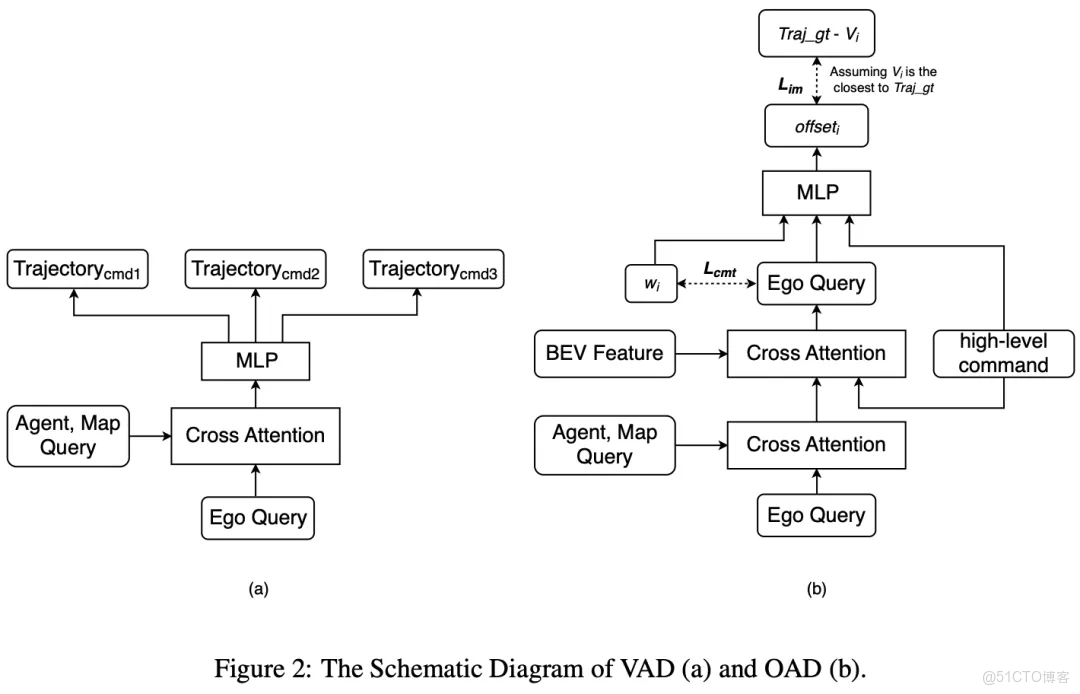

在規劃模塊中,VAD僅設計了自車查詢(ego query)與Agent查詢(agent queries)和地圖查詢(map queries)之間的交互,其中並未涉及BEV特徵,如圖2(a)所示。這導致自車查詢只能感知結構化的障礙物和地圖信息,而無法捕捉周圍環境的豐富特徵和全面信息。受UniAD的啓發,我們將自車查詢與BEV特徵進行關聯,從而使系統能夠更好地理解和感知其周圍環境。

此外,對於每個高級指令(high-level command),VAD使用一個對應的多層感知機(MLP)頭來輸出軌跡。我們認為這種設計可能導致參數冗餘。因此,我們引入了高級指令嵌入作為條件輸入,使所有高級指令共享一個單一的MLP頭進行軌跡解碼。

高級指令插入位置

在UniAD中,高級指令僅在自車查詢與密集BEV特徵進行交叉注意力(cross-attention)之前被引入。我們認為,高級指令不僅應在與BEV的交叉注意力之前引入,還應在軌跡解碼MLP之前引入。前者使自車能夠更加關注與高級指令相對應的區域,從而降低碰撞率;後者則使軌跡解碼器能夠顯式捕捉未來方向,從而減少位移誤差。因此,我們在兩個位置都引入了高級指令嵌入,如圖2(b)所示。

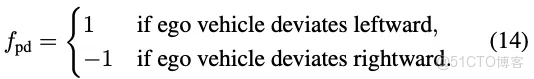

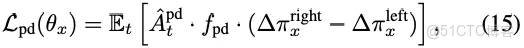

學習軌跡偏移量

我們認可VADv2和Hydra-MDP中採用的理念,即構建一個固定的規劃詞彙表以降低規劃的複雜性。略微不同的是,我們採用了在線K-means進行詞彙表學習,這使得實現更為簡單。

更重要的是,我們認為基於該規劃詞彙表學習偏移量,而非直接學習軌跡,可以帶來更高的有效性。這種方法受到目標檢測領域工作的啓發,其中學習相對於錨框(anchor boxes)的偏移量。

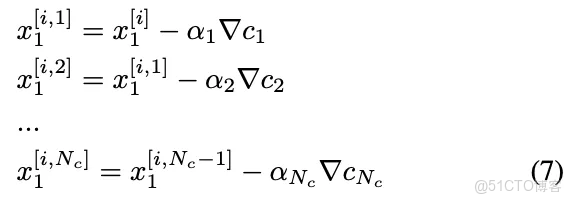

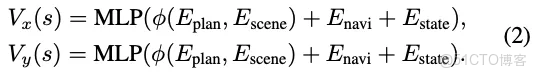

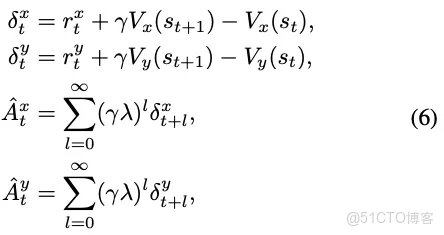

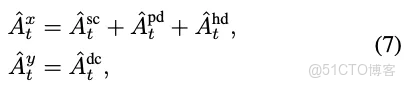

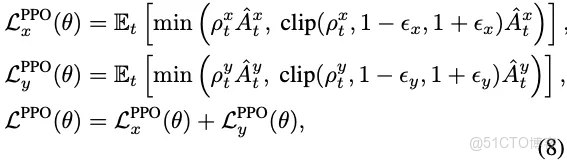

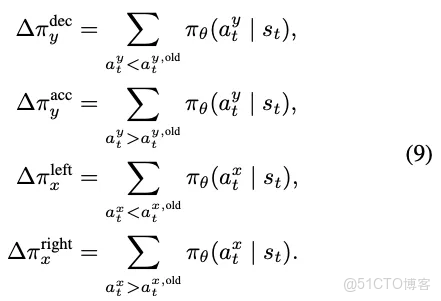

具體設計如圖2(b)所示。自車查詢結合軌跡錨點嵌入和高級指令,在關聯Agent查詢、地圖查詢和BEV特徵後學習偏移量,可表述如下:

其中, 表示自車查詢, 是一個可學習參數,表示規劃詞彙表中第 條軌跡的錨點嵌入。

在訓練過程中,從詞彙表中選擇具有最低偏移量的軌跡來計算損失:

其中, 表示最終位移誤差。總訓練目標為:

其中,表示真實自車軌跡, 表示規劃詞彙表中的第條軌跡,並作為軌跡錨點,表示模仿損失,表示用於學習的承諾損失:

其中, 表示停止梯度操作符。

在推理過程中,選擇最接近 的 來解碼規劃軌跡:

在此,我們使用的超參數為:詞彙表大小=30,,。

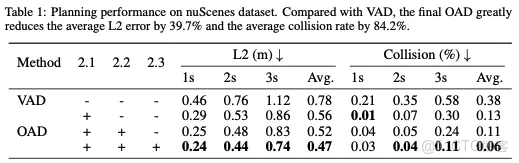

實驗結果分析相關配置

本文采用的基線模型是VAD-Tiny,其具有100×100的鳥瞰圖(BEV)查詢。為清晰簡潔起見,在本論文中VAD-Tiny統一簡稱為VAD。與VAD一致,我們的研究也使用了nuScenes數據集。在評估方面,位移誤差(DE)和碰撞率(CR)被用於全面評估規劃性能。需要注意的是,在所有實驗中,我們有意不將自車狀態作為輸入數據,以避免開環規劃中的捷徑學習。在訓練過程中,我們使用8塊NVIDIA A100 GPU,並遵循VAD的優化調度器。我們進行了超參調整,總批次大小為32、初始學習率為4×10⁻⁴時可實現最佳性能。

定量結果

上述方法的定量結果彙總於表1。顯然,每項設計都帶來了顯著的性能提升。

編輯

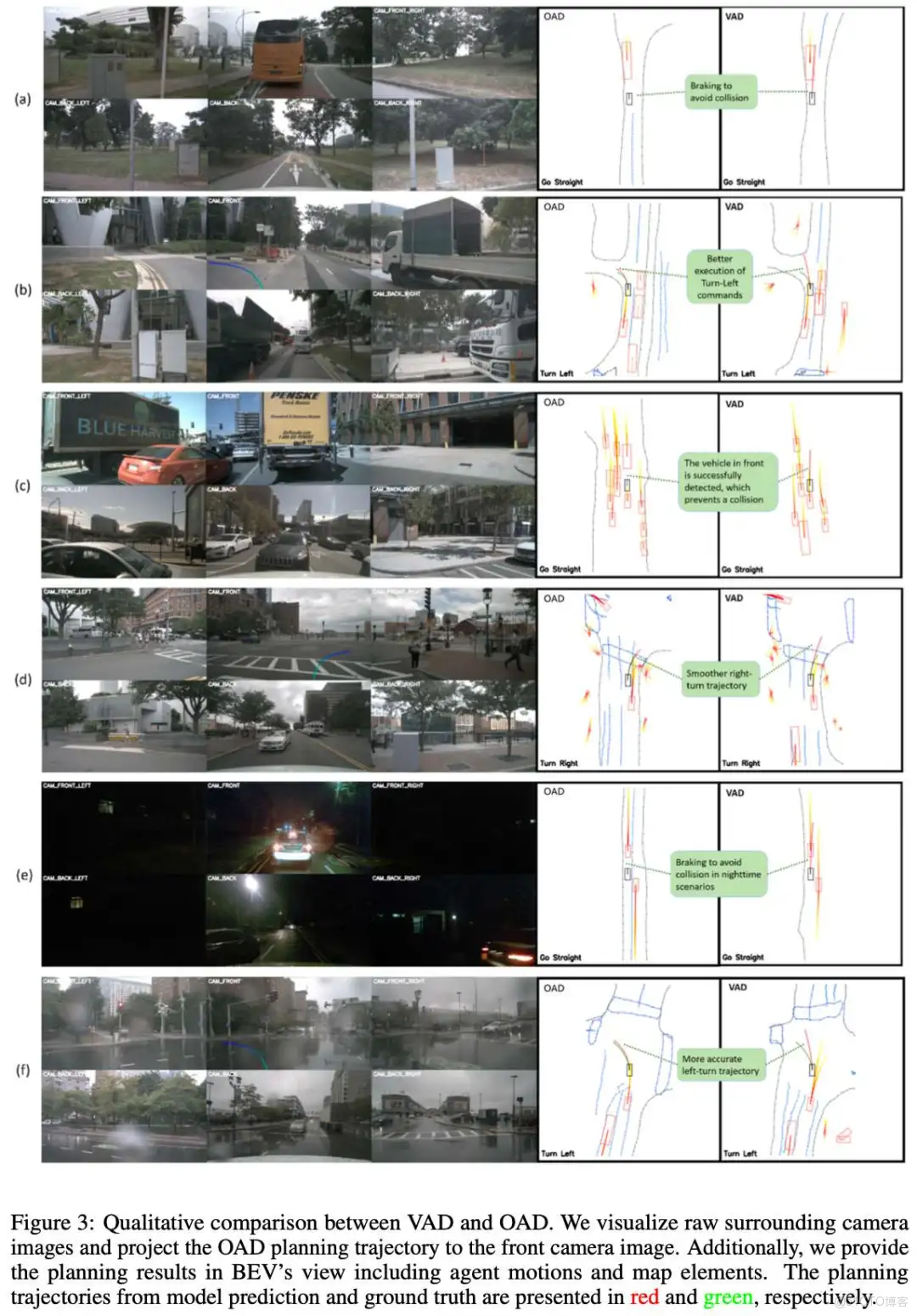

定性結果

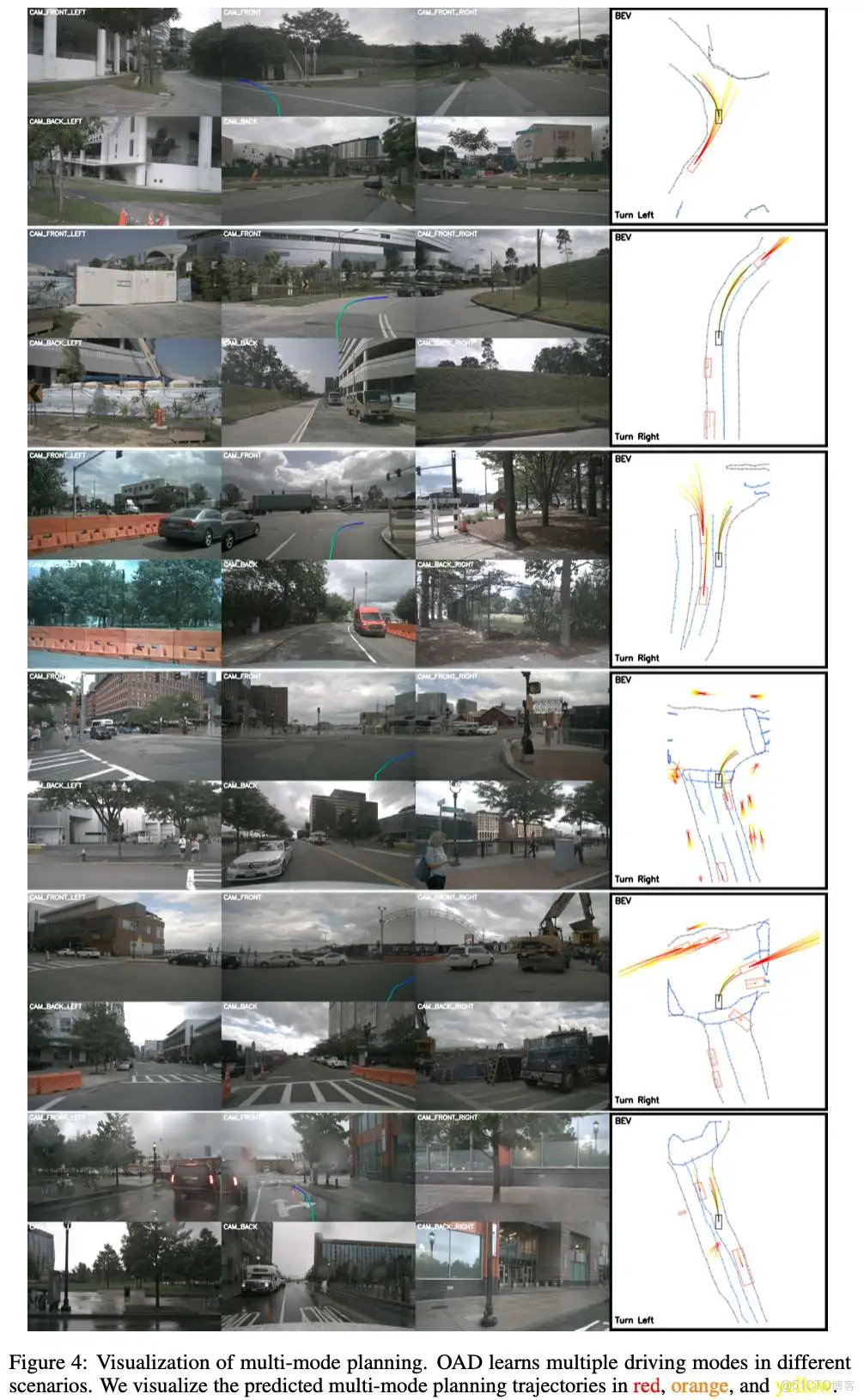

我們對OAD和VAD進行定性比較,以説明改進措施的有效性,如圖3所示。可視化結果表明,OAD能夠在複雜場景中實現更好的軌跡規劃。在圖(a)和(e)中,即使在夜間條件下,OAD在接近前車時也能通過制動展現出避撞能力。在圖(c)中,OAD成功識別出前方車輛(VAD未能識別),從而避免了直線行駛,有效降低了碰撞風險。在路口轉彎場景中,與VAD相比,OAD生成的軌跡更平滑、更合理,在圖(b)、(d)和(f)中降低了駕駛風險。利用軌跡詞彙表,OAD天然具備多模態規劃能力,如圖4所示。這為下游任務提供了更大的潛力。

編輯

編輯

結論

在本研究中,我們提出了對VAD框架的多項改進,特別聚焦於學習相對於規劃詞彙表的偏移量。定量結果和定性結果均表明了這些改進的有效性。我們將持續提出新的優化措施,以實現更卓越的端到端規劃性能。閉環評估也將成為我們未來工作的一部分。

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#博世最新D2GS:無需LiDAR的自駕場景重建方案

近年來,3DGS在自動駕駛領域的城市場景重建中展現出巨大潛力。然而,當前的城市場景重建方法通常依賴於多模態傳感器輸入,例如激光雷達和圖像。儘管激光雷達點雲提供的幾何先驗在很大程度上可以緩解重建中的不適定性,但在實踐中獲取如此精確的激光雷達數據仍然具有挑戰性:

i)需要對激光雷達與其他傳感器之間進行精確的時空標定,因為它們可能並非同時捕獲數據;ii)當激光雷達和相機安裝在不同位置時,空間未對準會導致重投影誤差。為了避免獲取精確激光雷達深度的困難,本文提出了 D²GS,一種無需激光雷達的城市場景重建框架。在這項工作中,獲得了與激光雷達效果相當,但更密集、更精確的幾何先驗。本次xxx為大家邀請到D²GS作者 博世創新軟件中心,三維重建算法專家張友健為大家詳細分析本篇工作。

論文標題:D2GS: Dense Depth Regularization for LiDAR-free Urban Scene Reconstruction

論文鏈接:https://arxiv.org/abs/2510.25173

....

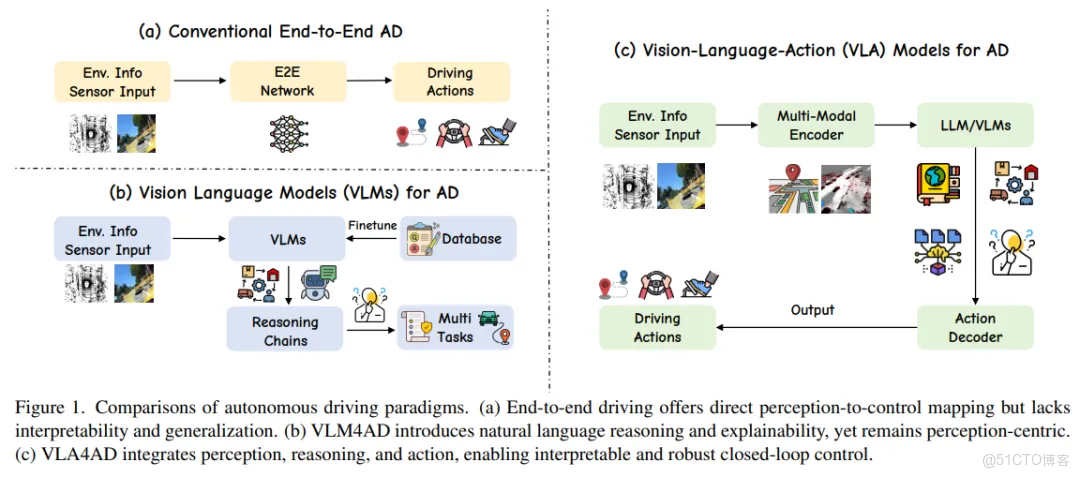

#自動駕駛三大技術路線

端到端、VLA、世界模型概述

- 行業在解決的問題:安全且經濟 corner case

- 技術路線之爭

- 單車智能 vs 智能網聯

- 傳感器:視覺 vs 激光雷達

- 算法架構:模塊化 vs 端到端

- AI決策:VLM vs VLA vs WA(去LLM)

- Waymo等主流企業採用 VLM,讓 AI 負責環境理解與推理,最終決策權交由傳統模塊,確保過程可控

- 特斯拉、吉利、小鵬等企業探索的 VLA則試圖讓 AI 直接學習所有駕駛技巧,通過海量數據訓練實現 “端到端” 決策

- 華為: ADS 4 為代表的WEWA 架構(世界引擎 + 世界動作模型)

編輯

圖片來源:https://arxiv.org/pdf/2506.24044

- 規則系統 → 數據驅動 → 認知建模

2022年以前:感知、預測、決策(規劃控制)

2022年: BEV感知成為主流

2023年: OCC感知興起

2024年: 端到端(E2E)開始落地

2025年: VLA/VLM/WA成為新熱點

1 分階段模塊化

- 感知(定位)、預測、規劃、控制

- 在多模態大模型和端到端自動駕駛技術[71]出現之前,自動駕駛的感知和預測任務通常由不同模塊承擔,每個模塊針對各自任務和數據集進行訓練

- 感知模塊:處理圖像、點雲等數據,完成目標檢測和地圖分割等任務,將感知到的世界投射到抽象幾何空間。

- 感知數據的處理與深度學習技術的發展密切相關

- 定位模塊:確定車輛在環境中的精確位置。

- 全球定位系統( GPS)

- 慣性測量單元(IMU)+傳感器數據來估計車輛的全局位置。

- 基於地圖的定位技術,如將車輛的傳感器數據與預先製作的詳細地圖進行匹配 。

- 預測模塊:通常在這些(感知輸出的)幾何空間內運行,預測周圍環境的未來狀態

- 如:預測其他車輛的行駛軌跡和行人的移動

- 決策和規劃模塊:根據導航信息,並在接受上游的感知和定位信息的基礎上,同時結合自車的當前狀態,對當前環境進行分析並做出具體決策,以在有限的時間範圍內規劃出滿足安全、舒適等約束條件的可行駛軌跡

- 控制模塊:負責精確控制車輛的油門、剎車和轉向,以實現平滑和安全的駕駛

感知概述

- 最開始:二維或三維檢測,其目標是識別圖像中的物體(如車輛、行人、車道線),並將這些帶有標籤的邊界框提供給下游模塊。

- 問題:與後續的路徑規劃模塊之間存在語義隔閡。感知的結果後面規劃不好用

- 【空間關係的影響】感知視角:只要準確框出所有物體、不遺漏、不誤判,就算完成任務,不關心物體與車輛的 “空間關係影響”。

- 規劃視角:需要知道物體是否在 “可通行區域” 內,比如路邊的護欄是 “不可逾越的邊界”,臨時停靠的車輛是 “需要繞行的障礙”,這些 “場景語義” 無法從單純的 “框” 中解讀出來。

- 【信息維度不匹配:從 “靜態描述” 到 “動態決策”】感知輸出:僅能提供 “前方 50 米有一個寬 1.8 米、高 1.5 米的矩形框,標籤為‘行人’” 這類數據。

- 規劃需要:這個行人是在過馬路還是在路邊站立?他的行走方向是否會與車輛路徑交叉?當前車速下是否需要減速避讓?這些 “動態意圖” 和 “交互關係” 信息,單純的 “框” 無法提供。

- 多攝像頭、多傳感器數據信息無法融合

- BEV:將不同視角的信息融合進一個統一的、具備空間一致性的座標系,極大地便利了路徑規劃與動態信息的融合。

- BEV的普及實質上重塑了感知與規劃之間的接口,使其更易於被端到端的學習模型所理解與利用(後面會提到端到端)

- 問題:BEV缺乏高度信息

- OCC:佔用網絡不是簡單地提供“這裏有個車”這樣的數據,而是把“某個空間點在未來若干幀裏被什麼佔着、有多大概率被佔着”等數據給釐清出,它把時間維、空間維和不確定性都納進來,對動態交互的建模更友好。

SLAM感知

- 視覺SLAM、激光雷達SLAM,以激光雷達SLAM為例。在實際使用時候,一般先建圖,再定位。而建圖過程,即是SLAM過程(同步建圖與定位);後面的定位,可以使用如NDT等算法進行定位

- 建圖:前端里程計使用激光雷達和 IMU 的信息,接收到信 息後首先進行時間戳對齊以及為激光雷達點雲去畸變,再通過 IMU 積分以及點面 距離殘差進行誤差卡爾曼濾波,迭代求解此時刻激光雷達相對於地圖座標系的里程 計位姿。後端優化接收前端里程計和 GNSS的信息,使用前端里程計構建激光雷達 里程計因子、激光雷達幀的相似性配準構建迴環檢測因子、GNSS 位置信息構建 GNSS 因子,共同加入因子圖中進行聯合優化,進一步優化前端輸出的里程計位姿。 通過激光雷達點雲及其對應的里程計位姿,即可構建出三維點雲地圖,供後續定位 等環節使用。

- 定位:重定位模塊首先設計了一種全局描述子,這種描述子依賴激光雷達點 雲的結構信息和強度信息,將點雲的特徵通過矩陣的方式進行表達,降低了查找相 似幀的時間。同時設計了一種多層搜索方法,可以在更短的時間內搜尋相似幀,而 且不會降低查找的準確程度。在建圖環節中,會根據接收到的關鍵幀計算描述子並 將其對應的變換矩陣保存到文件中。當進行定位初始化時,重定位模塊會加載這些 描述子和相對位姿,通過描述子的相似性判斷點雲幀的相似性,進而判斷滿足迭代 要求的位姿初值發送給點雲配準模塊。點雲配準模塊使用 IMU 預積分代替傳統的 運動模型假設,和配準結果共同進行圖優化,可以提供更為準確的迭代初值,降低 計算時間並增加其精度。

BEV/OCC感知

- 現狀: 已完全成熟並大規模量產

- 核心:表徵空間的統一。它解決了多傳感器融合的根本問題——如何在統一的空間中理解三維世界

- BEV和OCC感知論文彙總:

https://blog.csdn.net/CV_Autobot/article/details/138738416 - BEV經典算法彙總:BEV算法(感知):常用算法和BEV論文拆解https://v11enp9ok1h.feishu.cn/wiki/CLppw4v5EiXfjDkOY8IcBDQ5nyh

- 優勢:

- 天然適合動態/靜態感知、OCC感知

- 快速替代傳統單目/雙目檢測方案

- 99%常規場景可收斂

- 缺陷:在非結構化場景和超複雜路口(150米+)仍有瓶頸,暴露了純幾何表徵的天花板。

BEV+3DGS?

- GaussianLSS:邁向真實世界的BEV感知

https://zhuanlan.zhihu.com/p/1895567729823568547 https://zhuanlan.zhihu.com/p/1892984568358880566 - 為什麼現在有些BEV算法要用3DGS?

- 用3DGS不是為了重建場景,而是借用了3DGS的一個核心特性——”軟投影”,來解決傳統LSS方法的致命缺陷

- 3DGS在這裏不是用於重建,而是被當成一個高級版的”雙線性插值”或”模糊投影”工具,恰好它的”模糊”特性完美契合不確定性建模的需求。

- 本質是用一個成熟的渲染算法,替換掉感知 pipeline 裏一個粗糙的投影模塊,順帶收穫了效率提升

- LSS投影的缺陷:

- 離散=稀疏:只在少數幾個深度點有特徵,BEV圖上出現”空洞”

- 不連貫:相鄰像素深度差1個箱子,投影到BEV上可能相距2米,特徵突然斷開

- 沒容錯:深度估計錯了0.5米,特徵就投到隔壁車道去了

- 這篇文章怎麼做的?

- 把每個像素變成一個3D高斯”氣球”:

- 連續=緻密:氣球在BEV上自然攤開,填滿空隙,沒有”空洞”

- 平滑:相鄰像素的”氣球”邊緣重疊,特徵過渡自然

- 帶容錯:深度估計不准沒關係,氣球本身就有範圍,真實位置仍在覆蓋區內

- 不確定性可視化:氣球大小直接反映深度估計的置信度

2 端到端

- 參考資料:端到端自動駕駛綜述 https://zhuanlan.zhihu.com/p/675237671

- 端到端定義:輸入傳感器的原始信息,直接輸出任務關心的變量

- 自動駕駛系統可定義為從輸入到輸出完全可微的過程。模型整體學會,而不是把問題拆成一大堆由人寫規則的子模塊

- 自動駕駛端到端的本質:感知信息的無損傳遞

- 狹義的端到端

- 原始傳感器數據為輸入,規劃/控制 或者 行駛軌跡(車型適配問題)動作為輸出

- 廣義的端到端

- 感知和決策規劃分別使用神經網絡,模塊之間仍有人工設計的數據接口。引入了一些相關的中間任務的監督

- 和傳統分階段的核心區別

- 傳統:每個模塊單獨優化,再拼接在一起

- 端到端:讓神經網絡學會從輸入到輸出的整體映射,用數據告訴它“這樣做就是好”的標準。試圖通過梯度反傳實現全局優化。

- 因此:傳統分階段的問題不在於分階段本身,而在於每個階段的信息瓶頸。

- 階段目標與統一目標不一致

- 誤差累積問題

- 計算負擔

- 端到端的問題:

- 可解釋性悖論: 端到端提升了性能但降低了可解釋性,這在安全攸關的自動駕駛領域是致命的

- 數據問題:規模、質量(Tesla領先在數據規模上)

- 需要更多端到端標註的軌跡數據,成本高昂

- 人類的駕駛數據噪音很多,自動駕駛場景和模式繁多,學習起來困難

- 長尾場景覆蓋度

- 工程複雜度: 調試和迭代比分階段系統更困難

- 在廣義的端到端裏面,感知結果會交給決策層學習。決策層的技術路線:

- 模仿學習:

- 通過擬合人類駕駛數據來快速獲得基礎能力

- 但泛化性不足,在偏離示範數據時表現不佳

- 強化學習:

- 通過試錯學得魯棒策略

- 但依賴仿真環境以規避現實風險(生成場景與真實世界分佈存在顯著偏差)

- 先用模仿學習初始化模型,再通過強化學習在仿真中優化長期收益

端到端的分類

- 端到端的分類/階段:

參考https://zhuanlan.zhihu.com/p/1895879471770346785 - 感知“端到端” 。這一階段,整個自動駕駛架構被拆分成了感知和預測決策規劃兩個主要模塊,其中,感知模塊已經通過基於多傳輸器融合的BEV (Bird Eye View,鳥瞰圖視角融合 ) 技術實現了模塊級別的 “ 端到端 ”。通過引入 transformer 以及跨傳感器的 cross attention 方案,感知輸出檢測結果的精度及穩定性相對之前的感知方案都有比較大的提升,不過,規劃決策模塊仍然以Rule-based 為主。

- 第二階段:決策規劃模型化。這個階段,整個自動駕駛架構被仍然分為感知和預測決策規劃兩個主要模塊,其中,感知端仍保持上一代的解決方案,但預測決策規劃模塊的變動比較大 —— 從預測到決策到規劃的功能模塊已經被集成到同一個神經網絡當中。值得注意的是,雖然感知和預測規劃決策都是通過深度學習實現,但是這兩個主要模塊之間的接口仍然基於人類的理解定義(如障礙物位置,道路邊界等);另外,在這一階段,各模塊仍然會進行獨立訓練。

- 第三階段:模塊化端到端。 從結構上來講,這一階段的結構和上一階段比較類似,但是在網絡結構的細節及訓練方案上有很大不同。首先,感知模塊不再輸出基於人類理解定義的結果,而更多給出的是特徵向量。相應地,預測決策規劃模塊的綜合模型基於特徵向量輸出運動規劃的結果。除了兩個模塊之間的輸出從 基於人類可理解的抽象輸出變為特徵向量,在訓練方式上,這個階段的模型必須支持跨模塊的梯度傳導 —— 兩個模塊均無法獨立進行訓練,訓練必須通過梯度傳導的方式同時進行。 【華為、小鵬、理想】

- 第四階段:One Model/ 單一模型端到端。在這一階段,就不再有感知、決策規劃等功能的明確劃分。從原始信號輸入到最終規劃軌跡的輸出直接採用同一個深度學習模型。基於實現方案的不同,這一階段的 One Model 可以是基於強化學習( Reinforcement Learning, RL)或模仿學習( Imitation Learning, IL)的端到端模型,也可以通過世界模型這類生成式模型衍生而來。【Tesla】 其中,模塊化端到端以及 One Model 端到端都是基於全局優化的視角進行設計,且都滿足梯度反向傳播的特性,接下來,我們詳細闡述下兩個階段的來龍去脈及技術特點。

3 VLM/VLA

- 參考資料:VLA綜述

https://zhuanlan.zhihu.com/p/1923912633192523592 - corner case的本質: 不是數據問題,而是理解問題。傳統方案通過枚舉case的方式永遠無法窮盡,VLA通過理解語義來泛化

- 語言模型的突破:語言對應的概念和邏輯關係建模了出來。比如 “小狗” 或 “汽車”,在模型中是一個清晰的概念,模型能基於這些概念做理解和生成,這是過去 AI 沒有的

- 語言的三大價值:

- 海量數據:語言模型吸收了海量互聯網案例(尤其是 “彩色案例”,即有代表性和複雜性的場景)。這些數據對自動駕駛訓練非常有幫助。

- 推理能力:通過鏈式推理(CoT, Chain of Thought),語言模型能帶來一定的邏輯推理,彌補世界模型目前還未建立的細粒度推理。

- 人機交互:用户需要能像跟司機溝通一樣,直接告訴車 “開進小區,左轉,在樓下停”。這需要自然語言接口,而不僅僅是導航按鈕或固定選項。

- 兩種觀點:VLA 是世界模型的核心,也有説世界模型是用來給 VLA 做仿真評測的

- 現在大部分 VLA、VLM 的做法,是先有一個語言模型基座,然後在一些圖像數據上訓練一個插件,把視覺轉成語言,再輸入到語言模型裏。

- 它的 “根” 還是語言,只是頭上插了個視覺轉換器。

- 世界模型要直接在視頻端建立能力,而不是先轉成語言。

- 華為就提出了 WA(World Action, 世界行為模型),並強調不需要 L(語言)

- VLA、WA 這些名字,更多是表述方式的差別。

- 關鍵還是要看它是否真正建立了時空認知能力,而不僅僅是在語言模型上做加法。

- 語言模型的侷限:語言模型解決的是 “概念認知”,但在 “時空認知”——真實世界的四維時空(空間 + 時間)建模上仍有明顯短板。比如複雜的交通場景、物理規律。自動駕駛需要的恰恰就是 “時空認知”,這個空白,正是世界模型要去補的。世界模型的目標是建立基於視頻/圖像的 “時空認知”,補齊語言模型的短板。

- 物理規律的內建:比如重力、慣性、速度變化,這些規律必須在模型內部形成;

- 時空操作能力:能理解和預測物體在三維空間 + 時間維度的運動,比如車輛繞行、機器人搬運。

- 缺陷

- 空間理解能力: 現有通用大模型缺乏精確的3D空間理解

- 實時性約束: 車端算力限制vs模型能力的平衡

- 專用基座模型: 需要專門為自動駕駛訓練的基礎模型

VLM

- VLM能夠解釋複雜的交通場景、回答相關問題,顯著提升了系統的可解釋性和對罕見事件的泛化能力。然而,這些模型主要停留在“感知和理解”,語言輸出與車輛的實際控制脱節,存在“行動鴻溝”

- VLM:環境信息輸入 → VLM → 推理鏈/多任務(感知和理解,用於增強可解釋性) → 輸出(非直接控制)

- 輸入數據

- 視覺輸入:前視相機圖像(多攝像頭拼接)、導航地圖信息(如高德/百度地圖截圖)、BEV特徵圖

- 語言輸入:

- Prompt指令:系統預設的引導文本(如”請分析當前場景並給出駕駛建議”)

- 導航指令:來自導航系統的文本(如”前方500米右轉”)

- 用户指令:駕駛員語音轉文本(如”避開擁堵路段”)

- 數據格式:圖像經過ViT/CNN編碼為256-512維特徵向量;文本經Tokenizer編碼為Token序列

- 核心處理流程

- 採用三階段推理鏈:

- 場景描述(天氣、時間、道路類型等基礎信息)

- 場景分析(關鍵物體識別、風險判斷、意圖預測(如”路邊停車可能開車門”))

- 高層決策建議

- 技術實現:

- 視覺編碼器:ViT或CNN提取圖像特徵

- 語言編碼器:Transformer-based LLM(如Qwen-7B壓縮版)

- 跨模態對齊:通過Cross-Attention機制,讓每個文本Token關注圖像相關區域

- 運行頻率:低頻率(2-5 Hz),作為”慢系統”

- 輸出數據

- 場景描述:文本格式,如”雨天夜間,城市主幹道,前方紅燈”

- 場景分析:文本格式,如”右側公交車遮擋視線,存在行人橫穿風險”

- Meta-Actions:結構化決策建議, VLA

VLA

- VLA:感知推理行動閉環。VLA旨在打造能夠理解高級指令、推理複雜場景並自主決策的智能車輛。

- 環境信息輸入 → 多模態編碼器 → LLM/VLM → 動作解碼器 → 駕駛動作

- 輸入數據

- 視覺數據 (Visual Data): 視覺是自動駕駛系統的核心輸入。技術已從早期的單前視攝像頭髮展到如今的多攝像頭環視系統。原始圖像可以被直接處理,或轉換為鳥瞰圖(BEV)等結構化表示,以輔助空間推理。

- 其他傳感器數據 (Other Sensor Data): 為增強空間感知能力,系統還融合了多種傳感器。包括用於精確3D結構的激光雷達(LiDAR)、用於速度估計的雷達(RADAR)、用於運動追蹤的慣性測量單元(IMU)以及用於全局定位的GPS。方向盤轉角、油門等本體感知數據也愈發重要。

- 語言輸入 (Language Inputs): 語言輸入的形式日趨豐富,其演進路徑如下:

- 直接導航指令:例如“在下一個路口左轉”。

- 環境查詢:例如“現在變道安全嗎?”。

- 任務級指令:例如,用自然語言解析交通規則或高階目標。

- 對話式推理:最新的研究已支持多輪對話和基於思維鏈(CoT)的複雜推理,甚至包括語音指令輸入。

- 採用端到端一體化架構

- 多模態編碼:視覺特徵+語言特徵

- 融合與推理

- 動作生成(關鍵區別)

- 技術實現:三大核心模塊

- 視覺編碼器 (Vision Encoder): 該模塊負責將原始圖像和傳感器數據轉換為潛在表徵。通常使用如DINOv2或CLIP等大型自監督模型作為骨幹網絡。許多系統採用BEV投影技術,或通過點雲編碼器(如PointVLA)來融合3D信息。

- 語言處理器 (Language Processor): 該模塊使用預訓練的語言模型(如LLaMA2或GPT系列)來處理自然語言指令。通過指令微調或LoRA等輕量化微調策略,可以高效地讓模型適應自動駕駛領域的特定知識。

- 動作解碼器 (Action Decoder): 該模塊負責生成最終的控制輸出。其實現方式主要有三種:

- 自迴歸令牌器:將連續的軌跡點或離散的動作(如“加速”、“左轉”)作為Token,並依次生成。

- 擴散模型頭 (Diffusion heads):基於融合後的特徵,通過採樣生成連續的控制信號。

- 分層控制器:由一個高階的語言規劃器生成子目標(如“超車”),再由一個低階的PID或MPC控制器來執行具體軌跡。

- 輸出數據

- 【直接控制信號】低階動作 (Low-Level Actions): 一部分VLA4AD系統直接預測原始控制信號,如方向盤轉角、油門和剎車。這種方式優點是可以輸出更精細的控制,但對感知誤差敏感,且缺乏長遠規劃能力,並且不同車型的可拓展性較差。

- 【軌跡點序列(部分方案):未來5秒、每秒10個點的(x,y)座標及速度】軌跡規劃 (Trajectory Planning): 另一些VLA自動駕駛研究輸出預測軌跡或路徑點。這種方式具有更好的可解釋性和拓展能力s,可以由下游的MPC等規劃器靈活執行。它使得VLA模型能夠進行更長時程的推理,並更有效地整合多模態信息。

- 思維鏈(CoT):可選輸出推理過程,如"檢測到錐桶→分析施工區域→規劃繞行軌跡"

- 共存協作——VLM提供高層決策指導,VLA負責底層精細執行。

- 商業應用:小鵬第二代VLA

語言作用的演變:VLA發展的四個階段

- 階段一:語言模型作為解釋器 (Pre-VLA)

- 以場景描述增強可解釋性。

- 採用凍結視覺模型(如CLIP)+ LLM的架構,代表作為DriveGPT-4,僅生成高階操縱標籤或場景描述,但不參與控制。

- 核心問題是延遲高、效率低,且存在語義鴻溝(描述≠駕駛指令)。

- 階段二:模塊化VLA模型

- 語言成為主動規劃組件,嵌入可解釋的決策中間環節。語言不再僅僅是“評論員”,而是成為了規劃過程中的一個可解釋的中間環節,將高級指令轉化為車輛可執行的計劃。

- 典型工作包括OpenDriveVLA(融合多模態輸入生成路徑點)、CoVLA-Agent(動作Token映射軌跡)、DriveMoE(用語言線索動態選擇專家)和RAG-Driver(檢索增強規劃)。

- 雖縮小了語義差距,但依賴多階段流水線,存在延遲與級聯誤差風險。

- 階段三:統一的端到端VLA模型

- 構建單一可微分網絡,將傳感器輸入(+可選文本指令)直接映射到軌跡或控制信號。

- 代表作為EMMA、LMDrive、CarLLaVA(基於LLaVA,採用“行動構想”技術)、ADriver-I(生成式視頻模型預測未來畫面)和DiffVLA(擴散生成軌跡)。模型反應靈敏,但在長時程規劃與細粒度解釋上仍存瓶頸。

- 階段四:推理增強的VLA模型

- 將VLM/LLM置於控制環路核心,實現長時程推理、記憶與交互。

- 核心是讓模型在行動前進行解釋與預測。

- 代表作為ORION(結合記憶模塊與LLM生成軌跡+自然語言解釋)、Impromptu VLA(思維鏈CoT對齊行動,零樣本SOTA)和AutoVLA(融合CoT與軌跡規劃,離散化路徑點)。

- 未來挑戰在於城市規模記憶索引、LLM推理實時性(30Hz)及策略形式化驗證。

4 VLA和世界模型

- 兩種觀點:VLA 是世界模型的核心,也有説世界模型是用來給 VLA 做仿真評測的

- 現在大部分 VLA、VLM 的做法,是先有一個語言模型基座,然後在一些圖像數據上訓練一個插件,把視覺轉成語言,再輸入到語言模型裏。

- 它的 “根” 還是語言,只是頭上插了個視覺轉換器。

- 世界模型要直接在視頻端建立能力,而不是先轉成語言。

- 華為就提出了 WA(World Action, 世界行為模型),並強調不需要 L(語言)

- VLA、WA 這些名字,更多是表述方式的差別。

- 關鍵還是要看它是否真正建立了時空認知能力,而不僅僅是在語言模型上做加法。

- 統一vla和世界模型:阿里最新工作https://mp.weixin.qq.com/s/_o4P-wzVKx5wQEWDUt_qsQ

- 世界模型 通過結合對動作與圖像的理解來預測未來圖像,旨在學習環境的潛在物理規律,以提升動作生成的準確性;

- 動作模型 則基於圖像觀測生成後續動作,不僅有助於視覺理解,還反向促進世界模型的視覺生成能力。

思考:自動駕駛是否一定需要語言模型?

- 參考資料:https://mp.weixin.qq.com/s/Iubiu1CC8YG_ppAzDk3Luw

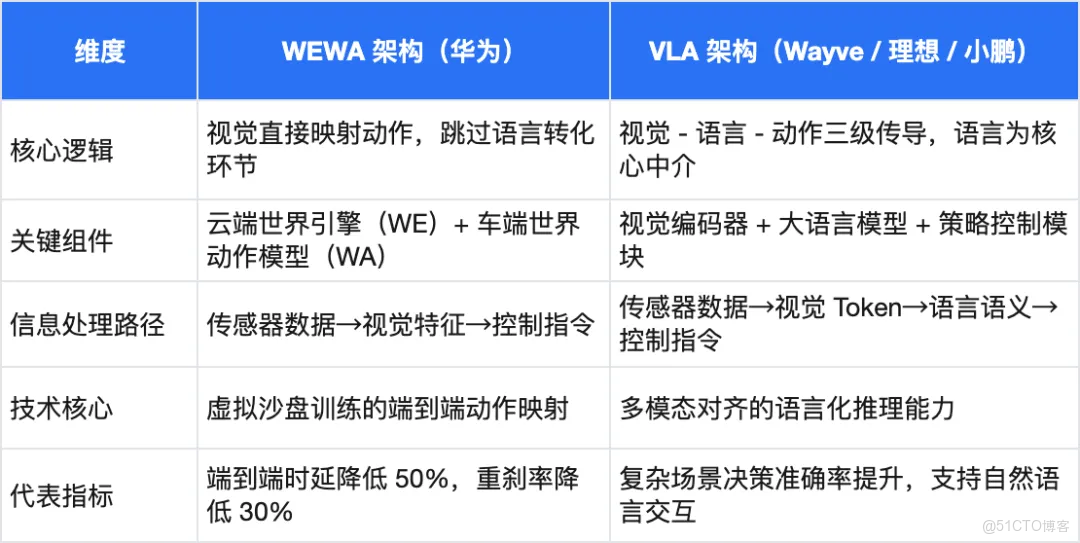

- 2025技術路線之爭

- 以華為乾崑智駕 ADS 4為代表的WEWA 架構(世界引擎 + 世界動作模型)

- 以理想、小鵬等企業競逐的VLA 架構(視覺 - 語言 - 動作模型)

- 兩種技術路線對比

編輯

- VLA 架構的興起仍源於語言模型帶來的場景抽象能力與認知智能躍升,這正是 WEWA 等 “去語言化” 架構不具備的。

- 語言的高度抽象能力可以把成千上萬的類似場景壓縮成一句話。所謂抽象,本質是歸類,用對一類場景的描述來涵蓋這一類中數不清的個例。

- 語言模型在自動駕駛中的作用

- 跨場景的知識遷移能力:大語言模型(LLM)通過互聯網級預訓練積累的常識知識,賦予自動駕駛系統"類人推理"能力,這被認為是解決長尾場景的關鍵突破。【華中理工與地平線團隊開發的Senna系統,在大型數據集DriveX上預訓練後,相比未預訓練模型平均規劃誤差降低27.12%,碰撞率降低33.33%,印證了跨場景遷移的量化價值。】

- 多模態信息的統一表徵:語言作為通用語義載體,實現了視覺、語音、導航等異構信息的端到端對齊,解決了傳統架構的接口瓶頸問題。【商湯DriveMLM通過一致的決策指令設置,可直接與Apollo等模塊化系統對接,無需重大更改即可實現閉環駕駛,證明了語言接口的兼容性價值。】

- 決策的可解釋性與安全性:語言模型將"黑箱"決策轉化為自然語言推理鏈,這是L3+自動駕駛商業化的信任基石。

....

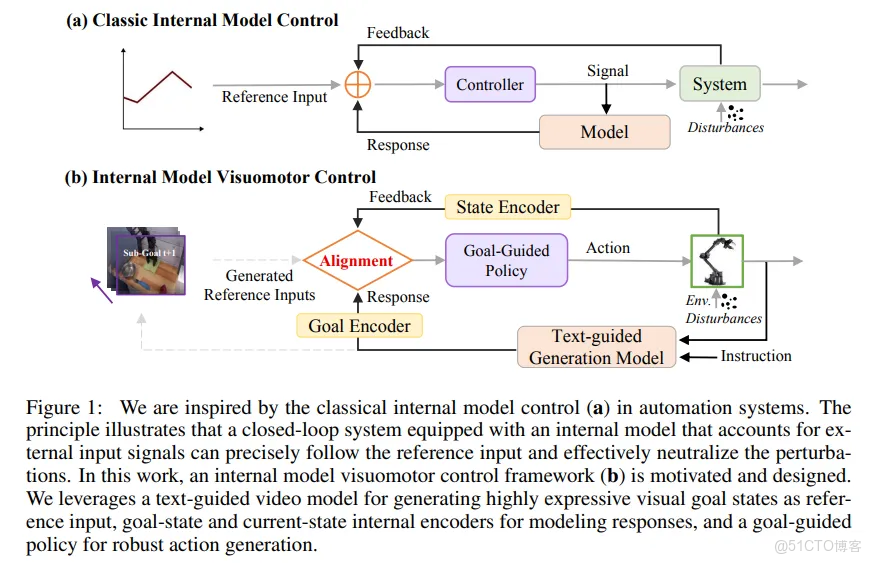

#GEVRM

西湖大學最新!極大擴展VLA部署的可靠和穩健性~

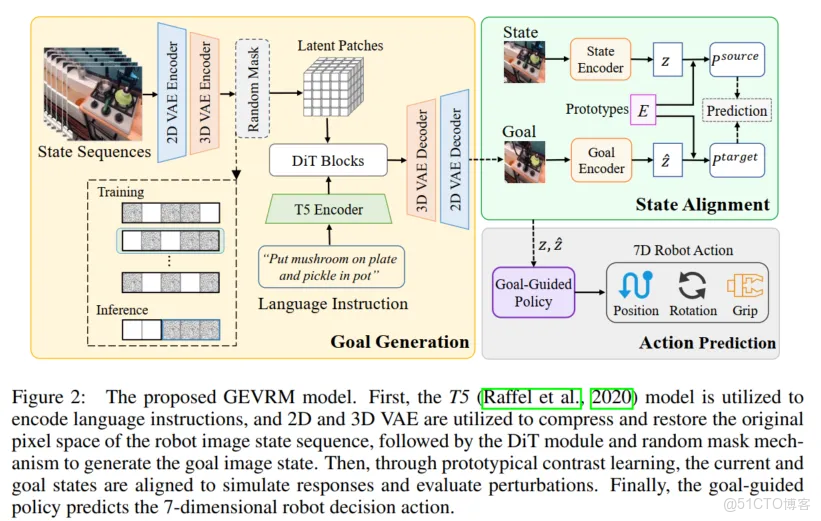

隨着快速發展,用於通用機器人決策的視覺-語言-動作(VLA)模型取得了顯著進展。然而,現有的大多數VLA模型未能考慮到在部署過程中不可避免的外部擾動。這些擾動給VLA模型帶來了不可預見的狀態信息,導致動作不準確,進而使泛化性能大幅下降。經典的內模控制(IMC)原理表明,具有包含外部輸入信號的內模的閉環系統可以準確跟蹤參考輸入並有效抵消干擾。這裏提出了一種新穎的閉環VLA方法GEVRM,該方法集成了IMC原理,以增強機器人視覺操作的穩健性。GEVRM中的文本引導視頻生成模型可以生成高度表達性的未來視覺規劃目標。同時,我們通過模擬響應來評估擾動,這些響應稱為內部嵌入,並通過原型對比學習進行優化。這使得模型能夠隱含地推斷和區分來自外部環境的擾動。所提出的GEVRM在標準和受擾動的CALVIN基準測試中均實現了最先進的性能,並且在實際機器人任務中顯示出顯著的改進。

領域介紹

追求穩健且適應性強的機器人系統是xx通用智能的基石。最近,隨着大規模機器人數據收集、通用狀態表示學習以及表達性策略學習的成功推進,機器人視覺-語言-動作(VLA)模型的研究取得了重大進展。上述策略已被證明在從物理模擬器到精心設計的現實世界環境等各種環境中,對估計機器人狀態和生成穩健動作是有效的。然而,這些精心設計的環境並未考慮到部署過程中不可避免的外部擾動,例如光照條件的波動或由於信號傳輸問題導致的視頻流噪聲。當VLA模型部署在這些非理想環境中時,外部擾動會給機器人帶來不可預測的狀態信息。這使得VLA在不準確的環境狀態下產生脆弱且不穩定的動作,導致其泛化性能顯著下降。因此,增強VLA模型的穩健性以應對部署時不可避免的外部擾動是一個持續的挑戰。

在計算機視覺和強化學習領域,圖像增強是一種常見的技術,用於緩解模型過擬合問題、抵抗輸入圖像的擾動並增強模型的穩健性。其思想是對模型的輸入圖像應用任務標籤不變的變換。例如,對於物體識別任務,圖像翻轉和旋轉不會改變語義標籤。因此,這項技術也已應用於機器人視覺語言操作任務。一些先前的工作利用視覺作為通用媒介,開發了能夠通過想象和執行來規劃各種任務的特定智能體。這些方法涉及使用生成模型來預測未來視頻或目標圖像,然後是將視覺計劃轉化為實際動作的目標條件策略。在訓練目標條件策略時利用了圖像增強技術,這在一定程度上緩解了策略對特定任務的過擬合。然而,這些模型受到其生成能力的限制,它們生成的未來目標圖像(或視頻)狀態表達不夠充分,並且圖像增強僅允許模型在狹窄的任務分佈內進行泛化。它對環境擾動缺乏強大的彈性,難以在不同的任務場景中產生始終有效的動作。

編輯

受到圖1(a)所示的經典內模控制(IMC)原理的啓發。該原理的核心思想是,在閉環控制系統中,通過在控制器內部構建一個能夠模擬外部擾動和參考輸入的模型,可以準確跟蹤期望輸出並有效抵消擾動。也就是説,它利用內模來複制系統的行為,隨後評估系統的擾動,從而增強閉環穩定性。人們普遍認為,智能哺乳動物也依賴內模來產生它們的動作,並且這種機制也得到了行為學、神經生理學和成像數據的揭示和支持。更重要的是,將內模集成到機器人控制系統中已被證實可以增強機器人運動控制的穩健性。然而,結果僅限於特定場景,難以擴展到更復雜和通用的任務,如視覺語言操作。如何在VLA框架中實例化內模以提高決策動作的穩健性尚未得到探索。

為此,我們提出了GEVRM,一種用於穩健視覺操作的目標表達視頻生成模型。如圖1(b)所示,為了在VLA模型中有效地實現經典的IMC原理,我們對方法的一些組件進行了相應調整。

目標生成:將視頻幀作為描述機器人狀態的通用接口,我們引入一種先進的文本引導視頻擴散生成模型作為機器人行為規劃器,以生成未來目標幀作為參考輸入。為了提高未來目標狀態的表達性,我們通過高效的視頻時空壓縮和隨機掩碼策略來訓練視覺規劃器,以優先理解物理世界規律和物體的3D一致性。

狀態對齊:我們利用機器人的模擬響應來估計系統擾動。這些響應稱為內部嵌入,是從機器人狀態中提取的。由於響應固有地嵌入在機器人的歷史觀測中,因此可以通過原型對比學習來優化內部嵌入,以使機器人未來的表達性目標狀態與當前狀態對齊。這使模型能夠隱含地推斷和區分來自外部環境的擾動。

目標引導策略:我們提出一種以生成的高度表達性目標為條件的擴散策略,以更好地對機器人操作的多模態任務分佈進行建模。該策略和上述內部嵌入通過逆動力學和對比學習目標進行聯合優化,以便即使在存在擾動的情況下也能很好地跟蹤高度表達性目標。

貢獻有三個方面:

- 引入了GEVRM,這是一種新穎的穩健VLA模型,它結合了IMC原理來增強機器人視覺操作。

- 研究瞭如何使用文本引導視頻生成模型獲得高度表達性的目標,並通過原型對比學習對齊狀態表示,以抵抗部署時的外部擾動。

- 大量實驗驗證了所提出的GEVRM的有效性和先進性。它在標準和外部擾動的CALVIN基準測試中顯著優於先前的最先進方法。與以前的基線方法相比,在實際視覺操作中生成的目標狀態的表達性顯著提高。

相關工作視覺-語言-動作模型

隨着廣泛的多任務機器人數據集的興起,機器人學界越來越關注多任務執行能力。視覺-語言-動作模型因其能夠使用語言作為目標命令,使機器人能夠基於視覺感知做出明智決策而受到關注。早期研究利用語言和視覺之間的跨模態注意力,但有限的模型性能阻礙了其有效性。最近,注意力轉向了大型基礎模型,以提高通用性。然而,文本描述往往缺乏關於環境狀態的細節,這使得跨形態任務變得複雜。因此,一些研究現在利用視覺作為通用媒介,採用生成模型來預測未來動作,然後通過目標條件策略來執行。UniPi是最早利用互聯網規模數據訓練文本條件視頻生成器的模型之一,它使用逆動力學模型來估計動作。同樣,SuSIE使用圖像編輯模型為低級控制器規劃高級子目標,而ADVC從具有密集對應關係的預測視頻內容中推斷動作。這些努力旨在實現通用狀態表示,但由於兩個原因而未能成功。首先,由於動力學建模不佳,現有的視覺計劃存在時間和空間不一致性。我們提出了一種穩健的視頻生成模型來解決這個問題並增強動作執行。其次,先前的工作側重於受控環境,忽略了機器人對外部干擾的響應。我們的GEVRM方法採用對比學習進行狀態對齊,有效地模擬響應並抵抗干擾。這些元素共同定義了我們富有表達力的目標表示。

內模控制框架

IMC框架是一種廣泛認可的控制策略,它利用系統的內模來預測未來行為並相應地調整控制動作,使其對干擾和模型不準確性具有高度的魯棒性。IMC由Garcia和Morari首次提出,已廣泛應用於線性和非線性過程控制中,在穩定性和適應性方面具有顯著優勢。其反饋機制允許進行實時調整,這在諸如機器人技術等對精度要求極高的動態環境中尤為重要。IMC的設計已針對多變量和複雜系統進行了進一步探索和改進,證明了其在各種控制應用中的通用性和魯棒性。然而,以前的大多數研究工作都侷限於特定的控制場景,難以擴展到一般的視覺語言操作任務。最近,受經典閉環控制系統的啓發,有人提出了一種閉環視覺運動控制框架,該框架結合了反饋機制來改進自適應機器人控制。與這些工作不同,我們研究如何在VLA框架中有效地實例化內模,以提高決策動作的穩健性。

問題公式化

這項工作研究如何生成高度表達性的目標狀態並誘導穩健的動作,以抵禦外部干擾。正式地,在非馬爾可夫決策過程框架中研究機器人軌跡和動作生成,該框架由以下元組指定:,其中和分別表示圖像狀態和動作空間,表示語言文本目標空間,是轉移動力學,是初始圖像狀態分佈。我們旨在生成富有表達力的未來圖像目標狀態以及在視覺操作任務中,根據抽象語言指令和歷史圖像序列狀態(即視頻)要執行的當前動作: 。該問題被分解為兩個層次:

- 機器人行為規劃:給定語言指令和歷史視頻狀態,推斷圖像目標狀態。

- 機器人動作預測:給定歷史和推斷出的富有表達力的未來圖像目標狀態,預測要執行的當前動作。

這種解耦過程可以表示為:

編輯

這種解耦過程極大地降低了模型訓練對語言、圖像序列和機器人動作對的依賴。行為軌跡規劃模型的訓練只需要文本-視頻對,而無需機器人動作標籤,這些數據可以從互聯網上帶有語言標籤的大規模視頻片段和帶有文本註釋的機器人序列決策數據中獲得。的訓練只需要少量針對特定下游任務的無語言標籤的演示數據。在測試階段,給定新任務的自然語言描述和初始圖像狀態,我們不僅需要評估模型推斷的未來目標狀態的表達力,還需要評估在外部擾動下完成任務的成功率。

方法介紹

我們的目標是構建一個穩健的VLA模型,將IMC概念融入機器人視覺運動控制中,如圖2所示。為了在執行前設定高度表達性的目標,引入一個強大的視頻生成模型作為視覺規劃器。下面也會詳細介紹如何對齊目標狀態以評估擾動,並展示如何誘導生成穩健的決策動作。最後,實現GEVRM的整體測試時執行流程。

編輯

機器人行為規劃器

受近期視頻生成模型成功的啓發,我們尋求構建一個文本引導的視頻擴散變壓器模型,作為用於生成機器人目標狀態的行為規劃器。該規劃器可以根據歷史視頻觀察和抽象的文本任務描述忠實地合成未來目標圖像幀。通過視頻生成進行規劃需要一個既能從給定視頻生成受限視頻,又能完成下游任務的模型。具體來説,為了獲得高度表達性的未來目標狀態,在設計機器人行為規劃器時需要考慮三個核心方面:

- 視頻時空壓縮:擴散變壓器(DiT)需要大量計算資源才能在原生像素空間中對機器人圖像狀態序列數據執行復雜操作。為了緩解這個問題,首先使用2D變分自動編碼器(VAE)壓縮原始像素空間,然後使用3D VAE進一步壓縮,以獲得信息豐富的低維密集空間。這樣做的好處是避免了3D VAE在原始像素空間中的高計算成本。實際上,在2D VAE進行空間壓縮後,相鄰特徵之間仍然存在相當大的時間相關性。在圖像狀態序列編碼階段,最初通過應用2D VAE將空間維度減少8×8倍,隨後通過3D VAE將時間維度壓縮4倍。在圖像狀態序列解碼階段,先恢復時間維度,再恢復空間維度。3D VAE採用因果3D卷積層代替3D卷積神經網絡(CNNs),確保每一幀的輸出僅取決於其前序幀。

- 隨機掩碼機制:為了實現高效的目標圖像合成,實施了一種隨機掩碼機制。訓練過程涉及對幀進行隨機掩碼,包括揭示初始幀、前幀、最後一幀、後幀、初始幀和最後幀的組合以及任意幀等場景。在測試階段,我們可以訪問歷史圖像狀態,但無法獲取未來圖像狀態。因此,在模型的訓練方案中,對前幀的掩碼操作被賦予最大權重,具體為75%。其餘的掩碼策略被歸類為補充目標,共同構成剩餘的25%。雖然掩碼機制在概念上很簡單,但它使機器人行為規劃器能夠根據各種時間快照預測後續幀,顯著增強了模型對物體動力學和時間順序相關性的理解和感知。

- 模型骨幹和訓練:DiT模塊源自一個預訓練的文本引導視頻生成模型,並集成了一個固定的T5編碼器來處理語言指令。受Stable Diffusion 3最新進展的啓發,我們使用整流流對機器人行為規劃器進行微調,超越了傳統的去噪擴散概率模型(DDPM)。整流流通過沿着樣本之間的直線路徑求解常微分方程,促進了從噪聲到真實圖像分佈的映射學習。這種方法已被證明是一種更高效的訓練範式,顯著減少了視頻採樣步驟,進而顯著提高了模型訓練速度並減少了推理時間。

機器人動作預測

機器人行為規劃器生成的高表達性目標狀態用於指導決策動作的預測。從視覺目標狀態和當前視覺狀態到最終動作的輸出,我們的目標導向策略可分為以下兩個部分:1)狀態對齊以模擬響應。從視覺目標狀態和當前視覺狀態中提取有價值的特徵,並利用原型對比學習來對齊狀態表示、模擬機器人響應以及評估干擾。2)目標導向動作預測。將目標和當前內部緊湊編碼信號解碼為機器人能夠穩健執行的動作。

- 狀態對齊以模擬響應:在經典控制系統領域,IMC框架要求在控制器中集成系統的內部模型。這個內部模型能夠抵消外部干擾和參考輸入,從而確保系統行為的精確性和可靠性。為了在基於學習的框架中實現IMC原理,我們首先部署殘差網絡ResNet 34作為目標狀態和當前狀態的視覺編碼器。這種轉換將原始像素數據轉換為豐富的視覺表示和 。對於當前視覺狀態表示,關鍵在於如何對其進行優化,以模擬機器人響應來評估外部擾動,而這種響應本身就編碼在視覺目標狀態中。遵循IMC原理,我們主張在潛在空間中對這一過程進行建模,並通過對比學習進行優化,以實現與視覺目標狀態的對齊。

在演示數據中,如果一對和來自同一軌跡,它們就是正樣本對,否則為負樣本對。這些樣本對通過交換分配的任務進行優化。具體來説,給定從演示數據中採樣的圖像觀察序列,可以從轉換過程中推導出未來目標圖像作為目標向量,將當前圖像觀察作為源向量。源向量和目標向量分別輸入到源編碼器和目標編碼器中,以獲得潛在特徵,這些潛在特徵被映射到高維空間的單位球面上並進行歸一化:

為了從潛在特徵預測聚類分配概率和,我們首先對原型進行歸一化,以獲得可訓練的歸一化矩陣,然後對所有原型的源向量或目標向量的點積取soft maximum:

這裏是温度參數。和是當前和目標圖像觀察和映射到索引為的單個聚類的預測概率。為了在避免平凡解的同時獲得預測概率和,應用Sinkhorn-Knoppal算法。現在我們有了聚類分配預測和目標,狀態對齊的目標是最大化預測準確率:

值得注意的是,學習表示以區分不同的指令和視覺表示是一個長期存在的科學問題,而很少有研究探索它們模擬機器人響應的能力。這種能力在預訓練的視覺編碼器或僅基於當前觀察學習的策略模型(即行為克隆)中無法直接獲得。

- 目標導向動作預測:為了使模型簡潔、通用且具有可擴展性,利用目標導向擴散策略從模擬響應的狀態編碼中解碼動作輸出。僅使用靜態相機的第三視角RGB圖像作為輸入,並將動作標籤作為訓練標籤。不使用機器人本體感受觀察和夾爪視角圖像。考慮一個7自由度機器人的動作空間,由末端執行器的位置和夾爪狀態組成。目標導向擴散策略是一個使用馬爾可夫噪聲和去噪過程的潛在變量模型,可用於為潛在變量建模參數化行為分佈 。前向噪聲過程遵循固定的方差調度,其分佈為 。遵循DDPM,我們的實際實現包括直接參數化分數網絡以恢復行為克隆目標:

利用這個目標來訓練目標導向策略,併為其提供目標和當前狀態的內部嵌入。在每次策略訓練迭代中,狀態編碼通過狀態對齊目標進行優化,這使得策略能夠隱含地推斷和區分來自外部環境的擾動。因此,狀態編碼和目標導向擴散策略的最終優化目標是:

其中是温度參數。為了從中採樣,使用反向擴散過程,其中且,並在每一步進行重採樣:

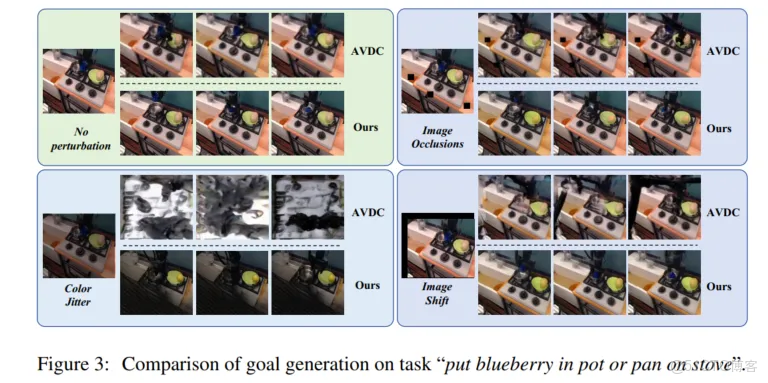

GEVRM的測試階段執行流程

一旦機器人行為規劃器和目標導向策略都訓練完成,它們就可以用於解決新的操作任務。給定一個新場景和一個新的語言命令,GEVRM通過迭代生成高度表達性的目標狀態並誘導目標導向策略來實現這些子目標,從而嘗試解決任務。最初,我們從中採樣一組目標,其中表示目標狀態生成的數量。我們將目標狀態和當前狀態通過狀態編碼器經過個時間步,以獲得內部嵌入並推導出目標導向策略,其中是固定的時間間隔數。在個時間步之後,我們再次從行為規劃器中採樣來更新目標狀態,並重復該過程。算法的測試執行過程如算法1所示。

編輯

實驗評估

這裏我們評估GEVRM的狀態生成和視覺操作能力。為此,實驗旨在研究以下問題:1)GEVRM在各種環境中是否具有強大的泛化能力,以生成富有表達力的目標?2)與基線相比,GEVRM在各種環境中執行機器人任務的成功率是否更高?3)GEVRM的核心組件對於實現穩健的決策動作有多重要?

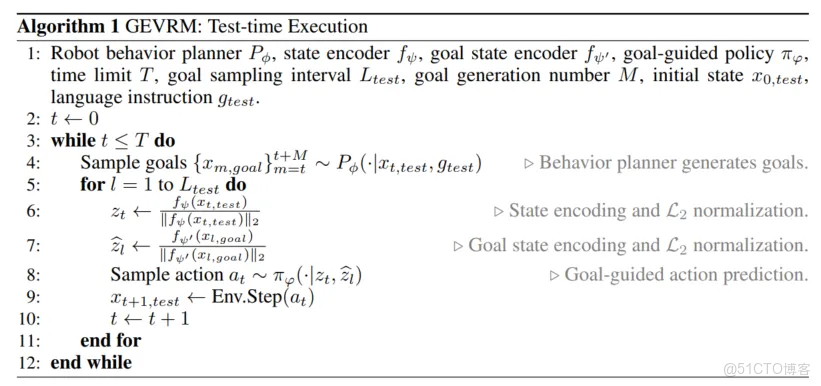

目標生成評估

- 設置:使用兩種類型的數據集(真實的Bridge和模擬的CALVIN)來評估目標生成的泛化能力。在預定義的訓練集上訓練模型,並在有和沒有外部擾動的測試集上評估機器人目標生成性能。

- 基線:為了進行公平比較,選擇了開源視頻生成模型:1)AVDC,一種典型的用於機器人的擴散式生成模型。2)GR-1,這是一種自迴歸式生成模型,它將語言指令和狀態序列作為輸入,並以端到端的方式預測機器人動作和未來圖像。3)SuSIE,使用圖像編輯擴散模型作為高級規劃器,並提出可以由低級控制器實現的中間子目標。

- 指標:所採用的評估指標是弗雷歇初始距離(FID)和弗雷歇視頻距離(FVD),這兩個指標在圖像和視頻生成領域都得到了廣泛認可。我們還使用其他標準指標評估不同模型生成視頻的質量:結構相似性指數(SSIM)、峯值信噪比(PSNR)、學習感知圖像塊相似性(LPIPS)。

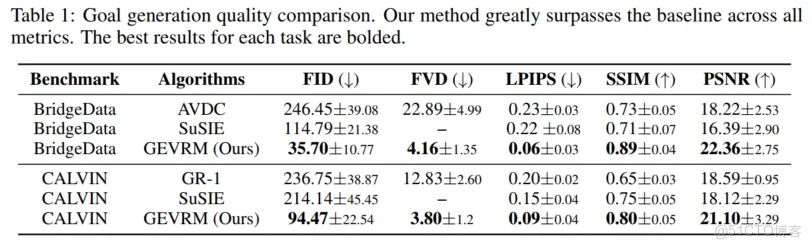

- 目標生成比較:在未見環境中評估目標生成的泛化能力(表1)。結果表明,與基線相比,GEVRM模型性能顯著提升。結果表明,GEVRM具有更強的表達能力,能夠有效地對機器人圖像序列的複雜紋理和時間連貫性進行建模。然後,在比較在受擾動環境中目標生成的穩健性(圖3)時,基線模型在環境變化時表現不佳,生成的嚴重幻覺會扭曲物體,甚至可能完全破壞場景。相比之下,我們的方法產生的幻覺較少,並且能夠根據語言指令生成富有表達力的目標狀態。這證實了GEVRM確實能夠更好地理解物理世界的規律,並保持物體的3D一致性。

編輯

編輯

動作執行評估

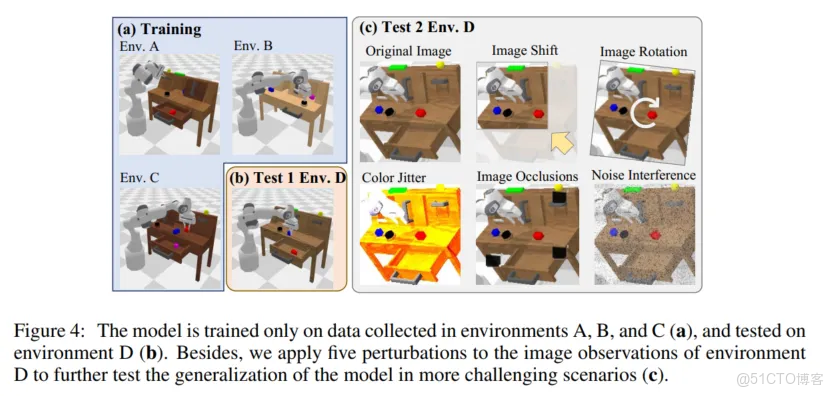

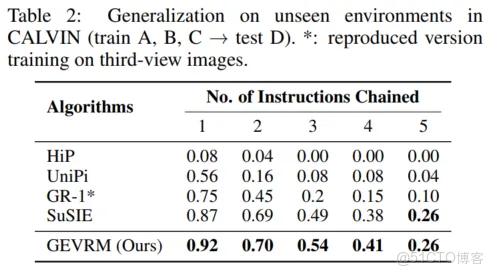

- 設置:在CALVIN上進行實驗,CALVIN是一個用於語言條件操作的基準測試,用於評估GEVRM在閉環動作執行方面的能力。CALVIN由四個模擬環境(A、B、C和D)組成,每個環境都有一個人類收集的演示軌跡數據集。我們研究在A、B和C環境上進行零樣本多環境訓練,並在D環境上進行測試,D環境在桌面紋理、傢俱位置和彩色補丁方面有所不同。我們還測試了GEVRM對擾動的穩健性(圖4)。

- 基線:選擇具有代表性的基線來驗證在標準未見環境上的泛化性能:1)UniPi):首先將決策制定轉化為文本條件視頻生成,能夠生成預測視頻序列並隨後提取控制動作。2)HiP:該模型通過結合分層推理擴展了長期規劃能力,改進了UniPi。3)GR-1:該模型利用預訓練的視頻模型來增強自迴歸動作生成。4)RoboFlamingo,使用預訓練的視覺語言模型進行單步視覺語言理解,並使用顯式策略頭對順序歷史信息進行建模。此外,在有外部擾動的測試環境中,我們選擇具有代表性的基線SuSIE,因為它採用常見的數據增強策略來應對擾動,並且在先前的工作中取得了最先進的結果。將靜態相機的第三視角RGB圖像作為觀察值,這使得機器人的執行更具挑戰性。

- 動作執行比較:在表2中展示了完成鏈中每個語言指令的成功率。模型在環境A、B和C上進行訓練(圖4(a)),在D環境上進行測試(圖4(b))。與基線相比,GEVRM有顯著的性能提升。這表明基於IMC原理的方法在面對新環境時具有更好的目標生成能力,並能誘導機器人預測更通用的決策動作。

- 外部擾動下的動作執行比較:為了全面評估提出的GEVRM與基線SuSIE的性能,在五個更具挑戰性的場景中對兩個模型進行了測試(圖4(c))。五個受擾動任務的平均性能如表3所示。這些場景旨在挑戰模型對環境刺激的感知和對物理定律的理解。結果表明,GEVRM能夠很好地模擬機器人響應,並指導策略生成穩健的決策動作以抵抗外部擾動。更多動作執行比較結果見附錄表5。

編輯

編輯

編輯

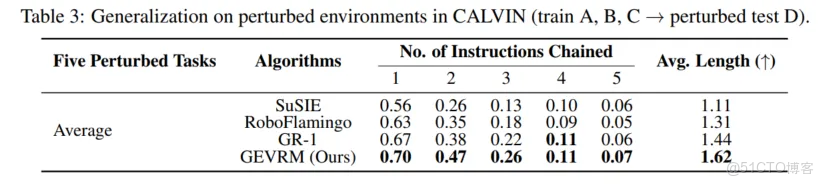

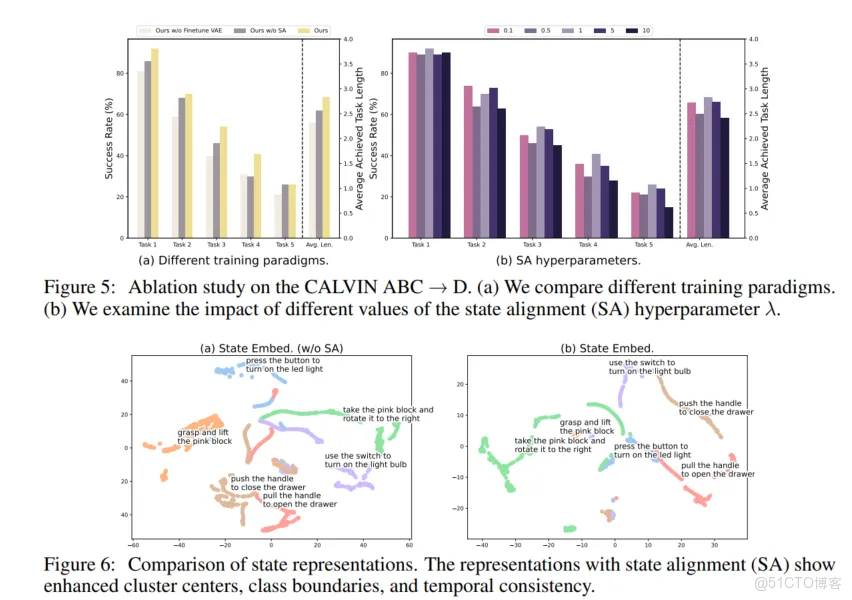

消融研究

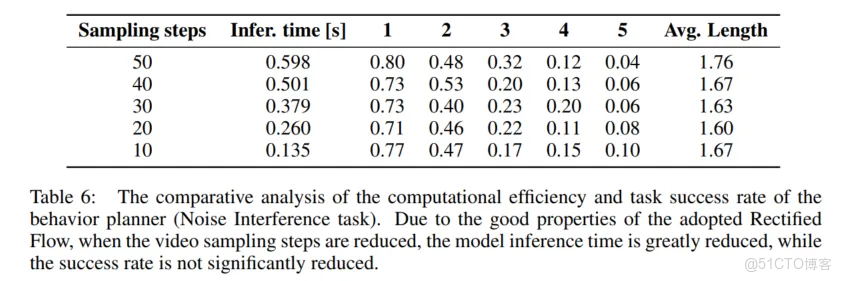

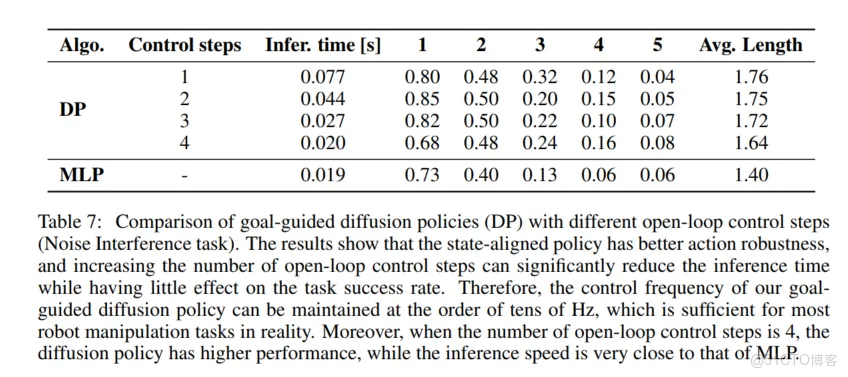

我們評估VAE微調與狀態對齊應用對CALVIN環境A、B和C上模型性能的影響,重點關注機器人行為規劃和目標導向策略訓練。圖5(a)中的結果表明,省略VAE微調或狀態對齊集成會顯著降低模型在CALVIN環境D上的性能,這是因為VAE在多樣化視頻數據上的預訓練增強了時空一致性,隨後在機器人數據上的微調有助於決策的泛化。狀態對齊增強了策略的視覺狀態表示,以實現更好的任務泛化。此外,在策略訓練中平衡專家模仿和狀態對齊的超參數,我們測試了五個值(圖5(b))。性能指標變化很小,表明對的調整具有魯棒性,對我們的方法來説是最優的。為了説明狀態對齊對目標導向表示的影響,我們進行了一項視覺比較實驗。使用T-SNE分析在CALVIN ABC→D “噪聲干擾” 任務中,有無狀態對齊時當前和未來圖像狀態的潛在空間表示,結果如圖6和附錄圖8所示。結果表明,狀態對齊通過增強類內凝聚性和類間分離性來改進聚類和分類。此外,狀態對齊確保了圖像狀態序列的時間一致性,從而增強了策略對環境和任務的識別能力,並有助於泛化到新場景。目標生成和目標導向擴散策略執行效率的消融實驗分別見附錄表6和表7。

編輯

編輯

編輯

最後的結論

方法的創新之處在於能夠將經典的內模控制原理融入現代VLA框架,從而增強機器人處理環境擾動的能力並保持性能的完整性。在提出的穩健GEVRM模型中,利用視頻生成模型獲得高度表達性的目標狀態。同時,基於原型對比學習有效地對齊狀態表示,以模擬機器人響應並評估外部擾動。正如GEVRM在模擬和現實視覺操作任務中的最先進性能所示,它有效地增強了目標狀態的表達性,並對外部擾動表現出很強的彈性。因此,工作極大地擴展了機器人系統在部署場景中的可靠性和穩健性,是xx通用智能領域向前邁出的重要一步。一項有前景的工作是考慮將更通用的高質量視頻生成模型納入VLA框架,以應對現實世界機器人複雜多樣的操作任務。

....

#預測規劃統一新框架

利用一致性模型的端到端預測規劃器來了(普林斯頓大學)

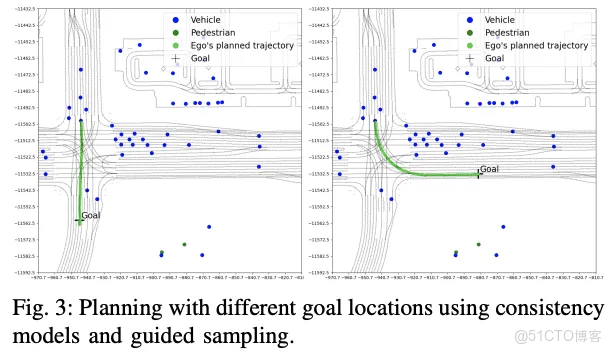

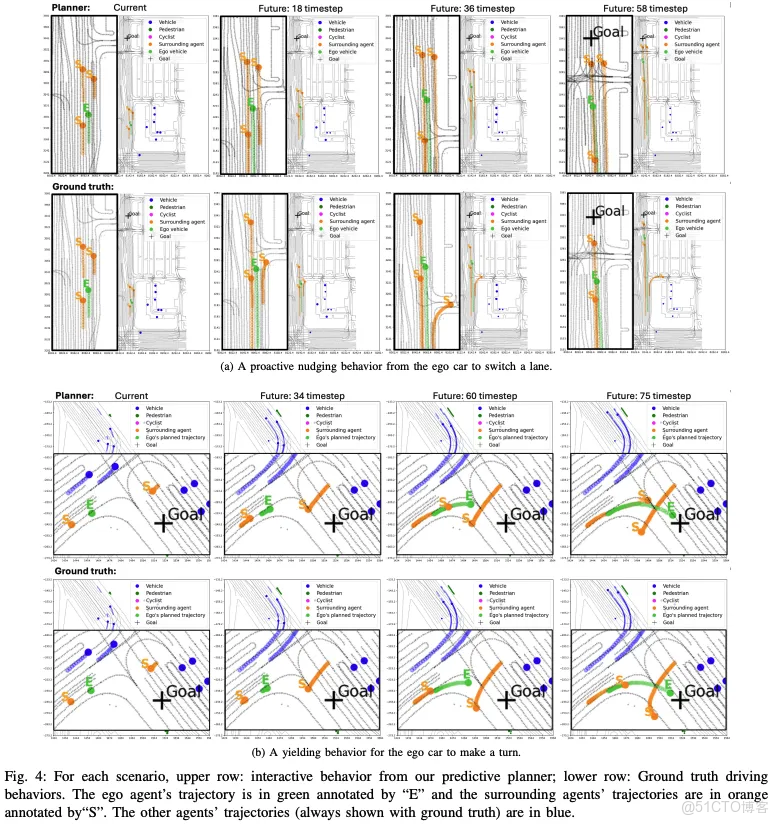

一篇關於集成了自動駕駛預測和規劃的最新算法框架文章。軌跡預測和規劃是自動駕駛系統當中至關重要的兩個組成部分。在早期的傳統自動駕駛系統當中,預測和規劃屬於是各自獨立的模塊,這種範式限制了執行交互式規劃的能力。因此,本文我們提出了一個新穎的統一數據驅動框架,將預測和規劃與一致性模型相結合。我們提出的算法模型以更少的採樣步驟實現了更好的性能,使其更適合實時部署。

首先,我們先介紹模塊化預測和規劃範式的問題。然後引出我們本文所提出算法模型的網絡結構和細節。接下來是在WOMD數據集上的實驗結果和指標分析,最後是本文所得出的結論。

簡介

為了在動態環境中安全高效地行駛,自動駕駛汽車必須有效地預測並與各種道路參與者互動,包括其他車輛和行人。這通常需要一個預測模塊來預測其他代理的未來軌跡,以及一個規劃模塊來為自車生成軌跡。雖然預測模塊已廣泛採用數據驅動的方法來從人類駕駛數據中學習,但規劃模塊通常依賴於基於優化的方法。這兩個模塊通常以解耦、交替的方式運行。

但是這種解耦的方法引入了根本性的限制。規劃器生成的交互行為本質上是被動的,而不是主動的,因為規劃器響應其他代理,而不考慮它們如何對自車做出反應。這種限制可能導致計算成本高昂的心理理論推理。在高度交互的場景中,例如車道合併,主動規劃是必不可少的,被動規劃可能會導致自車卡住。現有的解決方案要麼難以隨着代理數量的增加而擴展,要麼由於對解決方案搜索空間的限制性探索而損害了最優性。

此外,模塊化方法可以獨立優化預測和規劃,與聯合訓練的端到端框架相比,這通常會導致效率降低。預測和規劃模塊之間的交替也引入了延遲和計算效率低下,使得滿足實時操作的需求變得具有挑戰性。

近年來,擴散模型被廣泛應用於自動駕駛領域。它們對條件分佈進行建模的能力使它們非常適合軌跡規劃應用,因為它允許結合規劃和預測的關鍵背景,包括軌跡歷史、地圖信息、自車的目標位置等。與 Transformer 模型相比,基於擴散的方法還支持可控生成,以僅在測試時通過引導採樣來滿足額外要求,而無需任何額外的訓練。然而,擴散模型通常需要許多采樣步驟才能獲得高質量的樣本,這使得滿足自動駕駛汽車實時操作的需求變得具有挑戰性。

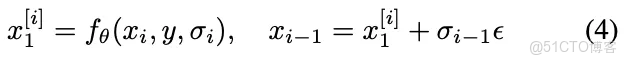

考慮到上述提到的相關問題,在本文中我們提出了一種基於一致性模型的端到端預測規劃器,旨在在單一數據驅動框架內統一規劃和預測。大量的實驗表明,我們提出的算法模型在Waymo Open Motion Dataset數據集上與現有各種方法相比在軌跡質量、約束滿足和交互行為方面的優勢。

論文鏈接:https://arxiv.org/pdf/2502.08033

算法模型網絡結構&細節梳理Motion-Transformer Encoder

在本文中,我們通過規劃目標來規劃自車的軌跡,同時預測其他車輛的交互行為。為了將軌跡歷史和地圖信息編碼為一致性模型的條件輸入,我們採用了 MTR 的編碼器架構。這種基於 Transformer 的架構通過局部注意機制有效地對場景上下文進行建模,從而實現代理與路線圖之間的高效交互建模,同時保持內存效率。它還引入了一個具有損失函數的密集預測頭來單獨訓練此編碼器。此外,需要注意的是,我們的方法是與編碼器無關的,允許靈活選擇任何合適的場景編碼器與我們基於一致性模型的預測規劃器集成。

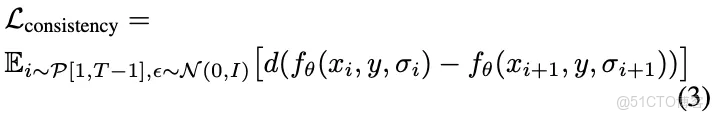

Consistency Model

一致性模型僅需一個或幾個採樣步驟就能從複雜分佈中生成高質量樣本。它由正向擴散過程和逆向擴散過程組成。假設是我們數據集中的軌跡,我們首先使用在整個數據集上計算的平均值和標準差對中所有的軌跡進行標準化。

令為此類歸一化軌跡的空間,是數據分佈。在前向過程中,我們首先從中抽取初始樣本。然後我們應用增加噪聲的方式,通過步來逐漸破壞。具體來説,在每一步,我們從正態分佈中進行採樣,並且假設破壞的數據可以從下式子獲得

編輯

我們通過選擇足夠大的噪聲方式,通過重複從數據中進行採樣並通過加性高斯噪聲進行破壞時,進而得到相應的分佈。

假設,是條件信息空間。在逆向過程中,我們的目標是學習一個具有參數的一致性函數,該函數映射嘈雜的軌跡樣本、條件以及噪聲級別直接到相應的乾淨樣本。這是通過選擇特定的函數形式來實現的。

編輯

對於一致性模型訓練,我們的目標是加強輸出在相鄰採樣步驟中的一致性。一致性訓練通過最小化以下損失函數進行實現。

編輯

在數據生成過程中,我們首先抽取樣本。然後使用訓練好的一致性模型。我們通過首先預測近似的乾淨數據,然後從正態分佈中抽樣來進行迭代抽樣。

編輯

在聲明好上述的符號和所定義好的問題後,下圖展示了我們提出算法模型的整體網絡結構。

編輯

具體而言,我們首先使用MTR編碼器對代理的軌跡歷史和地圖信息進行編碼。然後,我們使用一致性模型,該模型採用自車代理的規劃目標和MTR 編碼特徵的條件輸入,分別為自車和周圍代理生成軌跡計劃和預測。最後通過一致性模型的引導採樣,可以實現自我代理的額外規劃約束。

Data pre-processing

為了訓練擴散模型或一致性模型,我們通常需要對輸入數據進行規範化。如果我們聯合建模自車和周圍代理的未來軌跡,使用以自車為中心的座標系會在數據中引入很大的差異,特別是對於在不同場景中位置差異很大的周圍代理而言。因此訓練性能會大大降低。相反,我們應用類似於 MTR++ 的座標變換,將每個代理的軌跡映射到其自己的局部座標系中,以當前時間步的位置為中心。這種轉換為我們提供了方差大幅降低的數據。然後,我們計算整個數據集中轉換後的軌跡的經驗平均值和標準差,並將它們標準化為零均值和單位方差。為了保留代理之間的相對空間關係,我們收集由每個代理在時間步的位置組成的參考狀態。

Consistency Model Training

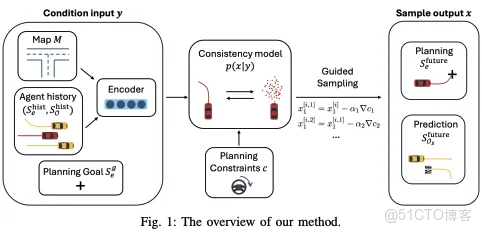

令表示自車和周圍的未來軌跡空間,令表示條件輸入的空間,包含編碼的歷史軌跡、地圖特徵、自我代理的目標狀態和參考座標。給定一個規劃目標和環境背景作為條件,我們利用一致性模型從條件概率分佈中抽取未來軌跡。每個軌跡樣本代表自車和周圍代理的一種可能的聯合未來行為。

為了訓練我們的預測規劃器,我們使用混合損失函數一步聯合訓練 MTR 編碼器和一致性模型,該函數由一致性訓練損失和 MTR 編碼器的密集預測損失的加權和構成。

編輯

Guided Sampling

在使用經過訓練的一致性模型生成軌跡以對自車的未來軌跡施加規劃約束時,我們提出了一種類似於分類器引導的新型引導採樣方法。重要的是,這種引導僅在測試時的採樣過程中應用,而無需對訓練程序進行任何修改。假設有個規劃約束需要最小化,並從分類器指導中汲取靈感,我們可以在每個採樣步驟中對預測執行梯度下降過程。

編輯

然而,同時優化多個約束對於有效找到合適的步長提出了重大挑戰,特別是當約束可能相互衝突時。為了應對這一挑戰,受ADMM算法的啓發,我們提出了一種新穎的交替方向法,該方法在每個採樣步驟中一次僅優化一個約束

編輯

在我們的方法中,我們按順序優化每個約束,並在每次梯度下降迭代期間使用相應的步長。雖然我們對優化順序和相對較小步長的選擇是基於經驗觀察的,但這種策略在實踐中已經證明了有效的收斂,而使用梯度下降的標準指導方法很難實現。ADMM的收斂通常在包括封閉、適當和凸函數以及適當選擇的步長的條件下得到保證。

Planning Constraints Construction

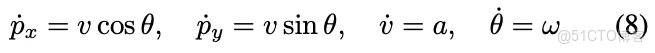

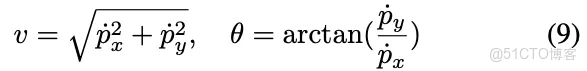

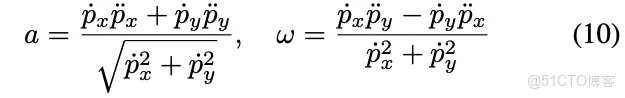

我們假設自車的動態用如下的形式進行表示

編輯

假設我們僅使用自車的未來狀態中的和來構建我們的規劃約束函數。因為其他狀態(如或)可能不滿足動力學方程,而且也非常嘈雜。利用動態的微分平坦性,我們可以推斷出和。

編輯

然後我們可以進一步的推斷控制輸入

編輯

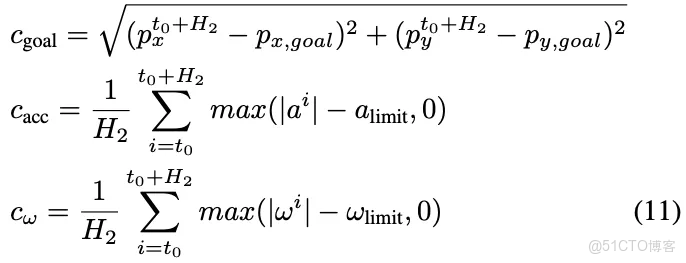

在有,,以及情況下,我們考慮三種類型的規劃約束以最小化如下。

編輯

實驗結果及評價指標

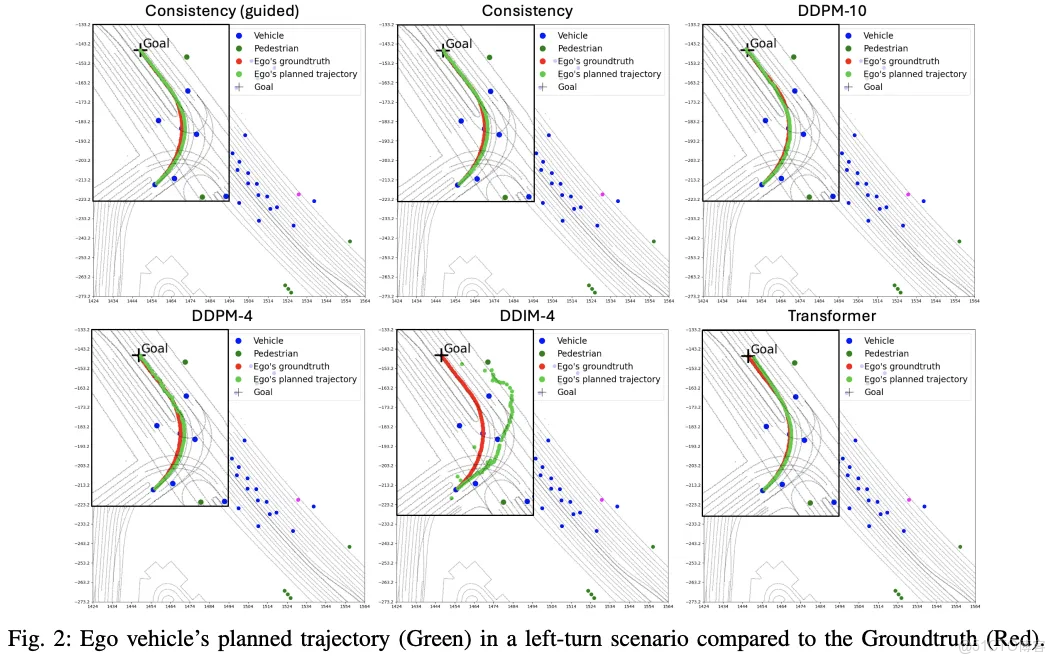

我們將不同方法生成的規劃軌跡與數據集中的真實軌跡進行比較。該場景要求自車進行左轉,然後直行以達到其目標地點,如下圖所示。

編輯

DDPM-4 達到了目標,但產生了嘈雜的軌跡,這可能是由於擴散模型的採樣步驟不足以生成高質量的軌跡。雖然 DDPM-10 增加的採樣步驟產生了稍微平滑的軌跡,但代價是更長的計算時間。DDIM-4 嘗試僅使用 4 個採樣步驟來加速 DDPM-10,但無法生成達到目標的軌跡。具有較大模型尺寸的 Transformer 生成的軌跡接近真實值,但錯過了準確的目標位置。相比之下,我們的一致性模型生成的軌跡既與真實值一致,又精確地到達目標位置。

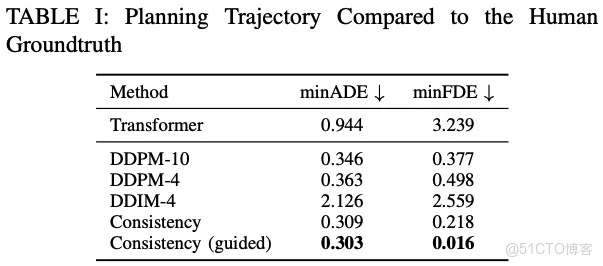

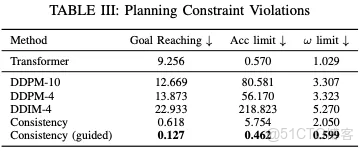

我們通過 Waymo 運動預測挑戰賽的指標,定量評估了自我車輛相對於人類地面實況的規劃性能,如下表所示。

編輯

通過表格中的實驗結果可以看出,結果與我們的定性觀察結果一致:我們的一致性模型實現了最低的 minADE 和 minFDE,表明它很好地捕捉了人類的駕駛模式。此外,添加引導採樣顯著改善了一致性模型的 minFDE,因為它明確地納入了實現目標的約束。

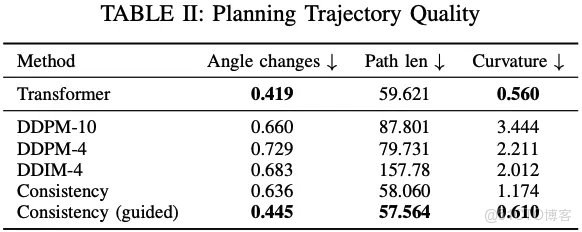

此外,我們使用三個表徵駕駛行為的指標來評估軌跡質量,如下表所示。

編輯

此外,下圖中展示了我們的方法在選擇目標位置方面的靈活性。我們的一致性模型在瞄準新的目標位置時保持高質量的軌跡規劃,即使它們不在數據集中。

編輯

我們的預測規劃器的一個關鍵優勢是它能夠確保與交通中的其他道路使用者安全有效地互動。我們的規劃器展示了生成主動行為的能力,如下圖所示。

編輯

通過下表可以看出,我們的基礎一致性模型已經實現了比其他基於擴散的方法更準確的目標達成和更流暢的行為。

編輯

通過引導採樣,達到所有方法中的最低值。需要注意的是,這種改進不需要模型重新訓練,並且僅適用於推理期間。

結論

在本文中,我們提出了一種新穎的數據驅動方法,該方法使用一致性模型統一了軌跡預測和規劃。通過對自車和周圍代理的軌跡的聯合分佈進行建模,我們的方法可以實現高效和交互式的規劃,而無需在預測和規劃模塊之間進行迭代交替。實驗結果表明,與現有方法相比,我們的方法實現了卓越的軌跡質量和交互行為,同時需要更少的採樣步驟。

....

#DenseSplat

五邊形戰士:首個無縫結合NeRF和3DGS的SLAM系統3DGS對關鍵幀的依賴

視覺稠密同時定位與建圖(SLAM)是三維計算機視覺領域的核心研究方向,主要關注於實時定位相機位置並生成周圍環境的高精度地圖。該技術在機器人定位與導航、自動駕駛以及虛擬/增強現實(VR/AR)等領域發揮着關鍵作用。

近年來,基於可微渲染的突破性進展,特別是神經輻射場(NeRF)和三維高斯噴濺(3DGS),顯著推動了視覺稠密 SLAM 系統的發展。基於 NeRF 的神經隱式 SLAM 通過將 NeRF 模型與同時跟蹤和建圖相結合,實現了高質量的在線密集地圖重建,並大幅提升了幾何精度。在此基礎上,高斯 SLAM 系統進一步拓展了研究邊界,提供了更高保真的地圖重建。3DGS 採用顯式高斯原語,具備細節紋理表現力強、可顯式操控場景以及卓越的實時渲染能力等優勢。

然而,在 SLAM 系統的應用中,3DGS 仍然面臨一定挑戰。與常見的離線重建不同,SLAM 需要在有限的計算資源下進行在線處理,而 3DGS 依賴於大量關鍵幀來優化場景的幾何和外觀。這種依賴性在機器人應用中尤為突出,因為機器人往往只能從稀疏的視角觀察場景,導致地圖中存在大量空洞。此外,當前高斯 SLAM 系統大多缺乏迴環檢測和捆綁調整(BA)機制,這可能導致跟蹤誤差積累並影響長期建圖的精度。

本文介紹的DenseSplat[1]是首個結合 NeRF 和 3DGS 優勢的 SLAM 系統。DenseSplat 通過利用 NeRF 先驗信息來引導高斯原語的初始化,從而在稀疏關鍵幀條件下生成密集的地圖表示,並有效填補未觀察到的區域。此外,我們設計了基於幾何的原語採樣和修剪策略,以優化粒度並提高渲染效率。更進一步,DenseSplat 結合了迴環檢測和捆綁調整,以提高跟蹤魯棒性並減少漂移誤差。

主要貢獻:

提出 DenseSplat,這是首個利用 NeRF 先驗優化 3DGS 的視覺 SLAM 系統,在稀疏關鍵幀條件下實現高質量地圖重建。

設計了一種基於幾何的高斯原語採樣和修剪策略,以優化渲染效率並減少無關原語的影響。

集成了迴環檢測和捆綁調整,顯著提高了幀間跟蹤精度,減少了誤差積累。

在多個大規模數據集上進行實驗,結果表明 DenseSplat 在跟蹤和建圖方面均優於現有的最先進方法。

具體方法

圖 2 展示了 DenseSplat 的整體流程。系統以 RGB-D 數據流 作為輸入,並通過同時優化相機位姿和神經輻射場 進行跟蹤。隨後,系統利用從隱式輻射場採樣的點來引導高斯原語的初始化,以實現高精度的地圖重建和場景插值。為了減少漂移誤差,我們在高斯地圖上實施了局部迴環檢測和捆綁調整。最後,介紹了整個建圖過程中的損失計算方法以及有效降低系統內存消耗的子地圖劃分策略。

神經輻射先驗

神經輻射渲染基礎

NeRF 模型 是一個連續函數,用於預測沿採樣光線 的顏色 和體密度 。具體而言,給定相機原點 和光線方向 ,我們在光線方向上均勻採樣 個點 (其中 ),然後使用光線行進(ray marching)計算像素顏色 :

其中 表示透射率, 是點 處的透明度, 表示相鄰採樣點之間的間距。輻射場 由一個帶 ReLU 激活函數的 MLP 參數化,並通過梯度下降優化,以最小化光度損失:

其中, 表示來自具有有效深度測量的光線集合的一個批次, 是真實顏色值。

基於 NeRF 的相機跟蹤

我們通過優化 NeRF 的目標函數來跟蹤每一幀的相機到世界變換矩陣 。相機位姿初始化遵循恆定速度假設:

在此,我們僅利用 NeRF 模型進行逐幀相機跟蹤,之後基於精細化的高斯地圖進行迴環檢測和捆綁調整,以糾正累積漂移誤差(詳見第 III-C 節)。

基於幾何的點採樣

與需要密集視角優化場景的顯式高斯表示不同,基於 NeRF 的模型在插值能力方面表現優異,可以推斷出未觀測到的幾何信息。為了在實時場景中高效利用這一能力,我們採用了多分辨率哈希輻射場,該方法能夠在不同分辨率下精確獲取體數據,特別是在稀疏採樣區域內捕捉詳細的表面幾何。我們通過設置密度閾值 識別關鍵的表面過渡區域,並使用以下公式進行插值計算:

其中, 和 為採樣網格點, 表示體密度。隨後,我們將這些點彙總為點雲。這種方法利用 NeRF 的強大插值能力,實現了密集、基於幾何的高斯原語初始化,並在後續的建圖步驟中進一步優化。

精細化高斯地圖

多尺度高斯渲染

通過從 NeRF 模型進行網格採樣初始化,我們使用一組各向異性的 3D 高斯原語 來表示場景。每個高斯原語 由均值 、協方差矩陣 、不透明度值 、三階球諧係數 以及縮放因子 組成。在渲染過程中,這些高斯原語首先投影到 2D 平面上,轉換為 2D 高斯。轉換過程使用視圖矩陣 ,2D 協方差矩陣 計算如下:

其中 是仿射投影的雅可比矩陣。2D 高斯的均值 通過 將 投影到圖像平面上。隨後,這些投影的高斯按照從近到遠的順序排序,並使用類似於光線行進的 alpha 混合過程進行渲染,最終得到光柵化的像素顏色 和深度值 。

射線引導的高斯修剪

從 NeRF 模型進行採樣時,可能會引入誤差的高斯浮動原語和異常值,這些都可能影響重建質量。為了減少密集化過程中產生的冗餘高斯原語並提高渲染效率,我們實施了基於射線的修剪策略。具體來説,我們使用重要性評估來識別和去除在優化過程中不活躍的高斯原語。每個高斯原語的 重要性 通過它對所有輸入圖像 上採樣光線的貢獻來量化。靈感來自於之前的研究,我們通過以下公式對每個原語進行評分:

其中 捕捉了高斯原語 對像素顏色預測的貢獻。然後,我們通過以下公式計算修剪掩碼:

其中,低於修剪閾值 的原語會從地圖中去除。需要注意的是,由 NeRF 模型初始化的高斯原語不參與此修剪過程,以避免去除那些用於橋接遮擋視角的原語,從而保證場景的可管理粒度。

多尺度高斯渲染策略

高斯原語的多尺度渲染策略通過合併較小的高斯原語來提高場景的一致性,尤其在較細粒度的層次中有效。具體來説,我們使用四個不同分辨率的高斯函數進行渲染,分別對應於 1×、4×、16× 和 64× 的降採樣分辨率。在訓練過程中,我們將較小的細節級別的高斯合併到較大的粗糙級別的高斯中。選擇哪些高斯進行合併,是根據像素覆蓋範圍來確定的,覆蓋範圍由該區域內的最高頻率成分的倒數 來決定,其中 為縮放因子。

通過這種方式,我們能夠有效地合併較小的高斯原語,從而避免渲染過程中出現混疊效應,提高地圖的質量和一致性。

迴環檢測和捆綁調整

在捆綁調整(BA)過程中,我們使用詞袋(BoW)模型來確定關鍵幀之間的相關性。一旦檢測到迴環,就會觸發對涉及關鍵幀的 BA 過程。為了在 BA 之後保持地圖的幾何和視覺一致性,我們調整渲染顏色 和深度 ,並使用估計的相對位姿變換 對共視關鍵幀 進行變換。我們構造 BA 損失如下:

高斯地圖優化

建圖目標函數

在我們的實驗中,我們觀察到在捆綁調整(BA)過程中,聚合的高斯原語可能會經歷尺度膨脹,進而可能在地圖中引入偽影。為了緩解這一問題,我們引入了 L2 正則化損失 ,該損失用於對尺度超過閾值 的高斯原語進行懲罰。因此,整體的建圖損失定義為:

其中, 和 分別表示輸入流的真實顏色和深度。SSIM 損失用於計算渲染圖像與真實圖像之間的結構相似性。係數 ,, 和 是加權超參數。

子地圖劃分與融合

在大規模環境中部署 SLAM 系統時,密集建圖帶來的過度內存消耗是實際應用中的一個關鍵問題。為了解決這一問題,我們採用了一種簡單而有效的子地圖劃分與融合策略,如算法 1 所示。具體而言,我們將輸入幀按每 400 幀為一個間隔進行子地圖劃分,結構如下:

其中, 表示每個子地圖,用於開發 NeRF 模型和後續的高斯地圖。儘管顯式的高斯表示使得子地圖可以無縫地合併為一個全局地圖,但直接融合子地圖仍然是一個具有挑戰性的任務。我們借鑑 Mipsfusion 的思路,在子地圖融合過程中使用錨幀捆綁調整(BA)來實現精確對齊,並確保子地圖邊界的無縫融合。每個子地圖的錨定是基於其第一幀的估計位姿進行的。完成 BA 後,我們精確調整每個子地圖的中心位姿,以確保準確的重新錨定。

我們的子地圖策略通過允許每個子地圖的並行構建,顯著減少了內存消耗,從而緩解了全局地圖持續擴展帶來的問題。

實驗效果

總結一下

DenseSplat是首個無縫結合 NeRF 和 3DGS 優勢的 視覺稠密 SLAM 系統,用於實現魯棒的跟蹤和建圖。DenseSplat 主要針對現實應用中的挑戰,例如 遮擋視角、計算硬件限制導致的關鍵幀稀疏性 等問題。該方法通過 NeRF 先驗 提升了高斯原語的插值能力,並優化了在較少關鍵幀條件下的 SLAM 性能,從而實現了 精細化的場景重建 和 卓越的實時表現。未來研究方向可以包括 在移動端應用中實現該系統,或在 多智能體協作系統 中推廣 DenseSplat,並進一步在真實環境中進行實驗。

限制性:其場景插值能力依賴於 NeRF,因此繼承了 NeRF 的一些限制。當缺失區域過大,且 NeRF 無法有效捕捉幾何信息時,我們的方法和 NeRF 一樣 難以填補這些空洞,導致部分區域在重建地圖中仍然欠缺。此外,由於 DenseSplat 採用 顯式高斯原語 進行場景表示,其存儲 高保真地圖 需要的內存比 NeRF 模型更大(後者採用 隱式神經表示)。儘管 DenseSplat 通過 子地圖系統 來減少計算過程中的內存消耗,但仍然存在優化空間,未來的研究可以探索更先進的 子地圖管理策略,以在 多智能體系統 中實現更好的擴展性。

....

#Invertible Diffusion Models for Compressed Sensing

一、論文信息

- 論文標題:Invertible Diffusion Models for Compressed Sensing

- 論文作者:Bin Chen(陳斌), Zhenyu Zhang(張振宇), Weiqi Li(李瑋琦), Chen Zhao(趙琛), Jiwen Yu(餘濟聞), Shijie Zhao(趙世傑), Jie Chen(陳杰) and Jian Zhang(張健)

- 作者單位:北京大學信息工程學院、阿卜杜拉國王科技大學、字節跳動

- 發表刊物:IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI)

- 發表時間:2025年2月5日

- 正式版本:https://ieeexplore.ieee.org/document/10874182

- ArXiv版本:https://arxiv.org/abs/2403.17006

- 開源代碼:https://github.com/Guaishou74851/IDM

二、任務背景

擴散模型作為當前非常知名且強大的生成模型之一,已在圖像重建任務中展現出極大的潛力。擴散模型的基本實現方式是在訓練階段構建一個噪聲估計網絡(通常是一個UNet),並在推理階段通過迭代的去噪和加噪過程完成圖像生成與重建。然而,如何進一步提升擴散模型在圖像重建中的性能與效率,仍然是業界探索的重點問題。

當我們將擴散模型應用於圖像重建任務時,面臨兩個關鍵挑戰:

- 挑戰一:“噪聲估計”任務與“圖像重建”任務之間的偏差。擴散模型中的深度神經網絡主要針對“噪聲估計”任務(即,從當前變量中估計出噪聲)得到最優化,而非“圖像重建”任務(即,從低質量的觀測數據中預測原始圖像)本身。這可能導致其圖像重建性能存在進一步提升的空間。

- 挑戰二:推理速度慢、效率低。儘管擴散模型能夠生成較為真實的圖像,但其推理過程往往需要大量的迭代步驟,運行時間長,計算開銷大,不利於實際應用。

針對這兩個挑戰,本文提出了一種可逆擴散模型(Invertible Diffusion Models,IDM)。這一方法通過引入(1)端到端的訓練框架與(2)可逆網絡設計,有效提升了圖像重建的性能與效率。

三、主要貢獻

我們的方法在圖像重建任務中帶來了兩個主要創新:

1. 端到端的擴散採樣圖像重建學習框架

傳統擴散模型在訓練階段的目標任務是“噪聲估計”,而實際的目標任務是“圖像重建”。為了提升擴散模型的圖像重建性能,我們將它的迭代採樣過程重新定義為一個整體的圖像重建網絡,對該網絡進行端到端的訓練,突破了傳統噪聲估計學習範式所帶來的侷限。如圖所示,通過這種方式,模型的所有參數都針對“圖像重建”任務進行了最優化,重建性能得到大幅提升。實驗結果表明,基於Stable Diffusion的預訓練權重與這一端到端學習框架,在圖像壓縮感知重建任務中,相比其他模型,我們的方法在PSNR(峯值信噪比)指標上提升了2dB,採樣步數從原本的100步降到了3步,推理速度提升了約15倍。

2. 雙層可逆網絡設計:減少內存開銷

大型擴散模型(如Stable Diffusion)採樣過程的端到端訓練需要佔用很大的GPU內存,這對於其實際應用來説是一個嚴重的瓶頸。為了減少內存開銷,我們提出了一種雙層可逆網絡。可逆網絡的核心思想是通過設計特殊的網絡結構,讓網絡每一層的輸出可以反向計算得到輸入。在實踐中,我們將可逆網絡應用到(1)所有擴散採樣步驟和(2)噪聲估計網絡的內部,通過“佈線”技術將每個採樣步驟與其前後模塊連接,形成一個雙層可逆網絡。這一設計使得整個訓練過程中,程序無需存儲完整的特徵圖數據,只需存儲較少的中間變量,顯著降低了訓練模型的GPU內存需求。最終,這使得我們可以在顯存有限的GPU(如1080Ti)上對該模型進行端到端訓練。

四、實驗結果1. 圖像壓縮感知重建

在圖像壓縮感知重建任務中,我們的方法IDM與現有基於端到端網絡和擴散模型的重建方法進行了對比。實驗結果顯示,IDM在PSNR、SSIM、FID和LPIPS等指標上取得明顯提升。

2. 圖像補全與醫學成像

在掩碼率90%的圖像補全任務中,我們的方法能夠準確恢復出窗户等複雜結構,而傳統的擴散模型(如DDNM)無法做到這一點。此外,我們還將該方法應用於醫學影像領域,包括核磁共振成像(MRI)和計算機斷層掃描(CT)成像,取得了良好的效果。

3. 計算成本與推理時間的優化

基於傳統擴散模型的圖像重建方法往往需要較長的推理時間和計算開銷,而我們的可逆擴散模型IDM顯著縮短了這一過程。在重建一張256×256大小的圖像時,推理時間從9秒縮短至0.63秒,大幅降低了計算開銷。與現有方法DDNM相比,IDM的訓練、推理效率和重建性能得到了顯著提升。

欲瞭解更多細節,請參考原論文。

五、作者簡介

- 陳斌:北京大學信息工程學院博士生,主要研究方向是圖像壓縮感知與超分辨率。

- 張振宇:北京大學信息工程學院碩士生,主要研究方向是圖像重建。

- 李瑋琦:北京大學信息工程學院博士生,主要研究方向是圖像壓縮感知與超分辨率。

- 趙琛:沙特阿卜杜拉國王科技大學(KAUST)的研究科學家,圖像與視頻理解實驗室(IVUL)視頻分析課題組組長。她首次提出了可逆化預訓練神經網絡方法,實現了大型預訓練模型的極低顯存微調。她在這一領域的代表工作包括Re2TAL(CVPR 2023)、Dr2Net (CVPR 2024)等。個人主頁:https://zhao-chen.com/。

- 餘濟聞:北京大學信息工程學院碩士生,主要研究方向是生成式擴散模型。

- 趙世傑:字節跳動多媒體實驗室研究員,負責視頻處理與增強課題組。

- 陳杰:北京大學信息工程學院副教授,主要研究方向是計算機視覺與模式識別和AI4Science。個人主頁:https://aimia-pku.github.io/。

- 張健:北京大學信息工程學院副教授,主要研究方向是視覺內容重建與生成、AIGC內容鑑偽和版權保護。個人主頁:https://jianzhang.tech/cn/。

....

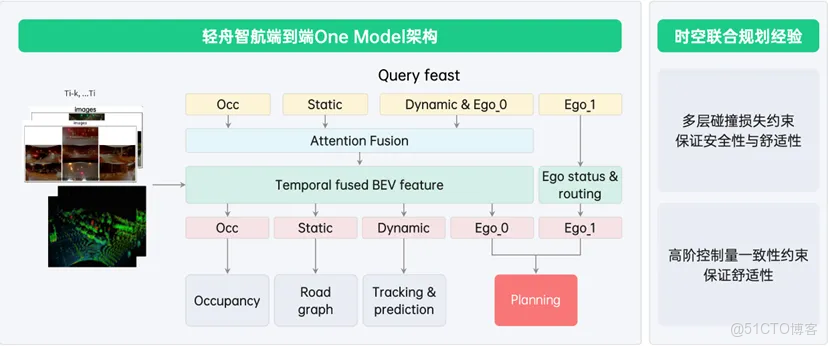

#以技術創新驅動安全智駕

輕舟智航首創「安全的端到端」

近日,輕舟智航正式啓動以「安全智駕」為核心的「安全+」品牌戰略,首次創新性地提出「安全的端到端」技術架構,併發布安全智駕新範式,以更先進的技術範式、更完善的安全冗餘、更主動的安全反饋,突破3個指數“9”,推動智駕安全從“99.99%”向“99.99999%”進化。同時,輕舟智航將面向用户、客户和行業,從“產品、品牌、可持續發展”打造三位一體的全面“安全感”,向更高等級自動駕駛邁進。

安全紅線是智駕發展的“生命線”。隨着NOA規模化量產上車,任何不安全問題都將凸顯;安全是智駕真正贏得用户信賴,讓用户願用、愛用的底線,更是L3時代到來的門檻條件。然而,安全≠保守,輕舟智航向以技術創新驅動汽車安全的先行者致敬,致力於做「安全智駕護航者」,堅定不移地通過技術創新,持續驅動智駕體驗更安全。

無論中配、高配,安全都是頂配

輕舟智航憑藉三大優勢,量·質齊飛,確保智駕系統的安全,各項量產安全指標均已躋身業內最高水準梯隊:

- 源於L4級自動駕駛的技術基因:成熟的L4開發經驗,讓安全思維根植於心;完善安全冗餘設計,充分考慮各個單點甚至子系統失效的可能性,來確保極端情況下的安全處理。

- 以安全為導向的開發流程和質量管理體系:研發體系基於安全設計,由安全倒推技術創新和軟件質量要求,包括代碼質量,評測系統,面向自動駕駛的CI/CD系統設計與開發,設計文檔審查,問題修復機制等,通過紮實的工程質量來確保軟件質量。

- 50萬+行業領先的大規模量產交付:基於大量的用户數據和問題反饋,持續利用數據閉環及問題修復流程,提升軟件質量,形成有效的安全正循環。

編輯

如何實現更安全的智駕體驗,輕舟智航提出全新命題,以突破3個指數“9”的全新範式,讓智駕安全從“99.99%”向“99.99999%”進化。

編輯

第一個“9”:更先進的技術範式,解決長尾問題

端到端已成為智駕技術發展的必然趨勢,但其安全下限低的問題一直是行業尋求突破的痛點。輕舟智航團隊基於NOA大規模量產經驗及在端到端和大模型技術上的深入探索,首次創新性地提出「安全的端到端」,將獨創且已得到充分量產驗證的“時空聯合規劃”的經驗融入One Model 端到端模型設計中,保證行車的安全與舒適。比如,在線模型訓練層面,加入了多層碰撞的損失約束,來保證安全性;並添加了高階控制量一致性約束,來保證舒適性。

編輯

編輯

同時,類比大模型的安全對齊,輕舟智航獨創端到端模型的安全對齊,讓模型規劃的軌跡符合人為定義的安全機制。安全機制充分借鑑時空聯合規劃的規則和限制,融入到網絡訓練中。具體而言體現在兩方面:

- 在軌跡生成過程中,借鑑圖文生成中條件生成的方法,將安全規則作為“教師”,在模型軌跡生成過程中引入額外的指導信號,以增加對生成過程的控制,引導軌跡朝特定方向發展,滿足安全性。

- 基於大語言模型的訓練過程,將安全規則作為獎勵函數,對模型進行微調,進一步增加模型的安全性。

綜上,從而確保整個端到端模型既可以充分發揮靈活、上限高的優勢,又可以做到下限高、更安全。

另外,針對離線的端到端模型訓練,輕舟智航創新性地構建了基於運動模擬的世界模型。相較於傳統世界模型,基於運動模擬的世界模型可以批量生產大量的長尾場景和罕見的安全臨界場景,同時生成的仿真視頻更加可控,保證了時序、空間位置、物體幾何、物理規則的一致性和正確性,從而保證端到端系統的安全性。

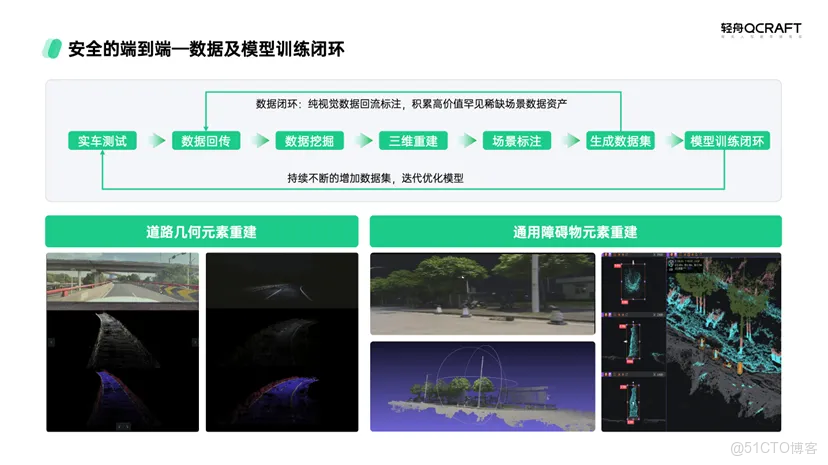

高效的數據和模型訓練閉環是端到端體驗和安全不斷進化的基礎。輕舟智航作為高級別自動駕駛解決方案提供商,在數據工具鏈方面具備天然優勢,基於自動駕駛超級工廠「輕舟矩陣」,實現從數據回傳、數據挖掘、三維重建、自動化標註、數據生成到模型訓練的完整數據閉環平台,可以實現天級別的閉環和迭代,以高效的數據轉動持續解決各類複雜的長尾問題。

編輯

第二個“9”:更完善的安全冗餘,應對安全失效

輕舟智航在智駕系統設計中,充分考慮各個單點甚至子系統失效的可能性,構建了完善的冗餘設計,可有效應對各類安全失效問題。在硬件層面,域控的診斷模塊會監控域控內外的各類故障,監控到故障後功能狀態機會採取降級措施,並通知用户接管。若用户長時間未接管,系統還會自動引導車輛安全停車,並上傳整個過程數據至雲平台分析。在模型冗餘層面,已量產採用 BEV+Mono 兩套視覺架構模型,可在其中一套失效時繼續工作,確保感知結果不受影響。

第三個“9”:更主動的安全反饋,提升人機交互

基於大量用户使用數據和反饋,針對可能存在用户安全風險的場景,輕舟智航與頭部新勢力車企客户聯合首創並落地了多種安全策略功能,可以通過主動的人機交互反饋,進行主動式安全保護,為用户帶來更多“安全感”。

編輯

編輯

以「安全+」品牌戰略,打造三位一體的全面“安全感”

安全既是紅線,也是輕舟智航做好智駕產品的基本態度。隨着2025 NOA規模化量產加速及自動駕駛向更高等級邁進,輕舟智航從“安全”到“安全感”全面思考,從產品、品牌到可持續發展的三位一體,為用户、客户及行業帶來滿滿的安全感。

編輯

- 面向用户,輕舟智航秉承「安全一票否決制」的產品理念,以全方位的安全策略保障產品安全,讓輕舟方案的產品均做到安全可信任。

- 面向客户,輕舟智航以持續技術引領的創新力、100%支持投入的生態力、健康穩健品牌向上的發展力,與客户建立充分的信賴,助力車企決勝智能化下半場。

- 面向行業,輕舟智航將依託深厚的L4技術積累和豐富的L2++量產經驗,堅定不移地推動自動駕駛從L2++向L3、L4的技術實現和商業閉環,為行業的可持續發展帶來更多信心,逐步將無人駕駛帶進現實,通向更廣闊的通用人工智能。輕舟智航將攜手車企率先推動“事實性L3”的落地,一方面以技術創新切實確保用户智駕安全;另一方面基於產品的大規模的量產驗證、海量用户智駕使用數據的反饋支撐及快速的技術迭代和問題修復能力,提出敢賠模式,通過保險兜底的方式,為用户帶來極致安全保障及可靠安心保障,真正降低用户對智駕的心理門檻,讓智駕成為用户願意付費的必選功能,推動智駕市場體量的指數級增長。

....

#論文推土機World Models一覽~

Ha, D., & Schmidhuber, J. (n.d.). World Models. world model的工作模式和自動駕駛預測決策規劃如出一轍,我認為world model是自動駕駛數據驅動方式的終局方案。perception對應V model, 預測對應M model,決策規劃則是C model,在感知輸入下,world model具有ego action對環境影響的判斷能力,可以預測出next Z, 通過ego action的rollouts獲得這種自車行為對未來的影響與演化過程,最後找到best policy,這不就是自動駕駛在做的事情嗎。

world model

world model的組成有兩部分:vision model + memory model. 其中vision model將高維度視覺信息轉變成低維度信息,這裏通過VAE完成:

memory model採用了MDN-RNN模型實現,説白了就是混合高斯模型+LSTM. memory模塊要維護一個latent state h, 它用於存儲歷史信息。此外他還要有預測未來的能力:“we also want to compress what happens over time. For this purpose, the role of the M model is to predict the future.”未來的狀態記為z:“we train our RNN to output a probability density function p(z) instead of a deterministic prediction of z”。那這裏有一個説法,關於z怎麼表達,不同文章有不同的做法,比如可以是deterministic的做法,直接就是確定的z, 或者是這裏的gaussian distribution用於容納不確定性,也有dreamer系列的做法,搞成discrete的形式。下圖表達了world model的結構,不過這裏還不完整,少了action.

所以更準確的表達是帶上action:

訓練:

vision, memory and control三部分都是互相獨立的,各訓練各自的即可:

vision部分就是要訓練一個重建任務:

memory部分是要訓練一個對未來的預測任務:

在後面的附錄裏面還有一個更明確的圖:

RNN輸出兩個東西,一個是latent state h: "M will then take the current zt and action at as an input to update its own hidden state to produce ht+1 to be used at time t + 1.", 還有一個未來的預測z。看到這裏的温度係數,用於加入噪聲,温度係數越大,則對網絡施加的干擾越大。文中説到可以“adjust τ to control the uncertainty of the environment generated by M”。

controller就是參數量極小的MLP: = + , 訓練過程也很簡單,就是在rollouts中找打reward最高的rollout。文章強調:“In our experiments, we deliberately make C as simple and small as possible, and trained separately from V and M, so that most of our agent's complexity resides in the world model (V and M).”就是要用很小的C,來把壓力全部給到V and M. 後面實驗的參數量也可以看到:

網絡的一次循環偽代碼如下:

- 感知輸入進行encoding

- controller輸入z,h 計算action

- rnn輸入action, z,h更新h

實驗

第一個實驗式car racing。做了一個ablation, 説這個controller不給他h, 只有當前v行不行,答案是不行:

然後説既然這個world model可以自己預測未來,是不是可以直接在world model的閉環中實現自我學習:“This begs the question – can we train our agent to learn inside of its own dream, and transfer this policy back to the actual environment?”

那必須的,world model不就是用來幹這個的嘛:“Since our world model is able to model the future, we are also able to have it come up with hypothetical car racing scenarios on its own. We can ask it to produce the probability distribution of zt+1 given the current states, sample a zt+1and use this sample as the real observation. We can put our trained C back into this hallucinated environment generated by M”,事實上,在下一個實驗中就詳細論證了這個自我學習過程,然後應用到真實環境中的思路。

VizDoom:

這個實驗中強調了以下幾點:

温度係數的作用

“we note that it is possible to add extra uncertainty into the virtual environment, thus making the game more challenging in the dream environment. We can do this by increasing the temperature τ parameter during the sampling process of zt+1”,説我們可以通過調整温度係數來在M model的訓練過程中引入更多的不確定性,這樣可以讓模型學的更厲害,“In fact, increasing τ helps prevent our controller from taking advantage of the imperfections of our world model。”然後從後面的實驗結果中也可以看到,提升係數可以讓模型的虛擬表現和真實表現更加接近:

表達能力和決策能力

我們並不需要V model用來完美重建,這個和後面的M and C的表現不完全相關,V只要能夠提供信息的壓縮即可。“even though the V model is not able to capture all of the details of each frame correctly, for instance, getting the number of monsters correct, the agent is still able to use the learned policy to navigate in the real environment”。

iterative training

在環境比較複雜的時候,可以採用迭代學習策略“We need our agent to be able to explore its world, and constantly collect new observations so that its world model can be improved and refined over time”,因為你不可能直接一下子學到複雜環境的world model, 而我們的自學習過程又需要好的world model給到action-state的未來預測能力,所以這個時候就可以迭代學習:

....

#自動駕駛規劃與決策技術前沿

從擴散模型到強化學習的創新突破

1、 題目:Diffusion-Based Planning for Autonomous Driving with Flexible Guidance

鏈接:xxx

簡介:Diffusion Planner:基於擴散的柔性引導自動駕駛規劃

時間:2025-01-28T23:52:12.534+0800

2、 題目:Evaluating Scenario-based Decision-making for Interactive Autonomous Driving Using Rational Criteria: A Survey

鏈接:xx

簡介:全面綜述DRL算法在典型自動駕駛場景中的應用,概括了道路特徵及其最新進展

時間:2025-01-06T23:04:15.661+0800

3、 題目:Exploring Critical Testing Scenarios for Decision-Making Policies: An LLM Approach

鏈接:xxx

簡介:探索決策策略的關鍵測試場景:一種LLM方法

時間:2024-12-10T22:36:42.652+0800

4、 題目:Why Studying Cut-ins? Comparing Cut-ins and Other Lane Changes Based on Naturalistic Driving Data

鏈接:xxx

簡介:基於自然駕駛數據的正常變道和cut-in的比較研究

時間:2024-02-16T21:47:39.587+0800

5、 題目:Reinforcement Learning for Freeway Lane-Change Regulation via Connected Vehicles

鏈接:xxx

簡介:更優的變道策略:一種基於多智能體強化學習(MARL)的動態變道調控設計

時間:2024-12-08T21:25:02.106+0800

6、 題目:LHPF: Look back the History and Plan for the Future in Autonomous Driving

鏈接:xxx

簡介:LHPF:一種集成歷史規劃信息的模仿學習規劃器

時間:2024-11-27T23:41:12.178+0800

7、 題目:Explanation for Trajectory Planning using Multi-modal Large Language Model for Autonomous Driving

鏈接:xxx

簡介:基於多模態大語言模型的自動駕駛軌跡規劃解釋

時間:2024-11-18T22:48:03.082+0800

8、 題目:SwapTransformer: highway overtaking tactical planner model via imitation learning on OSHA dataset

鏈接:xxx

簡介:SwapTransformer:基於OSHA數據集的模仿學習高速公路超車策略規劃模型

時間:2024-01-04T21:09:06.440+0800

9、 題目:EMPERROR: A Flexible Generative Perception Error Model for Probing Self-Driving Planners

鏈接:xxx

簡介:EMPERROR:一種基於Transformer的生成性PEM,並將其應用於壓力測試模仿學習(IL)基礎的規劃器

時間:2024-11-13T23:10:25.697+0800

10、 題目:DP and QP Based Decision-making and Planning for Autonomous Vehicle

鏈接:xxx

簡介:基於DP和QP的自動駕駛汽車決策與規劃

時間:2024-11-12T23:03:53.713+0800

11、 題目:Maneuver Decision-Making with Trajectory Streams Prediction for Autonomous Vehicles

鏈接:xxx

簡介:FFStreams++:用於不同動作(如無保護左轉、超車和保持車道)的決策制定和運動規劃

時間:2024-09-17T20:24:18.288+0800

12、 題目:Reliable Reinforcement Learning for Decision-Making in Autonomous Driving

鏈接:xxx

簡介:分享密歇根大學的一篇博士論文,主要研究用於自動駕駛決策的可靠強化學習!

時間:2024-09-08T16:18:28.248+0800

13、 題目:End-to-End Autonomous Driving Decision Method Based on Improved TD3 Algorithm in Complex Scenarios

鏈接:xxx

簡介:複雜場景下基於改進TD3算法的端到端自動駕駛決策方法

時間:2024-08-05T22:37:17.618+0800

14、 題目:Enhancing Autonomous Driving Navigation Using Soft Actor-Critic

鏈接:xxx

簡介:近年來,自動駕駛汽車在學術界和工業界引起了廣泛關注。對於這些自動駕駛汽車來説,由於交通參與者的不可預測行為和複雜的道路佈局,城市環境中的決策帶來了重大挑戰。雖然基於深度強化學習(DRL)的現有決策方法顯示出解決城市駕駛情況的潛力,但它們的收斂速度較慢,尤其是在具有高機動性的複雜場景中。在本文中,提出了一種基於Soft Actor-Critic(SAC)算法的新方法來控制自動駕駛汽車平穩、安全地進入環形交叉口,並確保其毫不延遲地到達目的地。為此,引入了一種使用卷積神經網絡(CNN)與提取的特徵連接的目標向量。為了評估模型的性能,在CARLA仿真器中進行了大量實驗,並將其與深度Q網絡(DQN)和近端策略優化(PPO)模型進行了比較。定性結果表明,與DQN和PPO模型相比,模型在高流量的場景中快速收斂,並取得了很高的成功率。

時間:2024-07-07T17:16:43.929+0800

15、 題目:An automatic driving trajectory planning approach in complex traffic scenarios based on integrated driver style inference and deep reinforcement learning

鏈接:xxx

簡介:如何解決複雜交通場景(如無信號燈交叉口)中對規劃提出的挑戰?

時間:2024-01-28T19:13:05.951+0800

16、 題目:SDS++: Online Situation-Aware Drivable Space Estimation for Automated Driving

鏈接:xxx

簡介:SDS++,旨在克服SDS的缺點,同時保留其優點

時間:2024-06-10T23:15:50.615+0800

17、 題目:Can Vehicle Motion Planning Generalize to Realistic Long-tail Scenarios?

鏈接:xxx

簡介:車輛運動規劃能推廣到真實的長尾場景嗎?

時間:2024-04-12T23:09:46.682+0800

18、 題目:Towards learning-based planning: The nuPlan benchmark for real-world autonomous driving

鏈接:xxx

簡介:走向基於學習的規劃!現實世界自動駕駛的 nuPlan 基準

時間:2024-03-08T21:02:04.441+0800

19、 題目:On the Road to Portability: Compressing End-to-End Motion Planner for Autonomous Driving

鏈接:xxx

簡介:CVPR 2024 第一個專為壓縮端到端運動規劃器而設計的知識蒸餾框架

時間:2024-03-05T23:17:52.301+0800

從基於擴散模型的柔性軌跡生成,到結合大語言模型的可解釋性規劃;從面向長尾場景的魯棒性強化學習,到輕量化端到端規劃器的知識蒸餾——這些研究不僅展現了自動駕駛決策技術的多樣性與創新性,也揭示了未來發展的關鍵趨勢:多技術融合、場景化深耕與系統級驗證。然而,如何將這些算法真正落地於複雜現實世界,仍需在安全邊界定義、動態交互建模和人類駕駛行為兼容性上持續突破。可以預見,隨着仿真基準(如nuPlan)的完善和生成式誤差模型(如EMPERROR)的引入,自動駕駛的“智能進化”將加速邁向更高階的自主性與可靠性。

....

#RAD

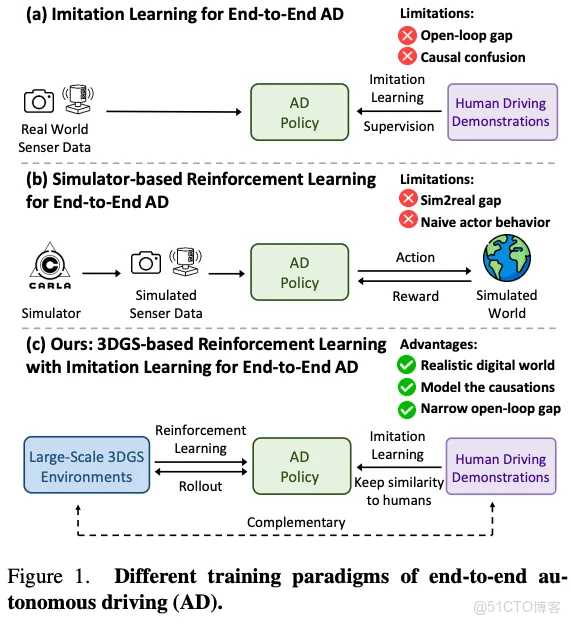

端到端訓練新範式!華科&地平線RAD:基於3DGS的閉環強化學習SOTA!性能提升3倍~個人理解

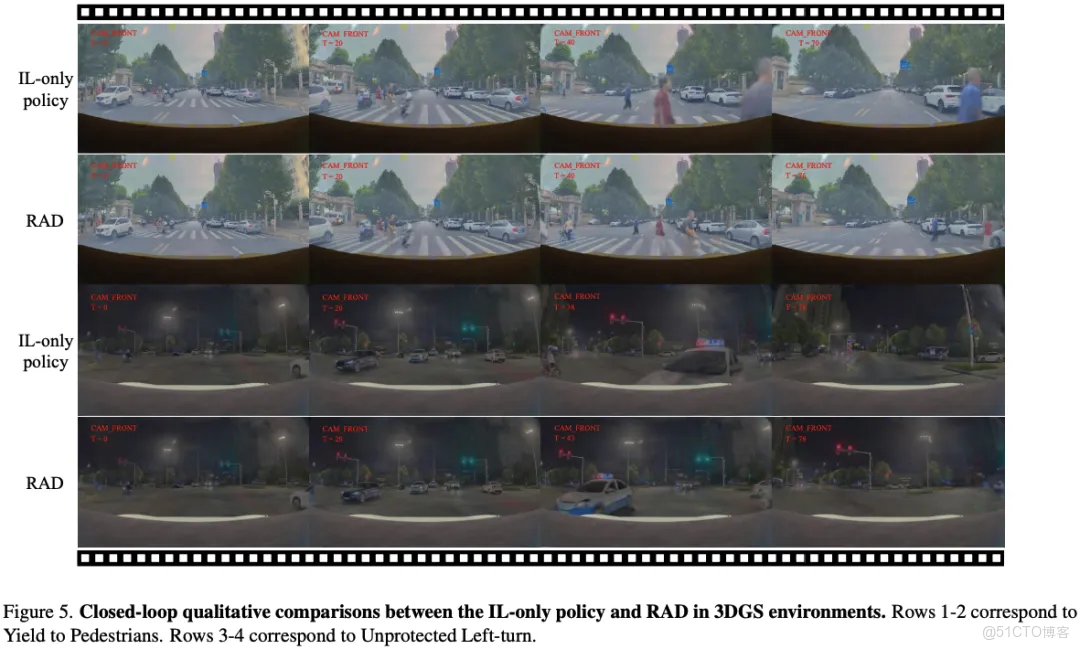

現有的端到端自動駕駛(AD)算法通常遵循模仿學習(IL)範式,這面臨着因果混淆和開環Gap等挑戰。在這項工作中,我們建立了一個基於3DGS的閉環強化學習(RL)訓練範式。通過利用3DGS技術,可以構建真實物理世界的真實仿真結果,使AD策略能夠廣泛探索狀態空間,並通過大規模試錯學習處理分佈外場景。為了提高安全性,我們設計了專門的獎勵機制,引導策略有效應對安全關鍵事件並理解現實世界的因果關係。為了更好地與人類駕駛行為對齊,IL被納入RL訓練作為正則化項。我們引入了一個由多樣且以前未見過的3DGS環境組成的閉環評估基準。與基於IL的方法相比,RAD在大多數閉環指標中表現更強,尤其是碰撞率降低了3倍。

- 項目主頁:https://hgao-cv.github.io/RAD。

編輯

引言

端到端自動駕駛(AD)目前是學術界和工業界的熱門話題。它通過直接將感官輸入映射到駕駛動作,用整體流水線取代模塊化流水線,從而提供系統簡潔性和泛化能力的優勢。大多數現有的端到端AD算法遵循模仿學習(IL)範式,該範式訓練神經網絡以模仿人類駕駛行為。然而儘管它們簡單,但基於IL的方法在實際部署中面臨重大挑戰。

一個關鍵問題是因果混淆。IL通過從演示中學習來訓練網絡複製人類駕駛策略。然而,這種範式主要捕捉觀察(狀態)和動作之間的相關性,而不是因果關係。因此經過IL訓練的策略可能難以識別規劃決策背後的真正因果因素,導致捷徑學習,例如僅僅從歷史軌跡推斷未來軌跡。此外,由於IL訓練數據主要包含常見的駕駛行為,不足以覆蓋長尾分佈,經過IL訓練的策略往往收斂到平凡解,缺乏對碰撞等安全關鍵事件的足夠敏感性。

另一個主要挑戰是開環訓練與閉環部署之間的差距。IL策略以開環方式使用分佈良好的駕駛演示進行訓練。然而,現實世界的駕駛是一個閉環過程,每一步的小軌跡誤差會隨着時間累積,導致複合誤差和分佈外場景。IL訓練的策略在這些未見過的情況下常常表現不佳,引發了對其魯棒性的擔憂。

解決這些問題的一個直接方法是進行閉環強化學習(RL)訓練,這需要一個可以與AD策略交互的駕駛環境。然而,使用真實世界的駕駛環境進行閉環訓練存在禁止的安全風險和運營成本。具有傳感器數據模擬功能的仿真駕駛環境(這是端到端AD所需要的)通常建立在遊戲引擎上,但無法提供仿真的傳感器模擬結果。

在這項工作中,我們建立了一個基於3DGS的閉環RL訓練範式。利用3DGS技術,我們構建了真實物理世界的仿真數字副本,使AD策略能夠廣泛探索狀態空間,並通過大規模試錯學習處理分佈外場景。為了確保對安全關鍵事件的有效響應和對現實世界因果關係的更好理解,我們設計了專門的安全相關獎勵。然而,RL訓練提出了幾個關鍵挑戰,本文解決了這些問題。

一個重大挑戰是人類對齊問題。RL中的探索過程可能導致偏離類人行為的策略,破壞動作序列的平滑性。為了解決這個問題,我們在RL訓練期間將模仿學習作為正則化項納入,幫助保持與人類駕駛行為的相似性。如圖1所示,RL和IL協同優化AD策略:RL通過建模因果關係和縮小開環差距來增強IL,而IL通過確保更好的人類對齊來改進RL。

另一個主要挑戰是稀疏獎勵問題。RL經常遭受稀疏獎勵和緩慢收斂的問題。為了緩解這個問題,我們引入了與碰撞和偏差相關的密集輔助目標,有助於約束完整動作分佈。此外,我們簡化並解耦動作空間,以減少與RL相關的探索成本。

為了驗證我們方法的有效性,我們構建了一個由多樣且以前未見過的3DGS環境組成的閉環評估基準。我們的方法RAD在大多數閉環指標中優於基於IL的方法,特別是在碰撞率方面降低了3倍。

總結來説,本文的主要貢獻如下:

- 我們提出了第一個基於3DGS的RL框架,用於訓練端到端AD策略。獎勵、動作空間、優化目標和交互機制經過特別設計,以提高訓練效率和效果。

- 我們結合RL和IL協同優化AD策略。RL通過建模因果關係和縮小開環差距來補充IL,而IL在人類對齊方面補充RL。

- 我們在一個由多樣且以前未見過的3DGS環境組成的閉環評估基準上驗證了RAD的有效性。RAD在閉環評估中表現更強,特別是碰撞率比基於IL的方法低3倍。

相關工作回顧

動態場景重建

隱式神經表示在新視圖合成和動態場景重建中佔據主導地位,UniSim、MARS和 NeuRAD等方法利用神經場景圖來實現結構化的場景分解。然而這些方法依賴於隱式表示,導致渲染速度較慢,限制了它們在實時應用中的實用性。相比之下,3D 高斯濺射(3DGS)作為一種高效的替代方案出現,提供了顯著更快的渲染速度,同時保持了高視覺保真度。最近的工作探索了其在動態場景重建中的潛力,特別是在自動駕駛場景中。StreetGaussians、DrivingGaussians和 HUGSIM展示了基於高斯表示在建模城市環境中的有效性。這些方法在保持可控性的同時實現了卓越的渲染性能,通過顯式將場景分解為結構化組件。然而,這些工作主要利用3DGS進行閉環評估。在這項工作中,我們將3DGS納入RL訓練框架。

端到端自動駕駛

基於學習的規劃由於其數據驅動的性質和隨着數據量增加而表現出的出色性能,最近顯示出巨大的潛力。UniAD通過整合多個感知任務來增強規劃性能,展示了端到端自動駕駛的潛力。VAD進一步探索了使用緊湊的矢量化場景表示來提高效率。一系列工作也採用了單軌跡規劃範式,並進一步增強了規劃性能。VADv2 通過建模規劃詞彙的概率分佈,將範式轉向多模式規劃。Hydra-MDP改進了VADv2的評分機制,通過引入基於規則的評分器提供額外監督。SparseDrive探索了一種替代的無BEV解決方案。DiffusionDrive提出了一種截斷擴散策略,將錨定的高斯分佈去噪為多模式駕駛動作分佈。大多數端到端方法遵循數據驅動的IL訓練範式。在這項工作中,我們提出了基於3DGS的RL訓練範式。

強化學習

強化學習是一項有前景的技術,尚未被充分探索。AlphaGo和 AlphaGo Zero已經展示了強化學習在圍棋遊戲中的強大能力。最近,OpenAI O1和 Deepseek-R1利用強化學習開發了推理能力。一些研究也將強化學習應用於自動駕駛。然而,這些研究基於非仿真的模擬器(如CARLA),或者不涉及端到端駕駛算法,因為它們需要完美的感知結果作為輸入。據我們所知,RAD是第一個在仿真的3DGS環境中使用強化學習訓練端到端AD代理的工作。

RAD算法詳解

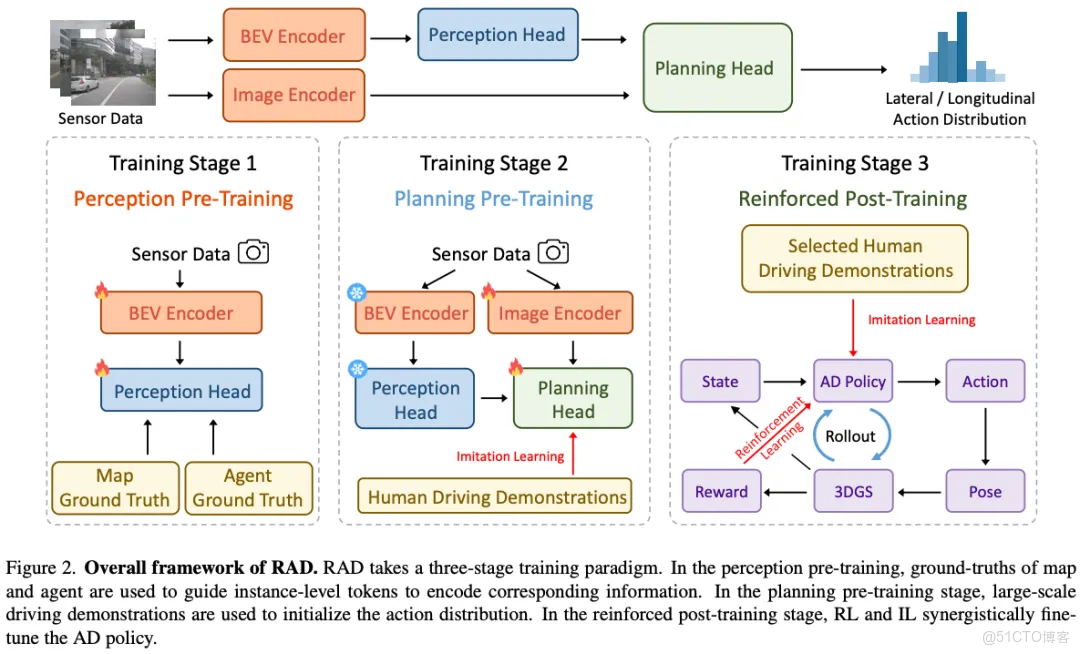

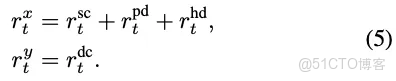

端到端駕駛策略

RAD的整體框架如圖2所示。RAD以多視圖圖像序列作為輸入,將傳感器數據轉換為場景標記嵌入,輸出動作的概率分佈,並對動作進行採樣以控制車輛。

編輯

- 鳥瞰圖(BEV)編碼器:我們首先使用BEV編碼器將多視圖圖像特徵從透視視圖轉換為鳥瞰圖,從而在BEV空間中獲得一個特徵圖。該特徵圖隨後用於學習實例級地圖特徵和智能體特徵。

- 地圖頭:然後,我們利用一組地圖標記從BEV特徵圖中學習駕駛場景的矢量化地圖元素,包括車道中心線、車道分隔線、道路邊界、箭頭、交通信號燈等。

- 智能體頭:此外,我們採用一組智能體標記來預測其他交通參與者的運動信息,包括位置、方向、大小、速度和多模態未來軌跡。

- 圖像編碼器:除了上述實例級地圖和智能體標記外,我們還使用單獨的圖像編碼器將原始圖像轉換為圖像標記。這些圖像標記為規劃提供了密集而豐富的場景信息,與實例級標記形成互補。

- 動作空間:為了加速強化學習訓練的收斂,我們設計了一種解耦的離散動作表示。我們將動作分為兩個獨立的部分:橫向動作和縱向動作。動作空間是在0.5秒的短時間範圍內構建的,在此期間,通過假設車輛的線性速度和角速度恆定來近似其運動。在這個假設下,橫向動作和縱向動作可以根據當前的線性速度和角速度直接計算得出。通過將解耦與有限的時間範圍和簡化的運動模型相結合,我們的方法有效地降低了動作空間的維度,加速了訓練收斂。

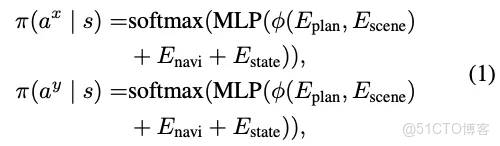

- 規劃頭:我們用表示場景表示,它由地圖標記、智能體標記和圖像標記組成。我們初始化一個規劃嵌入,記為。一個級聯的Transformer解碼器以規劃嵌入作為查詢,場景表示作為鍵和值。解碼器的輸出然後與導航信息和自車狀態相結合,以輸出橫向動作和縱向動作的概率分佈:

編輯

其中、、和MLP的輸出維度均為。規劃頭還輸出值函數和,分別用於估計橫向和縱向動作的預期累積獎勵:

編輯

值函數用於強化學習訓練。

訓練範式

我們採用三階段訓練範式:感知預訓練、規劃預訓練和強化後訓練,如圖2所示。

- 感知預訓練:圖像中的信息是稀疏且低級的。在第一階段,地圖頭和智能體頭明確輸出地圖元素和智能體運動信息,這些信息由真實標籤進行監督。因此,地圖標記和智能體標記隱式編碼了相應的高級信息。在這個階段,我們只更新BEV編碼器、地圖頭和智能體頭的參數。

- 規劃預訓練:在第二階段,為了防止強化學習訓練的冷啓動不穩定,首先進行模仿學習,基於專家駕駛員在現實世界中的大規模駕駛演示來初始化動作的概率分佈。在這個階段,我們只更新圖像編碼器和規劃頭的參數,而BEV編碼器、地圖頭和智能體頭的參數被凍結。感知任務和規劃任務的優化目標可能會相互衝突。然而,通過將訓練階段和參數解耦,這種衝突在很大程度上得以避免。

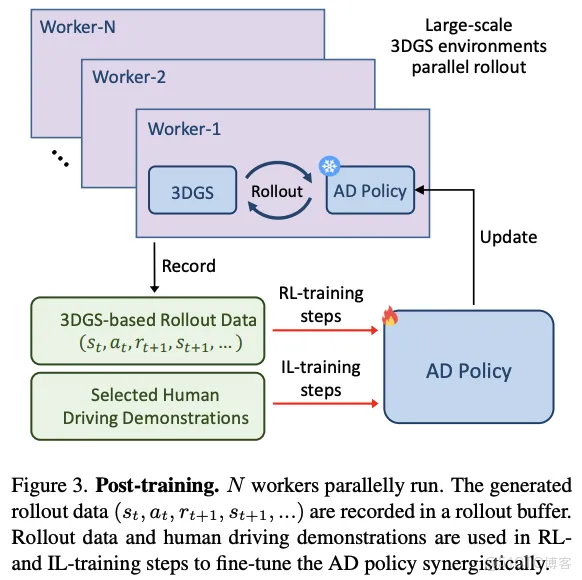

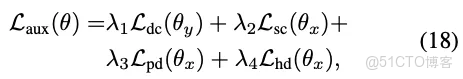

- 強化後訓練:在強化後訓練中,強化學習和模仿學習協同微調分佈。強化學習旨在引導策略對關鍵風險事件敏感,並適應分佈外的情況。模仿學習作為正則化項,使策略的行為與人類行為保持相似。

我們從收集到的駕駛演示中選擇了大量高碰撞風險的密集交通片段。對於每個片段,我們訓練一個獨立的3DGS模型,對該片段進行重建,並將其作為數字駕駛環境。如圖3所示,我們設置了N個並行工作進程。每個工作進程隨機採樣一個3DGS環境並開始滾動,即AD策略控制自車移動,並與3DGS環境進行迭代交互。在這個3DGS環境的滾動過程結束後,生成的滾動數據被記錄在滾動緩衝區中,並且該工作進程將採樣一個新的3DGS環境進行下一輪滾動。

編輯

在策略優化方面,我們迭代執行強化學習訓練步驟和模仿學習訓練步驟。對於強化學習訓練步驟,我們從滾動緩衝區中採樣數據,並遵循近端策略優化(PPO)框架來更新AD策略。對於模仿學習訓練步驟,我們使用現實世界的駕駛演示來更新策略。在固定數量的訓練步驟之後,更新後的AD策略被髮送到每個工作進程中,以替換舊策略,從而避免數據收集和優化之間的分佈偏移。我們只更新圖像編碼器和規劃頭的參數。BEV編碼器、地圖頭和智能體頭的參數被凍結。下面將詳細介紹強化學習的設計。

AD策略與3DGS環境之間的交互機制

在3DGS環境中,自車根據AD策略行動。其他交通參與者以日誌重放的方式根據現實世界數據行動。我們採用一個簡化的運動學自行車模型,每隔秒迭代更新自車的位姿,公式如下:

編輯

其中和表示自車相對於世界座標系的位置;是航向角,定義了車輛相對於世界x軸的方向;是自車的線速度;是前輪的轉向角;L是軸距,即前後軸之間的距離。

在滾動過程中,AD策略在時間步為0.5秒的時間範圍輸出動作。我們根據推導出線性速度和轉向角。基於公式3中的運動學模型,自車在世界座標系中的位姿從更新為。基於更新後的,3DGS環境計算自車的新狀態。更新後的位姿和狀態作為下一次推理過程迭代的輸入。3DGS環境還根據多源信息(包括其他智能體的軌跡、地圖信息、自車的專家軌跡和高斯參數)生成獎勵R,這些獎勵用於優化AD策略。

獎勵建模

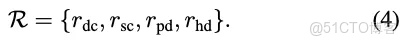

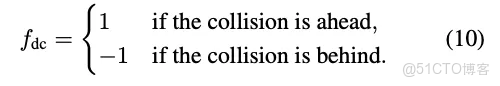

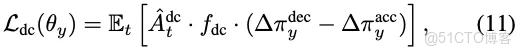

獎勵是訓練信號的來源,它決定了強化學習的優化方向。獎勵函數旨在通過懲罰不安全行為和鼓勵與專家軌跡對齊來引導自車的行為。它由四個獎勵組件組成:(1)與動態障礙物碰撞、(2)與靜態障礙物碰撞、(3)與專家軌跡的位置偏差、(4)與專家軌跡的航向偏差:

編輯

如圖4所示,這些獎勵組件在特定條件下被觸發。在3DGS環境中,如果自車的邊界框與動態障礙物的標註邊界框重疊,則檢測到動態碰撞,觸發負獎勵。類似地,當自車的邊界框與靜態障礙物的高斯分佈重疊時,識別為靜態碰撞,產生負獎勵。位置偏差通過自車當前位置與專家軌跡上最近點之間的歐幾里得距離來衡量。如果偏差超過預定義閾值,則會產生負獎勵。航向偏差計算為自車當前航向角與專家軌跡匹配的航向角之間的角度差。如果偏差超過閾值,則會產生負獎勵。

這些事件中的任何一個,包括動態碰撞、靜態碰撞、過度的位置偏差或過度的航向偏差,都會立即觸發情節終止。因為在這些事件發生後,3DGS環境通常會生成有噪聲的傳感器數據,這對強化學習訓練是有害的。

策略優化

在閉環環境中,每一步的誤差會隨着時間累積。上述獎勵不僅由當前動作引起,還受到前面步驟動作的影響。獎勵通過廣義優勢估計(GAE)向前傳播,以優化前面步驟的動作分佈。

具體來説,對於每個時間步,我們存儲當前狀態、動作、獎勵和值的估計。基於解耦的動作空間,並考慮到不同獎勵與橫向和縱向動作的相關性不同,獎勵被分為橫向獎勵和縱向獎勵:

編輯

類似地,值函數被解耦為兩個組件:用於橫向維度的和用於縱向維度的。這些值函數分別估計橫向和縱向動作的預期累積獎勵。優勢估計和的計算如下:

編輯

其中和是橫向和縱向維度的時間差分誤差,是折扣因子,是GAE參數,用於控制偏差和方差之間的權衡。

為了進一步闡明優勢估計與獎勵組件之間的關係,我們基於公式5中的獎勵分解和公式6中的優勢估計,對和進行分解。具體來説,我們得到以下分解:

編輯

其中是避免靜態碰撞的優勢估計,是最小化位置偏差的優勢估計,是最小化航向偏差的優勢估計,是避免動態碰撞的優勢估計。

這些優勢估計用於遵循PPO框架指導AD策略的更新。通過利用分解後的優勢估計和,我們可以獨立優化策略的橫向和縱向維度。這是通過為每個維度定義單獨的目標函數和來實現的,如下所示:

編輯

其中是橫向維度的重要性採樣比,是縱向維度的重要性採樣比,和是小常數,用於控制橫向和縱向維度的裁剪範圍,確保策略更新的穩定性。

裁剪後的目標函數可防止對策略參數進行過大的更新,從而保持訓練的穩定性。

輔助目標

強化學習通常面臨獎勵稀疏的問題,這使得收斂過程不穩定且緩慢。為了加快收斂速度,我們引入了輔助目標,為整個動作分佈提供密集的指導。

輔助目標旨在通過納入特定的獎勵源來懲罰不良行為,這些獎勵源包括動態碰撞、靜態碰撞、位置偏差和航向偏差。這些目標是基於舊的自動駕駛策略在時刻選擇的動作和計算的。為了便於評估這些動作,我們將動作的概率分佈分為四個部分:

編輯

這裏,表示減速動作的總概率,表示加速動作的總概率,表示向左轉向動作的總概率,表示向右轉向動作的總概率。

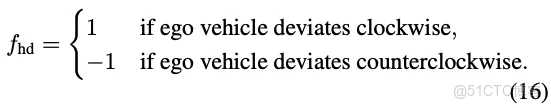

- 動態碰撞輔助目標:動態碰撞輔助目標根據潛在碰撞相對於自車的位置調整縱向控制動作。如果檢測到前方有碰撞,策略優先選擇減速動作();如果檢測到後方有碰撞,則鼓勵加速動作()。為了將這種行為形式化,我們定義一個方向因子:

編輯

避免動態碰撞的輔助目標定義為:

編輯

其中,是避免動態碰撞的優勢估計。

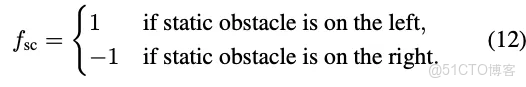

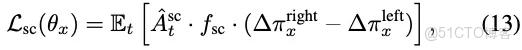

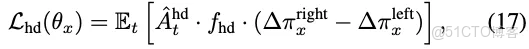

- 靜態碰撞輔助目標:靜態碰撞輔助目標根據與靜態障礙物的接近程度調整轉向控制動作。如果檢測到靜態障礙物在左側,策略促進向右轉向動作();如果檢測到靜態障礙物在右側,則促進向左轉向動作。為了將這種行為形式化,我們定義一個方向因子:

編輯

避免靜態碰撞的輔助目標定義為:

編輯

其中,是避免靜態碰撞的優勢估計。

- 位置偏差輔助目標:位置偏差輔助目標根據自車相對於專家軌跡的橫向偏差調整轉向控制動作。如果自車向左偏離,策略促進向右修正();如果向右偏離,則促進向左修正()。我們用一個方向因子來形式化這一過程:

編輯

位置偏差修正的輔助目標為:

編輯

其中,用於估計軌跡對齊的優勢。

- 航向偏差輔助目標:航向偏差輔助目標根據自車當前航向與專家參考航向之間的角度差調整轉向控制動作。如果自車逆時針偏離,策略促進順時針修正();如果順時針偏離,則促進逆時針修正()。為了將這種行為形式化,我們定義一個方向因子:

編輯

航向偏差修正的輔助目標定義為:

編輯

其中,是航向對齊的優勢估計。

- 整體輔助目標:整體輔助目標是各個單獨目標的加權和:

編輯

其中,、、和是加權係數,用於平衡每個輔助目標的貢獻。

- 優化目標:最終的優化目標將裁剪後的近端策略優化目標與輔助目標相結合:

編輯

實驗結果分析實驗設置

- 數據集和基準:我們在真實物理世界中收集了2000小時的專家人類駕駛演示數據。通過低成本的自動標註流程,獲取這些駕駛演示中地圖和智能體的真實標籤。在第一階段的感知預訓練中,我們將地圖和智能體標籤作為監督信息。在第二階段的規劃預訓練中,我們使用自車的里程計信息作為監督。在第三階段的強化後訓練中,我們從收集到的駕駛演示中挑選出4305個高碰撞風險的關鍵密集交通片段,並將這些片段重建為3DGS環境。其中,3968個3DGS環境用於強化學習訓練,另外337個3DGS環境作為閉環評估基準。

- 評估指標:我們使用九個關鍵指標來評估自動駕駛策略的性能。動態碰撞率(DCR)和靜態碰撞率(SCR)分別量化與動態和靜態障礙物碰撞的頻率,它們的總和表示為碰撞率(CR)。位置偏差率(PDR)衡量自車相對於專家軌跡在位置上的偏差,而航向偏差率(HDR)評估自車與專家軌跡在前進方向上的一致性。整體偏差由偏差率(DR)量化,定義為PDR和HDR之和。平均偏差距離(ADD)量化在發生任何碰撞或偏差之前,自車與專家軌跡之間的平均最近距離。此外,縱向加加速度(Long. Jerk)和橫向加加速度(Lat. Jerk)通過測量縱向和橫向的加速度變化來評估駕駛的平穩性。CR、DCR和SCR主要反映策略的安全性,而ADD反映自動駕駛策略與人類駕駛員之間的軌跡一致性。

編輯

結果消融實驗

為了評估RAD中不同設計選擇的影響,我們進行了三項消融實驗。這些實驗研究了強化學習(RL)和模仿學習(IL)之間的平衡、不同獎勵源的作用以及輔助目標的效果。

- RL-IL比例分析:我們首先分析不同RL與IL步驟混合比例的影響(表1)。純模仿學習策略(0:1)導致最高的CR(0.229),但ADD最低(0.238),這表明其軌跡一致性強,但安全性較差。相比之下,純強化學習策略(1:0)顯著降低了CR(0.143),但增加了ADD(0.345),這意味着以軌跡偏差為代價提高了安全性。在4:1的比例下實現了最佳平衡,此時CR最低(0.089),同時ADD也相對較低(0.257)。進一步增加RL的主導地位(例如8:1)會導致ADD惡化(0.323)和加加速度升高,這意味着軌跡平滑度降低。

- 獎勵源分析:我們分析了不同獎勵組件的影響(表2)。僅使用部分獎勵項訓練的策略(例如ID 1、2、3、4、5)與完整獎勵設置(ID 6)相比,具有更高的碰撞率(CR)。ID 6實現了最低的CR(0.089),同時保持了穩定的ADD(0.257)。這表明,一個平衡良好的獎勵函數,包含所有獎勵項,能夠有效地提高安全性和軌跡一致性。在部分獎勵配置中,ID 2省略了動態碰撞獎勵項,表現出最高的CR(0.238),這表明缺少該項會顯著削弱模型避免動態障礙物的能力,從而導致更高的碰撞率。

- 輔助目標分析:最後,我們研究了輔助目標的影響(表3)。與完整的輔助目標設置(ID 8)相比,省略任何一個輔助目標都會增加CR,當所有輔助目標都被移除時,CR顯著上升。這突出了它們在提高安全性方面的集體作用。值得注意的是,ID 1保留了所有輔助目標但排除了近端策略優化(PPO)目標,其CR為0.187。這個值高於ID 8,這表明雖然輔助目標有助於減少碰撞,但與PPO目標結合時最為有效。

我們的消融實驗強調了結合RL和IL、使用全面的獎勵函數以及實施結構化輔助目標的重要性。最優的RL - IL比例(4:1)以及完整的獎勵和輔助目標設置始終能產生最低的CR,同時保持穩定的ADD,確保了安全性和軌跡一致性。

編輯

與現有方法的比較

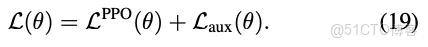

如表4所示,我們在提出的基於3DGS的閉環評估中,將RAD與其他端到端自動駕駛方法進行了比較。為了進行公平比較,所有方法都使用相同數量的人類駕駛演示數據進行訓練。RAD中用於RL訓練的3DGS環境也是基於這些數據構建的。與基於IL的方法相比,RAD在大多數指標上表現更優。特別是在CR方面,RAD實現了低三倍的碰撞率,這表明RL幫助自動駕駛策略學習了通用的避撞能力。

編輯

定性比較

我們對僅使用模仿學習的自動駕駛策略(無強化後訓練)和RAD進行了定性比較,如圖5所示。僅使用模仿學習的方法在動態環境中表現不佳,經常無法避免與移動障礙物的碰撞或處理複雜的交通情況。相比之下,RAD始終表現良好,能夠有效地避免動態障礙物並處理具有挑戰性的任務。這些結果突出了混合方法中閉環訓練的優勢,它使模型能夠更好地處理動態環境。

編輯

研究侷限與結論

在本研究中,我們提出了首個基於3D高斯濺射(3DGS)的強化學習框架,用於訓練端到端的自動駕駛策略。我們將強化學習和模仿學習相結合,其中強化學習有助於建模因果關係、縮小開環差距,而模仿學習則使策略在行為上更貼近人類駕駛。不過,本研究也存在一定的侷限性。目前所使用的3DGS環境運行方式缺乏反應性,即其他交通參與者不會根據自車的行為做出反應,僅以日誌重放的形式行動。並且3DGS的效果仍有提升空間,尤其是在渲染非剛性行人、未觀測到的視角以及低光照場景方面。未來的研究將致力於解決這些問題,並將強化學習提升到新的水平。

....

#某智駕公司工資發放困難

進入2025年,一些智駕公司陷入缺錢狀態,更是爆發了縱目暴雷這樣的極端事件。近期,某智駕公司未能足額發放員工工資,對員工只發放了部分比例的工資。

這家智駕公司成立比較早,前幾年發展勢頭一度不錯,拿到了幾家頭部主機廠的項目。這也使得公司創始人信心滿滿,想要成長為明星級別的智駕公司。但是近兩年形勢直轉而下,不停的丟客户,幾乎是做一個項目丟一個客户。

背後的原因比較複雜,有的説是項目沒做好,有的説是客户太難侍候,總之是客户越來越少。另外,這兩年智駕行業從簡單初級的低階L2向中階、高階迭代,這家智駕公司也沒有跟上迭代的節奏,沒有吃到中階擴容的蛋糕。

做項目的收入不佳,就只能靠融資。

這家智駕公司創始人在24年全年都在忙着融資,不停的見海內外的各路資本,費勁口舌向資本講述自己公司前景的故事。終於功夫不負有心人,在24年融到了一筆錢,但是創始人根本不敢停歇,還是通過各種路子繼續找錢,只有找到新錢才能活着。

這也是過去幾年許多智駕公司的共同的處境,做項目的收入低只能靠融資。不過,這種處境在2025年要逆轉了。

在過去智駕公司做項目收入低的一個重要原因是:主機廠對智駕是選配。同一個車型帶智駕的版本比不帶智駕的貴,比如帶中階高速NOA功能的比不帶的要貴一兩萬。這就導致帶智駕功能的銷量極低,能佔銷量的一二成就不錯了。

過去幾年智駕行業,不僅項目少而且還是選配。所以,不是智駕公司們不努力,而是很難在貧瘠的鹽鹼地上豐收糧食。

2025年形勢開始根本性逆轉,因為迪王下場卷智駕,把智駕捲成標配了。一旦進入標配時代,智駕公司們做一個項目的出貨量至少是之前的幾倍,而且整個行業的項目數量也會至少增長几倍。

最讓智駕公司們“哭笑不得”的主機廠,逆轉了智駕公司們的命運。

智駕將正式進入長坡厚雪的時代,可以預見的是25年之後一些智駕公司的項目收入會蹭蹭的上漲。

智駕公司未來的商業收入能達到什麼量級呢?一位業界朋友表示,單輛車上,智駕的成本價格要比座艙高許多,未來智駕公司商業收入會超過座艙公司的。頭部的座艙公司營收能過百億,第二梯隊的也能做到幾十億,所以未來預計智駕行業會很快會出現收入幾十億上百億的智駕公司。

有嗅覺敏鋭的資本已經行動起來了,又開始積極的看智駕公司了。資本的熱情有多熱呢,某拿到頭部主機廠項目的公司創始人一天要見幾波投資人。

即將迎來長坡厚雪時代之際,一些陷入不佳處境的智駕公司或許能迎來轉機。這些公司這些年都是在缺項目缺錢中熬過來的,都熬了這麼多年了,也許再熬一熬黎明就來了。

....

#STAMP

異構協同感知框架新框架!無痛擴展~

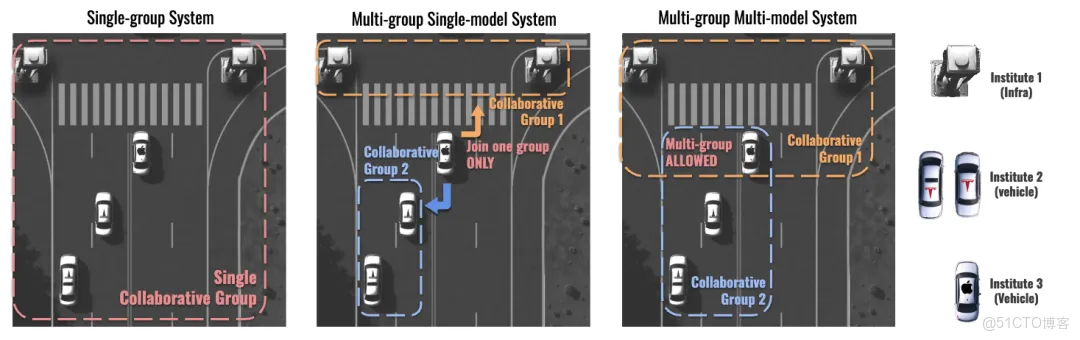

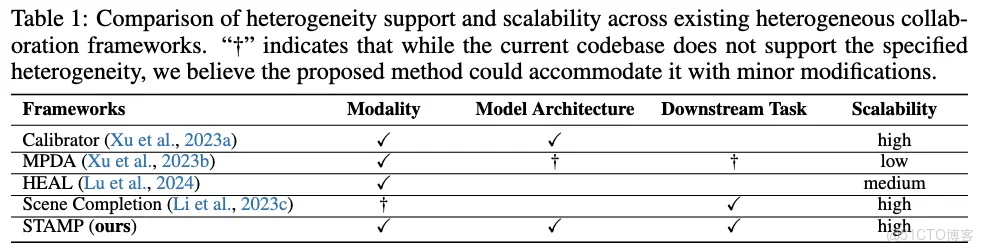

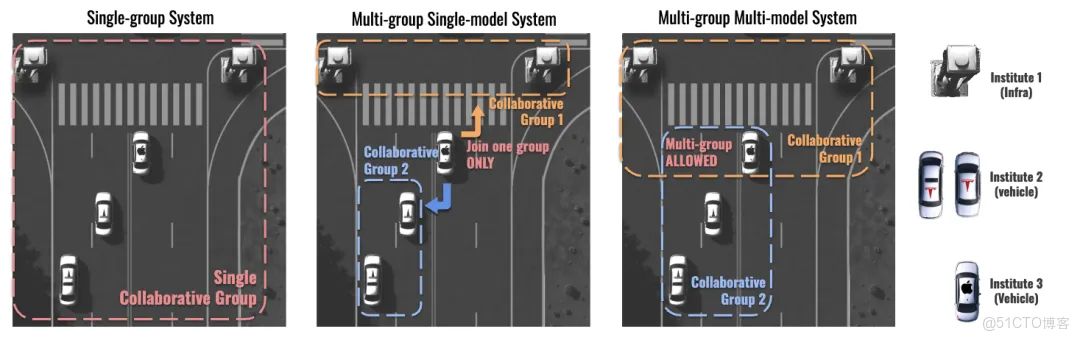

[ICLR 2025] STAMP: Scalable Task- And Model-agnostic Heterogeneous Collaborative Perception 一個可擴展,與任務和模型無關的,異構協同感知框架

在快速發展的自動駕駛領域,如何讓不同車輛高效地共享和通信環境感知信息是一個重大挑戰。試想,特斯拉可以無縫地將其攝像頭數據共享給配備 LiDAR 的 Waymo 車輛,同時又能安全地接收其他車輛的感知信息——通過多車輛之間的協同,構建一個更全面、更安全的駕駛環境。

編輯

論文鏈接:https://arxiv.org/abs/2501.18616論文代碼:https://github.com/taco-group/STAMP項目網站:https://xiangbogaobarry.github.io/STAMP/講解視頻(英文):https://www.youtube.com/watch?v=OlQDg7EMWrE&t=3s作者信息:https://www.xiangbogao.com/

異構協同感知的挑戰

傳統的自動駕駛車輛作為獨立個體運行,僅依賴自身的傳感器和處理能力。儘管這種方法有效,但並非最佳選擇。車輛經常會遇到視野受限、遮擋或惡劣天氣等情況,這些都會削弱感知能力。

解決方案看似簡單:讓車輛共享它們所見的信息。然而,不同的自動駕駛車輛使用:

- 不同類型的傳感器(攝像頭、LiDAR、雷達)

- 不同的 AI 模型和架構

- 不同的任務(如目標檢測、分割、軌跡預測)

這就像一羣講不同語言、使用不同工具且目標各異的人試圖合作。以往的嘗試侷限於:部分異構的協同感知[1],僅限於目標檢測任務的異構協同感知[2,3],或是僅限於兩輛或少量異構車輛的協同感知[4]。

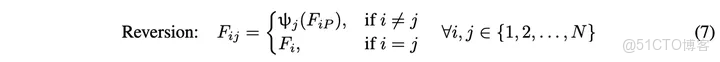

編輯

STAMP: 自動駕駛車輛模型的通用翻譯器

STAMP是一個可擴展的,任務與模型無關的,異構協同感知框架,通“協作特徵對齊”(Collaborative Feature Alignment)的方法,多個異構車輛之間也能相互溝通,協同感知。其工作原理如下:

- 協議網絡 (Protocol Network): STAMP 首先建立一個統一的鳥瞰圖特徵空間(BEV feature space),可視為建立一個所有車輛都能翻譯到和從中翻譯出的通用語言。

- 適配器(Adapter)和恢復器(Reverter):每輛車配備:

- 一個適配器 (ϕ),將其本地(local)的特徵圖 (feature map)適配到協議特徵空間(Protocol feature space),類比於將“地方方言”翻譯為“通用語言”。

編輯

- 一個恢復器 (ψ),將其協議空間的特徵圖恢復到本地特徵空間,類比於將“通用語言”重新轉換為“地方方言”。

編輯

編輯

STAMP 的重要性

- 可擴展性:與先前異構協同感知的解決方案因車輛數量增加而大幅增加計算量不同,由於適配器恢復器十分輕量,STAMP 僅需要極小的額外計算量就能實現多車異構協同感知。

- 安全性:車輛無需共享其專有的 AI 模型或算法,僅需共享被適配到協議格式下特徵。

- 靈活性:新車輛即使擁有不同的傳感器或 AI 模型,也能加入網絡,而無需更新現有車輛。

性能與實際影響

STAMP在模擬數據集OPV2V和真實世界數據集V2V4Real上,均展現了突出的結果。

從實際角度看,使用 STAMP 的車輛可以:

- 在具有挑戰性的條件下更準確地檢測目標

- 即使車輛傳感器,感知模型,下游任務能力不同也能高效協作

- 即便數據存在噪聲或不完美,也能保持性能

未來研究方向

- STAMP 提供了多個值得進一步探索的研究方向。協議網絡架構可以針對不同的現實場景和應用需求進行優化。例如,城市環境可能需要與高速公路駕駛條件不同的協議特性,而惡劣天氣場景可能從專門的協議架構中受益。研究可以探討自適應協議網絡,根據環境條件和感知需求動態調整協議。

- 適配器-恢復器架構也是另一個值得深入研究的領域。目前的實現通過 ConvNeXt 層,但替代架構可能在性能或效率權衡上表現更優。研究人員可以探索基於 Transformer 的架構,甚至是針對邊緣設備的硬件優化,以更大程度減少計算開銷,同時保持性能。

- STAMP 評估中識別的瓶頸效應強調了實際部署中系統設計的重要問題。這種效應表明,系統的整體性能可能會受到最弱參與者的限制,因此需要更復雜的協作策略。一個有前景的方向是實現多組協作系統,在這種系統中,智能體可以根據其能力、可靠性評分和當前感知質量選擇性地加入特定分組。通信協議可以通過質量評估機制進行增強,幫助智能體決定何時以及與誰協作。在多組場景中,這些機制尤為重要,因為智能體可能需要根據任務需求和環境條件動態調整其在不同組中的參與。STAMP 的輕量級適配器-恢復器對的特性使這種靈活的分組參與在計算上變得可行。

- 該領域將受益於專門為協作感知系統設計的標準化評估指標。目前的指標(如平均精度和平均交併比)雖然有用,但可能無法完全捕捉多智能體協作的細微差別。新的指標可以考慮通信效率、對新智能體的適應速度,以及對智能體故障或性能下降的抗干擾能力等因素。

....

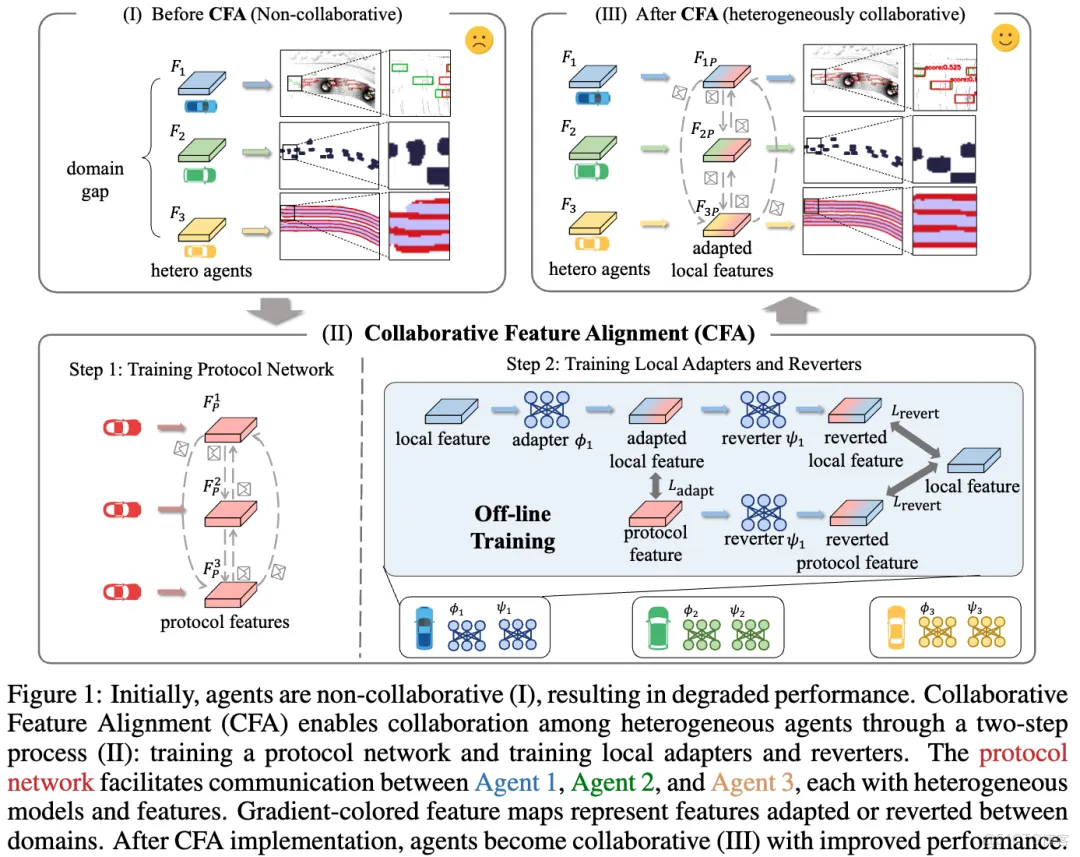

#Reasoning模型復現R1經驗綜述

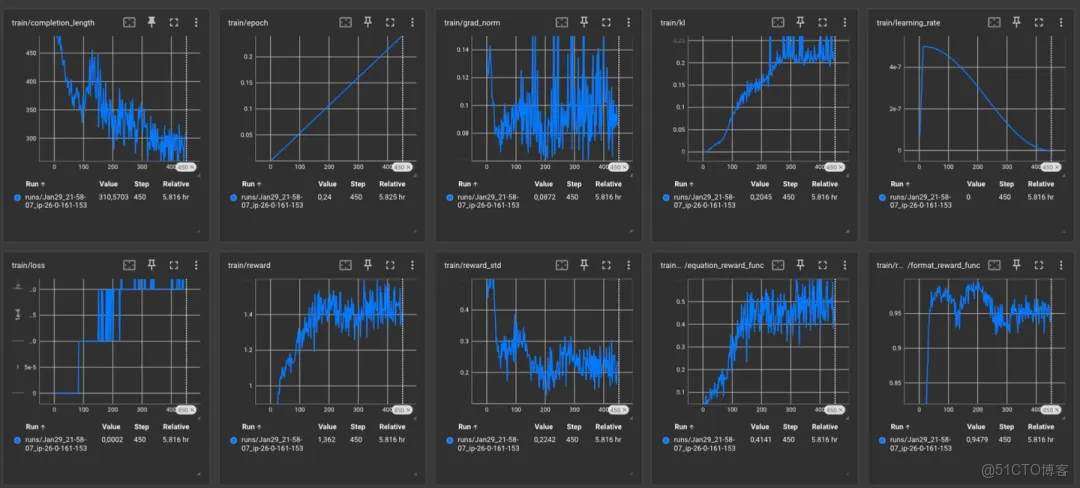

作者復現R1基於HF的open-r1,底層使用trl庫,在GSM8K數據集上進行了復現,使用了4張40G的A100和Qwen2.5 1.5B-Instruct模型。代碼在https://github.com/Mryangkaitong/deepseek-r1-gsm8k

獎勵:

- 格式獎勵參考了Logic-RL的工作,格式檢查了以下內容:

- 出現在之後,

- 在之後,

- 在之後,

- 以上三種任意一種都是格式錯誤,獎勵值出-1,其他出+1;

- accuracy_reward直接看結果是否正確,正確獎勵值為1,錯誤獎勵值為0。

參數:

作者使用了DeepSpeed Zero3,FlashAttention2, 提示詞長度最大512,回答長度最大1024,每張卡1個BS,梯度累計16步, 每次採樣3個回答,學習率3e-6,BF16,使用VLLM。

復現效果:

編輯

來源於https://github.com/Mryangkaitong/deepseek-r1-gsm8k/blob/main/log/log.png

作者使用Qwen2.5 1.5B-Instruct在GSM8K訓練完的準確率為74.29%。

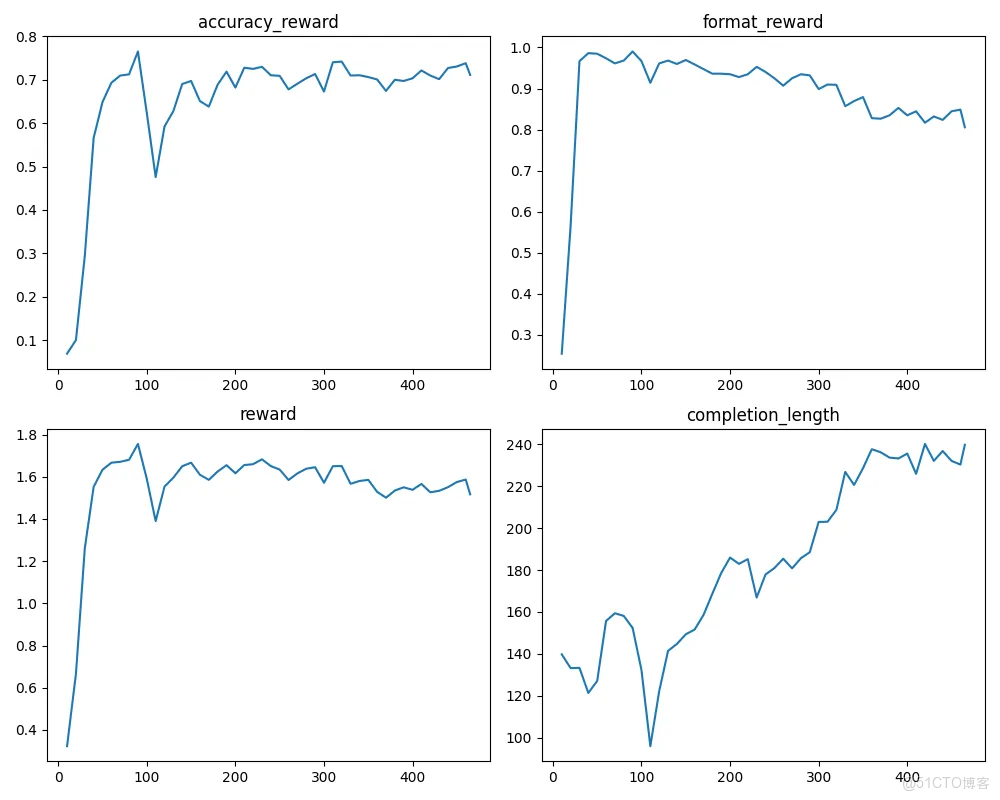

HF的Open-R1(復現R1)

github.com/huggingface/open-r1/

復現的訓練步驟:

編輯

- 首先對有指令遵循的模型蒸餾DeepSeek R1的訓練數據,得到Open R1-Distill;

- 對Base 模型用GRPO訓練得到OpenR1-Zero;

- 對Base模型先蒸餾Open R1-Zero的指令遵循數據,再使用GRPO訓練得到Open R1。

復現效果

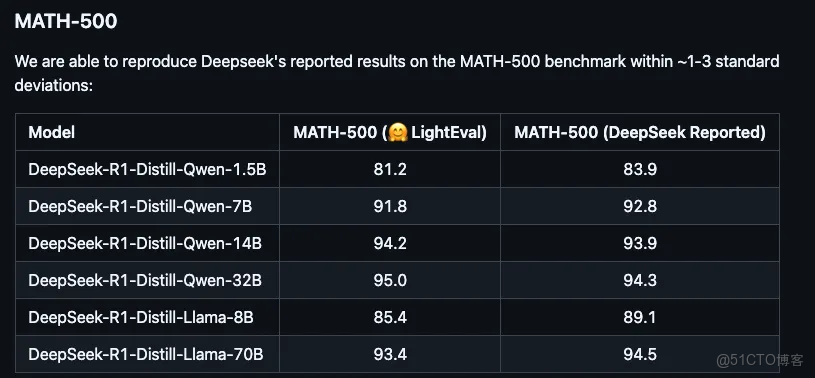

編輯

左側是HF Open R1,右側是DeepSeek R1.

作者的生成使用的温度係數為0.6。

Mini-R1 (基於GRPO的用來玩小遊戲的模型)

作者希望能通過GRPO的訓練,讓模型精通Countdown遊戲。Countdown 遊戲是一個數字拼圖遊戲,玩家使用一組隨機抽取的數字和基本的算術運算 (+、-、×、÷) 來達到或儘可能接近目標數字

作者的技術文章在 https://www.philschmid.de/mini-deepseek-r1

獎勵設置

- Format Reward:檢查生成的格式是否滿足[thinking][answer]的格式。滿足獎勵值為 1.0 ,否則為0。

- Accuracy Reward:從標籤中提取方程式,並根據目標以及每個數字是否使用一次對其進行評估。

- 生成的回答必須包含且必須可以被(.?)解析出內容,同時解析出的內容只能包含數字、運算符(+、-、、/)、括號、點號(.)和空白字符。

- 數字使用正確:解析出的內容中的數字只能是輸入的幾種數字。

- 使用eval運行解析出的表達式,結果需要和答案的差異小於1e-5。

- 異常處理:報異常直接返回0.

參數設置

每個設備一個BatchSize,梯度累計8步,採樣8次,使用VLLM。

觀察

- 在 ~50 步時,模型已學習正確的格式。...\n...

- 在 100 步時,求解方程的成功率約為 25%。模型開始用單詞 “推理” ,見下面的例子。

- 在 200 步時,性能似乎收斂得慢得多,我們的成功率為 ~40%。該模型開始學習一種新的 “格式”,在其中,它通過嘗試不同的組合並查看結果,類似於以編程方式求解方程式,請參閲“步驟 200 和 450 之間的成功推理樣本”。

- 在 450 個步驟中,我們求解方程的成功率為 50%。性能仍然緩慢提高,模型從步驟 200 開始保持其新的格式形式。

編輯

Logic-RL(復現R1)

文檔鏈接 https://evxpwrsfkdb.feishu.cn/docx/NokEdaMBmo6aqZxVdxkcSm2cnab

代碼鏈接 https://github.com/Unakar/Logic-RL

獎勵設置:

作者自己寫的規則

作者發現:

我們發現模型在學習format的時候,其實是一個快速收斂--逐漸崩壞--又忽然找回format的形式,與我們三階段RL訓練設置吻合。

還有一個有趣的小發現,在中間階段,模型似乎認為格式反而阻礙了它的思考:日誌裏看到不少例子,模型在tag開始後意識到自己犯錯了,想重回進入思考模式,可惜被format reward狠狠懲罰了

獎勵設置:

- 格式是否遵循think> [thinking][answer]的格式。滿足獎勵值為 1.0 ,否則為-1.0。

- 答案是否正確:如果答案正確是2,答案可以解析但是錯誤是-1.5,答案不可以解析是-2

參數:

- 模型:Qwen2.5-7B-Instruct-1M

- 數據集&場景:作者使用了不到2K合成數據集。 場景:邏輯問題類似老實人和騙子的益智題,老實人總説真話,騙子總説假話,下面N個人,各有各的表述,請判斷誰是騙子。

- 訓練(全局GRPO):

- 預熱:作者先使用一共三個人的邏輯問題作為訓練集,3epoch的RL訓練後,成功讓qwen-7B達到了0.41。模型在10step訓練裏很快就能學會把format error降到0.1的佔比

- 訓練:高温採樣設置温度係數1.2

- 退火:温度從1.2慢慢降到0.9,學習率降低到2e-7。

作者在挑選模型發現Qwen 7B MATH:

首先它指令跟隨能力比較一般,很難學會format;

其次,它説話老愛用python code解題,訓練很難克服移除system prompt後,還是習慣用\box{}包裹answer,還是format不行Markdown味道太重,一板一眼的,Reasoning模型本應思想跳脱一些才是。

從邏輯上確實是Qwen 7B Math更高,但是格式遵循不如Qwen Instruct模型。

作者使用了GRPO,採樣數逐漸減少 64-32-16(因現存有限,每個設備的BatchSize先小後大)。

simpleRL-reason(Math模型)

Qwen2.5-7B-SimpleRL訓練使用了8K條math相關的數據,

- SFT:作者先從Qwen 32B QwQ生成 對應回答,然後對基模進行蒸餾。

- RL: 作者使用GRPO,每個採樣8個回答,訓練模型。

Qwen2.5-7B-SimpleRL-Zero訓練只有RL步驟,無SFT。

效果

(pass@1) 33.3% on AIME, 62.5% on AMC, and 77.2% on MATH。

總結

- Reasoning能力:這幾個復現項目都以Qwen為基模。預訓練通過較好的過濾,減少知識的衝突,提高數據質量,把世界知識灌注好,通過GRPO就可以激發模型的reasoning能力。

- 高效訓練:強化學習可以參考OpenRLHF 、Ray和 生成時考慮VLLM。

- 蒸餾具有Reasoning能力的教師模型或者通過Rule-Base RL訓練都可以得到不錯的效果。但是蒸餾涉及到數據的選取問題,RL涉及到Rule的質量,規避Reward hacking現象。

- 通過高温採樣可以得到多樣性強的結果。

....

#華科&百度最新自動駕駛世界模型綜述!

- 論文鏈接:https://arxiv.org/pdf/2502.10498

摘要

本文介紹了世界模型在塑造自動駕駛中的作用:綜述。駕駛世界模型(DWM)着重於預測駕駛過程中的場景演變,它已經成為自動駕駛中有前景的範式。這些方法使得自動駕駛系統能夠更好地感知、理解動態駕駛環境並且與之交互。本綜述全面概述了DWM中的最新進展。本文根據預測場景的模態對現有方法進行分類,並且總結了其對自動駕駛的特定貢獻。此外,本文還對DWM研究範圍內針對不同任務設計的高影響力數據集和各種指標進行了回顧。最後,本文討論了當前研究的潛在侷限性,並且提出了未來的研究方向。本綜述為DWM的發展和應用提供了有價值的見解,促進了其在自動駕駛中的廣泛應用。

主要貢獻

本文的貢獻總結如下:

1)本文全面回顧了DWM中的最新進展,通過預測的場景模態對現有方法進行分類,並且概述了DWM在自動駕駛中的應用;

2)本文對當前侷限性進行關鍵性分析,並且概述了有前景的未來研究方向,這不僅為研究界提供了有價值的見解,還有助於DWM的持續發展。

論文圖片和表格

駕駛世界模型(DWM)逐漸被認為是自動駕駛系統架構中的一個組成部分,旨在通過未來演變預測來改進決策。本文研究了DWM的具體貢獻,不僅系統性概述了通過預測的場景模態進行分類的現有方法,還總結了DWM應用及其對自動駕駛的影響,隨後回顧了常用的數據集和指標。此外,本文進一步深入研究了當前的侷限性,並且指出了一些有前景的未來研究方向,以克服這些挑戰並且推進未來的領域探索。本文認為,本綜述將為早期研究者提供DWM領域中關鍵進展的快速概覽。

....

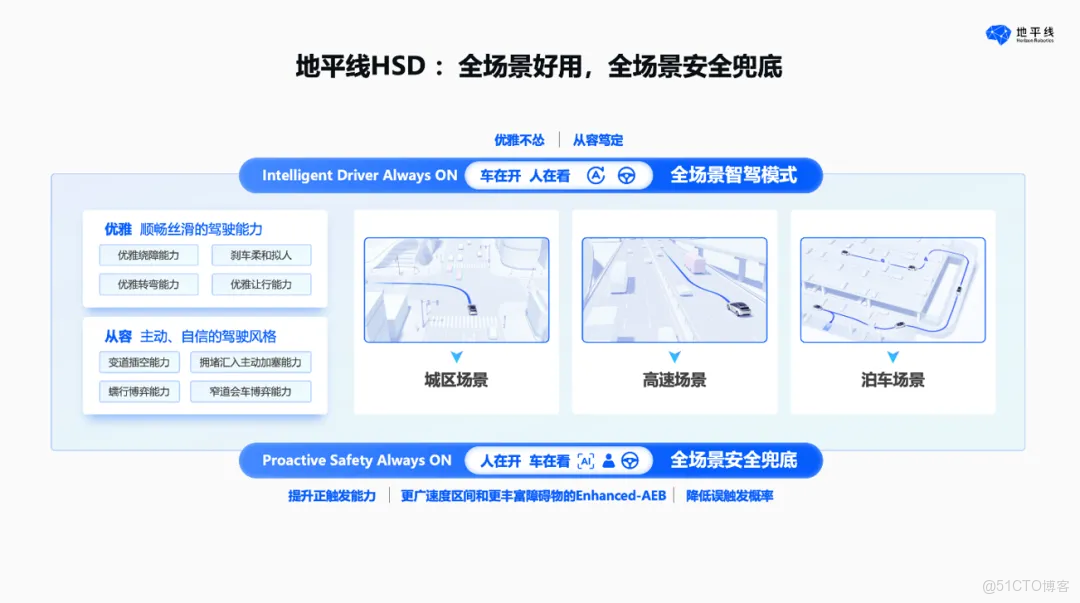

#地平線高階智駕北京市區實測:全程零接管,輕鬆應對複雜路況

端到端的高階智能駕駛,即將大規模落地。

説到國內智能駕駛,地平線是個一定繞不過去的名字。

去年 4 月,地平線正式發佈了新一代智能駕駛方案征程 6 系列,該公司基於征程 6P 打造了 HSD(Horizon SuperDrive)全場景智能駕駛解決方案,首發了多項技術,刷新高階智駕的天花板。

基於征程 6 系列,地平線官宣了多家批量合作車企及品牌,正在大規模量產落地。地平線提出的 HSD 系統搭載端到端 VLA(視覺 - 語言 - 行為)大模型,能夠賦予車輛高度擬人的駕駛能力。具體來説,HSD 可以「看懂」車輛周圍複雜環境,如識別紅綠燈文字、預判大型車輛風險,並遵守交規執行轉向或待轉動作。這一系列能力,讓我們對新一代智能駕駛有了期待。

本週,我們實際體驗了正處在測試階段的地平線 HSD 高階智駕系統(搭載車型為大眾 ID4)。在北京望京地區的複雜交通環境下,地平線 HSD 充分展示了強大性能與絲滑擬人、十分上手的智駕新體驗。

編輯

我們本次試駕的路線覆蓋眾多寬窄不同的街道、複雜的路口,包括左轉紅綠燈和待轉區。在城市道路上,HSD 智能駕駛可以輕鬆應對擁堵路況,在右側車道有慢車的時候可以自動轉向左道,能夠禮讓斑馬線上的行人,還能與其他車輛進行一定程度的「博弈」。

如果遇到一些非常規的路況,如右側車道上佔道違停的車輛、橫穿馬路的行人和車輛,智能駕駛也能輕鬆地應付。

編輯

在整個時長約 40 分鐘的全市區環境車程裏,HSD 智能駕駛系統在較為複雜的路線場景上沒有發生一次人工接管。

地平線 HSD 智能駕駛開啓的過程中,我們可以觀察到車機中控屏的顯示狀態也與此前的智駕有所不同 —— 系統通過高算力芯片以下一代 SR 實時環境渲染能力,實現了極為精細的交互界面,可以沉浸式地還原出現實世界。

編輯

結合國內率先落地的端到端 VLA 大模型智能駕駛系統,地平線的智駕系統不僅能「看清」,還能「讀懂」交通環境。通過強大的通用理解能力和綜合推理能力,它可以識別道路交通元素和風險並做出智駕行為反應,例如對紅綠燈、路口標識文字等信息進行識別並決策、進入待轉區,遵守交規並提升駕駛質量。

地平線的工程師表示,其 HSD 智能駕駛中的 VLA 模型相比其他廠商使用的 VLM 模型,對智能駕駛決策的參與更加直接。

此外,根據智駕系統感知到的大型車輛屬性、載貨類型、尺寸等更多維信息,系統還可以綜合判斷評估其風險等級。

據介紹,除此以外地平線的高階智駕還融合了倒車能力(支持狹窄道路上的三點掉頭)、無指令漫遊模式、自主規劃路線等能力。在各項能力加持下,HSD 可以真正實現點對點的智能駕駛。

地平線構建的 HSD 全場景智能駕駛解決方案基於自身軟硬件結合的全棧技術打造,可以在不需要高精地圖的條件下實現高階的智能駕駛(全場景 NOA)。該系統擁有高度擬人的駕駛風格,可以實現高通行效率、優雅從容的姿態,提供了全國一致的智駕體驗。

編輯

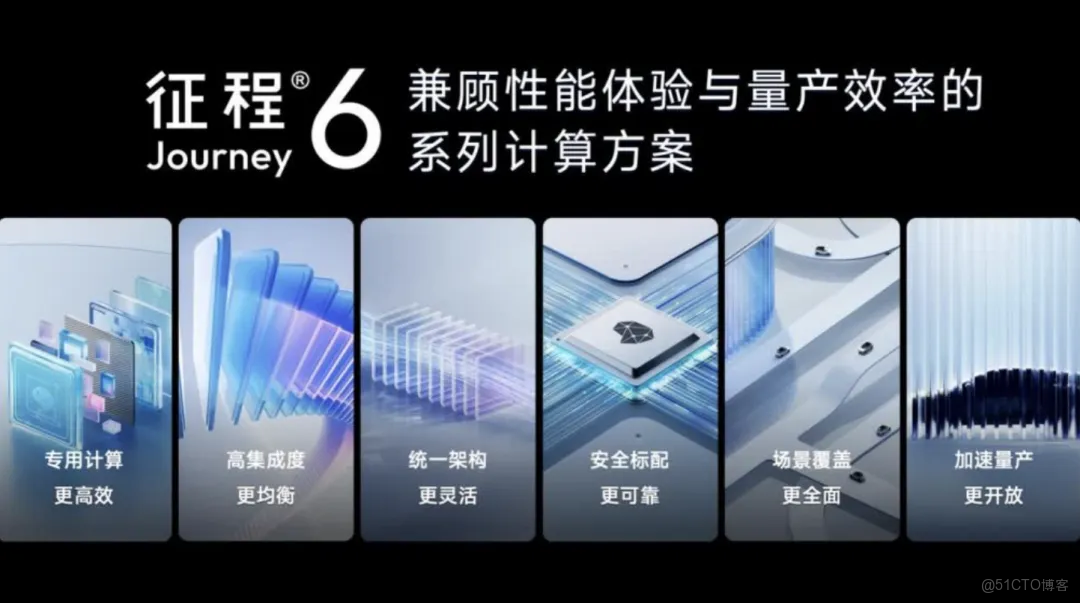

去年 4 月,地平線重磅發佈了新一代車載智能計算方案征程 6 系列,及全場景智能駕駛解決方案 HSD,鞏固了地平線智駕科技公司第一陣營的行業地位。

根據高工智能汽車監測數據,2024 年 1-12 月中國市場自主品牌乘用車智駕計算方案市場中,地平線憑藉低、中、高全階計算方案的產品佈局以 33.97% 的市場份額穩居市場第一。地平線已與包括中國前十大車企在內的全球超 40 家車企及品牌達成合作,賦能合作車型超 300 款,覆蓋的車主已超過 500 萬人。

編輯

隨着 AI 大模型、世界模型等技術不斷髮展,我們正在見證智能駕駛算法技術經歷新一輪迭代,性能實現突破性提升。在很多專家眼中,自動駕駛將是xx智能與物理世界交互的第一個場景,汽車是「機器人大規模落地的第一個形態」。

目前,端到端的智能駕駛正在逐步落地。地平線創始人、CEO 餘凱博士曾表示,智能駕駛將在 2025 年迎來真正的拐點,未來三年智駕體驗將進入「脱手開」時代,智駕行業也將進入競爭的關鍵時期。

高階智駕的標配化是我們迎來變革的標誌。2 月 10 日,比亞迪公佈了全新的整車智能戰略,推出天神之眼 C 高階智駕三目版,高階智能駕駛正式邁入了 10-20 萬級主流大眾汽車市場。天神之眼之中就搭載了地平線征程 6 系列。

編輯

「征程」家族車載智能計算方案已成為國內最大規模前裝量產的智能駕駛計算方案,累積出貨量預計將在 2025 年正式跨越 1000 萬量產大關,地平線也將成為國內首個突破千萬級量產的智駕科技品牌。

與此同時,地平線征程 6 系列旗艦版征程 6P 已經順利投片,計劃將在 2025 年第一季度內回片點亮。與之相對應的,具備全場景 NOA 的 HSD 已經完成了全國泛化,預計會在 2025 年第三季度實現首款量產合作車型交付。

....

#FGU3R

北郵提出 :統一3D表示用於多模態3D目標檢測 !

多模態3D目標檢測在自動駕駛領域引起了廣泛關注。然而,多模態檢測器由於將3D點和2D像素粗略融合而存在維度不匹配問題,這導致了融合性能欠佳。

在本文中,作者提出了一種名為FGU3R的多模態框架來解決上述問題,通過統一的3D表示和精細融合來實現,該框架包含兩個重要組成部分。

首先,作者提出了一種用於原始點和偽點的有效特徵提取器,稱為偽原始卷積(PRConv),它同步調節多模態特徵,並基於多模態交互在關鍵點上聚合不同類型點的特徵。

其次,設計了一種交叉注意力自適應融合(CAAF),通過交叉注意力變體以精細的方式自適應地融合同質3D RoI(興趣區域)特徵。這兩個部分共同實現了在統一3D表示上的精細融合。

在KITTI和nuScenes數據集上進行的實驗表明,作者提出的方法是有效的。

引言

3D目標檢測,旨在智能預測3D空間中物體的類別、位置和尺寸,在許多領域發揮着至關重要的作用,例如機器人視覺和自動駕駛。在過去幾年中,儘管基於LiDAR的檢測器[4]-[8]取得了巨大成就,但由於LiDAR點雲固有的缺陷,如稀疏性和語義貧乏,其性能仍然不盡如人意。最近的研究嘗試引入多模態數據以克服基於LiDAR檢測器的侷限性。[9]-[11]利用成熟的二維檢測器精確地捕捉3D空間中的錐體,以去除冗餘的背景點。然而,它們的性能受到二維檢測器的限制。旨在將點雲轉換為二維表示,通過視角變換與二維圖像進行維度匹配,從而允許二維卷積提取特徵。PointPainting[19]通過傳感器校準投影將語義分割生成的語義分數附加到相應的原始點上。[20]-[22]建立了點雲特徵與RGB圖像之間的聯繫,以探索細粒度的融合。[23]、[24]引入了注意力機制,在特徵 Level 融合點與RGB像素。[25]利用多個相關任務來補充3D任務的特性。FUTR3D[26]利用Transformer對模態無關的隱式特徵進行編碼。

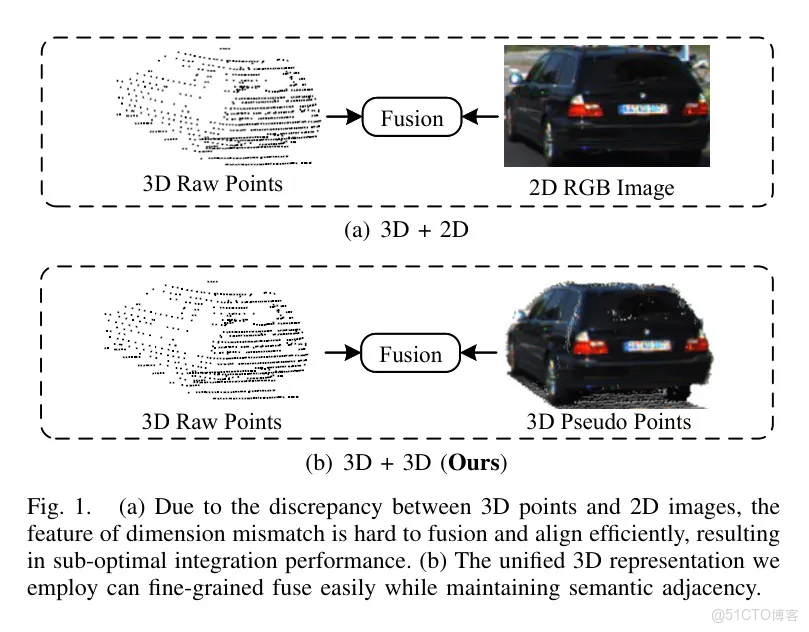

圖1(a)由於三維點和二維圖像之間的差異,維數不匹配的特徵難以高效融合和校準,導致集成性能不佳。(b)作者採用的統一三維表示可以輕鬆實現細粒度融合,同時保持語義相鄰性。

編輯

儘管先前的方法取得了令人印象深刻的改進,但它們存在兩個主要問題。首先,許多方法將3D點和2D像素——來自不同維度的特徵——結合在一起,從而引發了維度不匹配問題,如圖1a所示。其次,先前的方法通過逐元素相加或拼接簡單融合多模態特徵,這是一種粗粒度融合,會降低檢測性能。

為了應對上述挑戰,作者提出了一種多模態3D檢測框架,該框架利用顯式統一的3D表示來進行細粒度融合。首先,作者通過提供顯式統一的3D表示來克服維度不匹配問題,如圖1b所示。具體來説,作者採用一個預訓練的深度補全網絡來補充2D圖像的深度,生成可靠的3D偽點雲。其次,作者提出了一種多模態 Backbone 網絡,即偽原始卷積(PRConv),以從偽點和原始點中提取特徵,同時充分實現各種元素的交互。最後,作者提出了一種交叉注意力自適應融合(CAAF),它通過交叉注意力變體自適應地融合多模態特徵,並在模態之間構建關聯信息,這是一種更細粒度的融合策略。

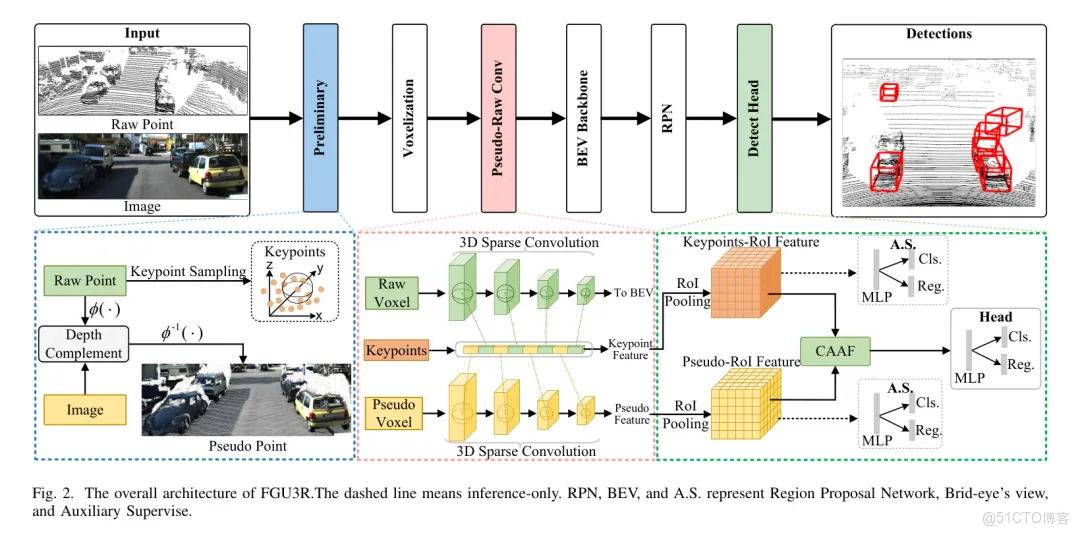

H. 提出的方法

FGU3R的整體框架如圖2所示。首先,通過深度補全將原始點和圖像生成偽點,並通過採樣原始點生成關鍵點。其次,原始點和偽點被 Voxel 化。原始 Voxel 和偽 Voxel 被輸入到PRConv中提取細粒度特徵。最後,由RPN(區域建議網絡)生成的異構Rol特徵通過CAAF(詳見第二節C部分)融合,並進行最終的迴歸。

編輯

初步的

要將圖像轉換為偽點雲,需要像素級深度信息。通常,對於單目相機,通過深度估計或深度補全來獲得像素級深度。在此,作者採用深度補全方法以獲取更可靠的深度信息。給定一個原始點集的幀和RGB圖像,其中為點雲中的點數,和分別為圖像的寬度和高度。作者可以利用LiDAR相對於相機參考系的旋轉矩陣和平移矩陣,將投影到圖像平面上,從而獲取一個稀疏深度圖,具體如下:

表示相機內參;表示像素座標;為深度值。作者定義這種可逆投影操作為。將和輸入到深度補全網絡中,以獲得密集的深度圖,具體如下:

最後,作者通過反向投影獲得一個偽點幀。

在實踐中,這個過程產生了不錯的偽點。偽點的定義將在第二部分的第二節中描述。

偽原始卷積(Pseudo-RawConvolution)

偽點與原始點相比,偽點是一種更為密集的表示,其中包含了豐富的語義信息。具體來説,圖像中的每個像素都會生成一個相應的偽點,它包括深度、顏色以及像素座標。PRConvPointnet [29] 是一種提取點特徵的原生方法。然而,由於偽點的數量龐大,它將導致通過球 Query 算子 [29] 進行大量計算。為了利用多模態點之間的互補性,作者提出了一種基於點- Voxel 的主幹偽原始卷積(PRConv)。對於原始點分支,使用稀疏3D卷積來提取原始 Voxel 特徵。與作者的 Baseline [5] 類似,通過通道變換將原始 Voxel 特徵轉換為2D鳥瞰圖(BEV)特徵,並用於獲取候選框。對於偽點分支,作者首先將其 Voxel 化以生成偽 Voxel ,並將它們輸入到3D稀疏卷積中以獲得偽 Voxel 特徵。

在此,作者分別獲取了異質體的 Voxel 特徵。儘管基於 Voxel 的特徵效率較高,但不可避免的信息損失降低了細粒度定位的準確性。

另一方面,基於點的特徵雖然能夠提供細粒度信息,但計算量巨大。因此,作者的目標是有效地結合兩種方法的優勢。受[5]的啓發,作者在共享點雲空間中通過最遠點採樣(FPS)進行關鍵點採樣,以獲取低噪聲的全局關鍵點。如圖2所示,在關鍵點周圍,通過球 Query [29]或 Voxel Query [6]對異構特徵進行聚合,以實現特徵間的交互。最後,第個關鍵點特徵可以表示如下:

代表 級多模態語義特徵,而 則結合了原始點和偽點。 表示多層感知器,而 則分別指最大池化或平均池化。

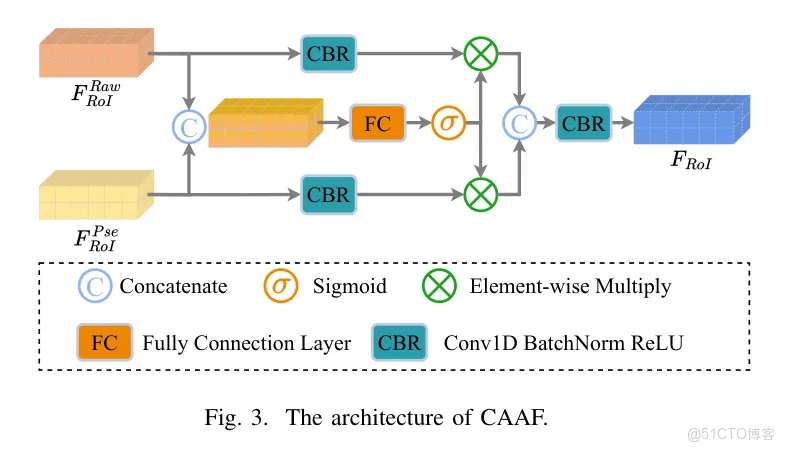

C. 跨注意力自適應融合

激光雷達和相機的特性導致了一個固有難題——維度不匹配,這很大程度上限制了多模態檢測器的性能。儘管之前的方法[19]、[20]、[23]、[24]已經提出直接融合異構特徵,但它們未能解決這一關鍵問題。得益於上述提到的偽點生成,維度可以在三維空間中得到很好的匹配。儘管偽點可以緩解維度不匹配的問題,但在對齊方面仍是一個關鍵挑戰。根據作者的可視化分析,偽點的座標和數據與關鍵點不同,這導致它們的對應關係複雜,而不是一對一的對齊。

為了實現關鍵點和偽關鍵點的自適應集成,作者通過引入一個交叉注意力變體動態捕捉這種對應關係。具體來説,作者在細化階段使用CAAF融合RoI的異構特徵。給定一對RoI特徵,其中是RoI的數量。作者將連接的RoI特徵輸入到一個全連接層和sigmoid函數中,以產生注意力權重。最後,與加權,得到自適應融合的RoI特徵。形式上,CAAF可表示如下:

sigmoid函數、全連接層和拼接操作分別表示為和。此外,還使用了1D卷積進行一些維度調整。幻象如圖3所示。

編輯

D損失函數

由於作者的框架是一個兩階段檢測器,作者分別針對區域 Proposal 網絡(RPN)和細化頭設置了兩個基本損失函數,即 和 。為了防止梯度被單一模式主導,作者設計了兩個輔助監督項,即 和 。它們與 類似,包含邊界框迴歸損失和類別置信度損失。總損失可以表示如下:

在本文中, 和 分別對 和 進行加權(默認情況下,,)。 是作者的深度補充網絡損失。

第三章:實驗

數據集及實現細節

作者在兩個流行的自動駕駛數據集上進行了實驗,即KITTI[37]和nuScenes[38]。KITTI包含7481個標註樣本,作者按照流行的3D檢測模型[5]將其分為訓練集(3712個樣本)和驗證集(3769個樣本)。至於nuScenes,這是一個大規模的自動駕駛數據集,包含700個訓練場景、150個驗證場景和150個測試場景。每個場景大約有200幀。對於KITTI,作者使用平均精度(AP)在驗證集上評估結果,該AP是通過在簡單、中等和困難難度下計算40個召回率位置得到的[37]。對於nuScenes,作者使用官方指標,即平均平均精度(mAP)和nuScenes檢測分數(NDS)[38]來評估不同模型的性能。

作者利用PENet [39]和MVP [35]分別生成KITTI和nuScenes的偽點。雖然深度補全可以以端到端的方式進行處理,但作者採用離線方式,利用偽點雲進行處理,這使作者能夠快速進行實驗。對於PRConv,作者將關鍵點的數量設置為2048,對於KITTI和nuScenes分別設置為4096。作者使用開源框架OpenPCDet [40]實現作者的方法。所有實驗均在8個RTX 3090 GPU上訓練,並在單個RTX 3090 GPU上進行推理。為確保公平性,作者遵循 Baseline PV-RCNN [5],按照OpenPCDet [40]中指定的參數設置超參數。具體來説,FGU3R使用Adam優化器,學習率為,並採用單週期學習方案。

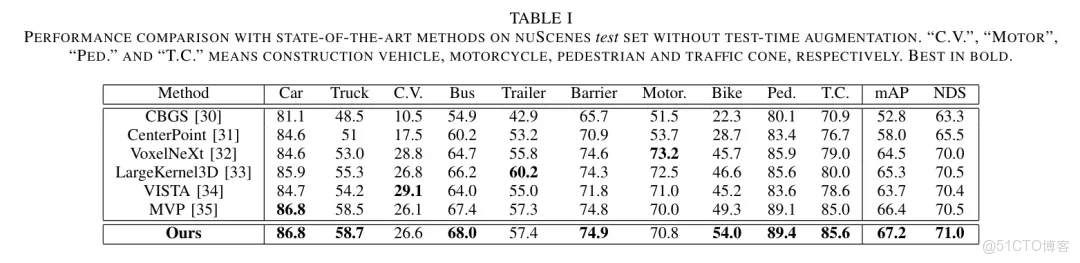

B. 主要結果

為了驗證作者方法的有效性,作者在nuScenes [38]上將其與幾種最先進的方法進行了比較。如表1所示,FGU3R在大多數指標上優於所有先前最先進的方法。特別是,它在測試集上分別以0.8%的mAP和0.5%的NDS優於MVP [35]。此外,作者注意到它在所有類別上都優於MVP,並在難度較高的類別(如C.V.、自行車)上取得了顯著提升。如表2所示,FGU3R通過3D+3D融合方式在簡單 Level 上提高了基準[5]的2.69% AP3D,這進一步證明了作者的方法在KITTI [37]上的有效性。

編輯

表1展示了在NUSCENES測試集上,不進行測試時間增強的情況下,與現有方法的性能比較。"C.V."、"MOTOR"、"PED."和"T.C."分別代表建築車輛、摩托車、行人和交通錐,分別以粗體表示最佳結果。

表2展示了在KITTI val數據集上針對汽車類別的性能比較,與現有方法的比較。“MOD.”和“_”分別表示“適度”和“未提及”。最佳結果以粗體顯示。

表3展示了不同模塊在KITTI val數據集上的消融實驗結果。PRConv和CAAF分別代表偽原始卷積和交叉注意力自適應融合。

編輯

C. 消融研究與分析

組件級分析。為了驗證每個組件的效率,作者逐步在 Baseline [5]上進行了組件級實驗。如表2所示,在實驗(a)中,作者僅將偽點應用於 Baseline ,性能提升微乎其微。在實驗(b)中,PRConv提取偽點特徵並利用兩種模態之間的交互,分別在簡單、中等和困難場景下實現了1.03%、0.69%和0.61%的性能提升。實驗(c)在實驗(b)的基礎上增加了CAAF模塊,該模塊能夠自適應地融合同構3D RoI特徵,在所有任務上都取得了最佳性能。值得注意的是,在AP3D的簡單和中等場景下,分別獲得了2.39%和2.22%的顯著提升,這證明了CAAF的效率。

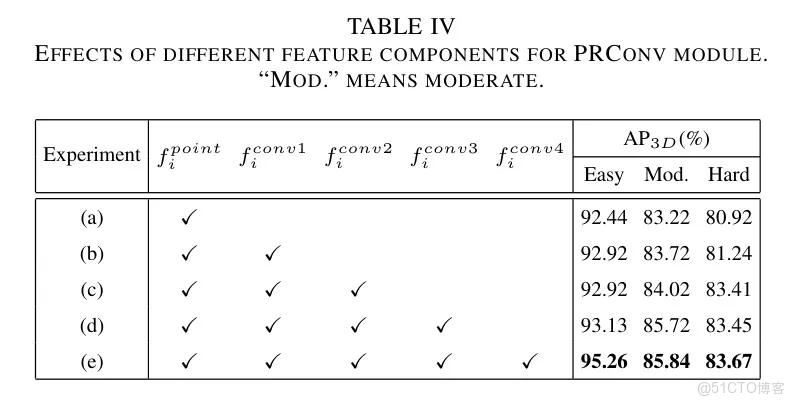

表四:不同特徵成分對PRCONV模塊的影響。"MOD."表示適度。

在表4中,作者探討了將不同多模態特徵聚合對PRConv的影響。在實驗(a)中,結果顯示僅聚合會導致性能顯著下降,因為模態交互的淺層次不足以支持更高的性能。在實驗(b)、(c)、(d)和(e)中,作者逐步應用高級語義特徵,直至達到峯值性能。這表明高級語義特徵對性能有顯著影響,並證明了PRConv能夠提取出信息豐富的多模態特徵。

編輯

四、結論

在這篇論文中,作者提出了一種多模態3D目標檢測框架FGU3R,該框架利用由深度補全生成的偽點來處理由點雲和圖像引起的維度不匹配問題。

通過提出的PRConv,當多模態交互出現時,多模態特徵能夠被高效且充分地提取。

此外,作者還設計了一個CAAF模塊,它通過交叉注意力機制自適應地整合多模態特徵。

在KITTI和nuScenes數據集上進行的實驗表明,作者的方法顯著提高了檢測精度。

....