一.戰略挑戰:當前數據工作流程的瓶頸與高昂成本

數據是驅動現代企業分析、決策與創新的核心引擎,而數據管道正是確保數據在企業內部高效、可靠流動的關鍵基礎設施。然而,我們當前依賴手動配置和維護的數據工作流程,正面臨着日益嚴峻的效率瓶頸和成本壓力,這已成為制約我們業務敏捷性和增長潛力的戰略性障礙。

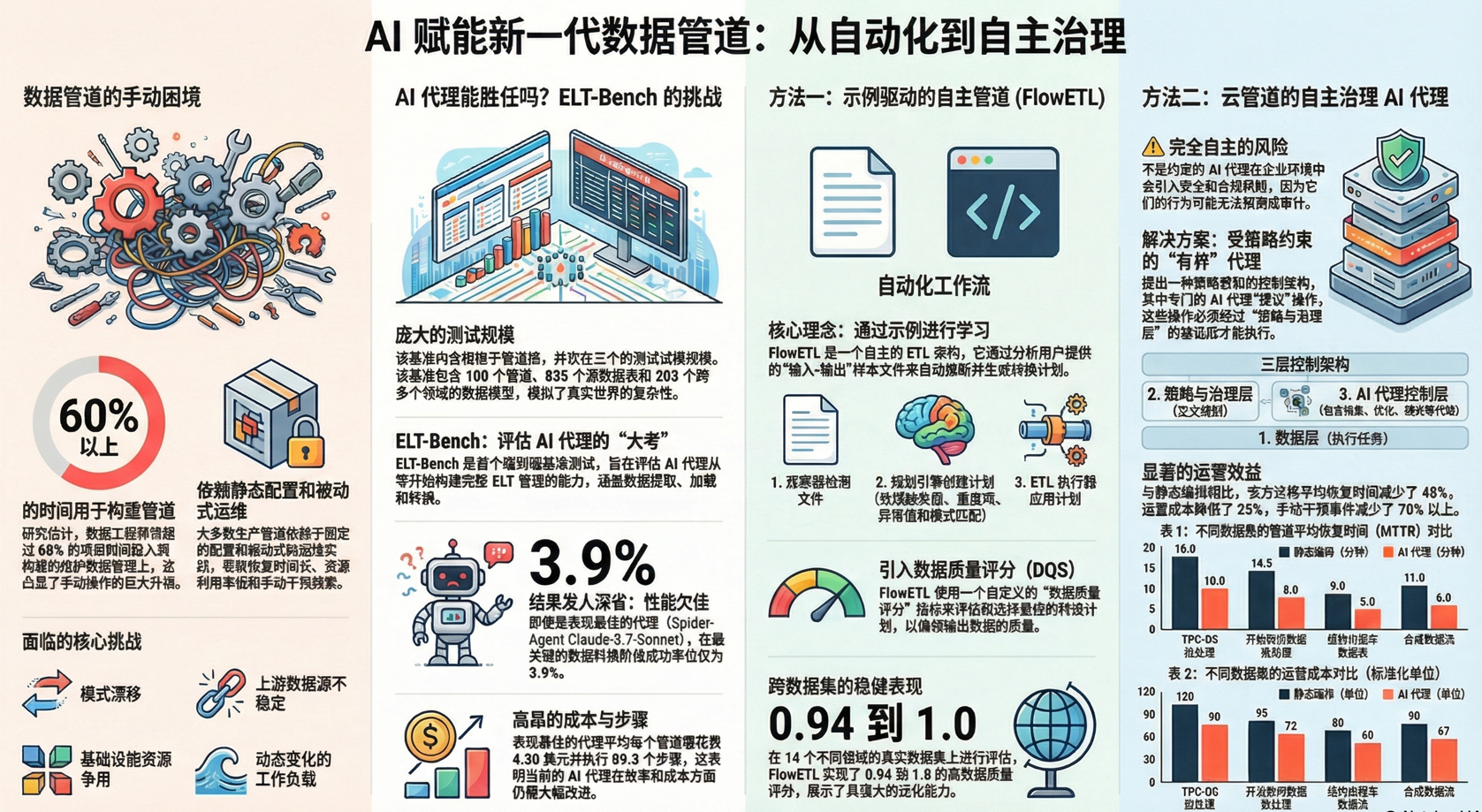

基於對行業實踐的深入研究,當前數據管道的開發與維護流程中存在以下幾個核心痛點,其影響已被精確量化:

• 極高的人力資源消耗: 研究表明,數據工程師將超過60%3到5小時的高度集中的手動工作。這意味着我們寶貴的工程技術人才,大部分時間被消耗在重複性、低附加值的任務中,而非戰略性的數據創新。

• 流程的內在複雜性: 數據工程師必須對源數據的模式(schema)有深刻的理解,才能編寫出滿足業務需求的複雜數據轉換查詢。這一過程不僅耗時,且高度依賴個人經驗,難以規模化複製,並帶來了潛在的錯誤風險。

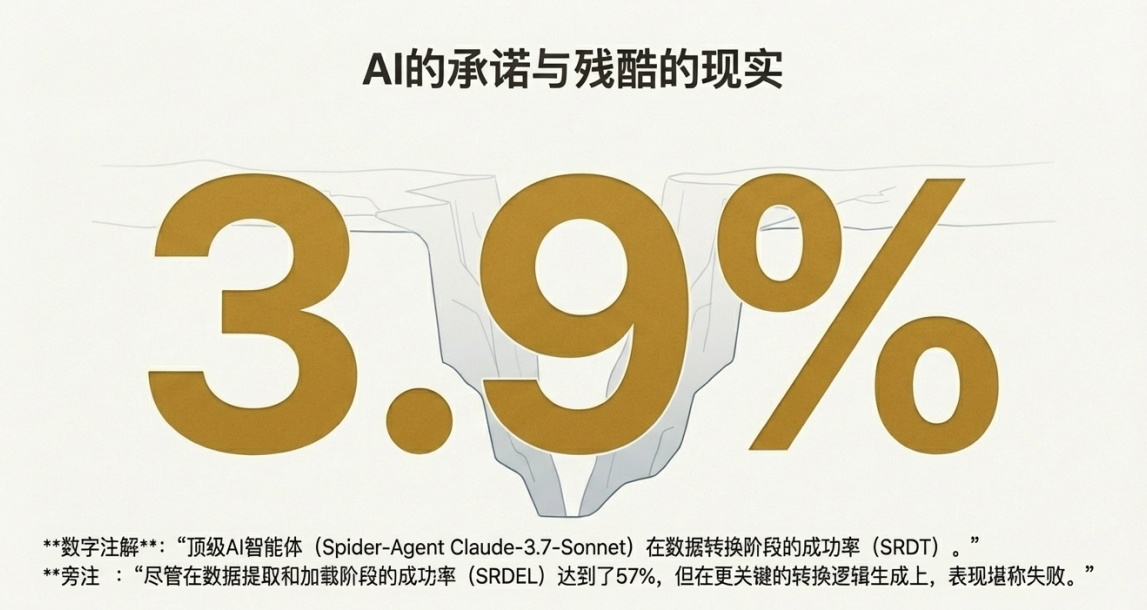

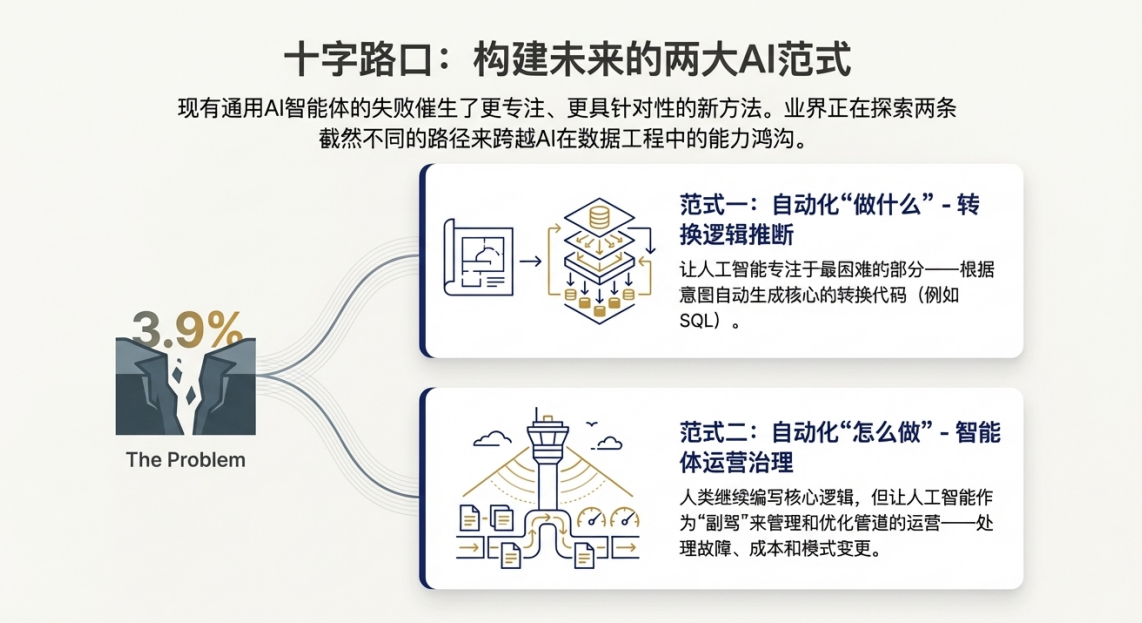

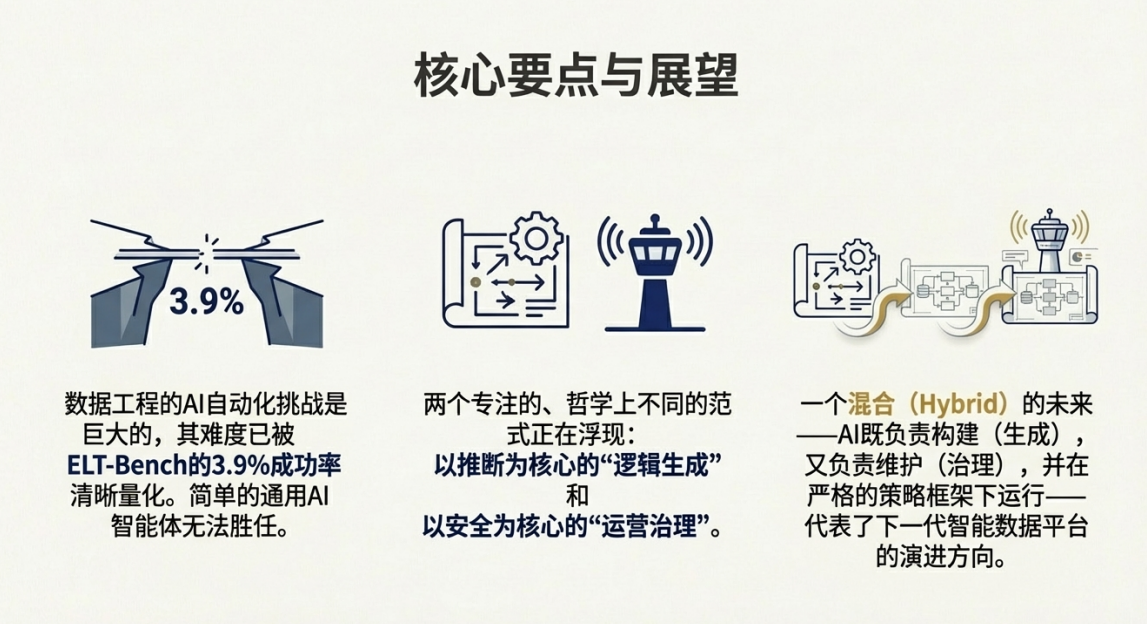

• 現有AI自動化的顯著侷限性: 儘管人工智能(AI)在許多領域取得了進展,但在核心的數據工程任務上仍力不從心。ELT-Bench的一項基準測試顯示,即便是當前表現最佳的AI智能體(Spider-Agent Claude-3.7-Sonnet),在最關鍵的數據轉換階段,成功率也僅為3.9%。更值得注意的是,為了達成這極低的成功率,AI智能體完成每個管道的平均成本為$4.30美元,並需執行多達89.3個步驟。這一數據清晰地表明,現有的通用AI工具遠未成熟到可以有效解決核心挑戰的程度。

這些效率低下問題不僅是技術挑戰,它們直接轉化為高昂的運營成本、遲緩的業務響應速度和被抑制的創新能力。現有通用AI智能體的災難性表現證明,我們需要的不是一個簡單的AI助手,而是一個從根本上重新設計的、由策略驅動並內置專業能力的自動化系統,以突破當前的戰略困局。

二.技術新範式:策略驅動的控制平面與自主化轉換引擎的整合

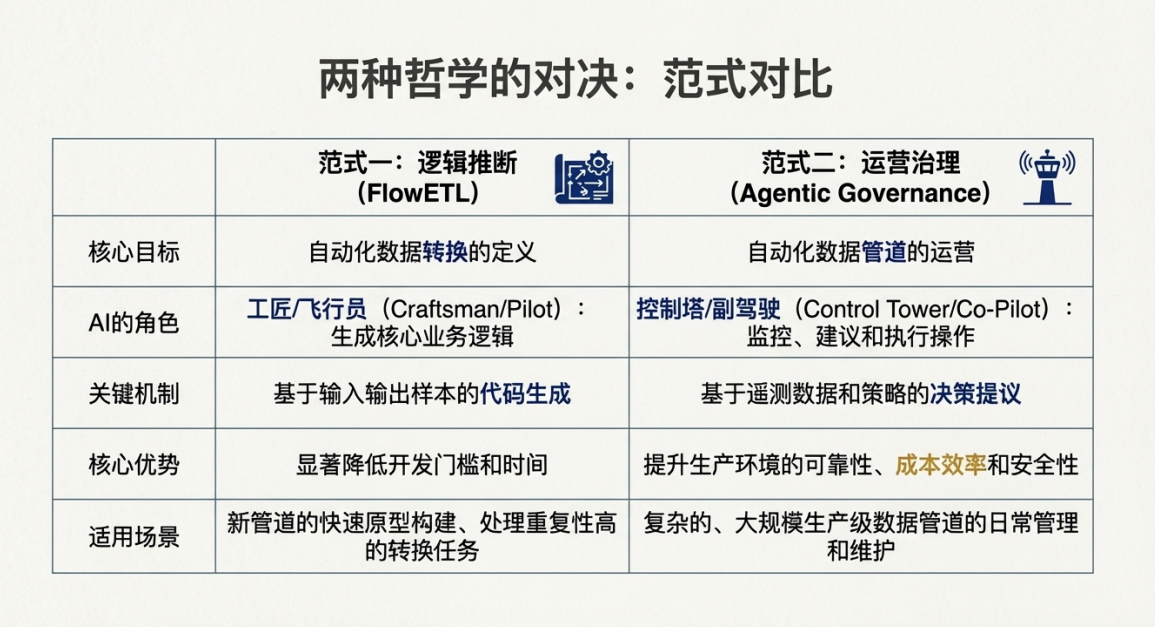

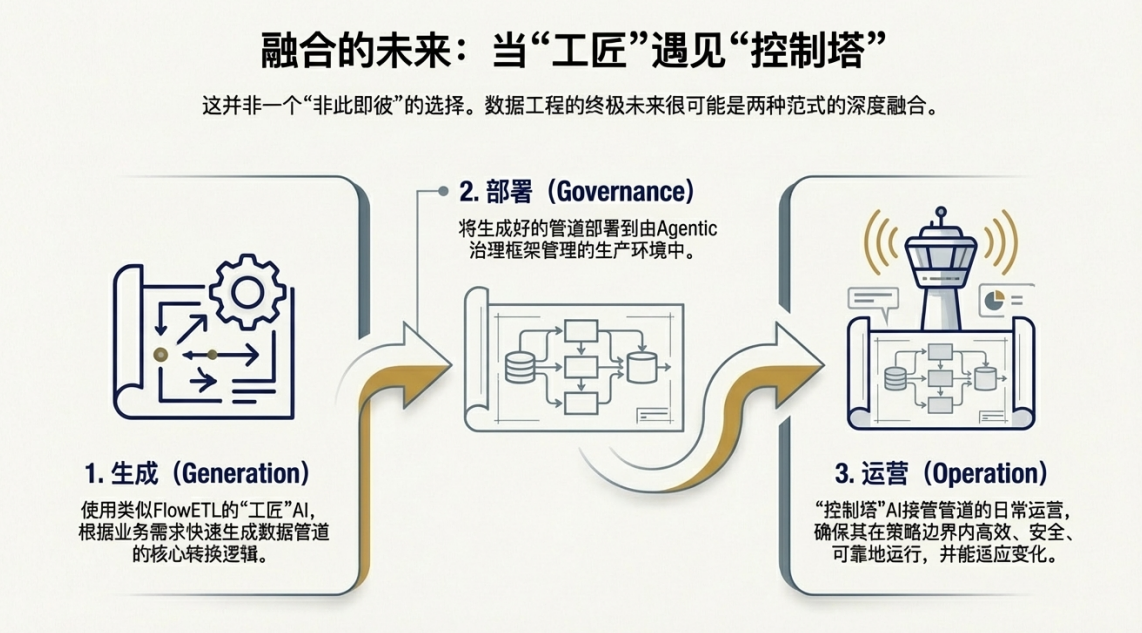

為應對上述根本性挑戰,我們需要構建一個集智能治理與高效執行於一體的整體解決方案。這一全新範式包含兩個核心組件:一個策略感知的智能“控制平面”,用於管理整個數據管道的生命週期;以及一個強大的自主“轉換引擎”,用於處理複雜的數據轉換任務。二者結合,將實現從被動的手動管理到主動的、由策略引導的自動化治理的戰略轉變。

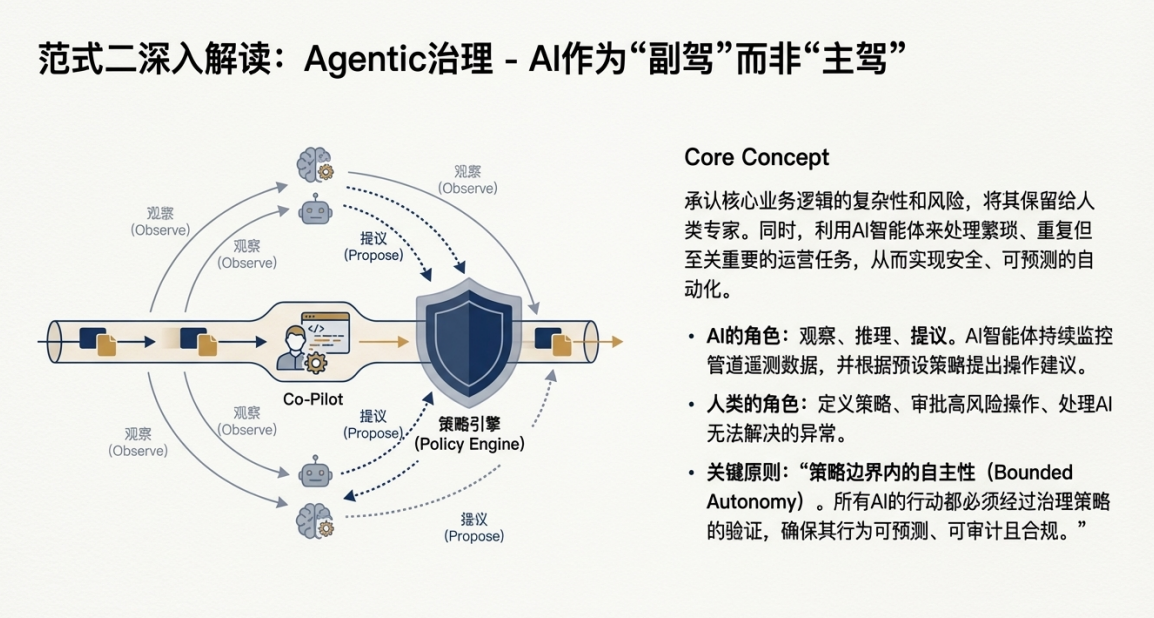

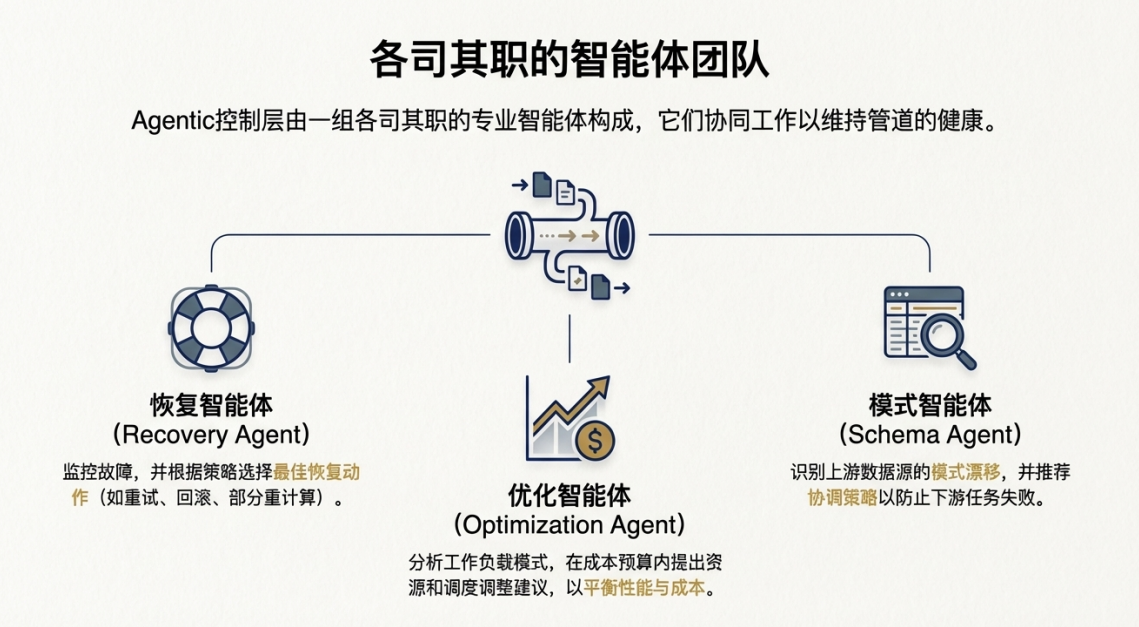

• 策略感知的智能代理控制 (Agentic Cloud Data Engineering) 這是一種頂層的治理與控制框架。它通過一系列專門的AI代理(如恢復代理、優化代理、模式代理)構成一個智能“控制平面”,主動監控數據管道的運行狀態。這些代理能夠基於實時遙測數據進行推理,並提出具體的操作建議,例如資源調整、故障恢復或模式變更。其核心優勢在於,所有代理提出的行動方案都必須經過預設的治理策略驗證,確保其行為不僅智能,而且完全可預測、可審計且符合合規要求。這從架構層面解決了通用AI工具在企業環境中不可控、不安全的根本性風險,確保了自動化行為的可靠性。

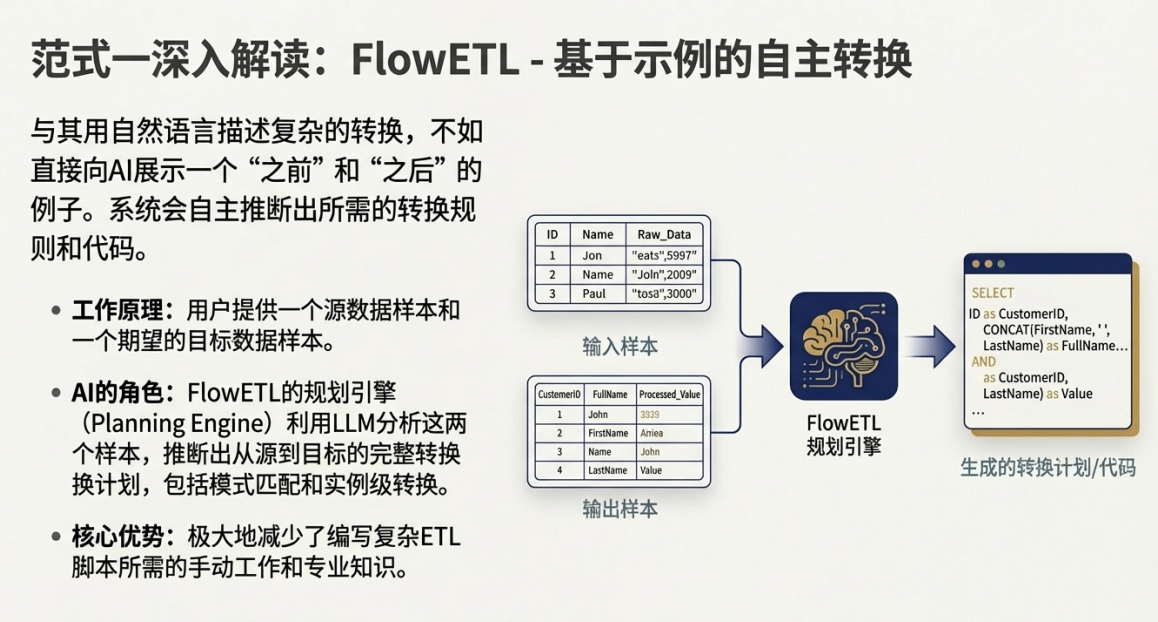

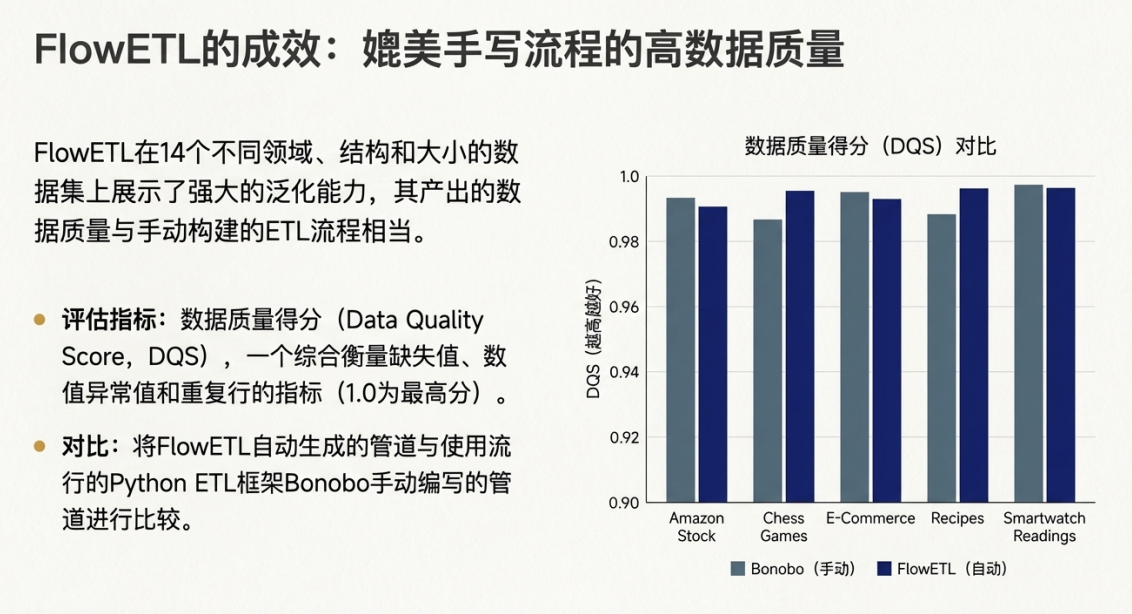

• 自主化、範例驅動的ETL (FlowETL) 這是在智能控制平面內部運行的高效轉換引擎。FlowETL架構提出了一種革命性的工作方式:開發人員不再需要手動編寫複雜的轉換邏輯,只需提供一個簡潔的“輸入-輸出”範例,系統便能自主推斷並執行所需的數據轉換。這種“範例驅動”的核心理念旨在最大限度地減少開發人員的直接干預,同時能夠自動處理常見的缺失值、數值異常值、數據規範化和去重等數據質量問題,從而在提升效率的同時,確保了產出數據的清潔與可靠。

通過將FlowETL這類高效的自主轉換引擎置於智能代理平台的治理框架之下,我們構建了一個既自動化又可控的端到端解決方案。這標誌着數據管理正經歷一場深刻的變革——從以“執行”為中心,向以“智能治理和自主優化”為中心的戰略轉變,為解鎖前所未有的業務價值奠定了堅實的技術基礎。

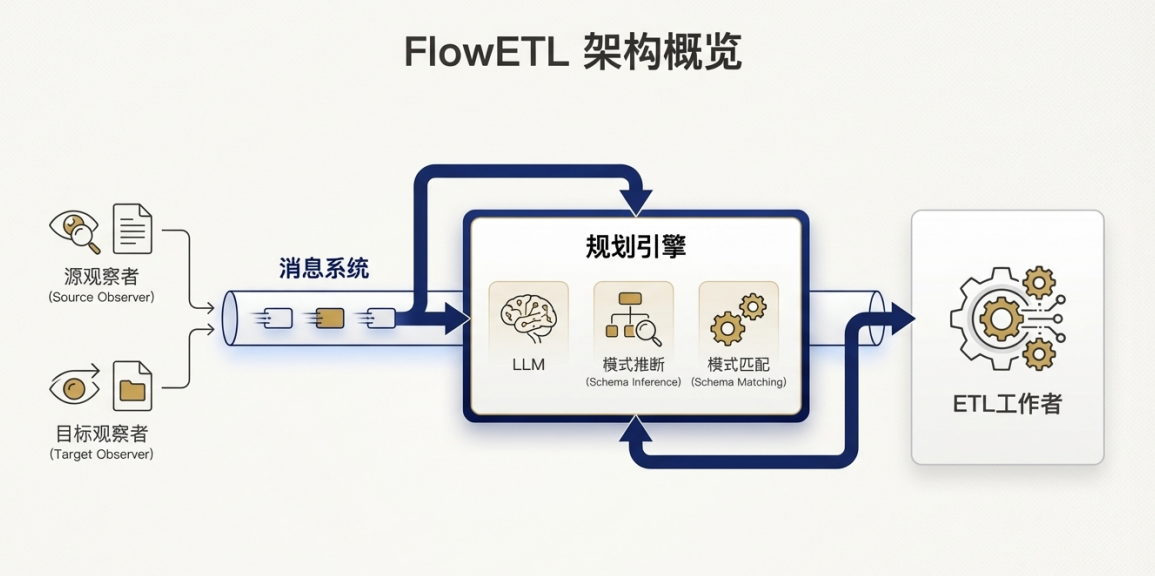

FlowETL:基於微服務和消息驅動的解耦架構

FlowETL採用了一種組件化、鬆散耦合的微服務架構,旨在實現高可擴展性和異步處理能力。其核心組件通過一個消息系統(如Apache Kafka)進行通信,實現了清晰的責任分離:

• Observers (數據觀察者):監控指定位置,當檢測到新的源文件和目標樣本文件時,將它們的信息發佈到消息系統。

• Planning Engine (規劃引擎):訂閲消息,消費源和目標樣本。它是系統的“大腦”,負責推斷轉換邏輯並生成一個詳細的執行計劃。

• ETL Worker (執行單元):獲取規劃引擎生成的計劃,並將其應用於完整的源數據集,執行實際的數據轉換操作,最終將結果加載到目標位置。

• Messaging System (消息系統):作為各組件之間的通信總線,確保了系統的解耦和異步處理能力。

FlowETL的一個核心抽象是內部表示(Internal Representation - IR),這是一種受數據幀(Dataframe)啓發的表格格式。無論輸入數據是CSV還是嵌套的JSON文件,都會被統一轉換為這種內部結構。對於JSON,系統會創建所有對象中鍵的並集來構成表頭。該設計極大地簡化了系統,使後續組件能夠處理標準化的數據對象。這種解耦的、消息驅動的架構是生產級解決方案的物理體現。通過將職責分離到“規劃引擎”和“ETL Worker”等專用組件中,FlowETL構建了一個可擴展、可維護、高韌性的“自動化工廠”,其設計目標是運營效率,而非AI代理測試。

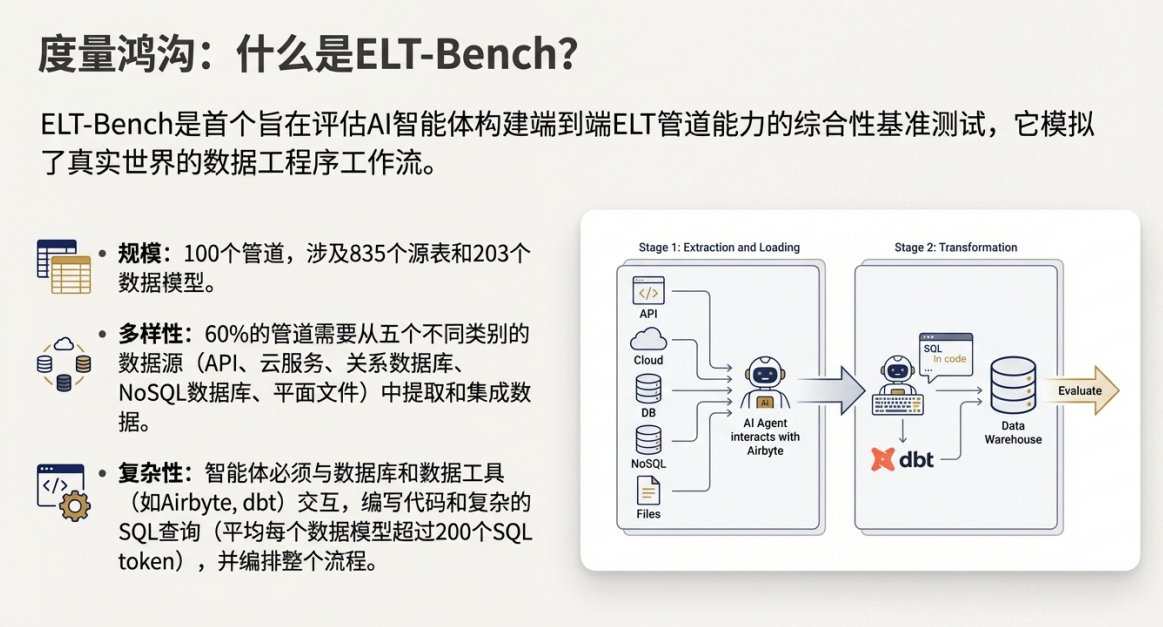

ELT-Bench:AI智能體的推理與行動循環

ELT-Bench所評估的AI智能體,其自動化機制遵循一種通用的“推理-行動”(Reason-Act)循環模式。在這種模式下,代理被賦予一個高級目標,然後需要自主地將目標分解為一系列具體步驟,並通過與環境交互來逐步完成。

在一個典型的ELT-Bench任務中,代理需要執行以下複雜序列:

1. 理解上下文:首先,代理必須仔細閲讀並理解項目基礎文件,如config.yaml(包含數據庫連接信息)和data_model.yaml(定義了最終目標表的結構和邏輯)。

2. 工具配置:接着,代理需要查閲提供的文檔,學習如何使用Terraform來配置Airbyte,正確設置多個異構數據源(如PostgreSQL、MongoDB、API等)的連接。

3. 邏輯實現:然後,也是最具挑戰性的一步,代理需要根據data_model.yaml中的自然語言描述,編寫出複雜的SQL查詢。這些查詢通常涉及多表連接、聚合、以及諸如RANK()這樣的排名函數,其中73個管道的每個數據模型平均需要超過200個SQL token才能實現。

4. 執行與調試:最後,代理執行它生成的代碼和命令,並根據命令行返回的輸出(無論是成功信息還是錯誤堆棧)進行調試和修正,直到任務完成。

這種機制的挑戰性在於,它極度依賴AI代理的代碼生成、工具使用、長期規劃和記憶能力。它並非針對ELT任務的特化設計,而是一種通用的、端到端的問題解決範式,試圖讓一個“黑盒”智能體學會成為一名數據工程師。

三.可量化的業務價值與戰略優勢

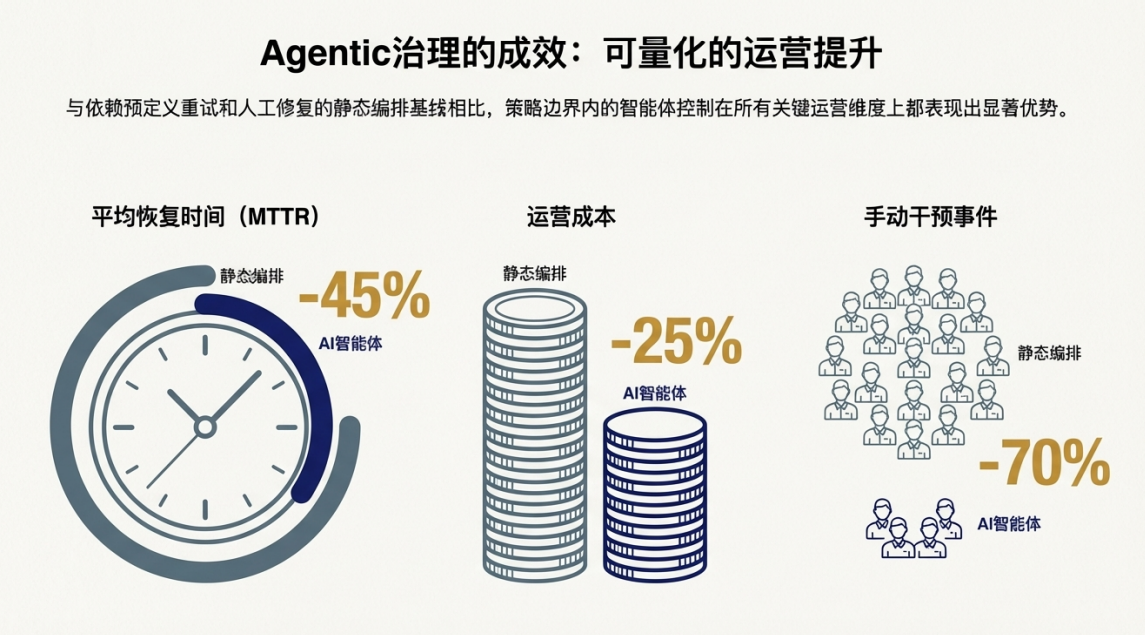

採用這一集成技術範式並非單純的技術升級,而是一項能夠帶來明確、可衡量投資回報(ROI)的戰略決策。其業務價值體現在運營效率、成本節約、系統可靠性和決策質量等多個維度。基於智能代理數據工程平台在企業級工作負載下的實驗結果,其商業影響力已得到清晰的驗證。

|

戰略優勢領域 |

量化提升成果 |

|

運營效率與人才優化 |

手動干預事件減少70%以上,將高價值工程師從故障修復中解放出來。 |

|

顯著的成本節約 |

整體運營成本降低約25%,實現直接的財務回報。 |

|

可靠性與業務連續性 |

平均故障恢復時間(MTTR)縮短高達45%,保障數據服務的穩定性。 |

|

數據質量與決策敏捷性 |

數據新鮮度顯著提升,保障高質量、高時效的數據供給。 |

這些數據點對業務的實際影響深遠:

• 運營效率與人才優化: 手動干預需求降低超過70%,意味着我們的工程師團隊可以徹底擺脱被動的“救火”模式,專注於數據架構優化、新數據產品開發等更高價值的創新活動。這不僅提升了團隊士氣,也最大化了我們的人才投資回報。

• 顯著的成本節約: 25%的成本降低並非一次性節省,它代表了向更高效運營模式的根本性轉變,能夠釋放可觀的運營支出(OPEX),用於再投資於其他戰略性數據項目和業務創新。這主要源於智能代理能夠根據實時工作負載動態優化雲資源,實現了成本與性能的最佳平衡。

• 可靠性與業務連續性: 平均故障恢復時間(MTTR)縮短45%,極大地降低了因數據服務中斷而導致的業務風險。更快的故障恢復意味着更短的業務停頓和更高的數據可用性,從而顯著增強下游業務部門對核心數據基礎設施的信任。

• 數據質量與決策敏捷性: 我們的策略治理框架通過改善數據新鮮度,確保了數據的時效性。同時,通過集成如FlowETL這類強大的轉換引擎——其已被證實能夠實現0.96至1.0之間的數據質量得分(DQS)——我們能確保交付的數據兼具高質量與高時效性。在瞬息萬變的市場環境中,這正是實現敏捷決策、搶佔市場先機的關鍵。

綜上所述,這些優勢共同構成了一個強有力的商業論證,證明投資於自動化與智能代理數據技術是推動公司數據能力現代化、構築核心競爭力的必然選擇。

四.戰略建議與後續步驟

我們正面臨一個關鍵的戰略抉擇:是繼續承受當前數據流程所帶來的高昂成本、低效率和創新遲滯,還是主動擁抱自動化與智能化技術,以此獲得決定性的競爭優勢。為了抓住這一機遇,我提議採取以下具體行動:

1. 批准戰略投資: 懇請管理層批准對自動化與智能代理數據管道技術的戰略性投資,將其作為公司數據基礎設施現代化的核心優先事項。

2. 啓動試點項目(Proof-of-Concept): 建議立即組建一個跨職能團隊,選取一個具有代表性的業務場景,啓動一個為期90天的試點項目。該項目旨在提供經驗性的內部驗證,證明該技術能直接解決我們在第一部分中識別的核心瓶頸。項目的成功將以實現我們預期的關鍵指標為衡量標準:手動干預減少70%、運營成本節約25%45%,從而為全面推廣建立強有力的商業案例。

3. 評估與全面推廣: 在試點項目結束後,我們將基於其量化成果、業務部門的反饋以及團隊的學習經驗進行全面評估。若成果符合預期,我們將制定一份詳細的技術推廣路線圖,分階段、分步驟地將該技術整合到公司的核心數據基礎設施中,並最終實現規模化應用。

通過這項戰略投資,我們將能夠構建一個更具彈性、更高效、更智能的數據基礎,它不僅是支撐當前業務的堅實後盾,更是驅動未來創新和增長的強大引擎。這將確保我們在新一輪的數字化競爭中,始終保持領先地位。