作者:SOFA 社區

背景

網關作為重要的中間件,在傳統業務中扮演着流量治理、路由轉發、協議轉換、安全防護等功能。根據不同業務場景的定位,也會衍生出不同類型的網關,例如流量網關、ESB(企業服務總線)、API 網關、雲原生網關。從網關職責看,其本質所承擔的職責沒有太多變化,主要是針對不同業務場景下作更多的適配,更好地滿足業務使用。比如,API 網關則是針對微服務場景,將原有的管理粒度從粗粒度的流量或服務,轉換成了細粒度的 REST 或接口維度的管理,從而實現了更精細化的治理,這是從流量網關演變為 API 網關的核心驅動力。

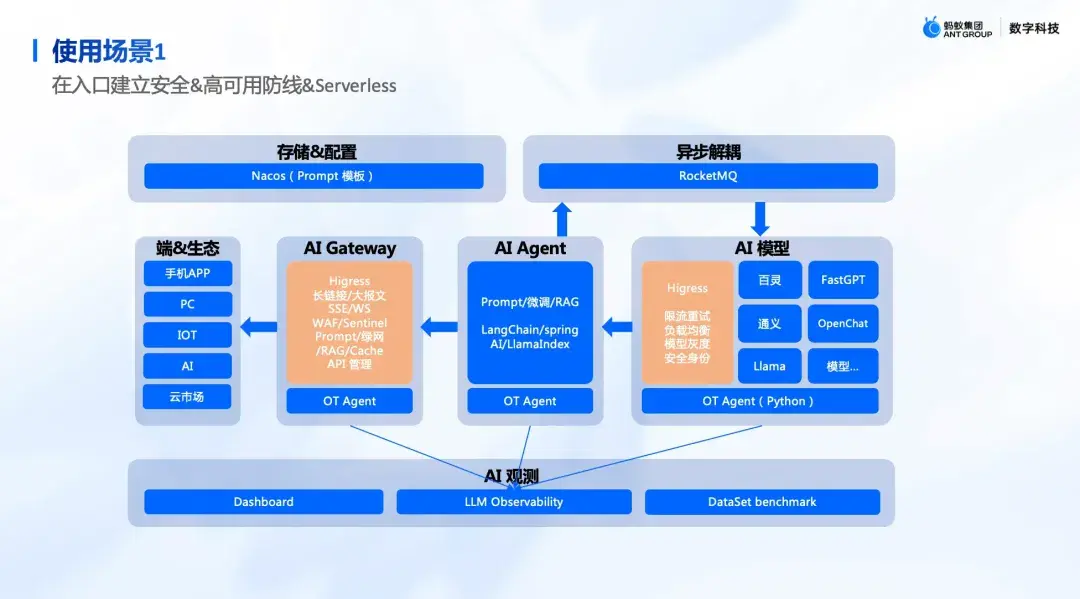

在 AI 場景下,業務模式發生了根本性的變革,網關所面對的挑戰也從“服務”轉向了“模型”和“智能體”等。這種轉變並非簡單的技術迭代,同時帶來業務邏輯、交互模式、資源消耗和風險模型的全面重塑。

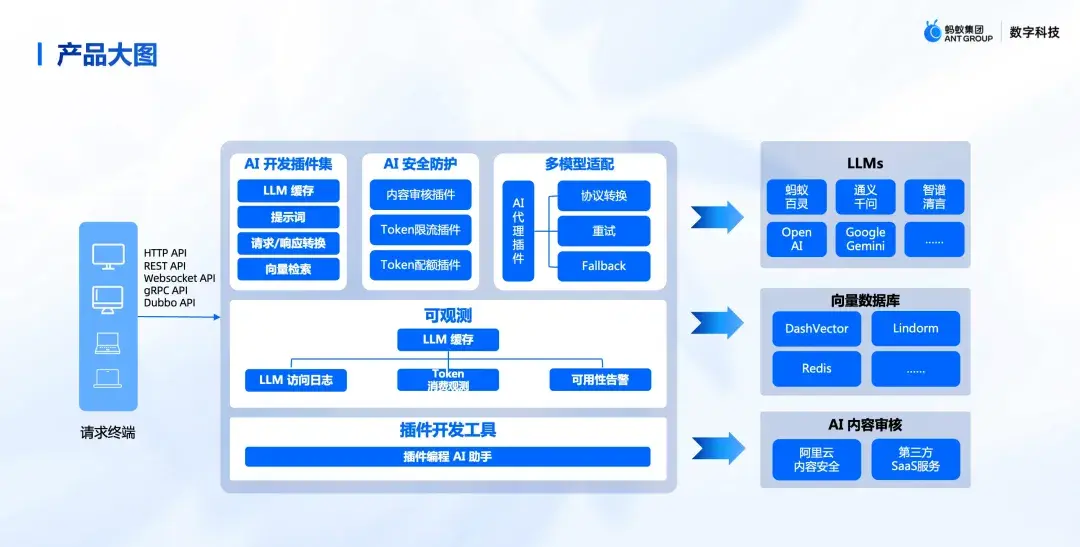

為了有效支撐日益複雜多樣的 AI 業務場景(如服務模型、智能體、AI 應用及 MCP 等),API 網關的角色亟需從通用型升級為專業化的 AI 網關。原有通用網關的核心能力已無法滿足這些場景的特定需求,因此 AI 網關針對性地拓展和強化了能力集,衍生出智能路由、模型統一接入、語義緩存、內容安全、MCP 代理、模型限流等核心特性。

為助力企業 AI 業務的快速發展,螞蟻集團 SofaStack 基於 Higress 推出了專為 AI 場景設計的 SOFA AI 網關(SOFA Higress),為企業 AI 應用提供高效、穩定且安全的統一入口。02

SOFA AI 網關定位

SOFA AI 網關(又名 SOFA Higress)基於開源 Higress 內核構建,專為 SOFA 深度優化、能力增強,是面向 AI 需求的智能網關解決方案。

SOFA AI 網關在構建之初即明確了其定位:為三類核心 AI 業務場景提供專業化服務:

- 智能體代理: 作為智能體流量的統一出入口網關,提供安全防護與流量管控。同時作為智能體的工具集(Tools Hub),統一管理工具列表,通過 AI 網關打通智能體與外部系統的連接。將業務存量 API 快速轉化為智能體可識別和調用的 Tools。此外,通過 MCP 協議提供 REST-to-MCP 轉換功能,加速存量業務 MCP 化進程,極大簡化智能體的對接與調用。

- 模型代理: 提供模型推理網關能力,集成語義緩存、內容安全、統一接入等核心功能,顯著降低模型接入複雜度與成本。同時,基於精細化業務屬性與特徵,提供精準的模型限流保障。

- MCP 市場服務: 構建金融領域專屬 MCP 市場,提供專業化的金融數據和豐富的金融業務服務,賦能金融場景業務,有效提升智能體研發的效率與質量。

下面將從以上三部分內容詳細展開。

落地實踐

3.1 技術選型

SOFA AI 網關使用 Higress 作為內核,主要考慮其強大的開源社區,豐富的擴展機制等,同時和網關未來多網關融合目標一致,因此我們基於 Higress 網關構建,並將原有 API 網關、數據網關、互通網關等能力遷移。

3.2 智能體出入口網關

當前智能體無疑是最熱的話題,很多企業開始構建自己的垂直業務智能體。為了幫助企業更好、更快地構建自己的智能體,我們將網關明確定位為智能體流量的統一出入口網關。

SOFA AI 網關為智能體提供關鍵能力:

- 保障入口安全與穩定: 對進入智能體的下游流量實施安全防護與業務限流,確保智能體應用的穩定運行與安全防護。

- 賦能智能體核心能力: 智能體自身需依賴模型、工具、知識庫等進行推理、規劃並緩解幻覺問題,以持續提升問題解答質量,最終成為專業的智能體。為此,網關在智能體的出口流量側對出口流量統一收斂,簡化智能體與外部對接成本。

SOFA AI 網關在智能體出口流量側,主要提供了以下幾個關鍵功能:

- 模型代理。 提供統一的模型接入與管理層,支持便捷的模型替換(如 A/B 測試效果驗證)、流量控制及 Token 統一管理,大幅簡化智能體研發過程中的模型迭代。鑑於模型資源成本高昂,網關還實現了業務級精細化的模型調用限流,有效防止部分業務過度消耗資源,保障整體模型服務的性能與穩定性,避免資源爭用。

- 工具和 MCP 管理。 SOFA AI 網關充當智能體與企業存量系統的橋樑,將現有的 REST API 標準化封裝為智能體可識別的 Function 調用,實現服務的便捷集成與統一管理。隨着 MCP (Model Calling Protocol) 協議的出現,網關進一步將存量 API 轉換為 MCP 格式供智能體使用,極大簡化了智能體對接後端服務的流程。對於企業採購的外部 AI 服務(通常具有獨立的認證體系),網關作為統一的出口代理,處理複雜的對接協議和認證,使智能體能夠無縫調用外部能力,專注於核心業務邏輯。

- 數據服務與快速取數: SOFA 網關內置數據開放 API,能夠將大數據平台處理後的結果,通過 SQL 查詢動態生成 REST API,進而封裝為智能體可直接使用的工具。鑑於 NL2SQL(自然語言轉 SQL)和 NL2Data(自然語言取數)技術的興起,網關規劃集成此類功能,未來將支持用户/智能體通過更自然的語言指令高效獲取所需數據。

3.3 推理網關-模型智能路由代理

網關在代理模型服務時與傳統服務代理存在顯著差異。這種差異的根源在於模型服務自身獨特的流量特性,主要包括:

- 高延遲與排隊效應: 模型推理需複雜計算,單請求處理時間遠超傳統服務(可達數秒至分鐘)。新請求到達時,若實例正忙,會進入隊列等待,導致首個 token 響應時間大幅延長,用户體驗下降。這與傳統服務的快速處理模式形成對比。

- 高資源消耗與持續佔用: 模型推理依賴 GPU 等專用硬件,是計算密集型任務。GPU 資源(顯存和算力)是關鍵瓶頸,一個推理請求會全程佔用資源,無法像傳統無狀態服務那樣快速釋放資源。

- 處理時間差異大: 模型請求耗時受輸入/輸出長度、模型複雜度和任務類型影響,波動極大(幾秒到數分鐘)。這種不確定性使傳統基於固定時間窗口或連接數的負載均衡策略難以適用。

正是基於模型流量的上述核心特點,傳統網關常用的負載均衡策略(如簡單的輪詢、最少連接數、隨機)在模型服務代理場景下往往效果不佳,甚至適得其反。例如,輪詢可能將新請求分配給已滿載並處於排隊狀態的實例,從而進一步加劇延遲。因此,模型服務網關需要提供更智能的路由策略,能夠根據模型實例的實時負載、KV Cache 狀態、隊列情況等指標進行動態決策。

SOFA AI 網關作為模型的統一入口,負責實現模型的多集羣路由與代理功能,並提供模型註冊、下線的生命週期管理以及智能路由能力。

SOFA AI 網關的智能路由邏輯與開源 Higress 以及業內推理網關的實現方式有所不同,但融合了兩者的優勢。Higress 的智能路由能力完全在插件中實現,即所有路由邏輯均通過插件方式開發和集成,包括基於 metrics 指標的路由。這種設計在性能上表現較佳。而當前業內的推理網關普遍基於 Gateway API Inference Extension 規範實現,通過獨立部署的 EPP 服務進行路由選擇。

SOFA AI 網關出於提升交付效率的考慮,既未選擇直接修改 Higress 數據面源碼集成 Gateway API Inference Extension 能力,也沒讓業務側直接在插件裏寫路由插件。相反,我們通過開發 Higress 插件,通過支持 ext-proc 協議對接業務側的 EPP 服務或使用 http 協議對接傳統服務,方便自定義路由擴展。

當然,未來為更好地與行業標準對齊,我們也計劃在數據面進行修改,以集成原生的 Gateway API Inference Extension 能力。

3.4 MCP 市場

在智能體項目的實踐中,我們認識到高質量的工具(特別是專業化的 MCP)和權威數據是智能體能力的關鍵。通用大模型在金融等專業領域落地存在顯著侷限:知識可能過時、缺乏深度行業理解、難以保證回答的準確性與合規性。

專業工具(MCP)的作用在於:

- 提供精準、實時的專業能力: 將複雜的金融分析、診斷、解讀等任務封裝為可調用的服務,確保輸出結果的專業性和可靠性。

- 接入權威、動態的數據源: 直接對接處理好的專業數據及合作方的核心金融數據,解決通用模型數據滯後、來源單一的問題。

- 提升效率與可擴展性: 將特定能力模塊化、服務化,便於智能體按需調用,也利於能力的持續迭代和複用。因此我們基於螞蟻的金融專業能力,以及在寧波等項目沉澱的智能體研發經驗,將一些有質量的金融數據、金融服務包裝成 MCP,構建一個 MCP 市場,為專有云的智能體提供 SaaS 化服務。 我們旨在將沉澱的金融專業能力(知識、數據、流程、風控等)進行標準化、服務化封裝,構建一個金融能力“樂高”市場。SOFA AI 平台已上架並持續豐富一系列面向金融場景的 MCP,為智能體提供強大的“專業工具箱”。目前已經上架多個金融領域 MCP,如產品診斷、配置選品、行情解讀、事件解讀等。

MCP 市場地址: https://mcp.sofa.antdigital.com/mcp/home

未來展望

在建設過程中,我們也遇到了一些新的挑戰,主要包括實體識別準確度不足和 MCP 上下文超限等問題。

實體提取不清晰:用户通過自然語言查詢或操作 MCP 服務時,涉及的關鍵輸入(如基金、股票名稱或代碼)高度依賴精準的實體識別。然而,當用户使用別名、行業非標準稱謂(俗稱“黑話”)或不完整名稱時,模型提取的結果可能無法準確對應到真實的金融實體(如基金名稱或證券代碼)。這直接影響後續處理的準確性和用户體驗。因此,我們亟需引入“提槽”工程能力,通過對識別結果進行精細化校驗和映射,以提升用户交互體驗和信息召回率。

MCP 上下文爆炸:目前平台已上架的專業 MCP 達到 15 個,且未來數量將持續增加。接入過多的 MCP 會顯著膨脹單個請求的處理上下文(Context),對模型的性能和資源消耗造成壓力。針對此問題,構建一套智能化的 MCP 路由機制變得尤為重要,以便根據用户請求精準篩選所需的服務模塊,避免不必要的上下文加載。

構建提槽能力和 MCP 智能路由能力,也將是 SOFA AI 網關在下半年重點發力的方向。

最後,感謝 Higress 開源團隊,因為有 Higress 這麼好的產品,SOFA AI 網關才能得以快速孵化。