本文將深入探討 Agent應用中的記憶需求、記憶類型、技術組件和主流開源框架,並介紹基於亞馬遜雲科技的數據產品自行構建記憶模塊,以及基於Agent構建平台Bedrock AgentCore的Agent memory的託管方案。

前言

當前大語言模型的困境

大語言模型在處理和生成文本方面表現出色,但它們在本質上是無狀態(stateless)的。這意味着每次與LLM的交互都是獨立的,模型本身不會“記住”過去的對話或經驗。大模型在“記憶”上主要侷限於:

- 上下文窗口的限制導致遺忘問題。LLM通過一個有限的“上下文窗口”(Context Window)來處理信息。所有輸入(包括Prompt和之前的對話片段)都必須塞入這個窗口。一旦信息超出這個窗口,LLM就“忘記”了它,無法再訪問。這導致了所謂的“遺忘”問題;

- 難以處理多輪/複雜任務。對於需要跨越多輪對話、追蹤狀態或執行一系列子任務的複雜任務,LLM很難保持連貫性和進展,因為它會不斷“忘記”之前的步驟和決策。特別是在Agent的場景,工具的定義和工具的返回值都會存在於上下文中,同時由於Agent具有自主工作的能力,和LLM的平均交互的輪數也大大增加;

- 無法個性化。由於不記住特定用户的歷史偏好、習慣或之前的互動,LLM難以提供真正個性化的體驗。每次互動都像是第一次見面;

- 長上下文帶來的性能和成本影響。推理速度變慢:LLM在處理更長的上下文時,需要進行更多的計算來處理和理解所有輸入信息。這會導致推理時間增加,響應速度變慢。模型表現下降:儘管LLM的上下文窗口越來越大,但研究發現,模型在超長上下文中檢索關鍵信息的能力可能會下降。更高的Token費用:上下文越長,輸入的token數量就越多,從而導致每次API調用的成本更高。對於需要頻繁交互或處理大量文本的應用來説,這會迅速累積成可觀的費用。

📢限時插播:無需管理基礎設施,利用亞馬遜技術與生態,快速集成與部署生成式AI模型能力。

✨ 精心設計,旨在引導您深入探索Amazon Bedrock的模型選擇與調用、模型自動化評估以及安全圍欄(Guardrail)等重要功能。

⏩快快點擊進入《多模一站通 —— Amazon Bedrock 上的基礎模型初體驗》實驗構建無限, 探索啓程!

為什麼需要記憶模塊

記憶系統旨在克服LLM的侷限性,賦予智能體以下核心能力:

- 長期保留與高效管理:存儲超出LLM上下文窗口的信息,實現高效檢索和過濾,避免信息遺忘;

- 持續知識更新:通過存儲與環境和用户的交互經驗,實現自我改進和知識更新;

- 個性化服務:記錄用户偏好和歷史互動,提供定製化迴應;

- 複雜任務支持:追蹤多Agent任務進展和中間結果,確保連貫完成並優化決策;

- 提升交互質量:保持上下文連貫性,支持深入推理,並通過反思機制從錯誤中學習。

AI Agent 記憶類型

智能體的記憶系統主要分為短期記憶和長期記憶兩大類。

短期記憶/工作記憶

短期記憶(Short-term Memory, STM)是智能體維護當前對話和任務的即時上下文系統,主要包括:

- 會話緩衝(Context)記憶:保留最近對話歷史的滾動窗口,確保回答上下文相關性;

- 工作記憶:存儲當前任務的臨時信息,如中間結果、變量值等。

短期記憶受限於上下文窗口大小,適用於簡單對話和單一任務場景。

長期記憶

長期記憶(Long-term Memory, LTM)是智能體用於跨會話、跨任務長期保存知識的記憶形式。它對應於人類的大腦中持久保存的記憶,例如事實知識、過去經歷等。長期記憶的實現通常依賴於外部存儲或知識庫,包括但不限於:

- 摘要記憶:將長對話內容提煉為關鍵摘要存儲;

- 結構化知識庫:使用數據庫或知識圖譜存儲結構化信息;

- 向量化存儲:通過向量數據庫實現基於語義的記憶檢索。

- 長期記憶使智能體能夠隨着時間累積經驗和知識,它特別適用於知識密集型應用和需要長期個性化的場景。

記憶管理與使用相關技術

設計開發Agent的記憶系統時要考慮不同場景下如何選擇記憶內容、設計寫入策略、組織記憶結構、實現檢索召回四個方面。

記憶產生:判斷哪些信息需要被記憶

在構建智能體記憶系統時,首先要根據具體的場景確定哪些信息值得記憶。這些記憶往往是多維度和動態的信息結構,包括時間維度(理解時間依賴的關係和序列)、空間維度(解釋基於位置的和幾何關係)、參與者狀態(跟蹤多個實體及其不斷變化的狀況)、意圖上下文(理解目標、動機和隱含的目的),以及文化上下文(在特定社會和文化框架內解釋交流)。

並非所有對話內容都需要長期保存,下面以4種常見場景舉例哪些是與任務相關、對後續交互有價值的記憶要點。

對於代碼助手類的智能體,記憶應側重用户項目的上下文和偏好。包括:用户項目的代碼庫結構(文件組織、模塊關係)、命名風格(變量命名約定、代碼格式風格)、常用的框架/庫以及用户以前提供的代碼片段或指令等。記憶這些信息可以更貼合定制化需求和項目實際情況給出建議。例如,沒有記憶支持時,開發者常常需要重複告訴 AI 項目的架構或糾正 AI 偏離項目規範的行為,這非常低效。而引入持久記憶後,AI 可以持續參考之前存儲的項目背景,”記住”用户的技術棧,從而保持技術決策的一致性。同時,代碼助手還能記憶用户過往的提問和反饋,例如某段代碼曾反覆修改,下一次遇到類似問題時可直接調用之前的方案,避免重複推理。總之,在代碼場景中,記憶系統使AI能夠理解長期的項目上下文,提供風格一致且上下文相關的代碼補全和解釋。

對於智能客服類的智能體,記憶的重點是用户歷史和偏好,以便提供連貫且個性化的服務。包括:用户當前任務的狀態,提過的問題、故障、產品使用,服務配置,和解決方案記錄。當用户第二次來詢問類似問題時,不必重複描述自己之前的問題細節,系統能夠回憶起上次給出的建議或已經嘗試過某些步驟,直接切入重點解決當前問題。此外,記憶用户的產品使用情況和喜好(例如偏好哪種通信渠道,是否傾向自助解決)可以使響應更加貼合用户習慣。這樣實現更快的問題解決和更高的客户滿意度,增強對品牌的信任。

對於個人助理智能體,記憶重點包括:用户個人信息和日程表、目標(如健身學習計劃)、經常執行的行為模式(如每週幾鍛鍊)以及對應用和服務的偏好(如偏好哪種提醒方式)等。這樣智能體會提醒日程,並結合過往偏好提供個性化安排(比如知道用户週五喜歡外賣,在傍晚時主動推薦餐廳)。隨着交互增加,持續的長期記憶使智能體能不斷適應用户,逐漸減少對用户指令的依賴,實現更主動和貼心的服務。

對於推薦服務智能體,記憶重點包括:用户的顯式反饋(如用户給某本書點贊或明確表達不喜歡某商品)和隱式反饋(如瀏覽記錄、點擊行為、購買歷史),以此構建興趣檔案,在後續交互中個性化推薦。並持續學習,對過往推薦的反饋(是否點擊、購買),不斷調整推薦策略,更新畫像。提高推薦轉化率也增強用户忠誠度。

記憶管理的實際例子

以下是在一個長文檔處理的Agent項目中使用的上下文壓縮提示詞,當上下文超過指定的限額時,將觸發基於LLM的壓縮機制。

# Custom system prompt for document processing domain summarization

custom_system_prompt = """您正在總結文檔處理工作流對話。創建一個簡明扼要的要點摘要,該摘要:

專注於文檔處理任務、章節生成和工作流進度

保留特定文件路徑、章節名稱和任務完成狀態

維護待辦事項列表狀態和進度跟蹤信息

省略對話元素,專注於可操作的工作流信息

使用適合文檔處理和內容生成的技術術語

保留錯誤消息和重要狀態更新

以要點形式呈現,不使用對話語言,按以下方式組織:

文檔處理:[關鍵處理步驟和結果]

章節生成:[已完成的章節和當前進度]

待辦狀態:[當前工作流狀態和待處理任務]

文件位置:[重要文件路徑和輸出]

錯誤/問題:[遇到的任何問題及解決方案]記憶策略

智能體的記憶更新可通過輪數或事件觸發。輪數觸發是每隔3-5輪對話自動生成摘要存入記憶;事件觸發則在完成任務、場景轉換等關鍵節點記錄信息。例如,客服完成問題處理時保存解決方案,個人助理更新日程後寫入日曆。開發者可實現監控邏輯,在對話累積或話題轉換時,讓大模型對近期對話生成摘要,提取關鍵信息並添加標籤便於檢索。

系統也可支持用户主動標記需要記住的信息,如通過口頭指令或界面操作。這不僅讓用户指定重要內容,也支持刪除特定記憶的需求,確保用户對數據的控制權。

記憶存儲:記憶組織結構設計

記憶數據通常採用用户→會話→記憶片段的三層結構管理。用户層區分不同賬號空間,會話層隔離各對話上下文,記憶片段層存儲具體內容及元數據(如時間、關鍵詞、來源等)。複雜系統可能需要維護多個記憶庫,包括短期工作記憶、長期情節記憶、語義知識庫等。合理的結構設計有助於快速檢索和有效管理記憶內容。

記憶檢索:記憶查詢與召回邏輯

智能體需要基於當前對話意圖從記憶庫中檢索相關信息。主要檢索方法包括關鍵詞匹配、向量語義搜索和元數據過濾。系統將檢索到的記憶按相關度排序,選取最相關內容加入到對話上下文中,用於生成更準確的響應。例如在推薦場景中,可基於用户歷史偏好記憶提供個性化建議。

上下文工程(Context Engineering)與記憶

上下文工程

上下文工程與記憶系統形成共生關係,共同支撐智能體的認知能力。記憶系統作為”信息倉庫”,存儲歷史對話、知識和用户偏好;而上下文工程則扮演”智能調度員”,決定從記憶中檢索哪些信息及如何組織呈現給LLM。

上下文工程的核心在於,LLM的性能和有效性根本上取決於其接收的上下文。實現了上下文工程的系統一般包含三類基礎組件:

- 上下文檢索與生成: 涵蓋Prompt生成和外部知識獲取;

- 上下文處理: 涉及長序列處理、自我完善和結構化信息集成;

- 上下文管理: 關注記憶層次、壓縮技術和優化策略。

這些組件是高級應用實現(如RAG、顯式記憶系統和智能體系統)的基石。由此,我們可以將上下文工程定義為:上下文工程將上下文C重新概念化為一組動態結構化的信息組件,c1, c2, …, cn。這些組件由一組函數進行來源獲取、過濾和格式化,最終由高級組裝函數A進行編排。

上下文工程與記憶的關係

上下文工程與記憶系統緊密且共生,都是AI智能體的重要構建手段。一方面,記憶是上下文的“倉庫”, 智能體的記憶系統(如歷史對話、知識庫、用户偏好)是信息存儲地,為LLM提供潛在上下文。另一方面,上下文工程是記憶的“調度員”和“優化器”,上下文工程決定從記憶中檢索哪些信息及如何檢索,確保提取最相關的記憶片段。

上下文工程在項目中的例子

在一個文檔自動化處理生成的Agent項目中,我們面臨一個關鍵挑戰:輸入文檔總量超過500頁,遠超模型的最大Token限制,同時項目對生成內容的召回率和準確率有較高要求。

為解決這一問題,我們實施了以下上下文工程策略:

- 文檔分塊處理:將大型文檔集合切分為適當大小的chunks,並存儲在文件系統中;

- 摘要生成:為每個文檔塊生成精煉的文字摘要,提供內容概覽。並生成整個文檔的摘要信息;

- 動態上下文管理:賦予Agent自主選擇的能力,使其可以根據任務需求動態調取相關文檔塊;

- 上下文優化:任務完成後自動釋放不再需要的上下文,優化資源利用。

這種方法使Agent能夠在保持高準確率的同時,有效處理超過模型上下文限制的文檔集合。

主流記憶框架分析

基於上個章節介紹的設計思路,核心組件和優化策略,業界涌現了多種記憶機制的實現方案。以下我們從開源框架(Mem0,MemGPT,LangMem以及他們與亞馬遜雲科技服務的集成)和亞馬遜雲科技商業解決方案(AI Agent構建託管服務Bedrock AgentCore的記憶模塊)兩個角度,對目前主流的Agent記憶方案進行分析,比較它們的特點、適用場景以及部署成本。

Mem0

Mem0是專為AI Agent設計的開源記憶框架,通過智能記憶管理幫助Agent實現狀態持久化。它支持工作記憶、事實記憶、情景記憶和語義記憶等多種類型,提供智能的LLM提取、過濾和衰減機制,有效降低計算成本。同時支持多模態處理和Graph記憶功能,既可使用託管服務也可自建部署。

從架構來看,Mem0包含幾個核心模塊:核心記憶層、大語言模型層、嵌入模型層、向量存儲層、圖存儲層和持久化存儲層。核心記憶層是構建核心邏輯來判斷新增、檢索、更新和刪除記憶的相應實現;大語言模型層負責根據用户輸入提取出關鍵信息,以及生成如何更新記憶的決策;嵌入模型和向量存儲層負責支持記憶的向量化存儲和檢索;圖存儲層負責存儲抽取出的實體關係,豐富記憶的組織形態;持久化存儲層負責存儲對記憶系統的操作信息。這種分層架構設計確保了記憶系統的可擴展性和可維護性,

每層職責明確,便於針對不同場景進行優化配置。

Mem0 的設計理念專注於智能記憶管理而非簡單數據存儲,融合了幾個關鍵技術創新:

- 雙 LLM 架構:系統通過兩次不同的 LLM 調用實現複雜的分工。第一次專注於信息提取,第二次專門處理決策過程,提高準確性並允許專門優化。

- 上下文感知處理:在現有記憶上下文中分析新數據,確保記憶系統一致性和連貫性,防止碎片化並維護信息間邏輯關係。

- 智能去重機制:結合向量相似性搜索與LLM判斷,防止冗餘信息存儲,保持記憶質量和系統效率。

- 衝突解決能力:當出現矛盾信息時,智能確定保留、更新或刪除的適當行動,適應用户偏好和環境的動態變化。

Mem0與Agent框架的集成

開發者可以通過兩種方式集成Mem0:一是在環境變量配置依賴信息後,直接調用Mem0的接口函數(如添加、查找、更新記憶等);二是將Mem0封裝成工具傳入Agent框架,由Agent根據處理邏輯自主調用相應方法。

Mem0與亞馬遜雲科技的集成

亞馬遜雲科技的多項服務均支持與Mem0集成,為開發者提供完整的企業級記憶解決方案:

- 模型服務集成:支持Amazon Bedrock的多種模型,包括Claude-3.7-Sonnet用於複雜推理、Titan-Embed-Text-v2用於向量化處理。

-

存儲服務集成:

- 向量存儲:Amazon Aurora Serverless V2 for PostgreSQL、Amazon OpenSearch

- 圖數據存儲:Amazon Neptune Analytics

- 開發框架集成:亞馬遜雲科技開源的StrandsAgent框架中內置了基於Mem0能力封裝的mem0_memory工具。

Mem0作為開源解決方案,為開發者提供了靈活的記憶管理能力。結合亞馬遜雲科技服務的強大生態,可以構建高性能、可擴展的Agent記憶系統,適合需要深度定製和成本優化的企業級應用場景。更多關於Mem0的深度解析以及和亞馬遜雲科技的服務的集成請見博客 https://amazon.awsapps.com/workdocs-amazon/index.html#/docume...

Letta (前身為MemGPT)

Letta 功能介紹

Letta(前身為MemGPT)是一個專注於構建具有持續記憶能力的 AI Agent 的框架,它的設計思路是將LLM代理類比為計算機操作系統,採用”虛擬內存“的概念來管理智能體的記憶。其核心創新在於雙層記憶架構,包括上下文內記憶(直接存在於模型上下文窗口中的系統指令、可讀寫記憶塊和當前對話)和上下文外記憶(存儲歷史對話和外部知識的長期存儲)。當上下文窗口接近填滿時,系統會自動將對話歷史壓縮為遞歸摘要並存儲為記憶塊,同時保留原始對話供後續檢索,通過工具如core_memory_append、core_memory_replace 和 recall 實現記憶的編輯與檢索,從而使 AI 代理能夠在長期交互中保持連貫性,真正實現記住過去、學習新知並隨時間演化的能力。

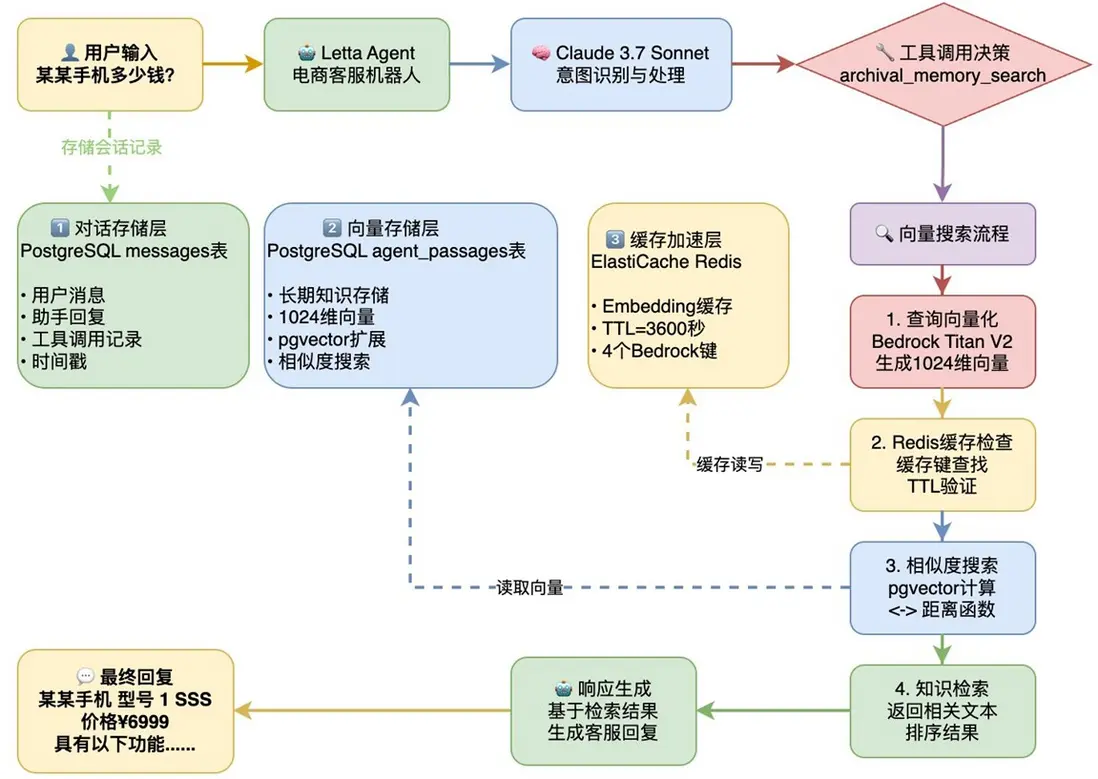

Letta與亞馬遜雲科技生態的深度集成

Letta可無縫對接亞馬遜雲科技服務棧,以下是一個通過 Letta 框架搭建的電商客服機器人問答流程示例:

- 使用 Amazon Bedrock 的 Claude 或 Titan 模型作為基礎 LLM

- 採用 Amazon PostgreSQL、OpenSearch 作為向量存儲後端

- 利用 ElastiCache 緩存來提升推理(框架原生支持)、問答等場景(需要搭建緩存中間件)的效率

- 通過 亞馬遜雲科技 Lambda 實現記憶管理的無服務器架構

圖1. 通過 Letta 框架搭建的電商客服機器人問答流程示例

LangMem

LangMem 是由 LangChain 開發的,旨在解決 AI 代理的”健忘症”問題。傳統的大語言模型在會話結束或上下文窗口被超出時會丟失之前的交互信息,而 LangMem 為 AI 代理提供了長期記憶能力,使其能夠跨會話保持知識連續性,記住用户的偏好、過往交互和重要事實。這一創新將 AI 代理從簡單的反應系統轉變為能夠隨時間學習和適應的動態助手。例如:你的 AI 助手能夠記住你上週提到的項目細節,瞭解你的工作習慣,甚至記得你喜歡的咖啡類型。

LangMem 框架的設計理念是借鑑人類心理學對記憶的分類,為Agent設計了三種核心記憶類型,每種類型都有其獨特的功能和應用場景。

- 語義記憶 (Semantic Memory):語義記憶是 Agent 的知識基礎,存儲客觀事實、用户偏好和基礎知識,作為長期持久化記憶嵌入系統提示中,可通過 Collection 方式保存完整歷史信息,或通過 Profile 方式只保留最新狀態,為Agent 提供穩定的知識支撐,確保其能夠準確理解和迴應用户需求。

- 情節記憶(Episodic Memory):捕捉 Agent 的交互經歷,不僅存儲對話內容,還包含完整上下文和推理過程,作為短期記憶主要用於構建用户提示詞,使 Agent 能夠從過往經驗中學習,參考成功案例調整響應策略,從而在類似情境中提供更加個性化和有效的解決方案。

- 程序記憶 (Procedural Memory):專注於”如何做”的實操知識,從初始系統提示開始,通過持續反饋和經驗積累不斷優化,作為短期記憶幫助 Agent 學習最有效的行為模式,既可用於系統提示也可用於用户提示,使 Agent 能夠根據不同情境靈活調整策略,提高解決問題的效率和準確性。

LangMem 不僅能存儲對話中的重要信息,還能優化提示和行為,在多次交互後提供更連貫、個性化的響應。它消除了傳統 AI 代理在會話結束後丟失上下文的問題,減少了重複詢問用户已提供信息的需要,顯著提升了用户體驗的連貫性和個性化程度。LangMem 提供通用存儲兼容性和熱路徑內存工具,使AI代理能在實時會話中即時保存和檢索信息。其智能後台內存管理功能自動提取、彙總並更新知識庫,且與 LangGraph 平台無縫集成。LangMem 的高級特性包括主動記憶管理、共享內存機制、命名空間組織和個性化持續進化能力,使 AI Agent 能根據重要性動態存儲信息,支持多個 Agent 之間的知識共享,高效組織檢索信息,並不斷適應用户需求變化,提供越來越精準的服務。

目前 LangMem 主要是與 LangGraph 集成,支持 Amazon Bedrock。在記憶存儲層面,針對開發場景,有內置的 InMemoryStore,支持快速的迭代、測試和原型設計;另外,提供對 PostgresqlSQL 的支持。對於其他記憶存儲引擎,LangMem 提供開放的接口實現方式,需要用户定製開發集成。

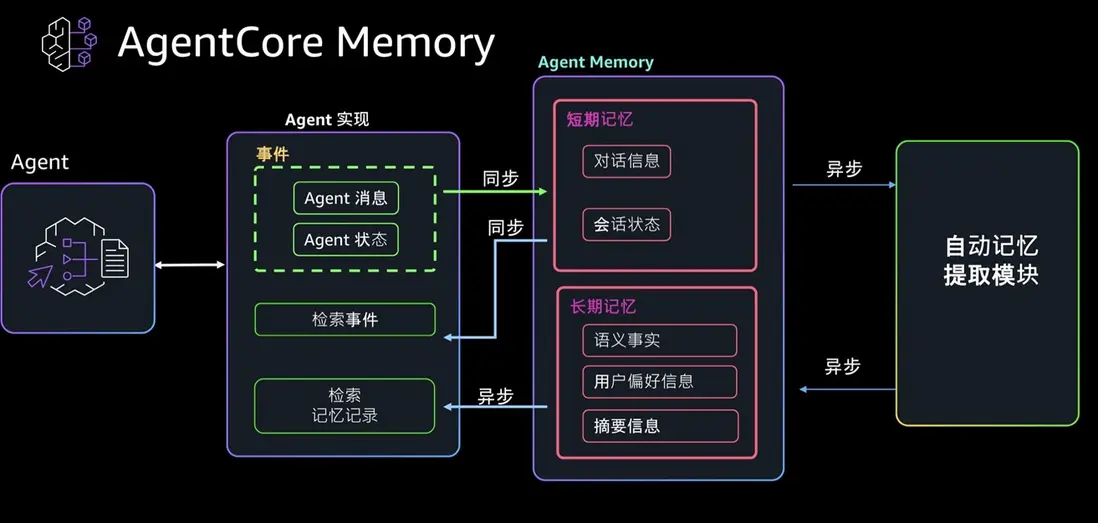

Amazon Bedrock AgentCore Memory:亞馬遜雲科技的託管記憶解決方案

相比開源框架,亞馬遜雲科技也提供開箱即用的託管服務,通過AI Agent構建平台Bedrock AgentCore中的記憶模塊幫助開發者更快捷地為AI Agent賦能記憶功能。您無需運維任何底層資源,只需一鍵即可集成業界領先的記憶系統。

圖2-Bedrock AgentCore中的記憶模塊核心功能展示

Amazon Bedrock AgentCore 的 Memory 模塊是一個由亞馬遜雲科技託管的持久化記憶系統,用於存儲和管理 AI Agent 的對話和知識。它提供短期記憶(short-term memory)和長期記憶(long-term memory)兩種模式。短期記憶負責在一次會話中記錄最近的最近幾輪對話,確保代理能夠“記住”當前對話的上下文。長期記憶則從對話中提取結構化的關鍵信息,在多個會話之間保留知識,使Agent能夠“學習”用户偏好、事實和摘要等信息。

記憶的存儲

Memory 模塊在架構上採用分層存儲策略:短期記憶層存儲原始交互事件作為即時上下文,長期記憶層存儲從事件提取的概要知識。Memory 服務背後實現了自動的信息處理流水線:當新的事件被存儲時,如果 Memory 配置了長期記憶策略,服務會異步地對事件內容進行分析(例如調用基礎模型)來提煉出可長期保存的知識片段。

AgentCore Memory 內置了多種記憶策略(Memory Strategy)來定義如何將原始對話轉化為結構化長期記憶。例如:

- SemanticMemoryStrategy(語義記憶策略):從對話中抽取出事實和知識,以便日後查詢。

- SummaryMemoryStrategy(摘要策略):為每個會話生成對話摘要,提煉主要內容。

- UserPreferenceMemoryStrategy(用户偏好策略):捕獲用户的偏好、風格和重複選擇等信息。

使用內置策略時,無需額外配置模型,AgentCore Memory 服務會在後台使用預置的模型來完成提取和歸納。當開發者調用 CreateEvent 保存新事件後,這些策略會被自動觸發,異步運行LLM分析內容併產生長期記憶記錄(memory records)。長期記憶記錄生成後存儲於 Memory 中,對應特定的命名空間和類型(如事實、摘要、偏好),每條記錄也有唯一ID以供檢索。

此外,AgentCore 允許自定義記憶策略(CustomMemoryStrategy),開發者可提供自定義的提示詞(prompt)和選擇特定的基礎模型來執行記憶提取,例如只提取某類domain知識。

記憶的使用

Memory 模塊提供檢索API,供應用在調用LLM推理時提取相關記憶並注入對話上下文中。在大語言模型生成回覆時,可以通過 Memory 提供的內容獲得額外的上下文信息。例如,開發者可以在每次生成回覆前,調用 list_events 獲取短期記憶的對話記錄,將其附加到 LLM 的提示中,以維護對話連續性。對於跨會話的信息,可以使用 retrieve_memories 接口通過語義查詢長期記憶,例如查詢某用户的偏好或某主題的事實知識,然後把檢索到的內容納入提示。這種機制確保LLM在回答新問題時,不僅有當前對話文本,還能利用 Memory 中沉澱的歷史知識,提高響應的相關性和智能性。

Memory as tool:Memory 模塊還可以與Agent框架的推理流程集成,實現自動的上下文注入。AgentCore Memory 可被包裝成一個工具(Tool)供 LLM 調用。以 Strands Agents 框架為例,開發者通過 AgentCoreMemoryToolProvider 將 Memory 註冊為工具,使得當模型需要回憶信息時,可以自主調用如 “agent_core_memory” 工具執行 retrieve 動作來查詢記憶,或用 record 動作將新的信息存入記憶。這種工具調用方式也可以通過Model Context Protocol (MCP) 等標準,讓 LLM 在推理中動態決定何時讀寫記憶,使Agent能夠更加自主地管理上下文。

所有數據由亞馬遜雲科技以加密方式存儲,並使用命名空間(namespace)進行隔離分區,確保不同應用或用户的記憶數據彼此分隔。這一完全託管的記憶基礎設施讓開發者無需自己搭建數據庫或向量存儲,就能方便地讓 Agent 擁有記憶功能。更多Bedrock AgentCore Memory的深度解析請見博客Amazon Bedrock AgentCore Memory博客

結語

記憶機制為 Agentic AI 注入了持續演進的靈魂,使智能體能像人類一樣從過去的互動中學習,在未來表現得更聰明、更貼心。無論是通過開源框架構建內部記憶模塊,還是藉助商業方案快速賦能,我們都應將記憶視作AI智能體的基礎而非可選項。可以肯定的是,在Agentic AI的大潮中,擁抱並善用記憶者,才能打造出真正有認知連續性的下一代智能體, 而亞馬遜雲科技也會持續走在技術與方案的前沿,與客户竭誠合作共創成功。

本文提到的技術資料鏈接

Strands Agent

https://aws.amazon.com/cn/blogs/china/practical-guide-to-building-agentic-ai-applications-for-aws-china-region/

AgentCore Memory官方文檔

https://docs.aws.amazon.com/zh_cn/bedrock-agentcore/latest/devguide/memory.html

AgentCore代碼樣例

GitHub – awslabs/amazon-bedrock-agentcore-sample

相關博客:

《Amazon Bedrock AgentCore Memory:亞馬遜雲科技的託管記憶解決方案》

本文將深入介紹亞馬遜雲科技提供開箱即用的託管服務,通過AI Agent構建平台Bedrock AgentCore中的記憶模塊幫助開發者更快捷地為AI Agent賦能記憶功能。

《相得益彰:Mem0 記憶框架與亞馬遜雲科技的企業級 AI 實踐》

本文將詳細探討mem0記憶框架和亞馬遜雲科技服務的集成方案。

關於Agentic AI基礎設施的更多實踐經驗參考,歡迎點擊:

Agentic AI基礎設施實踐經驗系列(一):Agent應用開發與落地實踐思考

Agentic AI基礎設施實踐經驗系列(二):專用沙盒環境的必要性與實踐方案

Agentic AI基礎設施實踐經驗系列(三):Agent記憶模塊的最佳實踐

Agentic AI基礎設施實踐經驗系列(四):MCP服務器從本地到雲端的部署演進

Agentic AI基礎設施實踐經驗系列(五):Agent應用系統中的身份認證與授權管理

Agentic AI基礎設施實踐經驗系列(六):Agent質量評估

Agentic AI基礎設施實踐經驗系列(七):可觀測性在Agent應用的挑戰與實踐

Agentic AI基礎設施實踐經驗系列(八):Agent應用的隱私和安全

*前述特定亞馬遜雲科技生成式人工智能相關的服務目前在亞馬遜雲科技海外區域可用。亞馬遜雲科技中國區域相關雲服務由西雲數據和光環新網運營,具體信息以中國區域官網為準。

本篇作者

本期最新實驗《多模一站通 —— Amazon Bedrock 上的基礎模型初體驗》

✨ 精心設計,旨在引導您深入探索Amazon Bedrock的模型選擇與調用、模型自動化評估以及安全圍欄(Guardrail)等重要功能。無需管理基礎設施,利用亞馬遜技術與生態,快速集成與部署生成式AI模型能力。

⏩️[點擊進入實驗] 即刻開啓 AI 開發之旅

構建無限, 探索啓程!