單目視頻到 4D 動態場景的重建長期以來被視為一個病態逆問題,缺乏基線使深度與運動難以解耦,傳統 SfM 只能恢復靜態外殼,而 NeRF-4D 又依賴數小時的逐場景優化,受制於幾何歧義、數據不足與算力開銷三重瓶頸。

字節跳動旗下的 Pico 團隊推出了新型 4D 視頻生成框架 EX-4D,能從單目視頻輸入生成極端視角下的高質量 4D 視頻。它核心創新在於提出了一種名為深度防水網格(DW-Mesh)的新型表示方法。它能夠同時建模可見區域與被遮擋部分,從而在極端相機視角下依然保持幾何結構的完整與一致。此外,團隊還設計了模擬遮擋掩碼策略,讓單目視頻也能產出高質量訓練數據,並結合輕量級 LoRA 視頻擴散適配器,生成的內容不僅物理一致,還保證了時間上的連貫性。在極端視角的測試中,EX-4D 的表現遠超現有方法,成為 4D 視頻生成的新解決方案。

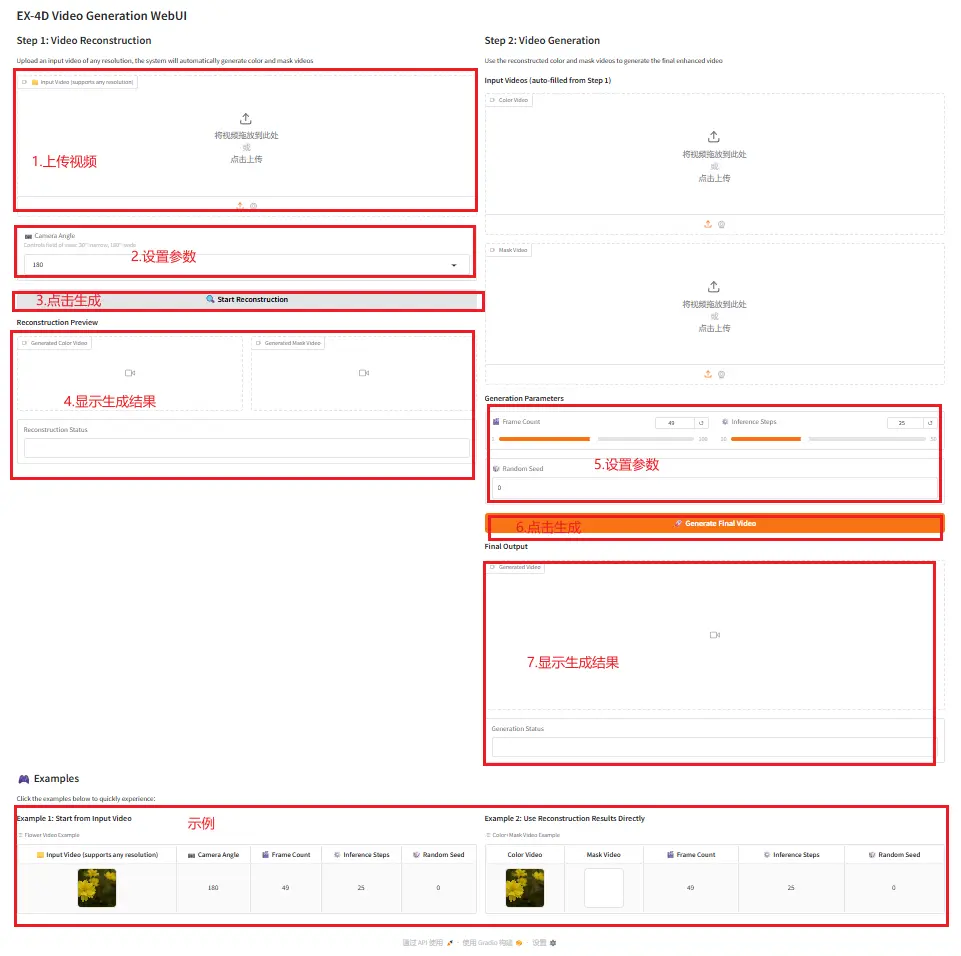

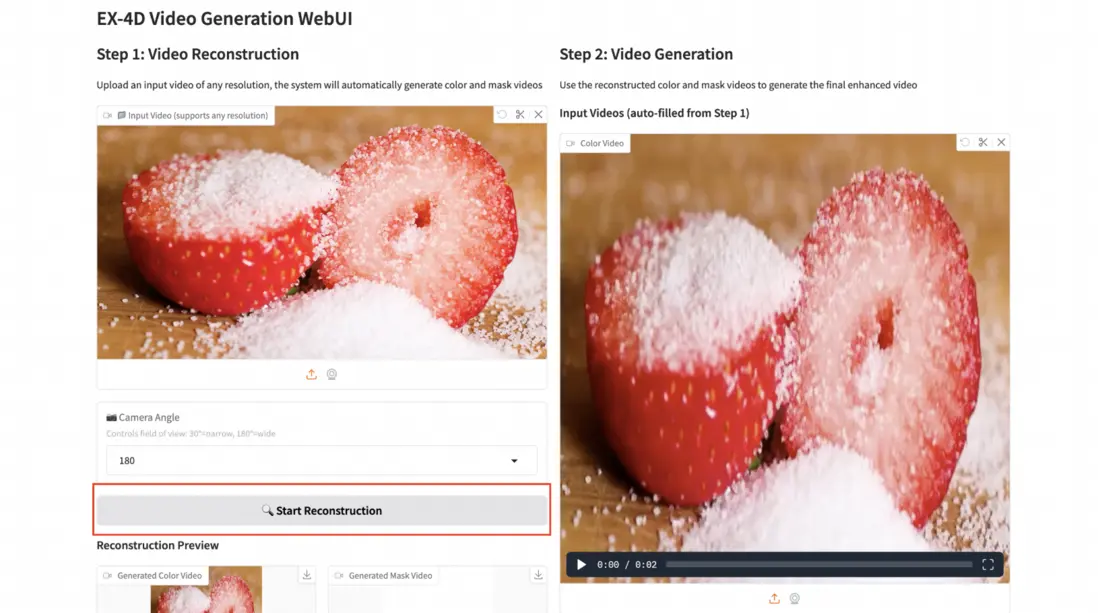

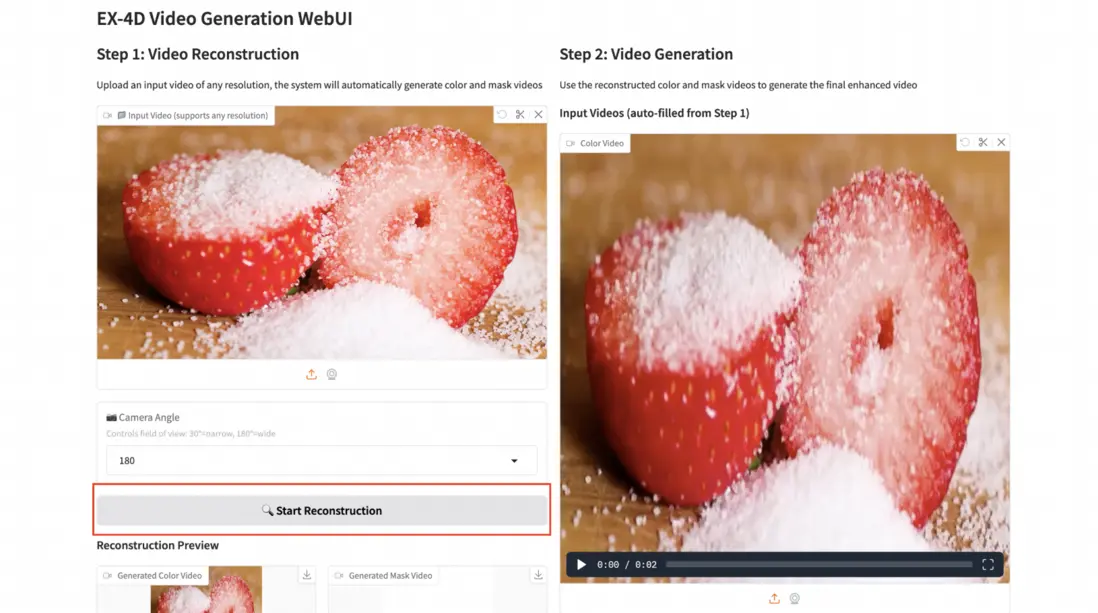

這裏上傳一個草莓的單目視頻,經過 EX-4D 的 4D 重建,可以看到生成效果。⬇️

(由於平台限制,視頻大家可以到「知乎-技術小白獅」同名文章內查看~)

教程鏈接:https://go.openbayes.com/FtNcm

使用雲平台: OpenBayes

http://openbayes.com/console/signup?r=sony_0m6v

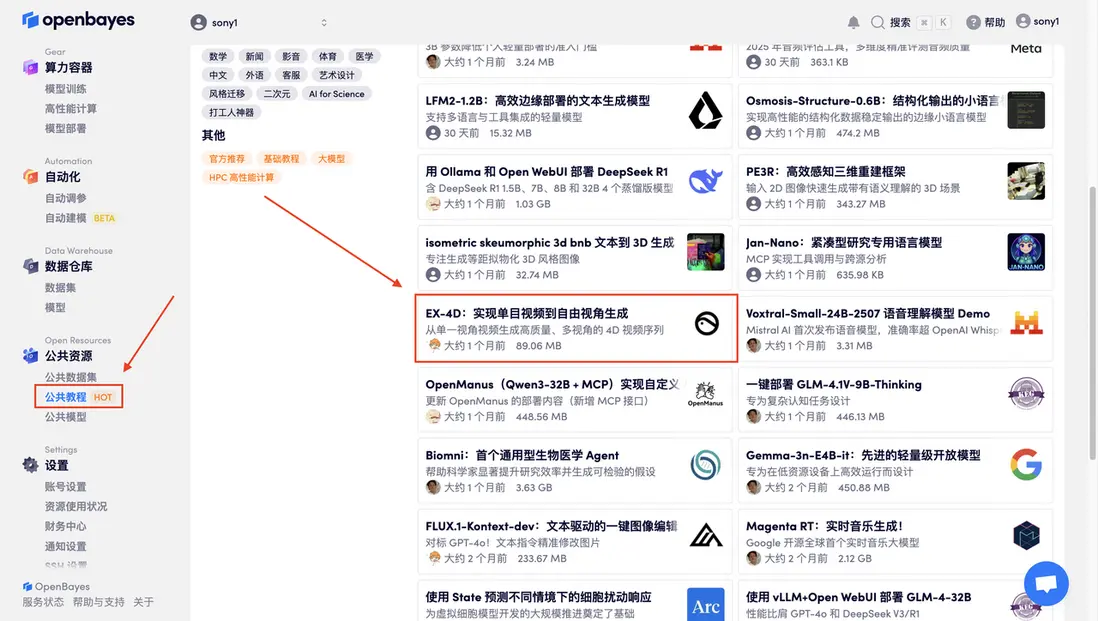

首先點擊「公共教程」,在公共教程中找到「EX-4D:實現單目視頻到自由視角生成」,單擊打開。

頁面跳轉後,點擊右上角的「克隆」,將該教程克隆至自己的容器中。

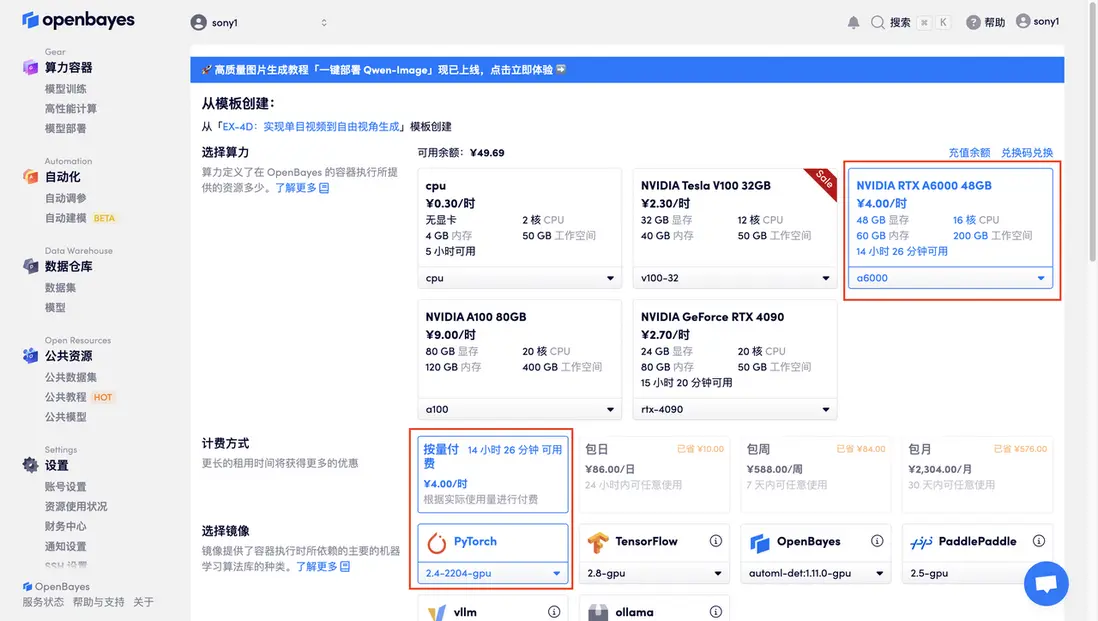

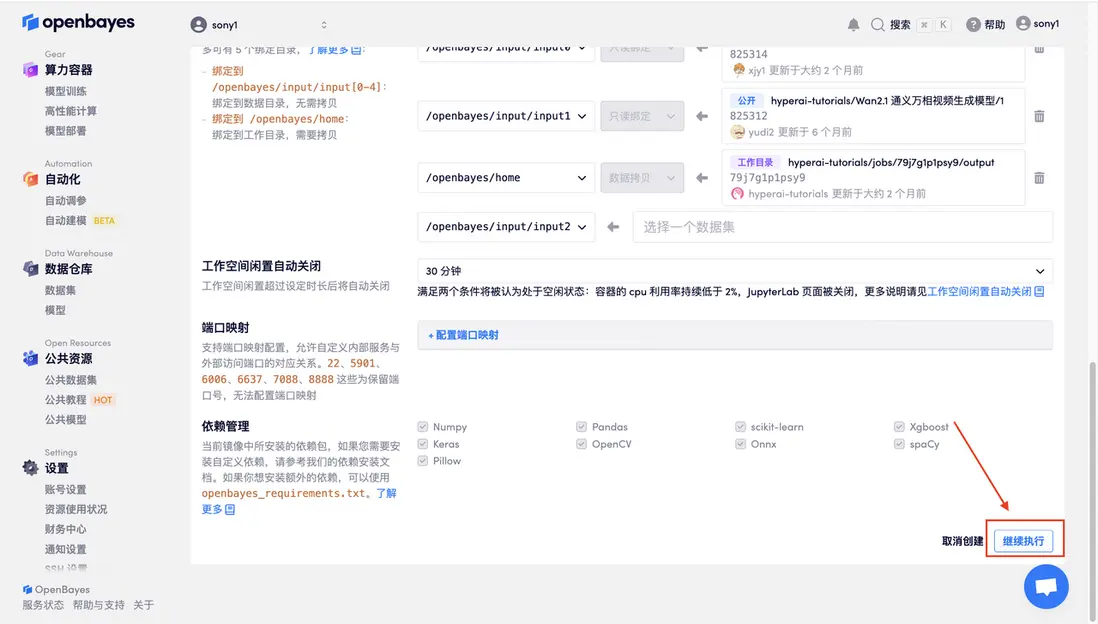

在當前頁面中看到的算力資源均可以在平台一鍵選擇使用。平台會默認選配好原教程所使用的算力資源、鏡像版本,不需要再進行手動選擇。點擊「繼續執行」,等待分配資源。

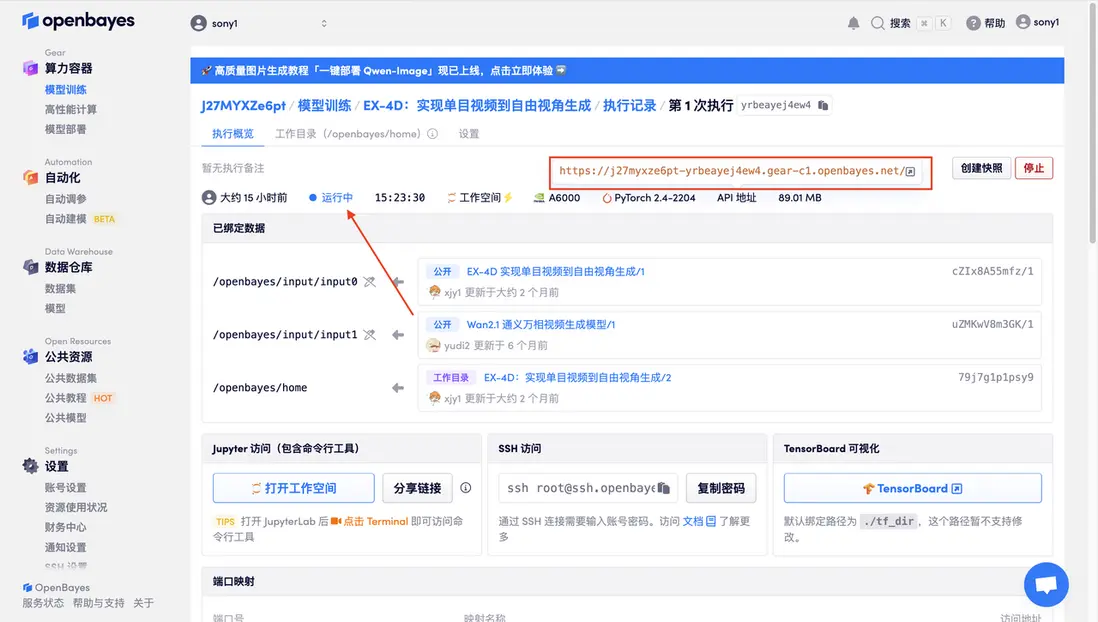

數據和代碼都已經同步完成了。容器狀態顯示為「運行中」後,點擊「 API 地址」,即可進入模型界面。

若顯示「Bad Gateway 」,這表示模型正在初始化,由於模型較大,請等待約 2-3 分鐘後刷新頁面。

參數説明

- Camera Angle:相機角度,30°-180°,角度越大視野越廣。

- Frame Count:視頻幀數。

- Inference Steps:推理步驟。

- Random Seed:隨機種子。

上傳一個草莓視頻,點擊「Start Reconstruction」,開始進行視頻重建。

重建完成後點擊「Generate Final Video」,生成最終的 4D 視頻。

(由於平台限制,視頻大家可以到「知乎-技術小白獅」同名文章內查看~)