在2025年雲棲大會上,阿里雲DLF產品負責人李魯兵正式發佈了DLF(Data Lake Formation)3.0,升級為面向AI時代的智能全模態湖倉管理平台。此次發佈標誌着DLF從傳統的湖倉管理工具,全面進化為支持結構化、半結構化與非結構化數據統一管理、安全開放、性能卓越的新一代數據基礎設施。本文將系統梳理DLF 3.0的架構演進、核心能力、典型應用場景以及其在實際業務中的落地價值。

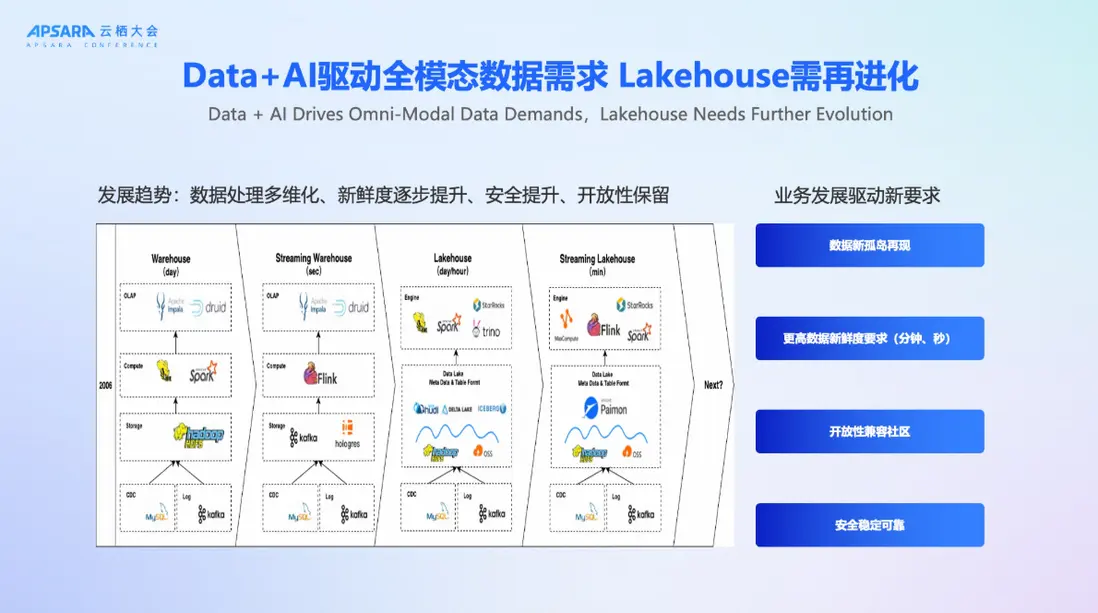

一、Data+AI需求驅動Lakehouse再進化

隨着AI時代的到來,數據形態正經歷前所未有的變革。傳統以表結構為主的數據倉庫已難以滿足日益複雜的業務需求。如今,企業不僅需要處理結構化交易數據,還需高效管理圖像、音頻、視頻、PDF等全模態非結構化數據。同時,業務對數據新鮮度的要求也從“天級”、“小時級”快速演進至“分鐘級”甚至“秒級”。

在這樣的背景下,Lakehouse架構應運而生,並持續演進。阿里雲觀察到四大核心趨勢正在驅動Lakehouse的下一輪升級:

- 數據處理多維化:從單一表格數據擴展到多模態、多源異構數據的統一管理;

- 數據新鮮度提升:實時性要求從分鐘級向秒級演進;

- 開放性必須保留:平台需兼容開源生態,避免廠商鎖定(Vendor Lock-in);

- 安全與穩定性要求提高:企業級用户對權限控制、審計合規、系統可靠性提出更高標準;

正是這些需求,推動DLF邁向3.0,構建一個真正“安全、開放、全模態”的新一代全模態湖倉管理平台。

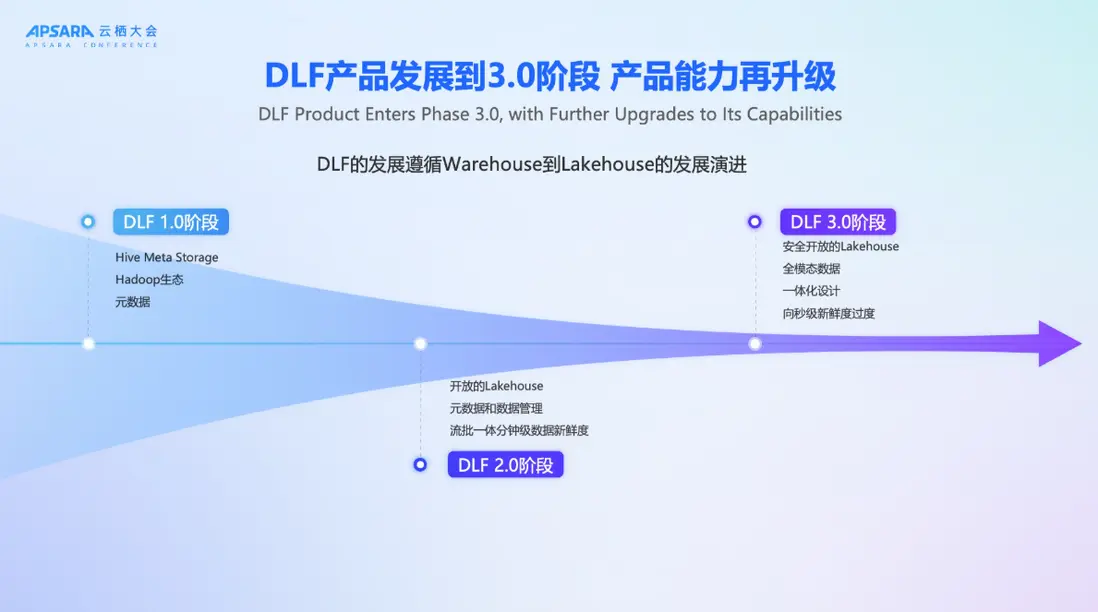

二、DLF產品演進:從元數據管理到全模態湖倉管理平台

DLF的發展歷程緊密跟隨大數據架構的演進路徑。其1.0版本誕生於Hadoop生態時代,核心目標是替代Hive Metastore(HMS),為用户提供統一的元數據管理服務,幫助企業在複雜的Hadoop組件中實現計算與存儲引擎的協同。

隨着Lakehouse架構逐步取代傳統Hadoop體系,DLF在2.0階段完成了關鍵轉型:從元數據管理工具升級為面向Lakehouse的開放元數據與數據管理平台。該階段支持Paimon、Iceberg等主流湖格式,實現流批一體、分鐘級數據新鮮度,並幫助用户平滑遷移至Lakehouse架構。

然而,隨着用户規模擴大和AI場景爆發,2.0架構暴露出若干挑戰:存儲管理分散導致誤操作風險、安全控制粒度不足、非結構化數據無法納入統一治理等。為此,DLF 3.0應運而生。

DLF 3.0的核心定位是:一個安全、開放、支持全模態數據的一體化Lakehouse管理平台。它不僅延續了對結構化表數據的支持,更將文件(Files)、向量、多媒體等非結構化數據納入統一目錄與生命週期管理體系,真正實現“一張湖”管理所有數據。

三、DLF 3.0核心能力發佈:六大企業級服務全面升級

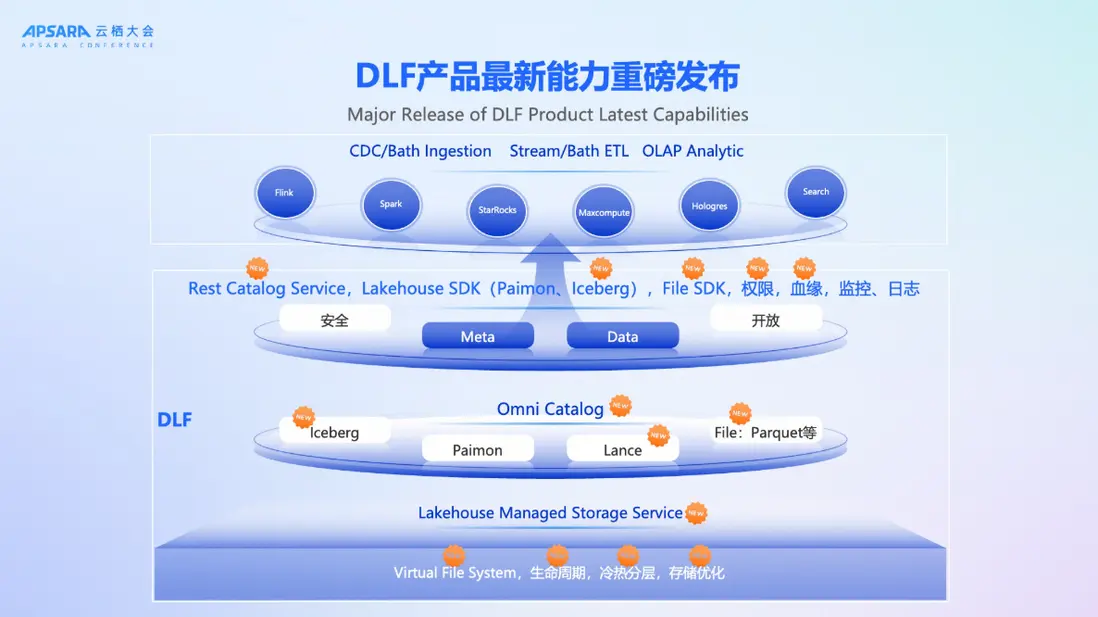

DLF3.0階段保持開放的同時是一個安全的面向全模態數據管理的平台,同時我們基於一體化設計能夠保證更好的安全、更好的開放性。

最上層是多引擎協同,通過用户的場景,選擇不同的引擎。就像我們搭樂高積木,剛開始業務的需求是批計算場景,隨着業務迭代需要升級到實時計算,採用DLF可以靈活無縫地從批計算升級實時計算。這套平台不僅可以做大規模的實時更新,也可以基於後期changeLog數據訂閲做流式的加工,所有這些能力在這個平台上都可以以插件化式來進行集成和完成,平滑地滿足用户和業務方要求的升級。同時DLF也對接了對應的OLAP引擎,可以通過OLAP分析引擎來快速查詢DLF裏面的數據,使用外表的查詢也能夠接近原來OLAP內表的性能。因此,流、批、OLAP分析可以同時構建在基於DLF這套產品架構上,這也是我們OpenLake解決方案的核心理念。

在DLF產品本身這層,有幾個重磅升級

第一個升級就是DLF提供了managed storage service,因為我們洞察到用户在數據管理上遇到了非常大的挑戰,所以我們做了全託管的manage方案,不管是數據的生命週期,還是冷熱分層,還是存儲優化,都能夠做更好的支持。

第二個升級對於catalog service的管理,DLF升級到Omni Catalog,我們面向全模態可以提供Iceberg、paimon、lance、object table及file相關的管理,對用户來説有一個非常重要的變化在於原來的Lakehouse架構可能只能管Table,DLF架構下不僅僅可以管理Table數據,還可以管理全模態的數據,意味着tables和files都可以統一管理。paimon是實時湖倉最領先的一套方案,同時我們也兼顧了用户存量的系統架構需求,也可以支持Iceberg這樣的湖倉架構,對於用户來説可以做到更靈活和多樣的選擇。

在這套架構基礎上,DLF可以提供更好地面向Catalog,比如説可以基於Rest做更好的Catalog service,同時有權限、血緣以及監控和日誌來幫助用户更好地搭建這樣一套Lakehouse架構,幫助大家更好地升級到Lakehouse架構來面對Data+AI時代所帶來的數據挑戰。

通過一系列重磅升級,DLF產品以統一開放catalog為基礎,整體功能覆蓋從數據入湖、湖表管與優化、湖表存儲服務、企業級安全等豐富功能,讓用户離線數據、實時數據、存量系統遷移平滑入湖,同時實現更高效的湖表存、管、優化,真正實現安全開放可靠的湖倉平台。

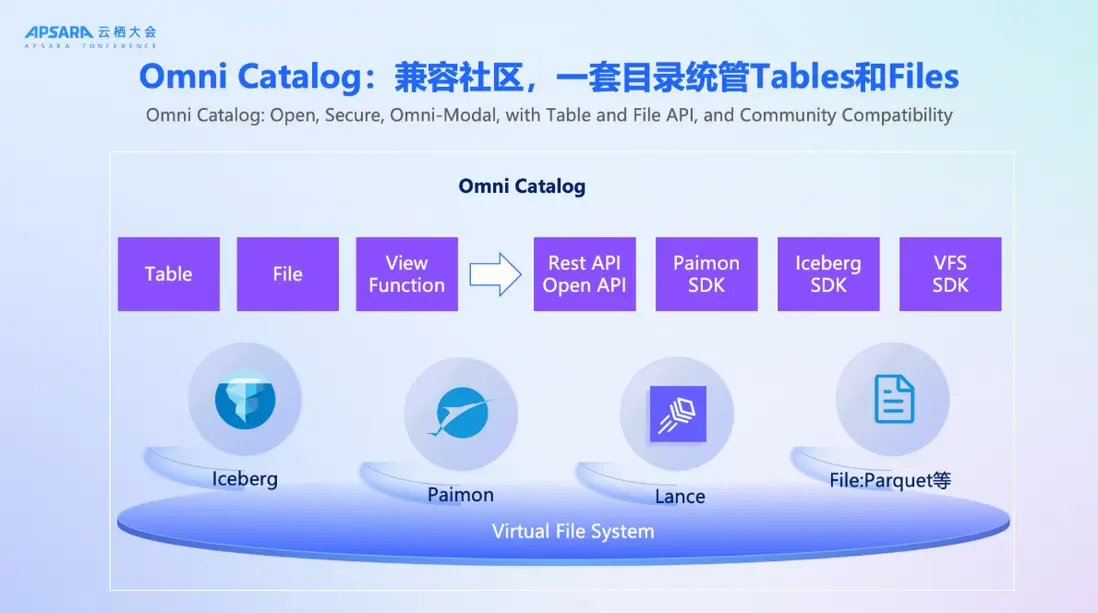

1、Omni Catalog:一套目錄統管Tables與Files

DLF 3.0發佈Omni Catalog,這是其全模態能力的基石。Omni Catalog不僅支持Paimon、Iceberg、Lance等主流湖表格式,還首次引入對文件(如Parquet、視頻、音頻、PDF)的原生管理能力。

通過Table API與File API雙接口,平台同時滿足BI(Business Intelligence)與AI(Artificial Intelligence)兩類工作負載,數據分析師可通過SQL查詢結構化表,AI工程師可直接通過文件路徑讀取原始數據進行模型訓練。更重要的是,DLF承諾完全兼容開源社區接口。用户可使用Paimon SDK、Iceberg SDK、Lance SDK等社區標準工具無縫接入DLF,徹底避免廠商鎖定。同時,平台提供Rest API與Open API,便於管控台集成與自動化運維。

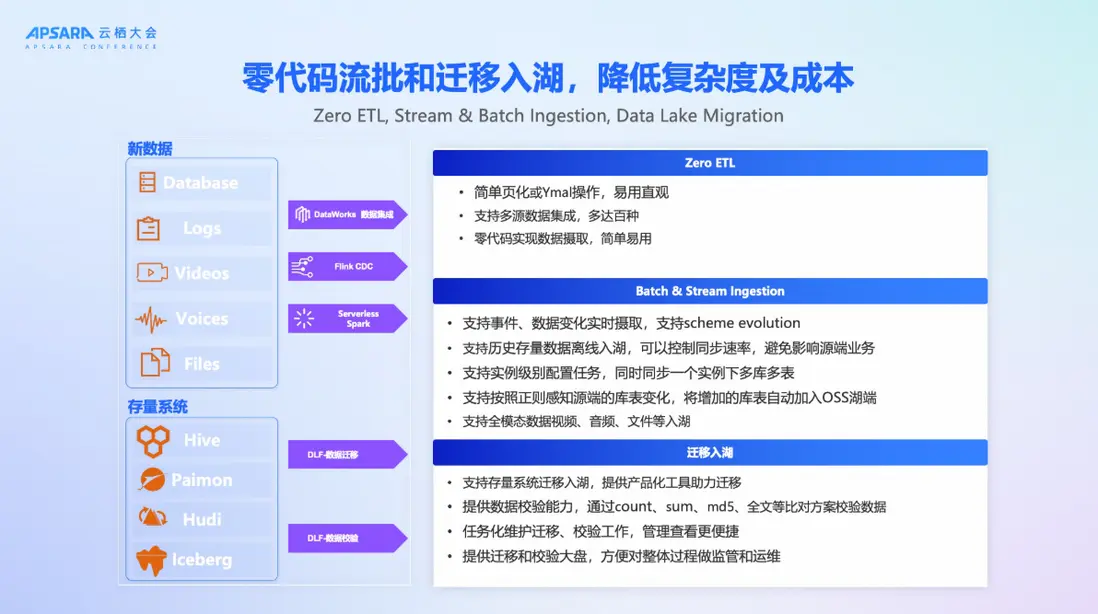

2、數據入湖:零代碼流批攝取與存量遷移

為降低數據入湖門檻,DLF 3.0推出零代碼數據攝取方案:

實時入湖:通過Flink CDC實現數據庫Binlog的全實時捕獲,支持Schema Evolution等; 離線入湖:藉助Serverless Spark,按調度或事件驅動批量寫入; 全模態入湖:支持視頻、音頻、文檔等非結構化數據通過Dataworks數據集成、Spark、Flink等實時離線一體化數據寫入或直接上傳入湖; 存量遷移:提供產品化遷移工具,支持Hive、Hudi、Iceberg等舊系統遷移,並內置數據校驗(Count/Sum/MD5/全文比對)確保一致性。 這套方案可以降低用户在數據攝取過程中的複雜度,幫助用户更低成本地將數據入湖,更低成本地將存量系統升級到Lakehouse架構。

3、湖表管理與優化:智能Compaction與自適應分桶

DLF 3.0內置智能優化引擎,自動處理湖表維護中的複雜問題,這些能力大幅降低用户運維負擔,讓Lakehouse真正“開箱即用”。

- 自適應分桶:用户僅需指定分桶Key,平台根據數據量自動調整分桶數量與併發,實現讀寫性能最優;

- 智能Compaction:自動合併小文件,減少元數據壓力,提升查詢效率;

- 快照管理:基於策略自動清理過期快照與孤兒文件,釋放存儲空間;

4、湖表存儲服務:智能冷熱分層降低成本

DLF 3.0推出Managed Storage Service,實現存儲成本與性能的平衡。DLF基於智能的冷熱分層來解決數據合理規劃的問題,可以基於讀取時間、更新時間的關鍵事件來決定分區該用什麼樣的存儲介質來承載,同時也可以基於數據的讀寫行為來對數據做更合理的加速和預熱,幫助用户在合理規劃存儲介質的過程中能夠保持數據讀寫和管理的效率。

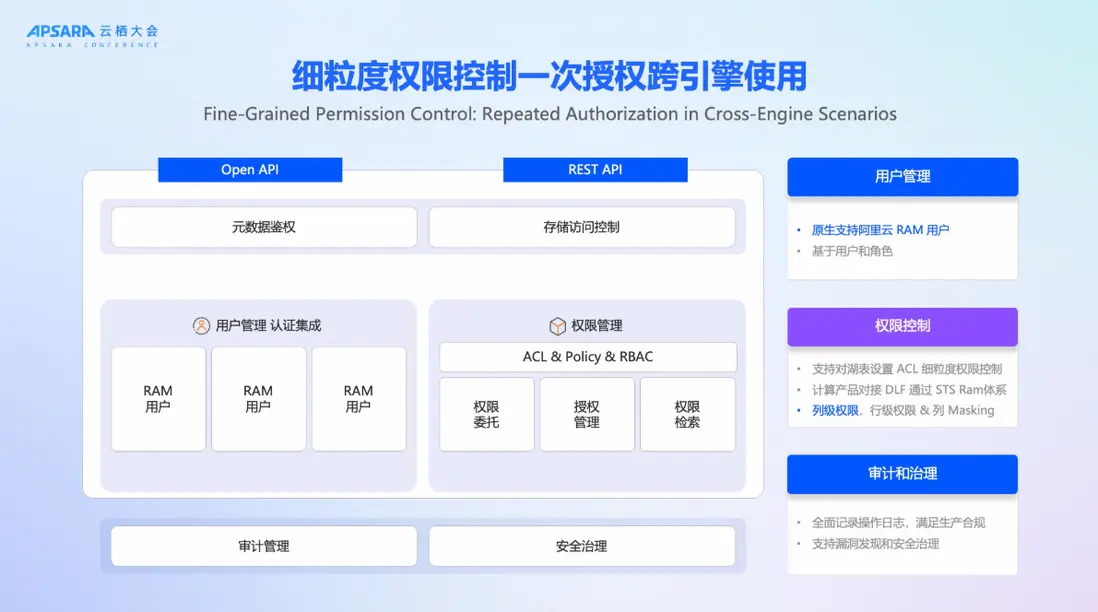

5、企業級安全:細粒度權限與跨引擎授權

原來自己搭建的Lakehouse平台下,數據權限管理是非常鬆散,甚至用AKSK這樣一套方案是非常有挑戰的,DLF提供細粒度的權限管理,可以做到粒級別的數據權限管理,基於table、DataBase、Catalog這些層面都可以做到更好的數據權限管理。基於這套數據權限管理也做了數據的共享,因為有跨團隊的協同,所以提供了數據共享的能力來幫助大家更好地做數據協同。

6、性能與成本效率:全面躍升

DLF 3.0在性能與成本上實現跨越式提升,元數據訪問性能提升10倍以上,存儲成本降低30%,查詢性能提升50%。我們希望Lakehouse不再是“昂貴玩具”,而是高性價比,具備普適性的數據基礎設施。

四、典型應用場景

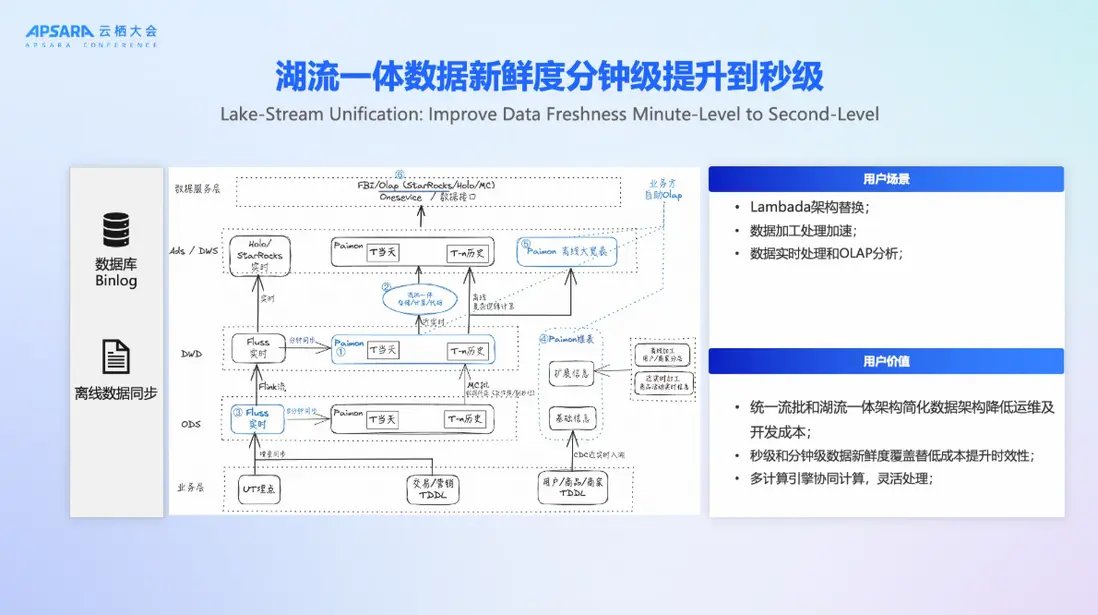

場景一:湖流一體-數據新鮮度從分鐘級邁向秒級

基於去年發佈的Streaming Lakehouse,DLF 3.0進一步引入Fluss實時存儲引擎,構建“湖流一體”架構:

- 實時數據通過Flink寫入Fluss,實現秒級延遲;

- 根據策略,數據可定時歸檔至Paimon表,供準實時、離線分析使用;

- 維表通過Paimon的Partial Update能力實現高效更新;

該方案成功替代Lambda架構,統一了湖流處理鏈路,降低開發與運維成本,同時滿足秒級與分鐘級的分析需求。

場景二:離線數倉升級Lakehouse架構

針對大量仍在使用Hadoop生態的企業,DLF提供無感遷移路徑,整體平台性能提升20%以上。

- 通過遷移工具將Hive表遷移至DLF管理的Paimon湖表;

- 保留原有SQL接口,業務代碼幾乎無需修改;

- 遷移後可逐步引入實時能力,實現架構漸進式演進;

我們一位DLF的用户在完成遷移後激動地表示:“這是歷史性時刻,我們終於告別了古早的Hadoop集羣!”

場景三:全模態數據管理與檢索

DLF 3.0最引人注目的創新在於全模態數據支持。隨着AI時代的到來,大家聽到更多的是非結構化數據該怎麼管,非常多的視頻、圖片數據該如何管理,該如何圈選我的DataSet。通過DLF平台可以將非結構化數據,包括視頻、音頻、PDF進行管理,同時原來這套結構化數據也可以進一步接入。通過實時採集或者離線採集或者數據上傳的方式接入到DLF平台,同時通過Lance這樣一套底層能力來構建全模態數據的存儲、管理以及後續承載embedding數據接入的能力。

基於這樣的能力,對於用户來説就可以做到更好的全模態檢索,包括圖搜圖、文搜圖,可以更好地檢索召回我們的數據。在全模態能力下DLF可以支持多主體的識別,通過多主體的識別,能夠幫助後續流程做更好的基於對應主體做embedding,實現更精準的search場景。

五、實戰案例:助力淘寶閃購業務準時上線,實現全鏈路實時運營

在2025年秋季,阿里雲DLF 3.0成功支撐了阿里巴巴集團閃購業務的準時上線。該業務對數據實時性要求極高,需在秒級內完成用户行為分析、庫存預警與營銷決策。因為在去年阿里巴巴集團就做了Alake項目,基於Lakehouse架構構建了整個平台,所以基於DLF可以讓流批做更好地融合。面向用户場景會有BI場景、AI場景,這套架構可以很好地兼容兩種場景的使用,靈活選擇多種引擎應對業務方的需求。

DLF 3.0的發佈,不僅是產品能力的升級,更是阿里雲對Data+AI時代數據基礎設施的深刻思考。全模態數據將成為未來企業核心資產,而Lakehouse必須進化為能承載這一資產的“智能湖”。基於阿里雲OpenLake解決方案的理念,DLF 3.0不再只是一個數據湖管理工具,而是一個融合結構化與非結構化數據、打通BI與AI、兼顧性能與成本、開放且安全的新一代全模態湖倉管理平台。在AI浪潮席捲全球的今天,DLF 3.0為企業提供強有力的基礎設施支撐,用數據驅動智能未來。

當前DLF3.0已經在阿里雲上開放使用,如果期望瞭解更多詳細內容,可以在阿里雲官網搜索DLF。