摘要

6 月底,GMI Cloud 技術 VP YujingQian 受邀參與了由 InfoQ 舉辦的 AICon 北京大會,在大會上Yujing發表了主題為《GMI Cloud Inference Engine 全球化高性能分佈式推理服務構建實踐》的演講,本文是他的演講總結。

越來越多的企業將自己的 AI 應用拓展到海外市場時,在推理服務方面遭遇諸多挑戰。例如用户跨地域分佈,單個集羣難以平衡低時延與高覆蓋,可能導致部分區域用户推理響應延遲過高;推理業務負載增加後,現有集羣會因為資源彈性不足出現算力瓶頸,影響服務穩定性等。

解決這些問題需要從全球化資源調度、彈性算力管理等多個維度入手,結合對不同地區網絡環境、用户需求的深度理解,構建靈活且高效的分佈式推理架構。而在這一領域,那些深耕全球化雲服務,且在 AI 推理場景有過大量實踐的企業,往往積累了更豐富的經驗。

所以,為了得到這些問題的答案,InfoQ 特別邀請到在全球化高性能分佈式推理服務構建方面有深度實踐經驗的 GMI Cloud,參加 InfoQ 極客傳媒舉辦的 AICon 全球人工智能與開發大會·北京站。GMI Cloud VP of Engineering Yujing Qian在本次會議上發表了主題為《GMI Cloud Inference Engine 全球化高性能分佈式推理服務構建實踐》的演講。

演講主要圍繞 AI 出海企業在 AI 推理方面的技術挑戰與行業趨勢展開,例如推理服務的及時性、擴展性、穩定性成為核心挑戰;隨着企業的多節點推理需求爆發,P/D 分離、EP 兩大技術成主流。Yujing Qian 也深入解析了集羣級別的自動擴容技術架構的設計邏輯與核心要素,包括負載均衡、擴容策略、冷啓動加速等。他還介紹了摒棄派工程師現場調研這種傳統方案的原因,並提供了推理引擎優化器的技術原理、應用場景與 Benchmark 工具,該工具可根據實際需求動態地對推理引擎進行管理和調控,同時還能支持基準測試、結果存儲等。

InfoQ 對其演講內容進行了整理,以期幫助從業者清晰認知 AI 出海企業在推理服務上的各種情況,為出海企業核心決策者提供基礎設施構建的新視角與技術路徑參考。

以下是演講實錄:

Part 1

全球AI應用推理的趨勢與挑戰

在 AI 應用全球化服務的趨勢下,推理服務的及時性、擴展性、穩定性成為核心挑戰。

以主打全球化服務的客户為例,其用户分佈在美西、美東、東南亞等全球各地,僅靠單一點位的算力集羣,無法為跨區域用户提供低延時服務。

面對AI應用的突然火爆,用户訪問在短時間內暴增,現有的集羣就會難以承受。目前 GMI Cloud 接觸的多個語言模型、視頻模型的客户,都曾遇到過類似問題——大模型突然走紅,但用户等待時間變長,這該如何解決?

除此之外,常被忽視的挑戰還有服務穩定性,這是用户留存的關鍵。GPU 集羣的穩定性制約着應用擴張,雖然海外 GPU 資源豐富,但能穩定提供服務的卻不多。然而,在當前情況下,很多企業可能難以獲取最新的高端 GPU 資源以用於測試和部署工作,同時還會面臨合規性問題。

在“挑戰”之外,AI推理還呈現出兩個趨勢。第一個是 AI 應用的流量高峯常常不期而至,推理服務及時彈性擴容變得至關重要。就像 Manus 上線七天,使用申請等候名單增加到 200 萬人,邀請碼一度“一碼難求”;北美知名的視頻生成網站 Higgsfield,發佈當天有幾十萬人在排隊,若此時告知用户,生成視頻需等待數小時,那留存率就難以保證了。

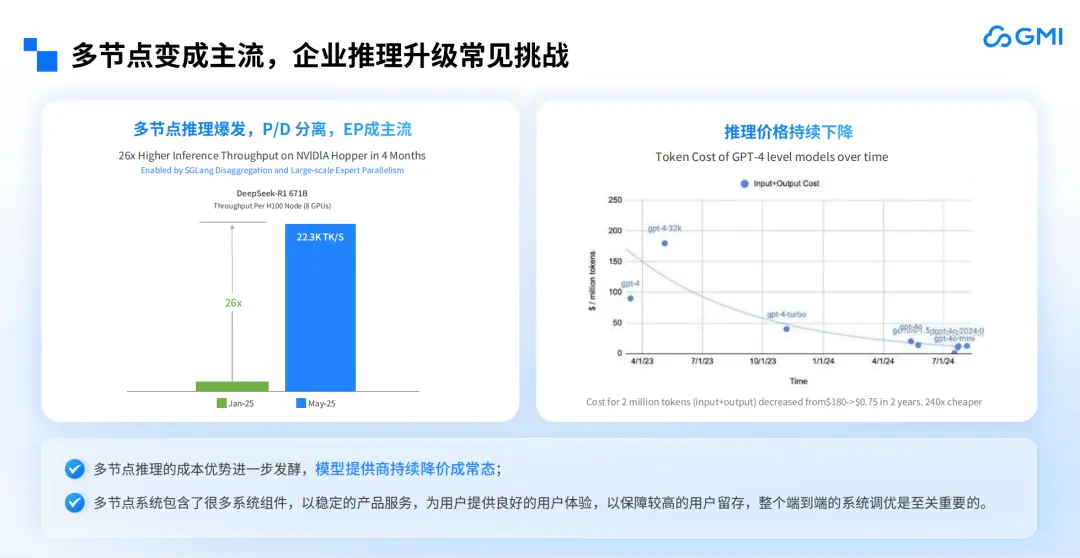

第二個是企業的多節點推理需求爆發,P/D 分離、EP 兩大技術成主流。以 DeepSeek-R1 671B 為例,每個 H100 節點(8個GPU)的吞吐量從 1 月到 5 月增長了 20 多倍。這種爆發式增長反映了大模型推理對算力規模的剛性需求,而單卡或單節點推理在面對高併發流量、複雜模型運算時,已難以滿足實時性與效率要求。

從技術邏輯看,多節點場景下的推理效率提升離不開技術與架構的創新:P/D 分離技術通過將參數存儲與計算邏輯解耦,有效解決了多節點間數據同步的性能瓶頸;而 EP 架構則通過將模型參數分配至不同節點,實現了算力資源的精細化調度。兩者結合使大模型在多節點部署時能充分釋放硬件潛力。

另外,隨着多節點推理的成本優勢進一步發酵,模型提供商的價格也在不斷下降。此時,企業若有部署模型的需求,就不需要花費大量資金做單節點部署了。

對於有自研模型且有出海需求的企業而言,必然有推理升級的需求。GMI Cloud 希望能助力企業完成 AI 應用的推理升級,無論是託管還是部署需求,都能滿足。

Part 2

GMI Cloud 的推理服務架構解析

GMI Cloud 的全棧技術架構主要分為兩層,底層是 IaaS 層,提供 GMI 雲集羣引擎(Cluster Engine),包含三個部分:首先是計算,核心載體就是 GPU;其次是存儲,無論是做大模型還是生成類模型,存儲都必不可少,可用於存放 KV Cache、日誌等;最後是網絡,無論是訓練還是構建多機推理系統,若網絡不通,即便部署眾多節點也無濟於事。因此,GMI Cloud 會為客户搭建好這三層,並提供統一的網絡接口。

上層是 MaaS 層,提供 GMI 雲推理引擎平台(Inference Engine),具備三大功能:一是高效的部署工作流,客户無需自行搭建整套推理框架,也無需思考更新問題,直接使用 GMI Cloud 的部署工作流即可輕鬆完成,且負責後續的維護與升級;二是支持模型推理的優化,無論是語言模型還是視頻模型,GMI Cloud 都能實現較優的性能表現;三是支持主動監控與服務容錯,在整個技術棧中,GMI Cloud 支持全棧(即端到端)的監控埋點,無論是 IaaS 層還是推理層,都能提供實時監控服務,並保障服務水平協議(SLA)。

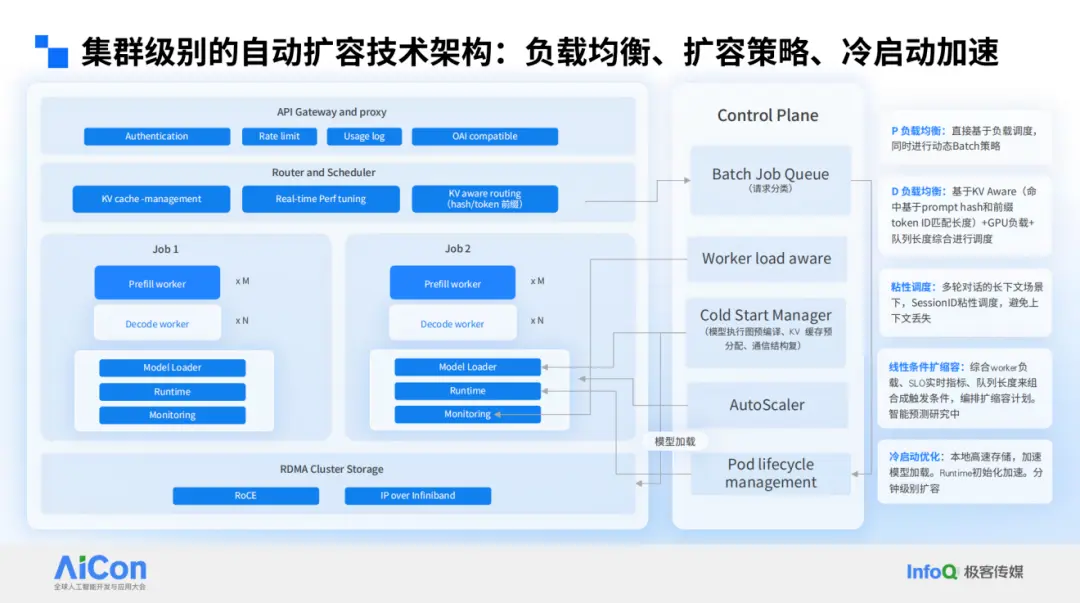

下圖是一個集羣級別的自動擴容技術架構,自上而下,GMI Cloud 都遵循行業通用的最佳實踐。最上層是 API Gateway 層,幫助客户處理請求驗證、限流及使用記錄;中間是負載均衡層和調度層,針對預填充(prefill)和解碼(decode)階段分別實現負載均衡,並支持 KV Aware 路由策略(命中基於 prompt hash 和前綴 token ID 匹配長度進行命中)。

再往下是客户各自的 Worker Load(工作負載)層,以 P/D 分離架構為例,當前多數客户在 GMI Cloud 上託管的是非專家模型(如傳統 32B 模型),儘管專家模型是行業熱點,但非專家模型仍佔主流。

最底層是存儲層,支持 KV Aware 遷移與模型存儲優化,實現快速冷啓動能力 。 以 DeepSeek 這樣規模的模型為例,可在分鐘級完成集羣拉起。這一優勢在單集羣場景下相對容易,而多集羣間的高效同步機制在行業內較為少見,GMI Cloud 通過存儲層優化,大幅縮短了多集羣環境下的模型啓動與同步耗時。

從架構設計來看,GMI Cloud 具備異構算力整合能力,將企業自有算力資源(包括自建集羣與公有云集羣)納入統一管理體系,通過全球調度服務實現算力資源的協同調度。具體而言,客户可優先利用自有集羣完成推理任務,當自有集羣資源利用率達到閾值時,系統將自動觸發資源擴容機制,無縫調用 GMI Cloud 的算力池持續支撐業務運行。

GMI Cloud 的算力是基於 Karmada 的混合雲彈性部署(如下圖所示),通過 Karmada 控制平面管理各集羣的擴縮容能力,無論集羣位於何處,只要接入 GMI Cloud 控制層即可實現彈性擴縮容。這在應對突發流量時非常有用,尤其是對延遲要求不高或能預測流量的模型,GMI Cloud 能在幾分鐘內調配資源以應對峯值流量,且客户無需提前預訂大量資源來保障 SLA。

計算與存儲密不可分,實現彈性擴縮容的前提是存儲能隨計算節點同步調整。因此,GMI Cloud 不僅實現了計算節點的擴縮容,還在底層實現了存儲的擴縮容。這一解決方案是 GMI Cloud 與 JuiceFS 合作完成,目前將存儲池劃分為北美、亞太和歐洲三個區域,其中亞太和歐洲區域是北美區域的鏡像。這樣,無論客户數據產生於何處,都能根據配置及時將數據拷貝至其他區域集羣。

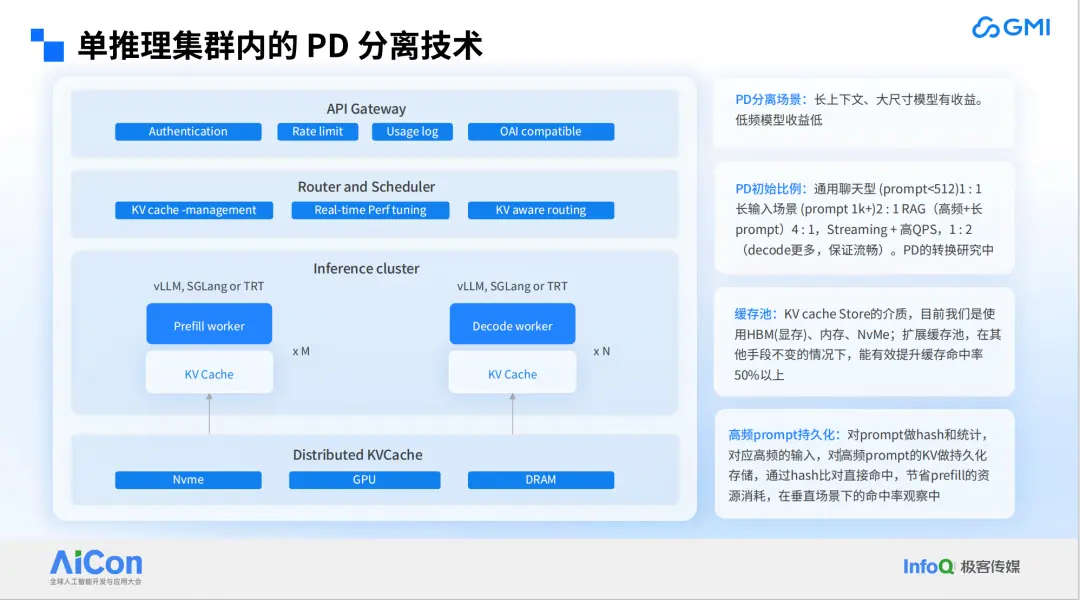

除了存儲方面的優化,對於單推理集羣內的 P/D 分離技術,GMI Cloud 也進行了大量優化。其中,較為有用的一點是高頻 prompt 持久化,這在 AI Agent 場景中尤為實用。我們對prompt做hash和統計,對高頻 prompt 的 KV 做持久化存儲,通過 hash 比對直接命中,節省 prefill 的資源消耗。從垂直場景的命中觀察來看,該機制能有效降低新建集羣的計算負載,實現 “以存儲換計算”的優化目標。

如下圖所示,若客户業務遍佈北美大區,美國區客户產生的 KV Cache 可通過我們的持久化存儲與加拿大區客户共享。這樣,在加拿大新開集羣時,就無需從零開始積累 KV Cache。

介紹完具體技術架構後,再介紹一下其他的功能,例如模型部署可視化工作流,實現部署運維一體化。

對於推理平台而言,若客户自行搭建,需要配置的組件眾多。而使用 GMI Cloud 的託管平台,客户可實現一鍵搭建,涵蓋從 Dockerfile 上傳、模型上傳、鏡像安裝,到推理副本設置、地區設置,再到服務管理和監控等整個鏈路。GMI Cloud 都可以提供解決方案,並配合底層 IaaS 層實現主動端到端監控,客户不僅能查看推理服務流量和延遲,還能瞭解運行服務的 GPU 狀態。

Part 3

GMI Cloud 推理引擎 Benchmark:

開發者友好的推理調優器

接下來,我再為大家介紹一下 GMI Cloud 發佈的一款對開發者極為友好的推理調優器。

過去的幾個月裏,企業在模型部署過程中頻繁提出相同的問題。比如,同樣的模型和負載,從 A100 遷移到 H100 需要多少張卡才能保持性能持平,最終是否節省成本?如果將精度從 fp16 降低到 fp8,能節省多少成本?針對我的工作負載或模型,最優的推理引擎及其配置是什麼?

還有些企業客户,可能是剛獲得融資並完成了概念驗證(POC),他們會問:我設計的每個 Agent 需要達到特定的用户吞吐量和首次響應時間(TTFT)目標,需要多少張 GPU 卡,才能實現預期的每秒查詢數(QPS)?

面對這些問題,行業內的傳統方案是派工程師根據用户場景,手動測試數週甚至數月,然後告知客户所需 GPU 卡的數量。但是,這種方法無法保證結果的絕對準確性和高效性。因為推理框架更新迅速,推理參數眾多,在不同參數設置下,吞吐、TTFT、TPOT 有非常大的差別,需要根據模型大小、用户場景輸入和輸出長度來進行性能評測,選擇最優的框架和參數。此外,派人現場調研成本較高。

以 vLLM 或 SGLang 為例,每次推理參數多達十幾、二十甚至三十個,哪些參數有效?哪些參數應優化設置?這都需要大量實驗才能得出經驗,而這些實驗的管理,哪些該做哪些不該做,對 Infra 提供方而言極具挑戰。特別是像我們這樣的雲平台,不可能為每個客户都配備專門的調優工程師,然後告知客户一個配置方案。

為解決這些問題,GMI Cloud 推出了推理引擎調優工具—— Benchmark ,該工具分為兩個版本:第一個是開源社區版,我們與 vLLM 社區合作,主要負責對不同開源大模型推理引擎(如 vLLM、SGLang、Ollama )進行基準測試。該版本已開源,主要覆蓋單節點命令部署,例如如何用一台 H100 或 A100 部署模型並達到預期吞吐。

目前,開源社區版的 Inference Engine 提供了已測出的所有 Benchmark 數據。企業在社區版上得出的結果,均可在 GMI Cloud 平台一鍵部署,確保 1:1 復現。

另一個是 GMI Cloud 雲版本,針對企業級用户,提供生產級推理方式的集羣部署評估。平台對 vLLM 生產棧、SGLang 多節點部署、NVIDIA Dynamo 等技術進行深度優化,確保測試結果與生產環境高度一致。

Benchmark 這一工具可以解決模型推理引擎的 7 個關鍵問題:

首先,實現按需引擎管理的需求,無需提前佔用 GPU,即可啓動、停止、列舉和管理所有經過 GMI Cloud 測試的推理引擎。過去,企業做實驗可能需要先申請 20 個節點,再探索最優節點配比,但這不是最優方法,因為會發現 12 台節點就能達到最高性能,其餘8台機器閒置,或者先約了 4 台機器,後來發現需要8台才能覆蓋所有場景,這給商務和資源管理帶來諸多反覆。現在 GMI Cloud 提供按需引擎管理,無論企業想試 4 台、8台還是12台機器,都無需提前預訂,可直接在GMI Cloud平台上測試,省去了提前預約的麻煩。

其次,提供了豐富的基準測試數據集。當然,也支持企業在Benchmark上上傳自己的數據集,因為大部分客户都有自己獨特的數據集,與開源數據集存在差異。

第三,支持全面的指標採集,Benchmark 會自動收集輸入吞吐量、輸出吞吐量、TPOT、TTFT 以及百萬 token的成本。

第四,支持結果存儲,即 Benchmark 幫助客户統一存儲和管理所有測試集的測試結果。

第五,Benchmark與vLLM社區共同開發了一整套 YAML 配置文件,使基準測試變得更簡單。企業只需要通過 YAML 文件定義好測試顆粒度,系統就能根據行業經驗幫企業自動優化指標評估順序,實現推理成本的優化。

此外,Benchmark 還提供交互式可視化儀表盤,展示客户的測試進度和分析所有歷史基準測試結果;企業還可以將自己的引擎配置上傳到 Arena 排行榜,分享特定情況下的最優配置。

總之,GMI Cloud 的目標是幫助企業以更貼近自身工況的方式,快速找到最優的引擎配比。

Part 4

寫在最後

GMI Cloud 作為一家總部在北美的 AI Native Cloud 公司,技術團隊多為 AI 工程師,一直也在以 AI 工程師的視角搭建更適合開發者使用的產品,專注於為全球 AI應用企業打造敏捷、易用的全棧 AI 基礎設施平台。

目前,GMI Cloud 已經是排名全球 Top10 NCP,也是全球僅有的六家 Reference Platform NVIDIA Cloud 之一,能夠即時獲取 NVIDIA 最新款的高級計算資源及更多產品或技術細節,更具優勢。我們的技術產品持續快速迭代中,希望大家可以持續關注,併到 GMI Cloud 官網體驗。

關於 GMI Cloud

由 Google X 的 AI 專家與硅谷精英共同參與創立的 GMI Cloud 是一家領先的 AI Native Cloud 服務商,是全球六大 Reference Platform NVIDIA Cloud Partner 之一,擁有遍佈全球的數據中心,為企業 AI 應用提供最新、最優的 GPU 雲服務,為全球新創公司、研究機構和大型企業提供穩定安全、高效經濟的 AI 雲服務解決方案。

GMI Cloud 憑藉高穩定性的技術架構、強大的GPU供應鏈以及令人矚目的 GPU 產品陣容(如能夠精準平衡 AI 成本與效率的 H200、具有卓越性能的 B200 以及未來所有全新上線的高性能芯片),確保企業客户在高度數據安全與計算效能的基礎上,高效低本地完成 AI 落地。此外,通過自研“Cluster Engine”、“Inference Engine”兩大平台,完成從算力原子化供給到業務級智算服務的全棧躍遷,全力構建下一代智能算力基座。

作為推動通用人工智能(AGI)未來發展的重要力量,GMI Cloud 持續在 AI 基礎設施領域引領創新。選擇 GMI Cloud,您不僅是選擇了先進的 GPU 雲服務,更是選擇了一個全方位的 AI 基礎設施合作伙伴。

如果您想要了解有關 GMI Cloud 的信息

請關注我們並建立聯繫