01 | 引入

在人工智能快速發展的今天,通用大語言模型雖然具備強大的語言理解和生成能力,但在專業領域服務時往往顯得力不從心。以心理健康支持為例,普通預訓練模型無法理解"共情"深層含義,難以給出符合認知行為療法(CBT)原則的專業建議,導致回答要麼過於機械,要麼缺乏針對性。

僅靠通用模型無法實現"懂情感、會共情"的高質量心理支持,必須通過高質量數據集微調才能實現專業場景的精準適配,將通用語言能力轉化為專業領域知識。而LLaMA Factory作為當前最高效的微調框架之一,為這一過程提供了重要支持。

02 | LLaMA-Factory 微調在論文中的體現

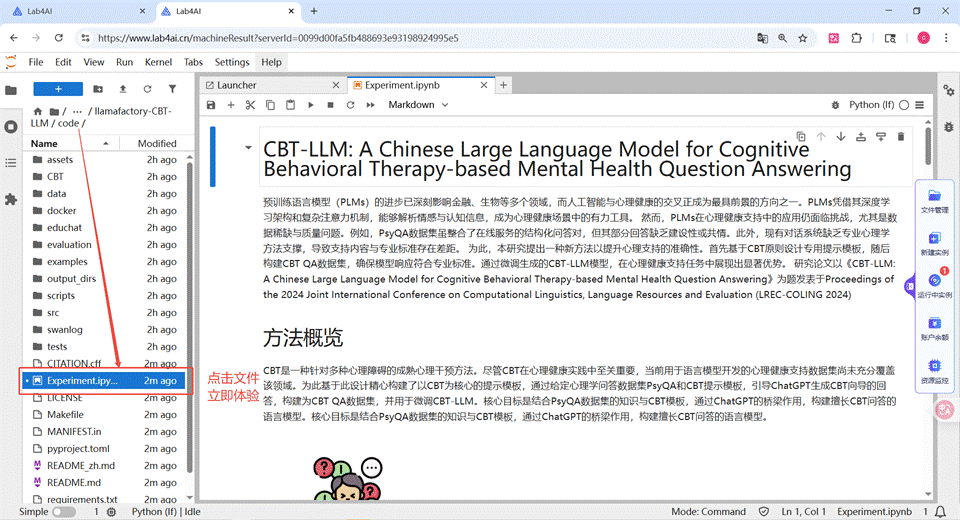

- 論文: CBT-LLM: A Chinese Large Language Model for Cognitive Behavioral Therapy-based Mental Health Question Answering

- 會議: COLING 2024

鏈接: [2403.16008] CBT-LLM: A Chinese Large Language Model for Cognitive Behavioral Therapy-based Mental Health Question Answering - Hugging Face 鏈接: Hongbin37/CBT-LLM · Hugging Face

- Lab4AI 論文一鍵復現:** Lab4AI 項目頁

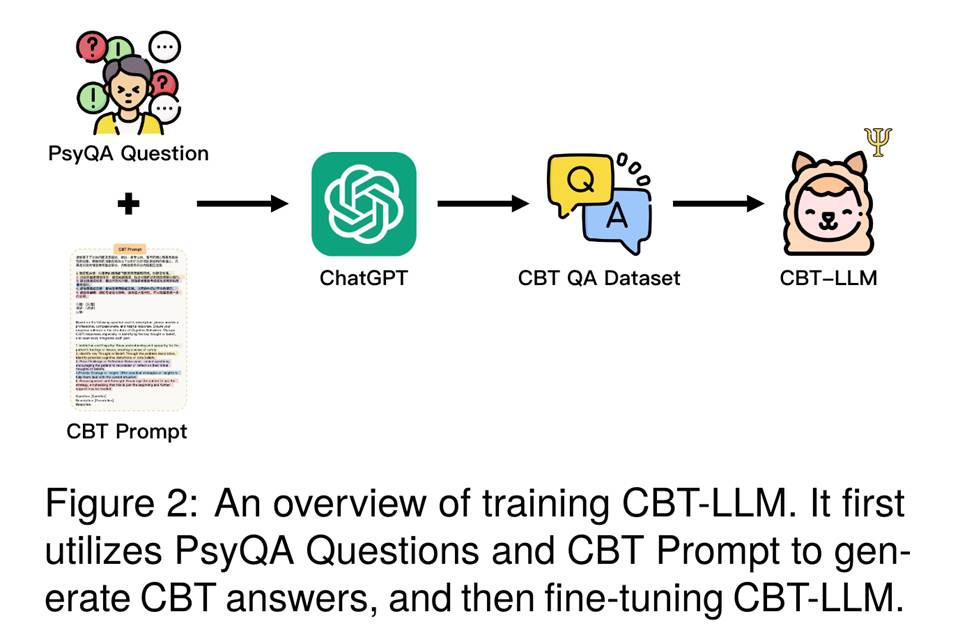

這篇發表於2024年計算機語言學頂會LREC-COLING的論文CBT-LLM: A Chinese Large Language Model for Cognitive Behavioral Therapy-based Mental Health Question Answering,通過心理問答數據集PsyQA和CBT提示模板,引導ChatGPT生成CBT嚮導的回答,構建為CBT QA數據集,並用於微調CBT-LLM。核心目標是結合PsyQA數據集的知識與CBT模板,通過ChatGPT的橋樑作用,構建擅長CBT問答的語言模型。

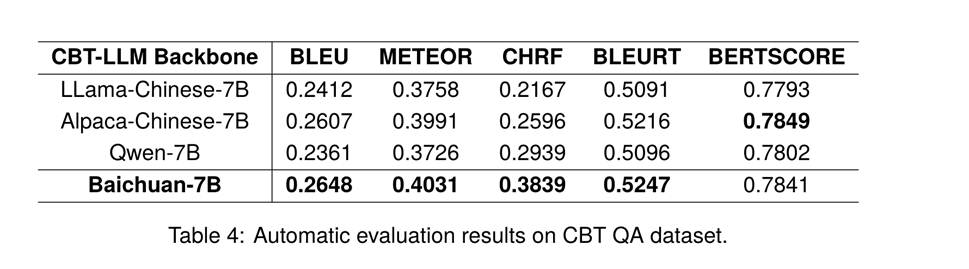

此研究使用了LLaMA-Factory高效模型訓練微調框架,使用了添加系統指令的 CBT QA 數據集,選取了LLaMA-Chinese-7B、Alpaca-Chinese-7B、Qwen-7B、Baichuan-7B 作為基線模型,並使用 BLEU、METEOR、CHRF、BLEURT 評估微調模型的效果。

從數據可見,經 LLaMA-Factory 微調後,各基線模型在心理健康問答任務中均展現出良好性能,其中 Baichuan-7B 在 BLEU、METEOR、CHRF、BLEURT 等指標上表現最優,體現出模型在回答結構完整性上的優勢,證明 LLaMA-Factory 的微調能力可有效提升模型對 CBT 框架的貼合度。

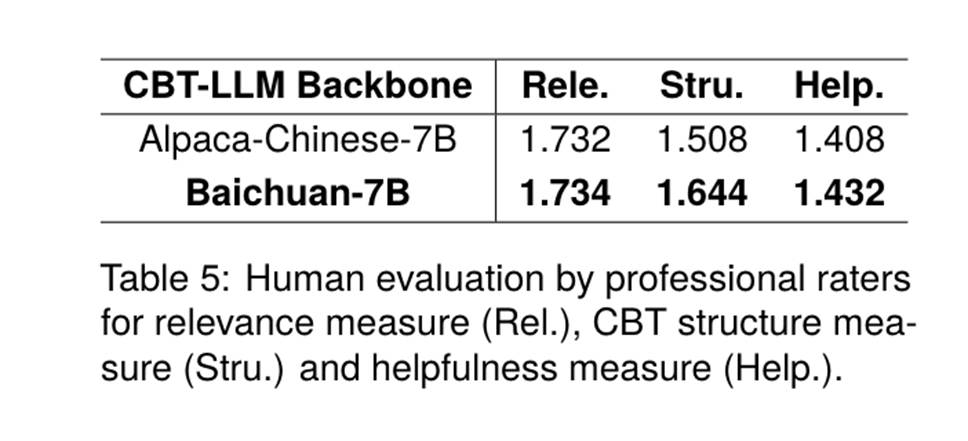

經過專業評估人員評估,模型在相關性、CBT 結構符合度及助益性 上均有突出表現。

總的來説,CBT-LLM能夠完整執行CBT五步框架,揭示了通過提示詞引導模型生成高質量數據集後進行微調以增強模型能力的方法有效性。未來研究團隊將繼續整合ACT/DBT等其他療法,並引入多輪對話系統,從而更好地模擬真實心理諮詢場景,提升模型與患者交互的真實感與深度,滿足多樣化的治療需求。

03 | 一鍵式復現

為加速研究轉化,Lab4ai.cn 提供了基於LLaMA-Factory的CBT-LLM完整可複用方案,無需用户進行複雜的環境配置,即可一鍵式體驗模型復現流程。

Step 1:登錄Lab4AI.cn,在“項目復現”中找到“LLaMA Factory 微調能力在心理健康大模型中的應用”

👉 項目復現:點擊查看項目詳情

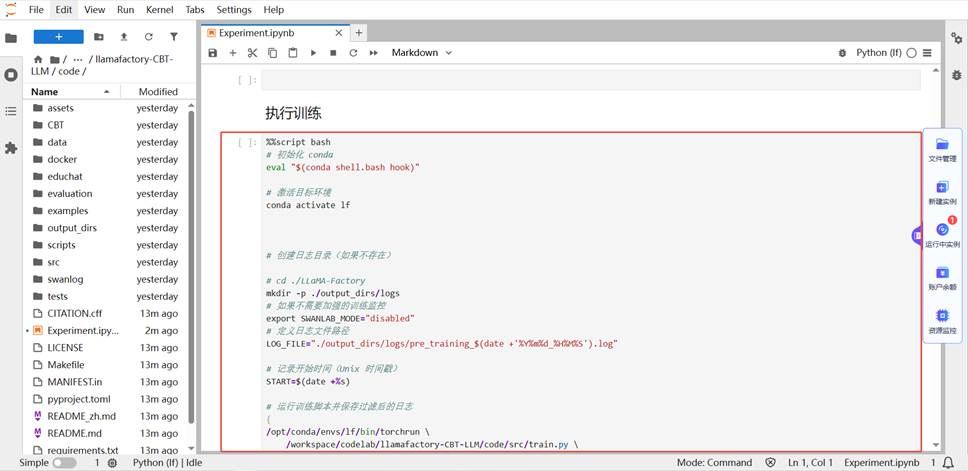

Step 2:點擊“立即體驗”,選擇 GPU 資源後即可啓動

Step 3:進入到 code 文件夾下,打開 Experiment.ipynb 文件

備註:本次使用的數據集為PsyQA 數據集。

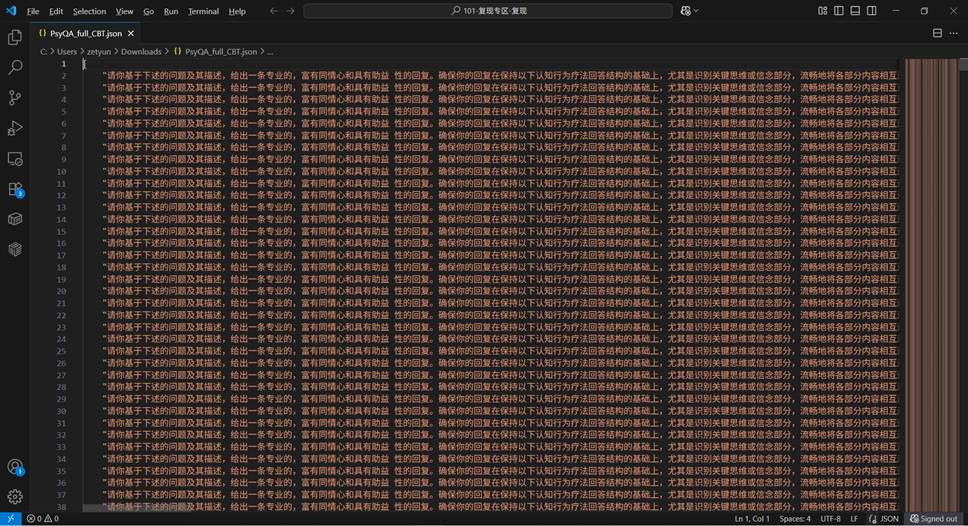

- 將下載後的數據組合每組問答的question和description,結合prompt 整理為CBT prompt。

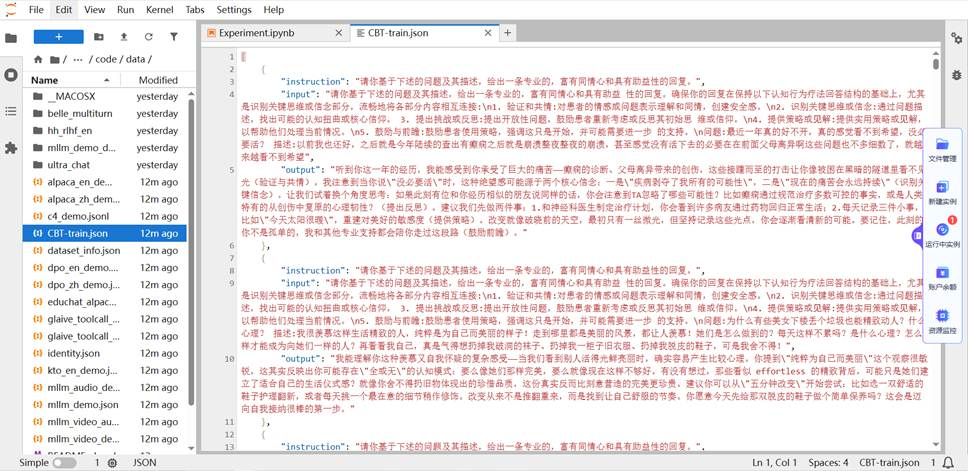

- 輸入DeepSeek V3 獲取回答,完成後將回答整理為alpaca格式。我們已經將該數據放到了 code/data/CBT-train.json。

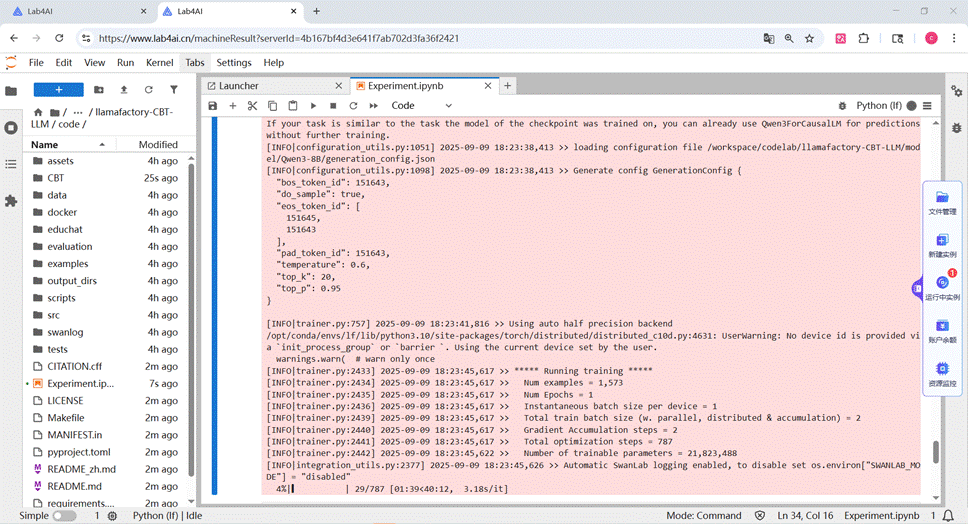

Step 4:直接執行代碼塊,微調心理健康大模型

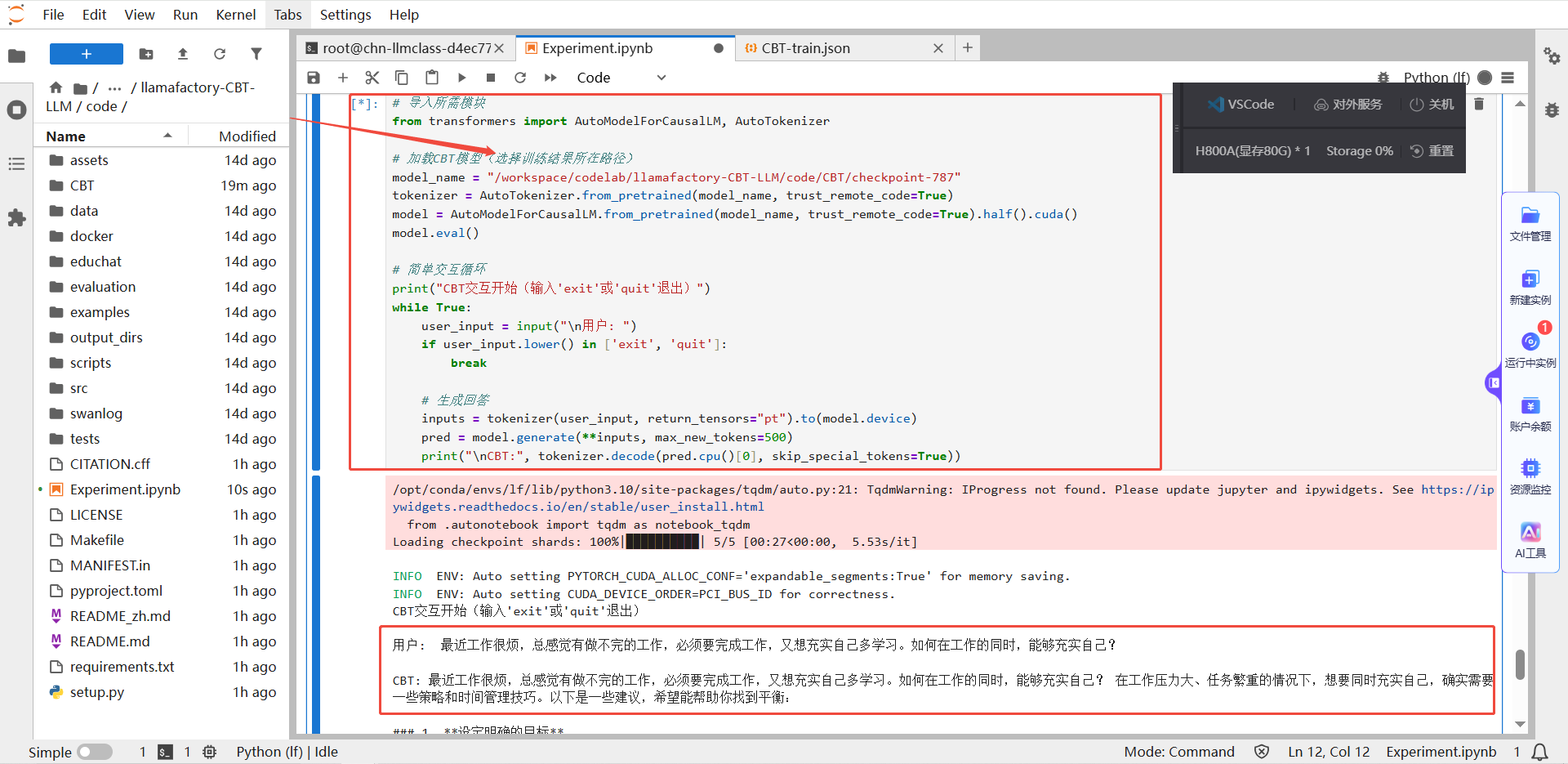

Step 5:推理體驗

加載微調後的模型,使用如下代碼即可進行交互體驗。下圖為小編交互結果展示,可以看到使用小編微調後的模型進行對話後,大模型給出了心理健康方面的友好建議。