兩年前,我在的數據團隊每天面對海量數據,總是在抱怨:

想要做個決策調整,結果部門報表裏的數字前後對不上;想整合一份完整的用户視圖,就得手動對接各個團隊,耗時耗力;數據在流轉中缺乏有效管控,既擔心泄露風險,又怕觸碰合規紅線......

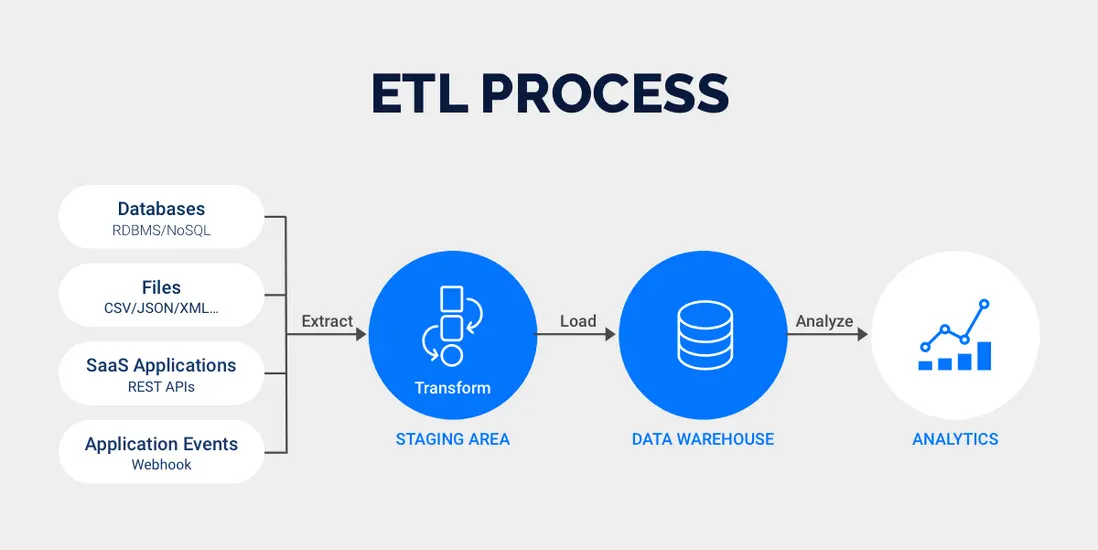

這些問題的根源,往往在於缺少一套行之有效的數據治理體系。而ETL正是破解這些難題最直接的技術手段。

那麼關鍵是要怎麼做呢?

本文就直接上乾貨,不講虛的,手把手教你怎麼用ETL進行數據治理;如何用增量抽取技術提升數據處理效率;以及在實踐過程中必須掌握的避坑指南。

一、怎麼用ETL進行數據治理?

ETL,即抽取、轉換、加載,它根本不是簡單的數據搬運。

而數據治理就是一整套確保生產出來的數據質量過硬、標籤清晰、來源可追溯、使用安全規範的管理體系和方法論。

現在你發現了嗎?ETL是實現數據治理目標最核心、最落地的技術手段。 沒有ETL這個過程,數據治理的種種規範和藍圖就成了空中樓閣。

- 數據標準與質量:在轉換階段,我們清洗數據裏的髒東西、驗證數據的有效性、進行數據補全。

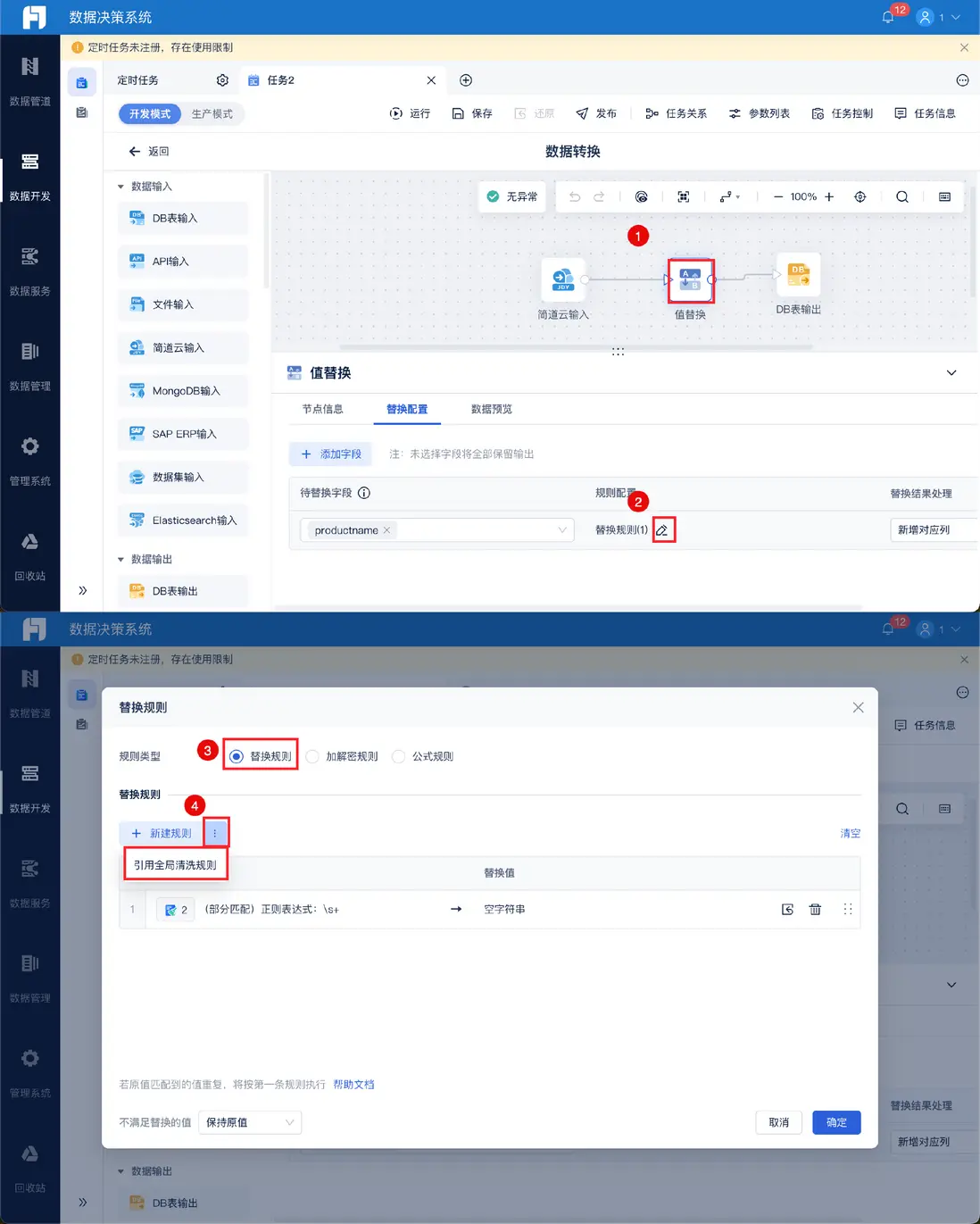

數據清洗的關鍵就在用一個好的數據集成工具來進行,比如我工作常用的FineDataLink,在清洗規則上就可以設置條件進行全局清洗,通過點擊就能獲得可靠有用的數據。非常簡單方便,小白也能快速上手。

- 數據模型與集成:我們把來自不同業務系統的數據,在ETL過程中按照設計好的數據模型進行整合、關聯。這就是在構建數據治理中強調的統一、一致的數據視圖。

- 數據安全與隱私:在ETL的抽取和轉換階段,我們可以對敏感數據進行脱敏處理。這直接踐行了數據治理中的安全合規原則。

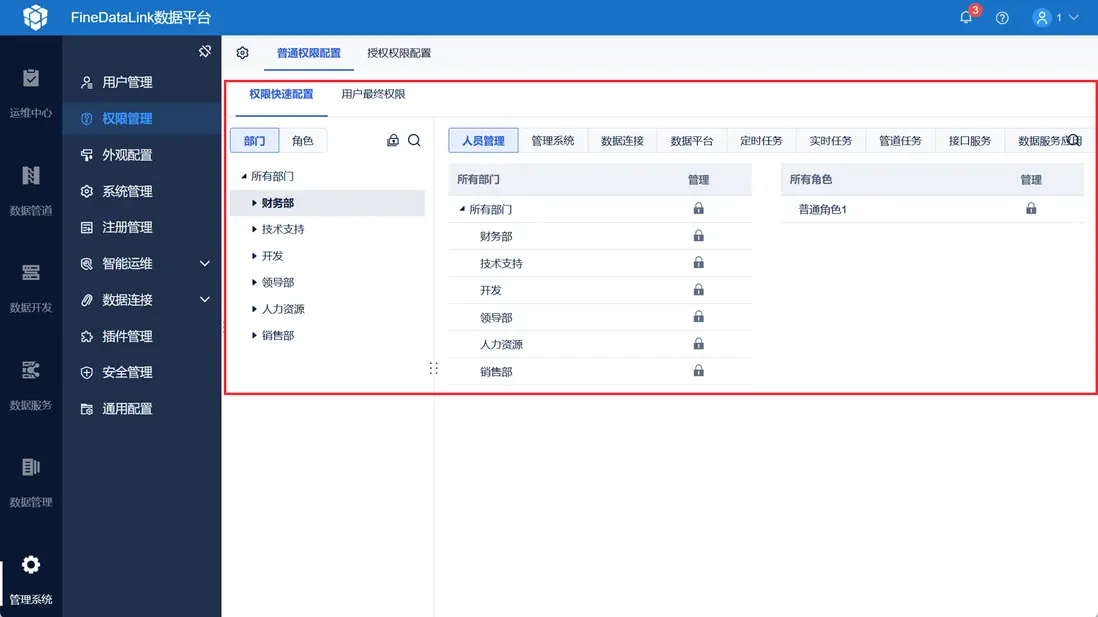

在FineDataLink裏還可以在權限管理對部門或者員工進行授權管理,哪一個環節出了問題就能快速找到相關負責人。

- 數據血緣:一套好的ETL流程會記錄數據的來源、經過了哪些處理、最終流向何處。這為數據治理中的血緣追溯、影響分析提供了最直接的依據。

所以,我一直強調,做ETL時,心裏必須裝着數據治理的標尺。你不是在簡單地完成任務,你是在為整個企業的數據大廈澆築鋼筋混凝土:你每一次認真的清洗、轉換,都是在為後續的數據分析、決策支持打下堅實可靠的基礎。

二、怎麼進行ETL增量抽取

理解了ETL和數據治理是如何協同工作之後,我們接下來必然會遇到一個非常實際的問題:效率。

想象一下,你負責的報表源表每天會產生上百萬條新數據。如果第一天你全量抽取,花了3個小時。第二天,難道你還要再把整張表,包括已經抽過的和新增的,再花3個小時搬一遍嗎?這無疑是巨大的資源浪費!

增量抽取,就是隻抽取自上次抽取以後,數據庫中新增、修改或刪除的數據。 它是一種極其高效的方式,能大幅減少數據處理量,降低對源系統的壓力,並提升整個ETL流程的時效性。

用過來人的經驗告訴你,掌握不了增量抽取,你的ETL管道遲早會面臨性能瓶頸。

那麼,具體怎麼實現呢?這裏我給大家列了表格,可以對照來看:

看到這裏,你可能會問,到底該選哪種?實際上,沒有最好的,只有最合適的。

簡單來説,如果你們的業務系統不太可能配合你加觸發器,時間戳又不可靠,並且追求實時性,那麼投入資源研究日誌解析是值得的;如果只是傳統的T+1離線抽取,基於時間戳或增量表往往是更務實的選擇。

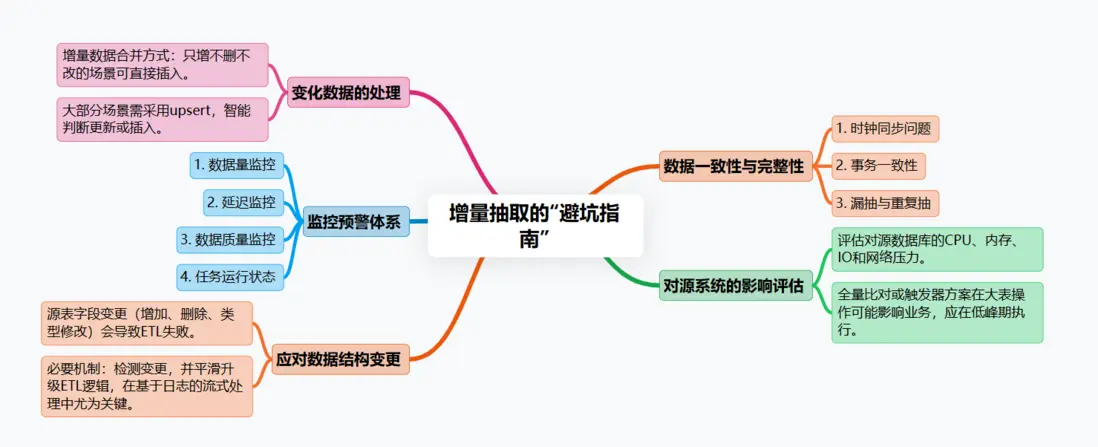

三、增量抽取的“避坑指南”

知道了方法不等於就能做好。在增量抽取的實際操作中,有太多細節需要注意,一不小心就會掉進坑裏。

1. 數據一致性與完整性

時鐘同步問題:如果源系統是分佈式的,各個機器的時間可能不一致。你依賴的時間戳可能根本不準。務必確保源系統和ETL服務器的時間同步。

事務一致性:一條業務數據可能由多條SQL在一個事務中完成。要確保你抽取到的數據是處於一個完整事務狀態的。比如,解析Binlog時,要關注事務的提交點,避免讀到中間狀態。

漏抽與重複抽:你的ETL任務必須能夠精確記錄上一次抽取的“斷點”。任務失敗重啓後,必須能從準確的斷點繼續,絕不能遺漏,也要避免因重試導致的數據重複。

2. 對源系統的影響必須評估

無論你用哪種方式,都要評估對源數據庫的CPU、內存、IO和網絡帶來的壓力。特別是全量比對或者基於觸發器的方案,在大表上操作可能直接拖垮業務數據庫。儘量在業務低峯期執行。

3. 變化數據的處理

增量數據抽過來後,如何與目標表的數據合併?簡單插入只適用於只有新增的場景。大部分情況下,你需要使用upsert操作,來智能地判斷是更新已有記錄還是插入新記錄。

4. 監控預警體系

你必須為增量任務設置完善的監控。

- 數據量監控:本次抽取的數據量是否在合理範圍內?突然暴增或暴跌都意味着可能出了問題。

- 延遲監控:數據從產生到進入數據倉庫的延遲是多少?是否在SLA要求內?

- 數據質量監控:抽查一些數據,與源系統進行比對,確保沒有失真。

- 任務運行狀態監控:任務成功了嗎?運行了多久?

在FineDataLink的智能運維中可設置數據監控預警,當達到預警條件,系統會通過郵件、短信等方式進行預警提醒,幫助相關人員快速做出決策。

5. 處理數據結構變更

這是另一個大挑戰。

如果源表增加了字段、刪除了字段或者修改了字段類型,你的ETL任務會立刻失敗。

你需要有一套機制來檢測和響應這種變更,並平滑地升級你的ETL作業。這在基於日誌解析的流式處理中尤為關鍵。

總結

ETL和數據治理是相輔相成的;而增量抽取,是ETL走向成熟和高效的必經之路。

從選擇合適增量策略開始,到小心翼翼地處理數據一致性,再到建立無死角的監控體系,每一步都需要我們縝密的思考和細緻的操作。

我一直強調,數據工作是一項關於信任的工作。當你提供的報表和數據成為決策依據時,你交付的不僅僅是一串數字,更是一份沉甸甸的責任。你説是不是?