本文作者:阿里雲數據庫高級技術專家 徐大丁(辰馬)

前言

“What I cannot create, I do not understand.” -- Richard Feynman

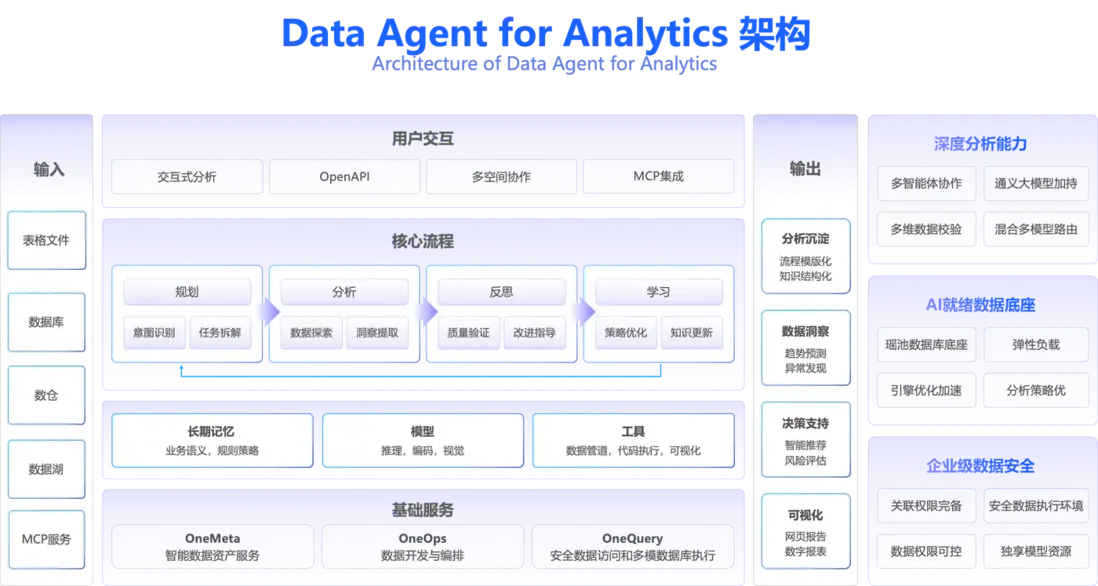

2025年3月,筆者曾撰文探討LLM驅動的AI Agent如何重塑人機協同模式,彼時更多聚焦於技術實驗與理論推演,尚未在實際業務場景中落地。如今,隨着Agentic AI技術的成熟,Data Agent for Analytics 正式從實驗室走向企業生產一線——它不僅是對AI Agent潛力的驗證,更是企業級數據分析範式的革新。

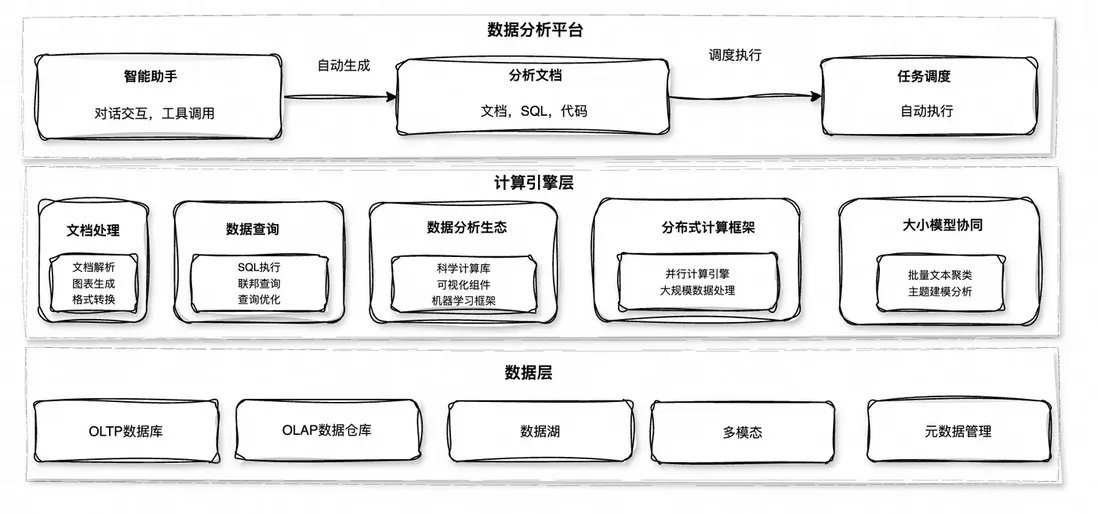

本篇將介紹DMS的一款數據分析智能體(Data Agent for Analytics )產品的技術思考和實踐。Data Agent for Analytics 定位為一款企業級數據分析智能體, 基於Agentic AI 技術,幫助用户查數據、做分析、生成報告、深入洞察。由於不同產品的演進路徑,背景都不一樣,所以只介紹最核心的部分,來深入剖析如何構建企業級數據分析助手:能力邊界定義,技術內核,企業級能力。希望既能作為Data Agent for Analytics產品的技術核心介紹,也能作為讀者的開發實踐的參考。

能力邊界定義

與ChatBI/NL2SQL的區別

很多客户會問Data Agent是不是ChatBI,是不是另一個NL2SQL產品。我一般都會明確回答不是,並補充Data Agent使用了ChatBI和NL2SQL相關的技術。但為了更好的讓用户理解本質的區別,需要先做一些概念的抽象,聚焦在數據與分析技術領域上,以及對Agentic AI的介紹,抽象能夠更好的理解。

定義分析技術

數據與分析主題在大語言模型起來之前已經比較熱門。我們可以藉助Gartner對數據與分析的定義,嘗試把Data Agent的分析能力邊界定義清楚。 Gartner把數據和分析定義為:管理數據以發揮數據作用,分析數據以優化決策、業務流程和成果的方法。並將核心分析技術按照目標分為四種:

● 描述性分析(Descriptive analytics):使用BI工具、數據可視化和展示面板來回答:發生了什麼?

● 診斷性分析(Diagnostic analytics):需要更深入的分析和數據挖掘能力來回答:為什麼會發生?

● 預測性分析(Predictive analytics):通過概率預測或模擬一段時間內一系列結果 來回答:可能發生什麼?

● 規範性分析(Prescriptive analytics ):以結構化方式整合已有的知識和優化技術,在約束範圍內尋找最佳結果並生成可執行的行動計劃,以此來回答:應該做什麼?

傳統的BI分析

ChatBI或NL2SQL類的產品分析技術本質上在傳統的BI分析基礎上結合了LLM能力。 傳統的BI分析側重描述性分析和診斷性分析,也就是回答發生了什麼,為什麼會發生問題,為決策提供事實依據, 典型流程是:業務系統,ETL工具,數據倉庫,預定義指標最後到報表和儀表盤。

傳統的BI分析技術,優勢在於直觀可控, 業務人員可以自主地生成報表, 工具鏈完整,技術成熟。 劣勢主要在分析能力上,比如深度上存在侷限,依賴預定義指標,需提前定義分析維度和提出假設,比較難以發現隱藏洞察。

高級分析技術

傳統的BI分析對於預測性或者規範性的分析洞察是比較困難的,所以這裏提出了高級分析技術, 涵蓋了預測性,規範性和人工智能技術。 偏向於使用數據科學和機器學習技術,主要流程包含數據處理與特徵工程,模型構建,模型推理最後到行動建議。

高級分析技術的優勢是可以利用不同的數據輸入類型和來源,為分析者提供更多的角度洞察,推動企業作出更明智的商業決策。通過ML模型預判趨勢/風險,優化算法生成行動方案,以及從非結構化數據中挖掘關聯規則,比如自然語言處理,挖掘隱藏模式等。 劣勢主要是門檻較高,落地週期長。 數據類型支持上,除了結構化數據, 相比傳統BI分析,多了非結構化,實時數據流以及圖關係數據,所以對數據治理要求也比較高。 另外涉及到機器學習,尤其是用到了深度學習模型,可解釋性存在挑戰。

Data Agent的價值主張

我們現在可以更明確地定義DMS Data Agent for Analytics了。 我們希望把 Data Agent 定位為一款能夠同時覆蓋傳統BI分析(描述性、診斷性)和高級分析(預測性、規範性)能力的智能體。也就是既可以作為自然語言到SQL查詢的轉換工具(NL2SQL),也可以生成預定義報表的聊天式BI(包括ChatBI),更重要的是一個具備理解分析意圖、規劃分析路徑、執行復雜任務、並生成深度洞察的自主智能系統。

這裏先嚐試定義Data Agent的價值主張,技術實現也是圍繞以下的價值主張:

● 打破分析能力邊界: 用户無需預先知道該用描述性統計還是構建預測模型。Data Agent 能根據用户模糊或複雜的自然語言提問(比如“為什麼上季度華東區銷售額下滑?預測下季度趨勢並給出改善建議”),自動判斷所需的分析技術組合,無縫銜接查詢、診斷、預測和規劃。

● 降低高級分析門檻: 將複雜的機器學習、優化算法等高級分析能力封裝在Data Agent內部,用户通過自然語言即可調用,無需具備數據科學專業知識,縮短從問題到洞察的行動路徑。

● 擺脱預定義的限制: 不再侷限於預定義的指標、維度和儀表盤。Data Agent 能動態探索數據,發現預定義框架之外的隱藏模式、關聯關係和異常點,提供更全面、更深入的洞察。

● 實現端到端分析閉環: 從數據查詢、可視化、根因診斷、趨勢預測到行動方案建議,能夠在一個連貫的交互過程中完成,過程可解釋,分析過程可複用,提供閉環的分析體驗。

● 具備企業級更大規模數據的分析能力:不限於分析數據庫或者表格文件,藉助於雲原生計算能力,能夠無縫對接大數據生態,使用分佈式計算(Spark/Ray)實現海量,多模的數據實時分析。

Agentic AI 能力對比

Data Agent與ChatBI等市面上其他的問數的產品區別是什麼呢?畢竟都在強調具備Agentic AI的能力。 Agentic AI(智能體驅動的人工智能)的概念在LLM出現之前就存在(例如在強化學習、傳統AI中), 但隨着LLM能力的突破性進展,Agentic AI作為新一代AI範式被廣泛認可。其核心可定義為:以大型語言模型為認知引擎,具備自主決策、目標導向和環境交互能力的智能體系統。

我們可以從利用模型推理的程度來進行分別,也就是Test-Time Scalling。 是模型推理階段的Scaling Law。

隨着OpenAI o1和DeepSeek R1等模型展示了強大的CoT推理能力,業界認識到增加推理計算量能顯著提升複雜任務的準確性。這催生了TTS(Test-Time Scaling)這一新興的研究領域。TTS模仿了人類在處理困難問題時的傾向,也就是投入更長的時間和更多的思考資源來提高決策的可靠性, 對於AI Agent來説, 通過增加LLM的測試時間, 可以增強其自我改進,減少人工監督。 接下來我們結合TTS從架構差異,性能和適用場景進行簡單對比。

● 架構的差異:

○ ChatBI(問數)優勢:架構簡潔,基於NL2SQL技術,易於集成現有BI平台,支持快速意圖識別和可視化輸出,適合對話式交互。侷限:TTS應用有限(簡單的CoT),被動響應模式,缺乏上下文記憶和多步推理,難以處理複雜查詢和根因分析。前期配置工作較多,比如需要對接入的數據源進行清洗,質量優化。同時為了提高自然語言查詢的準確度,需要預定義好數據模型(維度,獨立,層次關係等)

○ Data Agent 優勢:多代理架構,集成知識庫和長期記憶,深度應用TTS(多路徑探索、迭代採樣),支持主動監控和個性化洞察。侷限:架構複雜,實施門檻高,對於簡單的問題容易陷入複雜的邏輯陷阱中,導致取數效率不高。

● 性能:

○ ChatBI(問數)響應速度快,低延遲(單輪100-5000 Token),適合即時洞察(如銷售彙總、圖表生成),推理深度有限,缺乏主動性。

○ Data Agent:深度分析(異常檢測、預測建模、行動建議),支持多源數據處理,延遲較高,Token消耗大,但可以基於問題的難以程度實現推理時間的最優分配。

● 適用場景:

○ ChatBI(問數):適合標準化、高頻的簡單查詢場景,但對數據質量要求極高,需要提前做數據建模。

○ Data Agent:適合複雜、個性化的分析場景,對數據質量要求不高,提供主動式、智能化的數據洞察體驗。

總結

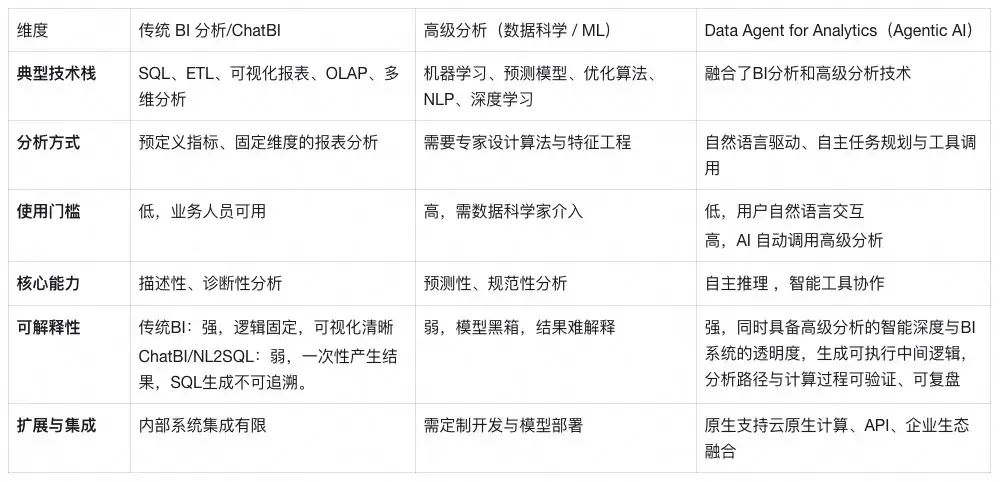

最後,我們可以用表格對傳統BI/ChatBI,高級分析和Data Agent差異化進行總結:

技術內核

通過前面的介紹,Data Agent將LLM作為認知引擎。 LLM基於語言模式的統計學習,缺乏對事實世界的真實理解。生成的內容是對訓練數據中模式的重組,而非基於邏輯推理的事實表述,這就會導致數據分析過程中,有可能出現幻覺。 其次是上下文學習能力(ICL)的侷限性,比如差的Few-shot會誤導後續推理,泛化能力問題,難以理解複雜場景下的深度語義和意圖等。 另外是工具使用上,一方面LLM對於太多工具難以適應,一方面工具調用也存在安全的風險。

接下來重點介紹 Data Agent 針對以上的問題是如何優化的,以及如何讓LLM像分析師一樣思考與行動,包含以下幾個方面:

● 深度語義理解

● 上下文管理

● 幻覺抑制

● 工具的使用

深度語義理解

首先需要理解用户想要什麼,當用户説"分析一下銷售表現"時,作為數據分析的智能助手, Data Agent需要考慮提問者的角色背景、所處的業務場景、以及歷史對話記錄中學習的用户偏好,計算口徑等,需要記憶沉澱能力。

其次是語義理解,語義理解的複雜性體現在同一個詞在不同行業、不同公司甚至不同部門都有不同含義。"活躍用户"在電商場景下可能指30天內有購買行為的用户,在社交產品中可能指7天內有登錄行為的用户,在SaaS產品中可能指當月有核心功能使用的付費用户。Data Agent必須維護這些領域特定的語義映射,並在對話中動態選擇正確的解釋。

數據的元數據(Catalog)決定Data Agent的數據理解, 比如多表關聯查詢,或者某個字段的分佈特徵,如果一開始 Data Agent不理解或者未完全理解,直接導致後續分析邏輯錯誤,我們把數據理解作為獨立模塊,便於在用户錄入和分析過程中可以複用。

計算口徑的澄清是語義理解的另一個關鍵維度。企業數據分析中最常見的問題之一就是:同樣的指標名稱,不同團隊計算出的結果不一樣,這往往源於對計算口徑的理解差異。是否包含退貨、是否剔除測試訂單、是用下單時間還是支付時間、匯率是用實時還是月末等等。

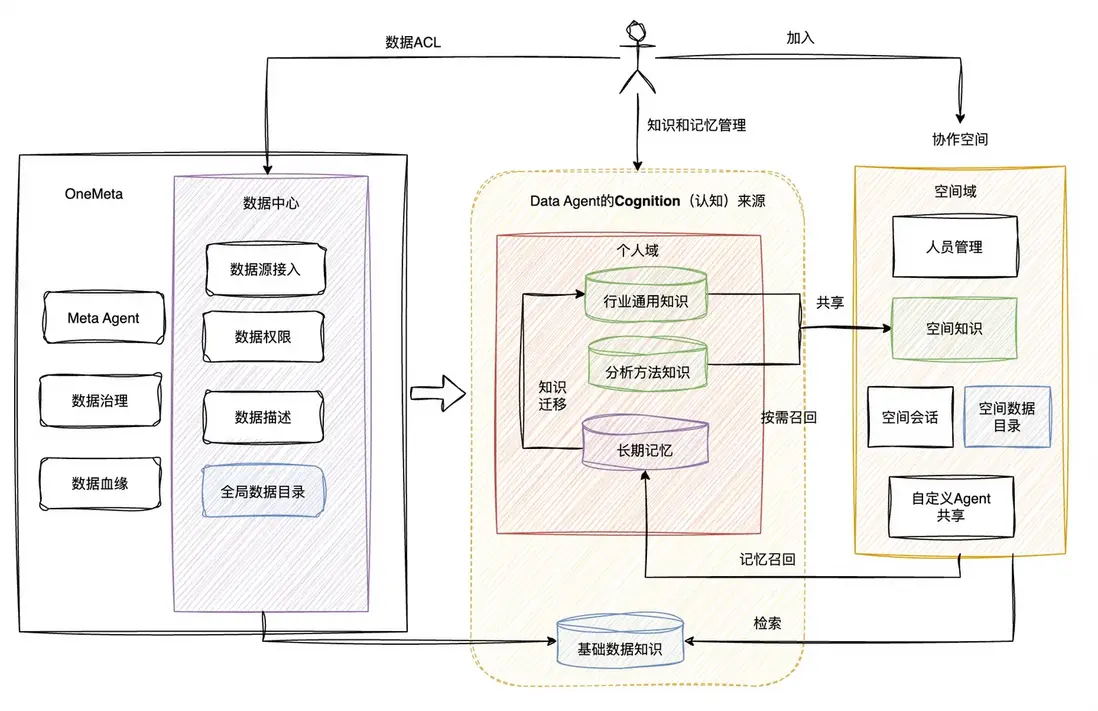

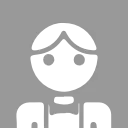

我們把以上的內容抽象為知識和記憶。

知識與記憶形成了人對事物的認知,AI Agent中的知識和記憶是什麼呢?在AI Agent 系統中,“知識”通常指Agent可獲取的領域事實、規則或靜態信息,如預先收集的文檔、知識庫或訓練數據中的隱式知識;而“記憶”指Agent在交互過程中動態記錄的上下文信息和經驗,如用户歷史對話、偏好或之前決策。知識和記憶如同光譜的兩端,二者在某種程度上可以相互轉化。

● 左側是具體,個性化的記憶,偏向具體的事實記錄,有情景性和特殊性。

● 右側是抽象,通用的知識,原理和規則,具有邏輯性強,通常是經過整理和歸納的通用信息。

● 中間存在過渡狀態,如同光譜的顏色漸變一樣,當記憶被多次驗證、結構化、抽象化後,它可以上升為知識;反之,當知識被個性化使用時,也會沉澱為新的記憶。

哲學家對知識的定義始終未達成一致,不過我們可以嘗試定義 Data Agent的知識,可以按照不同的抽象層次進行劃分:

● 底層是基礎數據知識,關於數據本身的詳細信息,包括數據的Catalog(通常包含庫表列,名稱含義、數據類型,存儲方式,採集來源,數據血緣等),是 Data Agent理解和獲取原始數據的基礎。

● 中間為分析方法知識,包含各種用於處理和分析數據的算法,模型,統計方法或口徑,以及自定義的分析流程, 決定 Data Agent如何從原始數據中提取有價值的信息和規律。

● 最高層為行業通用知識,包含通用的業務邏輯,行業術語(黑話),概念以及行業的一般性規則和理念等,用於指導 Data Agent的分析方向,如何解讀分析結果,並使得 Data Agent以符合行業或公司習慣的方法進行交流和應用分析結果。

知識和記憶的難點在於如何召回,二者的召回目的,流程和策略都有較大的差別,知識的目的是保證分析的正確性與通用性,提供確定性,邏輯規則,而記憶是為了連續性和情景化。 策略上,知識可以使用RAG,層級(上文的三個抽象層級)分類召回。 而記憶需要根據時間和熱度召回,記憶需要具備遺忘機制。

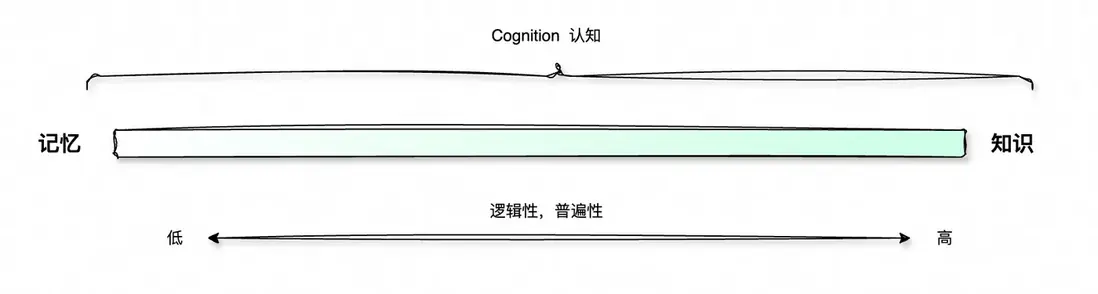

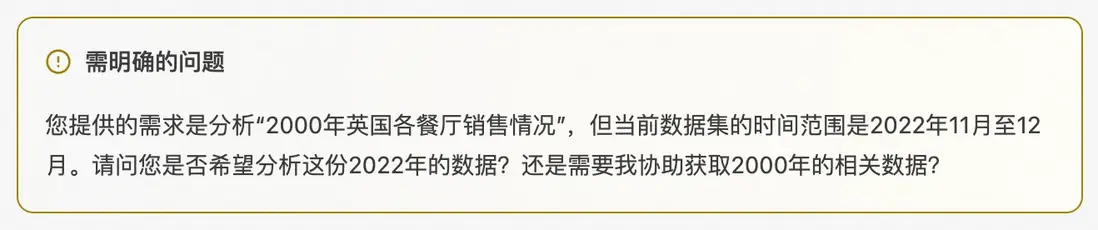

最後,人與人之間溝通需求時,也不是一次問答就能夠清晰明瞭的,所以多輪對話也是必要的, 這就要求 Data Agent 需求分析模塊具備“反向提問”的能力,當模型檢測到語義置信度不足,通過Human-in-the-Loop 意圖澄清機制,使得Data Agent能夠在前期確保問題被正確定義。

不阻塞分析-提示

阻塞分析-需要明確反饋

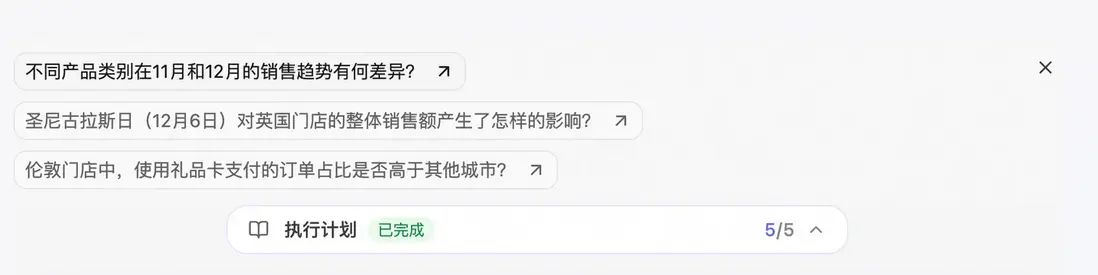

在語義結構明確後,Data Agent 會自動生成意圖執行計劃,以結構化方式給用户展示分析思路,用户也可以根據需要進行調整。

執行計劃概覽

展開後的計劃詳情

如何處理開放式探索性類型的問題, 很多時候用户可能也不知道怎麼提問,就像老闆給你分配一個模糊的任務一樣,老闆內心裏面可能希望你發現一些洞察,但是不知道具體是什麼。 這類問題對人來説簡直是天災,沒有目的地分析,對於認真工作的你來説,往往需要耗費更多的精力。 但是對於Data Agent來説,這反而是其最擅長的點。 Data Agent可以結合業務語義,數據語義從不同的角度進行分析。在這個過程中,可能會給你更多的啓發,幫助你進一步下鑽分析。

Data Agent一輪分析完後給出問題建議,幫助用户進一步洞察

上下文管理

Context Engineering 是當下比較流行的AI Agent開發的工程實踐, 針對每一次給到LLM的上下文進行動態的設計,構建,和優化,上下文內容除了系統提示詞、角色和目標描述、用户需求外,還有對話歷史,外部知識,工具調用等。 簡單來説,上下文工程決定了模型知道什麼,何時知道以及何種方式知道, 最終目的是LLM在約束的搜索空間下, 可以更好的理解、推理和決策。

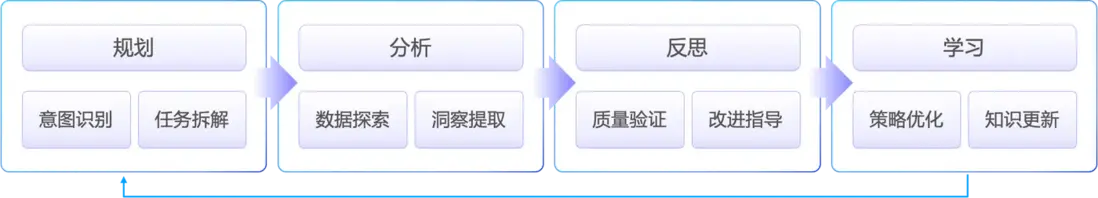

如下圖,Data Agent 的上下文管理實際上是一個完整的智能認知系統的構建,核心流程如下:從規劃,分析,反思到學習,構建一個完整的智能認知系統。

Agent Core Loop

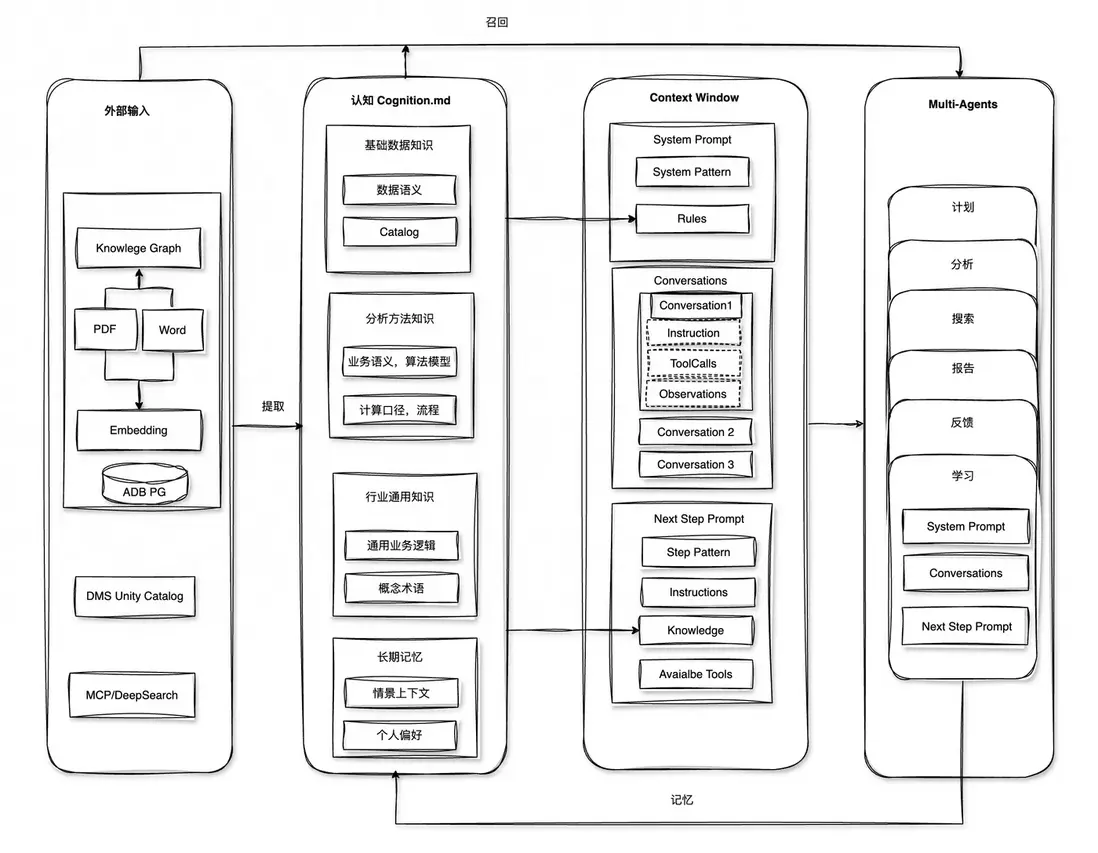

進一步展開,如下圖, 從右往左看:

Data Agent上下文管理

● Data Agent通過Multi-Agents協作,每個Agent具備獨立的上下文管理能力,有助於進一步縮小模型的搜索空間, 通過協作完成複雜的任務。

● Context Windows內容是動態的,也就是大家常看到的上下文管理能力, 比如長度控制,KVCache優化, 按需從長期記憶層尋找相關規則和知識內容。

● 我們稱為Cognition,有點擬人化意思。 包含前文描述的三層知識(基礎數據知識,分析方法支持和行業通用知識),同時包含Agent的長期記憶, 作為 Data Agent的認知基座,為每次分析提供認知支撐。

● 最左邊是外部輸入層,具備多源知識融合能力, 主要負責將文檔、數據庫、實時搜索等異構數據源統一處理,通過知識圖譜和向量化技術實現語義級的知識存儲和檢索。

幻覺抑制

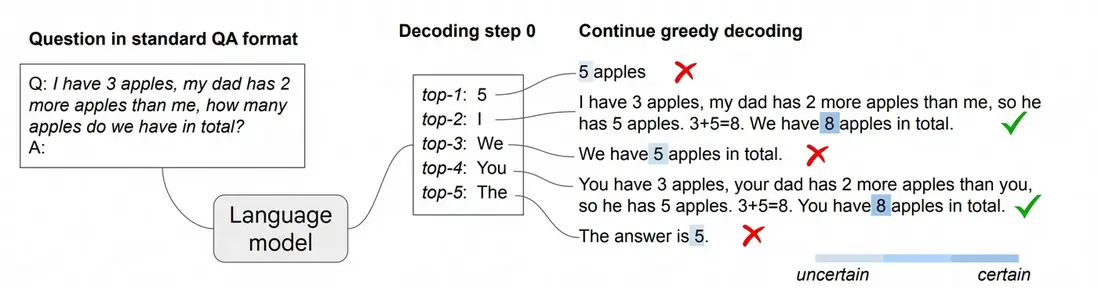

用户經常會問使用Data Agent做數據分析,模型有上下文窗口限制,是怎麼放得下的, 我們通常回答放不下,因為Data Agent並不會把用户的原始數據給到模型上下文, 根本原因不是上下文窗口問題,而是模型推理的本質, 雖然今天像Qwen,DeepSeek這類模型具備Thinking模式,模型進行依然是語義空間的模式匹配和概率推理,對於精確的數值計算,邏輯推導,模型本質是在模擬計算過程,而非真正執行計算。 比如下面的例子, 模型會根據問題進行下一個Token預測, 如果使用Greedy Decoding方式,每次取概率最大的Logis或token,很有可能計算錯誤,設置不同的tok_k或者temperature會產生不一樣的結論。

來自:Chain-of-Thought Reasoning without Prompting

如果結合LLM的預訓練機制,我們可以進一步分析LLM數字幻覺的原理,儘管今天的LLM在數學能力上顯著提升,在一些競賽上已經超過了大部分人,但在處理需要精確數值理解的任務時,仍易產生數字幻覺。具體體現在以下幾個方面。

○ 分詞問題,LLM在推理之前,會把輸入進行分詞,也就是我們常説的Token化,然後再進行Embedding向量化。 有時LLM對數字的分詞是非原子化的,比如“489,012” 可能被分解為:489、 , 、012 三個獨立的Token,這不僅割裂了數字的整體性,使模型難以將其作為一個單一數值實體處理,分隔符Token(如逗號)還可能引入干擾或歧義。

○ 位置編碼干擾,主流的序列位置編碼方法(比如RoPE)主要解決文本的相對位置依賴性,但對數值的絕對精度需求支持不足。位置編碼的量化特性也可能對鄰近小數字的表徵造成不利影響。

○ 預訓練知識中數據分佈的長尾效應, 數據中某些模式的普遍性會導致模型產生系統性偏差。例如我們之前遇到的一個真實案例:訓練語料中“第X個”的表達常以“第0個”或“第一個”對應索引0開始,導致模型在明確要求“從1開始計數”時,仍頑固地輸出從0開始的索引(BadCase)。相反,要求“從100開始計數”則可能正確,因為該模式在數據中相對少見。

○ 數字模式的過擬合,比如LLM學到了“銷售增長通常在20-30%” 這樣的模式, 當實際需要計算時,如果PE沒有做好,模型很可能會輸出這個“經驗值”

○ 語義空間和數值空間是不對等的, 我們知道LLM基於自然語言模式匹配,其數值推理缺乏數學嚴謹性,在Embedding空間中,兩組數字語義距離可能離得很近,但實際上對數值分析來説,毫無意義,甚至產生誤導。

那如何解決這個問題呢,一種方式是通過提示詞工程(PE)手段進行優化,比如COT,Step by Step等,這些PE優化手段的主要作用是:提升推理過程的透明度、引導LLM結構化思考、暴露潛在錯誤,它們本身不能直接大幅降低前面描述的LLM固有幻覺。在Agent應用場景中,這些方法的作用是讓錯誤更容易被發現,併為後續的驗證或工具調用創造條件。另外也可以使用Self-Consistency 方式,採樣多個推理路徑並投票,能在一定程度上減少隨機錯誤的發生。Self-Consistency 假設正確的答案往往對應多條合理的推理路徑,從統計上是優於單一路徑上的結果。

另外就是藉助工具,比如計算器。 2023年6月GPT-4首次引入Function Calling,而Calculator是最早的示例之一。

觀察今天的大語言模型,主要在內容創作,Math和Coding能力方面,這很大原因是這些知識都是人類對世界的抽象語言,並且已經數字化,這正是LLM的學習來源。 對於Agent來説,使用LLM 來Coding,實際在創造工具,感知真實世界,解決更復雜的問題,可能是通往AGI的必經之路。各大廠商都在不斷增強LLM的Codding能力。

Data Agent 綜合了以上的優化思路,尤其是以 Code-based Reasoning 為核心策略, LLM負責理解問題並生成可執行代碼,比如SQL,Python 以及其他的DSL,作為中間的邏輯表示, 將最終答案生成的責任轉移給代碼執行引擎,使輸出可執行、可解釋、可復現。將產生幻覺的風險從“自然語言層面的直接幻覺”轉化為“邏輯層面的代碼正確性風險”,後者可通過工程化手段(代碼檢查、測試、驗證)進行更有效的系統性管理,從而從大幅減少LLM 在最終數值和事實斷言上的編造問題。

其次Data Agent使得LLM像一個數據分析師那樣思考:理解問題 ,數據獲取 , 數據驗證 , 邏輯建模 , 可視化,結論生成等。除了通過編寫SQL或者藉助Pandas,Numpy這類數據分析常用的庫以外,Data Agent也會和數據分析一樣,通過數據可視化進行直覺驗證,畢竟一圖勝千言,藉助VL模型可以比較容易地洞察數據趨勢和異常點。 Verify機制也是Data Agent最重要的部分,不僅可以對可視化效果進行審查,最重要的是對最終的分析結果進行上下文驗證,進一步降低幻覺。另外在數據分析層次上,比如DIKW模型的內化,有助於 Data Agent更加的專業化的分析。

工具的使用

LLM因為有了工具,不再侷限於文本生成。 MCP掀起一波AI Ready 熱潮,可能MCP的構建者比MCP用户還要多。 實際上模型能夠準確地用好幾個工具已經是非常大的進步了。實際經驗來看,超過10個以上,主流的LLM很難得心應手。總結下來有幾個方面。

● 當系統中工具數量增多時,系統註冊了大量工具(例如:查詢數據庫、繪圖、報表生成、外部 API 調用等), 模型需要根據自然語言描述在這些工具之間進行匹配,面臨工具選擇的語義模糊性,導致工具誤選,漏選。

● 其次是工具多,增加了組合複雜性,尤其是參數複雜或中間狀態不透明時,很容易導致調用鏈斷裂,結果不一致和死循環。

● 上下文容量與記憶碎片化問題, 工具説明會佔用大量上下文,工具調用之間的狀態和結果難以長期保留,導致記憶碎片化,信息丟失。

● 工具接口不統一,往往由不同團隊或系統提供,接口規範、輸入輸出格式、錯誤機制各不相同,無形地增加了LLM推理時的搜索空間。

● 最後是安全問題,工具調用往往意味着執行外部代碼或訪問敏感數據,外部工具惡意 Prompt 注入可能誘導模型越權執行。

Data Agent 對於工具的選擇始終保持克制,前文提到 Data Agent 使用 “Code-based Reasoning” 的策略,專注於數據分析, 除了給到LLM的上下文是連貫的, 我們希望代碼邏輯也是連貫的,也就是LLM的輸出是可執行、可解釋、可復現的。結合DMS的DataOps的能力積累,我們為客户提供一個安全的,雲原生的沙箱環境,Agent通過統一的交互協議與之通信。 這種模式有以下幾個關鍵優勢,也是 Data Agent服務於企業客户數據分析場景的關鍵。

● 模型只需要知道一個工具,可以執行SQL,Python代碼,畫圖,編寫文檔,並且是交互式的,可驗證計算,有助於LLM自動修正與逐步推理。

● 具備持久執行上下文,代碼執行器可以在多輪推理中保留變量、函數、數據表和中間結果,變量與函數在多輪推理間複用。這種模式與模型上下文的目的是一致的,能讓 LLM 以更自然、更一致的方式進行多步推理與探索。同時可以固化為分析文檔,使得分析流程可追蹤和可解釋。

● 與數據分析生態融合, 兼容主流 Python 數據分析與機器學習庫,在分析過程中動態構建、訓練模型,利用算法結果輔助推理,傳統的算法提供確定性,LLM 提供語義解釋。

● 大小模型協同,尤其是自然語言處理領域除了LLM,還有許多專有的語言模型,在情感分析,文本聚類等場景下,尤其是數據規模比較大的情況下,性能效率更出色。

● 支持部署在用户VPC網絡環境,計算沙箱環境與VPC內存儲與計算資源打通,構建私有網絡分析環境,數據不出域。

● 支持更大規模數據的分析,計算沙箱環境可以作為數據庫,分佈式計算引擎或框架(比如Spark,Ray, Dask等)的Driver端,進而連接更大規模的數據。對海量的數據進行探索性分析。

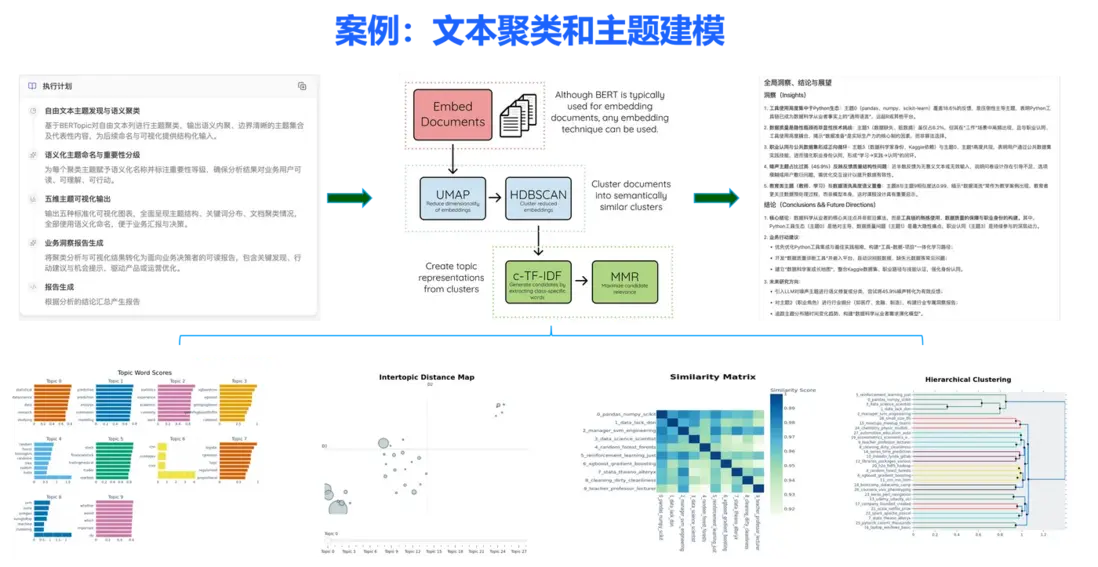

舉一個例子, 用Data Agent分析《2017年Kaggle 機器學習和數據科學調查》 公開數據集,Data Agent 可以利用BERTopic,將基於 Transformer 的嵌入模型,聚類以及自定義 TF-IDF 策略相結合,創建可解釋且語義上有意義的主題,再結合LLM的語言理解能力,可以給出人能看得懂的分析報告。

企業級能力

Data Agent 經過小半年的建設,其分析能力已經得到客户的認可,並在雲棲大會上,備受關注。 三天的雲棲大會,團隊的同學在展台邊上與來自各行各業的300+客户交流,深刻認識到,成為企業生產鏈路的一環是多麼的重要,技術先進性需與企業價值對齊,缺乏業務增長支撐的能力將難以落地。那我們常説的企業級能力是什麼呢, 或者説用雲企業客户關注企業級能力什麼特徵?我理解核心有三點:

○ 首先是可靠性,系統持續在線;

○ 其次是可控性,數據,安全,責任邊界等可控;

○ 最後是可複用性, 知識,流程,洞察能被沉澱和擴展。

從這三個特徵出發,結合客户交流反饋, 可以定義出Data Agent應當有哪些企業級核心能力。

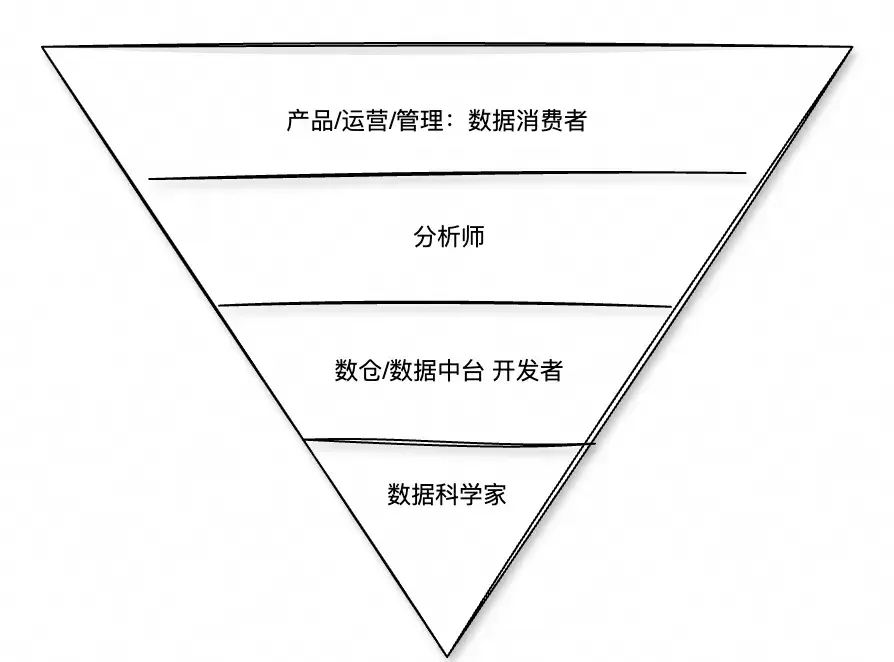

Data Agent 知識,記憶與協作

空間內部成員, 一個企業或者組織中, 圍繞數據可以分為四層結構,通常每一層對數據的認知需求也不太一樣, 可以面前的與DIKW模型對應起來,但這也不是絕對的。 但我們可以明確的是, 對數據洞察的需求以及數據分析技能的掌握是不匹配的, 大多數最有能力的人距離真實業務場景相對而言更遠。所以Data Agent需要考慮他們之間的協作關係,幫助有數據專業分析技能的人更加高效,使得他們的價值通過Data Agent 放大數倍,實現對企業數據更加深刻的洞察,同時可以減少數據消費者洞察數據價值的等待時間,另外借助Data Agent賦予數據消費者更多的自主能力。

企業數據分析需求分佈

最後

以上是我們這半年做Data Agent 一些想法和實踐經驗,希望使得您對Data Agent有更全面的認識, 同時在構建類似的產品功能時有些參考價值, LLM能力的快速發展,使人有一種AGI很快就會到來的錯覺, 但實踐下來其實還有很長的路要走, 或許不久將來會出現比基於Transformer或者RL更先進的訓練方法,不管怎麼樣,人工智能始終是一門應用學科,只有不斷地實踐,才能突破認知瓶頸,更好的擁抱時代的變化。

參考資料

Data Agent 精彩演示:https://developer.aliyun.com/live/255453

DMS Data Agent 當前開放邀測中,立即申請邀測碼免費測試:https://page.aliyun.com/form/act366003960/index.htm

Data Agent 免費體驗中心:https://www.aliyun.com/exp/data-agent

產品文檔:https://help.aliyun.com/zh/dms/data-agent-for-analytics/

Data Agent 個人版99元