本軟件工具僅限於學術交流使用,嚴格遵循相關法律法規,符合平台內容合法合規性,禁止用於任何商業用途!

一、背景介紹

1.1 爬取目標

我是@馬哥python説,一名10年程序猿。

我用Python獨立開發了一款爬蟲軟件,作用是:通過搜索關鍵詞采集YouTube的搜索結果,包含14個關鍵字段:關鍵詞,頁碼,視頻標題,視頻id,視頻鏈接,發佈時間,視頻時長,頻道名稱,頻道id,頻道鏈接,播放數,點贊數,評論數,視頻簡介。

軟件是通過調用YouTube的谷歌官方API實現,並非通過網頁爬蟲,所以穩定性較高!

開通YouTube的API:【詳細教程】手把手教你開通YouTube官方API接口(youtube data api v3)

開發成界面軟件的目的:方便不懂編程代碼的小白用户使用,無需安裝python,無需改代碼,雙擊打開即用!

軟件界面截圖:

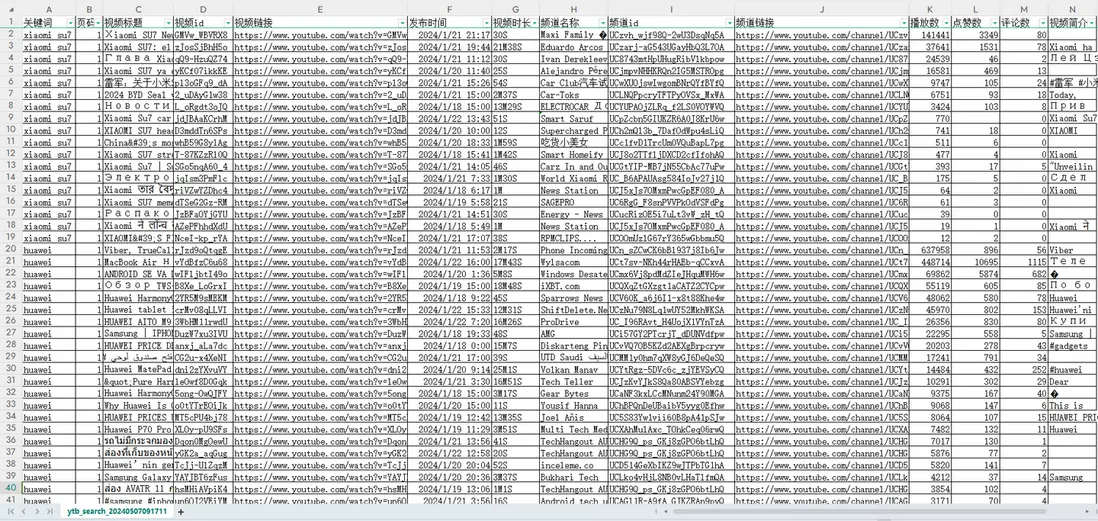

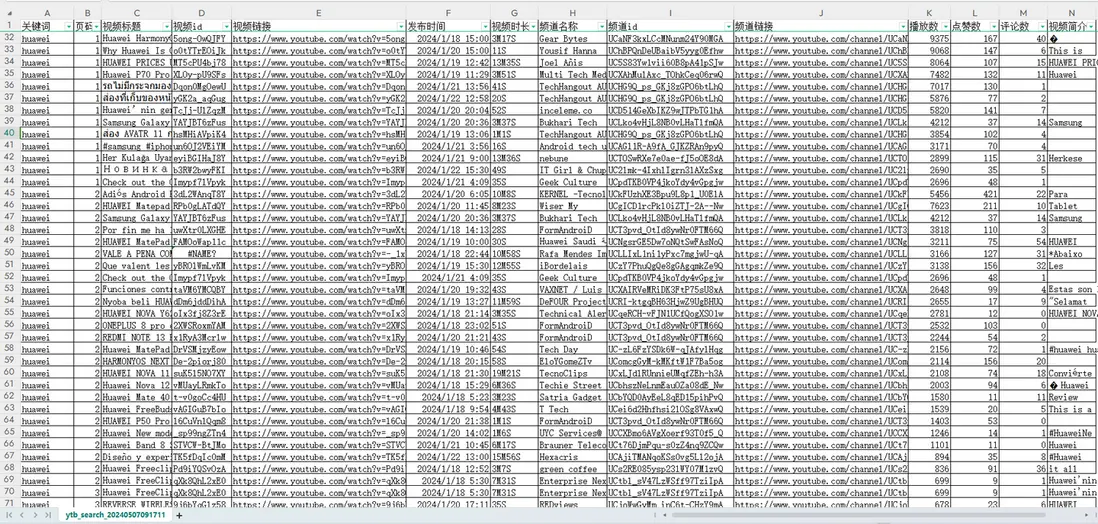

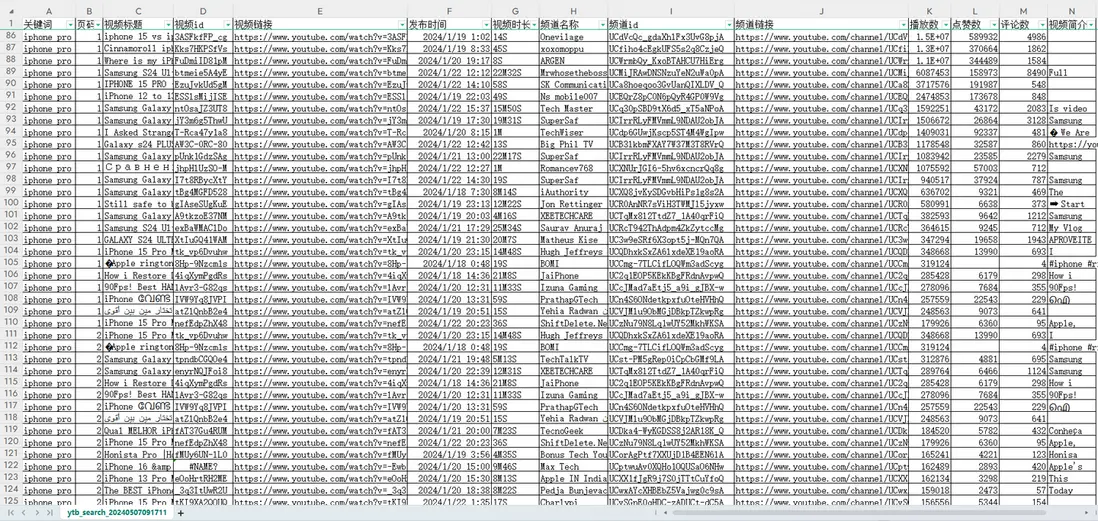

爬取結果截圖:

結果截圖1:

結果截圖2:

結果截圖3:

以上。

1.2 演示視頻

軟件使用演示:(不懂編程的小白直接看視頻,瞭解軟件作用即可,無需看代碼)

見文末。

1.3 軟件説明

幾點重要説明:

以上。

二、代碼講解

2.1 調用API-搜索接口

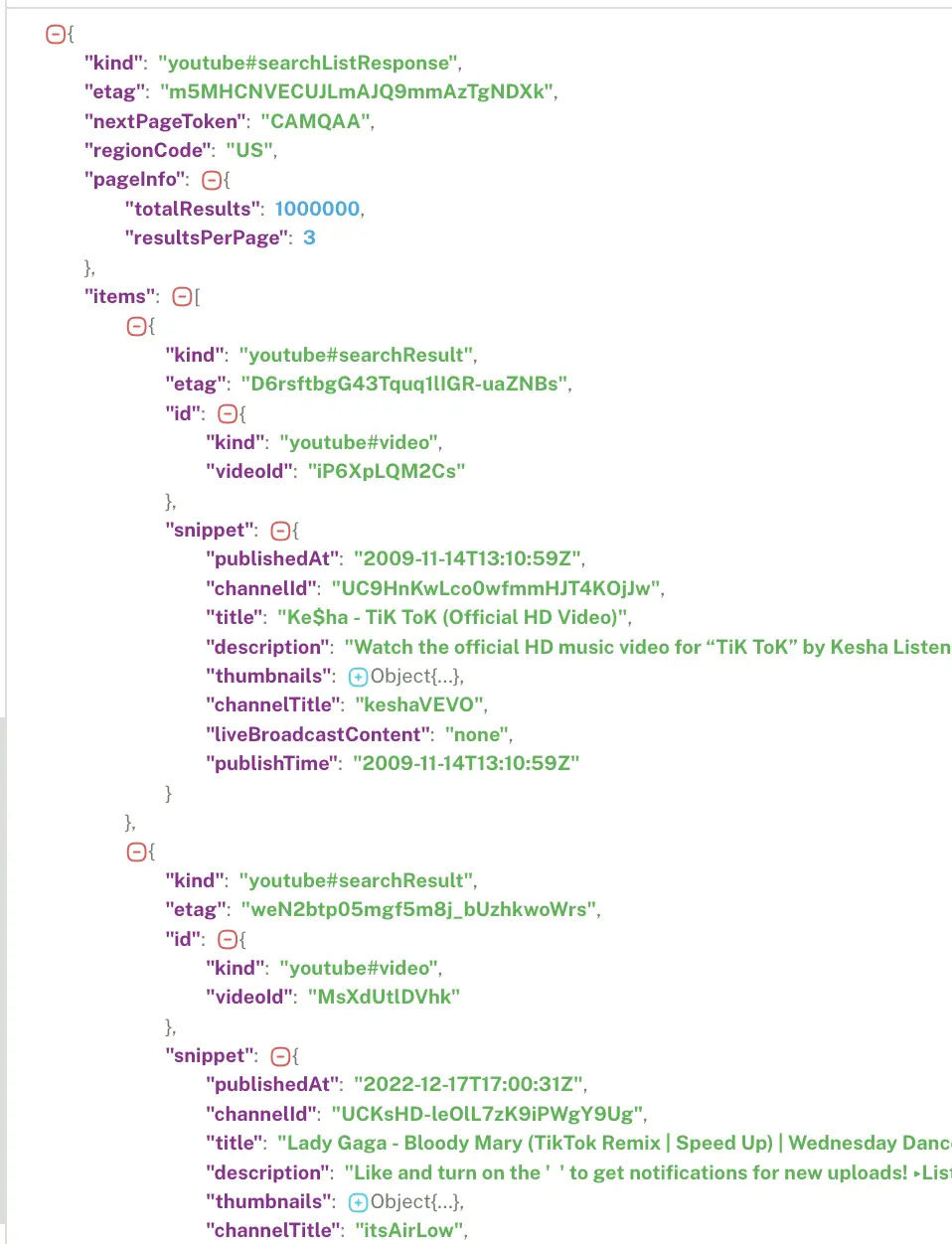

先給大家看看搜索接口的返回json數據:

首先,定義接口地址作為請求地址:

# 請求地址

url = 'https://youtube.googleapis.com/youtube/v3/search'定義一個請求頭,用於偽造瀏覽器:

# 請求頭

self.headers = {

"Accept": "*/*",

"User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

}加上請求參數,告訴程序你的爬取條件是什麼:

# 請求參數

params = {

'part': 'snippet',

'maxResults': '25',

'q': search_keyword,

'key': self.API_KEY,

'pageToken': pageToken,

'order': self.sort_by,

'publishedBefore': str(self.end_date) + 'T00:00:00Z',

'publishedAfter': str(self.start_date) + 'T00:00:00Z',

}2.2 調用API-詳情接口

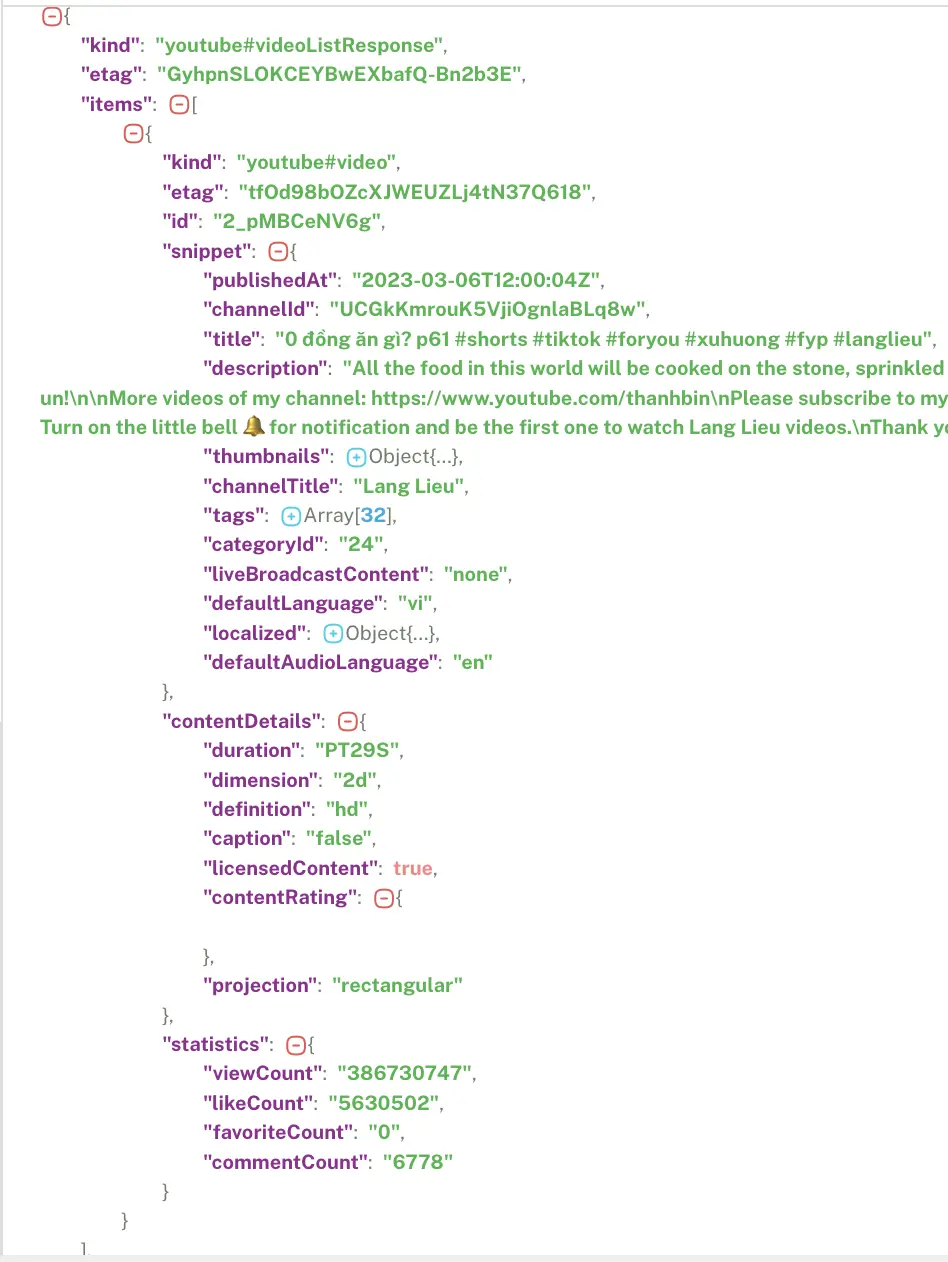

同樣,先給大家看看詳情接口的返回json數據:

首先,定義接口地址作為請求地址:

# 請求地址

url = 'https://youtube.googleapis.com/youtube/v3/videos?part=snippet%2CcontentDetails%2Cstatistics&id={}&key={}'.format(video_id, self.API_KEY)定義一個請求頭,用於偽造瀏覽器:

# 請求頭

self.headers = {

"Accept": "*/*",

"User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

}下面就是發送請求和接收數據:

# 發送請求

r = requests.post(url, headers=self.headers)

# 接收數據

json_data = r.json()逐個解析字段數據,以"播放數"為例:

# 播放數

try:

viewCount = json_data['items'][0]['statistics']['viewCount']

except:

viewCount = ''其他字段同理,不再贅述。

最後,是把數據保存到csv文件:

# 保存csv文件

with open(self.result_file, 'a+', encoding='utf_8_sig', newline='') as f:

writer = csv.writer(f)

writer.writerow(

[search_keyword, page, title, videoId, video_url, create_time, duration, channelTitle,

channelId, channel_url, viewCount, likeCount, commentCount, desc])

self.tk_show('csv保存成功:' + self.result_file)我採用csv庫保存結果,實現每爬一條存一次,防止中途異常停止丟失前面的數據。

完整代碼中,還含有:讀取API\_KEY判斷、循環結束條件判斷、拼接頻道URL、try異常保護、日誌記錄等關鍵實現邏輯。

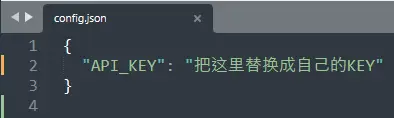

2.3 API\_KEY説明

API\_KEY是訪問YouTube官方接口的密鑰,只有拿到密鑰,並配置到代碼裏,才能正常調用API接口。

API開通的教程:【詳細教程】手把手教你開通YouTube官方API接口(youtube data api v3)

拿到密鑰之後,配置到當前文件的config.json裏面即可,如下:

另外,魔法是一切的前提,此處不便多説!

2.4 軟件界面模塊

主窗口部分:

# 創建主窗口

root = tk.Tk()

root.title('爬YouTube搜索軟件v1.0 | 馬哥python説')

# 設置窗口大小

root.minsize(width=850, height=650)

# 左上角圖標

root.iconbitmap('mage.ico')輸入控件部分:

# keyword

tk.Label(root, justify='left', text='搜索關鍵詞:').place(x=30, y=90)

entry_kw = tk.Text(root, bg='#ffffff', width=70, height=2, )

entry_kw.place(x=125, y=90, anchor='nw') # 擺放位置

tk.Label(root, justify='left', text='多關鍵詞以|分隔', fg='red', ).place(x=630, y=90)運行日誌部分:

# 運行日誌

tk.Label(root, justify='left', text='運行日誌:').place(x=30, y=280)

show_list_Frame = tk.Frame(width=780, height=260) # 創建<消息列表分區>

show_list_Frame.pack_propagate(0)

show_list_Frame.place(x=30, y=310, anchor='nw') # 擺放位置底部版權部分:

# 版權信息

copyright = tk.Label(root, text='@馬哥python説 All rights reserved.', font=('仿宋', 10), fg='grey')

copyright.place(x=290, y=625)以上。

2.5 日誌模塊

好的日誌功能,方便軟件運行出問題後快速定位原因,修復bug。

核心代碼:

def get_logger(self):

self.logger = logging.getLogger(__name__)

# 日誌格式

formatter = '[%(asctime)s-%(filename)s][%(funcName)s-%(lineno)d]--%(message)s'

# 日誌級別

self.logger.setLevel(logging.DEBUG)

# 控制枱日誌

sh = logging.StreamHandler()

log_formatter = logging.Formatter(formatter, datefmt='%Y-%m-%d %H:%M:%S')

# info日誌文件名

info_file_name = time.strftime("%Y-%m-%d") + '.log'

# 將其保存到特定目錄,ap方法就是尋找項目根目錄,該方法博主前期已經寫好。

case_dir = r'./logs/'

info_handler = TimedRotatingFileHandler(filename=case_dir + info_file_name,

when='MIDNIGHT',

interval=1,

backupCount=7,

encoding='utf-8')日誌文件截圖:

以上。

三、演示視頻

軟件演示:

不懂編程的小白直接看視頻,瞭解軟件作用即可,無需看代碼!!

【軟件演示】youtube採集工具,根據關鍵詞爬搜索結果

四、原創聲明

軟件【爬油管搜索視頻軟件】首發於眾公號"老男孩的平凡之路",歡迎交流!!

我是@馬哥python説,一名10年程序猿,持續分享Python乾貨中!