經驗之談:實踐表明,近80%的大模型微調失敗案例,根源都可追溯至數據集問題。

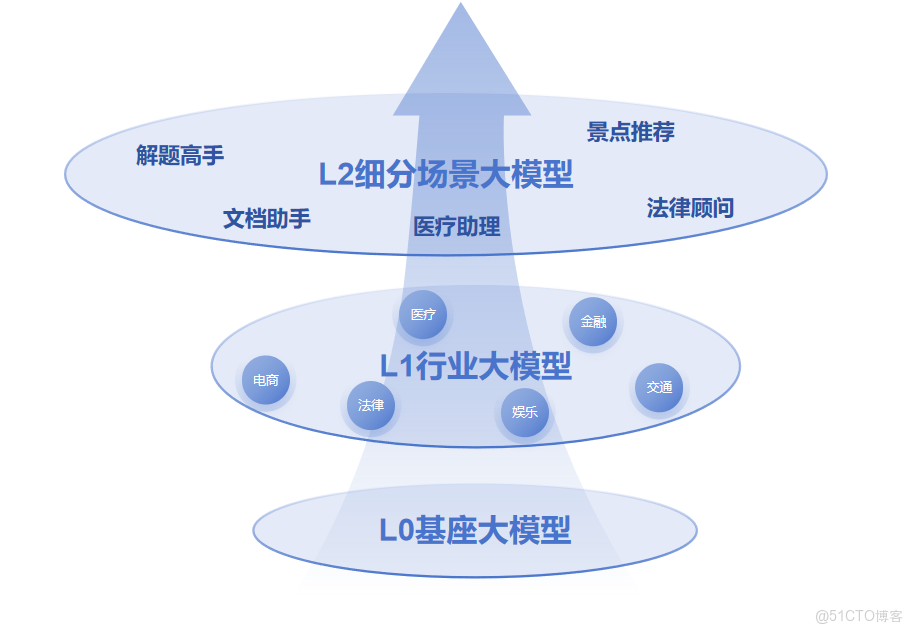

2024年堪稱“行業大模型元年”,金融、醫療、教育等各行各業都在積極佈局專屬AI助手。然而,許多企業在投入重金進行模型微調後,卻常常面臨“模型表現不及預期”的困境。

實踐中常見的三大困境:

● 災難性遺忘:模型在學習了新的專業知識後,原有的通用對話與理解能力顯著衰退。

● 泛化能力弱:在精心準備的測試集上表現亮眼,一旦投入真實複雜的業務場景,便錯誤百出。

● 數據 ROI 低:投入大量成本標註的數據,模型甚至無法正確處理最基礎的領域問題。

破局關鍵在於構建高質量的數據集。通過深度參與數十個大模型落地項目,我們總結出一個關鍵結論:優質的數據集是微調成功的首要決定因素,其重要性甚至超越了算法選擇。 在LLaMA-Factory Online的實踐中我們發現,一個精心構建的數據集,不僅能確保模型高效吸收領域知識,還能有效保留其通用能力,實現真正的“知識增強”,而非“知識替換”。

本文將系統性地拆解高質量數據集的完整構建流程,從核心理念到實操細節,為您提供一套可即刻落地的解決方案,幫助您的項目繞開常見陷阱,讓大模型切實產生業務價值。

一、 根本性轉變:從“算法崇拜”到“數據優先”

1、 為什麼數據比算法更重要?

在當前大模型技術快速發展的背景下,各主流框架的算法差異正在逐漸縮小,數據質量的重要性日益凸顯。我們必須認識到三個關鍵事實:

● 數據定義性能天花板:再精妙的算法,也無法從低質、有偏的數據中提煉出穩健的知識模式。

● 數據是知識的載體:每一個數據樣本,都封裝了獨特的業務邏輯與實踐經驗,這是賦予模型專業能力的“靈魂”所在。

● 數據構成核心壁壘:在開源模型性能趨同的當下,企業獨有的、高質量的領域數據,成為了難以複製的差異化競爭優勢。

2、 微調項目的資源分配真相

根據我們的項目實踐經驗,成功的微調項目在資源分配上呈現出明確傾向:

● 數據相關工作(佔比60%):涵蓋數據收集、清洗、標註、驗證等核心環節。

● 算法調優(佔比25%):涉及超參數調整、訓練策略優化等。

● 工程部署(佔比15%):包括模型服務化、性能優化等。

這一分配比例充分説明,數據工作是微調項目中需要投入最核心資源與精力的環節,這也是確保模型效果的基礎保障。

二、 善用現有生態:高效利用數據基礎設施

構建數據集不意味着一切從零開始。在啓動前,充分調研並利用現有數據平台,能讓我們事半功倍,將寶貴資源聚焦於提升數據質量本身。

1、 國際主流數據平台

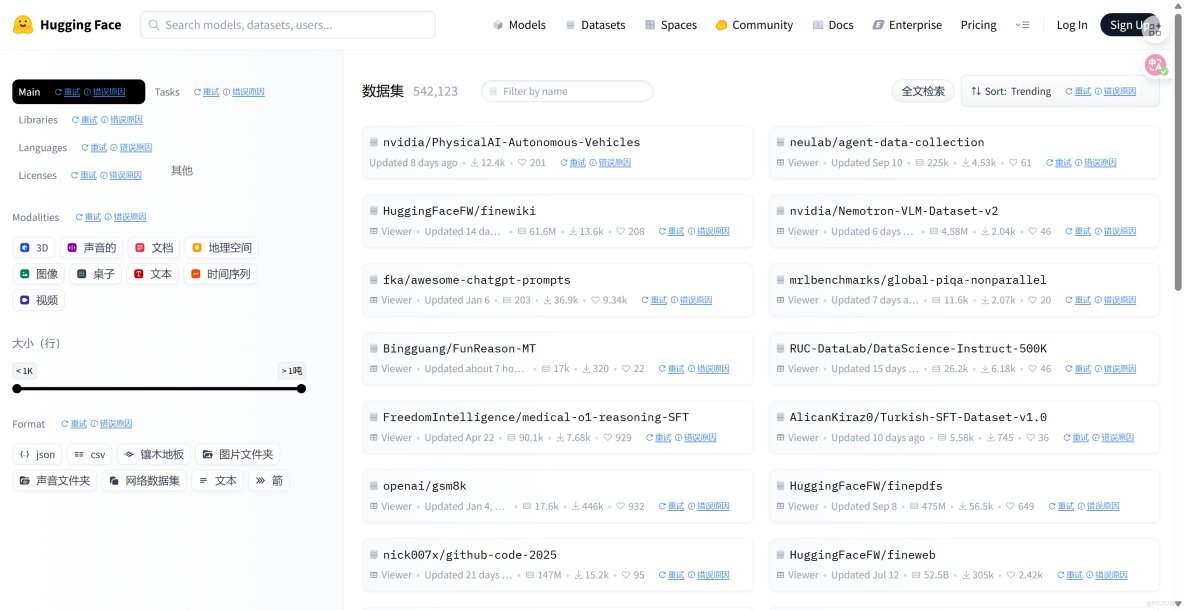

Hugging Face Datasets:NLP領域的“資源寶庫”

作為自然語言處理領域的事實標準,Hugging Face Datasets提供了真正意義上的“一站式”服務。其核心價值不僅在於匯聚了數千個多模態數據集,更在於其統一的API與基於內存映射的高效架構,讓研究人員能像處理本地文件一樣,輕鬆應對數十GB規模的數據集,極大降低了預處理複雜度。

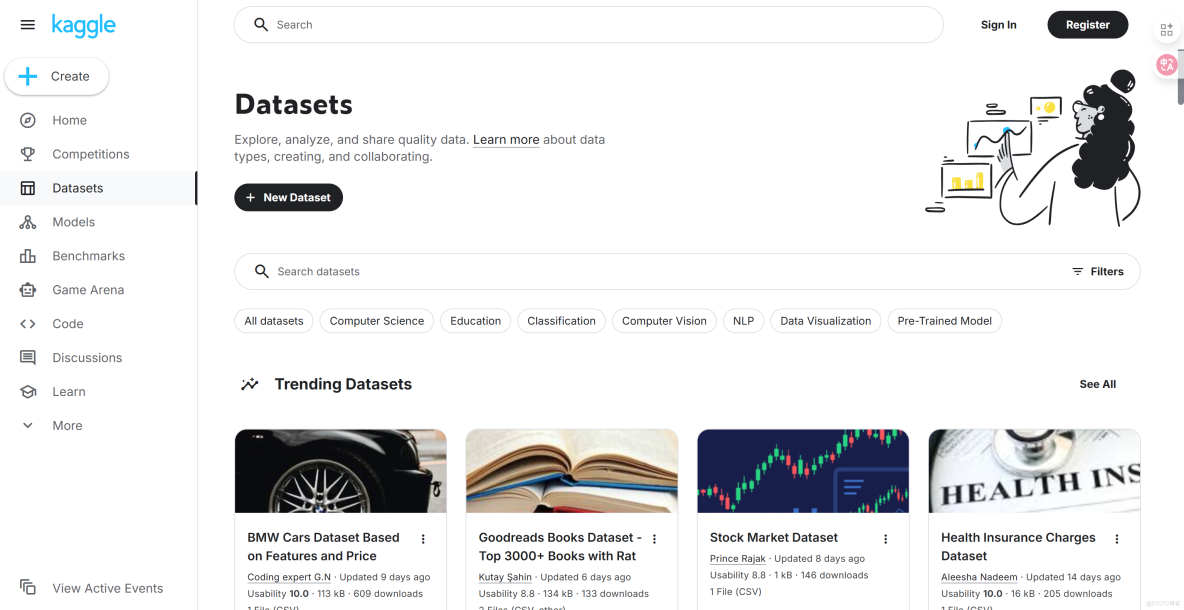

Kaggle Datasets:真實業務的"實踐平台"

Kaggle平台的獨特價值在於其強烈的實踐導向。這裏的數據集大多源於真實的商業競賽問題,每個數據集都伴隨着豐富的數據分析案例和活躍的社區討論。對於從業者而言,這不僅是獲取數據的渠道,更是學習如何將具體業務問題轉化為數據問題的絕佳平台。通過研究這些案例,能夠快速提升數據思維和業務理解能力。

2、 中文特色數據平台

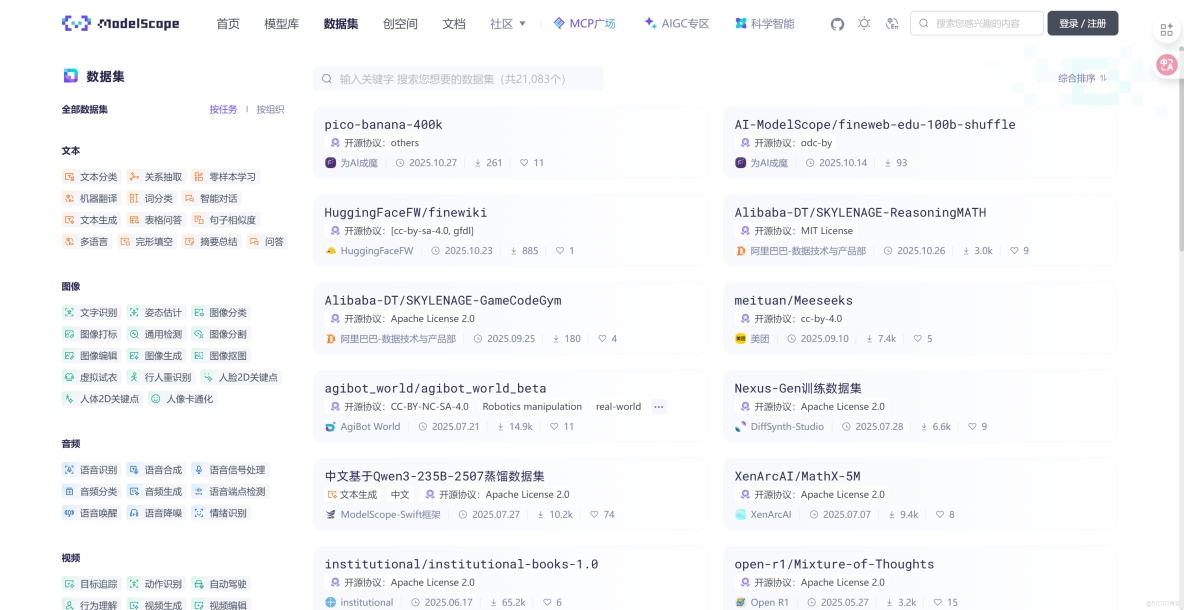

ModelScope:中文領域的“國家隊”

作為阿里巴巴推動的中文數據社區,ModelScope在理解中文語言特性方面具有獨特優勢。該平台彙集了大量貼閤中文語境和國內商業實踐的數據集,特別是在金融、法律、醫療等垂直領域,提供了國際平台難以替代的本地化資源。對於處理中文業務場景的團隊來説,這是不可或缺的重要補充。

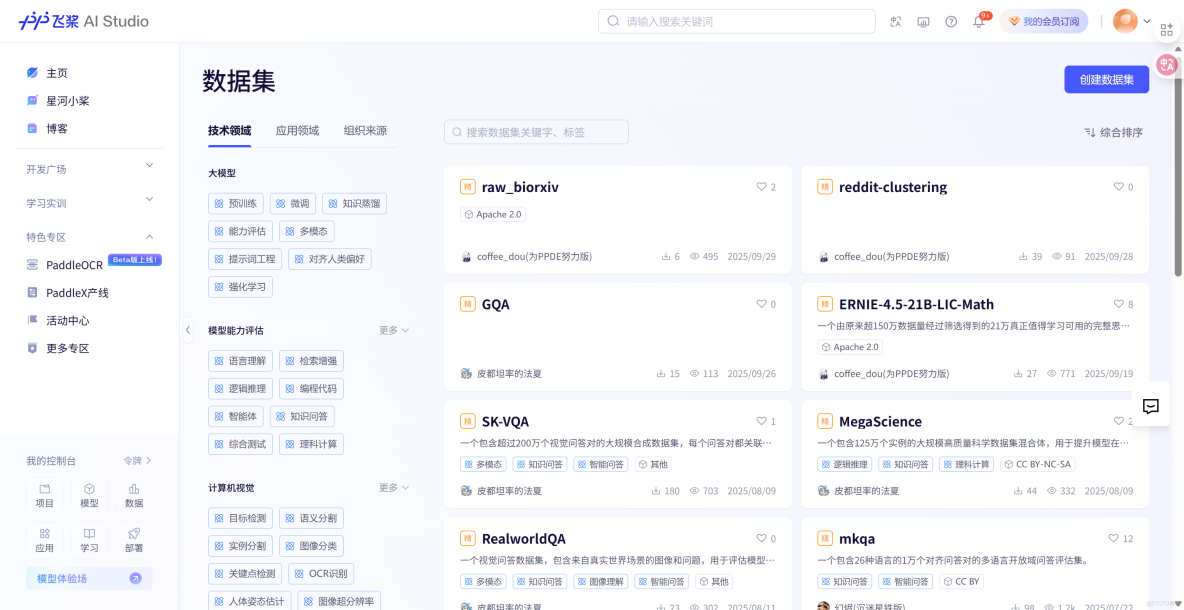

百度飛槳:產業落地的"助推器"

百度飛槳平台為中文自然語言處理提供了完善的產業級解決方案。該平台不僅提供了豐富的中文數據集資源,更重要的是建立了一套經過產業實踐驗證的模型開發和評估體系。無論是進行中文模型的訓練調優,還是驗證算法在實際業務場景中的有效性,它都能提供可靠的工程化支持,幫助團隊將技術成果快速轉化為業務價值。

三、 核心方法論:從0到1打造高質量數據集

數據集的構建不應是一次性的臨時任務,而應被視為一個可迭代、可驗證的工程化流水線。一個完整的數據工程流程包含以下四個關鍵階段:

1、 目標定義:確保業務技術對齊

目標定義階段是數據工程的藍圖規劃階段。團隊必須在此明確回答幾個核心問題:模型具體需要獲得哪些能力?如何量化微調的成功?需要什麼類型、多大規模的數據?數據格式需兼容哪些訓練框架?

此階段的核心產出是一份清晰的數據需求規格説明書。實踐經驗反覆證明,與業務方共同確認並量化成功標準至關重要。我們曾見證過因技術團隊認為90%準確率已屬優秀,而業務方期望是95%所導致的項目驗收困境。

2、 數據收集:多源融合與質量預審

我們推薦採用**"真實數據+合成數據"**的雙軌收集策略,確保數據的多樣性和覆蓋面。具體而言,可以從內部業務系統、公開數據集,以及通過大模型生成等多個渠道彙集原始數據。

● 內部數據:從企業內部的數據庫、系統日誌、歷史記錄中提取(需嚴格脱敏)。

● 外部數據:利用公開數據集、合規的網絡爬蟲與AI抽取技術獲取。

● 數據生成:通過大模型模擬、規則模板等方式生成,用於低成本補充長尾場景。

在此過程中,務必堅守 “垃圾進,垃圾出” 的基本原則。我們強烈建議實施 “百條樣本人工審查”機制:隨機抽取100條數據,以“偵探”般的眼光審視其質量、潛在偏見和代表性。這一簡單步驟常能提前發現系統性風險,避免後續大規模返工。

3、 數據清洗:構建工業化處理流程

這是最耗時,卻也最至關重要的質量管控環節。一個完整的清洗流程應標準化,包括去重、隱私脱敏、文本規範化、質量過濾等步驟。

從工程角度看,投資構建一個設計良好的數據清洗流水線回報率極高。一個常見的錯誤是使用臨時、粗糙的腳本來處理核心數據資產。正確的做法是將清洗流程構建為獨立的、可迭代的數據服務。

● 初步清洗:依託傳統大數據平台(如 Hive, Spark, Flink),剔除明顯錯誤和異常值。

● 智能修復:藉助AI技術,對數據中的錯別字、語法錯誤、邏輯矛盾進行修復,並結合標準數據集進行校準。

● 人工終審:通過隨機抽樣,對前序處理結果進行最終審核,確保數據的完整性與可靠性。

4、 數據增強:針對性提升數據多樣性(可選)

數據增強是提升數據集多樣性和模型魯棒性的有效手段,但需根據具體任務謹慎選用。

圖像數據增強可採用旋轉、裁剪、調整亮度對比度、添加噪聲等方法。

{

"image_augmentation_techniques": {

"rotation": {

"description": "圖像旋轉增強",

"parameters": {

"angle_range": [-30, 30],

"probability": 0.5

}

},

"cropping": {

"description": "隨機裁剪增強",

"parameters": {

"width": 400,

"height": 400,

"probability": 0.3

}

}

}

}文本數據增強可採用同義詞替換、回譯(如:中->英->中)等方法。

{

"text_augmentation_techniques": {

"synonym_replacement": {

"description": "同義詞替換增強",

"parameters": {

"replacement_probability": 0.1,

"max_replacements": 3

}

},

"back_translation": {

"description": "回譯增強",

"parameters": {

"intermediate_languages": ["en", "ja", "ko"],

"iterations": 2

}

}

}

}💡為什麼添加噪聲? 其主要目的是增強模型的魯棒性,具體包括:

● 模擬真實環境:讓模型適應實際應用中的各種噪聲干擾。

● 防止過擬合:作為一種正則化手段,避免模型過度依賴訓練集中的特定特徵。

● 增加數據多樣性:幫助模型學習更廣泛的特徵表示。

💡判斷是否需要增強?

● 無需增強:當原始數據已足夠豐富、高質量,且能很好覆蓋任務需求時;或模型過擬合風險較低時。

● 建議增強:當模型過擬合跡象明顯(訓練集表現遠好於驗證/測試集),或特定任務(如圖像生成、語音識別)需要模型學習更復雜模式時。

5、 版本管理:構建企業數據資產體系

應為每個正式發佈的數據集賦予唯一版本號,並生成詳盡的 “數據護照” ,完整記錄其來源、處理歷程、統計信息和已知限制。這使得數據集的任何變更都可追溯,當模型性能波動時,能快速定位問題是源於代碼還是數據。

數據集的版本控制應與代碼版本管理享有同等重要的地位。團隊必須能清晰回答:“V3模型效果下降,究竟是代碼改動所致,還是因為使用了V2.1數據集?” 這種能力對持續優化至關重要。

四、 實戰案例:構建智能客服對話數據集

理論結合實踐,我們將通過一個具體場景——為電商企業構建用於微調7B模型的客服對話數據集,來演示完整構建流程。

1、 目標確立與需求分析

在項目啓動階段,我們明確了三個層面的目標要求:

● 業務層面:模型需處理超80%的日常重複性問答,覆蓋訂單、退換貨、商品諮詢等場景。

● 技術層面:構建10,000條高質量對話,格式對齊ChatML標準,兼容主流微調框架。

● 質量層面:在新數據上的意圖識別準確率需>92%。

2、 多源數據收集策略

我們採用**"真實數據+合成數據"**的雙軌收集策略,確保數據的豐富性和覆蓋面。具體實施分為三個步驟:

● 業務層面:模型需處理超80%的日常重複性問答,覆蓋訂單、退換貨、商品諮詢等場景。

● 技術層面:構建10,000條高質量對話,格式對齊ChatML標準,兼容主流微調框架。

● 質量層面:在新數據上的意圖識別準確率需>92%。

{

"data_collection_pipeline": {

"phase_1_internal_data": {

"description": "加載內部脱敏數據",

"source": "internal_chat_logs.json",

"processing_steps": ["anonymization", "format_conversion"],

"expected_volume": 6000

},

"phase_2_synthetic_data": {

"description": "利用大模型生成模擬對話",

"expected_volume": 3000

},

"phase_3_external_data": {

"description": "從開源數據集篩選相關對話",

"expected_volume": 1000

},

"post_processing": {

"critical_step": "合併並基於語義進行去重"

}

}

}3、 數據標註與模板化增強

在數據標註階段,我們採用人工審核與AI輔助相結合的方式。首先基於真實對話記錄構建基礎的問答對,然後利用大語言模型對問答內容進行增強和優化。特別是在處理複雜業務場景時,通過設計專業的提示詞,引導模型生成包含詳細推理過程的思維鏈,提升數據的深度和質量。

對於客服場景中的典型問題,如訂單狀態查詢、退換貨政策等,我們通過模板化方式批量生成訓練數據,同時確保每個問答對都包含完整的業務邏輯和專業的服務話術。

{

"customer_service_templates": {

"order_status_inquiry": {

"user_query_template": "訂單{order_id}到哪裏了?",

"system_response_components": {

"greeting": "先生/女士您好,",

"information_retrieval": "查詢到您的訂單{order_id}目前狀態為{status},",

"next_steps": "預計{delivery_time}送達,請您保持手機暢通。"

}

}

}

}4、 數據清洗與質量管控

這個階段是確保數據質量的關鍵環節。我們構建了自動化的清洗流水線,依次執行敏感信息剔除、文本拼寫糾正與格式化、基於規則的質量過濾等操作。一個特別重要的步驟是引入人工抽樣審計機制——隨機抽取1%的清洗結果進行人工複核,這種雙重檢驗機制能夠有效確保自動化流程的可靠性。

{

"data_cleaning_pipeline_implementation": {

"processing_sequence": [

{

"step_name": "remove_pii",

"description": "移除個人信息"

},

{

"step_name": "normalize_text",

"description": "文本標準化"

},

{

"step_name": "filter_by_quality_rules",

"description": "應用質量規則"

}

],

"quality_assurance": {

"manual_audit_config": {

"sample_ratio": 0.01,

"acceptance_threshold": 0.95

}

}

}

}5、 標準化格式化輸出

最終,我們將清洗後的數據轉換為模型能夠有效學習的指令-回答對格式。同時,生成詳細的數據集説明文檔,完整記錄數據規模、字段含義、構建日期等元數據信息,完成數據資產的標準化封裝。

{

"standardized_dataset_output": {

"format_version": "1.0",

"data_samples": [

{

"instruction": "請以專業客服的身份,回覆用户關於訂單進度的詢問。",

"input": "我的訂單號是ORD-12345,現在到哪裏了?",

"output": "先生/女士您好,查詢到您的訂單ORD-12345目前已出庫,正在運輸中,預計明天下午送達,請您耐心等待並保持手機暢通。",

"metadata": {

"domain": "order_status",

"complexity": "simple"

}

}

],

"dataset_metadata": {

"name": "ecommerce_customer_service_v1",

"version": "1.0.0",

"total_samples": 10000,

"description": "電商領域智能客服對話訓練數據集"

}

}

}五、 實用工具推薦

基於項目經驗,我們提煉出兩個核心工具以提升效率:

● 數據集健康度檢查腳本:能夠快速評估數據集的潛在風險:

python data_health_check.py --dataset your_dataset.json● 格式統一化腳本:支持多種原始格式到標準格式的轉換:

python format_converter.py --input raw_data.csv --format alpaca這些工具在實際項目中顯著提升了數據處理效率,為構建高質量數據集提供了有力支持。

結語:構築於高質量數據之上的AI未來

在大模型技術迅猛發展的今天,我們必須清醒地認識到:高質量的數據已成為釋放AI價值的核心瓶頸。 一個精心構建的數據集,其實際價值往往遠超一個倉促訓練出的龐大模型。

數據集構建是一門融合了業務洞察、數據科學與工程實踐的綜合性藝術。它既需要宏觀的架構思維來設計穩健的數據流水線,又需要微觀的工匠精神來打磨每一條數據的質量。這正是為什麼在LLaMA-Factory Online的實踐中,我們始終將數據質量視為微調成功的第一性原則。優秀的數據集能夠將寶貴的業務邏輯與領域知識有效沉澱,為通用大模型注入專業的“行業靈魂”。這正是實現AI從“通用”走向“專用”,從“玩具”變為“工具”的核心所在。

希望本文提供的系統化框架,能助您在接下來的微調項目中打下堅實的數據根基,讓技術創新真正轉化為驅動業務增長的強大動力。

PS.如何學習AI大模型?

作為一名深耕大模型微調領域多年的技術架構師,我深知“紙上得來終覺淺”。在見證了上百個微調項目的成功與失敗後,我深刻認識到,擁有一個清晰的學習路徑和經過驗證的實戰資源是多麼關鍵。

為此,我特意整理了全套《大模型微調實戰進階寶典》,這份資料凝聚了我多年的實戰經驗,其中包含:

● 《大模型微調實戰避坑指南》:精選20+真實項目經驗,解析訓練發散、災難性遺忘等高頻難題

● 《十大前沿行業微調白皮書》:彙集金融、醫療、汽車、法律、保險等眾多領域大模型先鋒案例

● 《開箱即用微調數據集精選》:涵蓋指令微調、對話、專業領域問答與代碼生成等多個實戰場景

願你能用它,快速撬動大模型在你業務中的巨大價值!