•

</dependency•

•

<dependency>

•

<groupId>mysql</groupId>

•

<artifactId>mysql-connector-java</artifactId>

•

<version>5.1.38</version>

•

</dependency>

•

•

<dependency>

•

<groupId>org.apache.spark</groupId>

•

<artifactId>spark-hive_2.11</artifactId>

•

<version>${spark.version}</version>

•

</dependency>

•

</dependencies>

•

</project>- hive-site.xml的配置如下:

演示代碼:

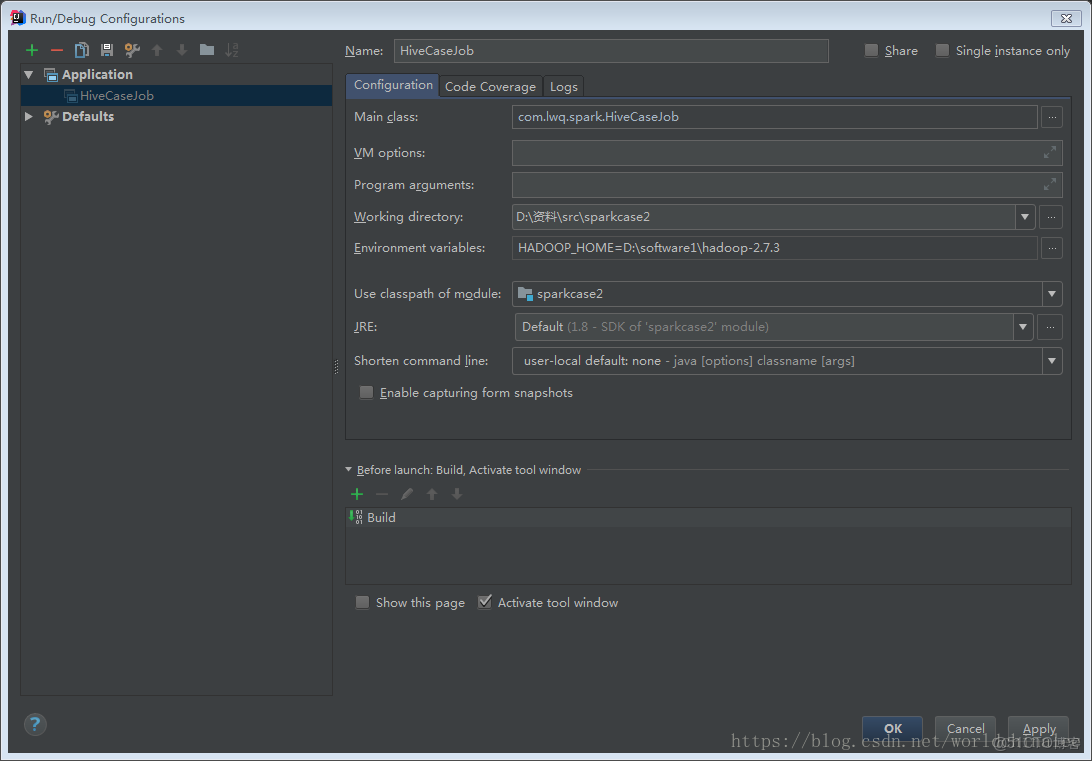

配置運行參數:

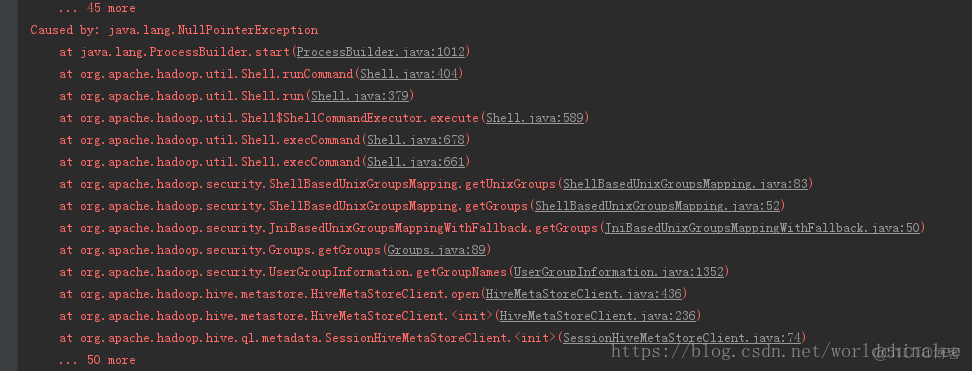

運行過程中可能的報錯:

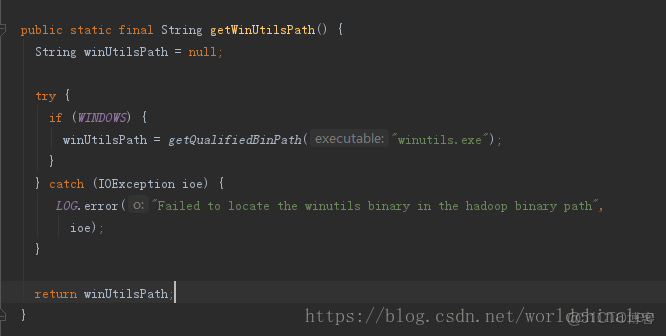

這是HADOOP_HOME變量和winutils.exe的原因,查看變量是否配好,winutils是否放在正確目錄。

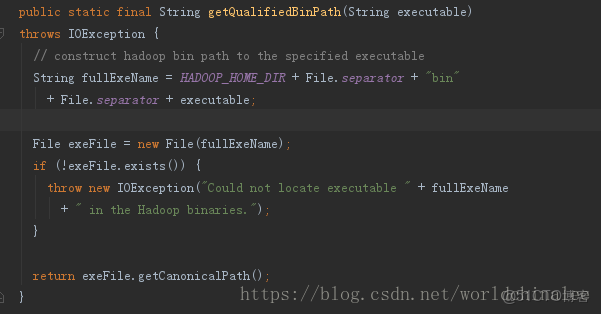

因為是在windows環境,在運行的時候會模擬linux,需要winutils.exe,winutils.exe的路徑代碼中默認是從hadoop的安裝路徑的bin目錄下。所以還需要上面的HADOOP_HOME變量。

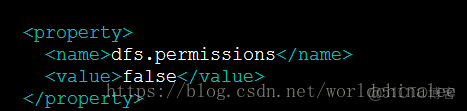

還有一個錯誤就是提示權限不足的,因為在windows下是通過windows的用户來訪問的,可以關閉hdfs的權限檢查

如下:

本文章為轉載內容,我們尊重原作者對文章享有的著作權。如有內容錯誤或侵權問題,歡迎原作者聯繫我們進行內容更正或刪除文章。