很多互聯網的業務研發或者基礎架構團隊的同學,包括前後端,其實都遇到了 35 歲的門檻,競爭力如何再次得到提升。

開篇我們先講講最近做數字人相關的知識。説到數字人,其實核心還是 wav2lib。很多沒有做過這方面的研發同學都對這個詞很陌生。

沒關係,這裏我們來普及一下。

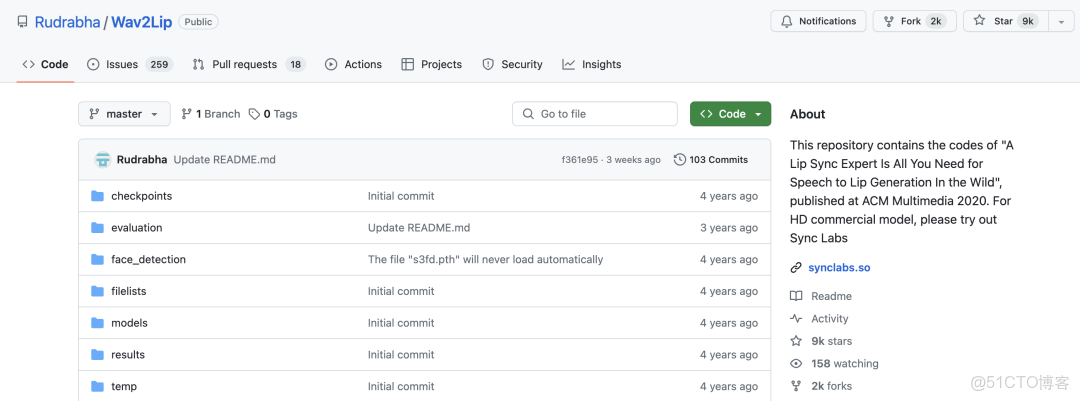

懂一點的可以看看這個項目:

https://github.com/Rudrabha/Wav2Lip

This repository contains the codes of “A Lip Sync Expert Is All You Need for Speech to Lip Generation In the Wild”, published at ACM Multimedia 2020. For HD commercial model, please try out Sync Labs

對,這種大部分都是 python,所以如果你轉型 AI,建議學習下 python 的基礎語法。

然後回順着有這個網站:

https://synclabs.so/

an app for realtime lip-sync` `animate people to` `speak any language in any videowav2lip 引入了一個在真實視頻中預訓練的專家口型同步判別器,且包含多幀信息,用於判斷音頻和口型是否同步。

相較於基於像素的人臉重建方法,專家判別器在口型同步判別任務上更精準。而且在訓練階段,專家判別器保持凍結狀態下,可以保證判斷結果不受偽影的干擾。

wav2lip模型的訓練分為兩個階段:

1、專家音頻和口型同步判別器預訓練

2、GAN網絡訓練。

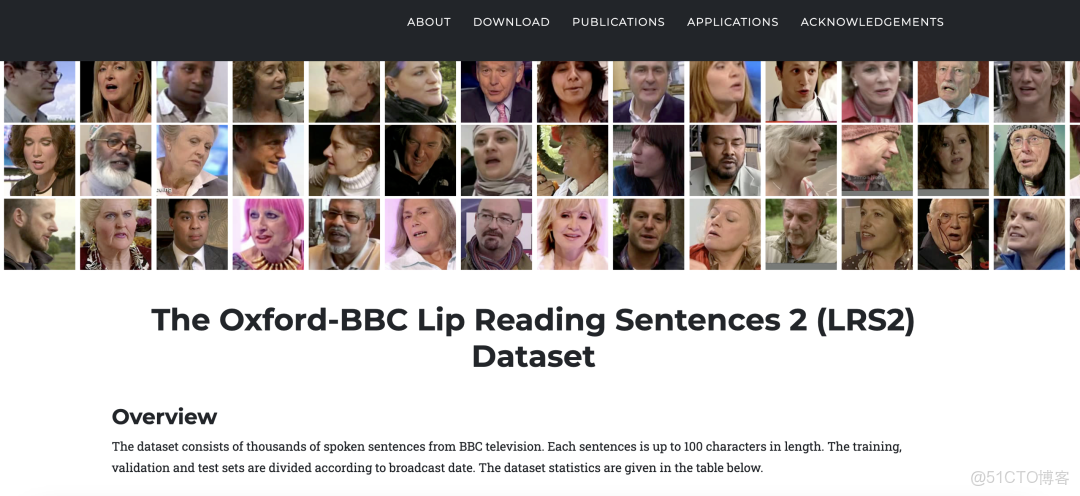

訓練也需要一個數據集,比如:

https://www.robots.ox.ac.uk/~vgg/data/lip_reading/lrs2.html

這是一個 BBC的唇語視頻。

The dataset consists of thousands of spoken sentences from BBC television. Each sentences is up to 100 characters in length. The training, validation and test sets are divided according to broadcast date. The dataset statistics are given in the table below.

這裏有提到一個關鍵字 lip-sync:

Lip-sync 是嘴唇同步的縮寫,是一種使人造圖像或視頻中的人物嘴唇動作與音頻(通常是人聲或對話)同步的技術。

這一技術廣泛應用於電影製作、遊戲開發以及實時視頻通信等領域。為了實現lip-sync,AI算法分析輸入的音頻信號,並生成與音頻中的音素相匹配的嘴唇運動,使人物的嘴唇動作看起來自然和準確。

在AI領域有幾個知名的開源項目可用於lip-sync任務:

1. Wav2Lip: Wav2Lip是一個深度學習模型,用於將任意説話人的嘴唇運動與任意音頻同步。該項目在GitHub上提供,並且以其高質量的同步和靈活的應用而著稱。

2. DeepSync: 類似於Wav2Lip,DeepSync是一個研究項目,旨在探索和改進視頻中嘴唇同步的質量。

3. AVSpeech: 雖然不是專門用於lip-sync,但AVSpeech是一個大型的視聽數據集,可用於培訓與lip-sync相關的AI模型。該數據集含有配有清晰音軌的YouTube視頻片段,可用於構建和測試lip-sync模型。

4. Adobe Project VoCo: 雖然不是完全開源的,但Adobe的Project VoCo就是一個知名的音頻編輯工具,可以用來修改説話人的音頻錄音。該技術可以與lip-sync技術配合使用,為特定的嘴唇運動創建匹配的音頻。

5. LipGAN: LipGAN (Lip Generative Adversarial Network) 是另一個用於口型合成的工具,能夠根據給定的音頻信號生成逼真的嘴唇動畫。

也是一種計算機視覺和機器學習算法,專門用於生成和同步唇部運動。

這種技術通常用於視頻中讓人的嘴唇動作與新的語音信號同步,例如在配音應用、視頻會議中改善音視頻同步,或者是為了語言教學等目的。LipGAN結合了生成對抗網絡(GANs)的概念,這種深度學習模型包括一個生成器和一個判別器,它們相互競爭:生成器試圖創建儘可能真實的數據(在這個情況下是唇部運動),而判別器則嘗試區分真實數據和生成器創建的數據。通過這種方式,LipGAN不斷改進,以生成更加精準的唇形來匹配給定的語音信號。

這些項目通常依賴於深度學習、計算機視覺和音頻處理技術。很多情況下,項目會使用如:

卷積神經網絡(CNN)、遞歸神經網絡(RNN)或生成對抗網絡(GAN)等先進的深度學習架構來訓練模型以對嘴唇動作進行準確預測。

使用這些模型可以創建出逼真的lip-sync效果,甚至在低分辨率視頻或在有背景噪聲的環境中也能保持較高的同步精度。