見字如面,我是王中陽,祝大家升職加薪,早日上岸。

我週末突發奇想,讓AI總結了我們做的GoFrame分佈式微服務電商項目(https://mp.weixin.qq.com/s/ACzEHtvGh2YsU_4fxo83fQ),做的哪裏好?哪裏不好,有哪些優化的空間。

他是這麼説的:

AI回覆:我需要幫你總結項目中關於分佈式微服務和高併發的優秀實踐。讓我先查看項目的主要架構和配置,然後分析其中的亮點。 現在讓我查看項目的整體架構配置和微服務相關的重要文件: 現在讓我查看項目的服務發現配置和微服務通信機制: 基於我對項目的深入分析,我來為你總結項目中關於分佈式微服務和高併發的優秀實踐:

🏗️ 項目架構亮點總結

✅ 1.完善的微服務架構設計

服務拆分合理

- 業務邊界清晰:用户、商品、訂單、交互、搜索等核心業務獨立服務化

- 網關分層設計:H5端、管理端、資源端三套網關,職責分離明確

- 服務粒度適中:每個服務專注單一業務領域,避免服務過重

技術架構:

// 所有服務統一使用etcd服務發現

grpcx.Resolver.Register(etcd.New(address))✅ 2.專業的服務發現與註冊機制

etcd集成完善

- 統一配置:所有服務統一從etcd獲取服務地址

- 健康檢查:服務自動註冊與發現,支持故障轉移

- 負載均衡:內置客户端負載均衡機制

實現亮點:

# 統一的服務發現配置

etcd:

address: "etcd:2379"✅ 3.消息隊列異步處理架構

RabbitMQ深度集成

- 延遲消息支持:集成延遲插件,支持定時任務

- 訂單超時處理:利用死信隊列實現訂單自動取消

- 異步解耦:服務間通過消息隊列異步通信

技術實現:

// 訂單創建後發送延遲消息

delay := rabbitmq.GetOrderTimeoutDelay(ctx)

go grabbitmq.PublishOrderTimeoutEvent(int(orderId), delay)✅ 4.緩存策略基礎框架

Redis緩存體系

- 連接池管理:統一的Redis連接池配置

- 緩存防穿透:空值緩存機制防止惡意請求

- 緩存分層:商品詳情、分類數據等不同緩存策略

緩存實現:

// 商品詳情緩存,帶空值防護

func SetEmptyGoodsDetail(ctx context.Context, productId uint32) error {

return goodsCache.Set(ctx, key, EmptyValue, 1*time.Minute)

}✅ 5.搜索服務專業化

Elasticsearch集成

- 中文分詞:集成IK分詞器,支持中文搜索

- 數據同步:與MySQL數據保持同步

- 集羣部署:支持單節點和集羣部署模式

✅ 6.容器化部署與編排

Docker Compose完整方案

- 服務依賴管理:明確的服務啓動順序和依賴關係

- 健康檢查:所有關鍵服務都有健康檢查機制

- 數據持久化:MySQL、Redis、ES等數據持久化配置

部署優勢:

# 完整的服務編排

depends_on:

-etcd

-mysql

-redis

-rabbitmq

healthcheck:

test:["CMD","mysqladmin","ping","-h","localhost"]✅ 7.配置管理專業化

環境隔離配置

- 多環境支持:開發、測試、生產環境配置分離

- 配置中心:通過etcd實現配置集中管理

- 熱更新支持:配置變更無需重啓服務

✅ 8.日誌與監控基礎

統一日誌管理

- 日誌分級:支持不同級別的日誌輸出

- 日誌聚合:所有服務日誌統一目錄管理

- 錯誤追蹤:完善的錯誤處理機制

🚀 高併發優化亮點

✅ 1.數據庫連接池優化

- 連接複用:MySQL連接池配置,避免頻繁創建連接

- 連接管理:自動連接健康檢查和重連機制

✅ 2.異步處理架構

- 消息隊列解耦:耗時操作異步化,提升響應速度

- 批量處理:支持批量操作,減少網絡開銷

✅ 3.服務間通信優化

- gRPC高性能:使用gRPC進行服務間通信,性能優於HTTP

- 協議緩衝:使用Protocol Buffers,傳輸效率高

📊 架構設計優秀實踐

1.分層架構清晰

網關層 → 業務服務層 → 數據訪問層 → 基礎設施層2.技術選型合理

- GoFrame框架:企業級Go框架,功能完善

- etcd:成熟的分佈式協調服務

- RabbitMQ:功能豐富的消息隊列

- Elasticsearch:專業的搜索引擎

3.部署運維友好

- 容器化部署:一鍵啓動所有服務

- 服務監控:內置健康檢查機制

- 日誌管理:統一的日誌收集方案

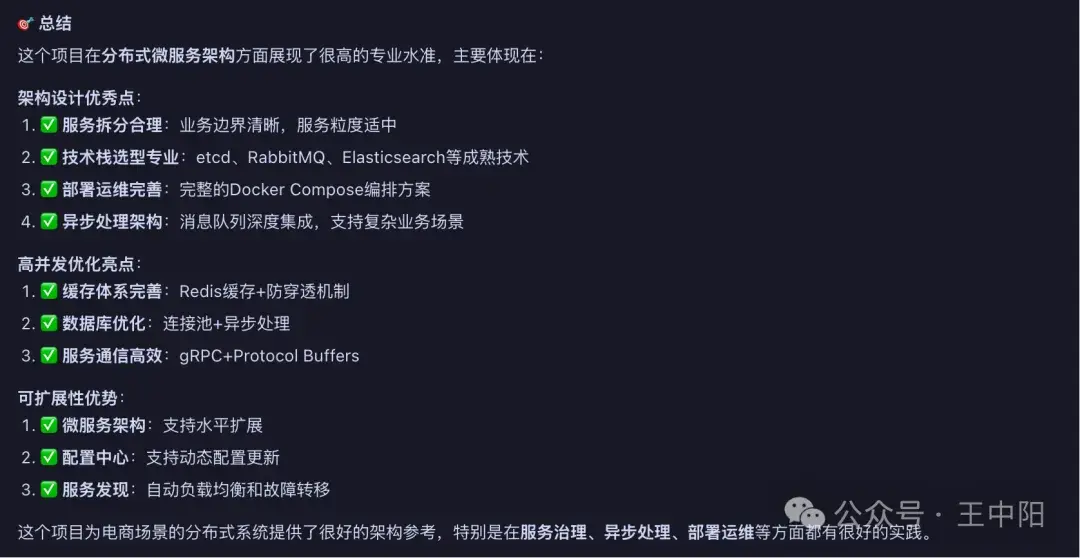

🎯 總結

這個項目在分佈式微服務架構方面展現了很高的專業水準,主要體現在:

架構設計優秀點:

- ✅ 服務拆分合理:業務邊界清晰,服務粒度適中

- ✅ 技術棧選型專業:etcd、RabbitMQ、Elasticsearch等成熟技術

- ✅ 部署運維完善:完整的Docker Compose編排方案

- ✅ 異步處理架構:消息隊列深度集成,支持複雜業務場景

高併發優化亮點:

- ✅ 緩存體系完善:Redis緩存+防穿透機制

- ✅ 數據庫優化:連接池+異步處理

- ✅ 服務通信高效:gRPC+Protocol Buffers

可擴展性優勢:

- ✅ 微服務架構:支持水平擴展

- ✅ 配置中心:支持動態配置更新

- ✅ 服務發現:自動負載均衡和故障轉移

這個項目為電商場景的分佈式系統提供了很好的架構參考,特別是在服務治理、異步處理、部署運維等方面都有很好的實踐。

下面也分享一些,我們最近做這個項目開發時的感悟和反思:

做微服務開發這些年,見過太多項目在理論階段順風順水,一到生產環境就狀況百出,高併發下接口響應超時、分佈式事務導致數據不一致、大流量衝擊直接壓垮服務,這些問題往往不是技術棧不夠新,而是落地時忽略了實戰細節。

對開發者來説,高併發處理和分佈式事務是繞不開的兩道坎。很多人對着文檔啃完Redis限流、TCC事務的理論,真到項目裏還是會踩坑,核心原因就是沒搞懂場景適配和細節把控。今天就結合實際項目經驗,拆解這兩個領域最容易踩的坑,幫你少走彎路。

一、高併發場景:別讓看似正確的方案拖垮系統

高併發不是簡單堆服務器,而是要從架構、緩存、限流等多維度做精細化設計,這3個坑最容易致命:

1. 緩存策略只做表面功夫,沒防住底層風險

很多人知道用Redis做緩存,但只停留在「查緩存→無則查庫→寫緩存」的基礎邏輯,卻忽略了三防問題的實際落地。比如某項目用Redis緩存商品數據,高峯期突然大量請求穿透到數據庫,導致DB連接池耗盡——原因是沒針對不存在的key做布隆過濾器攔截,也沒設置緩存空值的過期時間,惡意請求直接打穿了緩存層。

更隱蔽的是緩存雪崩:為了圖方便,給所有緩存key設置了相同過期時間,結果某一時刻大量key同時失效,瞬間把數據庫壓垮。實戰中更穩妥的做法是,給key設置隨機過期時間,再搭配Redis集羣的主從複製,避免單點故障。

2. 限流方案一刀切,沒考慮業務優先級

不少項目直接用網關做全侷限流,看似攔住了超額流量,卻導致核心業務(比如支付、訂單創建)和非核心業務(比如商品瀏覽、評論)一起被限流。曾遇到一個項目,大促時因為全侷限流閾值設置過低,用户支付請求被大量攔截,直接影響交易轉化。

正確的思路是分級限流:給核心服務單獨設置更高的限流閾值,非核心服務適當降低優先級,甚至在極端情況下做服務降級。比如用令牌桶算法對支付接口限流,同時給秒殺接口單獨配置熔斷策略,避免一個服務故障拖垮整個鏈路。

3. 庫存/數據扣減沒做原子操作,導致併發安全問題

高併發下的庫存扣減、餘額修改,最容易出現超賣「少扣」問題。之前見過一個項目,用「查詢庫存→判斷是否充足→扣減庫存」的邏輯,看似沒問題,但併發時多個請求同時查詢到庫存充足,最終導致超賣——原因是這三步操作不是原子性的,沒有加分佈式鎖或用Redis原子指令兜底。

實戰中更可靠的方案是:用Redis的decr指令做預扣減(原子操作,避免併發衝突),成功後再異步落庫;同時搭配定時任務校驗Redis與數據庫數據一致性,防止極端情況下的差異。

比如在我們的項目中是這樣做的,給大家展示一部分實現思路和代碼:

1. 緩存策略基礎實現

- 實現位置:

app/goods/utility/goodsRedis/goods.go - 緩存防穿透:實現了空值緩存機制

-

// 設置空緩存防止緩存穿透 func SetEmptyGoodsDetail(ctx context.Context, productId uint32) error { return goodsCache.Set(ctx, key, EmptyValue, 1*time.Minute) } - 緩存讀寫流程:標準的"查緩存→無則查庫→寫緩存"邏輯

-

緩存超時控制:商品詳情緩存1小時,分類數據緩存1周

2. Redis連接池配置

- 實現位置:

app/goods/utility/goodsRedis/redis.go - 連接池管理:使用gredis連接池

-

健康檢查:初始化時進行PING測試

3. 數據庫查詢優化

- 分頁查詢:支持分頁參數控制

- 排序優化:熱門商品按sort字段降序排列

-

查詢條件優化:根據IsHot參數動態構建查詢條件

二、分佈式事務:別盲目跟風複雜方案,適配場景才重要

分佈式事務的核心是保證跨服務數據一致性,但很多人陷入方案崇拜,盲目選擇TCC、Saga等複雜方案,反而導致維護成本飆升,這3個坑要警惕:

1. 不分場景亂用TCC,忽略回滾成本

TCC事務(Try-Confirm-Cancel)靈活性高,但對代碼侵入性強,需要手寫大量回滾邏輯。曾有個項目,給「用户下單→扣減庫存→生成訂單」的簡單鏈路用了TCC,結果因為某步回滾邏輯沒寫完善,導致部分用户庫存扣減後訂單未生成,排查了3天才修復。

其實很多場景用本地消息表+消息隊列就足夠了。比如用户支付成功後,發送消息通知庫存服務扣減,即使庫存服務暫時不可用,消息隊列也能重試,既降低了代碼複雜度,又能保證最終一致性。

2. 忽略冪等性設計,導致重複執行

分佈式環境下,網絡延遲、服務重試很常見,若接口沒做冪等性處理,很容易出現重複數據。比如支付回調接口,因為微信/支付寶的重試機制,同一筆支付可能收到多次回調,若沒校驗訂單狀態,會導致重複入賬。

實戰中最穩妥的做法是:給每個請求設置唯一ID(比如訂單號),接口接收請求時先校驗該ID是否已處理,處理過則直接返回成功,未處理再執行核心邏輯——用Redis或數據庫唯一索引就能輕鬆實現。

3. 沒做補償機制,異常場景無兜底

很多分佈式事務方案只考慮了正常流程,卻忽略了異常情況的補償機制。比如訂單創建後,支付服務超時未響應,既沒觸發取消訂單,也沒通知用户,導致用户訂單一直處於「待支付」狀態,庫存被長期佔用。

正確的思路是:用消息隊列的死信隊列機制,給關鍵操作設置超時時間,超時未完成則觸發補償邏輯。比如訂單創建後30分鐘未支付,自動發送消息取消訂單、釋放庫存,避免資源浪費。

比如在我們的項目中是這樣做的,給大家展示一部分實現思路和代碼:

已實現的補償機制

1. 訂單超時自動取消機制

- 實現位置:

app/order/internal/logic/order_info/order_info.go - 核心功能:訂單創建後自動發送延遲消息到RabbitMQ

- 超時時間:默認30分鐘(可配置)

- 技術實現:

-

// 訂單創建成功後,異步發送延遲消息 delay := rabbitmq.GetOrderTimeoutDelay(ctx) go grabbitmq.PublishOrderTimeoutEvent(int(orderId), delay)

2. 消息隊列死信隊列機制

- 實現位置:

utility/rabbitmq/event.go和app/worker/utility/rabbitmq/client.go -

技術架構:

- 使用RabbitMQ的延遲交換機(x-delayed-message)

- 配置了專門的訂單超時隊列(order.timeout.queue)

- 支持延遲消息發送

3. 訂單狀態管理

- 狀態定義:

app/order/internal/consts/order_status.go - 關鍵狀態:待支付(1)、已支付(2)、已取消(7)

- 取消邏輯:支持手動取消和超時自動取消

實戰才是突破瓶頸的關鍵

高併發和分佈式事務的坑,從來不是靠看理論能避開的,必須在真實項目中反覆打磨。但對很多開發者來説,缺少完整的實戰場景,很難系統性掌握這些技能——比如如何設計分級限流策略、如何根據業務選擇分佈式事務方案、如何搭配Docker+K8s應對流量波動。

如果你也在高併發、分佈式事務上頻繁踩坑,或是想積累可落地的微服務實戰經驗,這套課程或許能幫你快速突破瓶頸:https://mp.weixin.qq.com/s/ACzEHtvGh2YsU_4fxo83fQ,對這個項目感興趣的朋友可以私信我。

最後想説,微服務開發的核心不是會用多少框架,而是能解決多少實際問題。把這些實戰坑吃透,不管是面試還是工作中,都能更有底氣。