在企業數字化轉型進程中,將 SQL Server 的業務數據同步至 Hive 數據倉庫,是構建大數據分析平台的關鍵一步。然而,當數據量突破千萬級門檻,傳統同步方式往往陷入效率低下、穩定性差的困境。本文將分享使用ETLCLoud工具實現千萬級數據量下SQL Server到Hive高效同步的實戰經驗。

1.配置數據源

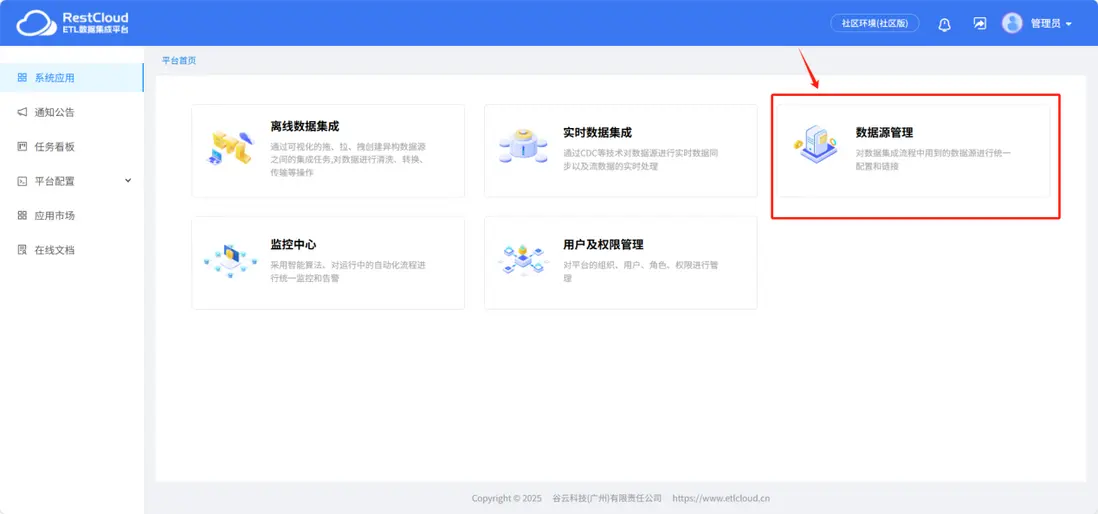

來到平台首頁進入數據源管理模塊。

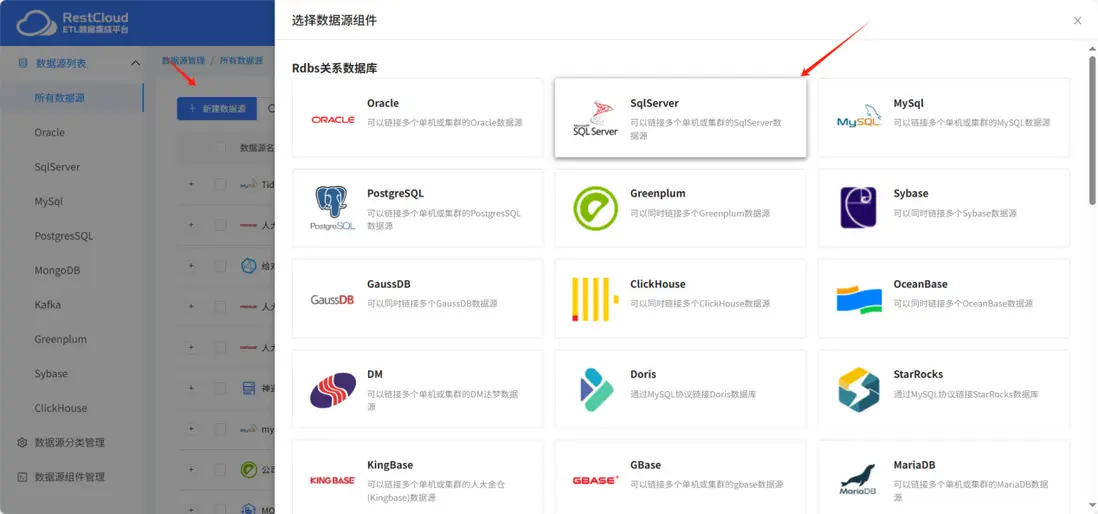

在新建數據源中選擇SQLserver數據源模板

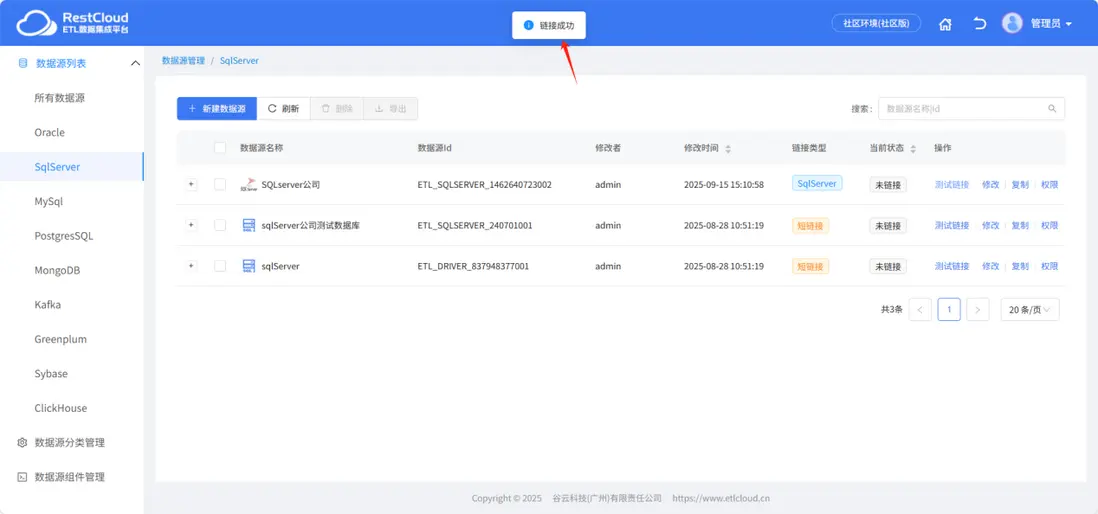

根據實際情況配置連接,注意url的配置。

配置完成後點擊保存並測試提示鏈接成功即可。

用同樣的步驟再次配置一個目標端hive數據源的鏈接。

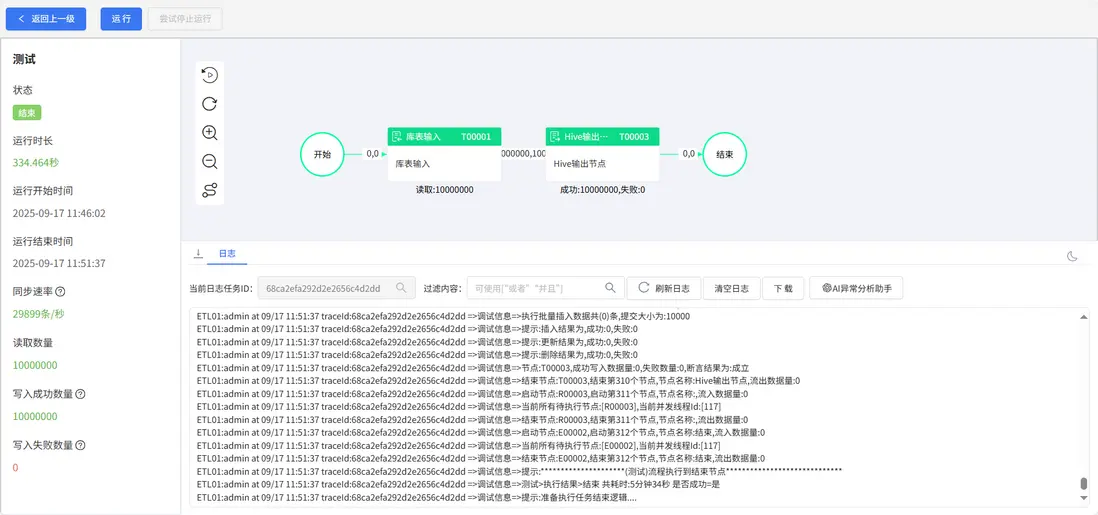

現在SQLserver裏有一張數據量是一千萬的表。

2.同步流程設計

ETLCloud無需用户編寫複雜代碼,即可實現高效、安全的分頁查詢和併發同步。其流程設計如下:

庫表輸入配置

Hive輸出配置

路由線設置併發數

3.運行結果

總結:

ETLCloud作為一款數據集成工具,通過其可視化開發、強大轉換能力、多目標支持和企業級可靠性,將流式ETL的複雜技術細節封裝起來,讓數據工程師和分析師能夠更專注於業務邏輯本身,而非底層實現,極大地加速了企業從數據到實時洞察的進程,是構建現代實時數據架構的理想選擇。