在自動駕駛、機器人導航等領域,3D場景的感知與生成一直是研究熱點。然而,傳統方法通常將這兩個過程分離:生成模型僅僅作為數據增強工具,為下游感知任務提供合成數據。這種方法不僅靈活性有限,生成的場景也往往缺乏對感知任務有價值的細節。

近日,上海交通大學與寧波數字孿生研究院聯合團隊提出了一種名為OccScene的創新範式,將細粒度3D感知與高質量場景生成統一在同一個框架中,實現了跨任務的互利共贏。

一、傳統方法的三大挑戰

現有3D場景生成方法面臨三大核心問題:

- 靈活性有限:依賴真實標註數據(如3D邊界框、BEV地圖)進行推理,標註成本高且難以生成多樣化的邊緣案例

- 約束不足:使用區域級粗糙先驗無法提供像素級細粒度語義和幾何指導

- 目標不明確:生成過程主觀質量驅動,與感知任務需求脱節

二、OccScene的核心創新

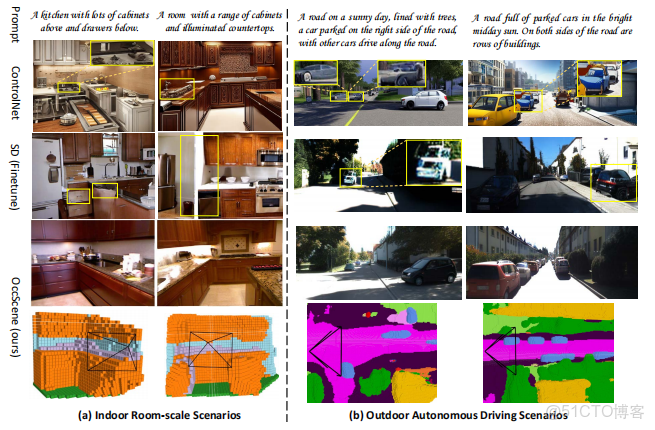

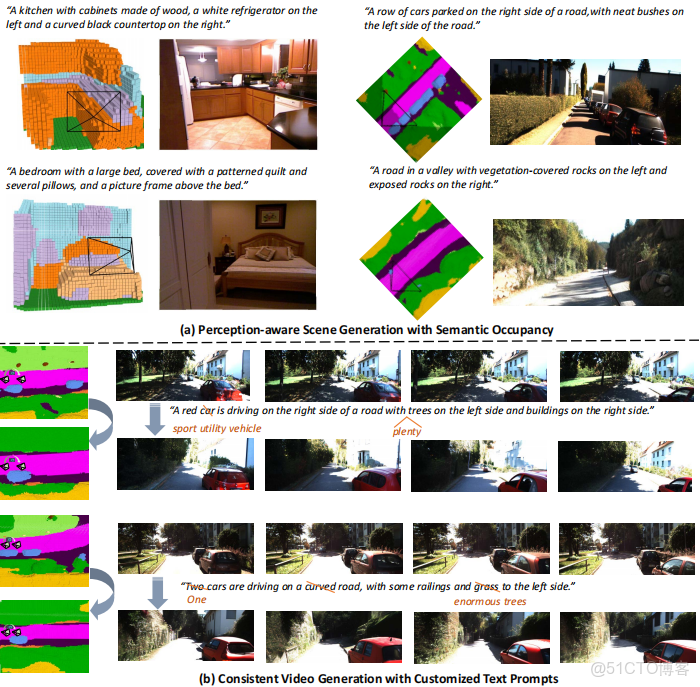

OccScene通過聯合學習方案,將語義佔據預測與文本驅動生成兩個任務統一在單一擴散過程中,實現了真正的跨任務協作。

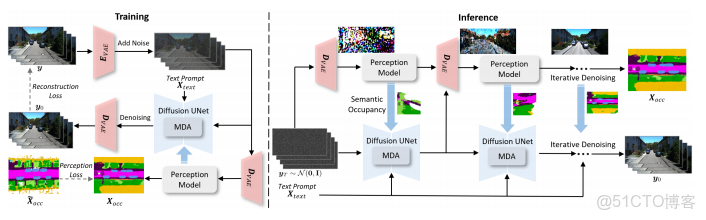

感知-生成聯合擴散方案

OccScene框架同時訓練生成擴散UNet和感知模型。輸入圖像經VAE編碼器壓縮後,分別送入擴散UNet去噪和VAE解碼器生成噪聲圖像。感知模型以噪聲圖像為輸入預測佔據網格,作為額外條件約束擴散UNet。

訓練過程採用兩階段策略:先凍結感知模型權重訓練擴散UNet,再聯合訓練兩者實現互利。損失函數結合了潛在擴散模型的重建損失和感知損失,通過√αₜ自適應調整不同噪聲水平的監督強度。

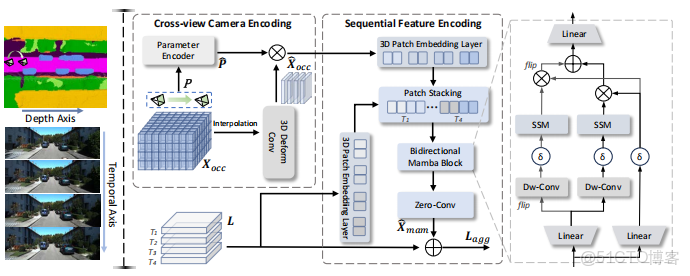

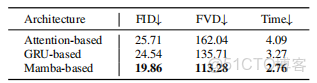

Mamba-based雙對齊模塊

為將語義佔據與擴散潛在特徵對齊,團隊提出了Mamba-based雙對齊模塊:

- 跨視角相機編碼:將相機參數與語義佔據結合,實現相機軌跡感知

- 序列特徵編碼:使用雙向Mamba塊沿深度維度處理語義佔據特徵,沿時間維度處理潛在特徵

該模塊通過線性複雜度操作符高效處理高維數據,確保跨視角生成一致性並提供細粒度幾何語義指導。

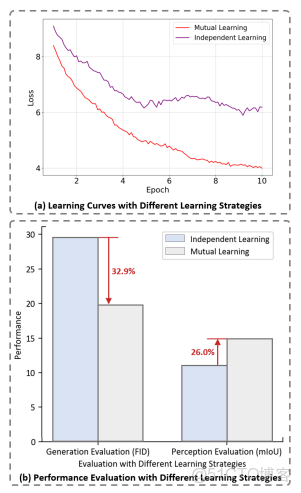

跨任務互利學習機制

研究表明,深度學習網絡在寬谷而非尖鋭極小值處找到的解具有更好的泛化能力。OccScene的跨任務互利學習恰好促進了這類高質量解的發現。

三、卓越的實驗表現

生成質量評估

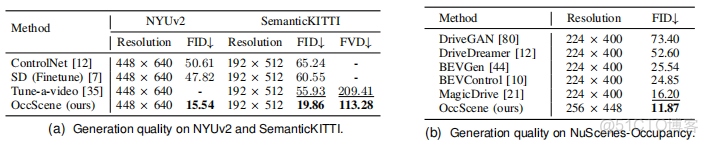

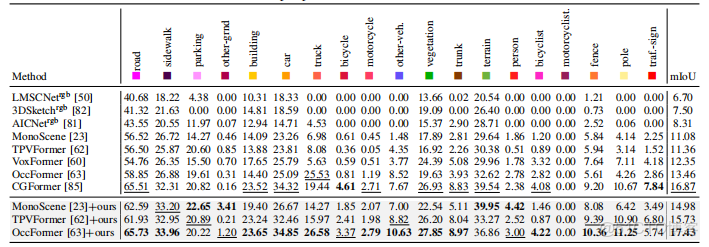

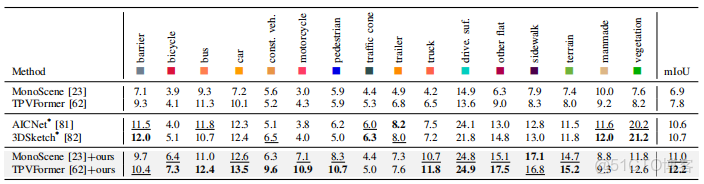

在NYUv2、SemanticKITTI和NuScenes-Occupancy等多個數據集上的實驗表明,OccScene在生成質量上顯著優於現有方法:

在NuScenes-Occupancy上達到11.87 FID,超越MagicDrive的16.20

在SemanticKITTI上實現113.28 FVD,優於Tune-a-video的209.41

3D語義場景生成的FID相比SemCity提升30.66%

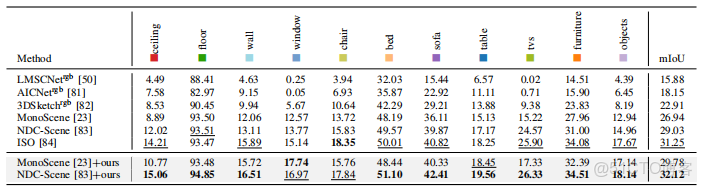

感知性能提升

OccScene作為即插即用框架,顯著提升了多種語義佔據預測模型的性能:

在NYUv2上,將MonoScene的mIoU提升2.84,NDC-Scene提升3.09

在SemanticKITTI上,將MonoScene的mIoU提升3.90,TPVFormer提升4.38

在NuScenes-Occupancy上,將MonoScene的mIoU提升4.10

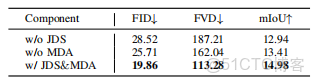

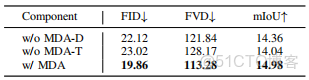

消融實驗驗證

團隊通過系統消融研究驗證了各組件貢獻:

聯合擴散方案(JDS)提升生成保真度並增強感知性能2.04 mIoU

Mamba-based雙對齊(MDA)在線性複雜度和生成質量上均優於基於注意力或GRU的設計

沿深度和時間維度同時應用MDA模塊帶來最大性能增益

四、實際應用價值

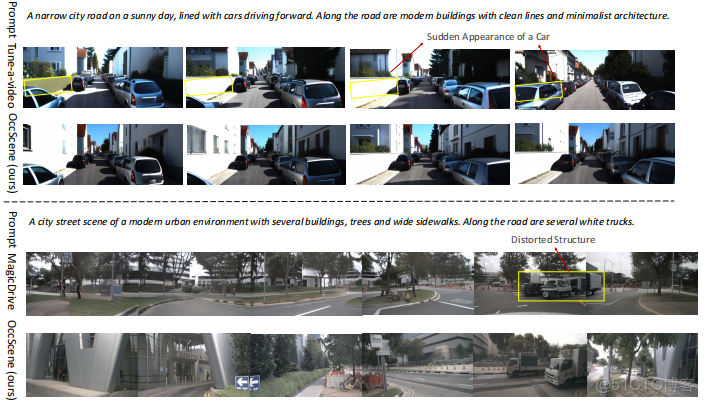

OccScene僅憑文本提示就能同步生成逼真的場景圖像/視頻及其對應語義佔據,為自動駕駛和機器人領域帶來了實際價值:

- 無需標註數據即可生成多樣化訓練樣本

- 增強感知模型在複雜場景下的理解能力

- 支持一致性視頻生成與編輯,適應動態環境

五、未來展望

OccScene為3D場景理解與生成開闢了新路徑。其核心思想——通過跨任務互利學習實現共贏——可望擴展到更多視覺任務中。隨着擴散模型和狀態空間模型的不斷髮展,感知與生成的融合將成為未來三維視覺領域的重要方向。